ChatGPT對技術(shù)的影響引發(fā)了對人工智能未來的預(yù)測,尤其是多模態(tài)技術(shù)的關(guān)注。OpenAI推出了具有突破性的多模態(tài)模型GPT-4,使各個領(lǐng)域取得了顯著的發(fā)展。 這些AI進(jìn)步是通過大規(guī)模模型訓(xùn)練實現(xiàn)的,這需要大量的計算資源和高速數(shù)據(jù)傳輸網(wǎng)絡(luò)。端到端InfiniBand(IB)網(wǎng)絡(luò)作為高性能計算和AI模型訓(xùn)練的理想選擇,發(fā)揮著重要作用。在本文中,我們將深入探討大型語言模型(LLM)訓(xùn)練的概念,并探索端到端InfiniBand網(wǎng)絡(luò)在解決LLM訓(xùn)練瓶頸方面的必要性。

大型語言模型(LLM)和ChatGPT之間是否存在聯(lián)系

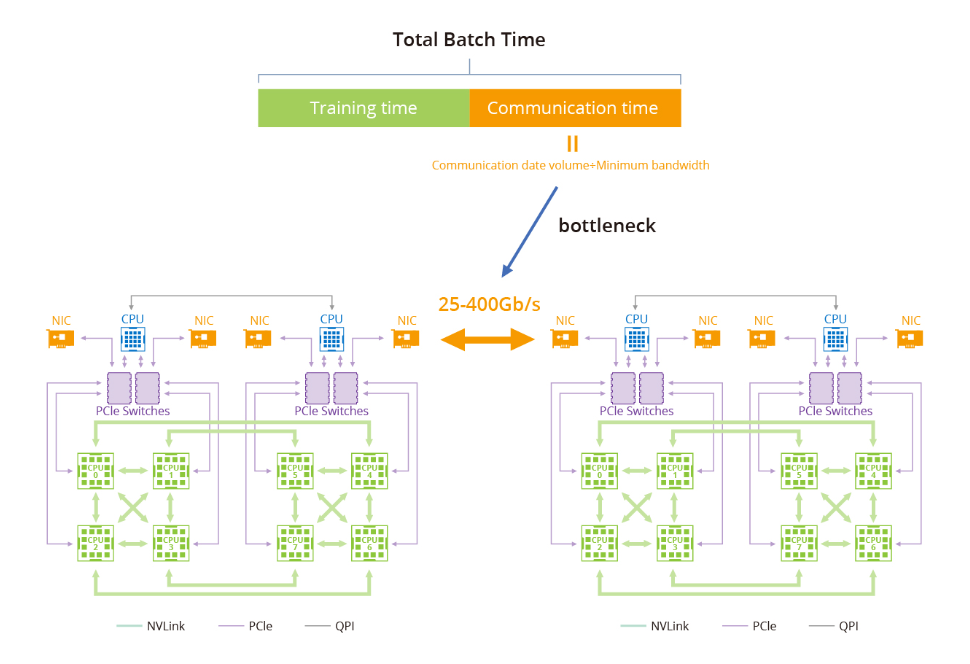

訓(xùn)練大型語言模型(LLM)面臨的瓶頸主要與GPU計算集群內(nèi)的數(shù)據(jù)傳輸和通信有關(guān)。隨著大型語言模型的增長,對高速可靠網(wǎng)絡(luò)的需求變得至關(guān)重要。例如,具有1.75萬億參數(shù)的GPT-3的模型無法在單機上訓(xùn)練,而是嚴(yán)重依賴于GPU集群。主要瓶頸在于在訓(xùn)練集群中高效地在節(jié)點之間傳輸數(shù)據(jù)。

階段1:環(huán)形全約減

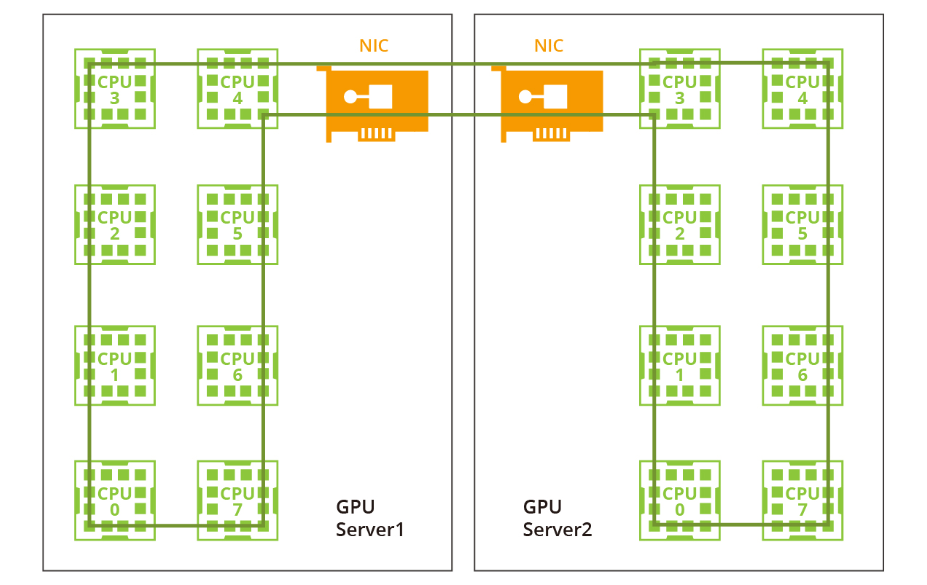

一種常用的GPU通信算法是環(huán)形全約減,其中GPU形成一個環(huán),使數(shù)據(jù)在環(huán)內(nèi)流動。每個GPU都有一個左鄰和一個右鄰,數(shù)據(jù)只向右鄰發(fā)送,從左鄰接收。該算法包括兩個步驟:散射-約減和全收集。在散射-約減步驟中,GPU交換數(shù)據(jù)以獲得最終結(jié)果的一個塊。在全收集步驟中,GPU交換這些塊,以確保所有GPU都具有完整的最終結(jié)果。

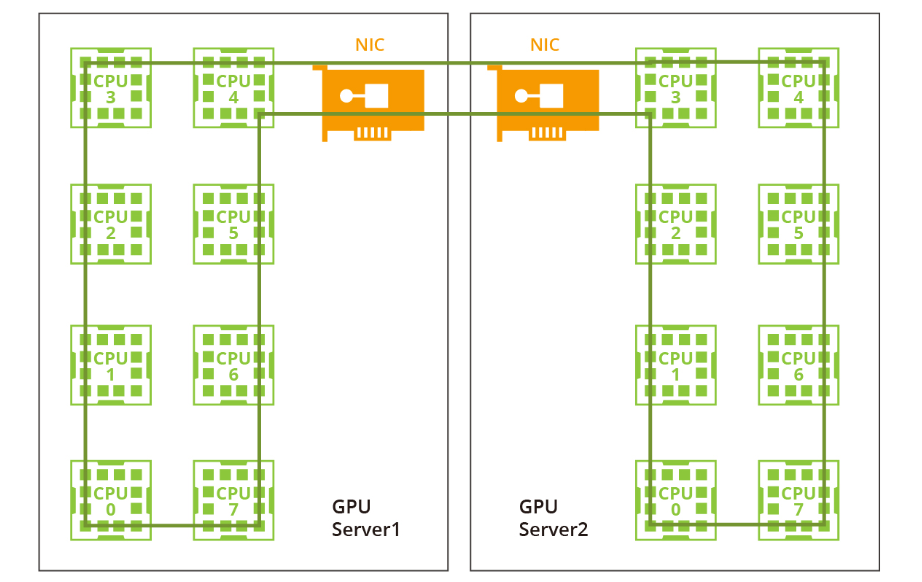

階段2:雙階段環(huán)形

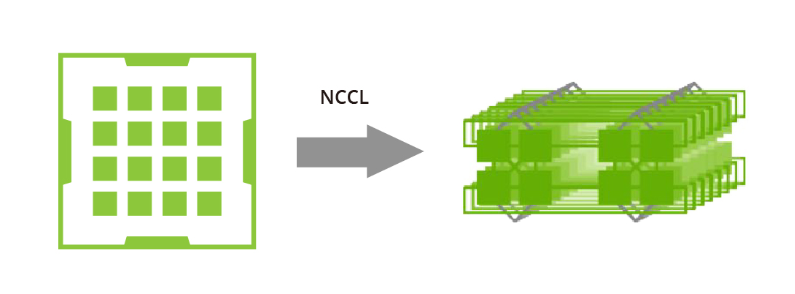

過去由于帶寬有限且沒有NVLink或RDMA技術(shù),一個大型環(huán)對于單機和多機分布已經(jīng)足夠。然而,隨著NVLink在單機內(nèi)的引入,相同的方法不再適用。網(wǎng)絡(luò)帶寬遠(yuǎn)低于NVLink的帶寬,因此采用一個大環(huán)將大幅降低NVLink的效率到網(wǎng)絡(luò)的水平。此外,在當(dāng)前的多網(wǎng)卡環(huán)境中,僅利用一個環(huán)無法充分利用多個網(wǎng)卡。因此,建議采用雙階段環(huán)方法來解決這些問題。 在雙階段環(huán)形場景中,數(shù)據(jù)同步發(fā)生在單臺機器內(nèi)的GPU之間,利用了NVLink的高帶寬優(yōu)勢。隨后,跨多臺機器的GPU使用多個網(wǎng)卡建立多個環(huán)形,以同步來自不同段的數(shù)據(jù)。最后,單臺機器內(nèi)的GPU再次進(jìn)行同步,完成所有GPU之間的數(shù)據(jù)同步。值得注意的是,NVIDIA集體通信庫(NCCL)在這個過程中發(fā)揮了關(guān)鍵作用。

NVIDIA集體通信庫(NCCL)包括針對NVIDIA GPU和網(wǎng)絡(luò)進(jìn)行優(yōu)化的多GPU和多節(jié)點通信例程。NCCL為全收集、全約減、廣播、約減、約減散開和點對點發(fā)送和接收操作提供高效的基本操作。這些例程經(jīng)過優(yōu)化,以實現(xiàn)高帶寬和低延遲,利用節(jié)點內(nèi)和NVIDIA Mellanox網(wǎng)絡(luò)通過PCIe和NVLink高速互連。

通過解決數(shù)據(jù)傳輸和通信中的瓶頸問題,GPU計算集群的進(jìn)步以及利用NCCL等工具的使用有助于克服大型語言模型訓(xùn)練中的挑戰(zhàn),為AI研究和開發(fā)進(jìn)一步的突破鋪平了道路。

端到端InfiniBand網(wǎng)絡(luò)解決方案如何提供幫助

在大型模型訓(xùn)練中,以太網(wǎng)在傳輸速率和延遲方面存在不足。相比之下,端到端InfiniBand網(wǎng)絡(luò)提供了高性能計算解決方案,能夠提供高達(dá)400 Gbps的傳輸速率和微秒級的延遲。因此,InfiniBand已成為大規(guī)模模型訓(xùn)練的理想選擇。

數(shù)據(jù)冗余和錯誤糾正機制

端到端InfiniBand網(wǎng)絡(luò)的一個關(guān)鍵優(yōu)勢是其對數(shù)據(jù)冗余和錯誤糾正機制的支持,確保可靠的數(shù)據(jù)傳輸。在大規(guī)模模型訓(xùn)練中,由于處理的數(shù)據(jù)量巨大,傳輸錯誤或數(shù)據(jù)丟失會對訓(xùn)練過程產(chǎn)生不利影響,這一點尤為重要。通過利用InfiniBand的強大功能,可以較大程度地減少由于數(shù)據(jù)傳輸問題引起的中斷或故障。

本地子網(wǎng)的配置和維護(hù)

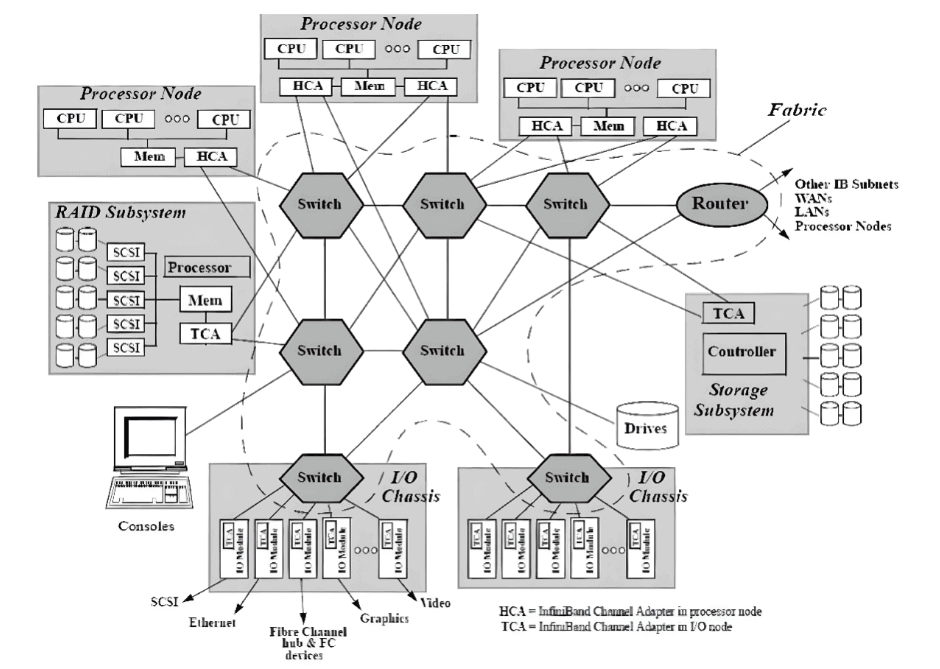

在InfiniBand互連協(xié)議中,每個節(jié)點都配備有一個主機通道適配器(HCA),負(fù)責(zé)與主機設(shè)備建立和維護(hù)鏈接。交換機具有多個端口,用于在端口之間進(jìn)行數(shù)據(jù)包轉(zhuǎn)發(fā),從而實現(xiàn)子網(wǎng)內(nèi)的高效數(shù)據(jù)傳輸。 子網(wǎng)管理器(SM)在配置和維護(hù)本地子網(wǎng)方面發(fā)揮著關(guān)鍵作用,每個InfiniBand設(shè)備上都有子網(wǎng)管理器數(shù)據(jù)包(SMP)和子網(wǎng)管理器代理(SMA)提供支持。子網(wǎng)管理器(SM)發(fā)現(xiàn)和初始化網(wǎng)絡(luò),為所有設(shè)備分配唯一標(biāo)識符,確定最小傳輸單元(MTU),并根據(jù)選擇的路由算法生成交換機的路由表。它還定期掃描子網(wǎng),檢測拓?fù)渥兓⑾鄳?yīng)調(diào)整網(wǎng)絡(luò)配置。

基于信用的流量控制

與其他網(wǎng)絡(luò)通信協(xié)議相比,InfiniBand網(wǎng)絡(luò)提供更高的帶寬、更低的延遲和更大的可擴展性。此外,InfiniBand采用基于信用的流量控制,發(fā)送節(jié)點確保不會傳輸超過接收緩沖區(qū)中可用信用數(shù)量的數(shù)據(jù)到連接的另一端。這消除類似TCP窗口算法的數(shù)據(jù)包丟失機制的需求,使InfiniBand網(wǎng)絡(luò)能夠以較低延遲和CPU使用率實現(xiàn)較高數(shù)據(jù)傳輸速率。

遠(yuǎn)程直接內(nèi)存訪問(RDMA)技術(shù)

InfiniBand利用遠(yuǎn)程直接內(nèi)存訪問(RDMA)技術(shù),實現(xiàn)應(yīng)用程序之間在網(wǎng)絡(luò)上直接進(jìn)行數(shù)據(jù)傳輸,無需涉及操作系統(tǒng)。這種零拷貝傳輸方法顯著減少了兩端CPU資源的消耗,使應(yīng)用程序能夠直接從內(nèi)存中讀取消息。降低的CPU開銷提升了網(wǎng)絡(luò)快速傳輸數(shù)據(jù)的能力,并使應(yīng)用程序更高效地接收數(shù)據(jù)。 總體而言,端到端InfiniBand網(wǎng)絡(luò)為大型模型訓(xùn)練提供了顯著優(yōu)勢,包括高帶寬、低延遲、數(shù)據(jù)冗余和錯誤糾正機制。通過利用InfiniBand的能力,研究人員可以克服性能限制,增強系統(tǒng)管理,并加速大規(guī)模語言模型的訓(xùn)練。

-

InfiniBand

+關(guān)注

關(guān)注

1文章

29瀏覽量

9180 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1548瀏覽量

7485 -

大模型

+關(guān)注

關(guān)注

2文章

2322瀏覽量

2479

原文標(biāo)題:InfiniBand:突破大模型訓(xùn)練性能瓶頸

文章出處:【微信號:AI_Architect,微信公眾號:智能計算芯世界】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

InfiniBand 連接現(xiàn)在和未來

語音端到端加密方案

為WiMAX構(gòu)建端到端的網(wǎng)絡(luò)架構(gòu)

基于WiMAX接入技術(shù)的端到端網(wǎng)絡(luò)架構(gòu)

CMHK宣布完成端到端5G網(wǎng)絡(luò)測試

端到端的自動駕駛研發(fā)系統(tǒng)介紹

我國正式啟動了5G網(wǎng)絡(luò)切片端到端總體架構(gòu)標(biāo)準(zhǔn)研制工作

三大巨頭實現(xiàn)首個基于APP應(yīng)用級的5G SA端到端網(wǎng)絡(luò)切片

基于深度神經(jīng)網(wǎng)絡(luò)的端到端圖像壓縮方法

如何實現(xiàn)端到端網(wǎng)絡(luò)切片?

英偉達(dá)三大AI法寶:CUDA、Nvlink、InfiniBand

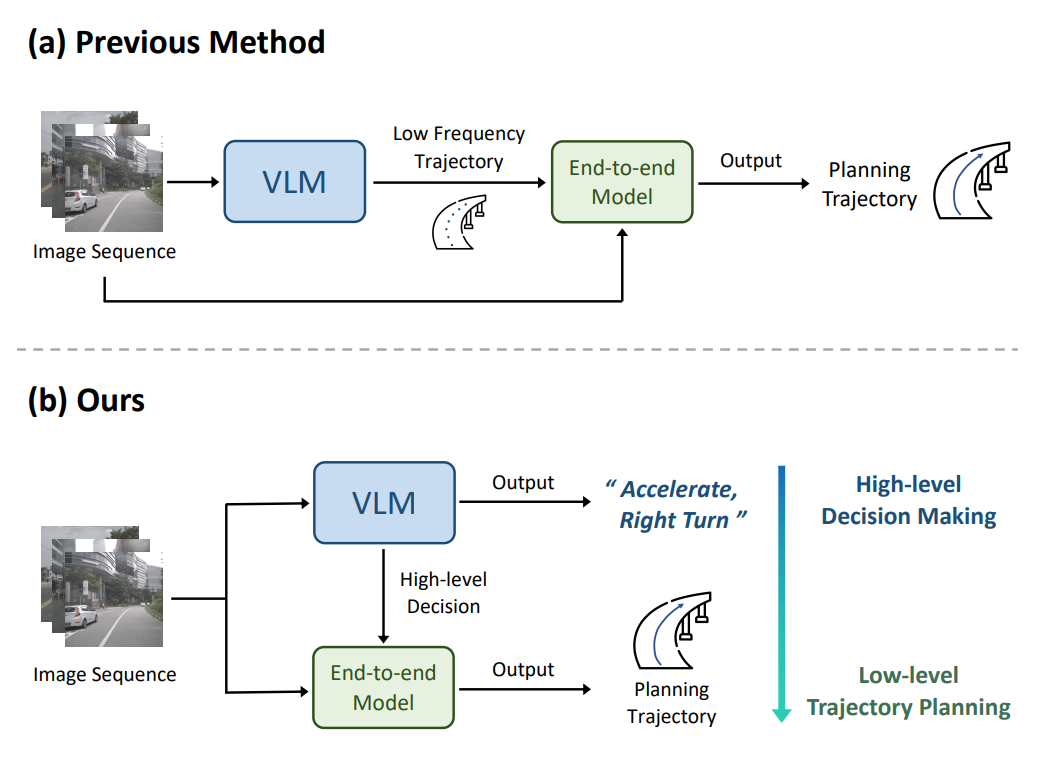

理想汽車自動駕駛端到端模型實現(xiàn)

連接視覺語言大模型與端到端自動駕駛

端到端InfiniBand網(wǎng)絡(luò)解決LLM訓(xùn)練瓶頸

端到端InfiniBand網(wǎng)絡(luò)解決LLM訓(xùn)練瓶頸

評論