評估AI大模型的效果是一個復雜且多維度的過程,涉及多個方面的考量。以下是一些關鍵的評估方法和步驟:

一、基準測試(Benchmarking)

使用標準數據集和任務來評估模型的性能,如GLUE、SuperGLUE、SQuAD等。這些數據集提供了不同任務上的基準評估,使得不同模型在同一任務上的性能可以進行直接比較。

二、多樣性和覆蓋性測試

測試模型在不同類型的數據和任務上的表現,如文本生成、翻譯、問答等。這有助于確保模型能夠處理各種語言現象和上下文,評估其泛化能力。

三、魯棒性測試

檢查模型在面對輸入數據擾動(如拼寫錯誤、語法錯誤、模糊描述等)時的表現。通過引入各種噪聲和干擾,測試模型對擾動和干擾的抗性能力,以確保模型的誤差容忍度和穩定性。

四、效率和可擴展性測試

測試模型在不同計算資源和硬件環境下的運行效率,評估推理速度、內存占用和擴展能力。這對于確保模型在實際應用中的可行性和性能至關重要。

五、實際應用測試

在真實場景中測試模型的應用效果,如客戶服務、文本分析、對話系統等。收集用戶反饋和性能指標,評估模型的實用性和用戶滿意度。這有助于發現模型在實際應用中的潛在問題和改進方向。

六、選擇合適的評估指標

根據具體應用場景和需求,選擇適合的評估指標進行模型的評估。常見的評估指標包括準確率、精確率、召回率、F1值等。對于分類任務,可以使用混淆矩陣來詳細分析模型的性能。對于回歸任務,則可以使用均方誤差(MSE)、均方根誤差(RMSE)、平均絕對誤差(MAE)等指標來評估模型的預測精度。

七、可解釋性和透明度評估

評估模型的可解釋性和透明度,了解模型是如何做出決策的。這有助于發現潛在的問題,提高模型的可信度和可靠性。對于某些應用場景,如金融、醫療等,模型的可解釋性尤為重要。

八、綜合評估框架

為了全面評估AI大模型的效果,可以使用綜合評估框架,如OpenCompass等。這些框架為開發者和研究者提供了一個一站式的平臺來評估大模型在各種任務上的表現。它們通常包括配置、推理與評估、可視化等階段,能夠方便地比較不同模型的性能,并提供詳細的評估報告。

綜上所述,評估AI大模型的效果需要綜合考慮多個方面,包括基準測試、多樣性和覆蓋性測試、魯棒性測試、效率和可擴展性測試、實際應用測試、選擇合適的評估指標、可解釋性和透明度評估以及綜合評估框架等。通過這些步驟和方法,可以全面評估AI大模型的性能和可靠性,確保模型在實際應用中的表現達到預期目標。

-

硬件

+關注

關注

11文章

3260瀏覽量

66131 -

GLUE

+關注

關注

0文章

5瀏覽量

7346 -

AI大模型

+關注

關注

0文章

307瀏覽量

294

發布評論請先 登錄

相關推薦

Meta發布新AI模型自學評估器,探索減少人類參與度

Meta推出可自我評估AI模型

ai模型訓練需要什么配置

【每天學點AI】人工智能大模型評估標準有哪些?

華為云盤古汽車大模型通過可信AI汽車大模型評估

STM CUBE AI錯誤導入onnx模型報錯的原因?

英國AI安全研究所推出AI模型安全評估平臺

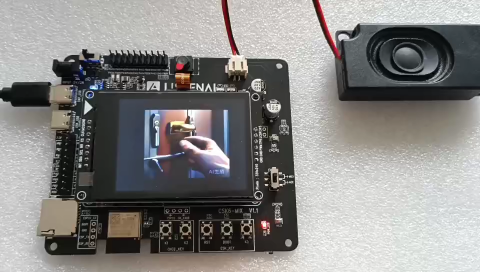

防止AI大模型被黑客病毒入侵控制(原創)聆思大模型AI開發套件評測4

使用cube-AI分析模型時報錯的原因有哪些?

如何評估AI大模型的效果

如何評估AI大模型的效果

評論