01

引 言

隨著自動駕駛技術的迅速發展,雷達和激光雷達等傳感器在自動駕駛汽車中的作用愈發重要。它們能夠生成3D點云數據,幫助車輛實時感知周圍環境并做出安全決策。然而,盡管這些傳感器對駕駛環境的檢測非常精確,它們也面臨一種新興的威脅——對抗性攻擊。

對抗性攻擊是一種通過微小但精心設計的擾動,旨在欺騙機器學習模型的攻擊方式。對于自動駕駛系統而言,這意味著通過對傳感器輸入的數據進行極小的修改,攻擊者可以導致自動駕駛汽車對其周圍環境作出錯誤的判斷。例如,在點云識別模型中,攻擊者可以通過擾動點云中的數據,使得車輛無法正確檢測障礙物或行人,從而引發嚴重的安全事故。

這種攻擊方式的危險在于,擾動往往非常微小,但它足以誤導深度學習模型。例如,通過使用針對3D點云的對抗性攻擊,攻擊者可以制造虛假目標,或隱藏真實目標,使車輛在物理世界中無法正確響應。這些攻擊不僅對自動駕駛的安全性構成重大威脅,也對自動駕駛系統的魯棒性提出了新的挑戰。

隨著對抗性攻擊技術的不斷演進,了解并防御這些攻擊變得尤為關鍵。本篇文章將重點介紹如何通過雷達對抗性攻擊來影響自動駕駛汽車的點云識別模型,揭示其潛在的危害。

02

針對點云識別模型的對抗性攻擊

2.1 2D對抗性攻擊方法向3D點云模型遷移的挑戰與難點

2014年,Goodfellow等[1]的研究指出,在待識別圖片中巧妙地加入一定的噪聲,會使得圖像被神經網絡誤分類。同時,該研究也揭示了神經網絡的脆弱性,使得神經網絡的攻擊方法成為了近年來深度學習的研究熱點之一,隨后,出現了大量針對圖像的對抗性攻擊方法。如Su等嘗試使用更改圖像的單個像素的方式完成對神經網絡的攻擊,該方法通過改變圖像中的單個像素觀察神經網絡輸出概率的方式,搜索最終生成對抗樣本需要更改的像素,Wang等提出一種使用替代模型訓練可遷移的對抗樣本的方法,通過訓練一定數量的替代網絡生成可遷移的對抗樣本。

但這些方法都難以直接遷移應用至點云識別模型的攻擊中:首先,2D的圖像和3D的點云數據結構上存在巨大的差異,2D圖像中的像素是有序的,按行列排布,而3D點云數據中的點是無序的,點的排列順序對點云的幾何結構沒有影響。這使得許多直接基于像素位置的2D方法無法簡單遷移到3D點云中,因為點云沒有固定的排列結構。另外,3D點云相比于2D圖像通常更加稀疏。點云中的每個點可能包含有限的鄰居點,而2D圖像中的每個像素通常都有固定數量的鄰居。這種稀疏性增加了在3D點云上生成有效對抗性樣本的難度。還有,2D圖像和3D圖像的坐標空間不同,在2D圖像中,像素位于離散的二維網格中,而3D點云的數據位于連續的三維空間中。攻擊者在2D圖像上進行的像素擾動非常直觀,而在3D空間中,修改點的坐標會影響物體的形狀、姿態和幾何結構,使得在生成對抗性樣本時需要更復雜的幾何變換。3D點云模型對旋轉和平移等幾何變換相對敏感。使得對抗性攻擊在3D點云模型上相比于2D圖像識別模型更容易受到空間和角度的變化所影響最終導致失效。最后,3D模型的對抗性攻擊相比于2D模型計算量更大,3D數據的處理往往比2D圖像復雜得多,計算成本更高。在生成對抗性樣本時,算法需要處理大量點,這顯著增加了時間和資源的消耗。

2.2 針對點云識別模型的對抗性攻擊算法介紹

雖然將2D模型的對抗性攻擊方法遷移至3D點云的攻擊方法存在諸多挑戰,但還是有研究人員成功地將應用于2D模型的對抗性攻擊方法遷移到了針對3D點云模型的方法中。Xiang等[2]提出了一種基于C&W的攻擊方法,稱之為3DAdv。3D Adv采用了C&W作為尋找對抗性特征使用的待優化函數,采用Chamfer距離用于衡量兩個點云之間的相似性,通過梯度下降的方法求解出最后的對抗性特征。3DAdv采用了Chamfer距離來度量原始點云與擾動點云的相似性:這使得擾動后的點云在幾何結構上依然保持與原始點云的高度相似,同時允許針對特定點的微小擾動,采用Chamfer距離很好地解決了L2范式等方法無法應用于評估點云之間的相似度問題,一定程度上解決了3D點云的無序性問題和稀疏性問題。3D Adv雖然在一定程度上解決了點云數據和圖像數據特征不一致的問題,但其難以在現實世界中復現,另外還存在生成的計算復雜度高、適用范圍有限等局限性。

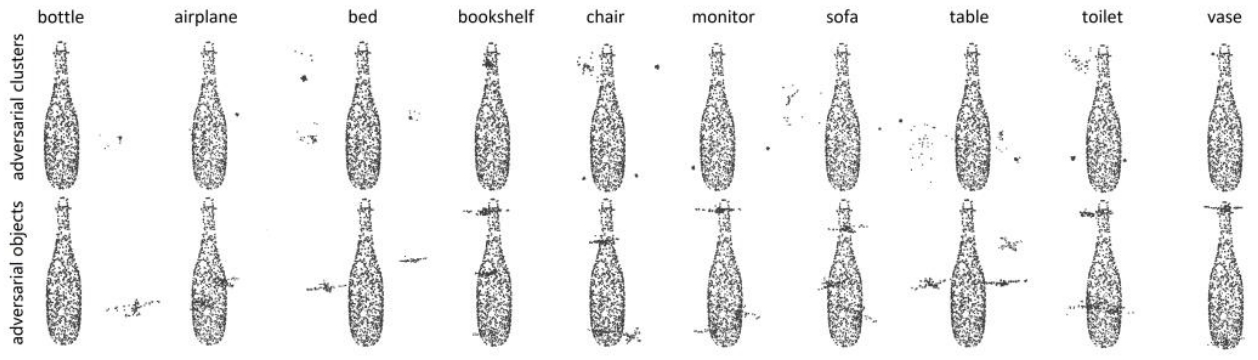

圖 1 3D Adv可視化效果[2]

另外也有其它的研究者另辟蹊徑,選擇使用別的方法生成對抗性的點云。比如Harmi等[3]就通過對抗性生成網絡進行對抗性點云的生成,對抗性生成網絡由兩個部分——生成器和判別器組成,生成器負責生成對抗樣本,判別器用于評估這些樣本的真實性。AdvPC 通過這種對抗性訓練,生成在幾何上與原始點云相似但能夠欺騙分類器的對抗樣本。通過這種方法生成的樣本具有魯棒性強、可遷移性強的特點:傳統的基于梯度的對抗性攻擊通常需要對目標模型進行專門優化,生成的對抗樣本難以在不同模型之間通用。AdvPC通過生成模型,能夠生成對多個模型都有效的對抗性樣本。換句話說,生成的對抗樣本具有較強的可遷移性,在不同的3D點云分類器中依然能夠誤導模型。另外,由于AdvPC結合了生成對抗網絡的強大能力,它生成的對抗樣本在一定的旋轉、平移或噪聲干擾下仍然能夠保持有效。相比于直接的梯度攻擊,AdvPC生成的對抗性樣本更能適應實際的物理環境變化,適合在現實應用中使用。但是,AdvPC也存在自己的局限性:由于GAN的訓練過程本身較為復雜,AdvPC的實現需要大量計算資源,尤其在生成高質量的對抗樣本時,訓練過程可能會消耗大量時間。另外,盡管AdvPC在數字環境中的效果顯著,但將這些對抗樣本應用于物理世界(如激光雷達數據)時,可能仍需要克服一些現實中的傳感器噪聲和環境變化。

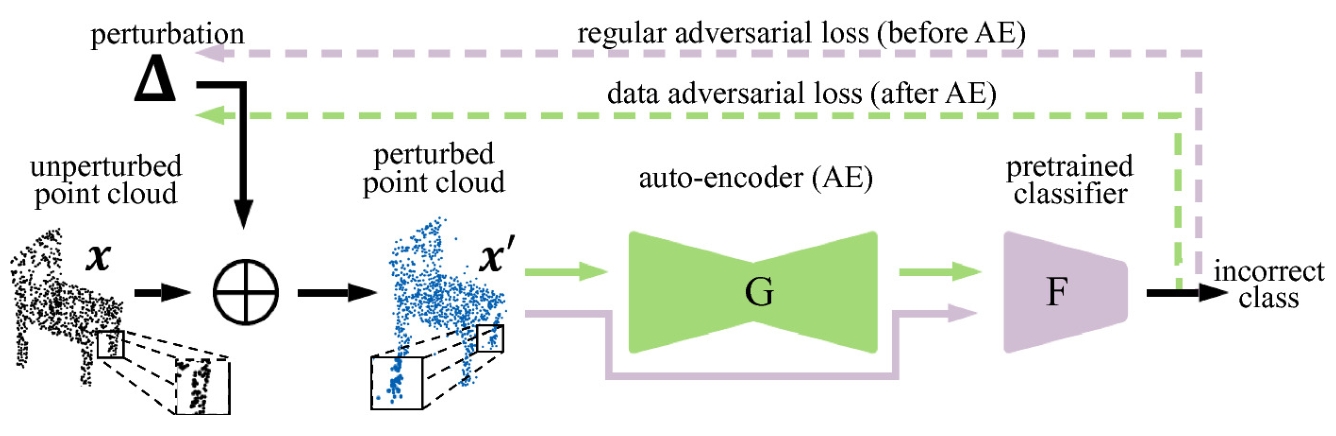

圖2 AdvPC算法流程[3]

3DAdv和AdvPC除去自身的局限性,他們還難以應用于黑盒攻擊的場景下。3DAdv需要知道模型的梯度信息,AdvPC需要知道數據的輸入特征,在目標模型的信息完全未知只能知道目標模型的輸入輸出的情況下這種白盒的方法無法應用。為了解決這一問題,Cao等[4]提出了EvolutionAdv,EvolutionAdv 通過進化算法逐步優化對抗性樣本。進化算法模擬自然選擇過程,生成一組隨機的擾動樣本,并通過選擇、變異和交叉操作,不斷改進樣本,使它們逐漸演化為能夠有效欺騙模型的對抗性樣本。EvolutionAdv 假設攻擊者無法訪問目標模型的內部結構或參數。因此,EvolutionAdv 不需要知道模型的細節,僅依賴模型的輸出來優化對抗性樣本。相比于前文提到的3DAdv和AdvPC,EvolutionAdv無需了解模型的內部結構、梯度或參數。這使得它非常適合攻擊那些對外界保密的模型,如商用模型或云端提供的深度學習服務。但同樣的EvolutionAdv同樣存在計算上比較復雜,生成對抗樣本的時間較長,效率較低等問題。

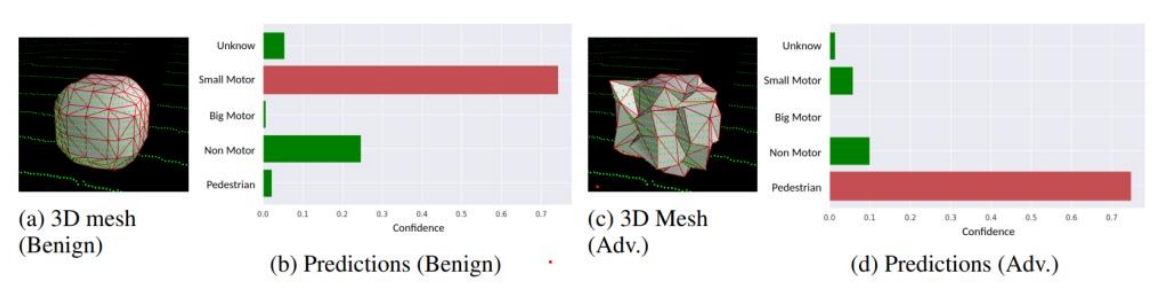

圖3 Evolution Adv攻擊效果可視化[4]

除去直接修改點云的方式以外,還有一種利用幾何變化的對抗性攻擊方法TSI[5],它的核心思想是通過利用三維幾何變換保持對抗性樣本在不同幾何條件下的有效性。在獲取點云后,TSI會對輸入的點云進行多次幾何變換,并在每次變換后通過優化調整對抗性擾動,使得每次變換后的樣本都能繼續誤導模型。通過使用最小化光譜范數作為評估攻擊前后的相似性,TSI能夠增強對抗性樣本的幾何魯棒性,確保它們在面對旋轉、平移等變換時依然能有效欺騙目標模型。這種方法在自動駕駛和機器人等應用場景中具有重要意義,因為它能夠處理動態的3D環境,并提高對抗性樣本的實用性。然而,TSI的計算復雜度和物理實現挑戰仍然是該方法需要進一步解決的問題。

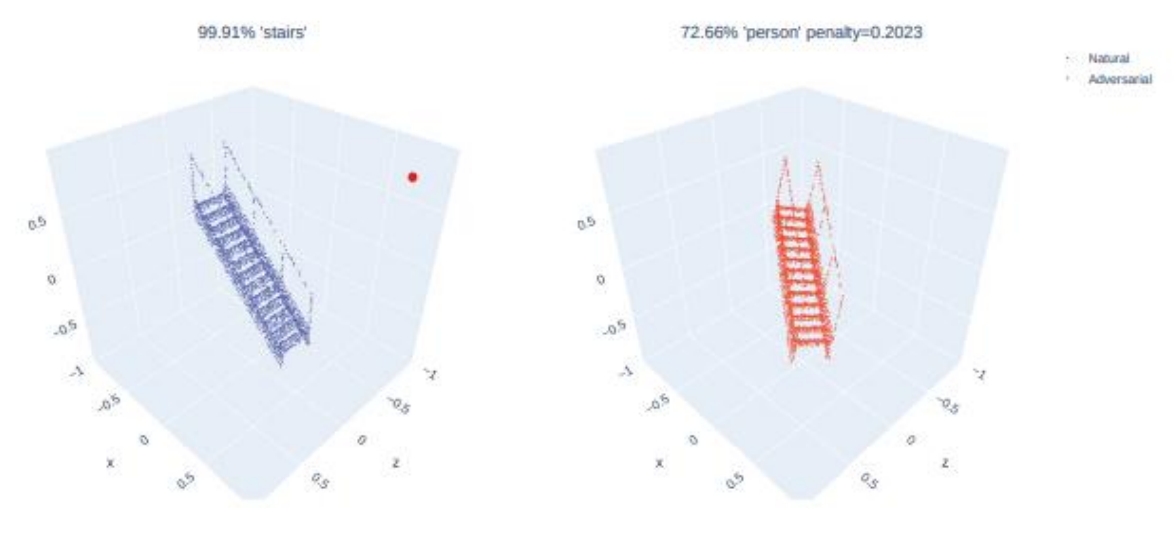

圖4 TSI攻擊可視化效果[5]

2.3 小結

在本章中,我們回顧了針對3D點云識別模型的幾種主要對抗性攻擊方法及其各自的特點和局限性。相較于2D圖像的對抗性攻擊,3D點云數據在無序性、稀疏性以及三維空間的幾何特性等方面增加了攻擊難度。3DAdv方法通過Chamfer距離保持幾何相似性,以解決點云無序性和稀疏性帶來的問題,但其高計算復雜度限制了應用的廣泛性;AdvPC基于生成對抗網絡生成對抗性點云,雖然具有較強的可遷移性和魯棒性,但在物理環境中的表現仍需進一步提升;EvolutionAdv利用進化算法生成對抗樣本,避免了白盒攻擊的限制,但在計算效率上存在不足;TSI通過幾何變換增強對抗樣本的魯棒性,在動態環境中表現出色,但也面臨著計算復雜度和物理實現的挑戰。

這些方法從不同角度出發解決了3D點云對抗性攻擊中的部分難題,但每種方法都有其適用的場景與限制。未來的研究可以進一步優化這些算法,以降低計算成本、提升對抗性樣本的魯棒性,并增強其在實際應用中的可操作性。在3D點云識別領域,對抗性攻擊的研究仍有廣闊的探索空間,這不僅能夠揭示模型的脆弱性,也為提高模型的安全性和魯棒性提供了方向。

03

總 結

雖然現今已經存在不少理論上可以對點云模型進行攻擊的對抗性算法,但這些算法在實際應用中仍然面臨諸多挑戰。首先,理論上的對抗性攻擊大多是在理想的實驗條件下實現的,實際環境中的復雜性和不確定性(如傳感器噪聲、動態光照條件、目標物體的多變性等)可能導致對抗樣本失效。特別是在自動駕駛場景中,車輛需要處理不斷變化的外部環境,對抗性樣本必須具備較強的魯棒性,才能在現實條件下誤導系統。

此外,物理可實現性仍是一個重要的瓶頸。許多對抗性攻擊算法是在數字空間中操作點云數據,而當這些擾動點云轉換到物理環境中(如激光雷達、相機等傳感器實際捕捉的物體),其攻擊效果可能會大打折扣。攻擊樣本必須經過調整,以確保在不同的物理傳感器和環境條件下仍能保留其對抗性。同時,點云數據的稀疏性和無序性也對攻擊算法的物理實現提出了新的挑戰,如何在物理世界中精確施加微小的擾動來影響3D點云仍然是一個未解決的問題。

其次,計算復雜度和資源消耗問題在實際應用中尤為突出。大多數對抗性攻擊算法需要經過多次迭代和優化,才能生成有效的對抗性樣本,這在計算資源有限或要求實時處理的自動駕駛應用中是一個巨大挑戰。例如,EvolutionAdv 等基于進化算法的方法,雖然在黑盒攻擊中表現優異,但其迭代過程復雜,生成對抗樣本所需的時間過長,難以滿足實時性要求。類似的,AdvPC 依賴于生成對抗網絡(GAN),雖然提高了對抗樣本的可遷移性和魯棒性,但GAN的訓練開銷巨大,尤其是在處理大規模3D點云數據時,計算資源需求較為龐大。

最后,3D點云對抗性攻擊的可解釋性與安全性依然是亟待解決的問題。對抗性攻擊的生成過程往往涉及復雜的數學優化和大量計算,使得對抗樣本的行為難以理解和預測。這種可解釋性缺失使得自動駕駛系統設計者難以預防攻擊,甚至在攻擊發生后也難以追溯根源。此外,在實際應用中,為了確保車輛和行人安全,必須在算法開發階段和模型部署前引入有效的防御機制。然而,現有防御方法在3D點云數據上效果有限,大多是針對2D圖像的算法簡單延伸,尚未針對3D點云特性設計出適應性強的防御策略。因此,盡管已有多種理論上的對抗性攻擊算法被提出來,如何在真實的自動駕駛場景中實現穩定有效的攻擊仍存在巨大挑戰。未來的研究可以集中在提高對抗性攻擊算法的物理可實現性、增強其魯棒性和可解釋性、以及設計更高效的計算方法上,以應對自動駕駛和其他應用場景中的實際需求。同時,研究社區也需要開發針對3D點云的專門防御策略,以在對抗性威脅下保護自動駕駛系統的安全和穩定性。

參考文獻:1. Goodfellow I J, Shlens J, Szegedy C. Explaining and harnessing adversarial examples[J]. arXiv preprint arXiv:1412.6572, 2014.2.Xiang C, Qi C R, Li B. Generating 3d adversarial point clouds[C], 2019.3.Hamdi A, Rojas S, Thabet A, et al. Advpc: Transferable adversarial perturbations on 3d point clouds[C], 2020. Springer.4.Cao Y, Xiao C, Yang D, et al. Adversarial objects against lidar-based autonomous driving systems[J]. arXiv preprint arXiv:1907.05418, 2019.5.Zhao Y, Wu Y, Chen C, et al. On isometry robustness of deep 3d point cloud models under adversarial attacks[C], 2020.

審核編輯 黃宇

-

雷達

+關注

關注

50文章

2897瀏覽量

117299 -

激光雷達

+關注

關注

967文章

3938瀏覽量

189593 -

自動駕駛汽車

+關注

關注

4文章

376瀏覽量

40814

發布評論請先 登錄

相關推薦

谷歌的自動駕駛汽車是醬紫實現的嗎?

[科普] 谷歌自動駕駛汽車發展簡史,都來了解下吧!

無人駕駛與自動駕駛的差別性

即插即用的自動駕駛LiDAR感知算法盒子 RS-Box

汽車防撞雷達的專家做進一步解讀特斯拉電動車的自動駕駛系統

自動駕駛汽車的定位技術

為什么網絡攻擊無法與自動駕駛相匹敵

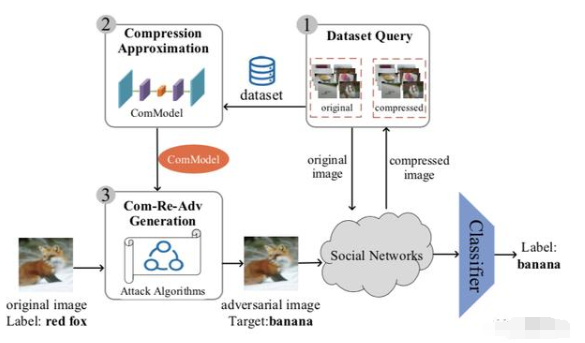

抗壓縮對抗框架ComReAdv:可讓人臉識別算法失效

如何應對自動駕駛的對抗性攻擊?

NVIDIA 自動駕駛實驗室:如何通過 AI 分割模型增強自動駕駛安全性

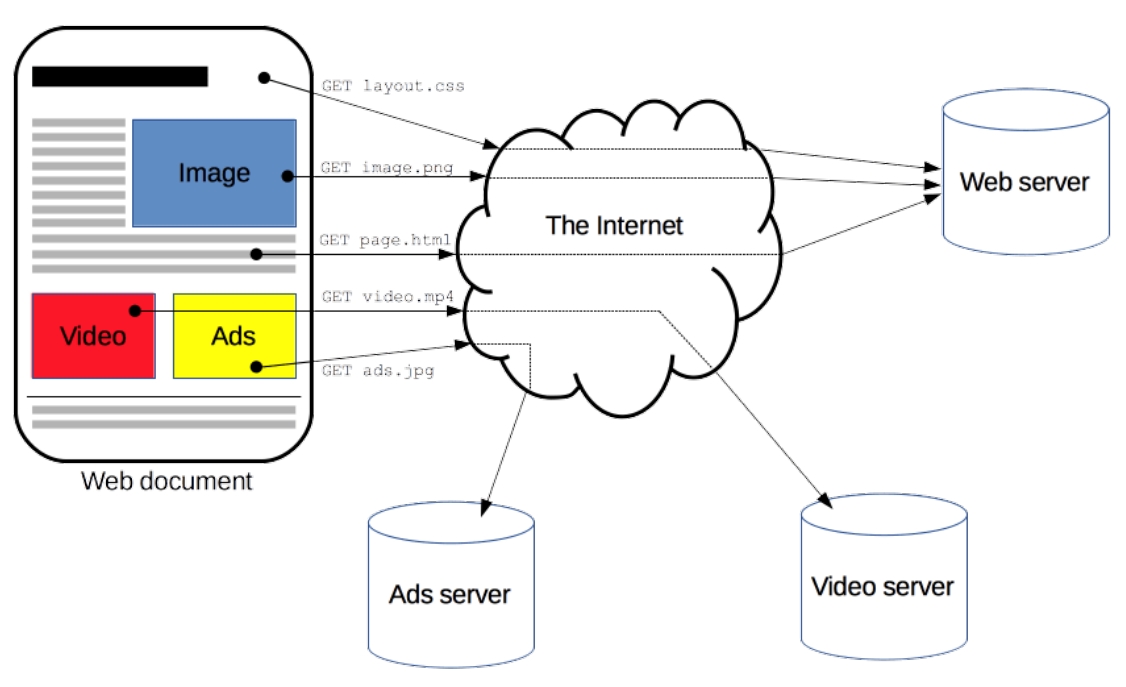

鑒源實驗室·HTTP協議網絡安全攻擊

鑒源實驗室·如何通過雷達攻擊自動駕駛汽車-針對點云識別模型的對抗性攻擊的科普

鑒源實驗室·如何通過雷達攻擊自動駕駛汽車-針對點云識別模型的對抗性攻擊的科普

評論