作者 / 高級開發者關系工程師 Kateryna Semenova 和高級產品經理 Mark Sherwood

在 "AI on Android Spotlight Week" 期間,我們深入探討了如何將自己的 AI 模型引入 Android 設備,如手機、平板電腦等。通過利用 Google 和其他來源的工具與技術,您可以直接在這些設備上運行復雜的 AI 模型,以實現更出色的性能、更好的隱私性和更高的可用性,創造激動人心的可能性。

了解設備端 AI

設備端 AI 不依賴基于云服務器,而是直接在硬件設備上部署和運行機器學習或生成式 AI 模型。此方法具有幾項優勢,例如降低延遲、強化隱私、節約成本,以及減少了對互聯網連接的依賴。

對于生成文本用例,請探索 Gemini Nano;用戶現在可以通過 Gemini Nano 的 SDK 進行實驗性訪問。對于許多設備端 AI 用例,您可能想要在應用中打包自己的模型。我們將在本文介紹如何在 Android 上實現此操作。

設備端 AI 的核心資源

Google AI Edge 平臺為在邊緣設備上構建和部署 AI 模型提供了一個全面的生態系統。此平臺支持各種框架和工具,能讓開發者將 AI 功能無縫集成到應用中。Google AI Edge 平臺包括:

MediaPipe Tasks - 跨平臺低代碼 API,用于處理常見的生成式 AI、視覺、文本和音頻任務

LiteRT (前身為 TensorFlow Lite) - 用于在 Android 上部署自定義機器學習模型的輕量級運行時

MediaPipe Framework - 用于將多個機器學習模型與預處理和后處理邏輯高效鏈接在一起的流水線框架

Model Explorer - 轉換、性能和調試可視化工具

如何在 Android 上構建

自定義 AI 功能

1. 定義您的用例: 在深入研究技術細節之前,明確定義您希望 AI 功能實現的目標非常重要。無論您致力于開發圖像分類、自然語言處理還是其他應用,擁有明確的目標將為您的開發進程指明方向。

2. 選擇合適的工具和框架: 根據您的用例,您或許可以使用開箱即用的解決方案,也可能需要創建或獲取自己的模型。通過 MediaPipe Tasks 查看常見的解決方案,如手勢識別、圖像分割或面部特征點檢測。如果您找到符合需求的解決方案,可以直接進入測試和部署步驟。

如果您需要為用例創建或獲取自定義模型,則需要一個設備端機器學習框架,例如 LiteRT (前身為 TensorFlow Lite)。LiteRT 專為移動和邊緣設備設計,為部署機器學習模型提供了輕量級運行時。只需按照以下子步驟操作:

開發和訓練模型: 使用您選擇的框架開發 AI 模型。訓練可以在功能強大的機器或云環境中執行,但模型應針對設備上的部署進行優化。量化和剪枝等技術可以幫助縮小模型尺寸并提高推理速度。Model Explorer 可以幫助您在使用模型的同時理解和探索該模型。

轉換和優化模型: 當您的模型訓練好后,就可以將其轉換為適合設備端部署的格式。例如,LiteRT 需要將其轉換為特定格式。優化工具可以幫助減少模型的占用空間并提升其性能。AI Edge Torch 允許您使用 Google AI Edge LiteRT 和 MediaPipe Tasks 庫來轉換 PyTorch 模型,使其能在 Android 和其他平臺上本地運行。

加速模型: 您可以使用 GPU 和 NPU,為 Android 上的模型推理加速。借助 LiteRT 的 GPU 代理,您可以立即在 GPU 上運行您的模型。我們正在努力構建下一代 GPU 和 NPU 代理,使您的模型運行得更快,并支持更多模型在 GPU 和 NPU 上運行。我們誠邀您參與我們的搶先體驗計劃,以試用這一新的 GPU 和 NPU 基礎設施。我們將會陸續邀請參與者搶先體驗,即刻聯系我們參與體驗吧!

3. 測試和部署: 為了確保您的模型在各種設備上都能實現預期的性能,嚴格的測試至關重要。完成測試后,即可向用戶部署您的應用,為他們提供無縫且高效的 AI 體驗。我們正在努力讓 Google Play 和 Android App Bundle 發揮其優勢,以便更好地為設備端 AI 功能提供自定義機器學習模型。Play for On-device AI 簡化了啟動、定位、版本控制、下載和更新設備端模型的復雜程度,從而為用戶提供更好的使用體驗,同時不會影響應用的大小,也不會增加成本。如有興趣加入 Play for On-device AI 搶先體驗計劃,您可以填寫表格。

通過隱私性和透明度

建立對 AI 的信任

隨著 AI 在日常生活中發揮的作用日益增強,確保模型在設備上按預期運行至關重要。我們強調 "零信任" 方法,為開發者提供工具來驗證設備完整性和用戶對其數據的控制。在零信任方法中,開發者需要能夠對設備的可信度做出明智決策。

我們推薦開發者使用 Play Integrity API,來驗證應用、服務器請求和設備環境。您可以在應用后端決定下載并運行模型之前的重要時刻調用 API。還可以考慮啟用在安裝應用時進行完整性檢查,以減少應用被分發到未知和不受信任的環境中。

Play Integrity API 利用 Android 平臺密鑰認證來驗證硬件組件,并在整個設備群中生成完整性判定,從而使大多數開發者不再需要直接集成不同的認證工具,降低了設備生態系統的復雜性。在決定是否信任設備運行 AI 模型之前,開發者可以使用其中一個或兩個工具來評估設備安全性和軟件完整性。

結論

將您的 AI 模型引入設備涉及多個步驟,包括定義用例、部署和測試模型等。借助 Google AI Edge 等資源,開發者可以使用強大的工具和洞察,使過程更順暢、更高效。隨著設備端 AI 的不斷發展,您將能夠利用這些資源,創建先進的應用,提供更好的性能、隱私性和用戶體驗。我們目前正在尋找搶先體驗的合作伙伴,在 Google AI Edge 中試用我們的一些最新工具和 API。填寫表格聯系我們,即刻了解我們該如何共同努力,以實現您的愿景。

-

Android

+關注

關注

12文章

3923瀏覽量

127133 -

AI

+關注

關注

87文章

30135瀏覽量

268411 -

模型

+關注

關注

1文章

3172瀏覽量

48711 -

機器學習

+關注

關注

66文章

8377瀏覽量

132407

原文標題:如何輕松將 AI 模型引入 Android 設備

文章出處:【微信號:Google_Developers,微信公眾號:谷歌開發者】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

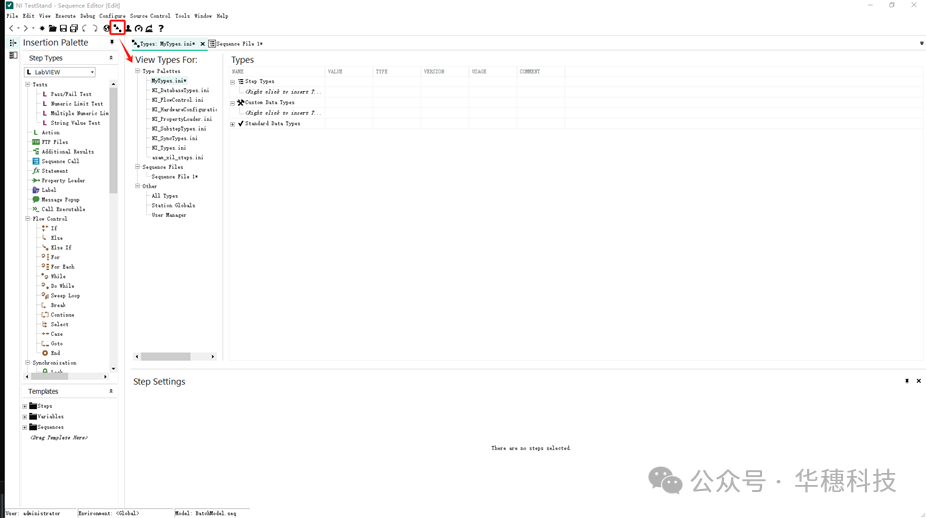

如何創建TestStand自定義步驟

NVIDIA AI Foundry 為全球企業打造自定義 Llama 3.1 生成式 AI 模型

如何通過SDK功能獲取esptouch v2 apk的自定義數據?

如何為ESP8266構建自定義盾牌?

如何在IDF框架中使用自定義的靜態庫和動態庫?

Chrome移動版支持自定義菜單欄功能

TSMaster 自定義 LIN 調度表編程指導

鴻蒙ArkUI實例:【自定義組件】

博途用戶自定義庫的使用

基于YOLOv8的自定義醫學圖像分割

如何在Android上構建自定義AI功能

如何在Android上構建自定義AI功能

評論