在深度學習的領域中,前向傳播、反向傳播和損失函數是構建和訓練神經網絡模型的三個核心概念。今天,小編將通過一個簡單的實例,解釋這三個概念,并展示它們的作用。

前向傳播:神經網絡的“思考”過程

前向傳播是神經網絡計算的基礎步驟,它涉及將輸入數據逐層傳遞,通過神經網絡的權重和激活函數,最終輸出預測結果。這個過程包含“樣本數據輸入、算法模型、輸出”這幾個步驟。

我們來舉個簡單的例子,比如給一個小寶寶看一張圖片,然后問他:“這上面畫的是什么?”他就會用他的小腦袋瓜去“思考”這張圖片,然后告訴你答案。前向傳播就像是這個過程,只不過小寶寶換成了神經網絡。

- 樣本數據輸入:這一步將圖像、文字、語音等樣本數據轉換為我們電腦能識別的數字輸入。就像小寶寶看到圖片,神經網絡也接收到一張圖片,這張圖片被轉換成一串數字。

- 算法模型:簡單來說,就是一些數學計算,主要包含線性層+規則化層+激活,線性層負責做線性函數的擬合;規則化層負責把我們的線性擬合規則化,方便后面的計算;激活層負責的是變成非線性化,因為我們的現實世界是非線性的。所以整個過程就是:我們輸入的樣本是非線性的,我們通過這樣一堆數學公式,去擬合非線性的樣本數據。

- 輸出層:也是一些數學運算,比如Linear或者Conv,負責將模型的輸出轉換為預測結果輸出。

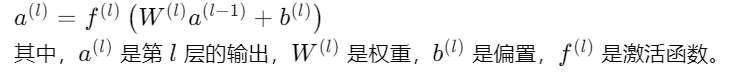

這個過程可以用下面的數學公式表示:

損失函數:告訴神經網絡它錯了多少

損失函數是衡量模型預測結果與真實標簽之間差距的依據,它的核心作用是告訴我們模型的預測結果“錯”得有多離譜。通俗來說,損失函數就像是一個裁判,它給模型的預測結果打分,分數越低,說明模型的預測結果越接近真實情況,模型的性能就越好。損失函數是為了讓我們反向傳播起作用的。就像如果小寶寶猜錯了,你會告訴他:“不對哦,這是數字8,不是3。”損失函數就像是這句話,它告訴神經網絡:“嘿,你的答案有點偏差。”

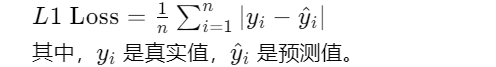

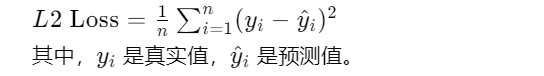

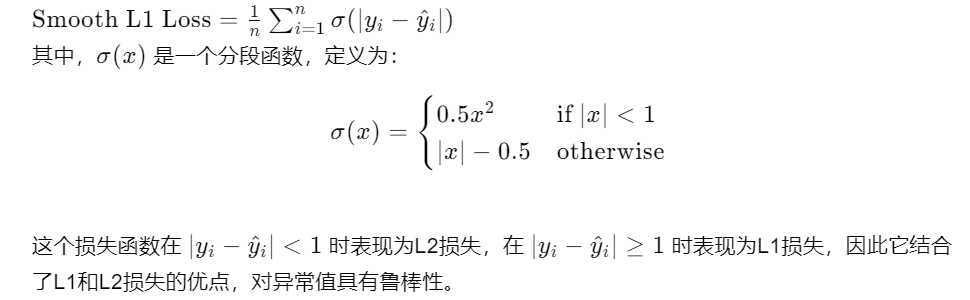

下面是幾種常用的損失函數:

L1 Loss(MAE):平均絕對誤差,對異常值的容忍性更高,但當梯度下降恰好為0時無法繼續進行。就像是你告訴小寶寶:“你的答案差了多遠。”這個距離就是損失值。

L2 Loss(MSE):均方誤差,連續光滑,方便求導,但易受到異常值的干擾。這就像是你告訴小寶寶:“你的答案差了多少個單位。”這個單位的平方和就是損失值。

Smooth L1 Loss:處理異常值更加穩健,同時避免了L2 Loss的梯度爆炸問題。就像是你告訴小寶寶:“你的答案差了多遠,但我不會因為你猜得特別離譜就懲罰你。”這個損失函數對極端錯誤更寬容。

反向傳播:神經網絡的“自我修正”過程

反向傳播是利用損失函數的梯度來更新網絡參數的過程。它從輸出層開始,逆向通過網絡,利用鏈式法則計算每個參數對損失函數的梯度。包含這幾個過程:

- 計算輸出層誤差梯度:首先計算輸出層的誤差梯度,這是損失函數對輸出層權重的敏感度。

- 逐層反向傳播:然后從輸出層開始,逆向通過網絡,逐層計算誤差梯度。

- 更新權重和偏置:使用梯度下降算法,根據計算出的梯度更新網絡中每一層的權重和偏置。

所以前向傳播、反向傳播、損失函數之間的關系是這樣的:

他們都是深度學習訓練過程中的核心。前向傳播負責生成預測結果,損失函數負責量化預測結果與真實標簽之間的差異,而反向傳播則負責利用這些差異來更新模型參數,以減少損失函數的值。

通過三者的結合,我們可以構建、訓練并優化深度學習模型,使其能夠從數據中學習復雜的模式,并在各種任務如圖像識別、自然語言處理和預測分析中做出準確的預測。

前向傳播、反向傳播、損失函數屬于機器學習領域中的核心概念,在AI全體系課程中,是理解其他更復雜機器學習算法的基礎,掌握這幾個概念對于深入學習機器學習、理解更高級的算法以及在實際應用中設計和優化模型都具有重要的意義。通過理解前向傳播、反向傳播和損失函數,學習者能夠更好地把握機器學習模型的工作原理,為進一步探索深度學習和其他高級機器學習技術打下堅實的基礎。

在人工智能算法的學習過程中,你會接觸到各種各樣的算法,包括機器學習、深度學習、計算機視覺、自然語言處理等方向的各類算法。但機器學習算法,一直都是通用算法基礎。我們機器學習課程里,會重點講解2012年后的深度學習的通用結構,線性+激活來逼近所有系統為基礎,幫助學習者搭建這個過程中所有的通用性知識與原理,拓展更多機器學習和AI全棧技術學習可參考下方學習路線圖。

AI體系化學習路線

學習資料免費領

AI全體系學習路線超詳版+AI體驗卡(AI實驗平臺體驗權限)+100余講AI視頻課程+項目源碼《從零開始訓練與部署YOLOV8》+170余篇AI經典論文

-

神經網絡

+關注

關注

42文章

4762瀏覽量

100535 -

AI

+關注

關注

87文章

30106瀏覽量

268398 -

機器學習

+關注

關注

66文章

8377瀏覽量

132405 -

深度學習

+關注

關注

73文章

5492瀏覽量

120975

發布評論請先 登錄

相關推薦

【每天學點AI】前向傳播、損失函數、反向傳播

【每天學點AI】前向傳播、損失函數、反向傳播

評論