近年來,在AIoT數(shù)據(jù)量快速成長、硬件效能提升、綠色低碳意識抬頭等趨勢影響下,邊緣AI應(yīng)用的系統(tǒng)架構(gòu)也出現(xiàn)改變。隨著越來越多企業(yè)將AI模型訓(xùn)練由云端轉(zhuǎn)移至邊緣端,邊緣AI服務(wù)器(Edge AI Server)的市場需求快速擴(kuò)大。

過往,企業(yè)大多會先在云端進(jìn)行AI模型訓(xùn)練,再將訓(xùn)練好的模型部署到邊緣端,由邊緣裝置進(jìn)行模型推論,并定期將終端數(shù)據(jù)及預(yù)測結(jié)果傳回云端。如今,隨著硬件技術(shù)更新迭代,邊緣裝置的運(yùn)算量能愈來愈強(qiáng),可以滿足AI模型訓(xùn)練的運(yùn)算需求,再加上AIoT數(shù)據(jù)量快速成長,大幅增加數(shù)據(jù)由邊緣端傳輸?shù)皆贫说某杀荆率蛊髽I(yè)開始思索「在邊緣端進(jìn)行AI模型訓(xùn)練的可行性」。對此,研華整合軟硬體及服務(wù)打造完整的邊緣AI服務(wù)器解決方案,協(xié)助企業(yè)資金更有效率地導(dǎo)入AI技術(shù)。

01AI模型訓(xùn)練在云端還是邊緣?

研華嵌入式物聯(lián)網(wǎng)事業(yè)群產(chǎn)品經(jīng)理郭佑伸建議,企業(yè)可以根據(jù)AI應(yīng)用類型與AI模型參數(shù)大小、數(shù)據(jù)量、數(shù)據(jù)的機(jī)密等級等因素,決定是要在云端或邊緣端進(jìn)行AI模型訓(xùn)練。如果AI模型參數(shù)較大,邊緣端的運(yùn)算能力不足,導(dǎo)致進(jìn)行AI模型微調(diào)訓(xùn)練所耗費(fèi)的時間過長,就比較適合放在云端高速運(yùn)算。另外,若企業(yè)用來訓(xùn)練AI模型的數(shù)據(jù)屬于重要機(jī)密,便不適合上傳到云端,又或者AI模型微調(diào)訓(xùn)練的數(shù)據(jù)太大致使傳輸至云端的成本過高,就可以通過邊緣端設(shè)備進(jìn)行AI數(shù)據(jù)預(yù)處理(Data Mining)或AI微調(diào)模型訓(xùn)練(Finetune)。

以生成式AI應(yīng)用為例,企業(yè)除了發(fā)展客服機(jī)器人來服務(wù)客戶,也開始結(jié)合知識管理系統(tǒng)、機(jī)臺維修手冊等數(shù)據(jù)用來優(yōu)化員工作業(yè)效率,如:加快資料檢索速度、協(xié)助新進(jìn)工程師快速進(jìn)入工作等。由于內(nèi)部資料有機(jī)密性,通常不適合上傳到云端,企業(yè)便可在邊緣端部署邊緣AI服務(wù)器來進(jìn)行大型語言模型(LLM)微調(diào)訓(xùn)練。

另一方面,當(dāng)企業(yè)微調(diào)訓(xùn)練生成式AI(GenAI)的大型語言模型(LLM)時,會消耗相當(dāng)大量的內(nèi)存(VRAM),若VRAM內(nèi)存容量不足,將產(chǎn)生無法進(jìn)行LLM模型微調(diào)訓(xùn)練的問題,最終需要再額外添購更多專用顯示卡來擴(kuò)充VRAM容量,對企業(yè)而言是高成本的負(fù)擔(dān)。因此,如何降低不斷成長的生成式AI模型參數(shù)所需的VRAM擴(kuò)充成本并兼顧數(shù)據(jù)安全保密性便是生成式AI應(yīng)用能否快速普及的關(guān)鍵。

02硬件、軟件、服務(wù),三大面向打造整體解決方案

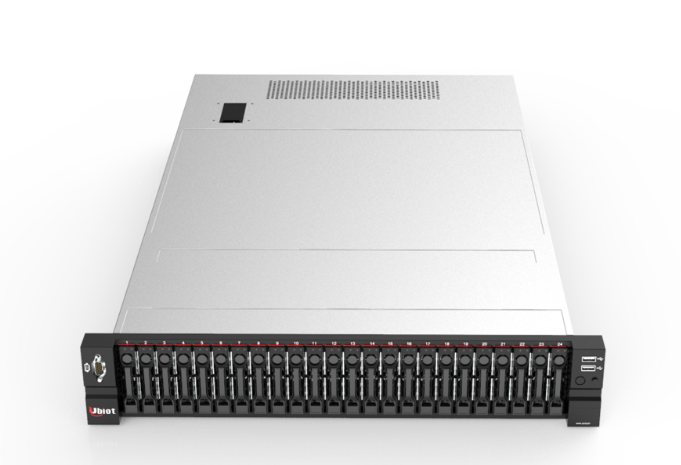

為滿足企業(yè)在邊緣端進(jìn)行AI模型訓(xùn)練與推論的需求,研華除了研發(fā)AIR-500系列邊緣AI服務(wù)器,提供高頻高效能的硬件設(shè)備,更結(jié)合軟件與服務(wù),從三大面向打造一站式邊緣AI應(yīng)用解決方案,一次滿足企業(yè)的各種需求,加速企業(yè)導(dǎo)入AI應(yīng)用。

03多種硬件規(guī)格,滿足多產(chǎn)業(yè)的AI應(yīng)用需求

AIR-500系列是針對邊緣端高性能AI推理與特定大小參數(shù)AI模型微調(diào)訓(xùn)練的應(yīng)用需求而設(shè)計(jì),除了滿足工控市場基本要求的系統(tǒng)EMC測試與安規(guī)認(rèn)證,亦提供10年長供貨保證。此外,針對AI高速運(yùn)算時產(chǎn)生的熱能,研華特別加強(qiáng)散熱設(shè)計(jì),確保在環(huán)境溫度40℃以內(nèi)穩(wěn)定運(yùn)作,避免超過AI加速卡的最高工作溫度,同時提供適合應(yīng)用在被動式散熱AI加速卡專用的散熱風(fēng)扇模塊,讓企業(yè)無論采用哪一種AI加速卡,都不必?fù)?dān)心會有過熱而降頻的問題,確保設(shè)備運(yùn)作性能最大化。

產(chǎn)品經(jīng)理郭佑伸指出,AIR-500系列產(chǎn)品提供510、520及530三種規(guī)格。其中AIR-520是研華首度將服務(wù)器等級芯片平臺導(dǎo)入至邊緣系統(tǒng),它能額外擴(kuò)充最多4張單槽顯卡或2張雙槽顯卡,具備相當(dāng)強(qiáng)大的AI運(yùn)算能力,整合群聯(lián)“aiDAPTIV+”技術(shù),最高可以支持大型語言模型LLaMA2 70B的地端微調(diào)訓(xùn)練,滿足企業(yè)在邊緣端進(jìn)行AI模型訓(xùn)練的需求。

群聯(lián)獨(dú)家專利的AI人工智慧運(yùn)算方案“aiDAPTIV+”,是通過群聯(lián)獨(dú)創(chuàng)整合SSD的AI運(yùn)算構(gòu)架,將大型AI模型做結(jié)構(gòu)性拆分,并將模型參數(shù)隨應(yīng)用時間序列與SSD協(xié)同運(yùn)行,以達(dá)到在有限的GPU與VRAM資源下,最大化可執(zhí)行的AI模型,能發(fā)揮既有硬件構(gòu)架下的最大效益。

AIR-530可進(jìn)行大量高速的數(shù)據(jù)傳輸,通過NVIDIA SmartNIC芯片可將網(wǎng)絡(luò)頻寬拉高至200 GbE,適合高速數(shù)據(jù)串流的AI應(yīng)用,例如:醫(yī)療內(nèi)視鏡系統(tǒng)、布建多臺監(jiān)控?cái)z像機(jī)的場域等。AIR-510提供豐富的I/O接口,適合需要整合多元裝置的AI應(yīng)用,例如半導(dǎo)體設(shè)備的光學(xué)檢測機(jī)、物流業(yè)的包裹分檢機(jī)等。

04結(jié)合軟件與服務(wù),加速企業(yè)導(dǎo)入

AI應(yīng)用軟件方面,研華也針對AI應(yīng)用需求代理相關(guān)軟件,如:Intel針對模型訓(xùn)練的輔助工具Intel Geti、NVIDIA針對AI算法開發(fā)的最佳化服務(wù)NVIDIA AI Enterprise,可協(xié)助企業(yè)打造完整的Edge AI應(yīng)用環(huán)境。

服務(wù)方面更是涵蓋全方面。首先,研華在全球各地設(shè)立的服務(wù)中心,可以根據(jù)在地客戶需求提供服務(wù),如彈性調(diào)整設(shè)備規(guī)格。其次,研華提供完整技術(shù)支持,如企業(yè)可向研華購買CPU、DRAM、SSD、顯卡等周邊元件,也可以由研華協(xié)助安裝Windows、Ubuntu等操作系統(tǒng),讓企業(yè)收到設(shè)備后插電就能使用。再者,研華一直與芯片商緊密合作,可以在第一線提供客戶技術(shù)顧問服務(wù),如今更成為中國臺灣IPC產(chǎn)業(yè)第一家獲得NVIDIA AI Enterprise軟件平臺認(rèn)證的全球經(jīng)銷商,研華計(jì)劃培育近200名邊緣AI應(yīng)用專家,期能建立更強(qiáng)大的技術(shù)支持,從更多方面協(xié)助客戶導(dǎo)入AI應(yīng)用。

展望未來,AIR-500系列產(chǎn)品的發(fā)展將依循研華“產(chǎn)業(yè)驅(qū)動”(Sector-Driven)策略,依照各產(chǎn)業(yè)的特殊需求開發(fā)相關(guān)功能并直接內(nèi)嵌于產(chǎn)品之中,甚至推出產(chǎn)業(yè)專用機(jī),讓各行各業(yè)都能快速部署AI應(yīng)用,大步邁向AIoT的新時代。

-

服務(wù)器

+關(guān)注

關(guān)注

12文章

9029瀏覽量

85205 -

AI

+關(guān)注

關(guān)注

87文章

30238瀏覽量

268471 -

研華

+關(guān)注

關(guān)注

0文章

362瀏覽量

38519

原文標(biāo)題:技術(shù)分享 | 邊緣AI服務(wù)器引發(fā)新浪潮:從云端到邊緣的轉(zhuǎn)型

文章出處:【微信號:研華智能地球,微信公眾號:研華智能地球】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

研華科技邊緣AI平臺榮獲2024年IoT邊緣計(jì)算卓越獎

研華科技亮相2024中國工博會

研華科技與瞰瞰智能合作打造先進(jìn)影像系統(tǒng)解決方案

研華科技攜手森云智能助力邊緣AI應(yīng)用落地

智能邊緣服務(wù)器 --開啟計(jì)算新時代

研華軟硬整合攜手打造邊緣AI生態(tài)圈

凌華智能推出全新AI 邊緣服務(wù)器MEC-AI7400 (AI Edge Server)系列

網(wǎng)宿科技正式揭曉其邊緣AI網(wǎng)關(guān)服務(wù)的創(chuàng)新

ai服務(wù)器是什么架構(gòu)類型

耐能推出最新的邊緣AI服務(wù)器及內(nèi)置耐能AI芯片的PC設(shè)備

研華攜手群聯(lián) 共同打造邊緣運(yùn)算與工控應(yīng)用生成式AI平臺

萊特波特與研華科技利用無線設(shè)計(jì)服務(wù)改變物聯(lián)網(wǎng)裝置無線連接方式

研華科技宣布與高通技術(shù)公司達(dá)成戰(zhàn)略合作,共創(chuàng)邊緣智能新未來

研華攜手Hailo,擴(kuò)展高算力邊緣 AI 產(chǎn)品組合

研華科技打造整體邊緣AI服務(wù)器解決方案

研華科技打造整體邊緣AI服務(wù)器解決方案

評論