NVIDIA CUDA-Q 平臺使谷歌量子 AI 研究人員能夠為其量子計算機創建大規模的數字模型,以解決設計中面臨的各種挑戰

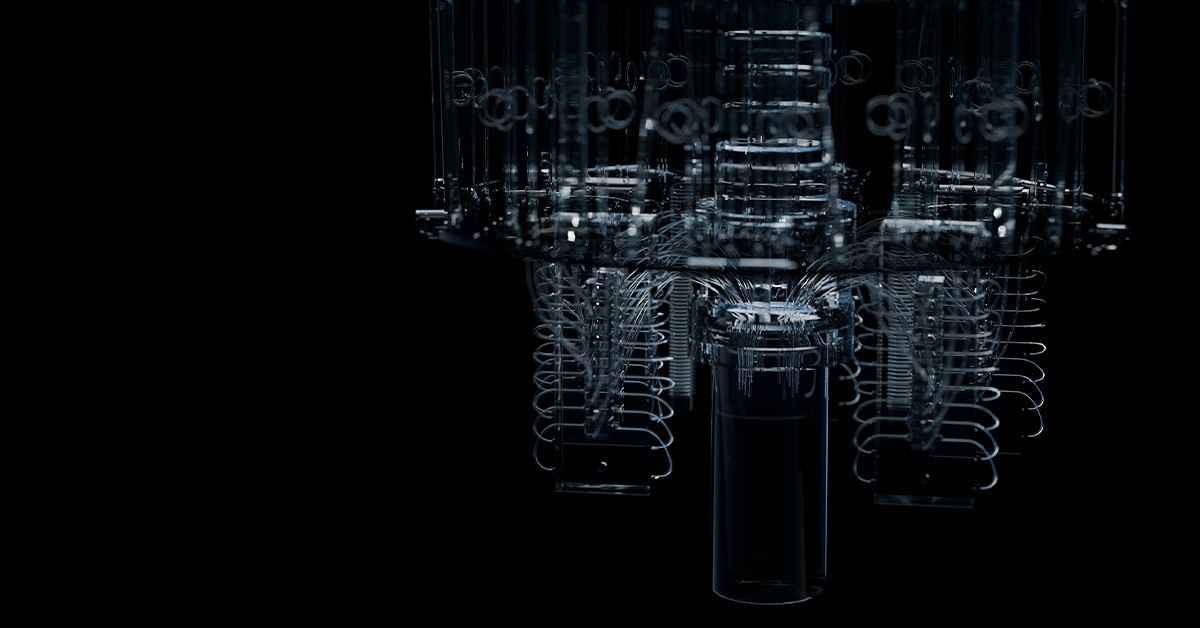

NVIDIA 于今日宣布正在與谷歌量子 AI 合作,使用 NVIDIA CUDA-Q 平臺進行模擬,加快下一代量子計算器件的設計工作。

谷歌量子 AI 正在使用量子-經典混合計算平臺和 NVIDIA Eos 超級計算機,來模擬其量子處理器的物理特性。這將有助于克服量子計算硬件當前的一些局限,即量子計算硬件只能運行一定數量的量子運算,然后由于存在研究人員稱之為“噪聲”的現象就必須終止計算。

谷歌量子 AI 的研究科學家 Guifre Vidal 表示:“要想開發出商用的量子計算機,就必須能夠在控制噪聲的情況下擴展量子硬件規模。借助 NVIDIA 加速計算,我們正在探索越來越大的量子芯片設計中噪聲的影響。”

理解量子硬件設計中的噪聲需要進行復雜的動態模擬,以便充分了解量子處理器內的量子比特是如何與周圍環境相互作用的。

過去,這些模擬的計算成本高得令人望而卻步。借助 CUDA-Q 平臺,谷歌可以在 NVIDIA Eos 超級計算機上使用 1024 個 NVIDIA Hopper Tensor Core GPU,以極低的成本進行世界上最大、最快的量子器件動態模擬。

NVIDIA 量子和高性能計算總監 Tim Costa 表示:“強大的 AI 超級計算有助于量子計算取得成功。谷歌對 CUDA-Q 平臺的使用展現了 GPU 加速的模擬在推進量子計算方面發揮了核心作用,它將幫助解決現實世界中的許多問題。”

借助 CUDA-Q 和 Hopper GPU,谷歌可以對包含 40 個量子比特的器件進行逼真的全面模擬,這是同類模擬中規模最大的。通過 CUDA-Q 提供的模擬技術,原本需要一周時間完成的噪聲模擬現在只需要幾分鐘就能完成。

驅動這些加速動態模擬的軟件將公開發布在 CUDA-Q 平臺上,使量子硬件工程師能夠快速地擴展他們的系統設計。

-

谷歌

+關注

關注

27文章

6141瀏覽量

105087 -

NVIDIA

+關注

關注

14文章

4935瀏覽量

102806 -

AI

+關注

關注

87文章

30106瀏覽量

268399

原文標題:SC24 | NVIDIA 助力谷歌量子 AI 通過量子器件物理學模擬加快處理器設計

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

英偉達與谷歌聯手加速量子計算設備設計

英偉達與谷歌攜手加速量子計算設備設計

英偉達攜手谷歌,共筑量子計算新篇章

NVIDIA 助力谷歌量子 AI 通過量子器件物理學模擬加快處理器設計

NVIDIA與谷歌量子AI部門達成合作

NVIDIA與谷歌量子AI部門達成合作

評論