本文簡要介紹了經典圖神經網絡(GNNs)的基準分析研究,發表在 NeurIPS 2024。

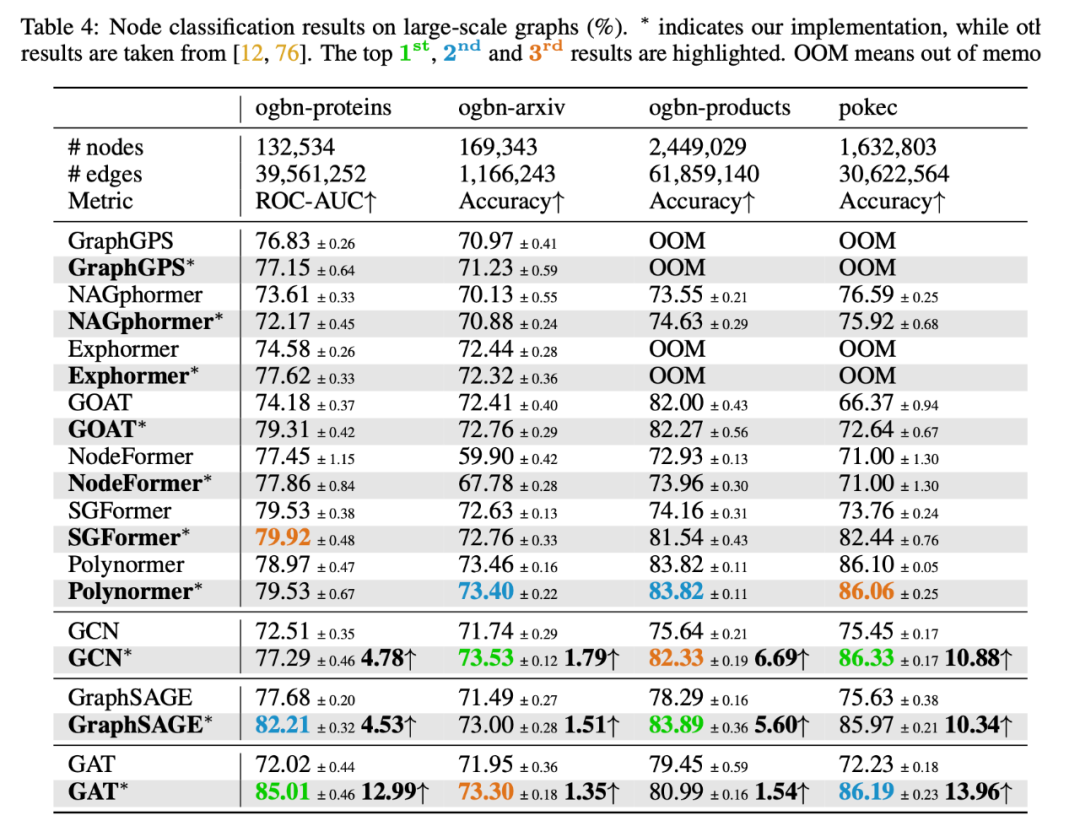

文章回顧了經典 GNNs 模型在節點分類任務上的表現,結果發現過去 SOTA 圖學習模型報告的性能優越性可能是由于經典 GNNs 的超參數配置不佳。通過適當的超參數調整,經典 GNNs 模型在 18 個廣泛使用的節點分類數據集中的 17 個上超越了最新的圖學習模型。本研究旨在為 GNNs 的應用和評估帶來新的見解。

論文題目:Classic GNNs are Strong Baselines: Reassessing GNNs for Node Classification

論文鏈接:

https://arxiv.org/abs/2406.08993

代碼鏈接:

https://github.com/LUOyk1999/tunedGNN

引言節點分類是圖機器學習中的一個基本任務,在社交網絡分析、生物信息學和推薦系統等多個領域中具有廣泛的高影響力應用。圖神經網絡(GNNs)已成為解決節點分類任務的強大模型。 GNNs 通過迭代地從節點的鄰居中聚合信息,這一過程被稱為消息傳遞,利用圖結構和節點特征來學習有用的節點表示進行分類。盡管 GNNs 取得了顯著的成功,但研究指出它們存在一些局限性,包括過度平滑、過度壓縮、對異質性缺乏敏感性以及捕獲長距離依賴的挑戰。 最近,Graph Transformer(GTs)作為 GNN 的替代模型受到越來越多的關注。與主要聚合局部鄰域信息的 GNNs 不同,Transformer 架構通過自注意力層可以捕獲任意節點對之間的交互。GTs 在圖級任務(如涉及小規模圖的分子圖分類)上取得了顯著成功。 這一成功激發了嘗試將 GTs 應用于節點分類任務的努力,特別是在大規模圖上,以應對 GNNs 的上述局限性。盡管最新的 GTs 取得了令人鼓舞的成果,但觀察到許多此類模型在顯性或隱性層面上仍然依賴于消息傳遞來學習局部節點表示,將其與全局注意力機制結合以獲得更全面的表示。 這促使我們重新思考:消息傳遞 GNNs 在節點分類中的潛力是否被低估了?雖然已有研究在一定程度上解決了這一問題,但這些研究在范圍和全面性上仍存在局限性,例如數據集數量和多樣性有限,以及超參數的考察不完整。 在本研究中,我們全面重新評估了 GNNs 在節點分類中的表現,使用了三種經典的 GNNs 模型—— GCN、GAT和 GraphSAGE ——并在 18 個真實世界的基準數據集上進行了測試,包括同質性、異質性和大規模圖。 我們考察了 GNNs 訓練中的關鍵超參數對其性能的影響,包括 normalization、dropout、residual connections 和 network depth。主要發現總結如下:

經過適當的超參數調整,經典 GNNs 在同質性和異質性圖中的節點分類任務中均能取得高度競爭力的性能,甚至在節點數量達百萬量級的大規模圖上也是如此。值得注意的是,經典 GNNs 在 18 個數據集中有 17 個超越了最先進的圖學習模型,表明 GTs 對比 GNNs 所宣稱的優勢可能是由于在 GNNs 評估中超參數配置不佳

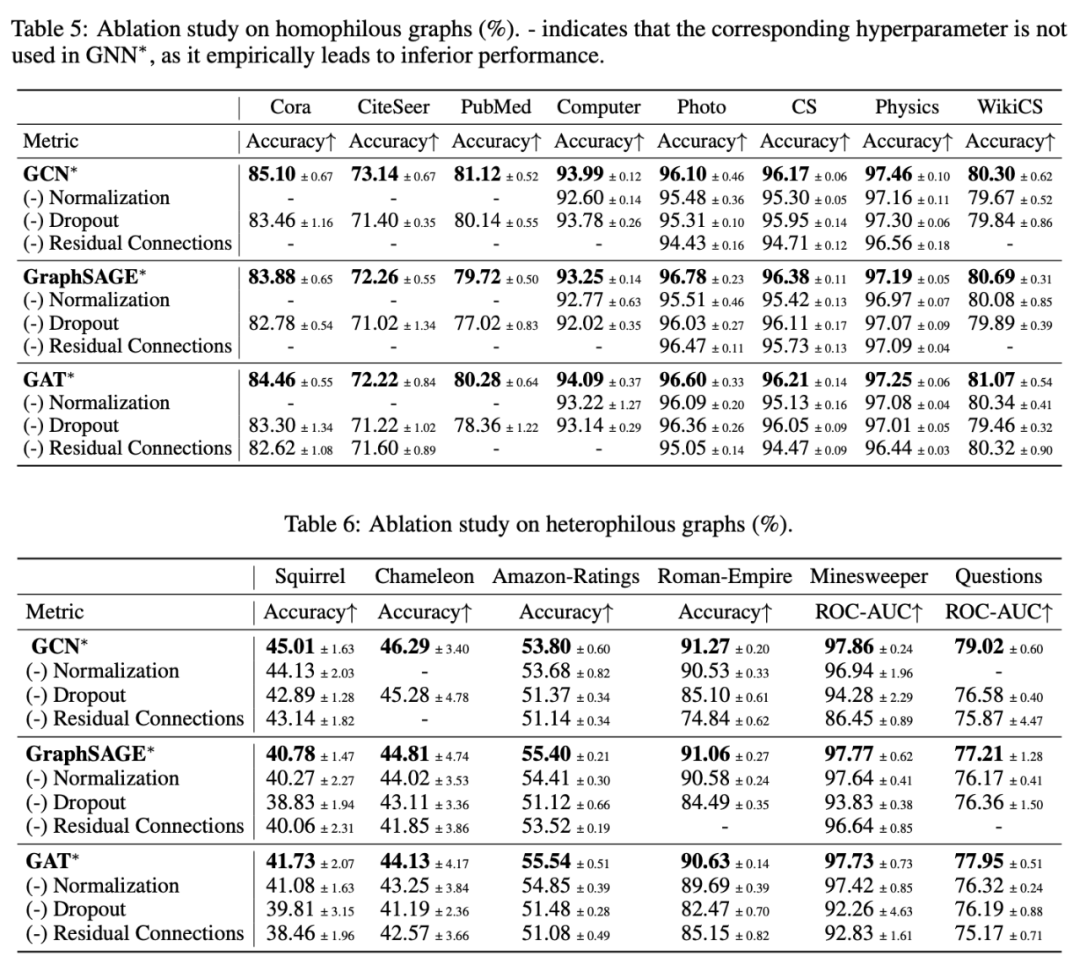

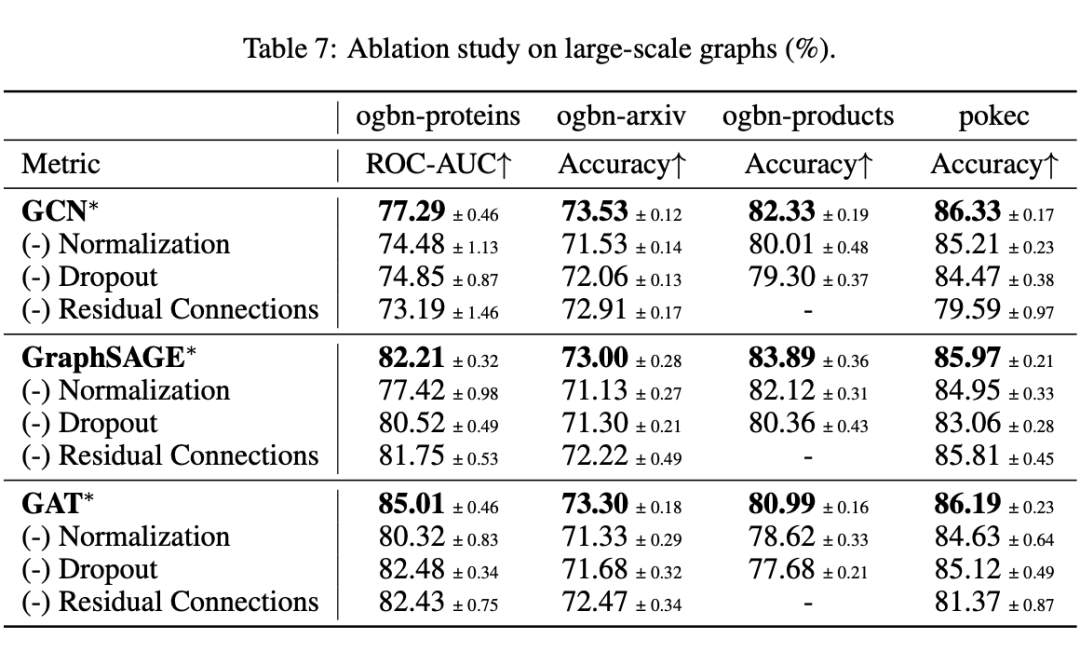

我們的消融研究對 GNNs 節點分類中的超參數提供了見解。我們驗證了:

Normalization 對于大規模圖至關重要

Dropout 一致地表現出積極影響

Residual connections 在異質性圖上可以顯著增強性能

在異質性圖上,較深的層數可能更適合 GNNs

方法介紹

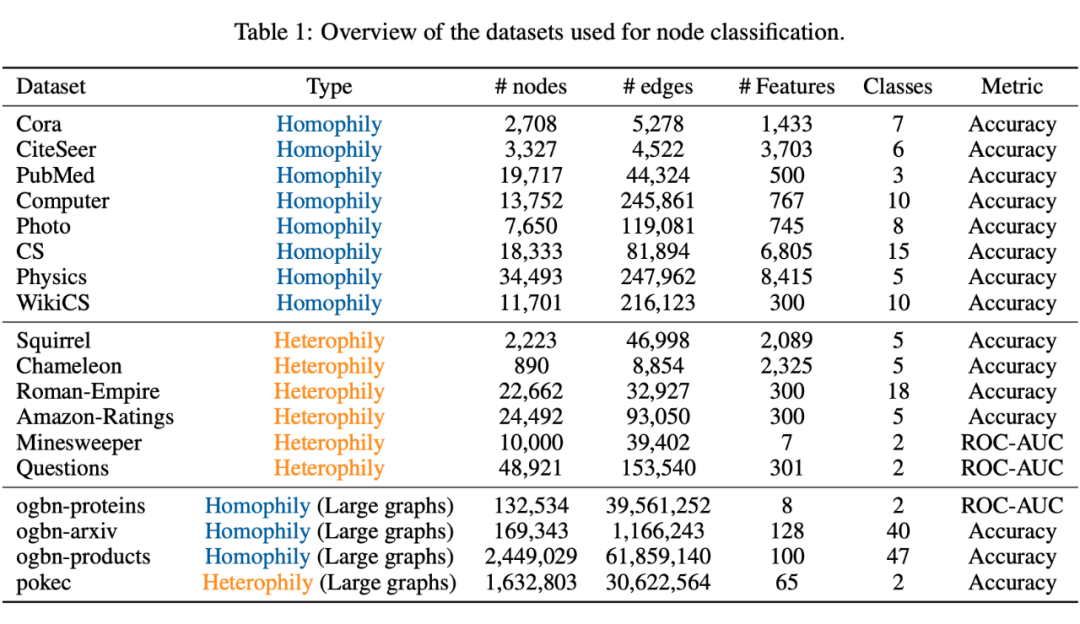

2.1 數據集概述

同質性圖:Cora、CiteSeer 和 PubMed 是三種常用的引用網絡[1]。我們遵循傳統的半監督設定[2]來劃分數據集。此外,Computer 和 Photo 是公共購買網絡[3],CS 和 Physics是公共作者網絡[3],我們采用訓練/驗證/測試劃分為 60%/20%/20% 的標準[4]。我們還使用了 Wiki-CS [5],該數據集是由計算機科學論文組成的引用網絡,我們使用[5]的劃分。

異質性圖:Squirrel 和 Chameleon 是兩個 Wikipedia 特定主題的頁面網絡[6]。我們采用異質圖基準測試[7]中的新的數據集劃分。此外,我們還使用 Roman-Empire、Amazon-Ratings、Minesweeper 和 Questions 四個異質性數據集[7],這些數據集的劃分和評估指標遵循其來源[7]的標準。大規模圖:我們使用了由 Open Graph Benchmark(OGB)[8]發布的多個大規模圖,包括 ogbn-arxiv、ogbn-proteins 和 ogbn-products,節點數量從 0.16M 到 2.4M 不等。此外,我們還分析了社交網絡 pokec [9]的性能表現。

2.2 超參數設置

我們的重點在于經典 GNNs 模型(GCN、GraphSAGE、GAT)與最先進的圖學習模型的比較。我們對經典 GNNs 進行了超參數調整,并與 Polynormer [4] 的超參數搜索空間保持一致。同時,所有基準baselines也在相同的超參數搜索空間和訓練環境下重新訓練。

2.3 關鍵超參數在本節中,我們概述了 GNNs 訓練中的關鍵超參數,包括 normalization、dropout、residual connections 和 network depth。這些超參數在不同類型的神經網絡中被廣泛應用,以提升模型性能:

Normalization:在每一層激活函數之前使用 layer normalization(LN)或 batch normalization(BN),可以減少協變量偏移,穩定訓練過程并加速收斂。

Dropout:在激活函數之后對特征嵌入使用 dropout 來減少隱藏神經元間的共適應,有助于降低 GNNs 中消息傳遞的共適應效應。

Residual Connections:通過在層之間引入 residual connections,可以緩解梯度消失問題,增強 GNNs 的表現力。

Network Depth:盡管深層網絡能夠提取更復雜的特征,但 GNNs 在深度上面臨獨特挑戰,如過度平滑等。因此,大多數 GNNs 采用較淺的結構,通常包含 2 到 5 層。然而,我們的實驗發現如果搭配上 residual connections,GNNs 可以拓深至 10 層的網絡。

實驗結果

3.1 主要發現

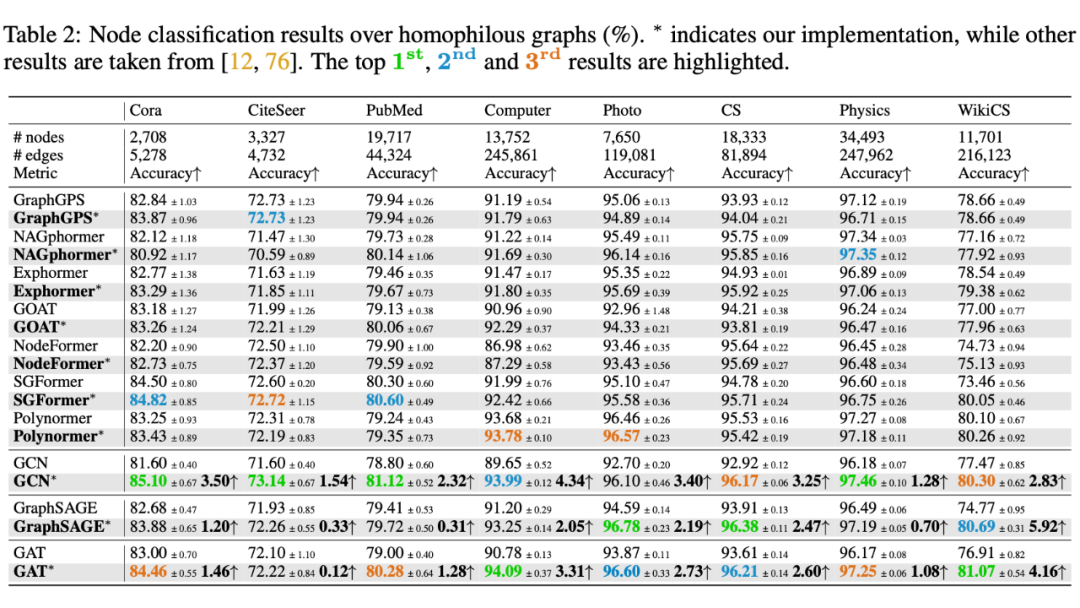

關于同質性圖的觀察:經典 GNNs 在同質性圖的節點分類任務中,僅需對超參數進行輕微調整,便能夠具備很強的競爭力,且在很多情況下優于最先進的 GTs。

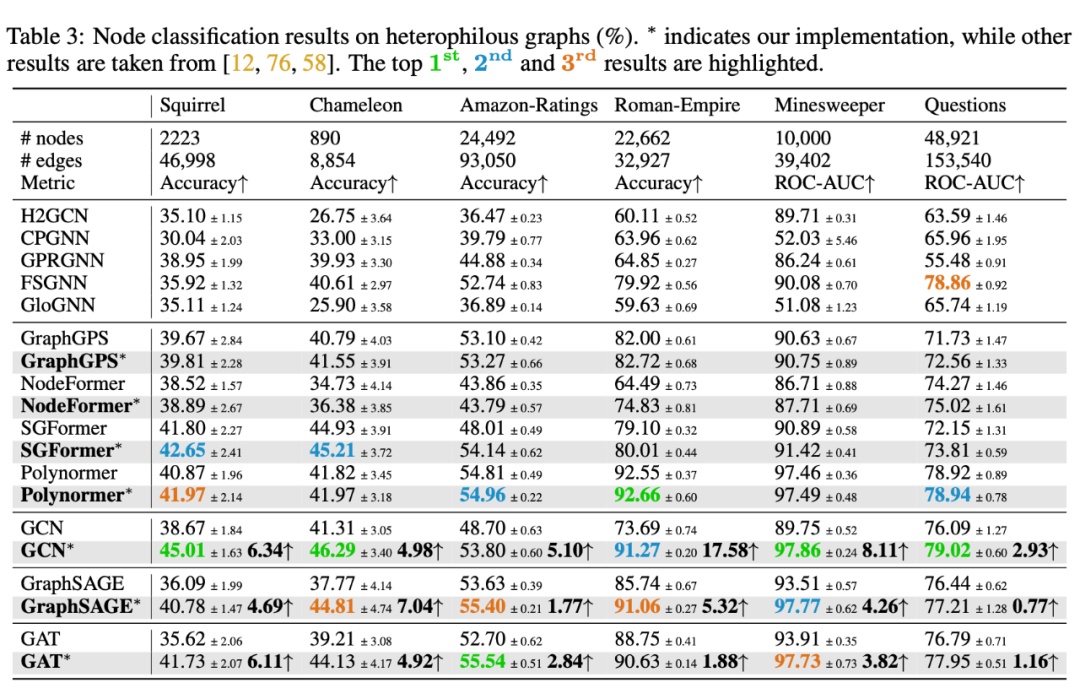

關于異質性圖的觀察:我們的參數調整顯著提高了經典 GNNs 在異質性圖上的先前最佳結果,超越了為此類圖專門設計的專用 GNNs 模型,甚至超過了 SOTA GTs 架構。這一進展不僅支持了[7]中的發現,還進一步強化了其結論,即經典 GNNs 在異質性圖上也是強有力的競爭者,挑戰了它們主要適用于同質性圖結構的普遍假設。

關于大規模圖的觀察:我們的參數調整顯著提升了經典 GNNs 的先前結果,在某些情況下準確率提升達到了兩位數。它們在這些大規模圖數據集(無論是同質性還是異質性)中取得了最佳結果,甚至超過了最先進的 GTs。這表明消息傳遞在大規模圖上學習節點表示仍然非常有效。

3.2 消融分析

消融觀察 1:Normalization 在大規模圖的節點分類中非常重要,但在小規模圖中則不太顯著。

消融觀察 2:Dropout 對于節點分類始終是必要的。

消融觀察 3:Residual Connections 能夠顯著提升某些數據集上的性能,且在異質性圖上的效果比同質性圖上更為顯著。 消融觀察 4:更深的網絡通常在異質性圖上帶來更大的性能提升,相較于同質性圖表現更為明顯。

總結我們的研究對經典 GNNs 模型在節點分類任務中的有效性進行了全面的重新評估。通過廣泛的實證分析,我們驗證了這些經典 GNNs 模型能夠在各種圖數據集上達到甚至超越最先進圖學習模型的性能。

此外,我們的全面消融研究提供了關于不同 GNNs 超參數如何影響性能的見解。我們希望我們的研究結果為 GNNs 的應用和評估帶來新的見解。

-

神經網絡

+關注

關注

42文章

4765瀏覽量

100549 -

機器學習

+關注

關注

66文章

8381瀏覽量

132428

原文標題:NeurIPS 2024 | 全面重新評估!經典GNN是強有力的節點分類基線模型

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

BP神經網絡和人工神經網絡的區別

人工神經網絡的案例分析

rnn是遞歸神經網絡還是循環神經網絡

人工神經網絡模型的分類有哪些

遞歸神經網絡是循環神經網絡嗎

循環神經網絡和卷積神經網絡的區別

深度神經網絡與基本神經網絡的區別

bp神經網絡和反向傳播神經網絡區別在哪

反向傳播神經網絡和bp神經網絡的區別

神經網絡擬合的誤差怎么分析

bp神經網絡是深度神經網絡嗎

bp神經網絡和卷積神經網絡區別是什么

卷積神經網絡和bp神經網絡的區別

詳解深度學習、神經網絡與卷積神經網絡的應用

經典圖神經網絡(GNNs)的基準分析研究

經典圖神經網絡(GNNs)的基準分析研究

評論