感謝眾多用戶及合作伙伴一直以來對NVIDIA TensorRT-LLM的支持。TensorRT-LLM 的 Roadmap 現(xiàn)已在 GitHub 上公開發(fā)布!

TensorRT-LLM

持續(xù)助力用戶優(yōu)化推理性能

TensorRT-LLM 可在 NVIDIA GPU 上加速和優(yōu)化最新的大語言模型(Large Language Models)的推理性能。該開源程序庫在 /NVIDIA/TensorRT-LLM GitHub 資源庫中免費提供。

近期,我們收到了許多用戶的積極反饋,并表示,TensorRT-LLM 不僅顯著提升了性能表現(xiàn),還成功地將其應(yīng)用集成到各自的業(yè)務(wù)中。TensorRT-LLM 強大的性能和與時俱進的新特性,為客戶帶來了更多可能性。

Roadmap 現(xiàn)已公開發(fā)布

過往,許多用戶在將 TensorRT-LLM 集成到自身軟件棧的過程中,總是希望能更好地了解 TensorRT-LLM 的 Roadmap。即日起,NVIDIA 正式對外公開 TensorRT-LLM 的 Roadmap ,旨在幫助用戶更好地規(guī)劃產(chǎn)品開發(fā)方向。

我們非常高興地能與用戶分享,TensorRT-LLM 的 Roadmap 現(xiàn)已在 GitHub 上公開發(fā)布。您可以通過以下鏈接隨時查閱:

https://github.com/NVIDIA/TensorRT-LLM

圖 1. NVIDIA/TensorRT-LLM GitHub 網(wǎng)頁截屏

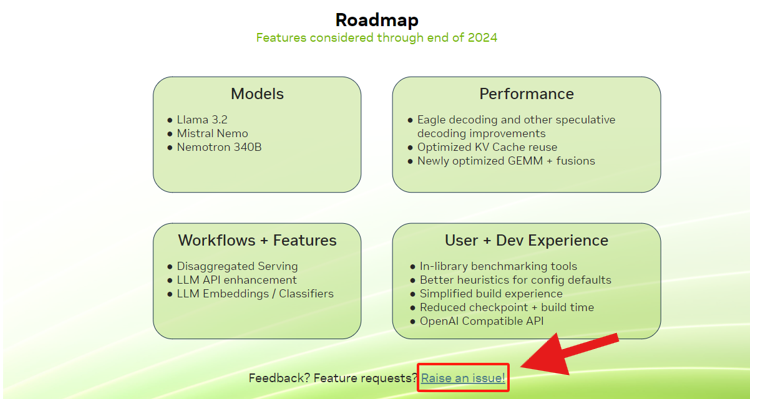

這份 Roadmap 將為您提供關(guān)于未來支持的功能、模型等重要信息,助力您提前部署和開發(fā)。

同時,在 Roadmap 頁面的底部,您可通過反饋鏈接提交問題。無論是問題報告還是新功能建議,我們都期待收到您的寶貴意見。

圖 2.Roadmap 整體框架介紹

利用 TensorRT-LLM

優(yōu)化大語言模型推理

TensorRT-LLM 是一個用于優(yōu)化大語言模型(LLM)推理的庫。它提供最先進的優(yōu)化功能,包括自定義 Attention Kernel、Inflight Batching、Paged KV Caching、量化技術(shù)(FP8、INT4 AWQ、INT8 SmoothQuant 等)以及更多功能,以讓你手中的 NVIDIA GPU 能跑出極致推理性能。

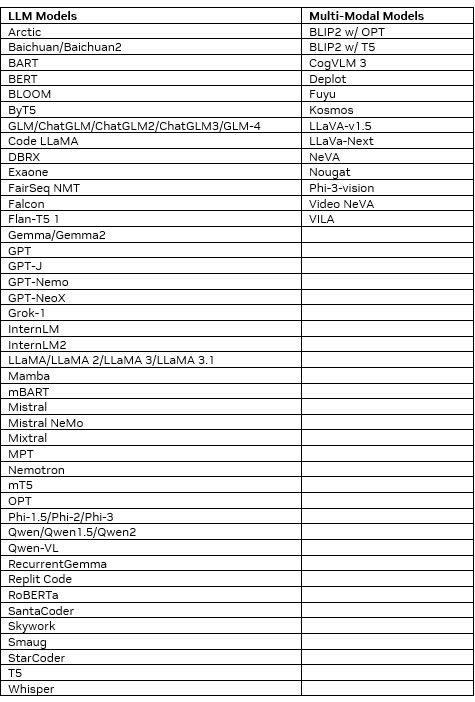

TensorRT-LLM 已適配大量的流行模型。通過類似 PyTorch 的 Python API,可以輕松修改和擴展這些模型以滿足自定義需求。以下是已支持的模型列表。

我們鼓勵所有用戶定期查閱 TensorRT-LLM Roadmap。這不僅有助于您及時了解 TensorRT-LLM 的最新動態(tài),還能讓您的產(chǎn)品開發(fā)與 NVIDIA 的技術(shù)創(chuàng)新保持同步。

-

NVIDIA

+關(guān)注

關(guān)注

14文章

4949瀏覽量

102823 -

GitHub

+關(guān)注

關(guān)注

3文章

467瀏覽量

16389 -

LLM

+關(guān)注

關(guān)注

0文章

275瀏覽量

306

原文標題:NVIDIA TensorRT-LLM Roadmap 現(xiàn)已在 GitHub 上公開發(fā)布!

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業(yè)解決方案】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

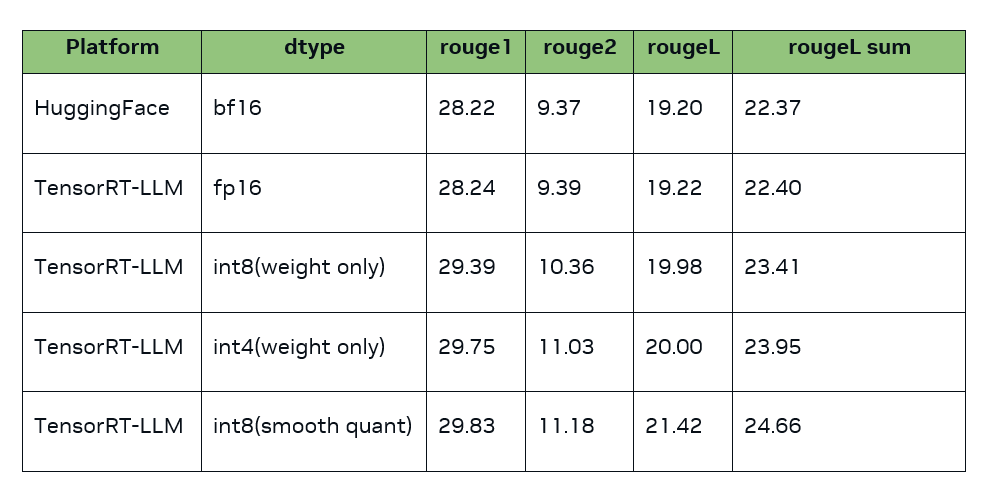

TensorRT-LLM低精度推理優(yōu)化

NVIDIA Nemotron-4 340B模型幫助開發(fā)者生成合成訓(xùn)練數(shù)據(jù)

魔搭社區(qū)借助NVIDIA TensorRT-LLM提升LLM推理效率

Mistral Large 2現(xiàn)已在Amazon Bedrock中正式可用

NVIDIA 通過 Holoscan 為 NVIDIA IGX 提供企業(yè)軟件支持

NVIDIA加速微軟最新的Phi-3 Mini開源語言模型

Mistral Large模型現(xiàn)已在Amazon Bedrock上正式可用

基于NVIDIA Megatron Core的MOE LLM實現(xiàn)和訓(xùn)練優(yōu)化

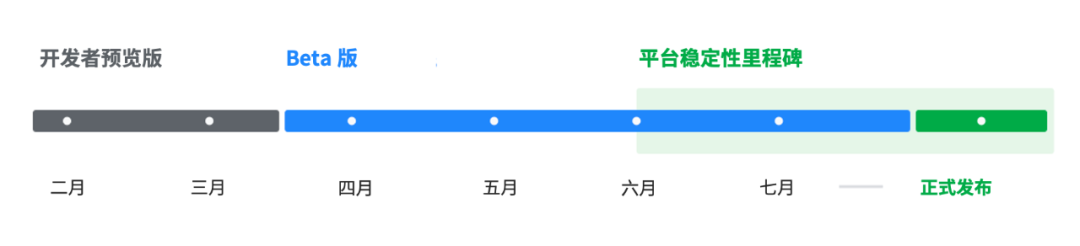

Android 15的首個開發(fā)者預(yù)覽版現(xiàn)已發(fā)布

ServiceNow、Hugging Face 和 NVIDIA 發(fā)布全新開放獲取 LLM,助力開發(fā)者運用生成式 AI 構(gòu)建企業(yè)應(yīng)用

TensorRT LLM加速Gemma!NVIDIA與谷歌牽手,RTX助推AI聊天

利用NVIDIA產(chǎn)品技術(shù)組合提升用戶體驗

使用NVIDIA TensorRT-LLM支持CodeFuse-CodeLlama-34B上的int4量化和推理優(yōu)化實踐

Torch TensorRT是一個優(yōu)化PyTorch模型推理性能的工具

如何在 NVIDIA TensorRT-LLM 中支持 Qwen 模型

NVIDIA TensorRT-LLM Roadmap現(xiàn)已在GitHub上公開發(fā)布

NVIDIA TensorRT-LLM Roadmap現(xiàn)已在GitHub上公開發(fā)布

評論