這在真實環(huán)境中成功讓機(jī)械臂從頭開始學(xué)習(xí)拾放物體。SAC-X 是基于從頭開始學(xué)習(xí)復(fù)雜的任務(wù)這種想法,即一個智能體首先應(yīng)該學(xué)習(xí)并掌握一套基本技能。就像嬰兒在爬行或走路前必須具有協(xié)調(diào)能力和平衡能力,為智能體提供與簡單技能相對應(yīng)的內(nèi)在目標(biāo)(具有輔助作用),這會增加它理解和執(zhí)行更復(fù)雜任務(wù)的可能性。

研究者認(rèn)為,SAC-X是一種通用的強化學(xué)習(xí)方法,未來可以應(yīng)用于機(jī)器人以外的更廣泛領(lǐng)域。

不管你讓小孩還是大人整理物品,他們很大可能都不會乖乖聽你的話,如果想要讓 AI 智能體進(jìn)行整理收拾,那就更難了。如果想成功,需要掌握如下幾個核心視覺運動技能:接近物體,抓住并舉起它,打開盒子,把物體放進(jìn)去。而更復(fù)雜的是,執(zhí)行這些技能時,必須按照正確的順序。

對于一些控制類的任務(wù),比如整理桌面或堆疊物體,智能體需要在協(xié)調(diào)它的模擬手臂和手指的九個關(guān)節(jié)時,做到三個 W,即如何(how),何時(when)以及在哪里(where),以便正確地移動,最終完成任務(wù)。

在任何給定的時間內(nèi),需要明確各種可能的運動組合的數(shù)量,以及執(zhí)行一長串正確動作,這些需求引申出一個嚴(yán)肅的問題,這成為強化學(xué)習(xí)中一個特別有趣的研究領(lǐng)域。

諸如獎賞塑形(reward shaping)、學(xué)徒學(xué)習(xí)(Apprenticeship learning)或從演示中學(xué)習(xí)(Learning from Demonstration)等技術(shù)可以幫助解決這個問題。然而,這些方法依賴于大量與任務(wù)相關(guān)的知識,而從零開始,通過最少的預(yù)先知識學(xué)習(xí)復(fù)雜的控制問題仍然是一個眾所周知的挑戰(zhàn)。

我們最近的論文提出了一種新的學(xué)習(xí)范式,叫做「調(diào)度輔助控制」(Scheduled Auxiliary Control (SAC-X)),我們試圖通過這種學(xué)習(xí)范式來克服這個問題。

SAC-X 是基于從頭開始學(xué)習(xí)復(fù)雜的任務(wù)這種想法,即一個智能體首先應(yīng)該學(xué)習(xí)并掌握一套基本技能。就像嬰兒在爬行或走路前必須具有協(xié)調(diào)能力和平衡能力,為智能體提供與簡單技能相對應(yīng)的內(nèi)在目標(biāo)(具有輔助作用),這會增加它理解和執(zhí)行更復(fù)雜任務(wù)的可能性。

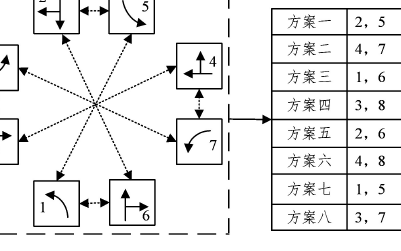

我們在幾個模擬和真實的機(jī)器人任務(wù)中演示了 SAC-X 法,包括不同物體的堆疊,將物體放到盒子里。我們定義的輔助任務(wù)遵循一般原則:鼓勵智能體探索其感應(yīng)空間。

例如,激活手指上的觸覺傳感器,感知手腕的力度,利用本體感應(yīng)器將關(guān)節(jié)角度調(diào)到最大,在視覺傳感器范圍內(nèi)強制性移動物體。對于每個任務(wù),如果實現(xiàn)目標(biāo),會提供相應(yīng)的簡單獎勵。沒實現(xiàn)目標(biāo)的話,獎勵為零。

智能體首先學(xué)習(xí)激活手指上的觸覺傳感器,然后移動物體

模擬智能體最終掌握復(fù)雜的堆疊任務(wù)

智能體接下來可以自行決定其當(dāng)前的「意圖」,例如下一步做什么。可能會是一個輔助任務(wù)或者是外部定義的目標(biāo)任務(wù)。至關(guān)重要的是,對于目前還沒有使用基于回放的離策略學(xué)習(xí)方法的任務(wù),該代理可以從獎勵信號中發(fā)現(xiàn)和學(xué)習(xí)。例如,當(dāng)拾取或移動一個物體時,智能體可能會偶然地將物體堆疊起來,觀察到「堆疊獎勵」。一系列簡單的任務(wù)會讓智能體觀察到罕見的外部獎勵,所以讓智能體具有安排意圖的能力至關(guān)重要。

基于收集到的所有的間接知識,智能體會建立一個個性化的學(xué)習(xí)課程。在如此大的領(lǐng)域中,通過這種方法來利用知識非常高效,在只有很少的外部獎勵信號的情況下尤其有用。

通過調(diào)度模塊,智能體會決定接下來的意圖。利用元學(xué)習(xí)算法,調(diào)度器會在訓(xùn)練過程中得到改進(jìn),該算法試圖最大限度地提高主任務(wù)的進(jìn)程,進(jìn)而顯著提高數(shù)據(jù)效率。

在探索完許多內(nèi)部輔助任務(wù)之后,智能體學(xué)會了如何堆疊和整理物品

評估表明,SAC-X 能夠從零開始完成我們設(shè)置的所有任務(wù),這些任務(wù)都是在相同的輔助任務(wù)集下完成的。令人興奮的是,利用 SAC-X,我們實驗室的機(jī)器人手臂能夠成功地從零開始學(xué)習(xí)拾取和擺放。在過去這極具挑戰(zhàn)性,因為在現(xiàn)實世界中讓機(jī)器人學(xué)習(xí)需要高效的數(shù)據(jù),所以流行的方法是預(yù)訓(xùn)練模擬智能體,然后再將這種能力轉(zhuǎn)移到真正的機(jī)器人手臂中。

針對真實的機(jī)器人手臂, SAC-X 能學(xué)習(xí)如何舉起和移動綠色的立方體,在此之前它從來沒有接觸過這類任務(wù)

我們認(rèn)為 SAC-X 是通向從零學(xué)習(xí)控制任務(wù)的重要一步,只需定義好整體目標(biāo)。SAC-X 允許任意定義輔助任務(wù),這些任務(wù)可以基于一般的看法(如有意激活傳感器),最終會涵蓋研究人員認(rèn)為重要的任務(wù)。從這方面來說,SAC-X 是一種通用的強化學(xué)習(xí)方法,可以廣泛應(yīng)用于控制和機(jī)器人領(lǐng)域之外的一般稀疏強化學(xué)習(xí)環(huán)境。

未來智能實驗室是人工智能學(xué)家與科學(xué)院相關(guān)機(jī)構(gòu)聯(lián)合成立的人工智能,互聯(lián)網(wǎng)和腦科學(xué)交叉研究機(jī)構(gòu)。

未來智能實驗室的主要工作包括:建立AI智能系統(tǒng)智商評測體系,開展世界人工智能智商評測;開展互聯(lián)網(wǎng)(城市)云腦研究計劃,構(gòu)建互聯(lián)網(wǎng)(城市)云腦技術(shù)和企業(yè)圖譜,為提升企業(yè),行業(yè)與城市的智能水平服務(wù)。

-

算法

+關(guān)注

關(guān)注

23文章

4601瀏覽量

92673 -

人工智能

+關(guān)注

關(guān)注

1791文章

46896瀏覽量

237670

原文標(biāo)題:DeepMind提出強化學(xué)習(xí)新算法,教智能體從零學(xué)控制

文章出處:【微信號:AItists,微信公眾號:人工智能學(xué)家】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

什么是深度強化學(xué)習(xí)?深度強化學(xué)習(xí)算法應(yīng)用分析

未來的AI 深挖谷歌 DeepMind 和它背后的技術(shù)

深度強化學(xué)習(xí)實戰(zhàn)

將深度學(xué)習(xí)和強化學(xué)習(xí)相結(jié)合的深度強化學(xué)習(xí)DRL

強化學(xué)習(xí)新方法,機(jī)器人究竟是怎么學(xué)習(xí)新動作的呢?

人工智能機(jī)器學(xué)習(xí)之強化學(xué)習(xí)

什么是強化學(xué)習(xí)?純強化學(xué)習(xí)有意義嗎?強化學(xué)習(xí)有什么的致命缺陷?

基于強化學(xué)習(xí)的MADDPG算法原理及實現(xiàn)

如何測試強化學(xué)習(xí)智能體適應(yīng)性

谷歌、DeepMind重磅推出PlaNet 強化學(xué)習(xí)新突破

DeepMind發(fā)布強化學(xué)習(xí)庫RLax

基于深度強化學(xué)習(xí)的路口單交叉信號控制

基于強化學(xué)習(xí)的目標(biāo)檢測算法案例

語言模型做先驗,統(tǒng)一強化學(xué)習(xí)智能體,DeepMind選擇走這條通用AI之路

DeepMind提出強化學(xué)習(xí)新算法,教智能體從零學(xué)控制

DeepMind提出強化學(xué)習(xí)新算法,教智能體從零學(xué)控制

評論