在過去的幾年中,深度卷積神經網絡(ConvNets)已經改變了計算機視覺的領域,這是由于它們具有學習高級語義圖像特征的無與倫比的能力。然而,為了成功地學習這些特征,它們通常需要大量手動標記的數據,這既昂貴又不可實行。因此,無監督語義特征學習,即在不需要手動注釋工作的情況下進行學習,對于現今成功獲取大量可用的可視數據至關重要。

在我們的研究中,我們打算通過這種方式學習圖像特征:訓練卷積神經網絡來識別被應用到作為輸入的圖像上的二維旋轉。我們從定性和定量兩方面證明,這個看似簡單的任務實際上為語義特征學習提供了非常強大的監督信號。我們在各種無監督的特征學習基準中,對我們的方法進行了詳盡的評估,并在所有這些基準中展示出了最先進的性能。

具體來說,我們在這些基準中的結果展現了在無監督的表征學習中,較之先前最先進的方法,我們的方法取得了巨大改進,從而顯著縮小了與監督特征學習之間的差距。例如,在PASCAL VOC 2007檢測任務中,我們的無監督預訓練的AlexNet模型達到了54.4%的 最先進的性能表現(在無監督的方法中),比監督學習的情況下僅少了2.4個百分點。當我們將無監督的學習特征遷移到其他任務上時,我們得到了同樣的驚人結果,例如ImageNet分類、PASCAL分類、PASCAL分割和CIFAR-10分類。我們論文的代碼和模型將會發布在這里。

近年來,在計算機視覺中廣泛采用的深度卷積神經網絡(LeCun等人于1998年提出),在這一領域取得了巨大的進步。具體來說,通過在具有大量手動標記數據的目標識別(Russakovsky等人于2015年提出)或場景分類(Zhou等人于2014年提出)任務上對卷積神經網絡進行訓練,它們成功學習到了適合于圖像理解任務的強大視覺表征。

例如,在這種監督的方式下,卷積神經網絡所學習的圖像特征在它們被遷移到其他視覺任務時取得了很好的效果,比如目標檢測(Girshick于2015年提出)、語義分割(Long等人于2015年提出),或者圖像描述(Karpathy 和 Fei-Fei于2015年提出)。然而,監督特征學習有一個主要的限制,那就是需要大量的手動標記工作。在如今擁有大量可用的可視數據的情況下,這既昂貴又不可實行。

以90°的隨機倍數(例如,0°、90°、180°、270°)旋轉的圖像。我們自監督特征學習方法的核心觀念是,如果一個人對圖像中描述的對象沒有概念,那么他就不能識別應用于它們的旋轉。

因此,最近人們對以無監督的方式學習高級的基于卷積神經網絡的表征越來越感興趣,這種方式避免了對視覺數據的手動注釋。其中,一個突出的范例就是所謂的自監督學習,它界定了一個注解不受約束的借口任務,只使用圖像或視頻上的視覺信息,從而給特征學習提供一個代理監督信號。

例如,為了學習特征,Zhang等人和Larsson等人訓練了卷積神經網絡以對灰度圖像進行著色,Doersch等人(于2015年)、Noroozi 和 Favaro(于2016年)預測了圖像塊的相對位置,以及Agrawal等人(于2015年)預測了在兩個連續幀之間正在移動的車輛的運動(即自動)。

這種自監督任務背后的基本原理是,解決這些問題將迫使卷積神經網絡學習語義圖像特征,這對其他視覺任務是有用的。事實上,通過上述自監督任務所學習的圖像表征,盡管它們沒能做到與監督學習表征的性能相當,但它們已經被證明在遷移到其他視覺任務上時是個好選擇,諸如目標識別、目標檢測和語義分割。其他成功的無監督特征學習案例是基于聚類的方法、基于重構的方法,和學習生成概率模型的方法。

我們所提出的用于語義特征學習的自監督任務的說明圖

我們的研究遵循自監督范例,并提出,通過訓練卷積神經網絡(ConvNets)識別應用于其作為輸入的圖像的幾何變換,從而學習圖像表示。更具體地說,首先,我們定義了一組離散的幾何變換,然后將這些幾何變換中的每一個應用于數據集上的每個圖像,并且將生成的變換圖像饋送到經過訓練以識別每個圖像的變換的卷積神經網絡模型中。在這個方法中,它是一組幾何變換,實際上定義了卷積神經網絡模型所必須學習的分類接口任務(classification pretext task)。

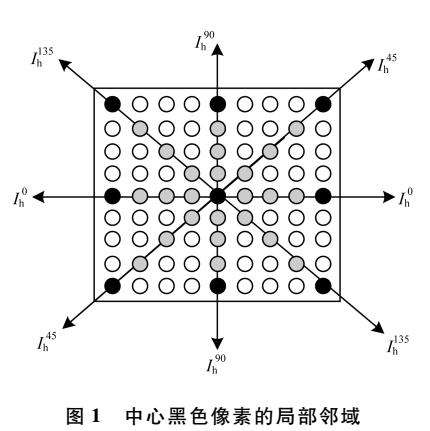

因此,為了實現無監督的語義特征學習,正確地選擇這些幾何變換是至關重要的。我們提出的是將幾何變換定義為0°、90°、180°和270°的圖像旋轉。因此,卷積神經網絡模型在識別四個圖像旋轉之一(見圖2)的4種圖像分類任務上進行了訓練。我們認為,為了讓一個ConvNet模型能夠識別應用于圖像中的旋轉變換,它需要理解圖像中所描述的對象的概念(參見圖1),例如它們在圖像中的位置、類型和、姿勢。在整篇論文中,我們從定性和定量的論證上支持這一理論。

此外,我們經過實驗證明,盡管我們的自監督方法很簡單,但預測旋轉變換的任務為特征學習提供了一個強大的替代監督信號。在相關基準測試上取得了顯著的進步。

由AlexNet模型所生成的注意力圖(attention map),對(a)進行訓練以識別目標(監督),和對(b)進行訓練以識別圖像旋轉(自監督)。為了生成一個卷積層的注意圖,我們首先計算該層的特征映射,然后我們提高power p上的每個特征激活,最后我們對特征映射的每個位置處的激活進行求和。對于卷積層1,2和3,我們分別使用了p = 1、p = 2和p = 4

需要注意的是,我們的自監督任務不同于Dosovitskiy等人于2014年和Agrawal等人于2015年所提出的研究方法,盡管他們也涉及到幾何變換。Dosovitskiy等人于2014年訓練了卷積神經網絡模型,以產生對圖像的區分性表征,同時不改變幾何和色度變換。相反,我們訓練卷積神經網絡模型來識別應用于圖像的幾何變換。

這與Agrawal等人于2015年提出的自運動方法(egomotion method)有根本的不同,該方法采用了一種帶有孿生(siamese)結構的卷積神經網絡模型,該模型將兩個連續的視頻幀作為輸入,并進行訓練以預測(通過回歸)其相機轉換。相反,在我們的方法中,卷積神經網絡將一個單一圖像作為輸入,我們已經應用了一個隨機幾何變換(旋轉),并經過訓練(通過分類)識別這種幾何變換,而不需要訪問初始圖像。

由AlexNet模型所學習第一層過濾器在(a)監督目標識別任務和(b)識別旋轉圖像的自監督任務上進行的訓練

我們的貢獻:

?我們提出了一個新的自監督任務,這個任務非常簡單,與此同時,我們也在文章中進行了展示,為語義特征學習提供了強大的監督信號。

?我們在各種環境(例如半監督或遷移學習環境)和各種視覺任務(即CIFAR-10、ImageNet、Places和PASCAL分類以及檢測或分割任務)中詳細評估了我們的自監督方法。

?我們提出的新的自監督方法在各個方面都展現出了最先進的成果,較先前的無監督方法有了顯著改善。

?我們的研究表明,對于幾個重要的視覺任務而言,我們的自監督學習方法顯著縮小了與無監督和監督特征學習之間的差距。

經過研究,我們提出了一種用于自監督特征學習的新方法,它通過訓練卷積神經網絡模型,使其能夠識別已經用作輸入圖像的圖像旋轉。盡管我們的自監督任務很簡單,但我們證明,它可以成功地訓練卷積神經網絡模型,從而學習語義特征,這些語義特征對于各種視覺感知任務非常有用,例如目標識別、目標檢測和目標分割。

我們在各種無監督和半監督條件下對我們的方法進行了詳盡的評估,并且在測試中實現了最先進的性能。具體而言,我們的自監督方法大幅度改進了ImageNet分類、PASCAL分類、PASCAL檢測、PASCAL分割和CIFAR-10分類的無監督特征學習的最新結果,超越了以往的方法,因此大幅縮小了無監督和監督特征學習之間的差距。

-

神經網絡

+關注

關注

42文章

4762瀏覽量

100535 -

圖像

+關注

關注

2文章

1083瀏覽量

40415

原文標題:無監督學習最新研究:通過簡單的「圖像旋轉」預測便可為圖像特征學習提供強大監督信號

文章出處:【微信號:AItists,微信公眾號:人工智能學家】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

50多種適合機器學習和預測應用的API,你的選擇是?(2018年版本)

如何平滑地旋轉圖像?

基于OpenCV的圖像特征智能識別系統設計

半監督的譜聚類圖像分割

基于鄰域特征學習的單幅圖像超分辨重建

基于SIFT特征的圖像配準(圖像匹配)

采用自監督CNN進行單圖像深度估計的方法

通過簡單的「圖像旋轉」預測便可為圖像特征學習提供強大監督信號

通過簡單的「圖像旋轉」預測便可為圖像特征學習提供強大監督信號

評論