基于一個(gè)可伸縮的、任務(wù)無關(guān)的系統(tǒng),OpenAI在一組包含不同的語言任務(wù)中獲得了最優(yōu)的實(shí)驗(yàn)結(jié)果,方法是兩種現(xiàn)有理念的結(jié)合:遷移學(xué)習(xí)和無監(jiān)督的預(yù)訓(xùn)練。這些結(jié)果證明了有監(jiān)督的學(xué)習(xí)方法可以與無監(jiān)督的預(yù)訓(xùn)練進(jìn)行完美的結(jié)合。這個(gè)想法許多人在過去探索過,OpenAI希望結(jié)果能激發(fā)更多的研究,進(jìn)而將這個(gè)想法應(yīng)用到更大、更多樣化的數(shù)據(jù)集上。

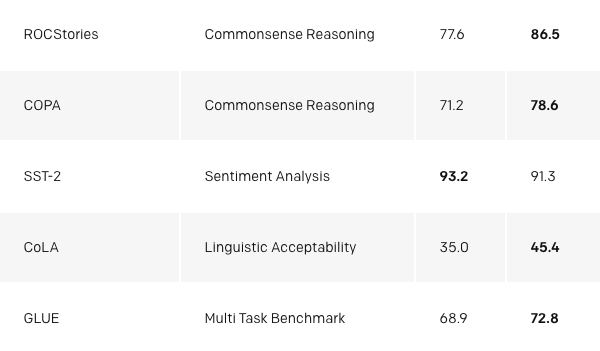

我們的系統(tǒng)分為兩個(gè)階段:首先,我們通過無監(jiān)督的方式在大數(shù)據(jù)集上訓(xùn)練一個(gè)遷移學(xué)習(xí)模型,訓(xùn)練過程中使用語言模型的訓(xùn)練結(jié)果作為信號(hào),然后我們?cè)诟〉挠斜O(jiān)督數(shù)據(jù)集上對(duì)這個(gè)模型進(jìn)行微調(diào),以幫助它解決特定的任務(wù)。這個(gè)方法的開發(fā)是在我們前一個(gè)sentiment neuron(情緒神經(jīng)元)的工作之后進(jìn)行的,在sentiment neuron任務(wù)中我們注意到,通過利用足夠的數(shù)據(jù)對(duì)模型進(jìn)行訓(xùn)練,無監(jiān)督學(xué)習(xí)可以獲得令人驚訝的判別特征。在這里,我們想進(jìn)一步探討這個(gè)想法:我們能否開發(fā)一個(gè)模型,以一種無監(jiān)督的方式使用大量數(shù)據(jù)對(duì)模型進(jìn)行訓(xùn)練,然后對(duì)模型進(jìn)行微調(diào),以在不同的任務(wù)中都獲得良好的性能?我們的研究結(jié)果表明,這種方法的效果出奇地好。同樣的核心模型可以針對(duì)完全不同的任務(wù)進(jìn)行微調(diào),以適應(yīng)任務(wù)。

本研究是基于在半監(jiān)督序列學(xué)習(xí)中引入的方法,該方法展示了如何通過對(duì)LSTM進(jìn)行無監(jiān)督的預(yù)訓(xùn)練,然后進(jìn)行有監(jiān)督的微調(diào),來提高文本分類的能力。它還擴(kuò)展了ULMFiT的研究,該研究展示了如何對(duì)單個(gè)數(shù)據(jù)不可知的LSTM語言模型進(jìn)行微調(diào),從而在各種文本分類數(shù)據(jù)集上獲得最優(yōu)的性能。我們的工作展示了如何在這種方法中使用遷移學(xué)習(xí)模型,從而在文本分類之外的更廣泛任務(wù)中取得成功,例如常識(shí)推理、語義相似性和閱讀理解等。它與ELMo類似,但屬于任務(wù)無關(guān)型問題,它包含了預(yù)訓(xùn)練,希望使用針對(duì)任務(wù)的特殊模型架構(gòu)來獲得最優(yōu)的結(jié)果。

我們通過對(duì)很少的參數(shù)調(diào)優(yōu)來達(dá)到我們的目的。所有的數(shù)據(jù)集都僅使用一個(gè)前向語言模型,沒有任何組合,并且大多數(shù)的結(jié)果都使用完全相同的超參數(shù)設(shè)置。

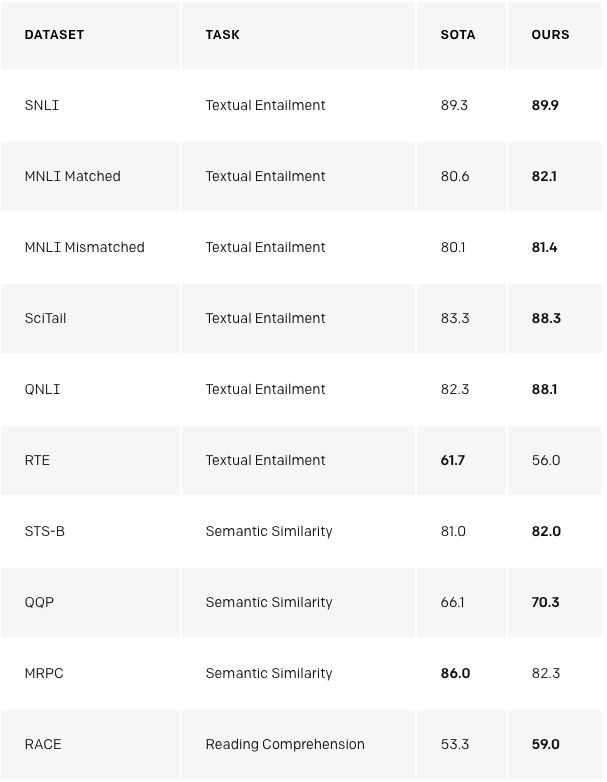

我們的方法在COPA、RACE和ROCStories三個(gè)數(shù)據(jù)集上的性能都表現(xiàn)得特別好,這些數(shù)據(jù)集是用來測(cè)試常識(shí)推理和閱讀理解的。我們的模型在這些數(shù)據(jù)集上獲得了最優(yōu)的結(jié)果。這些數(shù)據(jù)集的識(shí)別被認(rèn)為需要多句推理和重要的世界知識(shí),這表明我們的模型主要通過無監(jiān)督學(xué)習(xí)來提高這些能力。以上表明,無監(jiān)督的技術(shù)有希望開發(fā)復(fù)雜的語言理解能力。

為什么是無監(jiān)督學(xué)習(xí)?

監(jiān)督學(xué)習(xí)是大多數(shù)機(jī)器學(xué)習(xí)算法成功的核心。然而,它需要對(duì)大量的數(shù)據(jù)進(jìn)行仔細(xì)的清理,創(chuàng)建的代價(jià)也極其昂貴,這樣才能獲得很好的效果。無監(jiān)督學(xué)習(xí)的吸引力在于它有可能解決這些缺點(diǎn)。由于無監(jiān)督的學(xué)習(xí)消除了人為顯式標(biāo)記的瓶頸,它也很好地?cái)U(kuò)展了當(dāng)前的趨勢(shì),即增加了原始數(shù)據(jù)的計(jì)算能力和可用性。無監(jiān)督學(xué)習(xí)是一個(gè)非常活躍的研究領(lǐng)域,但它的實(shí)際應(yīng)用往往很有限。

最近的一次一項(xiàng)嘗試是試圖通過使用無監(jiān)督學(xué)習(xí)來對(duì)具有大量未標(biāo)記數(shù)據(jù)的系統(tǒng)進(jìn)行增強(qiáng),從而進(jìn)一步提高模型的語言能力。通過無監(jiān)督訓(xùn)練的單詞表示可以使用包含萬億字節(jié)信息組成的大型數(shù)據(jù)集,當(dāng)與有監(jiān)督學(xué)習(xí)相結(jié)合時(shí),可以提高各種NLP任務(wù)的性能。直到最近,這些無監(jiān)督的NLP技術(shù)(例如GLoVe和word2vec)使用了簡(jiǎn)單的模型(詞向量)和訓(xùn)練信號(hào)(單詞的局部同時(shí)出現(xiàn))。skip-Thought向量是一個(gè)很值得注意的早期想法,它展示了更復(fù)雜的方法如何進(jìn)行改進(jìn)的潛能。而現(xiàn)在正在使用新的技術(shù)將進(jìn)一步提高實(shí)驗(yàn)性能。上述技術(shù)包括使用預(yù)訓(xùn)練的句子來表示模型,上下文化的詞向量(特別是ELMo和CoVE),以及像我們提出來的方法:使用特定的模型架構(gòu)來將無監(jiān)督的預(yù)訓(xùn)練和有監(jiān)督的微調(diào)融合在一起。

在大量文本的基礎(chǔ)上對(duì)我們的模型進(jìn)行預(yù)訓(xùn)練,極大地提高了它在具有挑戰(zhàn)性的自然語言處理任務(wù)上的性能,比如Winograd模式解析。

我們還注意到,我們可以使用未訓(xùn)練的基礎(chǔ)語言模型執(zhí)行任務(wù)。例如,隨著基礎(chǔ)語言模型的改進(jìn),像選擇多個(gè)正確答案這樣任務(wù)的性能會(huì)穩(wěn)步增加。雖然這些方法的絕對(duì)性能相對(duì)于最新的有監(jiān)督技術(shù)而言仍然很低,(對(duì)于問答系統(tǒng),它的表現(xiàn)優(yōu)于簡(jiǎn)單的滑動(dòng)窗口那樣的基線系統(tǒng))但是鼓舞人心的一點(diǎn)是,這種行為在廣泛集合的任務(wù)中是具有魯棒性的。使用這些啟發(fā)式算法,不包含關(guān)于任務(wù)和世界的信息的隨機(jī)初始化網(wǎng)絡(luò)不會(huì)比包含這些信息的隨機(jī)初始化方法獲得更好的效果。這就提供了一些見解,告訴我們?yōu)槭裁瓷深A(yù)訓(xùn)練可以提高下游任務(wù)的性能。

我們還可以使用模型中現(xiàn)有的語言功能來執(zhí)行情感分析。對(duì)于由正面和負(fù)面影評(píng)組成的斯坦福情緒Treebank數(shù)據(jù)集,我們可以通過使用語言模型在句子后面輸入單詞“very”來猜測(cè)評(píng)論是正面還是負(fù)面,還能看看這個(gè)模型是否具有預(yù)測(cè)“積極的”或“消極的”的傾向。 這種方法根本不需要根據(jù)任務(wù)調(diào)整模型,其性能與經(jīng)典基線相當(dāng),準(zhǔn)確度達(dá)到80%左右。

我們的工作也驗(yàn)證了遷移學(xué)習(xí)的魯棒性和有效性,這表明它足夠靈活,可以在不需要對(duì)復(fù)雜的任務(wù)進(jìn)行定制或?qū)Τ瑓?shù)進(jìn)行調(diào)優(yōu)的情況下,在廣泛數(shù)據(jù)的任務(wù)上獲得最優(yōu)的結(jié)果。

缺點(diǎn)

這個(gè)項(xiàng)目有一些問題還是值得注意的:

計(jì)算要求:許多以前的NLP任務(wù)方法都是從頭開始,在單個(gè)GPU上訓(xùn)練相對(duì)較小的模型。 我們的方法需要昂貴的預(yù)訓(xùn)練步驟:在8個(gè)GPU上進(jìn)行為期1個(gè)月的訓(xùn)練。幸運(yùn)的是,這個(gè)訓(xùn)練只需要進(jìn)行一次。我們正在發(fā)布我們的模型,這樣其他人就不用再次訓(xùn)練這樣的模型了。同時(shí),與之前的工作相比,它也是一個(gè)大型模型,因此使用更多的計(jì)算和內(nèi)存,我們使用了37層(12塊)Transformer架構(gòu),并且我們訓(xùn)練的序列最多可達(dá)512個(gè)令牌。大多數(shù)實(shí)驗(yàn)都是在4個(gè)/8個(gè)GPU系統(tǒng)上進(jìn)行的。該模型可以快速調(diào)整新任務(wù),從而有助于減輕額外的資源需求。

學(xué)習(xí)到文本中所包含的世界局限性和數(shù)據(jù)傾斜:互聯(lián)網(wǎng)上隨時(shí)可用的書籍和文本不包含關(guān)于世界的完整乃至準(zhǔn)確的信息。最近的工作表明,某些類型的信息很難通過文本學(xué)習(xí),而其他工作表明模型學(xué)習(xí)且利用了數(shù)據(jù)分布中包含的傾斜。

脆弱的泛化能力:盡管我們的方法改善了廣泛任務(wù)的性能,但目前的深度學(xué)習(xí)NLP模型的表現(xiàn)有時(shí)仍然是違反直覺并且令人震驚的,尤其是在以系統(tǒng)性,對(duì)抗性或分布式分布的方式進(jìn)行評(píng)估時(shí)。盡管我們已經(jīng)觀察到一些進(jìn)展的跡象,但我們的方法對(duì)這些問題并非免疫。相比較于以往純文本的神經(jīng)網(wǎng)絡(luò),我們的方法具有更優(yōu)越的詞法魯棒性。在2018年Glockner等人介紹的數(shù)據(jù)集中,我們的模型準(zhǔn)確率達(dá)到83.75%,表現(xiàn)類似于通過WordNet整合外部知識(shí)的KIM方法。

展望未來

擴(kuò)展方法:我們已經(jīng)觀察到,語言模型性能的改進(jìn)與下游任務(wù)的改進(jìn)密切相關(guān)。目前我們正在使用一臺(tái)包含8 GPU計(jì)算機(jī)作為硬件,并僅使用大概包含5GB文本的幾千本書作為訓(xùn)練數(shù)據(jù)集。 根據(jù)經(jīng)驗(yàn)表明,使用更多的計(jì)算性能和數(shù)據(jù)可以使算法有很大的改進(jìn)空間。

改進(jìn)微調(diào):我們的方法目前非常簡(jiǎn)單。如果使用更復(fù)雜的適應(yīng)和遷移技術(shù)(例如ULMFiT中探索的技術(shù))可能會(huì)有實(shí)質(zhì)性的改進(jìn)。

更好地理解生成性預(yù)訓(xùn)練的原理會(huì)對(duì)模型有益:盡管我們已經(jīng)討論了一些我們?cè)诖擞懻摰南敕ǎ嗅槍?duì)性的實(shí)驗(yàn)和研究將有助于區(qū)分那些不同的解釋。例如,我們觀察到的性能提高有多少是得益于改進(jìn)了處理更廣泛背景的能力以及改進(jìn)的世界知識(shí)?

-

nlp

+關(guān)注

關(guān)注

1文章

487瀏覽量

22011 -

遷移學(xué)習(xí)

+關(guān)注

關(guān)注

0文章

74瀏覽量

5556

原文標(biāo)題:OpenAI最新研究:通過無監(jiān)督學(xué)習(xí)提高語言理解能力

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AI模型是如何訓(xùn)練的?訓(xùn)練一個(gè)模型花費(fèi)多大?

一文詳解知識(shí)增強(qiáng)的語言預(yù)訓(xùn)練模型

【大語言模型:原理與工程實(shí)踐】大語言模型的預(yù)訓(xùn)練

迄今最大模型?OpenAI發(fā)布參數(shù)量高達(dá)15億的通用語言模型GPT-2

基于主動(dòng)學(xué)習(xí)的半監(jiān)督圖神經(jīng)網(wǎng)絡(luò)模型來對(duì)分子性質(zhì)進(jìn)行預(yù)測(cè)方法

小米在預(yù)訓(xùn)練模型的探索與優(yōu)化

NLP中的對(duì)抗訓(xùn)練到底是什么

利用ImageNet訓(xùn)練了一個(gè)能降噪、超分和去雨的圖像預(yù)訓(xùn)練模型

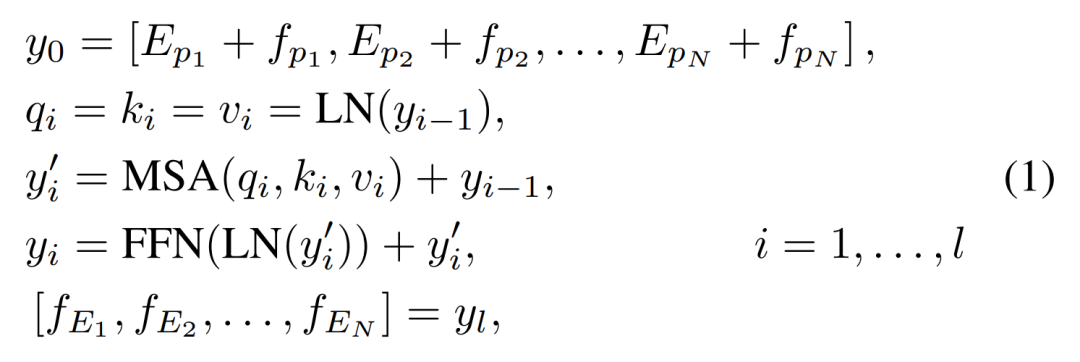

2021 OPPO開發(fā)者大會(huì):NLP預(yù)訓(xùn)練大模型

2021年OPPO開發(fā)者大會(huì) 融合知識(shí)的NLP預(yù)訓(xùn)練大模型

無監(jiān)督訓(xùn)練加微小調(diào)整,只用一個(gè)模型即可解決多種NLP

無監(jiān)督訓(xùn)練加微小調(diào)整,只用一個(gè)模型即可解決多種NLP

評(píng)論