當前人工智能最大的挑戰之一,是如何讓多個智能體學會一起完成同一個任務,學會彼此合作和相互競爭。在發表于ICML 2018的一項研究中,倫敦大學學院汪軍教授團隊利用平均場論來理解大規模多智能體交互,極大地簡化了交互模式。他們提出的新方法,能夠解決數量在成百上千甚至更多的智能體的交互,遠遠超過了所有當前多智能體強化學習算法的能力范圍。

柯潔揮淚烏鎮一周年,AI已經重新書寫了圍棋的歷史。而創造出地球上最強棋手AlphaGo系列的DeepMind,早已經將目光轉向下一個目標——星際爭霸。

玩星際爭霸,需要AI在不確定的情況下進行推理與規劃,涉及多個智能體協作完成復雜的任務,權衡短中長期不同的收益。相比下圍棋這樣的確定性問題,星際爭霸的搜索空間要高出10個數量級。

從現實意義上來說,研究多智能體協作也具有廣泛的應用場景。例如,股票市場上的交易機器人博弈,廣告投標智能體通過在線廣告交易平臺互相競爭,電子商務協同過濾推薦算法預測用戶興趣,等等。

倫敦大學學院(UCL)計算機科學系教授汪軍博士及其團隊一直從事多智能體協作的研究。汪軍教授認為,目前通用人工智能(AGI)研究有兩個大方向,一是大家熟知的AlphaGo,這是單智體,其背后的經典算法是深度強化學習;另一個就是多智體(Multi-agent),也可以理解為集體智能,這是人工智能的下一個大方向。

目前,人工智能最大的挑戰之一,就是如何讓多個智能體學會一起完成同一個任務,學會彼此合作和相互競爭。如何利用一套統一的增強學習框架去描述這個學習過程。

研究負責人、倫敦大學學院(UCL)的汪軍教授

在一項最新的研究中,汪軍和他的團隊利用平均場論來理解大規模多智能體交互,極大地簡化了交互模式,讓計算量大幅降低。他們提出的新方法,能夠解決數量在成百上千甚至更多的智能體的交互,遠遠超過了所有當前多智能體強化學習算法的能力范圍。相關論文已經被ICML 2018接收,作者將在7月13日下午5點在ICML會場做報告,歡迎大家去現場交流。

“我們發現在處理大規模智能體學習時,把多體問題抽象成二體問題是一種有效的方法,”論文作者Yaodong Yang告訴新智元:“這個想法的初衷異常簡單,就是把環境中所有領域內其他智能體對中心個體的影響,僅僅用一個它們的均值來抽象,而不用一一分別考慮建模。”

他們設計的平均場Q-learning算法成功模擬并求解了物理領域的伊辛模型(ising model)。Yaodong表示:“用強化學習的框架可以解決物理學中的伊辛模型,這一發現非常令人振奮。”

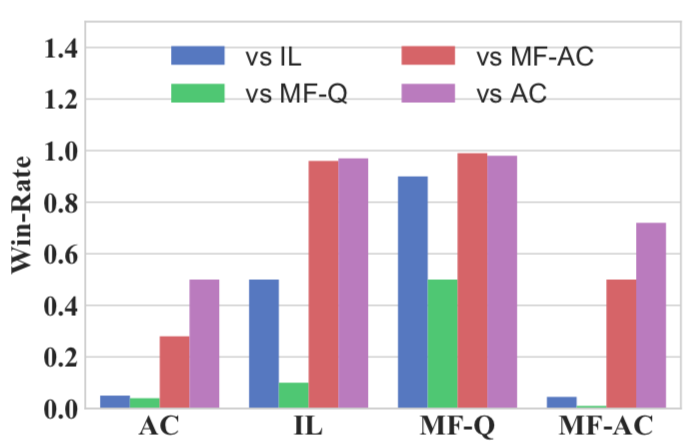

上海交通大學張偉楠助理教授團隊也積極參與了此次工作,張偉楠認為:“使用平均場計算領域智能體的行動分布,并整合于強化學習中在計算上十分高效,在不同算法互相對戰的實驗中,平均場Q-learning算法能穩定提高群體智能的效果,在battle中碾壓傳統多智能體強化學習的算法。”

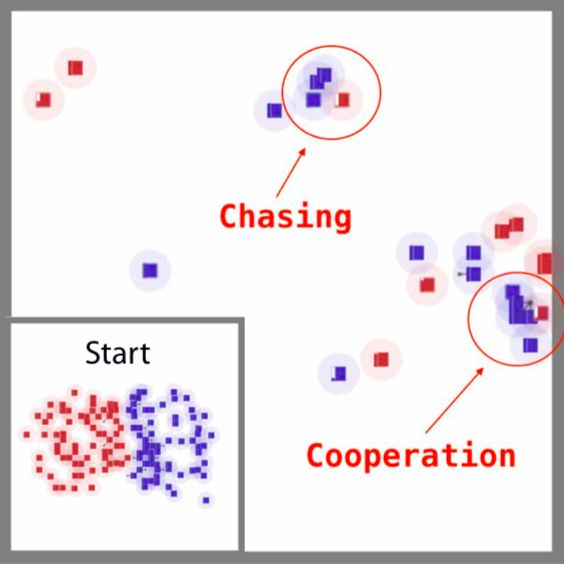

在一個混合式的合作競爭性戰斗游戲中,研究人員證明了平均場MARL相對其他多智能體系統的基線獲得了更高的勝率。其中,藍方是平均場Q-learning算法,紅方是傳統的強化學習算法DQN。

對戰局部,agent彼此間的合作與競爭。

對戰結果:經過2000多輪比較實驗,新提出的平均場Q-learning算法(MF-Q)相對于其他傳統強化學習算法的勝率(綠色)。很明顯,在所有的指標中,MF-Q的勝率都高出一大截。

由于大幅降低了計算量,他們的方法可以推廣用于很多實際場景,比如終端通訊設備流量分配,互聯網廣告競價排名,智能派單等大規模分布式優化場景中。

用平均場論解決大規模多智能體交互,大幅簡化計算

多智體強化學習(Multi-agent reinforcement learning, MARL)假設有一組處在相同環境下的自主智能體。在MARL中學習非常困難,因為agent不僅與環境交互,而且還會相互作用:一個agent的策略變化會影響其他agent的策略,反之亦然。

例如,在星際爭霸中,讓一組20個agent去攻擊另外一組的20個agent,每個agent就要考慮周圍39個agents的行為從而做出最優決策。對于每個個體來說,要學會理解的狀態空間是很龐大的,這還不包括其他智能體在探索環境時產生的噪聲。當agent增多到1000乃至上萬個時,情況就變得超級復雜,現有的多智能體強化學習算法有很大局限性,也沒有那么大的計算力。

但是,推測其他agent的策略來計算額外的信息,對每個agent自身是有好處的。研究表明,一個學習了聯合行動效應的agent,比那些沒有學習的agent表現更好,無論是在合作博弈、零和隨機博弈和一般和隨機博弈中,情況都是如此。這也很好理解,知彼知己,才能百戰不殆。

因此,結果就是,現有的均衡求解方法雖然可行,但只能解決少數agent的問題,大部分的實驗還局限于兩個agent之間的博弈。而在實踐當中,卻常常會需要有大量agent之間的策略互動。

如何解決這個問題?UCL的研究者想到了平均場論。

平均場論(Mean Field Theory,MFT)是一種研究復雜多體問題的方法。在物理學場論和機器學習的變分推斷中,平均場論是對大且復雜的隨機模型的一種簡化。未簡化前的模型通常包含巨大數目的含相互作用的小個體。平均場理論則做了這樣的近似:對某個獨立的小個體,所有其他個體對它產生的作用可以用一個平均的量給出,這樣,簡化后的模型對于每個個體就成了一個單體問題。

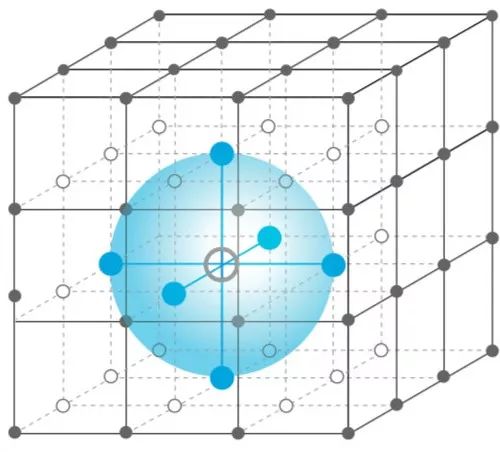

在他們的研究中,UCL團隊沒有去分別考慮單個智能體對其他個體產生的不同影響,而是將領域內所有其他個體的影響用一個均值來代替。這樣,對于每個個體,只需要考慮個體和這個均值的交互作用就行了。這種抽象的方法,當研究對象大到無法表達的時候尤其有用。

平均場論的方法能快速收斂,用強化學習解決伊辛模型

應用平均場論后,學習在兩個智能體之間是相互促進的:單個智能體的最優策略的學習是基于智能體群體的動態;同時,集體的動態也根據個體的策略進行更新。

在此基礎上,研究人員提出了平均場Q-learning算法(MF-Q)和平均場Actor-Critic算法(MF-AC),并通過伊辛模型驗證了它們的解是否能夠快速收斂。

易辛模型(Ising model),是一個以物理學家恩斯特·易辛為名的數學模型,用于描述物質的鐵磁性。該模型中包含了可以用來描述單個原子磁矩的參數,其值只能為+1或-1,分別代表自旋向上或向下(在多智能體的情況下,就是向上或者向下移動)。這些磁矩通常會按照某種規則排列,形成晶格,并在模型中引入特定交互作用的參數,使得相鄰的自旋互相影響。

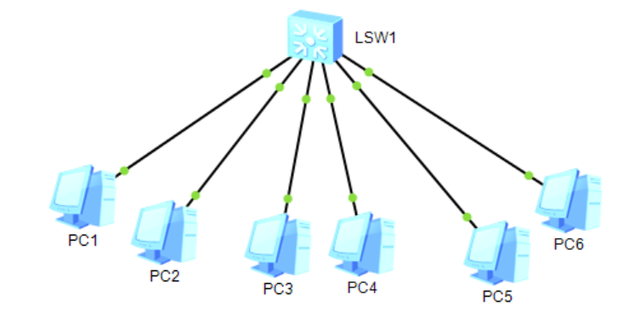

平均場近似。每個agent都表示為網格中的一個節點,它只受鄰居(藍色區域)的平均效果影響。多個agents相互作用被有效地轉換為兩個代理的相互作用。

雖然伊辛模型相對于物理現實是一個相當簡化的模型,但它卻和鐵磁性物質一樣,在不同溫度下會產生相變。事實上,一個二維的方晶格易辛模型是已知最簡單而且會產生相變的物理系統。在這個場景下, 雖然每一個磁矩對整個磁體的性質的影響非常有限, 但是通過微觀的相互作用, 磁矩之間卻會形成宏觀的趨勢, 而這種趨勢能夠決定我們所關心的整體磁場的性質。

在多智體強化學習這個領域,特定的任務可以被有效的抽象為同質智能體(homogeneous agent)之間的相互學習以及博弈的過程。

在平均場多智體伊辛模型中,網格中的每個agent向上和向下的獎勵是不同的,如果最終能讓所有agent都朝同一個方向移動(都變為黑色),也就表明了平均場方法能夠比較快速的收斂。通過下面的動圖,可以更直觀地看到這種快速收斂的效果。

研究難點及未來方向

研究人員表示,這項工作有兩方面的難點。首先是理論部分,只有一套嚴格自洽的理論才能作為后續實驗以及分析的基礎。在將平均場論融入多智體強化學習的過程中,他們利用了不同領域里的多項理論,包括平均場論的近似化方法,在stochastic games中的納什均衡學習理論(nash q learning),不動點分析,以及最優化理論中的壓縮映射(contraction mapping)。最后,理論證明了他們所提出的平均場強化學習在一些溫和條件的收斂性,并且提供了近似化中誤差的上下界 。

另一方面的難點在于實驗,由于目前沒有良好的針對多智體強化學習的測試平臺,團隊設計構建了一個實驗環境,用于提供必要的測試條件。

研究人員表示,據他們所知,某些大廠已經在實驗室階段實現了他們的算法,用于大規模派單和通訊設備流量分配。因為這個算法適合處理的特定問題是大規模智能體,并且每個智能體都有相同程度的相似性,實際應用的場景會非常廣闊,例如廣告競價、智能城市等等。

目前,關于多智能體的深度強化學習上,理論層面還是沒有看到太多的發展。這個領域缺乏一個大家都認可的理論框架。例如,多智能體在學習的時候目標函數到底應該是什么,是否應該是納什均衡,還有很多爭論。

更有學者認為,多智能體學習不應該專注個體的決策,反而應該從種群的角度去理解,也就是演化博弈論(evolutionary game theory)的理論框架。演化博弈論認為,關注的重心應該是一個種群里選擇某些行動的agent的比例是不是在進化意義上是穩定的,也就是evolutionary stable strategies的想法。

對此,UCL團隊的研究人員認為,他們接下來將進一步完善理論和實驗方法,探索潛在的實際應用。

論文:平均場多智體強化學習

摘要

現有的多智體(multi-agent)強化學習方法通常限制于少數的智能體(agent)。當agent的數量增加很多時,由于維數以及agent之間交互的指數級的增長,學習變得很困難。

在這篇論文中,我們提出平均場強化學習(Mean FieldReinforcement Learning),其中,agent群體內的交互以單個agent和總體或相鄰agent的平均效應之間的交互來近似;兩個實體之間的相互作用是相互加強的:個體agent的最佳策略的學習取決于總體的動態,而總體的動態則根據個體策略的集體模式而變化。

我們提出了使用的平均場 Q-learning 算法和平均場 Actor-Critic算法,并分析了納什均衡解的收斂性。Gaussian squeeze、伊辛模型(Ising model)和戰斗游戲的實驗,證明了我們的平均場方法的學習有效性。此外,我們還通過無模型強化學習方法報告了解決伊辛模型的第一個結果。

-

人工智能

+關注

關注

1791文章

46896瀏覽量

237669 -

智能體

+關注

關注

1文章

135瀏覽量

10570 -

強化學習

+關注

關注

4文章

266瀏覽量

11220

原文標題:UCL汪軍團隊新方法提高群體智能,解決大規模AI合作競爭

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

請問怎么在同一個PCB文件中設計多個PCB板?

一個APP如何控制多個智能硬件

四大科技巨頭都如何利用AI來相互競爭

如何讓RTOS多任務訪問同一個UART?

SS-431 使多個 Modbus 設備如同一個設備被訪問

FPGA中電源管腳在同一個BANK為何需要多個引腳?

如何讓多個智能體學會一起完成同一個任務,學會彼此合作和相互競爭

如何讓多個智能體學會一起完成同一個任務,學會彼此合作和相互競爭

評論