跨鏡追蹤(Person Re-Identification,簡(jiǎn)稱 ReID)技術(shù)是現(xiàn)在計(jì)算機(jī)視覺(jué)研究的熱門(mén)方向,主要解決跨攝像頭跨場(chǎng)景下行人的識(shí)別與檢索。該技術(shù)能夠根據(jù)行人的穿著、體態(tài)、發(fā)型等信息認(rèn)知行人,與人臉識(shí)別結(jié)合能夠適用于更多新的應(yīng)用場(chǎng)景,將人工智能的認(rèn)知水平提高到一個(gè)新階段。

本期大本營(yíng)公開(kāi)課,我們邀請(qǐng)到了云從科技資深算法研究員袁余鋒老師,他將通過(guò)以下四個(gè)方面來(lái)講解本次課題:

1、ReID的定義及技術(shù)難點(diǎn);

2、常用數(shù)據(jù)集與評(píng)價(jià)指標(biāo)簡(jiǎn)介;

3、多粒度網(wǎng)絡(luò)(MGN)的結(jié)構(gòu)設(shè)計(jì)與技術(shù)實(shí)現(xiàn);

4、ReID在行人跟蹤中的應(yīng)用分析與技術(shù)展望

以下是公開(kāi)課文字版整理內(nèi)容

ReID 是行人智能認(rèn)知的其中一個(gè)研究方向,行人智能認(rèn)知是人臉識(shí)別之后比較重要的一個(gè)研究方向,特別是計(jì)算機(jī)視覺(jué)行業(yè)里面,我們首先簡(jiǎn)單介紹 ReID 里比較熱門(mén)的幾項(xiàng)內(nèi)容:

1、行人檢測(cè)。任務(wù)是在給定圖片中檢測(cè)出行人位置的矩形框,這個(gè)跟之前的人臉檢測(cè)、汽車檢測(cè)比較類似,是較為基礎(chǔ)的技術(shù),也是很多行人技術(shù)的一個(gè)前置技術(shù)。

2、行人分割以及背景替換。行人分割比行人檢測(cè)更精準(zhǔn),預(yù)估每個(gè)行人在圖片里的像素概率,把這個(gè)像素分割出來(lái)是人或是背景,這時(shí)用到很多 P 圖的場(chǎng)景,比如背景替換。舉一個(gè)例子,一些網(wǎng)紅在做直播時(shí),可以把直播的背景替換成外景,讓體驗(yàn)得到提升。

3、骨架關(guān)鍵點(diǎn)檢測(cè)及姿態(tài)識(shí)別。一般識(shí)別出人體的幾個(gè)關(guān)鍵點(diǎn),比如頭部、肩部、手掌、腳掌,用到行人姿態(tài)識(shí)別的任務(wù)中,這些技術(shù)可以應(yīng)用在互動(dòng)娛樂(lè)的場(chǎng)景中,類似于 Kinnect 人機(jī)互動(dòng)方面,關(guān)鍵點(diǎn)檢測(cè)技術(shù)是非常有價(jià)值的。

4、行人跟蹤“ MOT ”的技術(shù)。主要是研究人在單個(gè)攝像頭里行進(jìn)的軌跡,每個(gè)人后面拖了一根線,這根線表示這個(gè)人在攝像頭里行進(jìn)的軌跡,和 ReID 技術(shù)結(jié)合在一起可以形成跨鏡頭的細(xì)粒度的軌跡跟蹤。

5、動(dòng)作識(shí)別。動(dòng)作識(shí)別是基于視頻的內(nèi)容理解做的,技術(shù)更加復(fù)雜一點(diǎn),但是它與人類的認(rèn)知更加接近,應(yīng)用場(chǎng)景會(huì)更多,這個(gè)技術(shù)目前并不成熟。動(dòng)作識(shí)別可以有非常多的應(yīng)用,比如闖紅燈,還有公共場(chǎng)合突發(fā)事件的智能認(rèn)知,像偷竊、聚眾斗毆,攝像頭識(shí)別出這樣的行為之后可以采取智能措施,比如自動(dòng)報(bào)警,這有非常大的社會(huì)價(jià)值。

6、行人屬性結(jié)構(gòu)化。把行人的屬性提煉出來(lái),比如他衣服的顏色、褲子的類型、背包的顏色。

7、跨境追蹤及行人再識(shí)別 ReID 技術(shù)。

一、ReID 定義及技術(shù)難點(diǎn)

▌(一)ReID 定義

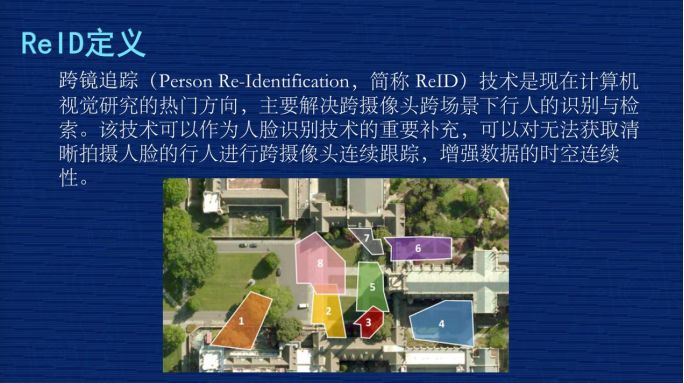

我們把 ReID 叫“跨鏡追蹤技術(shù)”,它是現(xiàn)在計(jì)算機(jī)視覺(jué)研究的熱門(mén)方向,主要解決跨攝像頭跨場(chǎng)景下行人的識(shí)別與檢索。該技術(shù)可以作為人臉識(shí)別技術(shù)的重要補(bǔ)充,可以對(duì)無(wú)法獲取清晰拍攝人臉的行人進(jìn)行跨攝像頭連續(xù)跟蹤,增強(qiáng)數(shù)據(jù)的時(shí)空連續(xù)性。

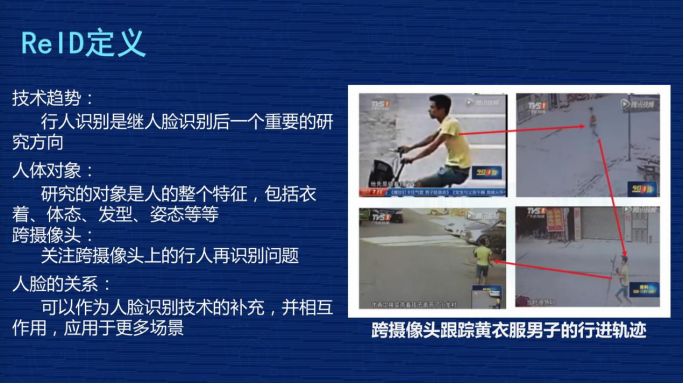

給大家舉個(gè)例子,右圖由四張圖片構(gòu)成,黃色這個(gè)人是之前新聞報(bào)道中的偷小孩事件的人,這個(gè)人會(huì)出現(xiàn)在多個(gè)攝像頭里,現(xiàn)在警察刑偵時(shí)會(huì)人工去檢索視頻里這個(gè)人出現(xiàn)的視頻段。這就是 ReID 可以應(yīng)用的場(chǎng)景,ReID 技術(shù)可以根據(jù)行人的穿著、體貌,在各個(gè)攝像頭中去檢索,把這個(gè)人在各個(gè)不同攝像頭出現(xiàn)的視頻段關(guān)聯(lián)起來(lái),然后形成軌跡,這個(gè)軌跡對(duì)警察刑偵破案有一定幫助。這是一個(gè)應(yīng)用場(chǎng)景。

▌(二)ReID 技術(shù)難點(diǎn)

右邊是 ReID 的技術(shù)特點(diǎn):首先,ReID 是屬于行人識(shí)別,是繼人臉識(shí)別后的一個(gè)重要研究方向。另外,研究的對(duì)象是人的整體特征,包括衣著、體形、發(fā)行、姿態(tài)等等。它的特點(diǎn)是跨攝像頭,跟人臉識(shí)別做補(bǔ)充。

二、常用數(shù)據(jù)集與評(píng)價(jià)指標(biāo)簡(jiǎn)介

很多人都說(shuō)過(guò)深度學(xué)習(xí)其實(shí)也不難,為什么?只要有很多數(shù)據(jù),基本深度學(xué)習(xí)的數(shù)據(jù)都能解決,這是一個(gè)類似于通用的解法。那我們就要反問(wèn),ReID 是一個(gè)深度認(rèn)知問(wèn)題,是不是用這種邏輯去解決就應(yīng)該能夠迎刃而解?準(zhǔn)備了很多數(shù)據(jù),ReID 是不是就可以解決?根據(jù)我個(gè)人的經(jīng)驗(yàn)回答一下:“在 ReID 中,也行!但僅僅是理論上的,實(shí)際操作上非常不行!”

為什么?第一,ReID 有很多技術(shù)難點(diǎn)。比如 ReID 在實(shí)際應(yīng)用場(chǎng)景下的數(shù)據(jù)非常復(fù)雜,會(huì)受到各種因素的影響,這些因素是客觀存在的,ReID 必須要嘗試去解決。

第一組圖,無(wú)正臉照。最大的問(wèn)題是這個(gè)人完全看不到正臉,特別是左圖是個(gè)背面照,右圖戴個(gè)帽子,沒(méi)有正面照。

第二組圖,姿態(tài)。綠色衣服男子,左邊這張圖在走路,右圖在騎車,而且右圖還戴了口罩。

第三組圖,配飾。左圖是正面照,但右圖背面照出現(xiàn)了非常大的背包,左圖只能看到兩個(gè)肩帶,根本不知道背包長(zhǎng)什么樣子,但右圖的背包非常大,這張圖片有很多背包的信息。

第四組圖,遮擋。左圖這個(gè)人打了遮陽(yáng)傘,把肩部以上的地方全部擋住了,這是很大的問(wèn)題。

圖片上只列舉了四種情況,還有更多情況,比如:

1、相機(jī)拍攝角度差異大;

2、監(jiān)控圖片模糊不清;

3、室內(nèi)室外環(huán)境變化;

4、行人更換服裝配飾,如之前穿了一件小外套,過(guò)一會(huì)兒把外套脫掉了;

5、季節(jié)性穿衣風(fēng)格,冬季、夏季穿衣風(fēng)格差別非常大,但從行人認(rèn)知來(lái)講他很可能是同一個(gè)人;

6、白天晚上的光線差異等。

從剛才列舉的情況應(yīng)該能夠理解 ReID 的技術(shù)難點(diǎn),要解決實(shí)際問(wèn)題是非常復(fù)雜的。

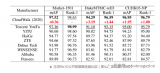

ReID 常用的數(shù)據(jù)情況如何?右圖列舉了 ReID 學(xué)術(shù)界最常用的三個(gè)公開(kāi)數(shù)據(jù)集:

第一列,Market1501。用得比較多,拍攝地點(diǎn)在清華大學(xué),圖片數(shù)量有 32000 張左右,行人數(shù)量是 1500 個(gè),相當(dāng)于每個(gè)人差不多有 20 張照片,它是用 6 個(gè)攝像頭拍的。

第二列,DukeMTMC-reID,拍攝地點(diǎn)是在 Duke 大學(xué),有 36000 張照片,1800 個(gè)人,是 8 個(gè)攝像頭拍的。

第三列,CUHK03,香港中文大學(xué),13000 張照片,1467 個(gè) ID,10 個(gè)攝像頭拍的。

看了這幾個(gè)數(shù)據(jù)集之后,應(yīng)該能有一個(gè)直觀的感受,就是在 ReID 研究里,現(xiàn)在圖片的數(shù)量集大概在幾萬(wàn)張左右,而 ID 數(shù)量基本小于 2000,攝像頭大概在 10 個(gè)以下,而且這些照片大部分都來(lái)自于學(xué)校,所以他們的身份大部分是學(xué)生。

這可以跟現(xiàn)在人臉數(shù)據(jù)集比較一下,人臉數(shù)據(jù)集動(dòng)輒都是百萬(wàn)張或者千萬(wàn)張照片,一個(gè)人臉的 ID 多的數(shù)據(jù)集可以上百萬(wàn),而且身份非常多樣。這個(gè)其實(shí)就是 ReID 面對(duì)前面那么復(fù)雜的問(wèn)題,但是數(shù)據(jù)又那么少的一個(gè)比較現(xiàn)實(shí)的情況。

這里放三個(gè)數(shù)據(jù)集的照片在這里,上面是 Market1501 的數(shù)據(jù)集,比如紫色這個(gè)人有一些照片檢測(cè)得并不好,像第二張照片的人只占圖片的五分之三左右,并不是一個(gè)完整的人。還有些照片只檢測(cè)到了局部,這是現(xiàn)在數(shù)據(jù)集比較現(xiàn)實(shí)的情況。

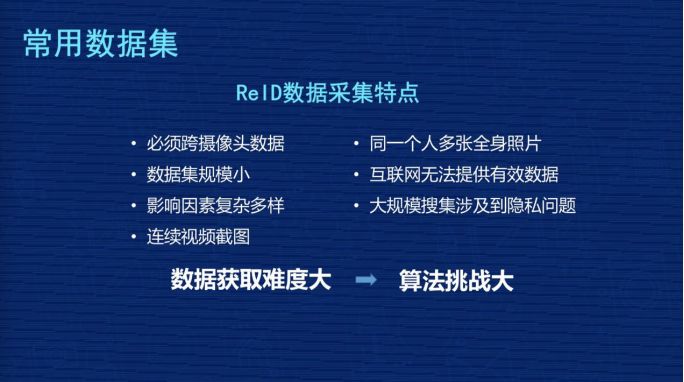

總結(jié)一下 ReID 數(shù)據(jù)采集的特點(diǎn):

1、必須跨攝像頭采集,給數(shù)據(jù)采集的研發(fā)團(tuán)隊(duì)和公司提出了比較高的要求;

2、公開(kāi)數(shù)據(jù)集的數(shù)據(jù)規(guī)模非常小;

3、影響因素復(fù)雜多樣;

4、數(shù)據(jù)一般都是視頻的連續(xù)截圖;

5、同一個(gè)人最好有多張全身照片;

6、互聯(lián)網(wǎng)提供的照片基本無(wú)法用在 ReID;

7、監(jiān)控大規(guī)模搜集涉及到數(shù)據(jù),涉及到用戶的隱私問(wèn)題。

這些都是 ReID 數(shù)據(jù)采集的特點(diǎn),可以歸結(jié)為一句話:“數(shù)據(jù)獲取難度大,會(huì)對(duì)算法提出比較大的挑戰(zhàn)。”問(wèn)題很復(fù)雜,數(shù)據(jù)很難獲取,那怎么辦?現(xiàn)在業(yè)內(nèi)盡量在算法層面做更多的工作,提高 ReID 的效果。

這里講一下評(píng)價(jià)指標(biāo),在 ReID 用得比較多的評(píng)價(jià)指標(biāo)有兩個(gè):

第一個(gè)是 Rank1

第二個(gè)是 mAP

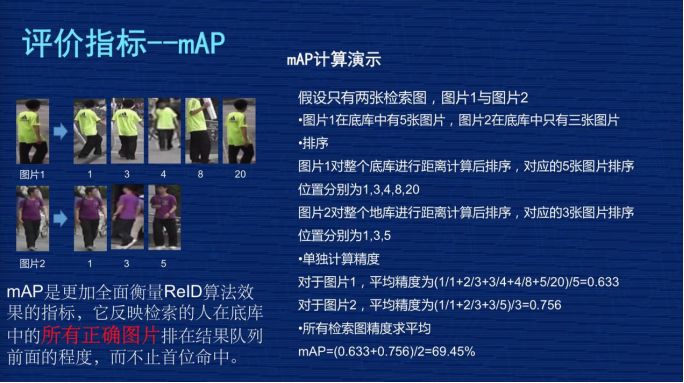

ReID 終歸還是排序問(wèn)題,Rank 是排序命中率核心指標(biāo)。Rank1 是首位命中率,就是排在第一位的圖有沒(méi)有命中他本人,Rank5 是 1-5 張圖有沒(méi)有至少一張命中他本人。更能全面評(píng)價(jià)ReID 技術(shù)的指標(biāo)是 mAP 平均精度均值。

這里我放了三個(gè)圖片的檢索結(jié)果,是 MGN 多粒度網(wǎng)絡(luò)產(chǎn)生的結(jié)果,第一組圖 10 張,從左到右是第 1 張到第 10 張,全是他本人圖片。第二組圖在第 9 張圖片模型判斷錯(cuò)了,不是同一個(gè)人。第三組圖,第 1 張到第 6 張圖是對(duì)的,后面 4 張圖檢索錯(cuò)了,不是我們模型檢索錯(cuò)了,是這個(gè)人在底庫(kù)中總共就 6 張圖,把前 6 張檢索出來(lái)了,其實(shí)第三個(gè)人是百分之百檢索對(duì)的。

詳細(xì)介紹評(píng)價(jià)指標(biāo) mAP。因?yàn)?Rank1 只要第一張命中就可以了,有一系列偶然因素在里面,模型訓(xùn)練或者測(cè)試時(shí)有一些波動(dòng)。但是 mAP 衡量 ReID 更加全面,為什么?因?yàn)樗蟊粰z索人在底庫(kù)中所有的圖片都排在最前面,這時(shí)候 mAP 的指標(biāo)才會(huì)高。

給大家舉個(gè)例子,這里放了兩組圖,圖片 1 和圖片 2 是檢索圖,第一組圖在底庫(kù)中有 5 張圖,下面有 5 個(gè)數(shù)字,我們假設(shè)它的檢索位置,排在第 1 位、第 3 位、第 4 位、第 8 位,第 20 位,第二張圖第 1 位、第 3 位、第 5 位。

它的 mAP 是怎么算的?對(duì)于第一張圖平均精度有一個(gè)公式在下面,就是 0.63 這個(gè)位置。第一張是 1 除以 1,第二張是除以排序?qū)嶋H位置,2 除以 3,第三個(gè)位置是 3 除以 4,第四個(gè)是 4 除以 8,第五張圖是 5 除以 20,然后把它們的值求平均,再總除以總的圖片量,最后得出的 mAP 值大概是 0.63。

同樣的算法,算出圖片 2 的精度是 0.756。最后把所有圖片的 mAP 求一個(gè)平均值,最后得到的 mAP 大概是 69.45。從這個(gè)公式可以看到,這個(gè)檢索圖在底庫(kù)中所有的圖片都會(huì)去計(jì)算 mAP,所以最好的情況是這個(gè)人在底庫(kù)中所有的圖片都排在前面,沒(méi)有任何其他人的照片插到他前面來(lái),就相當(dāng)于同一個(gè)人所有的照片距離都是最近的,這種情況最好,這種要求是非常高的,所以 mAP 是比較能夠綜合體現(xiàn)這個(gè)模型真實(shí)水平的指標(biāo)。

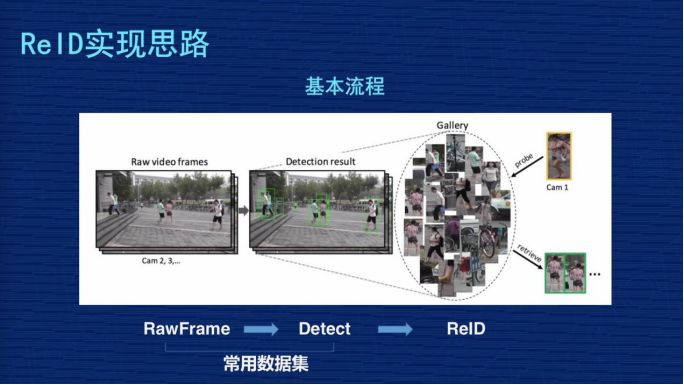

再來(lái)看一下 ReID 實(shí)現(xiàn)思路與常見(jiàn)方案。ReID 從完整的過(guò)程分三個(gè)步驟:

第一步,從攝像頭的監(jiān)控視頻獲得原始圖片;

第二步,基于這些原始圖片把行人的位置檢測(cè)出來(lái);

第三步,基于檢測(cè)出來(lái)的行人圖片,用 ReID 技術(shù)計(jì)算圖片的距離,但是我們現(xiàn)在做研究是基于常用數(shù)據(jù)集,把前面圖像的采集以及行人檢測(cè)的兩個(gè)工作做過(guò)了,我們 ReID 的課題主要研究第三個(gè)階段。

ReID 研究某種意義上來(lái)講,如果抽象得比較高,也是比較清晰的。比如大家看下圖,假設(shè)黃色衣服的人是檢索圖,后面密密麻麻很多小圖組成的相當(dāng)于底庫(kù),從檢索圖和底庫(kù)都抽出表征圖像的特征,特征一般都抽象為一個(gè)向量,比如 256 維或者 2048 維,這個(gè) Match 會(huì)用距離去計(jì)算檢索圖跟庫(kù)里所有人的距離,然后對(duì)距離做排序,距離小的排在前面,距離大的排在后面,我們理解距離小的這些人是同一個(gè)人的相似度更高一點(diǎn),這是一個(gè)比較抽象的思維。

剛才講到核心是把圖像抽象成特征的過(guò)程,我再稍微詳細(xì)的畫(huà)一個(gè)流程,左圖的這些圖片會(huì)經(jīng)過(guò) CNN 網(wǎng)絡(luò),CNN 是卷積神經(jīng)網(wǎng)絡(luò),不同的研究機(jī)構(gòu)會(huì)設(shè)計(jì)自己不同的網(wǎng)絡(luò)結(jié)構(gòu),這些圖片抽象成特征 Feature,一般是向量表示。

然后分兩個(gè)階段,在訓(xùn)練時(shí),我們一般會(huì)設(shè)計(jì)一定的損失函數(shù),在訓(xùn)練階段盡量讓損失函數(shù)最小化,最小化過(guò)程反向把特征訓(xùn)練得更加有意義,在評(píng)估階段時(shí)不會(huì)考慮損失函數(shù),直接把特征抽象出來(lái),用這個(gè)特征代表這張圖片,放到前面那張 PPT 里講的,去計(jì)算它們的距離。

因?yàn)楝F(xiàn)在 ReID 的很多研究課題都是基于 Resnet50 結(jié)構(gòu)去修改的。Resnet 一般會(huì)分為五層,圖像輸入是 (224,224,3),3 是 3 個(gè)通道,每層輸出的特征圖譜長(zhǎng)寬都會(huì)比上一層縮小一半,比如從 224 到 112,112 到 56,56 到 28,最后第五層輸出的特征圖譜是 (7,7,2048)。

最后進(jìn)行池化,變成 2048 向量,這個(gè)池化比較形象的解釋,就是每個(gè)特征圖譜里取一個(gè)最大值或者平均值。最后基于這個(gè)特征做分類,識(shí)別它是行人、車輛、汽車。我們網(wǎng)絡(luò)改造主要是在特征位置(7,7,2048)這個(gè)地方,像我們的網(wǎng)絡(luò)是 384×128,所以我們輸出的特征圖譜應(yīng)該是 (12,4,2048)的過(guò)程。

下面,我講一下 ReID 里面常用的算法實(shí)現(xiàn):

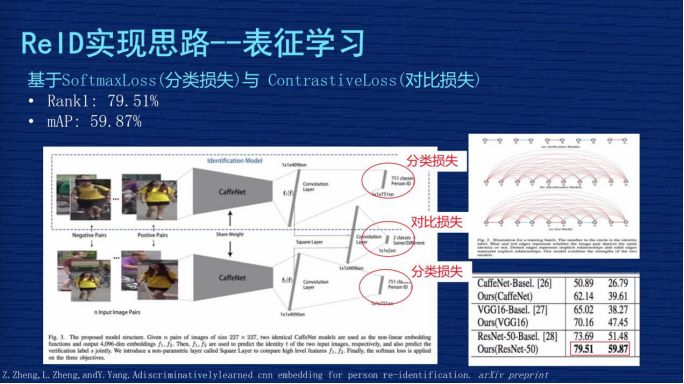

▌第一種,表征學(xué)習(xí)。

給大家介紹一下技術(shù)方案,圖片上有兩行,上面一行、下面一行,這兩行網(wǎng)絡(luò)結(jié)構(gòu)基本是一樣的,但是兩行中間這個(gè)地方會(huì)把兩行的輸出特征進(jìn)行比較,因?yàn)檫@個(gè)網(wǎng)絡(luò)是用了 4096 的向量,兩個(gè)特征有一個(gè)對(duì)比 Loss,這個(gè)網(wǎng)絡(luò)用了兩種 Loss,第一個(gè) Loss 是 4096 做分類問(wèn)題,然后兩個(gè) 4096 之間會(huì)有一個(gè)對(duì)比 Loss。

這個(gè)分類的問(wèn)題是怎么定義的?在我們數(shù)據(jù)集像 mark1501 上有 751 個(gè)人的照片組成,這個(gè)分類相當(dāng)于一張圖片輸入這個(gè)網(wǎng)絡(luò)之后,判斷這個(gè)人是其中某一個(gè)人的概率,要把這個(gè)圖片分類成 751 個(gè) ID 中其中一個(gè)的概率,這個(gè)地方的 Loss 一般都用 SoftmaxLoss。機(jī)器視覺(jué)的同學(xué)應(yīng)該非常熟悉這個(gè),這是非常基本的一個(gè) Loss,對(duì)非機(jī)器視覺(jué)的同學(xué),這個(gè)可能要你們自己去理解,它可以作為分類的實(shí)現(xiàn)。

這個(gè)方案是通過(guò)設(shè)計(jì)分類損失與對(duì)比損失,來(lái)實(shí)現(xiàn)對(duì)網(wǎng)絡(luò)的監(jiān)督學(xué)習(xí)。它測(cè)試時(shí)取的是 4096 這個(gè)向量來(lái)表征圖片本人。這個(gè)文章應(yīng)該是發(fā)在 2016 年,作者當(dāng)時(shí)報(bào)告的效果在當(dāng)時(shí)的時(shí)間點(diǎn)是有一定競(jìng)爭(zhēng)力的,它的 Rank1 到了 79.51%,mAP 是 59.87%

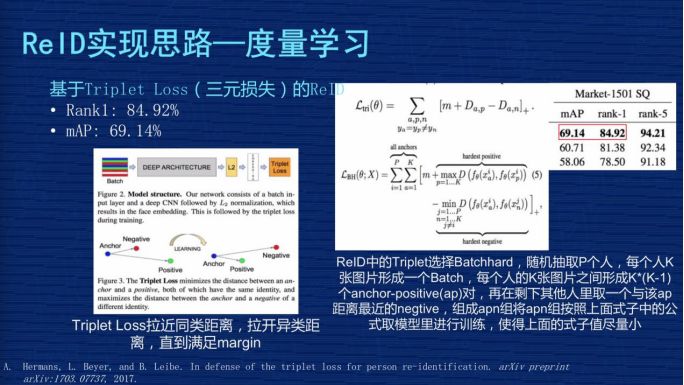

▌第二種,度量學(xué)習(xí)方案。

基于TripletLoss 三元損失的 ReID 方案。TripletLoss 是計(jì)算機(jī)視覺(jué)里另外一個(gè)常用的 Loss。

它的設(shè)計(jì)思路是左圖下面有三個(gè)點(diǎn),目的是從數(shù)據(jù)里面選擇三個(gè)圖片,這三個(gè)圖片由兩個(gè)人構(gòu)成,其中兩張圖片是同一個(gè)人,另外一張圖片不是同一個(gè)人,當(dāng)這個(gè)網(wǎng)絡(luò)在沒(méi)有訓(xùn)練的時(shí)候,我們假設(shè)這同一個(gè)人的兩張照片距離要大于這個(gè)人跟不是同一個(gè)人兩張圖片的距離。

它強(qiáng)制模型訓(xùn)練,使得同一個(gè)人兩張圖片的距離小于第三張圖片,就是剛才那張圖片上箭頭表示的過(guò)程。它真正的目的是讓同類的距離更近,不同類的距離更遠(yuǎn)。這是TripletLoss的定義,大家可以去網(wǎng)上搜一下更詳細(xì)的解釋。

在 ReID 方案里面我給大家介紹一個(gè) Batchhard的策略,因?yàn)?TripletLoss 在設(shè)計(jì)時(shí)怎么選這三張圖是有很多文章在實(shí)現(xiàn)不同算法,我們的文章里用的是 Batchhard算法,就是我們從數(shù)據(jù)集隨機(jī)抽取 P 個(gè)人,每個(gè)人 K 張圖片形成一個(gè) Batch,每個(gè)人的 K 張圖片之間形成一個(gè) K×(K-1)個(gè) ap 對(duì),再在剩下其他人里取一個(gè)與該 ap 距離最近的 negtive,組成 apn 組,然后我們這個(gè)模型使得 apn 組成的 Loss 盡量小。

這個(gè) Loss 怎么定義?右上角有一個(gè)公式,就是 ap 距離減 an距離,m 是一個(gè)gap,這個(gè)值盡量小,使得同類之間盡量靠在一起,異類盡量拉開(kāi)。右圖是 TripletLoss 的實(shí)驗(yàn)方案,當(dāng)時(shí)這個(gè)作者報(bào)告了一個(gè)成果,Rank1 到了 84.92%,mAP 到了 69%,這個(gè)成果在他發(fā)文章的那個(gè)階段是很有競(jìng)爭(zhēng)力的結(jié)果。

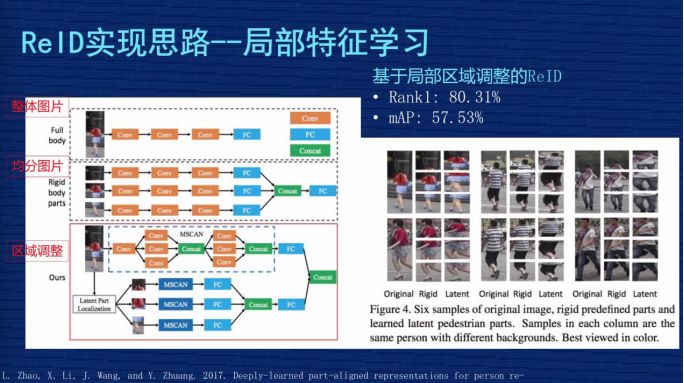

▌第三種,局部特征學(xué)習(xí)。

1、基于局部區(qū)域調(diào)整的 ReID 解決方案。多粒度網(wǎng)絡(luò)也是解決局部特征和全局特征的方案。這是作者發(fā)的一篇文章,他解釋了三種方案。

左圖第一種方案是把整張圖輸進(jìn)網(wǎng)絡(luò),取整張圖的特征;

第二種方案是把圖從上到下均分為三等,三分之一均分,每個(gè)部分輸入到網(wǎng)絡(luò),去提出一個(gè)特征,把這三個(gè)特征又串連起來(lái);

第三種方案是文章的核心,因?yàn)樗X(jué)得第二種均分可能出現(xiàn)問(wèn)題,就是有些圖片檢測(cè)時(shí),因?yàn)闄z測(cè)技術(shù)不到位,檢測(cè)的可能不是完整人,可能是人的一部分,或者是人在圖里面只占一部分,這種情況如果三分之一均分出來(lái)的東西互相比較時(shí)就會(huì)有問(wèn)題。

所以他設(shè)計(jì)一個(gè)模型,使得這個(gè)模型動(dòng)態(tài)調(diào)整不同區(qū)域在圖片中的占比,把調(diào)整的信息跟原來(lái)三分的信息結(jié)合在一起進(jìn)行預(yù)估。作者當(dāng)時(shí)報(bào)告的成果是 Rank1為80% 左右,mAP為57%,用現(xiàn)在的眼光來(lái)講,這個(gè)成果不是那么顯著,但他把圖片切分成細(xì)粒度的思路給后面的研究者提供了啟發(fā),我們的成果也受助于他們的經(jīng)驗(yàn)。

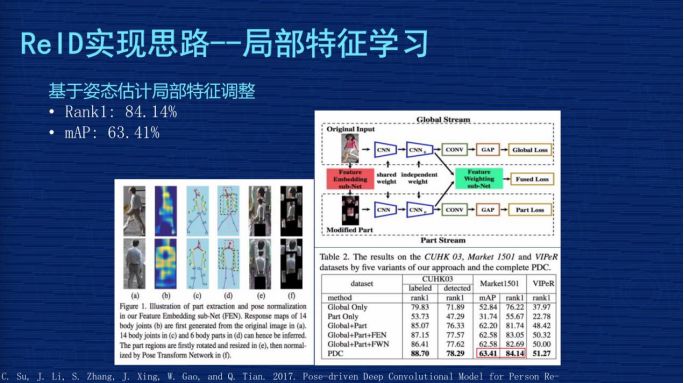

2、基于姿態(tài)估計(jì)局部特征調(diào)整。局部切割是基于圖片的,但對(duì)里面的語(yǔ)義不了解,是基于姿態(tài)估計(jì)局部位置的調(diào)整怎么做?先通過(guò)人體關(guān)鍵點(diǎn)的模型,把這個(gè)圖片里面人的關(guān)節(jié)位置取出來(lái),然后按照人類對(duì)人體結(jié)構(gòu)的理解,把頭跟頭比較,手跟手比較,按照人類的語(yǔ)義分割做一些調(diào)整,這相對(duì)于剛才的硬分割更加容易理解。基于這個(gè)調(diào)整再去做局部特征的優(yōu)化,這個(gè)文章是發(fā)表在 2017 年,當(dāng)時(shí)作者報(bào)告的成果 Rank1為84.14%,mAP為63.41%。

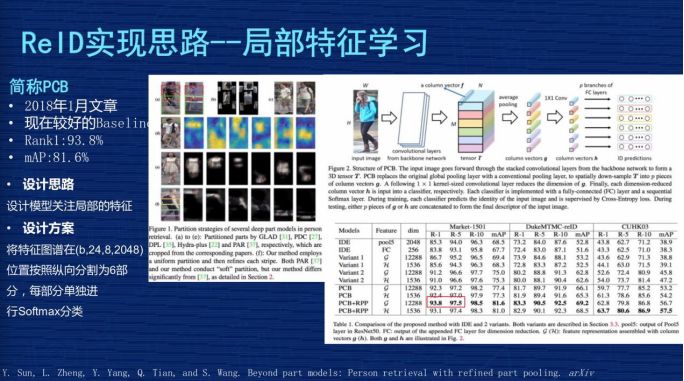

3、PCB。發(fā)表在 2018 年 1 月份左右的文章,我們簡(jiǎn)稱為 PCB,它的指標(biāo)效果在現(xiàn)在來(lái)看還是可以的,我們多粒度網(wǎng)絡(luò)有一部分也是受它的啟發(fā)。下圖左邊這個(gè)特征圖較為復(fù)雜,可以看一下右邊這張圖,右圖上部分藍(lán)色衣服女孩這張圖片輸入網(wǎng)絡(luò)后有一個(gè)特征圖譜,大概個(gè)矩形體組成在這個(gè)地方,這是特征圖譜。這個(gè)圖譜位置的尺寸應(yīng)該是 24×8×2048,就是前面講的那個(gè)特征圖譜的位置。

它的優(yōu)化主要是在這個(gè)位置,它干了個(gè)什么事?它沿著縱向?qū)?4 平均分成 6 份,縱向就是 4,而橫向是 8,單個(gè)特征圖譜變?yōu)?×8×2048,但它從上到下有 6 個(gè)局部特征圖譜。6個(gè)特征圖譜變?yōu)?個(gè)向量后做分類,它是同時(shí)針對(duì)每個(gè)局部獨(dú)立做一個(gè)分類,這是這篇文章的精髓。這個(gè)方式看起來(lái)非常簡(jiǎn)單,但這個(gè)方法跑起來(lái)非常有效。作者報(bào)告的成果在 2018 年 1 月份時(shí) Rank1 達(dá)到了 93.8%,mAP 達(dá)到了 81.6%,這在當(dāng)時(shí)是非常好的指標(biāo)了。

三、多粒度網(wǎng)絡(luò)(MGN)的結(jié)構(gòu)設(shè)計(jì)與技術(shù)實(shí)現(xiàn)

剛才講了 ReID 研究方面的 5 個(gè)方案。接下來(lái)要講的是多粒度網(wǎng)絡(luò)的結(jié)構(gòu)設(shè)計(jì)與實(shí)現(xiàn)。有人問(wèn) MGN 的名字叫什么,英文名字比較長(zhǎng),中文名字是對(duì)英文的一個(gè)翻譯,就是“學(xué)習(xí)多粒度顯著特征用于跨境追蹤技術(shù)(行人在識(shí)別)”,這個(gè)文章是發(fā)表于 4 月初。

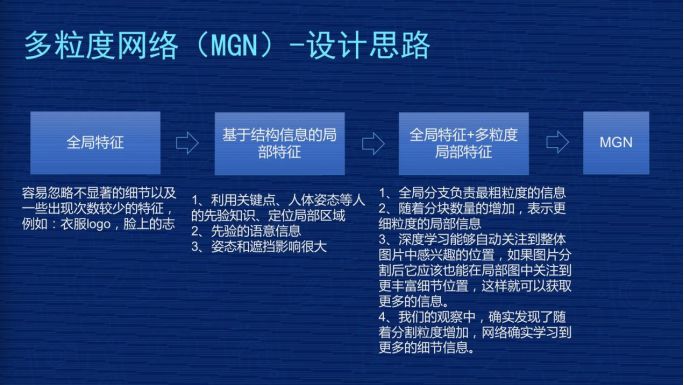

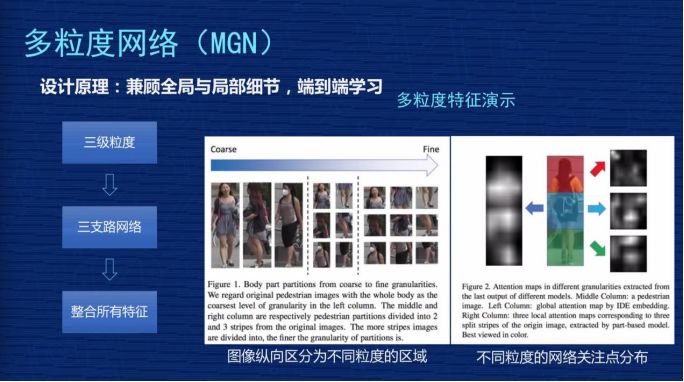

▌(一)多粒度網(wǎng)絡(luò)(MGN)設(shè)計(jì)思路。

設(shè)計(jì)思想是這樣子的,一開(kāi)始是全局特征,把整張圖片輸入,我們提取它的特征,用這種特征比較 Loss 或比較圖片距離。但這時(shí)我們發(fā)現(xiàn)有一些不顯著的細(xì)節(jié),還有出現(xiàn)頻率比較低的特征會(huì)被忽略。比如衣服上有個(gè) LOGO,但不是所有衣服上有 LOGO,只有部分人衣服上有 LOGO。全局特征會(huì)做特征均勻化,LOGO 的細(xì)節(jié)被忽略掉了。

我們基于局部特征也去嘗試過(guò),用關(guān)鍵點(diǎn)、人體姿態(tài)等。但這種有一些先驗(yàn)知識(shí)在里面,比如遮擋、姿態(tài)大范圍的變化對(duì)這種方案有一些影響,效果并不是那么強(qiáng)。

后來(lái)我們想到全局特征跟多粒度局部特征結(jié)合在一起搞,思路比較簡(jiǎn)單,全局特征負(fù)責(zé)整體的宏觀上大家共有的特征的提取,然后我們把圖像切分成不同塊,每一塊不同粒度,它去負(fù)責(zé)不同層次或者不同級(jí)別特征的提取。

相信把全局和局部的特征結(jié)合在一起,能夠有豐富的信息和細(xì)節(jié)去表征輸入圖片的完整情況。在觀察中發(fā)現(xiàn),確實(shí)是隨著分割粒度的增加,模型能夠?qū)W到更詳細(xì)的細(xì)節(jié)信息,最終產(chǎn)生 MGN 的網(wǎng)絡(luò)結(jié)構(gòu)。

下面演示一下多粒度特征,演示兩張圖,左邊第一列有 3 張圖,中間這列把這3張圖用二分之一上下均分,你可以看到同一個(gè)人有上半身、下半身,第三列是把人從上到下分成三塊——頭部、腹胸、腿部,它有 3 個(gè)粒度,每個(gè)粒度做獨(dú)立的引導(dǎo),使得模型盡量對(duì)每個(gè)粒度學(xué)習(xí)更多信息。

右圖表示的是注意力的呈現(xiàn)效果,這不是基于我們模型產(chǎn)生的,是基于之前的算法看到的。左邊是整張圖在輸入時(shí)網(wǎng)絡(luò)在關(guān)注什么,整個(gè)人看著比較均勻,范圍比較廣一點(diǎn)。第三欄從上到下相當(dāng)于把它切成 3 塊,每一塊看的時(shí)候它的關(guān)注點(diǎn)會(huì)更加集中一點(diǎn),亮度分布不會(huì)像左邊那么均勻,更關(guān)注局部的亮點(diǎn),我們可以理解為網(wǎng)絡(luò)在關(guān)注不同粒度的信息。

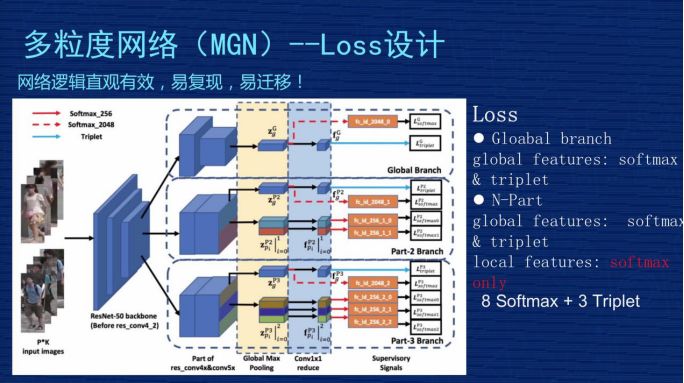

▌(二)多粒度網(wǎng)絡(luò)(MGN)——網(wǎng)絡(luò)結(jié)構(gòu)

這是 MGN 的網(wǎng)絡(luò)架構(gòu)完整的圖,這個(gè)網(wǎng)絡(luò)圖比較復(fù)雜,第一個(gè),網(wǎng)絡(luò)從結(jié)構(gòu)上比較直觀,從效果來(lái)講是比較有效的,如果想復(fù)現(xiàn)我們的方案還是比較容易的。如果你是做深度學(xué)習(xí)其他方向的,我們這個(gè)方案也有一定的普適性,特別是關(guān)注細(xì)粒度特征時(shí),因?yàn)槲覀儾皇侵会槍?duì) ReID 做的。我們?cè)O(shè)計(jì)的結(jié)構(gòu)是有一定普適性,我把它理解為“易遷移”,大家可以作為參考。

首先,輸入圖的尺寸是 384×128,我們用的是 Resnet50,如果在不做任何改變的情況下,它的特征圖譜輸出尺寸,從右下角表格可以看到,global 這個(gè)地方就相當(dāng)于對(duì) Resnet 50不做任何的改變,特征圖譜輸出是 12×4。

下面有一個(gè) part-2 跟 part-3,這是在 Res4_1 的位置,本來(lái)是有一個(gè)stride等于 2 的下采樣的操作,我們把 2 改成1,沒(méi)有下采樣,這個(gè)地方的尺寸就不會(huì)縮小 2,所以 part-2 跟 part-3 比 global 大一倍的尺寸,它的尺寸是 24×8。為什么要這么操作?因?yàn)槲覀儠?huì)強(qiáng)制分配 part-2 跟 part-3 去學(xué)習(xí)細(xì)粒度特征,如果把特征尺寸做得大一點(diǎn),相當(dāng)于信息更多一點(diǎn),更利于網(wǎng)絡(luò)學(xué)到更細(xì)節(jié)的特征。

網(wǎng)絡(luò)結(jié)構(gòu)從左到右,先是兩個(gè)人的圖片輸入,這邊有 3 個(gè)模塊。3 個(gè)模塊的意思是表示 3 個(gè)分支共享網(wǎng)絡(luò),前三層這三個(gè)分支是共享的,到第四層時(shí)分成三個(gè)支路,第一個(gè)支路是 global 的分支,第二個(gè)是 part-2 的分支,第三個(gè)是 part-3 的分支。在 global 的地方有兩塊,右邊這個(gè)方塊比左邊的方塊大概縮小了一倍,因?yàn)樽隽藗€(gè)下采樣,下面兩個(gè)分支沒(méi)有做下采樣,所以第四層和第五層特征圖是一樣大小的。

接下來(lái)我們對(duì) part-2 跟 part-3 做一個(gè)從上到下的縱向分割,part-2 在第五層特征圖譜分成兩塊,part-3 對(duì)特征圖譜從上到下分成三塊。在分割完成后,我們做一個(gè) pooling,相當(dāng)于求一個(gè)最值,我們用的是 Max-pooling,得到一個(gè) 2048 的向量,這個(gè)是長(zhǎng)條形的、橫向的、黃色區(qū)域這個(gè)地方。

但是 part-2 跟 part-3 的操作跟 global 是不一樣的,part-2 有兩個(gè) pooling,第一個(gè)是藍(lán)色的,兩個(gè) part 合在一起做一個(gè) global-pooling,我們強(qiáng)制 part-2 去學(xué)習(xí)細(xì)節(jié)的聯(lián)合信息,part-2 有兩個(gè)細(xì)的長(zhǎng)條形,就是我們剛才引導(dǎo)它去學(xué)細(xì)節(jié)型的信息。淡藍(lán)色這個(gè)地方變成小方體一樣,是做降維,從 2048 維做成 256 維,這個(gè)主要方便特征計(jì)算,因?yàn)榭梢越稻S,更快更有效。我們?cè)跍y(cè)試的時(shí)候會(huì)在淡藍(lán)色的地方,小方塊從上到下應(yīng)該是 8 個(gè),我們把這 8 個(gè) 256 維的特征串連一個(gè) 2048 的特征,用這個(gè)特征替代前面輸入的圖片。

▌(三)多粒度網(wǎng)絡(luò)(MGN)——Loss設(shè)計(jì)

Loss 說(shuō)簡(jiǎn)單也簡(jiǎn)單,說(shuō)復(fù)雜也復(fù)雜也復(fù)雜,為什么?簡(jiǎn)單是因?yàn)檎麄€(gè)模型里只用了兩種Loss,是機(jī)器學(xué)習(xí)里最常見(jiàn)的,一個(gè)是 SoftmaxLoss 一個(gè)是 TripletLoss。復(fù)雜是因?yàn)榉种П容^多,包括 global 的,包括剛才 local 的分支,而且在各個(gè)分支的 Loss 設(shè)計(jì)上不是完全均等的。我們當(dāng)時(shí)做了些實(shí)驗(yàn)和思考去想 Loss 的設(shè)計(jì)。現(xiàn)在這個(gè)方案,第一,從實(shí)踐上證明是比較好的,第二,從理解上也是容易理解的。

首先,看一下 global 分支。上面第一塊的 Loss 設(shè)計(jì)。這個(gè)地方對(duì) 2048 維做了SoftmaxLoss,對(duì) 256 維做了一個(gè) TripletLoss,這是對(duì) global 信息通用的方法。下面兩個(gè)部分 global 的處理方式也是一樣的,都是對(duì) 2048 做一個(gè) SoftmaxLoss,對(duì) 256 維做一個(gè) TripletLoss。中間 part-2 地方有一個(gè)全局信息,有 global 特征,做 SoftmaxLoss+TripletLoss。

但是,下面兩個(gè) Local 特征看不到 TripletLoss,只用了 SoftmaxLoss,這個(gè)在文章里也有討論,我們當(dāng)時(shí)做了實(shí)驗(yàn),如果對(duì)細(xì)節(jié)當(dāng)和分支做 TripletLoss,效果會(huì)變差。為什么效果會(huì)變差?

一張圖片分成從上到下兩部分的時(shí)候,最完美的情況當(dāng)然是上面部分是上半身,下面部分是下半身,但是在實(shí)際的圖片中,有可能整個(gè)人都在上半部分,下半部分全是背景,這種情況用上、下部分來(lái)區(qū)分,假設(shè)下半部分都是背景,把這個(gè)背景放到 TripletLoss 三元損失里去算這個(gè) Loss,就會(huì)使得這個(gè)模型學(xué)到莫名其妙的特征。

比如背景圖是個(gè)樹(shù),另外一張圖是某個(gè)人的下半身,比如一個(gè)女生的下半身是一個(gè)裙子,你讓裙子跟另外圖的樹(shù)去算距離,無(wú)論是同類還是不同類,算出來(lái)的距離是沒(méi)有任何物理意義或?qū)嶋H意義的。從模型的角度來(lái)講,它屬于污點(diǎn)數(shù)據(jù),這個(gè)污點(diǎn)數(shù)據(jù)會(huì)引導(dǎo)整個(gè)模型崩潰掉或者學(xué)到錯(cuò)誤信息,使得預(yù)測(cè)的時(shí)候引起錯(cuò)誤。所以以后有同學(xué)想復(fù)現(xiàn)我們方法的時(shí)候要注意一下, Part-2、part-3 的 Local 特征千萬(wàn)不要加 TripletLoss。

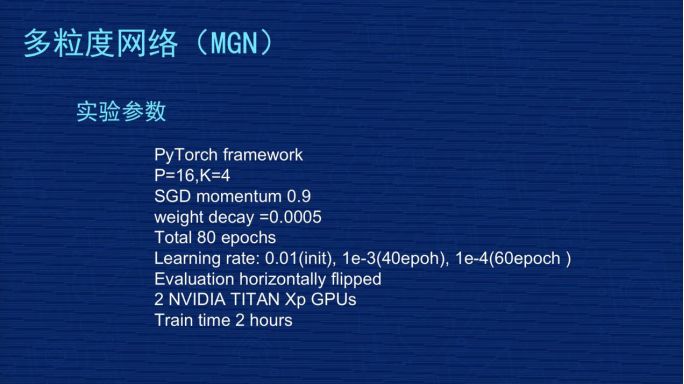

▌(四)多粒度網(wǎng)絡(luò)(MGN)——實(shí)驗(yàn)參數(shù)

圖片展示的是一些實(shí)驗(yàn)參數(shù),因?yàn)楹芏嗤瑢W(xué)對(duì)復(fù)現(xiàn)我們的方案有一定興趣,也好奇到底這個(gè)東西為什么可以做那么好。其實(shí)我們?cè)谖恼吕锇押芏鄥?shù)說(shuō)得非常透,大家可以按照我們的參數(shù)去嘗試一下。

我們當(dāng)時(shí)用的框架是 Pytorch。TripletLoss 復(fù)現(xiàn)是怎么選擇的?我們這個(gè) batch是選 P=16,K=4,16×4,64 張圖作為 batch,是隨機(jī)選擇16 個(gè)人,每個(gè)人隨機(jī)選擇 4 張圖。

然后用 SGD 去訓(xùn)練,我們的參數(shù)用的是 0.9。另外,我們做了weightdecay,參數(shù)是萬(wàn)分之五。像 Market1501 是訓(xùn)練 80epochs,是基于 Resnet50 微調(diào)了。我們之前實(shí)驗(yàn)過(guò),如果不基于 Resnet50,用隨機(jī)初始化去訓(xùn)練的話效果很差,很感謝 Resnet50 的作者,對(duì)這個(gè)模型訓(xùn)練得 非常有意義。

初始學(xué)習(xí)率是百分之一,到 40 個(gè) epoch 降為千分之一,60 個(gè) epoch 時(shí)降為萬(wàn)分之一。我們?cè)u(píng)估時(shí)會(huì)對(duì)評(píng)估圖片做左右翻轉(zhuǎn)后提取兩個(gè)特征,這兩個(gè)特征求一個(gè)平均值,代表這張圖片的特征。剛才有人問(wèn)到我們用了什么硬件,我們用了 2 張的 TITAN 的 GPU。

在 Market1501 上訓(xùn)練 80 epoch的時(shí)間大概差不多是 2 小時(shí)左右,這個(gè)時(shí)間是可以接受的,一天訓(xùn)練得快一點(diǎn)可以做出 5-10 組實(shí)驗(yàn)。

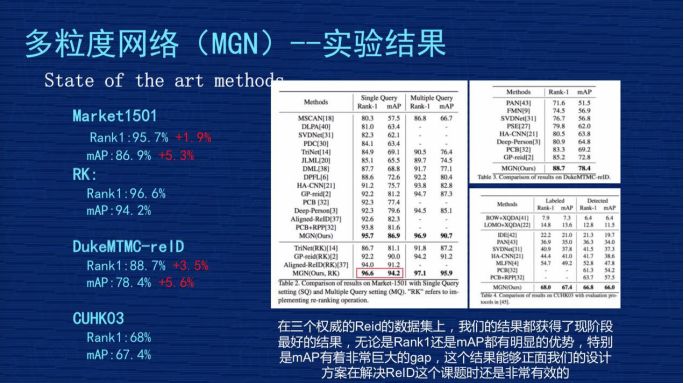

▌(五)多粒度網(wǎng)絡(luò)(MGN)——實(shí)驗(yàn)結(jié)果

我們發(fā)表成果時(shí),這個(gè)結(jié)果是屬于三個(gè)數(shù)據(jù)集上最好的。

1、Market1501。我們不做 ReRank 的時(shí)候,原始的 Rank1 是 95.7%,mAP 是 86.9%,跟剛才講的業(yè)內(nèi)比較好的 PCB 那個(gè)文章相比,我們的 Rank1 提高差不多 1.9 個(gè)點(diǎn),mAP 整整提高 5.3 個(gè)點(diǎn),得到非常大的提升。

2、RK。Rank1 達(dá)到 96.6%,mAP 是 94.2%。RK 是 ReRank 重新排序的簡(jiǎn)稱,ReID 有一篇文章是專門(mén)講 ReRank 技術(shù)的,不是從事 ReID 的同學(xué)對(duì) ReRank 的技術(shù)可能有一定迷惑,大家就理解為這是某種技術(shù),這種技術(shù)是用在測(cè)試結(jié)果重新排列的結(jié)果,它會(huì)用到測(cè)試集本身的信息。因?yàn)樵诂F(xiàn)實(shí)意義中很有可能這個(gè)測(cè)試集是開(kāi)放的,沒(méi)有辦法用到測(cè)試集信息,就沒(méi)有辦法做ReRank,前面那個(gè)原始的 Rank1 和 mAP 比較有用。

但是對(duì)一些已知道測(cè)試集數(shù)據(jù)分布情況下,可以用 ReRank 技術(shù)把這個(gè)指標(biāo)有很大的提高,特別是 mAP,像我們方案里從 86.9% 提升到 94.2%,這其中差不多 7.3% 的提升,是非常顯著的。

3、DukeMTMC-reID和 CUHKO3這兩個(gè)結(jié)果在我們公布研究成果時(shí)算是最好的,我們是4月份公布的成果,現(xiàn)在是 6 月份了,最近 2 個(gè)月 CEPR 對(duì)關(guān)于 ReID 的文章出了差不多 30 幾篇,我們也在關(guān)注結(jié)果。現(xiàn)在除了我們以外最好的成果,原始 Rank1 在 93.5%-94% 之間,mAP 在83.5%-84% 之間,很少看到 mAP 超過(guò) 84% 或者 85% 的關(guān)于。

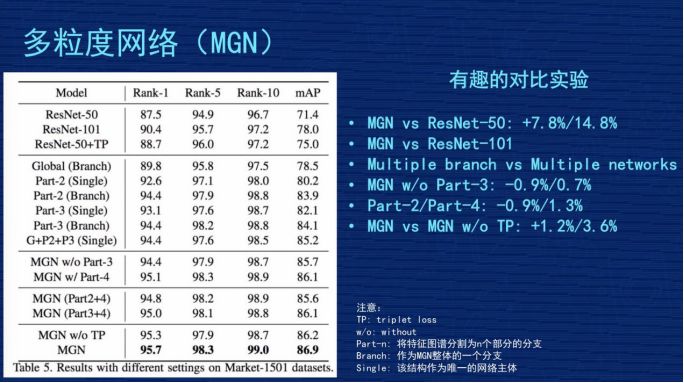

▌(六)多粒度網(wǎng)絡(luò)(MGN)——有趣的對(duì)比實(shí)驗(yàn)

因?yàn)榫W(wǎng)絡(luò)結(jié)構(gòu)很復(fù)雜,這么復(fù)雜的事情能說(shuō)得清楚嗎?里面各個(gè)分支到底有沒(méi)有效?我們?cè)谖恼吕镒隽藥捉M比較有意思的實(shí)驗(yàn),這里跟大家對(duì)比一下。

第一個(gè)對(duì)比,對(duì)比 MGN 跟 Resnet50,這倒數(shù)第二行,就是那個(gè) MGN w/o TP,跟第一行對(duì)比,發(fā)現(xiàn)我們的多粒度網(wǎng)絡(luò)比 Resnet50 水平,Rank1 提高了 7.8%,mAP 提高了14.8%,整體效果是不錯(cuò)的。

第二個(gè)對(duì)比,因?yàn)槲覀兊木W(wǎng)絡(luò)有三個(gè)分支,里面參數(shù)量肯定會(huì)增加,增加的幅度跟 Resnet101的水平差不多,是不是我們網(wǎng)絡(luò)成果來(lái)自于參數(shù)增加?我們做了一組實(shí)驗(yàn),第二行有一個(gè) Resnet101,它的 rank1 是 90.4%,mAP 是 78%,這個(gè)比 Resnet50 確實(shí)好了很多,但是跟我們的工作成果有差距,說(shuō)明我們的網(wǎng)絡(luò)也不是純粹堆參數(shù)堆出來(lái)的結(jié)果,應(yīng)該是有網(wǎng)絡(luò)設(shè)計(jì)的合理性在。

第三個(gè)對(duì)比,表格第二個(gè)大塊,搞了三個(gè)分支,把這三個(gè)分支做成三個(gè)獨(dú)立的網(wǎng)絡(luò),同時(shí)獨(dú)立訓(xùn)練,然后把結(jié)果結(jié)合在一起,是不是效果跟我們差不多,或者比我們好?我們做了實(shí)驗(yàn),最后的結(jié)果是“G+P2+P3(single)”,Rank1 有 94.4%,mAP85.2%,效果也不錯(cuò),但跟我們?nèi)齻€(gè)網(wǎng)絡(luò)聯(lián)合的網(wǎng)絡(luò)結(jié)構(gòu)比起來(lái),還是我們的結(jié)構(gòu)更合理。我們的解釋是不同分支在學(xué)習(xí)的時(shí)候,會(huì)互相去督促或者互相共享有價(jià)值的信息,使得大家即使在獨(dú)立運(yùn)作時(shí)也會(huì)更好。

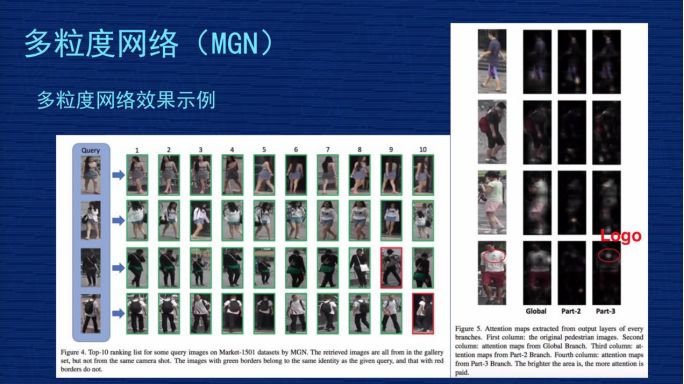

▌(七)多粒度網(wǎng)絡(luò)(MGN)——多粒度網(wǎng)絡(luò)效果示例

這是排序圖片的呈現(xiàn)效果,左圖是排序位置,4 個(gè)人的檢索結(jié)果,前 2 個(gè)人可以看到我們的模型是很強(qiáng)的,無(wú)論這個(gè)人是側(cè)身、背身還是模糊的,都能夠檢測(cè)出來(lái)。尤其是第 3 個(gè)人,這張圖是非常模糊的,整個(gè)人是比較黑的,但是我們這個(gè)模型根據(jù)他的綠色衣服、白色包的信息,還是能夠找出來(lái),盡管在第 9 位有一個(gè)判斷失誤。第 4 個(gè)人用了一張背面的圖,背個(gè)包去檢索,可以發(fā)現(xiàn)結(jié)果里正臉照基本被搜出來(lái)了。

右邊是我們的網(wǎng)絡(luò)注意力模型,比較有意思的一個(gè)結(jié)果,左邊是原圖,右邊從左到右有三列,是 global、part2、part3 的特征組,可以看到 global 的時(shí)候分布是比較均勻的,說(shuō)明它沒(méi)有特別看細(xì)節(jié)。

越到右邊的時(shí)候,發(fā)現(xiàn)亮點(diǎn)越小,越關(guān)注在局部點(diǎn)上,并不是完整的整個(gè)人的識(shí)別。第 4 個(gè)人我用紅圈圈出來(lái)了,這個(gè)人左胸有一個(gè) LOGO,看 part3 右邊這張圖的時(shí)候,整個(gè)人只有在 LOGO 地方有一個(gè)亮點(diǎn)或者亮點(diǎn)最明顯,說(shuō)明我們網(wǎng)絡(luò)在 part3 專門(mén)針對(duì)這個(gè) LOGO 學(xué)到非常強(qiáng)的信息,檢索結(jié)果里肯定是有這個(gè) LOGO 的人排列位置比較靠前。

四、應(yīng)用場(chǎng)景與技術(shù)展望

▌(一)ReID 的應(yīng)用場(chǎng)景

第一個(gè),與人臉識(shí)別結(jié)合。

之前人臉識(shí)別技術(shù)比較成熟,但是人臉識(shí)別技術(shù)有一個(gè)明顯的要求,就是必須看到相對(duì)清晰的人臉照,如果是一個(gè)背面照,完全沒(méi)有人臉的情況下,人臉識(shí)別技術(shù)是失效的。

但 ReID 技術(shù)和人臉的技術(shù)可以做一個(gè)補(bǔ)充,當(dāng)能看到人臉的時(shí)候用人臉的技術(shù)去識(shí)別,當(dāng)看不到人臉的時(shí)候用 ReID 技術(shù)去識(shí)別,可以延長(zhǎng)行人在攝像頭連續(xù)跟蹤的時(shí)空延續(xù)性。右邊位置2、位置3、位置4 的地方可以用 ReID 技術(shù)去持續(xù)跟蹤。跟人臉識(shí)別結(jié)合是大的 ReID 的應(yīng)用方向,不是具象的應(yīng)用場(chǎng)景。

第二個(gè),智能安防。

它的應(yīng)用場(chǎng)景是這樣子的,比如我已經(jīng)知道某個(gè)嫌疑犯的照片,警察想知道嫌疑犯在監(jiān)控視頻里的照片,但監(jiān)控視頻是 24 小時(shí)不間斷在監(jiān)控,所以數(shù)據(jù)量非常大,監(jiān)控?cái)z像頭非常多,比如有幾百個(gè)、幾十個(gè)攝像頭,但人來(lái)對(duì)攝像頭每秒每秒去看的話非常費(fèi)時(shí),這時(shí)可以用 ReID 技術(shù)。

ReID 根據(jù)嫌疑犯照片,去監(jiān)控視頻庫(kù)里去收集嫌疑犯出現(xiàn)的視頻段。這樣可以把嫌疑犯在各個(gè)攝像頭的軌跡串連起來(lái),這個(gè)軌跡一旦串連起來(lái)之后,相信對(duì)警察的破案刑偵有非常大的幫助。這是在智能安防的具象應(yīng)用場(chǎng)景。

第三個(gè),智能尋人系統(tǒng)。

比如大型公共場(chǎng)所,像迪斯尼樂(lè)園,爸爸媽媽帶著小朋友去玩,小朋友在玩的過(guò)程中不小心與爸爸媽媽走散了,現(xiàn)在走散時(shí)是在廣播里播一下“某某小朋友,你爸爸媽媽在找你”,但小朋友也不是非常懂,父母非常著急。

這時(shí)可以用 ReID 技術(shù),爸爸媽媽提供一張小朋友拍的照片,因?yàn)橛螛?lè)園里肯定拍了小朋友拍的照片,比如今天穿得什么衣服、背得什么包,把這個(gè)照片輸入到 ReID 系統(tǒng)里,實(shí)時(shí)的在所有監(jiān)控?cái)z像頭尋找這個(gè)小朋友的照片,ReID 有這個(gè)技術(shù)能力,它可以很快的找到跟爸爸媽媽提供的照片最相似的人,相信對(duì)立馬找到這個(gè)小朋友有非常大的幫助。

這種大型公共場(chǎng)所還有更多,比如超市、火車站、展覽館,人流密度比較大的公共場(chǎng)所。智能尋人系統(tǒng)也是比較具象的 ReID 應(yīng)用場(chǎng)景。

第四個(gè),智能商業(yè)-大型商場(chǎng)。

想通過(guò)了解用戶在商場(chǎng)里的行為軌跡,通過(guò)行為軌跡了解用戶的興趣,以便優(yōu)化用戶體驗(yàn)。ReID 可以根據(jù)行人外觀的照片,實(shí)時(shí)動(dòng)態(tài)跟蹤用戶軌跡,把軌跡轉(zhuǎn)化成管理員能夠理解的信息,以幫助大家去優(yōu)化商業(yè)體驗(yàn)。

這個(gè)過(guò)程中會(huì)涉及到用戶隱私之類的,但從 ReID 的角度來(lái)講,我們比較提倡數(shù)據(jù)源來(lái)自于哪個(gè)商場(chǎng),那就應(yīng)用到哪個(gè)商場(chǎng)。因?yàn)?ReID 的數(shù)據(jù)很復(fù)雜,數(shù)據(jù)的遷移能力是比較弱的,這個(gè)上場(chǎng)的數(shù)據(jù)不見(jiàn)得在另外一個(gè)商場(chǎng)里能用,所以我們提倡 ReID 的數(shù)據(jù)應(yīng)用在本商場(chǎng)。

第五個(gè),智能商業(yè)-無(wú)人超市。

無(wú)人超市也有類似的需求,無(wú)人超市不只是體驗(yàn)優(yōu)化,它還要了解用戶的購(gòu)物行為,因?yàn)槿绻换谌四榿?lái)做,很多時(shí)候是拍不到客戶的正面,ReID 這個(gè)技術(shù)在無(wú)人超市的場(chǎng)景下有非常大的應(yīng)用幫助。

第六個(gè),相冊(cè)聚類。

現(xiàn)在拍照時(shí),可以把相同人的照片聚在一起,方便大家去管理,這也是一個(gè)具象的應(yīng)用場(chǎng)景。

第七個(gè),家庭機(jī)器人。

家庭機(jī)器人通過(guò)衣著或者姿態(tài)去認(rèn)知主人,做一些智能跟隨等動(dòng)作,因?yàn)榧彝C(jī)器人很難實(shí)時(shí)看到主人的人臉,用人臉識(shí)別的技術(shù)去做跟蹤的話,我覺(jué)得還是有一些局限性的。但是整個(gè)人體的照片比較容易獲得,比如家里有一個(gè)小的機(jī)器人,它能夠看到主人的照片,無(wú)論是上半年還是下半年,ReID 可以基于背影或者局部服飾去識(shí)別。

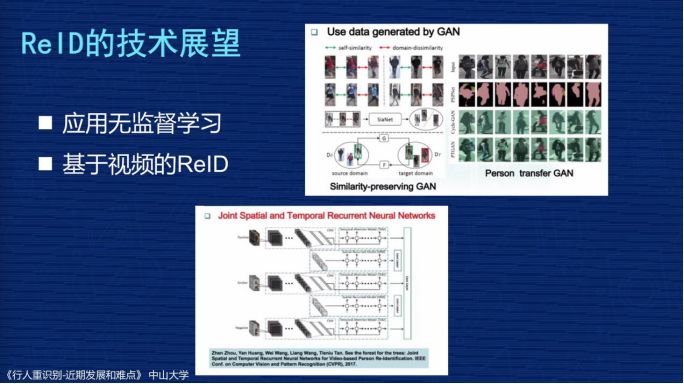

▌(二)ReID 的技術(shù)展望

第一個(gè),ReID 的數(shù)據(jù)比較難獲取,如果用應(yīng)用無(wú)監(jiān)督學(xué)習(xí)去提高 ReID 效果,可以降低數(shù)據(jù)采集的依賴性,這也是一個(gè)研究方向。右邊可以看到,GAN生成數(shù)據(jù)來(lái)幫助 ReID 數(shù)據(jù)增強(qiáng),現(xiàn)在也是一個(gè)很大的分支,但這只是應(yīng)用無(wú)監(jiān)督學(xué)習(xí)的一個(gè)方向。

第二個(gè),基于視頻的 ReID。因?yàn)閯偛艓讉€(gè)數(shù)據(jù)集是基于對(duì)視頻切好的單個(gè)圖片而已,但實(shí)際應(yīng)用場(chǎng)景中還存在著視頻的連續(xù)幀,連續(xù)幀可以獲取更多信息,跟實(shí)際應(yīng)用更貼近,很多研究者也在進(jìn)行基于視頻 ReID 的技術(shù)。

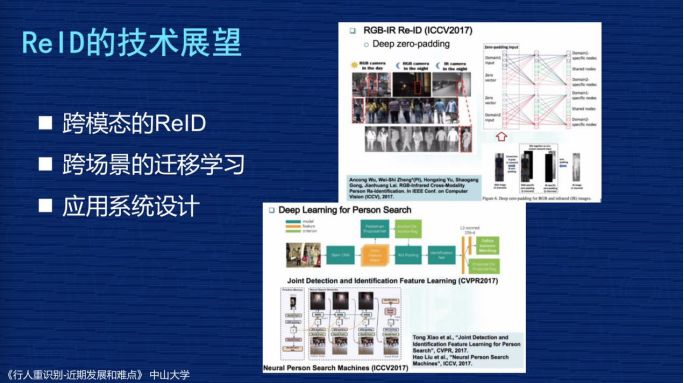

第三個(gè),跨模態(tài)的 ReID。剛才講到白天和黑夜的問(wèn)題,黑夜時(shí)可以用紅外的攝像頭拍出來(lái)的跟白色采樣攝像頭做匹配。

第四個(gè),跨場(chǎng)景的遷移學(xué)習(xí)。就是在一個(gè)場(chǎng)景比如 market1501 上學(xué)到的 ReID,怎樣在 Duke數(shù)據(jù)集上提高效果。

第五個(gè),應(yīng)用系統(tǒng)設(shè)計(jì)。相當(dāng)于設(shè)計(jì)一套系統(tǒng)讓 ReID 這個(gè)技術(shù)實(shí)際應(yīng)用到行人檢索等技術(shù)上去。

-

人工智能

+關(guān)注

關(guān)注

1791文章

46853瀏覽量

237546 -

REID

+關(guān)注

關(guān)注

1文章

18瀏覽量

10848

原文標(biāo)題:云從科技資深算法研究員:詳解跨鏡追蹤(ReID)技術(shù)實(shí)現(xiàn)及難點(diǎn) | 公開(kāi)課筆記

文章出處:【微信號(hào):AI_Thinker,微信公眾號(hào):人工智能頭條】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

電流鏡設(shè)計(jì)步驟詳解【全過(guò)程】

ARM微處理器應(yīng)用開(kāi)發(fā)技術(shù)詳解與實(shí)例分析

自動(dòng)化測(cè)試技術(shù)發(fā)展趨勢(shì)展望分析,不看肯定后悔

使用LabVIEW進(jìn)行物體追蹤圖像處理分析

人工智能即將從“刷臉”跨到“識(shí)人”的新紀(jì)元

云從科技助中國(guó)電信開(kāi)啟人工智能化戰(zhàn)略

刷新三項(xiàng)世界紀(jì)錄的ReID技術(shù)

澎思科技ReID技術(shù)取得新突破

ReID行人重識(shí)別再破行業(yè)新高,多目標(biāo)定位與追蹤精準(zhǔn)呈現(xiàn)

Vulkan光線追蹤技術(shù),實(shí)現(xiàn)跨平臺(tái)和跨系統(tǒng)

基于其自主知識(shí)產(chǎn)權(quán)的新一代商用級(jí)跨鏡追蹤Re-ID技術(shù)

詳解跨鏡追蹤(ReID)應(yīng)用分析與技術(shù)展望

詳解跨鏡追蹤(ReID)應(yīng)用分析與技術(shù)展望

評(píng)論