在AR/VR技術逐漸普及的當下,其中3D模型的使用給我們帶來了許多便利。但是現今3D模型的制作方法還是掌握在專業人士手中,用戶沒有任何切實可行的方式來充分利用AR/VR捕捉并分享他們的真實生活。

在剛過去的五月,Facebook在F8上公布了一項名為3D照片的新功能,通過傾斜手機、就能實現3D視角的變化。

適用于人物、動植物還有風景的拍攝,在室內外和不同光線條件下都可使用。而且只需要一個普通的雙攝像頭智能手機就能夠拍攝,而近兩年的智能手機,有幾家不是雙攝像頭呢?

近日,Facebook公布了該功能的相關論文,那就讓我們一起來看看他們是如何實現的吧。

雙攝本身的存在就是能夠感知景深,從而進行虛化突出中心,比如人物。(此處僅代表實驗所采用的iPhone 7 Plus的長焦攝像頭配置,而這也是大多數廠商的配置),這是因為兩個攝像頭所拍攝到的照片是有差別的,兩者間的差別就能提供深度信息,這與我們人眼能夠獲取深度信息的視網膜差機理一致。

先通過全景拍攝獲取圖像,也可以只是簡單的拍照來獲取圖像。

再通過卷積神經網絡(深度學習)我們就能獲得一個較為明確的深度信息圖像了。

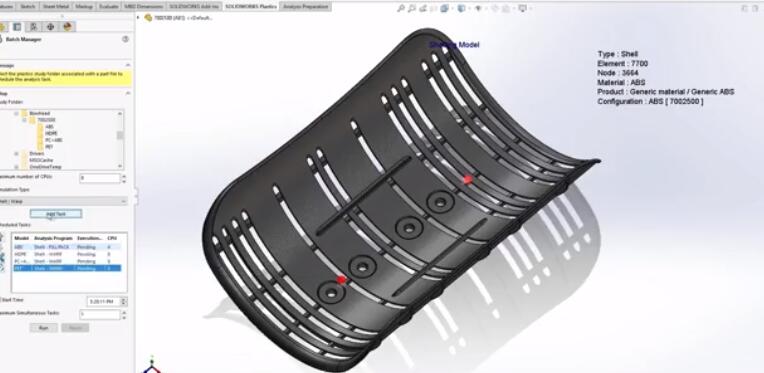

然后將深度信息圖像按照距離分為多層,并用網格表示各個圖像。

再按照不同的深度將各個網格不同程度的撕扯變形,最后再拼接在一起就成為了一個3D照片。

原理上這樣子一個3D照片就處理完成了,但在實際上的過程問題確是不斷出現的。

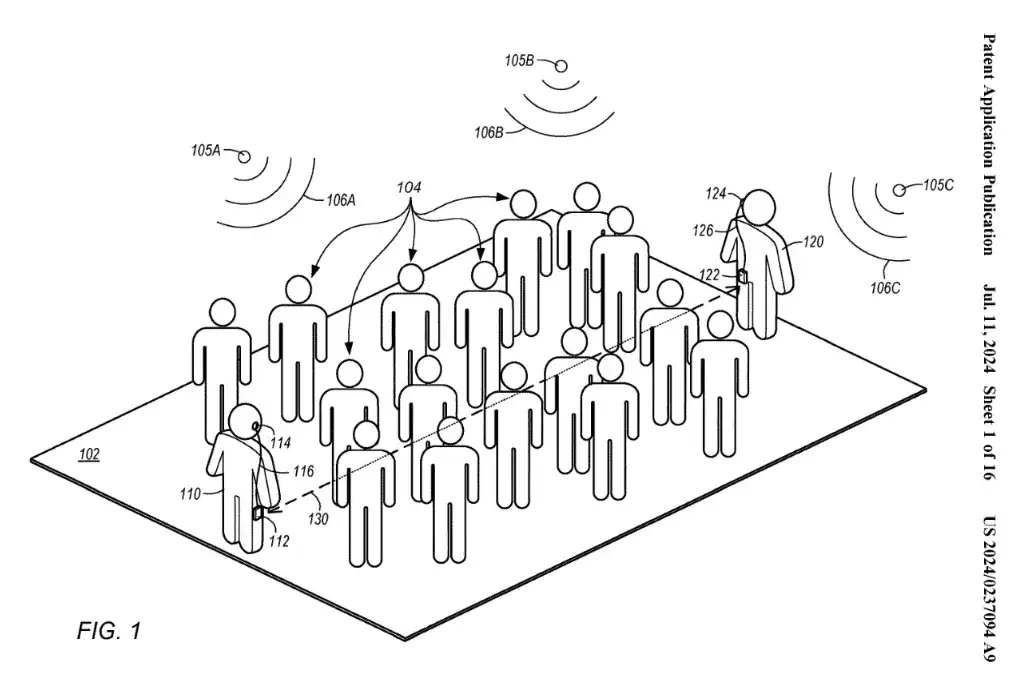

首先是設備本身的問題,雙攝的基線太短了。基線是指拍攝同一位置的兩個攝像機之間的距離,最先開始是航拍上的概念,在雙攝上我們可以理解為兩個攝像頭之間的距離。

理論上基線越大越有利于深度信息的獲取,短基線會使得測量結果充滿不確定性。同時,在拍攝全景時我們的雙手肯定會進行抖動,即使防抖功能也不能完全消除。拍攝期間的移動和旋轉將會造成誤差。

下圖是iPhone 7plus的深度圖像與其它深度圖的對比。a為iPhone 7plus的深度圖像。

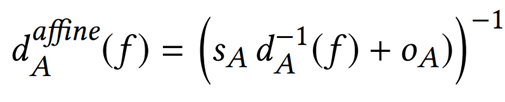

通過他們的全球仿射模型則可以良好的解決這個問題。

將圖a變為圖b,最后再進行拼接就有了圖c了。

同時加上其它的算法,極大的簡化了系統。系統所需要考慮的變量只有用戶拍攝時手機的姿勢,而且降低了短基線所造成的誤差。

另外一個問題還是設備造成的,長焦攝像頭本身視野就相當窄(垂直37°),所以需要捕捉的圖像相較于其他設備也更多,一般場景需要20~200張圖像。研究人員使用自動曝光模式來捕捉更多動態范圍的場景。

接下來的問題就是怎樣把分開的圖像再無縫縫合起來。首先,跟蹤并計算全景的投影中心,然后找到3D點,最大限度的減少圖像之間的距離。

傳統方法的拼接會拉伸圖像,如果不想形成這樣拉伸的三角形,可以選擇不將網格撕得那么大,不過這樣子就會形成空隙。通過算法的改良,研究人得出了一個較為折中的方案,還存在一些拉伸,但減輕了許多。

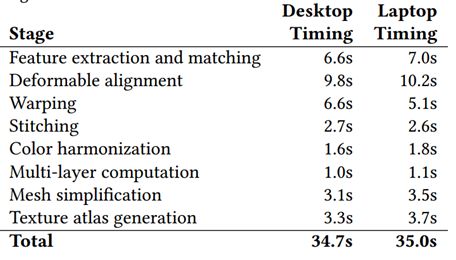

Facebook的3D照片技術,處理一張照片僅僅只需要不到一分鐘時間。

技術的限制還是很明顯的,就是相機的視野太窄了。如果兩個鏡頭都是廣角鏡頭,只需要捕獲少得多的圖像就能達到相同的效果,但是雙攝是為普通照相而服務的存在,都是廣角鏡頭的手機并不會成為主流。

-

智能手機

+關注

關注

66文章

18440瀏覽量

179879 -

VR技術

+關注

關注

2文章

226瀏覽量

18731 -

雙攝像頭

+關注

關注

0文章

111瀏覽量

16961

原文標題:普通雙攝手機就能制作3D照片

文章出處:【微信號:ARchan_TT,微信公眾號:AR醬】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

鐵威馬新品F8 SSD Plus:假期出行的完美存儲“伙伴”

NEO推出3D X-AI芯片,AI性能飆升百倍

3D 建模:塑造未來的無限可能

Meta推出革命性3D Gen AI模型:1分鐘內生成高質量3D內容

SK海力士五層堆疊的3D DRAM生產良率達到56.1%

裸眼3D相框——不一樣的智能相框

是時候了解一下什么是光場裸眼3D技術了

華為公布一項名為“鈉電池復合正極材料及其應用”的發明專利

Adobe Substance 3D整合AI功能:基于文本生成紋理、背景

在微芯片上使用3D反射器堆棧有助于加快6G通信的發展

SOLIDWORKS 3D CAD 2024的10大新增功能

SOLIDWORKS 2024:帶領CAD新功能與3D建模工具的革新

CASAIM沙盤模型3D打印的優勢和應用

Facebook在F8上公布了一項名為3D照片的新功能

Facebook在F8上公布了一項名為3D照片的新功能

評論