目前深度學習的應用較為廣泛,尤其是各種開源庫的使用,導致很多從業人員只注重應用的開發,卻往往忽略了對理論的深究與理解。普林斯頓大學教授Sanjeev Arora近期公開的77頁PPT,言簡意賅、深入淺出的介紹了深度學習的理論——用理論的力量橫掃深度學習!(文末附PPT下載地址)

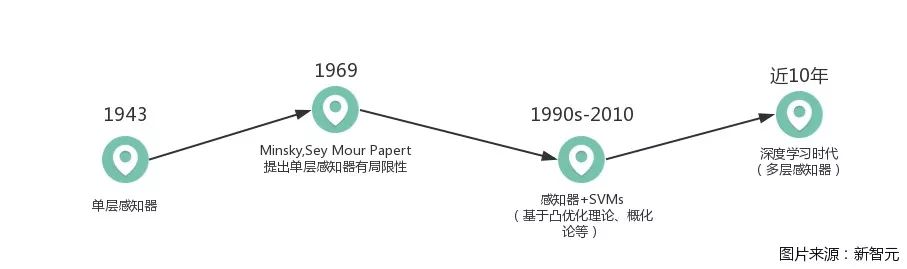

深度學習歷史

學習任何一門知識都應該先從其歷史開始,把握了歷史,也就抓住了現在與未來。——BryanLJ

由圖可以簡單看出深度學習的發展歷史,在經歷了單調、不足與完善后,發展到了如今“動輒DL”的態勢。

定義與基本概念

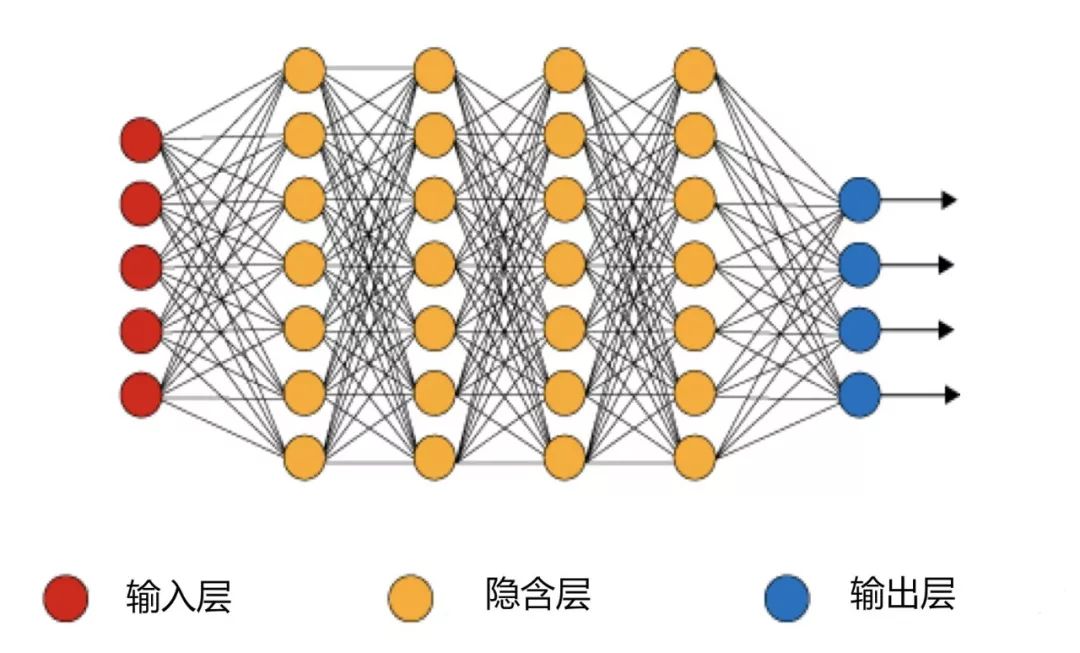

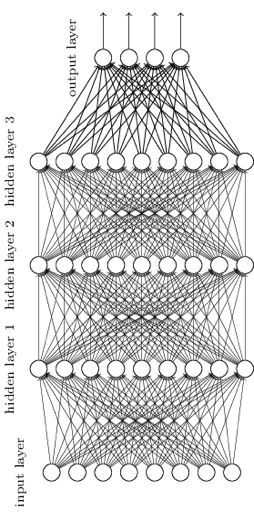

神經網絡基本結構圖:

定義:

訓練集:(x1, y1),(x2, y2),…,(xn, yn)

損失函數ζ(θ,x,y):表示網絡的輸出與點x對應的y的匹配度

目標: argminθEi[ζ(θ,x1, y1)]

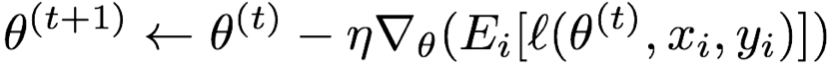

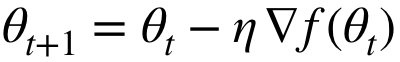

梯度下降:

結合GPUs、大型數據集,優化概念已經塑造了深度學習:

反向傳播:用線性時間算法來計算梯度;

隨機梯度下降:通過訓練集的小樣本評估

梯度、解空間推動形成了殘差網絡(resnet)、WaveNet及Batch-Normalization等;

理論的目標:通過整理定理,得出新的見解和概念。

深度學習中的優化

困難:深度學習中大多數優化問題是非凸(non-convex)的,最壞的情況是NP難問題(NP-hard)。

維數災難:指在涉及到向量的計算的問題中,隨著維數的增加,計算量呈指數倍增長的一種現象

深度學習“黑盒”分析:

原因:

1、無法確定解空間;

2、沒有明確的(xi, yi)數學描述;

所以,求全局最優解是不可行的。

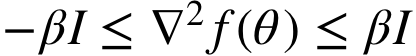

未知解空間中的控制梯度下降:

?≠0→?下降方向,但如果二階導數比較高,允許

?≠0→?下降方向,但如果二階導數比較高,允許 波動很大。為了確保下降,采用由平滑程度

波動很大。為了確保下降,采用由平滑程度 (可由高斯平滑?f來定義)決定的小步驟。

(可由高斯平滑?f來定義)決定的小步驟。

平滑:

要求: 滿足

滿足 且與

且與 成正比。

成正比。

非“黑盒”分析:

很多機器學習問題是深度為2的子案例,例如,輸入層和輸出層之間的一個隱含層。通常假設網絡的結構、數據分布,等等。比起GD/SGD,可以使用不同算法,例如張量分解、最小化交替以及凸優化等等。

過度參數化(over-parametrization)和泛化(generalization)理論

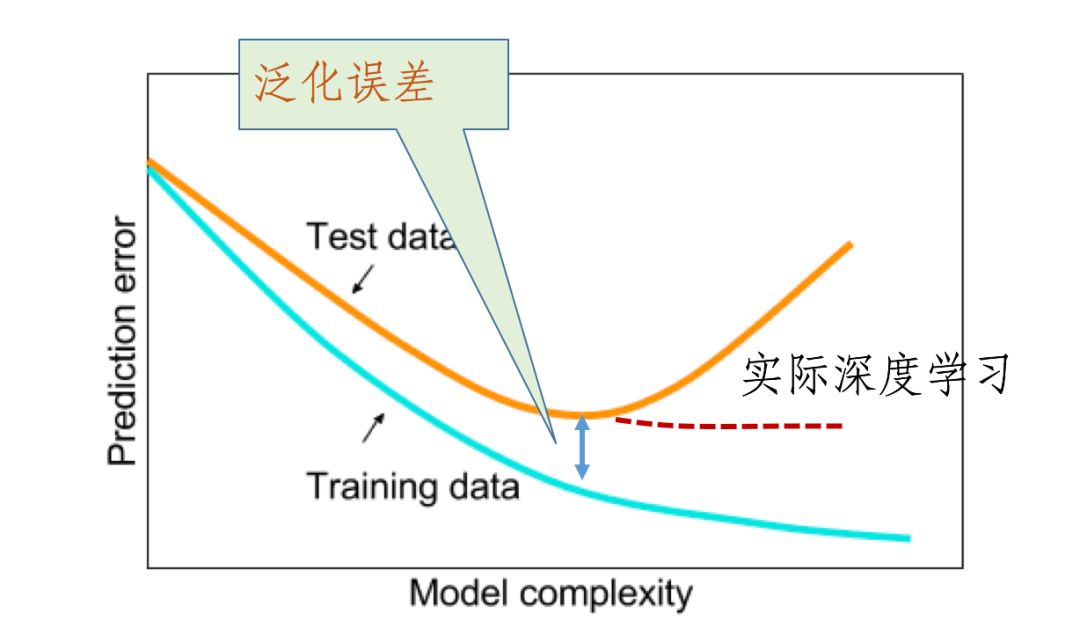

教科書中說:大型模型會導致過擬合

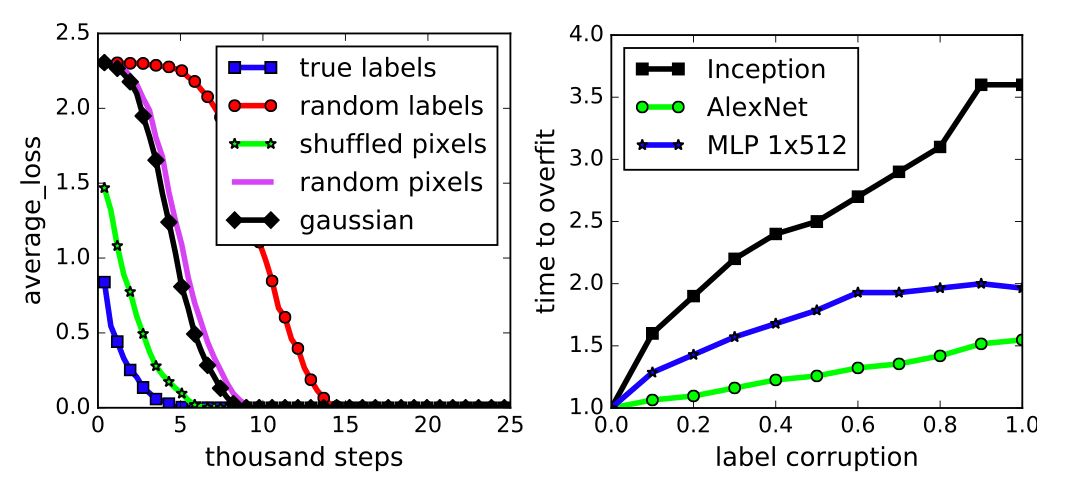

很多人認為:SGD +正則化消除了網絡的“過剩容量”(excess capacity),但是過剩容量依舊還是存在的,如下圖所示:

事實上,在線性模型中也存在同樣的問題。

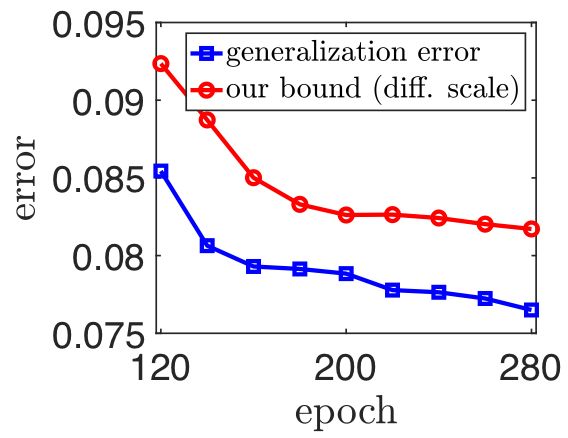

泛化理論:

測試損失(Test Loss)-訓練損失(Training Loss)≤

其中,N是“有效能力”。

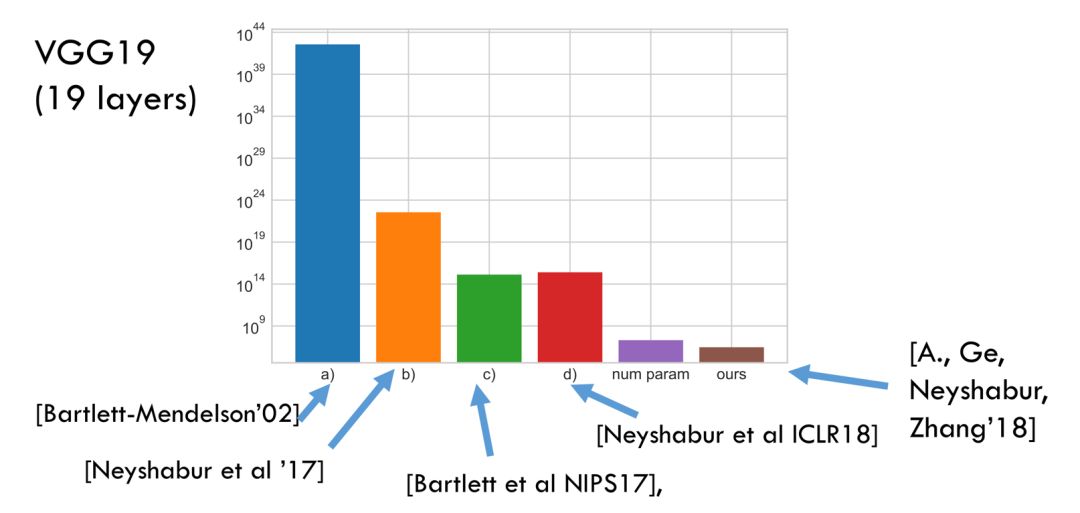

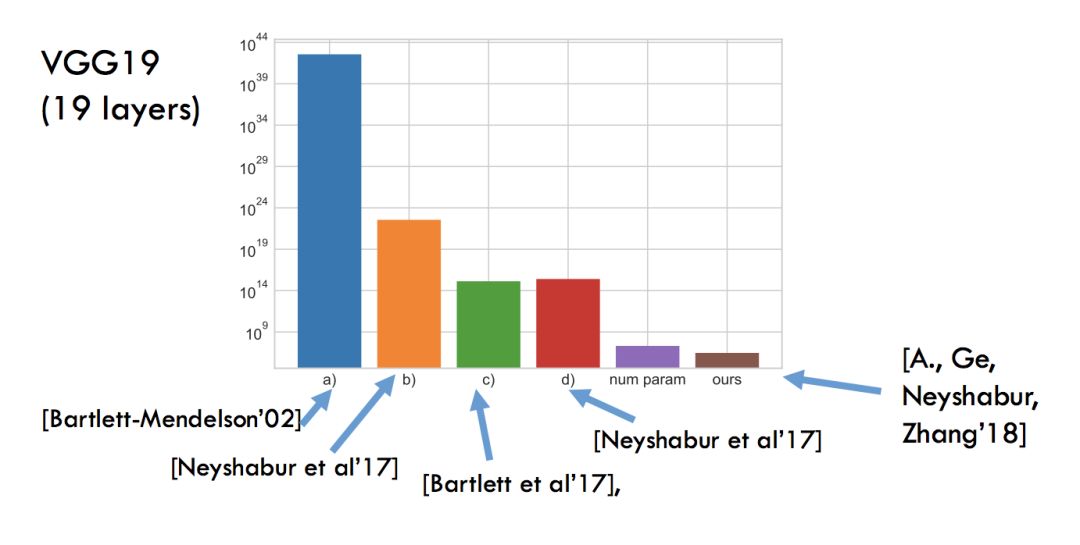

“真實容量”(true capacity)的非空估計被證明是難以捉摸的:

“真實參數”(true parameters)的非空邊界被證明是難以捉摸的:

深度網絡噪聲穩定性(可以視作深度網絡的邊緣概念):

噪聲注入:為一個層的輸出x添加高斯η。

測量更高層次的變化,若變化是小的,那么網絡就是噪聲穩定的。

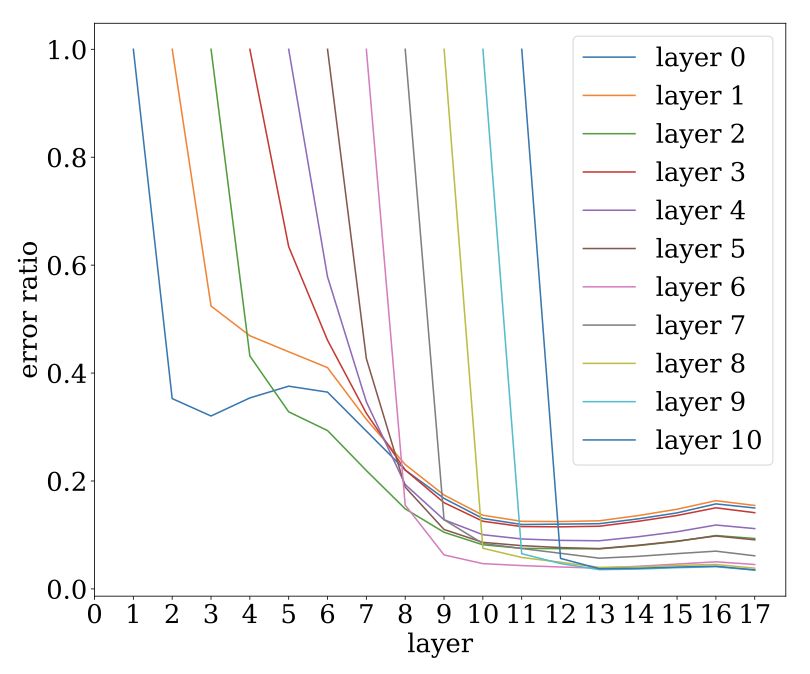

VGG19的噪聲穩定性:

當高斯粒子經過更高層時的衰減過程

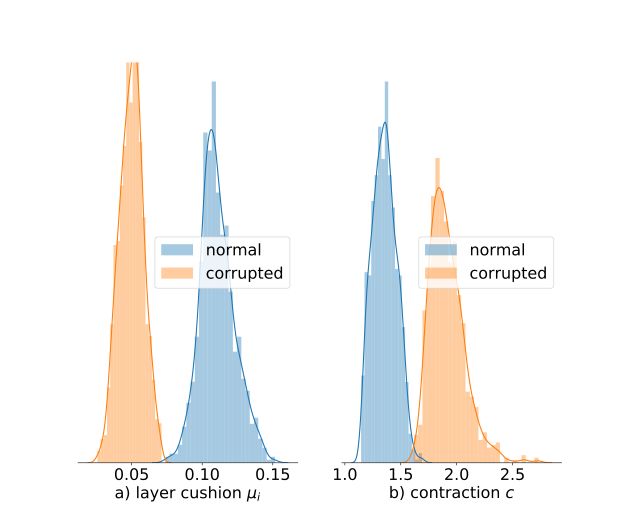

與泛化相關定性實驗:

墊層(layer cushion)在正常數據上的訓練要比在損壞數據上的訓練高得多

在正常數據訓練過程中的進化

“深度”的作用

深度的作用是什么?

理想的結果是:當遇到自然學習問題時,不能用深度d來完成,但可以用深度d+1來完成。但是目前,由于理論依據不足,缺乏“自然”學習問題的數學形式化,還無法達到理想的結果。

深度的增加對深度學習是有益還是有害的?

支持:會出現更好的表現(正如上面實驗結果所示);

反對:使優化更加困難(梯度消失(vanishing gradient)、梯度爆炸(exploding gradient),除非像殘差網絡這樣的特殊架構)。

生成模型與生成對抗網絡(GAN)理論

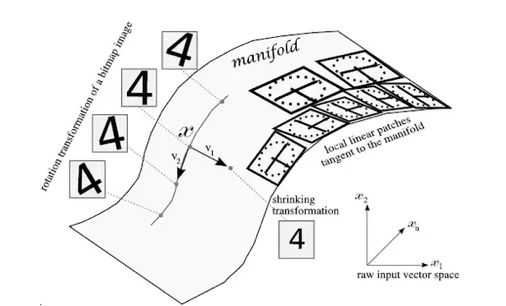

無監督學習:“流行假設”(Mainfold Assumption):

學習概率密度p(X|Z)的典型模型

其中,X是圖像,Z是流行上的編碼。目的是使用大量未標簽的數據集來學習圖像→編碼匹配(code mapping)。

深度生成模型(deep generative model)

隱含假設: Dreal是由合理大小的深度網絡生成的。

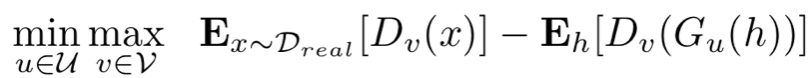

生成對抗網絡(GANs)

動機:

(1)標準對數似然函數值(log-likelihood)目標傾向于輸出模糊圖像。

(2)利用深度學習的力量(即鑒別器網絡,discriminator net)來改進生成模型,而不是對數似然函數。

u:生成網絡可訓練參數

v:鑒別器網絡可訓練參數

鑒別器在訓練后,真實輸入為1,合成輸入為0。

生成器訓練來產生合成輸出,使得鑒別器輸出值較高。

GANs噩夢:模式崩潰(mode collapse)

因為鑒別器只能從少數樣本中學習,所以它可能無法教會生成器產生足夠大的多樣性分布。

評估來自著名GANs的支持大小(support size)

CelaA:200k訓練圖像

DC-GAN:重復500個樣本,500x500 =250K

BiGAN和所有支持大小,1000x1000 =1M

(結果與CIFAR10相似)

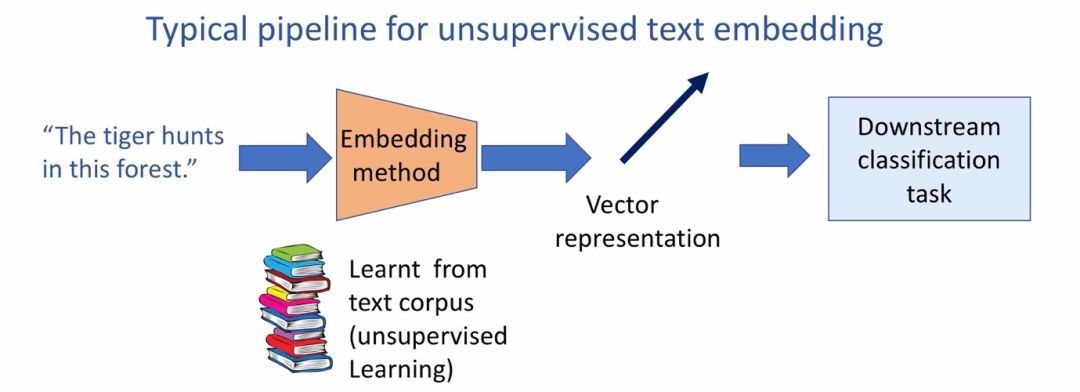

深度學習—自由文本嵌入

無監督學習文字嵌入經典流程

常用方法:復發性神經網絡或LSTM等

手工業(cottage industry)的文本嵌入是線性的:

最簡單的:構成詞(constituent word)的詞嵌入求和

加權求和:通過適應段落數據集來學習權重

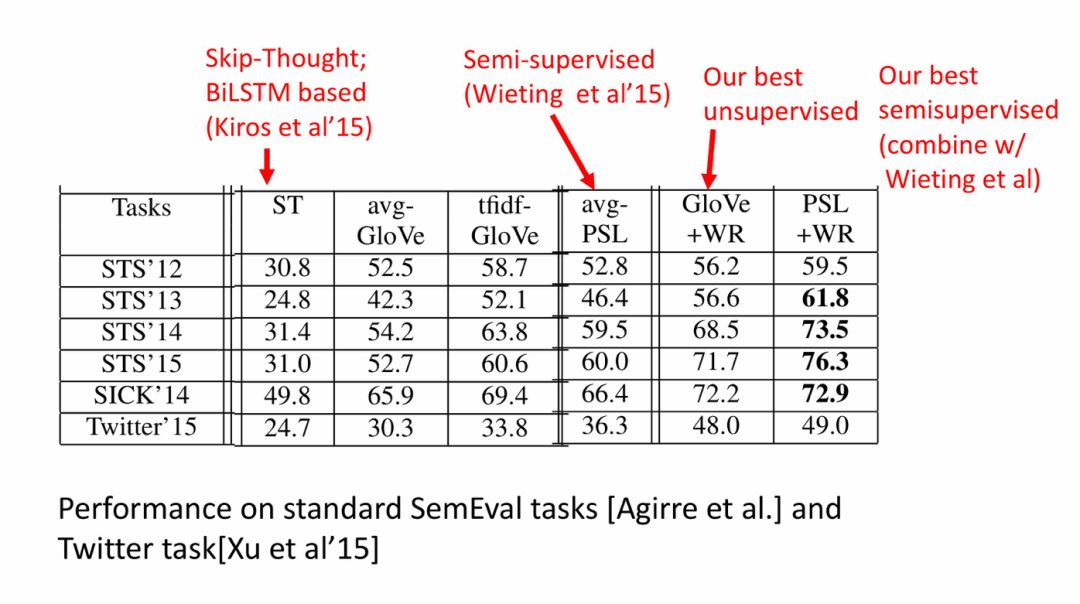

性能(相似性、蘊涵任務):

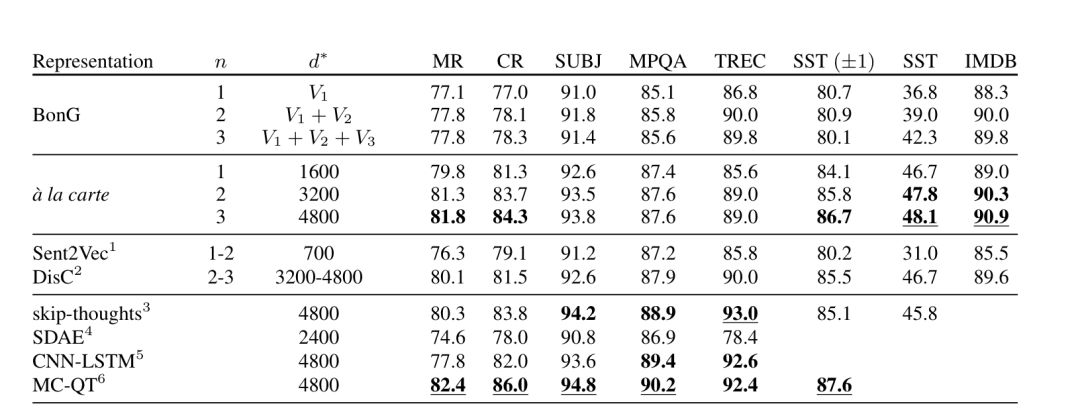

較先進的句子嵌入方法與下游分類(downstream classification)任務的比較:

-

神經網絡

+關注

關注

42文章

4764瀏覽量

100542 -

機器學習

+關注

關注

66文章

8378瀏覽量

132416 -

深度學習

+關注

關注

73文章

5493瀏覽量

120980

原文標題:普林斯頓大學教授:用理論的力量橫掃深度學習(77PPT)

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

[CPLD-FPGA]《深入淺出玩轉FPGA視頻學習課程》35講全[wmv]

深度學習入門基于python的理論與實現PDF電子書免費下載

深度學習入門基于Python的理論與實現的PDF電子書免費下載

深入淺出的介紹了深度學習的理論——用理論的力量橫掃深度學習!

深入淺出的介紹了深度學習的理論——用理論的力量橫掃深度學習!

評論