編者按:UW-Madison統(tǒng)計(jì)學(xué)助理教授Sebastian Raschka簡(jiǎn)明扼要地概述了他的最新研究SAN(半對(duì)抗神經(jīng)網(wǎng)絡(luò))。SAN基于卷積自動(dòng)編碼器進(jìn)行受限優(yōu)化:最大化某一分類器表現(xiàn)的同時(shí)最小化另一分類器表現(xiàn)。

簡(jiǎn)要總結(jié)手頭的項(xiàng)目,和包括同事、學(xué)生在內(nèi)的更一般的受眾分享,我覺得這是一個(gè)不錯(cuò)的主意。因此,我給自己的挑戰(zhàn)是用不到1000個(gè)單詞完成總結(jié),避免讓具體細(xì)節(jié)和技術(shù)術(shù)語(yǔ)分散注意力。

本文主要討論了我最近和iPRoBe實(shí)驗(yàn)室合作的研究項(xiàng)目,研發(fā)隱藏面部圖像的特定信息的技術(shù)。本文談?wù)摰氖顷P(guān)于“保持可用性的同時(shí)最大化隱私”的研究(這一目標(biāo)和差分隱私研究的目標(biāo)有些類似)。

如果你對(duì)本文討論的研究項(xiàng)目感興趣,可以參考以下兩篇論文獲取更多信息:

Semi-Adversarial Networks: Convolutional Autoencoders for Imparting Privacy to Face Images(半對(duì)抗網(wǎng)絡(luò):賦予面部圖像隱私的卷積自動(dòng)編碼器,ICB 2018,arXiv:1712.00321)

Gender Privacy: An Ensemble of Semi Adversarial Networks for Confounding Arbitrary Gender Classifiers(性別隱私:對(duì)抗任意性別分類器的半對(duì)抗網(wǎng)絡(luò)集成,BTAS 2018,arXiv:1807.11936)

保持可用性的同時(shí)改善隱私

我們處理的研究問(wèn)題可以看成一個(gè)更一般的受限優(yōu)化問(wèn)題:我們希望在保持計(jì)量生物學(xué)可用性的同時(shí)隱藏面部圖像的特定信息。具體來(lái)說(shuō),我們有三個(gè)目標(biāo):

擾亂性別信息

確保面部圖像看起來(lái)真實(shí)

保留計(jì)量生物學(xué)識(shí)別可用性

計(jì)量生物學(xué)識(shí)別包括兩種子任務(wù):在一對(duì)多匹配中識(shí)別未知人物的身份(A)和在一對(duì)一匹配中驗(yàn)證某人的身份(B):

這里,“擾亂”性別信息意思是給定的性別分類器不再能夠可靠地預(yù)測(cè)某人的性別。我們可以設(shè)想很多為什么需要防止自動(dòng)提取個(gè)人屬性的理由。這里給出三個(gè)典型的例子:

基于性別的畫像

竊取身份(通過(guò)結(jié)合眾多可以公開獲取的資源)

在用戶不知情的情況下提取數(shù)據(jù)

無(wú)論何時(shí),只要拍攝、上傳、(在中央數(shù)據(jù)庫(kù)中)儲(chǔ)存面部圖像,就可能引起上面提到的問(wèn)題。作為反制措施,在銷售給第三方前,系統(tǒng)(例如,超市監(jiān)控?cái)z像頭)可以預(yù)配性別擾亂技術(shù),使得最終用戶更難侵犯用戶的隱私,防止出于未經(jīng)許可的目的收集數(shù)據(jù)。比如,隱藏面部圖像數(shù)據(jù)庫(kù)中的信息可能同時(shí)有助于確保GDPR合規(guī)。

半對(duì)抗網(wǎng)絡(luò)的一般用途

當(dāng)然,我們輕而易舉就能隱藏性別數(shù)據(jù),只需增加圖像噪聲或加擾到一定程度。然而,我們需要牢記的是顯著改動(dòng)圖像可能同時(shí)讓面部圖像變得無(wú)用(計(jì)量生物學(xué)識(shí)別)。

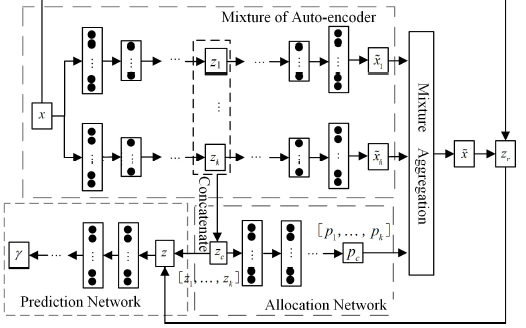

盡管我在上一節(jié)中突出了研發(fā)SAN的主要?jiǎng)訖C(jī)(保持可用性的同時(shí)改善隱私),SAN背后的主要思路可以看成更一般的方法,受限優(yōu)化任意損失函數(shù)。這意味著SAN可以用于任何我們希望在最大化某一分類器的表現(xiàn)的同時(shí)最小化另一分類器的表現(xiàn)的問(wèn)題。因此,即使你處理的不是面部識(shí)別問(wèn)題,SAN同樣可能有助于解決你面臨的受限優(yōu)化任務(wù)。

下一節(jié)將描述我們?cè)贗CB 2018提交的論文中的SAN總體架構(gòu)。

半對(duì)抗網(wǎng)絡(luò)架構(gòu)

根據(jù)我們?cè)谡撐闹刑峁┑膱D像,SAN的架構(gòu)可能看起來(lái)有點(diǎn)晦澀,不過(guò),如果我們將它分成三個(gè)主要部分,就比較直截了當(dāng):

擾亂輸入圖像的自動(dòng)編碼器,確保圖像看起來(lái)接近原圖

能夠給出精確預(yù)測(cè)的面部匹配器

不能給出精確預(yù)測(cè)的性別分類器

SAN的訓(xùn)練過(guò)程可以總結(jié)為以下的PyTorch(偽)代碼:

ae = AutoEncoder()

gc = GenderClassifier()

fm = FaceMatcher()

gc.load_state_dict(torch.load('saved_fm_model.pkl'))

fm.load_state_dict(torch.load('saved_gc_model.pkl'))

for fixed_model in (gc, fm):

for param in fixed_model.parameters():

param.requires_grad = False

optimizer = torch.optim.Adam(ae.parameters(), lr=learning_rate)

for epoch in range(num_total_epochs):

# ...

cost = loss_reconstruction + loss_gender_classification + loss_face_matching

cost.backward()

optimizer.step()

(完整代碼發(fā)布在GitHub倉(cāng)庫(kù)iPRoBe-lab/semi-adversarial-networks) 注意,在評(píng)估SAN模型時(shí),不僅使用了未見面部圖像數(shù)據(jù)集,同時(shí)還丟棄了訓(xùn)練中使用的性別分類器和面部匹配器,使用了一組未見面部匹配器和性別分類器。

致好奇名字由來(lái)的讀者,下圖解釋了為何我們將這一配置稱為半對(duì)抗:

多樣性和概括性

正如我們的BTAS 2018論文提到的,我們最近致力于通過(guò)增強(qiáng)數(shù)據(jù)集等措施改善原SAN模型的概括性表現(xiàn)。例如,為了避免Buolamwini等在Gender shades: Intersectional accuracy disparities in commercial gender classification(性別陰影:商業(yè)性別分類器的區(qū)際差異)中討論的偏差,我們過(guò)采樣了深膚色個(gè)體的隨機(jī)樣本(在大多數(shù)面部數(shù)據(jù)集中為少數(shù)類別),以緩解潛在的偏差。此外,我們擴(kuò)展了評(píng)估組合,引入了更多的未見性別分類器和面部匹配器。

后續(xù)

正如論文中提到的,目前還有很多方面有待探索,比如不同的集成方案,多屬性擴(kuò)展等。

本文大致介紹了我們?cè)赟AN和差分隱私方面的一些研究。更多研究成果即將發(fā)表。同時(shí),我們很興奮,能在今年秋季的BTAS 2018(10月22日-25日,洛杉磯)會(huì)議上呈現(xiàn)我們的最新結(jié)果,以及在ODSC West 2018(10月31日-11月3日)上報(bào)告我們的研究。

-

編碼器

+關(guān)注

關(guān)注

45文章

3601瀏覽量

134205 -

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4765瀏覽量

100568 -

分類器

+關(guān)注

關(guān)注

0文章

152瀏覽量

13175

原文標(biāo)題:安能辨我是雄雌:半對(duì)抗神經(jīng)網(wǎng)絡(luò)如何迷惑性別分類器

文章出處:【微信號(hào):jqr_AI,微信公眾號(hào):論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

[轉(zhuǎn)]LabVIEW實(shí)現(xiàn)窗口最大化和最小化

如何用labview實(shí)現(xiàn)最大化最小化關(guān)閉菜單

labview獲取【顯示器分辨率】并實(shí)時(shí)設(shè)置界面【最大化】和【最小化居中】

HDMI一分二,一分四;DVI一分二,一分四

基于變分自編碼器的異常小區(qū)檢測(cè)

如何才能將網(wǎng)線一分為二?

編碼器分類簡(jiǎn)介

C#教程之自定義窗體的最大化、最小化和關(guān)閉按鈕

稀疏邊緣降噪自動(dòng)編碼器的方法

如何使用深度神經(jīng)網(wǎng)絡(luò)技術(shù)實(shí)現(xiàn)機(jī)器學(xué)習(xí)的全噪聲自動(dòng)編碼器

一種混合自動(dòng)編碼器高斯混合模型MAGMM

什么是一分二功分器 微帶二功分器的目的 微波一分三功分器原理

編碼器是什么?編碼器有哪些分類及應(yīng)用

SAN基于卷積自動(dòng)編碼器進(jìn)行受限優(yōu)化:最大化某一分類器表現(xiàn)的同時(shí)最小化另一分類器表現(xiàn)

SAN基于卷積自動(dòng)編碼器進(jìn)行受限優(yōu)化:最大化某一分類器表現(xiàn)的同時(shí)最小化另一分類器表現(xiàn)

評(píng)論