從AlphaGo到猜畫小歌,Google一再向我們展示著人工智能的神通廣大,前段時間Google又推出一個新的AI實驗網站Move Mirror 。

Move Mirror是一個人工智能實驗,通過移動讓你以一種有趣的新方式來探索圖像,當你在攝像頭前移動時,Move Mirror會通過你的實時動作判定你的人體姿勢,與數百張在世界各地做類似姿勢的人的圖像相匹配,篩選出與你的姿勢最相近的圖像。你甚至可以捕獲做一個GIF圖,與你的朋友分享它。

大概的運作原理是:它會利用PoseNet來鏡像圖像中人體姿勢的關節對應位置,分析后從有80000張素材的數據圖庫中對比出與你姿勢最接近的圖像,而這個過程僅僅需要15ms。并且搜索結果會即時比對隨時變更。

這這要歸功于TensorFlow.js,這是一個允許你在瀏覽器中運行機器學習項目的Javascript庫。通過將PoseNet移植到TensorFlow.js,任何擁有配備好網絡攝像頭的PC或手機的人都可以在Web瀏覽器中體驗和使用這項技術。關于隱私,當PoseNet由tensorflow.js驅動時,這就意味著姿態估計直接發生在瀏覽器中,你的圖像不會被儲存或發送到服務器,所有的圖像識別都在本地進行。所以你可以放心去做一些看著很搞笑或有點蠢的動作。

上段說到PoseNet這是一個由劍橋大學開發的姿態估計開源工具,允許任何Web開發人員完全在瀏覽器中進行基于身體的交互,不需要特殊的相機或C++/Python技能,這是非常先進的姿勢估計模型,即使是一些模糊,低分辨率,黑白的圖片,也可以從圖像數據中提供高度準確的姿勢數據。PoseNet可以通過簡單易獲取的Web API降低了姿態估計的入門門檻。

姿態匹配和搜索是Move Mirror面臨的難點。

PoseNet在面部和身體上檢測17個姿勢關鍵點。每個關鍵點都有三個重要的數據:(x,y)坐標位置(表示PoseNet發現該關鍵點的輸入圖像中的像素位置)和一個置信度得分(PoseNet對猜測的正確程度有多大)。

通過將關鍵點轉化為矢量并繪制在高維空間中,找到兩個最接相似的姿勢。

但是姿態估計是一個動態的問題,每一個關節我們在匹配時候也并非擁有100%的置信度,這時候需要進行加權匹配,即根據重要性的不同不同關節的權值不同,以期待找到最為相似的動作。

通過MoveMirror,谷歌團隊展示了計算機視覺技術,姿態估計(Pose Estimation)。追蹤在3D空間中身體的移動,姿態估計是一個很復雜的問題,因為人們有不同的大小,同時有許多關節可以追蹤,并且周圍物體也會導致視覺遮擋(在過去我們介紹過不少有關技術),有些人使用輪椅拐杖都會影響相機判定。動作捕捉技術十年前就已經被使用,以微軟Kinect為代表的體感設備在游戲領域大放光彩,但使用的硬件都價格不菲,通常還需要其他數據庫和程序支持,這些支持從未普及到大眾開發者和用戶。

這也就是Move Mirror脫穎而出的原因,它讓你只需要瀏覽器和攝像頭就可以做到。

Move Mirror讓我們可以在各種各樣的人身上找到很多樂趣,通過你的動作去搜索舞蹈動作,電影剪輯或者是健身視頻。從另一個方面想,使用姿態估計系統來幫助指導家庭瑜伽鍛煉或物理治療也是一個不錯的選擇。盡管Move Mirror只是一個實驗,但在谷歌團隊眼里,這將是一場姿態實驗在瀏覽器中的寒武紀爆發。

-

Google

+關注

關注

5文章

1758瀏覽量

57417 -

人工智能

+關注

關注

1791文章

46882瀏覽量

237625

原文標題:Google推出Move Mirror趣味AI網站,可在瀏覽器中根據人體動作即時搜圖

文章出處:【微信號:ARchan_TT,微信公眾號:AR醬】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

Google AI Edge Torch的特性詳解

Google AI技術助力中國品牌出海增長

谷歌Vertex AI助力企業生成式AI應用

使用Google Play獲得安全可靠的AI體驗

谷歌推出新款電視盒子Google TV Streamer

使用google-translate和wwe合并后無法使用google-tts怎么解決?

SK海力士推出新一代移動端NAND閃存解決方案

Google Cloud推出基于Arm Neoverse V2定制Google Axion處理器

IBM向全球企業轉型顧問推出新的AI服務平臺—Consulting Advantage

上海AI實驗室發布新一代書生·視覺大模型

智譜AI推出新一代基座大模型GLM-4

PLC中Move指令可以實現什么功能?

Imagen 2 現已在 Vertex AI 上全面推出

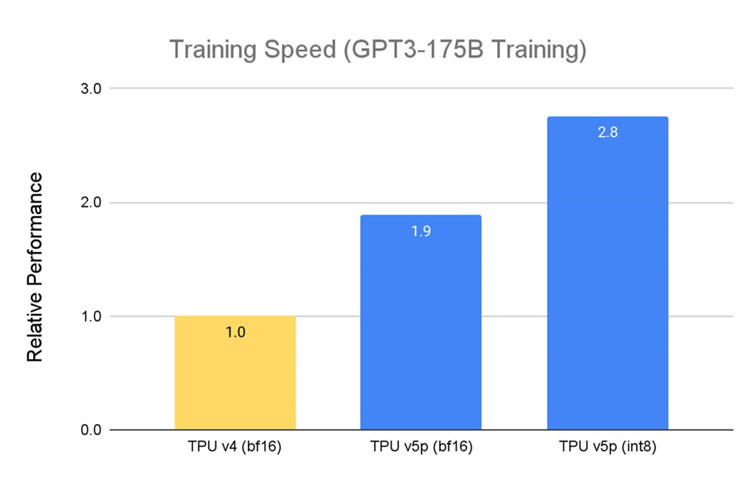

Google Cloud 推出 TPU v5p 和 AI Hypercomputer: 支持下一代 AI 工作負載

Google推出新AI實驗網站Move Mirror

Google推出新AI實驗網站Move Mirror

評論