多任務學習一直是AI研究的長期目標。DeepMind開發了PopArt,解決了不同游戲獎勵機制規范化的問題,它可以玩57款雅達利電子游戲,并且在所有57款游戲中達到高于人類中間水平的表現。

多任務學習——讓單個agent學習如何解決許多不同的任務——這是AI研究的一個長期目標。

近年來,多任務學習領域已經取得許多卓越的進步,例如DQN這樣的智能體能夠使用相同的算法來學習玩多個游戲,包括雅達利經典的 “突出重圍”(Breakout)和 “乒乓球”(Pong)游戲。

這些算法為每項任務訓練一個專家智能體(expert agents)。隨著AI研究向更復雜的現實世界領域發展,構建一個單一的強智能體(general agent)來學習執行多重任務將變得至關重要,而不是構建多個專家智能體。然而,到目前為止,這已經被證明是一項重大挑戰。

原因之一是,強化學習智能體用來判斷成功的獎勵方案經常存在差異,導致他們把注意力集中在獎勵更高的任務上。例如,在雅達利游戲“Pong”中,agent每一步會獲得-1、0或+1的獎勵:

Pong游戲中,兩道豎杠代表球拍,一個小光點代表球在屏幕上蹦蹦跳跳,由人操縱按紐控制反彈,打不中就失去一分

相比之下,在“吃豆人”游戲中,agent每走一步就可獲得幾百、幾千的分數。即使個體獎勵的規模相似,但隨著agent變得更好,獎勵的頻率會隨著時間推移而變化。

這意味著agent傾向于關注那些有很高分數的任務,導致在某些任務上表現更好,而在其他任務上表現更差。

為了解決這些問題,DeepMind開發了PopArt,它可以調整每一款游戲的分數等級,這樣不管游戲原本的獎勵等級如何規定,AI智能體都會判斷游戲具有同等的學習價值。

PopArt:在保持輸出完好的同時,自適應地重新調整目標(PreservingOutputsPrecisely whileAdaptivelyRescalingTargets)。

DeepMind將PopArt規范化應用到最先進的強化學習智能體上,從而得到一個單一的智能體,它可以玩57款雅達利電子游戲,并且在所有57款游戲中達到高于人類中間水平的表現。

PopArt:規范化獎勵,不影響目標

一般來說,深度學習依賴于不斷更新的神經網絡的權重,使神經網絡的輸出更接近期望的目標輸出。當神經網絡被用于深度強化學習時也是如此。PopArt通過估計這些目標的平均值和傳播范圍(比如游戲中的得分)來工作。然后,它使用這些數據對目標進行規范化,再利用它們來更新網絡的權重。

使用規范化的目標可以使學習更加穩定和強大,以適應規模和轉換的變化。為了獲得準確的估計——例如對未來的預期分數的估計——網絡的輸出可以通過反轉規范化過程來重新調整到真實的目標范圍。如果直接這樣做,每次更新統計數據都會改變所有未規范化的輸出,包括那些已經非常好的輸出。我們通過向相反的方向更新網絡來防止這種情況的發生。這意味著我們可以在保持以前學習過的輸出完好的同時,獲得大規模更新的好處。

傳統上,研究人員通過在強化學習算法中使用獎勵修剪(rewardclipping)來克服不同獎勵尺度的問題。這種方法將很大或很小的分數修剪為1或-1分的得分,大致使預期獎勵規范化。雖然這使學習變得更容易,但是它也改變了agent的目標。

例如,在“吃豆人小姐”(Ms. Pac-Man)游戲中,吃豆人的目標是收集豆子,吃到每個豆子獲得10分,吃到鬼魂獲得200到1600分。通過修剪獎勵,agent吃一個豆子和吃一個鬼魂得到的獎勵沒有明顯的區別,導致agent只吃豆子,從不去追逐鬼魂。如下面的視頻所示:

當我們用PopArt的自適應規范化來代替reward clipping,結果導致了智能體完全不同的行為。它會追逐鬼魂,并且獲得了更高的分數。

使用PopArt進行多任務深度強化學習

我們將PopArt應用于Importance-weighted Actor-Learner Architecture(IMPALA),這是DeepMind最流行的深度強化學習智能體之一。在實驗中,與沒有使用PopArt的baseline agent相比,PopArt大大提高了agent的表現。無論是修剪了獎勵還是沒有修剪獎勵,PopArt智能體在游戲中的中位數得分都高于人類中位數得分。

這遠遠高于使用reward clipping的baseline,而沒有使用reward clipping的baseline根本無法達到有意義的表現,因為它無法有效地處理不同游戲之間的獎勵尺度的巨大變化。

57款Atari游戲的標準化表現中位數。每一行對應于單個智能體的中位數表現,該智能體被訓練來使用相同的神經網絡來玩所有這些游戲。實線表示使用 reward clipping的表現,虛線表示沒有使用 reward clipping的表現。

這是我們第一次在使用單一智能體的這種多任務環境中看到超過人類的表現,這表明PopArt可以為如何在無需手動修剪或調整的情況下平衡各種目標的開放式研究問題提供一些解決方案。當我們將AI應用于更復雜的多模態領域時,AI在學習過程中自動適應規范化的能力變得非常重要,因為在這些領域中,AI智能體必須學會權衡各種不同的獎勵和不同的目標。

-

神經網絡

+關注

關注

42文章

4765瀏覽量

100566 -

智能體

+關注

關注

1文章

135瀏覽量

10570 -

DeepMind

+關注

關注

0文章

129瀏覽量

10823

原文標題:強化學習重大突破:DeepMind用一個AI在57個游戲中全面超越人類

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

貼片知識課堂十一,PCB設計規范化第第三節

關于發帖標題規范化管理公告

未來的AI 深挖谷歌 DeepMind 和它背后的技術

一種創新的無監督文本規范化系統

數據庫-關系規范化的詳細資料介紹,為什么要對進行關系的規范化?

淺析FPGA規范化的重要性

原理圖繪制規范電子版資料下載

基于規范化函數的深度金字塔模型算法

怎么樣才能讓Java代碼編寫更規范化

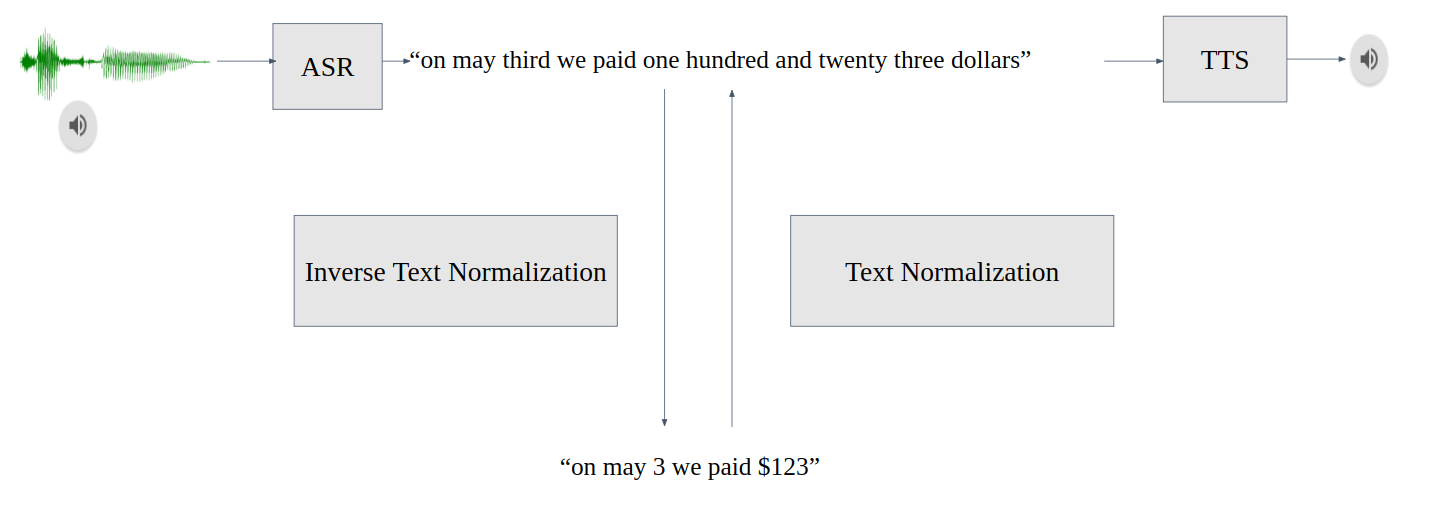

使用NVIDIA NeMo進行文本規范化和反向文本規范化

DeepMind開發了PopArt,解決了不同游戲獎勵機制規范化的問題

DeepMind開發了PopArt,解決了不同游戲獎勵機制規范化的問題

評論