多年來,半導體行業一直致力于將越來越多的組件緊密的集成到單個片上系統中(SoC)。畢竟這對于龐大的應用而言是非常實用的解決方案。通過優化處理器的定位,存儲器和外部設備芯片廠商能夠將數據路徑調整到最短,從而提高功率效率并取得更高的性能,此外還能夠顯著的降低成本。通過這些方法,該行業已經取得了巨大的成功,SoC幾乎是我們所有消費電子產品的標準組件。

AI作為一種標準

隨著更多的公司意識到利用神經網絡處理各種任務(比如自然語言處理、圖片識別分類)的巨大潛力,引入人工智能要素的產品數量也在穩步增加。與此同時,這些任務的處理過程正在從基于云的架構遷移到本地終端設備來實現,現在專用硬件神經網絡加速器也已經嵌入到SoC器件中。

AI正集成到更多的SoC器件中

從語音激活的消費電子產品(比如虛擬助理)到高級的駕駛輔助系統(ADAS),集成的神經網絡人工智能(AI)所面臨的機會正在多個細分的市場中展開,不可否認,人工智能(AI)被認為是許多解決方案必不可少的要素。

一種方法不能適用所有

然而,盡管AI應用程序的數量正在不斷增加,但這并不意味著集成有AI加速功能的SoCs能夠適用所有的場景。實際上,如果我們考慮AI能夠覆蓋大多數的細分市場,那么由于使用該技術的產品可能有很多不同的處理要求,自然就會產生碎片化的差異。細分的市場對于專用的SoC器件是一種挑戰,因此“一刀切”通用的方案不再適用。雖然一些市場(比如智能手機、ADAS)為SoC供應商提供了大量的機會,但是很多針對AI使用的市場目前仍然比較低迷。例如某些產品可能需要AI進行語音處理或圖像識別,但不一定兩者都需要。同樣的智能家居供應商認為將傳統的智能手機SoC嵌入AI功能就集成到他們的產品中并不是很好的解決方案,因為這不符合成本效益。

認識AI協同芯片

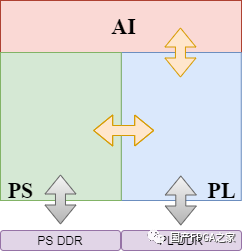

現在臺式機CPU和移動SoC大多都采用多核芯片,因為它們靈活的可擴展架構使其能夠按需提供不同的性能,AI“協同芯片”采用類似的方法,它們不僅僅只被設計成一個,而是多個計算GPU和神經網絡加速器(NNA)來為特定的應用提供足夠的性能,同時確保對硅片尺寸進行優化,將芯片的成本降至最低。這些處理器會緊挨著主應用處理器(SoC)作為“協同芯片”,承載主應用處理器上的NNA內核需要處理的AI推理任務。

現在SoC供應商有機會創建一個傳統的通用應用處理器,能夠經濟高效的適用于多個市場,同時可以配套AI協同芯片來滿足一些特定應用或小眾應用對于AI功能的需求。

從OEM廠商的角度來看,他們現在可以選擇適當地擴展自己的產品解決方案,這取決于他們期望在整個應用方案中對于AI處理操作的開銷。

一個AI處理器的例子:根據不同應用NNA的數量可以靈活的增減

典型的協同AI SoC芯片包括負責內部事務的通用控制CPU、用于高性能計算的GPU內核(而不是專門用于處理圖形和3D變換操作)以及多個NNA(神經網絡加速器),根據不同的神經網絡和推理引擎可靈活組合,此外還可以根據不同的任務采用不同的精度。舉個例子,在雙NNA系統中,其中一個NNA可以用來執行圖像識別任務,將結果傳遞給另一個NNA之前能夠識別出場景中的人臉部分,另一個NNA會將人臉部分劃分為單獨的特征從而識別出面部表情。

另一個例子就是汽車,對六核心的AI協同芯片進行分區,其中三個NNA(每個NNA負責不同的方面)用來識別道路上的標志,與此同時另外三個將專門負責行人檢測。NNA的數量和任務的分配是根據應用的需求而確定的。這個概念可以擴展到一系列專用的AI處理器,每個處理器都會集成不同數量的NNA來滿足不同任務的性能需求。

從云端到本地

我們已經看到了部署在云端的專用AI芯片,比如谷歌公司推出的TPU、微軟公司和英特爾合作的Brainwave項目采用Stratix FPGA作為解決方案,現在這些主要用于AI的機器學習和算法的訓練。

典型的云端AI解決方案——太龐大了!

然而并不是所有的設備都會連接到云服務,面對眾多不用的市場應用,業界認為至少可以把一些AI任務用本地設備自身來完成,這么多市場需求非常的復雜,正如我們之前討論過的,沒有完全通用的解決方案。業界的所有供應商都已經開始利用神經網絡來實現某些特殊的需求,而且向協同AI芯片的轉變有望成為AI處理解決方案又一令人興奮的一步。

-

芯片

+關注

關注

454文章

50441瀏覽量

421918 -

人工智能

+關注

關注

1791文章

46881瀏覽量

237618

原文標題:協同芯片:AI的明智選擇?

文章出處:【微信號:IV_Technology,微信公眾號:智車科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

AI云端計算資源有哪些類型

云端ai開發環境怎么樣

瑞薩電子推出Reality AI Explorer Tier,用于開發AI與TinyML解決方案

SAP Business ByDesign:云端ERP解決方案,提升企業競爭力與服務水平

新思科技攜手英特爾推出可量產Multi-Die芯片設計解決方案

協同芯片:典型的云端AI解決方案

協同芯片:典型的云端AI解決方案

評論