近日,在蒙特利爾舉行的神經(jīng)信息處理系統(tǒng)大會(NeurIPS)上,英偉達在一篇題為“視頻到視頻合成(“Video-to-Video Synthesis” )”的技術(shù)論文中闡述了其最新AI成果。

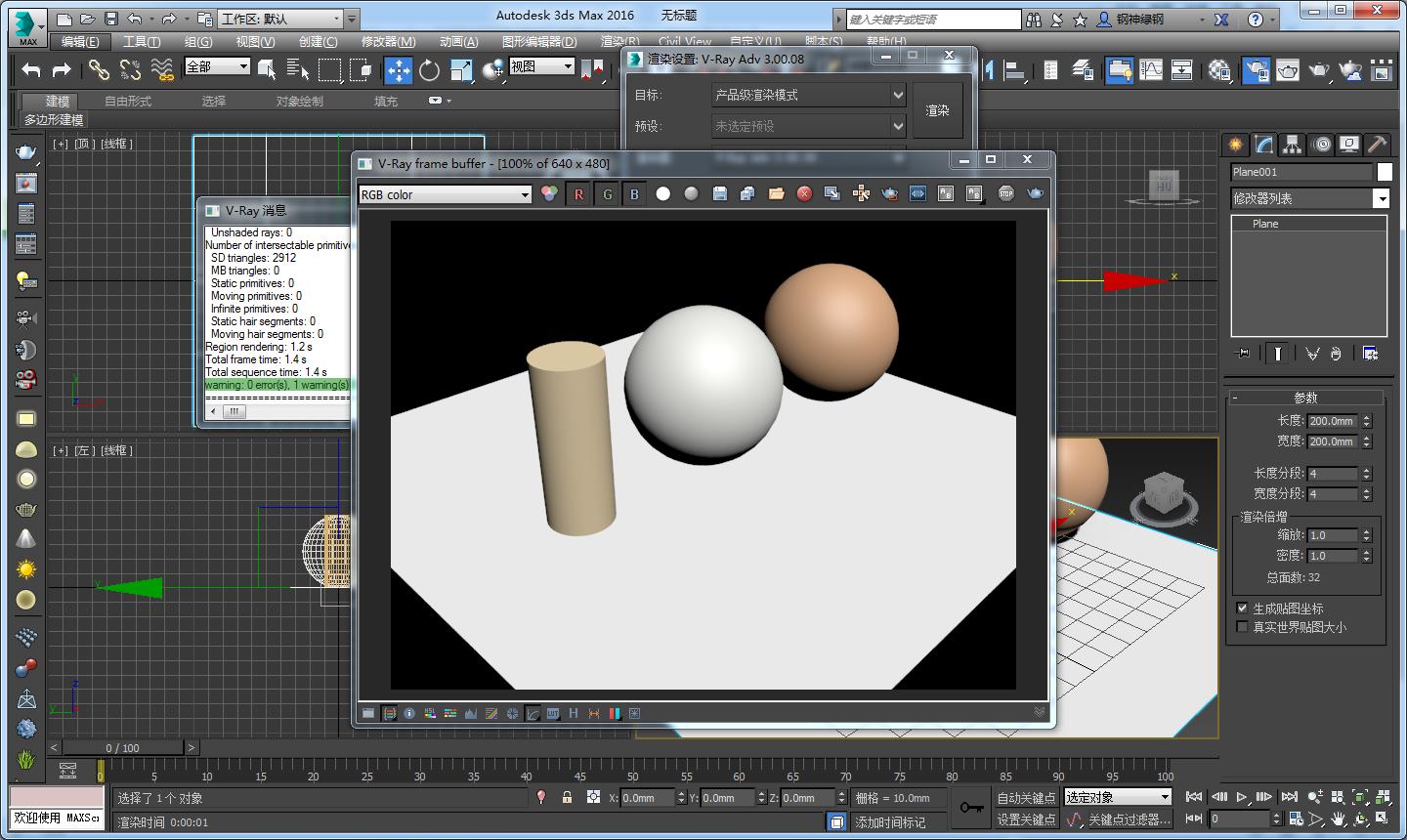

據(jù)透露,英偉達最新研發(fā)的這項成果,是可以渲染合成交互式3D環(huán)境的AI技術(shù)。在創(chuàng)建逼真的3D環(huán)境時,英偉達研發(fā)團隊不再使用傳統(tǒng)的圖形技術(shù),而是使用神經(jīng)網(wǎng)絡 ,特別是“生成模型”,通過來自如YouTube等來源的真實視頻,進行模型訓練,最終構(gòu)建逼真的3D虛擬世界。

英偉達研發(fā)團隊之所以使用“生成模型”來提高輸出的準確性,是由于這種模型要求機器必須有效地內(nèi)化數(shù)據(jù)的本質(zhì),它也因此被廣泛認為是促進機器“理解”大量數(shù)據(jù)之間關(guān)系的最有前途的方法之一。

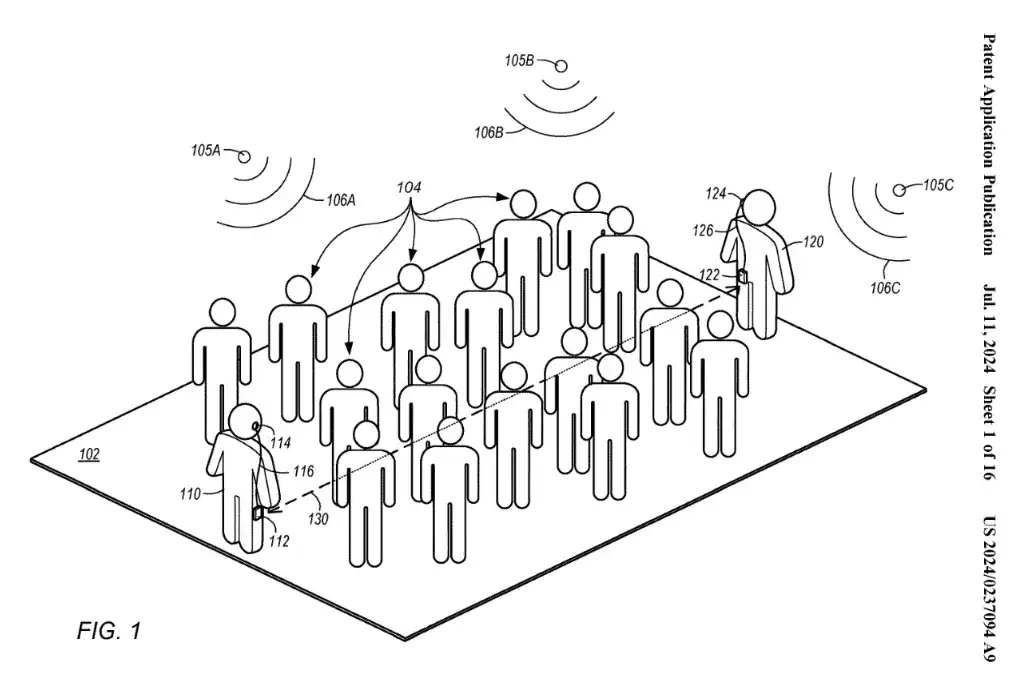

但是,像所有神經(jīng)網(wǎng)絡一樣,使用這個模型也需要訓練數(shù)據(jù)。幸運的是,英偉達研發(fā)團隊將AI模型應用于街景,通過自動駕駛項目采集到的大量視頻數(shù)據(jù),確保了其關(guān)于城市街道上行駛車輛的訓練鏡頭,再以分段網(wǎng)絡識別不同的對象類別,如地面,樹木,汽車,天空,建筑物等,開發(fā)算法以了解每個對象與其他對象的關(guān)系,最終,這些模型創(chuàng)建了城市環(huán)境的基本拓撲結(jié)構(gòu),然后AI再從基于從訓練數(shù)據(jù)中學到的東西,模擬世界外觀,包括照明,材料和動態(tài)等,由此生成幾乎是還原性的高逼真3D環(huán)境。

“由于場景是完全合成生成的,因此可以輕松編輯以刪除,修改或添加對象”英偉達表示。

在論文中,英偉達研發(fā)團隊得出的結(jié)論是:“我們提出了一種基于條件生成對抗網(wǎng)絡(GAN)的通用視頻到視頻合成框架:通過精心設(shè)計的發(fā)生器、鑒別器網(wǎng)絡以及時空對抗物鏡,我們可以合成高分辨率、照片級真實、時間一致的視頻,大量實驗表明,我們的結(jié)果明顯優(yōu)于最先進方法的結(jié)果。”

不得不承認,迄今為止,AI已經(jīng)是人類最強有力的創(chuàng)新“加速器”,它讓人類的能力得以延展,并逐漸變得更加強大。我們都能看到,在全世界范圍內(nèi),數(shù)以萬計的科學家們都在為AI技術(shù)的前沿突破做出努力,除了英偉達之外,不論是像Google、Facebook這樣的海外巨頭,還是類似國內(nèi)曠視科技、極鏈科技這樣的AI科技公司,都致力于全力研發(fā)產(chǎn)出能像人一樣思考的AI技術(shù)。今天,曠視科技已經(jīng)實現(xiàn)AI識別人臉對象中的各種特征,極鏈科技已經(jīng)實現(xiàn)AI理解海量視頻的場景表達,而未來,AI必然不僅是會讓機器“知其然”,還要做到讓它“知其所以然”,以最終實現(xiàn)推動整個AI進入“深度智能”的偉大愿景。

-

AI

+關(guān)注

關(guān)注

87文章

30191瀏覽量

268444

發(fā)布評論請先 登錄

相關(guān)推薦

鴻海與英偉達攜手打造下世代AI工廠

英偉達Cosmos AI項目曝光:構(gòu)建先進視頻模型

歡創(chuàng)播報 騰訊元寶首發(fā)3D生成應用

英偉達推出AI模型推理服務NVIDIA NIM

VIVERSE 推行實時3D渲染: 探索Polygon Streaming技術(shù)力量與應用

奧比中光英偉達聯(lián)辦3D視覺創(chuàng)新應用競賽圓滿收官

英偉達首席執(zhí)行官黃仁勛:AI模型推動英偉達AI芯片需求

進一步解讀英偉達 Blackwell 架構(gòu)、NVlink及GB200 超級芯片

烘焙vs渲染:3D模型制作中的效率與質(zhì)量之爭

NVIDIA生成式AI研究實現(xiàn)在1秒內(nèi)生成3D形狀

Stability AI推出全新Stable Video 3D模型

Adobe Substance 3D整合AI功能:基于文本生成紋理、背景

英偉達將推出生成式AI專業(yè)認證

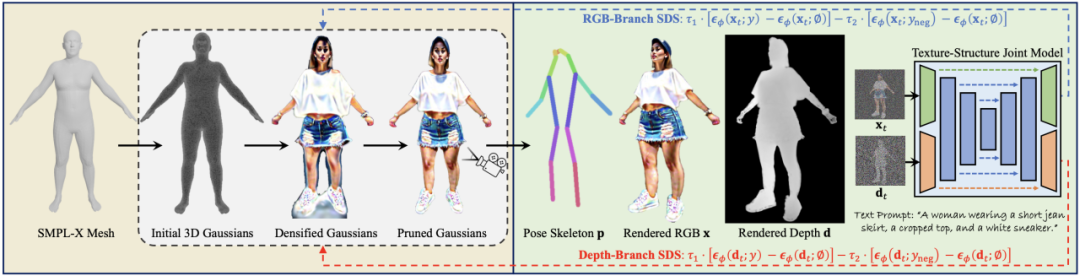

3D人體生成模型HumanGaussian實現(xiàn)原理

英偉達再出AI黑科技,通過生成模型渲染3D環(huán)境

英偉達再出AI黑科技,通過生成模型渲染3D環(huán)境

評論