對(duì)于開(kāi)發(fā)人員而言,基于云的機(jī)器學(xué)習(xí)工具帶來(lái)了使用機(jī)器學(xué)習(xí)創(chuàng)造和提供新的功能的可能性。然而,開(kāi)發(fā)者想要在它們的應(yīng)用程序中融入機(jī)器學(xué)習(xí),通常會(huì)犯一些錯(cuò)誤,本文列了十條注意點(diǎn)以饗讀者。

在提供發(fā)現(xiàn)埋藏?cái)?shù)據(jù)深層的模式的能力上,機(jī)器學(xué)習(xí)有著潛在的能力使得應(yīng)用程序更加的強(qiáng)大并且更能響應(yīng)用戶的需求。精心調(diào)校好的算法能夠從巨大的并且互不相同的數(shù)據(jù)源中提取價(jià)值,同時(shí)沒(méi)有人類思考和分析的限制。對(duì)于開(kāi)發(fā)者而言,機(jī)器學(xué)習(xí)為應(yīng)用業(yè)務(wù)的關(guān)鍵分析提供了希望,從而實(shí)現(xiàn)從改善客戶體驗(yàn)到提供產(chǎn)品推薦上升至超個(gè)性化內(nèi)容服務(wù)的任何應(yīng)用程序。

像Amazon和Micorosoft這樣的云供應(yīng)商提供云功能的機(jī)器學(xué)習(xí)解決方案,承諾為開(kāi)發(fā)者提供一個(gè)簡(jiǎn)單的方法,使得機(jī)器學(xué)習(xí)的能力能夠融入到他們的應(yīng)用程序當(dāng)中,這也算是最近的頭條新聞了。承諾似乎很好,但開(kāi)發(fā)者還需謹(jǐn)慎。

對(duì)于開(kāi)發(fā)人員而言,基于云的機(jī)器學(xué)習(xí)工具帶來(lái)了使用機(jī)器學(xué)習(xí)創(chuàng)造和提供新的功能的可能性。然而,當(dāng)我們使用不當(dāng)時(shí),這些工具會(huì)輸出不好的結(jié)果,用戶可能會(huì)因此而感到不安。測(cè)試過(guò)微軟年齡檢測(cè)機(jī)器學(xué)習(xí)工具( http://how-old.net/ )的人都會(huì)發(fā)現(xiàn),伴隨即插即用的易用性而來(lái)的是主要的精度問(wèn)題——對(duì)于關(guān)鍵應(yīng)用程序或者是重大決策,它應(yīng)該不值得信賴。

想要在應(yīng)用程序中成功地融入機(jī)器學(xué)習(xí)的開(kāi)發(fā)者,需要注意以下的一些關(guān)鍵要點(diǎn):

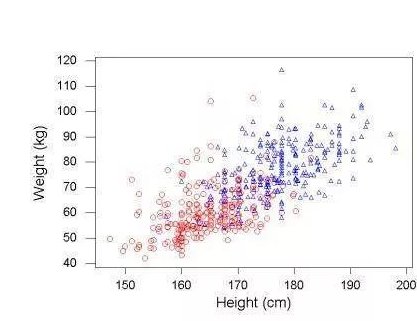

1.算法使用的數(shù)據(jù)越多,它的精度會(huì)更加準(zhǔn)確,所以如果可能要盡量避免抽樣。器學(xué)習(xí)理論在預(yù)測(cè)誤差上有著非常直觀的描述。簡(jiǎn)而言之,在機(jī)器學(xué)習(xí)模型和最優(yōu)預(yù)測(cè)(在理論上達(dá)到最佳可能的誤差)之間的預(yù)測(cè)誤差的差距可以被分解為三個(gè)部分:

由于沒(méi)有找到正確函數(shù)形式的模型的誤差

由于沒(méi)有找到最佳參數(shù)的模型的誤差

由于沒(méi)用使用足夠數(shù)據(jù)的模型的誤差

如果訓(xùn)練集有限,它可能無(wú)法支撐解決這個(gè)問(wèn)題所需的模型復(fù)雜性。統(tǒng)計(jì)學(xué)的基本規(guī)律告訴我們,如果我們可以的話,應(yīng)該利用所有的數(shù)據(jù)而不是抽樣。

2. 對(duì)給定的問(wèn)題選擇效果最好的機(jī)器學(xué)習(xí)算法是決定成敗的關(guān)鍵。

例如,梯度提升樹(shù)(GBT)是一個(gè)非常受歡迎的監(jiān)督學(xué)習(xí)算法,由于其精度而被業(yè)內(nèi)開(kāi)發(fā)人員廣泛使用。然而,盡管其高度受歡迎,我們也不能盲目的把這種算法應(yīng)用于任何問(wèn)題上。相反,我們使用的算法應(yīng)該是能夠最佳地?cái)M合數(shù)據(jù)特征同時(shí)能夠保證精度的算法。

為了證明這個(gè)觀點(diǎn),嘗試做這樣一個(gè)實(shí)驗(yàn),在數(shù)據(jù)集 the popular text categorization dataset rcv1上測(cè)試GBT算法和線性支持向量機(jī)(SVM)算法,并比較兩者的精度。我們觀察到在這個(gè)問(wèn)題上,就錯(cuò)誤率而言,線性SVM要優(yōu)于GBT算法。這是因?yàn)樵谖谋绢I(lǐng)域當(dāng)中,數(shù)據(jù)通常是高維的。一個(gè)線性分類器能夠在N-1維當(dāng)中完美的分離出N個(gè)樣本,所以,一個(gè)樣本模型在這種數(shù)據(jù)上通常表現(xiàn)的更好。此外,模型越簡(jiǎn)單,通過(guò)利用有限的訓(xùn)練樣本來(lái)避免過(guò)擬合的方式學(xué)習(xí)參數(shù),并且提供一個(gè)精確的模型,產(chǎn)生的問(wèn)題也會(huì)隨之越少。

另一方面,GBT是高度非線性的并且更加強(qiáng)大,但是在這種環(huán)境中卻更難學(xué)習(xí)并且更容易發(fā)生過(guò)擬合,往往結(jié)果精度也較低。

3. 為了得到一個(gè)更好的模型,必須選擇最佳的的算法和相關(guān)的參數(shù)。

這對(duì)于非數(shù)據(jù)科學(xué)家而言可能不容易。現(xiàn)代的機(jī)器學(xué)習(xí)算法有許多的參數(shù)可以調(diào)整。例如,對(duì)于流行的GBT算法單獨(dú)的就有十二個(gè)參數(shù)可以設(shè)置,其中包括如何控制樹(shù)的大小,學(xué)習(xí)率,行或列的采樣方法,損失函數(shù),正則化選項(xiàng)等等。一個(gè)特有的項(xiàng)目需要在給定的數(shù)據(jù)集上為每一個(gè)參數(shù)找到其最優(yōu)值并且達(dá)到最精準(zhǔn)的精度,這確實(shí)不是一件容易的事。但是為了得到最佳的結(jié)果,數(shù)據(jù)科學(xué)家需要訓(xùn)練大量的模型,而直覺(jué)和經(jīng)驗(yàn)會(huì)幫助他們根據(jù)交叉驗(yàn)證的得分,然后決定使用什么參數(shù)再次嘗試。

4. 機(jī)器學(xué)習(xí)模型會(huì)隨著好的數(shù)據(jù)而變得更好,錯(cuò)誤的數(shù)據(jù)收集和數(shù)據(jù)處理會(huì)降低你建立預(yù)測(cè)和歸納的機(jī)器學(xué)習(xí)模型的能力。根據(jù)經(jīng)驗(yàn),建議仔細(xì)審查與主題相關(guān)的數(shù)據(jù),從而深入了解數(shù)據(jù)和幕后數(shù)據(jù)的生成過(guò)程。通常這個(gè)過(guò)程可以識(shí)別與記錄、特征、值或采樣相關(guān)的數(shù)據(jù)質(zhì)量問(wèn)題。

5. 理解數(shù)據(jù)特征并改進(jìn)它們(通過(guò)創(chuàng)造新的特征或者去掉某個(gè)特征)對(duì)預(yù)測(cè)能力有著高度的影響。機(jī)器學(xué)習(xí)的一個(gè)基本任務(wù)就是找到能夠被機(jī)器學(xué)習(xí)算法充分利用的豐富特征空間來(lái)替代原始數(shù)據(jù)。例如,特征轉(zhuǎn)換是一種流行的方法,可以通過(guò)在原始數(shù)據(jù)的基礎(chǔ)上使用數(shù)學(xué)上的轉(zhuǎn)換提取新的特征來(lái)實(shí)現(xiàn)。最后的特征空間(也就是最后用來(lái)描述數(shù)據(jù)的特征)要能更好的捕獲數(shù)據(jù)的多復(fù)雜性(如非線性和多種特征之間的相互作用),這對(duì)于成功的學(xué)習(xí)過(guò)程至關(guān)重要。

6. 在應(yīng)用中,選擇合適的靈感來(lái)自商業(yè)價(jià)值的目標(biāo)函數(shù)/損失函數(shù)對(duì)于最后的成功至關(guān)重要。幾乎所有的機(jī)器學(xué)習(xí)算法最后都被當(dāng)成是一種優(yōu)化問(wèn)題。根據(jù)業(yè)務(wù)的性質(zhì),合理設(shè)置或調(diào)整優(yōu)化的目標(biāo)函數(shù),是機(jī)器學(xué)習(xí)成功的關(guān)鍵。

以支持向量機(jī)為例,通過(guò)假設(shè)所有錯(cuò)誤類型的權(quán)重相等,對(duì)一個(gè)二分類問(wèn)題的泛化誤差進(jìn)行了優(yōu)化。這對(duì)損失敏感的問(wèn)題并不合適,如故障檢測(cè),其中某些類型的錯(cuò)誤比重可能比其它類型的要高。在這種情況下,建議通過(guò)在特定的錯(cuò)誤類型上,增加更多的懲罰來(lái)解釋它們的權(quán)重,從而調(diào)整SVM的損失函數(shù)。

7. 確保正確地處理訓(xùn)練數(shù)據(jù)和測(cè)試數(shù)據(jù)。

如此當(dāng)在生產(chǎn)中部署該模型時(shí),測(cè)試數(shù)據(jù)能夠模擬輸入數(shù)據(jù)。例如,我們可以看到,這對(duì)于時(shí)間依賴性數(shù)據(jù)是多么的重要。在這種情況下,使用標(biāo)準(zhǔn)的交叉驗(yàn)證方法進(jìn)行訓(xùn)練,調(diào)整,那么測(cè)試模型的結(jié)果可能會(huì)有偏差,甚至?xí)粶?zhǔn)確。這是因?yàn)樵趯?shí)施平臺(tái)上它不能準(zhǔn)確的模擬輸入數(shù)據(jù)的性質(zhì)。為了糾正這一點(diǎn),在部署時(shí)我們必須仿照模型來(lái)部署使用。我們應(yīng)該使用一個(gè)基于時(shí)間的交叉驗(yàn)證,用時(shí)間較新的數(shù)據(jù)來(lái)驗(yàn)證訓(xùn)練模型。

8. 部署前理解模型的泛化誤差。

泛化誤差衡量模型在未知數(shù)據(jù)上的性能好壞。因?yàn)橐粋€(gè)模型在訓(xùn)練數(shù)據(jù)上的性能好并不意味著它在未知的數(shù)據(jù)上的表現(xiàn)也好。一個(gè)精心設(shè)計(jì)的模擬實(shí)際部署使用的模型評(píng)估過(guò)程,是估計(jì)模型泛化誤差所需要的。

一不留心就很容易違反交叉驗(yàn)證的規(guī)則,并且也沒(méi)有一種顯而易見(jiàn)的方法來(lái)表現(xiàn)交叉驗(yàn)證的非正確性,通常在你試圖尋找快捷方式計(jì)算時(shí)發(fā)生。在任何模型部署之前,有必要仔細(xì)注意交叉驗(yàn)證的正確性,以獲得部署性能的科學(xué)評(píng)估。

9. 知道如何處理非結(jié)構(gòu)化和半結(jié)構(gòu)化數(shù)據(jù)。

如文本、時(shí)間序列、空間、圖形或者圖像數(shù)據(jù)。大多數(shù)機(jī)器學(xué)習(xí)算法在處理特征空間中的數(shù)據(jù)時(shí),一個(gè)特征集代表一個(gè)對(duì)象,特征集的每一個(gè)元素都描述對(duì)象的一個(gè)特點(diǎn)。在實(shí)際當(dāng)中,數(shù)據(jù)引進(jìn)時(shí)并不是這種格式化的形式,往往來(lái)自于最原始的格式,并且最后都必須被改造成機(jī)器學(xué)習(xí)算法能夠識(shí)別的理想格式。比如,我們必須知道如何使用各種計(jì)算機(jī)視覺(jué)技術(shù)從圖像中提取特征或者如何將自然語(yǔ)言處理技術(shù)應(yīng)用于影片文本。

10. 學(xué)會(huì)將商業(yè)問(wèn)題轉(zhuǎn)換成機(jī)器學(xué)習(xí)算法。

一些重要的商業(yè)問(wèn)題,比如欺詐檢測(cè)、產(chǎn)品推薦、廣告精準(zhǔn)投放,都有“標(biāo)準(zhǔn)”的機(jī)器學(xué)習(xí)表達(dá)形式并且在實(shí)踐當(dāng)中取得了合理的成就。即使對(duì)于這些眾所周知的問(wèn)題,也還有鮮為人知但功能更強(qiáng)大的表達(dá)形式,從而帶來(lái)更高的預(yù)測(cè)精度。對(duì)于一般在博客和論壇中討論的小實(shí)例的商業(yè)問(wèn)題,適當(dāng)?shù)臋C(jī)器學(xué)習(xí)方法則不太明顯。

如果你是一個(gè)開(kāi)發(fā)者,學(xué)習(xí)這十個(gè)通往成功的訣竅可能似乎是一個(gè)艱難的任務(wù),但是不要?dú)怵H。事實(shí)上,開(kāi)發(fā)者不是數(shù)據(jù)科學(xué)家。認(rèn)為開(kāi)發(fā)人員可以充分利用所有的機(jī)學(xué)習(xí)工具是不公平的。但是這并不意味著開(kāi)發(fā)人員沒(méi)有機(jī)會(huì)去學(xué)習(xí)一些有水準(zhǔn)的數(shù)據(jù)科學(xué)從而改進(jìn)他們的應(yīng)用。隨著適當(dāng)?shù)钠髽I(yè)解決方案和自動(dòng)化程度的提高,開(kāi)發(fā)人員可以做模型構(gòu)建到實(shí)施部署的一切事情,使用機(jī)器學(xué)習(xí)最佳實(shí)踐來(lái)保持高精度。

自動(dòng)化是在應(yīng)用程序中擴(kuò)展機(jī)器學(xué)習(xí)的關(guān)鍵。即使你能夠供得起一批小的數(shù)據(jù)科學(xué)家團(tuán)隊(duì)和開(kāi)發(fā)者攜手合作,也沒(méi)有足夠的人才。像Skytree的AutoModel(自動(dòng)化模型)能夠幫助開(kāi)發(fā)者自動(dòng)地確定最佳的參數(shù)并且使得算法得到最大的模型精度。一個(gè)易于使用的接口可以引導(dǎo)開(kāi)發(fā)人員通過(guò)訓(xùn)練加工,調(diào)整并且測(cè)試模型來(lái)防止統(tǒng)計(jì)上的錯(cuò)誤。

自動(dòng)化機(jī)器學(xué)習(xí)過(guò)程,有許多方式,包括數(shù)據(jù)科學(xué)家或開(kāi)發(fā)者的人工智能原理,允許算法去思考,學(xué)習(xí)并且承受更多的建模重任。也就是說(shuō),認(rèn)為數(shù)據(jù)科學(xué)家能夠從機(jī)器學(xué)習(xí)中解耦是錯(cuò)誤的,特別是在關(guān)鍵任務(wù)模型上。謹(jǐn)防這種能夠簡(jiǎn)單使用機(jī)器學(xué)習(xí)功能的承諾,即能夠在不需要正確復(fù)雜的思考下或者可擴(kuò)展的應(yīng)用技術(shù)下就使用機(jī)器學(xué)習(xí)——這通常并不會(huì)得到高預(yù)測(cè)精度和機(jī)器學(xué)習(xí)提供的高商業(yè)價(jià)值結(jié)果。更糟糕的是,在應(yīng)用程序中使用不好的模型實(shí)際上可能會(huì)適得其反,并迅速在其用戶之間建立不信任的產(chǎn)品或服務(wù)。

-

算法

+關(guān)注

關(guān)注

23文章

4551瀏覽量

92014 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8306瀏覽量

131838

原文標(biāo)題:機(jī)器學(xué)習(xí)實(shí)踐的10個(gè)小秘訣

文章出處:【微信號(hào):AI_shequ,微信公眾號(hào):人工智能愛(ài)好者社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

深度學(xué)習(xí)與機(jī)器學(xué)習(xí)有什么差異你知道嗎?

幣圈熊市之下如何進(jìn)行投資?炒幣機(jī)器人幣小秘為你答疑

吳恩達(dá)的7條機(jī)器學(xué)習(xí)訓(xùn)練秘籍

嵌入式軟件測(cè)試的10條秘訣

電子設(shè)計(jì)工程師終身受用的光通信術(shù)語(yǔ)總結(jié)的太棒了

嵌入式軟件測(cè)試的10條秘訣

嵌入式軟件測(cè)試的10條秘訣

嵌入式軟件測(cè)試的10條秘訣

讓你終身受益的12個(gè)CNC編程小技巧

實(shí)踐機(jī)器學(xué)習(xí)的10個(gè)小秘訣

電子工程師成長(zhǎng)之教訓(xùn)系列故事(上)終身受用的啟發(fā)

基于終身機(jī)器學(xué)習(xí)的主題挖掘評(píng)分和評(píng)論推薦模型

億圖AI × 學(xué)習(xí),終身學(xué)習(xí)的效率加速器

想在STM32 MCU上部署機(jī)器學(xué)習(xí)模型?這份入門教程,讓你一學(xué)就會(huì)~

10條機(jī)器學(xué)習(xí)小秘訣讓你終身受益

10條機(jī)器學(xué)習(xí)小秘訣讓你終身受益

評(píng)論