深度卷積神經網絡(CNN)是一種特殊類型的神經網絡,在各種競賽基準上表現出了當前最優結果。深度 CNN 架構在挑戰性基準任務比賽中實現的高性能表明,創新的架構理念以及參數優化可以提高 CNN 在各種視覺相關任務上的性能。本綜述將最近的 CNN 架構創新分為七個不同的類別,分別基于空間利用、深度、多路徑、寬度、特征圖利用、通道提升和注意力。

引言

通過 1989 年 LeCun 處理網格狀拓撲數據(圖像和時間系列數據)的研究,CNN 首次受到關注。CNN 被視為理解圖像內容的最好技術之一,并且在圖像識別、分割、檢測和檢索相關任務上表現出了當前最佳性能。CNN 的成功引起了學界外的注意。在產業界,如谷歌、微軟、AT&T、NEC 和 Facebook 這樣的公司都設立了研究團隊來探索 CNN 的新架構。目前,圖像處理競賽中的大多數領跑者都會采用基于深度 CNN 的模型。

自 2012 年以來,關于 CNN 架構的不同創新被提出來。這些創新可分為參數優化、正則化、結構重組等。但是據觀察,CNN 網絡的性能提升應主要歸功于處理單元的重構和新模塊的設計。自 AlexNet 在 ImageNet 數據集上展現出了非凡的性能后,基于 CNN 的應用變得越來越普及。類似地,Zeiler 和 Fergus 介紹了特征分層可視化的概念,這改變了用深度架構(如 VGG)在簡單的低空間分辨率中提取特征的趨勢。如今,大多數新架構都是基于 VGG 引入的簡單原則和同質化拓撲構建的。

另一方面,谷歌團隊引入了一個非常著名的關于拆分、轉換和合并的概念,稱為 Inception 模塊。初始塊第一次使用了層內分支的概念,允許在不同空間尺度上提取特征。2015 年,為了訓練深度 CNN,Resnet 引入的殘差連接概念變得很有名,并且,后來的大多數網絡像 Inception-ResNet,WideResNet,ResNext 等都在使用它。與此類似,一些像 WideResnet、Pyramidal Nets、Xception 這樣的架構都引入了多層轉換的概念,通過額外的基數和增加的寬度來實現。因此,研究的重點從參數優化和連接再次調整,轉向了網絡架構設計(層結構)。這引發了許多像通道提升、空間和通道利用、基于注意力的信息處理等新的架構概念。

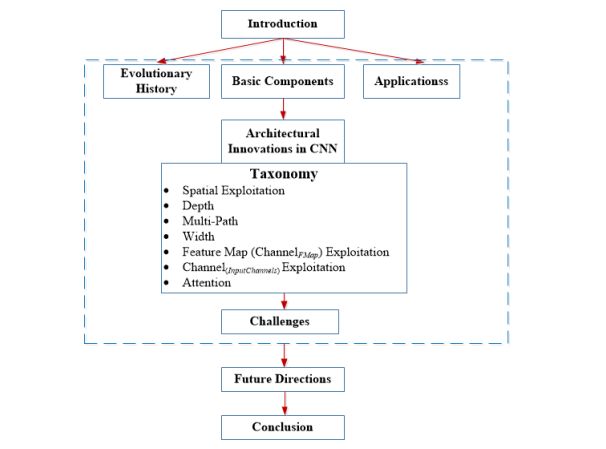

本文結構如下:

圖 1:文章結構

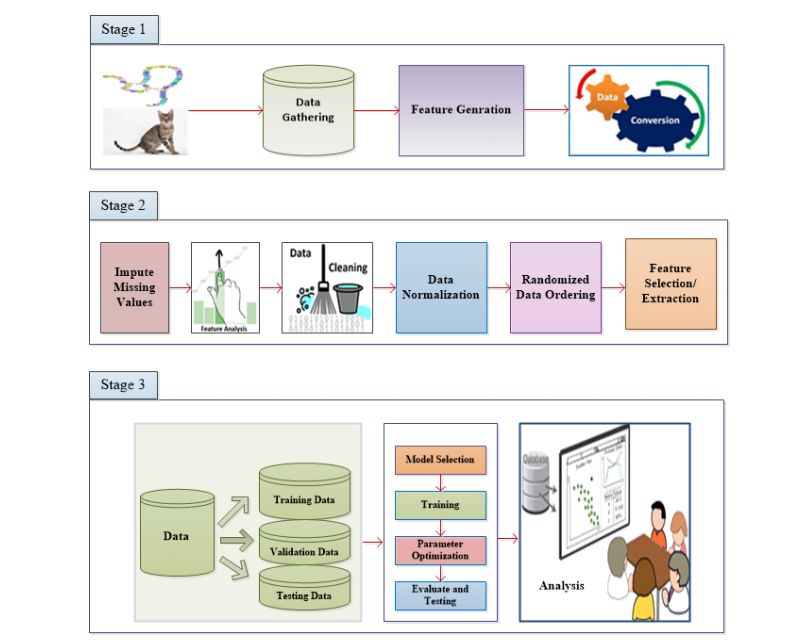

圖 2:典型模式識別(OR)系統的基本布局。PR 系統分為三個階段:階段 1 和數據挖掘相關,階段 2 執行預處理和特征選擇,而階段 3 基于模型選擇、調參和分析。CNN 有良好的特征提取能力和強大的鑒別能力,因此在一個 PR 系統中,它可以用于特征提取/生成和模型選擇階段。

4 CNN 中的架構創新

自 1989 年至今,CNN 架構已經有了很多不同的改進。CNN 中的所有創新都是通過深度和空間相結合實現的。根據架構修改的類型,CNN 可以大致分為 7 類:基于空間利用、深度、多路徑、寬度、通道提升、特征圖利用和注意力的 CNN。深度 CNN 架構的分類如圖 3 所示。

圖 3:深度 CNN 架構分類

4.1 基于空間利用的 CNN

CNN 有大量參數,如處理單元數量(神經元)、層數、濾波器大小、步幅、學習率和激活函數等。由于 CNN 考慮輸入像素的鄰域(局部性),可以使用不同大小的濾波器來探索不同級別的相關性。因此,在 2000 年初,研究人員利用空間變換來提升性能,此外,還評估了不同大小的濾波器對網絡學習率的影響。不同大小的濾波器封裝不同級別的粒度;通常,較小的濾波器提取細粒度信息,而較大的濾波器提取粗粒度信息。這樣,通過調整濾波器大小,CNN 可以在粗粒度和細粒度的細節上都表現很好。

4.2 基于深度的 CNN

深度 CNN 架構基于這樣一種假設:隨著深度的增加,網絡可以通過大量非線性映射和改進的特征表示更好地逼近目標函數。網絡深度在監督學習的成功中起了重要作用。理論研究已表明,深度網絡能夠以指數方式比淺層網絡更有效地表示特定的 20 個函數類型。2001 年,Csáji 表示了通用近似定理,指出單個隱藏層足夠逼近任何函數,但這需要指數級的神經元,因而通常導致計算上行不通。在這方面,Bengio 和 elalleau 認為更深的網絡有潛力在更少的成本下保持網絡的表現能力。2013 年,Bengio 等人通過 實證表明,對于復雜的任務,深度網絡在計算和統計上都更有效。在 2014-ILSVR 競賽中表現最佳的 Inception 和 VGG 則進一步說明,深度是調節網絡學習能力的重要維度。

一旦特征被提取,只要其相對于其他位置的近似位置被保留,其提取位置就變得沒那么重要了。池化或下采樣(如卷積)是一種有趣的局部操作。它總結了感受野附近的類似信息,并輸出了該局部區域內的主要反應。作為卷積運算的輸出結果,特征圖案可能會出現在圖像中的不同位置。

4.3 基于多路徑的 CNN

深度網絡的訓練頗具挑戰性,這也是近來很多深度網絡研究的主題。深度 CNN 為復雜任務提供了高效的計算和統計。但是,更深的網絡可能會遭遇性能下降或梯度消失/爆炸的問題,而這通常是由增加深度而非過擬合造成的。梯度消失問題不僅會導致更高的測試誤差,還會導致更高的訓練誤差。為了訓練更深的網絡,多路徑或跨層連接的概念被提出。多路徑或捷徑連接可以通過跳過一些中間層,系統地將一層連接到另一層,以使特定的信息流跨過層。跨層連接將網絡劃分為幾塊。這些路徑也嘗試通過使較低層訪問梯度來解決梯度消失問題。為此,使用了不同類型的捷徑連接,如零填充、基于投影、dropout 和 1x1 連接等。

激活函數是一種決策函數,有助于學習復雜的模式。選擇適當的激活函數可以加速學習過程。卷積特征圖的激活函數定義為等式(3)。

4.4 基于寬度的多連接 CNN

2012 至 2015 年,網絡架構的重點是深度的力量,以及多通道監管連接在網絡正則化中的重要性。然而,網絡的寬度和深度一樣重要。通過在一層之內并行使用多處理單元,多層感知機獲得了在感知機上映射復雜函數的優勢。這表明寬度和深度一樣是定義學習原則的一個重要參數。Lu 等人和 Hanin & Sellke 最近表明,帶有線性整流激活函數的神經網絡要足夠寬才能隨著深度增加保持通用的近似特性。并且,如果網絡的最大寬度不大于輸入維度,緊致集上的連續函數類無法被任意深度的網絡很好地近似。因此,多層堆疊(增加層)可能不會增加神經網絡的表征能力。與深度架構相關的一個重要問題是,有些層或處理單元可能無法學習有用的特征。為了解決這一問題,研究的重點從深度和較窄的架構轉移到了較淺和較寬的架構上。

4.5 基于特征圖(通道特征圖)開發的 CNN

CNN 因其分層學習和自動特征提取能力而聞名于 MV 任務中。特征選擇在決定分類、分割和檢測模塊的性能上起著重要作用。傳統特征提取技術中分類模塊的性能要受限于特征的單一性。相較于傳統技術,CNN 使用多階段特征提取,根據分配的輸入來提取不同類型的特征(CNN 中稱之為特征圖)。但是,一些特征圖有很少或者幾乎沒有目標鑒別作用。巨大的特征集有噪聲效應,會導致網絡過擬合。這表明,除了網絡工程外,特定類別特征圖的選取對改進網絡的泛化性能至關重要。在這一部分,特征圖和通道會交替使用,因為很多研究者已經用通道這個詞代替了特征圖。

4.6. 基于通道(輸入通道)利用的 CNN

圖像表征在決定圖像處理算法的性能方面起著重要作用。圖像的良好表征可以定義來自緊湊代碼的圖像的突出特征。在不同的研究中,不同類型的傳統濾波器被用來提取單一類型圖像的不同級別信息。這些不同的表征被用作模型的輸入,以提高性能。CNN 是一個很好的特征學習器,它能根據問題自動提取鑒別特征。但是,CNN 的學習依賴于輸入表征。如果輸入中缺乏多樣性和類別定義信息,CNN 作為鑒別器的性能就會受到影響。為此,輔助學習器的概念被引入到 CNN 中來提升網絡的輸入表征。

4.7 基于注意力的 CNN

不同的抽象級別在定義神經網絡的鑒別能力方面有著重要的作用。除此之外,選擇與上下文相關的特征對于圖像定位和識別也很重要。在人類的視覺系統中,這種現象叫做注意力。人類在一次又一次的匆匆一瞥中觀察場景并注意與上下文相關的部分。在這個過程中,人類不僅注意選擇的區域,而且推理出關于那個位置的物體的不同解釋。因此,它有助于人類以更好的方式來抓取視覺結構。類似的解釋能力被添加到像 RNN 和 LSTM 這樣的神經網絡中。上述網絡利用注意力模塊來生成序列數據,并且根據新樣本在先前迭代中的出現來對其加權。不同的研究者把注意力概念加入到 CNN 中來改進表征和克服數據的計算限制問題。注意力概念有助于讓 CNN 變得更加智能,使其在雜亂的背景和復雜的場景中也能識別物體。

-

神經網絡

+關注

關注

42文章

4764瀏覽量

100548 -

cnn

+關注

關注

3文章

351瀏覽量

22171

原文標題:7大類深度CNN架構創新綜述

文章出處:【微信號:aicapital,微信公眾號:全球人工智能】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

FPGA做深度學習能走多遠?

深度識別算法包括哪些內容

圖像分割與語義分割中的CNN模型綜述

基于深度學習的小目標檢測

cnn卷積神經網絡分類有哪些

深度學習與卷積神經網絡的應用

深度神經網絡模型cnn的基本概念、結構及原理

深度神經網絡模型有哪些

基于深度神經網絡的嬰兒哭聲識別算法

芯盾時代深度參編的行業標準《總體架構》即將施行

深度解析深度學習下的語義SLAM

深度探析7大類深度CNN創新架構

深度探析7大類深度CNN創新架構

評論