大數據分析工具有哪些

一、hadoop

Hadoop是一個能夠對大量數據進行分布式處理的軟件框架。但是Hadoop是以一種可靠、高效、可伸縮的方式進行處理的。Hadoop是可靠的,因為它假設計算元素和存儲會失敗,因此它維護多個工作數據副本,確保能夠針對失敗的節點重新分布處理。Hadoop是高效的,因為它以并行的方式工作,通過并行處理加快處理速度。Hadoop還是可伸縮的,能夠處理PB級數據。此外,Hadoop依賴于社區服務器,因此它的成本比較低,任何人都可以使用。

Hadoop帶有用Java語言編寫的框架,因此運行在Linux生產平臺上是非常理想的。Hadoop上的應用程序也可以使用其他語言編寫,比如C++。

二、HPCC

HPCC,HighPerformanceComputingandCommunications(高性能計算與通信)的縮寫。1993年,由美國科學、工程、技術聯邦協調理事會向國會提交了“重大挑戰項目:高性能計算與通信”的報告,也就是被稱為HPCC計劃的報告,即美國總統科學戰略項目,其目的是通過加強研究與開發解決一批重要的科學與技術挑戰問題。HPCC是美國實施信息高速公路而上實施的計劃,該計劃的實施將耗資百億美元,其主要目標要達到:開發可擴展的計算系統及相關軟件,以支持太位級網絡傳輸性能,開發千兆比特網絡技術,擴展研究和教育機構及網絡連接能力。

三、Storm

Storm是自由的開源軟件,一個分布式的、容錯的實時計算系統。Storm可以非常可靠的處理龐大的數據流,用于處理Hadoop的批量數據。Storm很簡單,支持許多種編程語言,使用起來非常有趣。Storm由Twitter開源而來,其它知名的應用企業包括Groupon、淘寶、支付寶、阿里巴巴、樂元素、Admaster等等。

Storm有許多應用領域:實時分析、在線機器學習、不停頓的計算、分布式RPC(遠過程調用協議,一種通過網絡從遠程計算機程序上請求服務)、ETL(Extraction-Transformation-Loading的縮寫,即數據抽取、轉換和加載)等等。Storm的處理速度驚人:經測試,每個節點每秒鐘可以處理100萬個數據元組。Storm是可擴展、容錯,很容易設置和操作。

四、ApacheDrill

為了幫助企業用戶尋找更為有效、加快Hadoop數據查詢的方法,Apache軟件基金會近日發起了一項名為“Drill”的開源項目。ApacheDrill實現了Google‘sDremel。該項目將會創建出開源版本的谷歌DremelHadoop工具(谷歌使用該工具來為Hadoop數據分析工具的互聯網應用提速)。而“Drill”將有助于Hadoop用戶實現更快查詢海量數據集的目的。

通過開發“Drill”Apache開源項目,組織機構將有望建立Drill所屬的API接口和靈活強大的體系架構,從而幫助支持廣泛的數據源、數據格式和查詢語言。

五、RapidMiner

RapidMiner是世界領先的數據挖掘解決方案,在一個非常大的程度上有著先進技術。它數據挖掘任務涉及范圍廣泛,包括各種數據藝術,能簡化數據挖掘過程的設計和評價。

六、PentahoBI

PentahoBI平臺不同于傳統的BI產品,它是一個以流程為中心的,面向解決方案(Solution)的框架。其目的在于將一系列企業級BI產品、開源軟件、API等等組件集成起來,方便商務智能應用的開發。它的出現,使得一系列的面向商務智能的獨立產品如Jfree、Quartz等等,能夠集成在一起,構成一項項復雜的、完整的商務智能解決方案。

-

大數據

+關注

關注

64文章

8863瀏覽量

137293 -

大數據分析

+關注

關注

1文章

133瀏覽量

16873 -

分析工具

+關注

關注

0文章

28瀏覽量

5074

發布評論請先 登錄

相關推薦

eda與傳統數據分析的區別

raid 在大數據分析中的應用

emc技術在大數據分析中的角色

云計算在大數據分析中的應用

數據分析除了spss還有什么

數據分析的工具有哪些

數據分析有哪些分析方法

機器學習在數據分析中的應用

大數據分析平臺網站

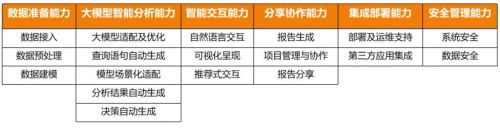

首批!數勢科技SwiftAgent完成中國信通院大模型驅動的智能數據分析工具專項測試

大數據分析工具有哪些

大數據分析工具有哪些

評論