近幾年來,隨著深度學習的學術研究和工業應用都越發火熱,大多數研究者們開始形成一個共識,那就是「未來的通用人工智能(AGI)一定不會是多層神經網絡」。邏輯推理、高層次概念抽象、小樣本多任務學習等等重要的智慧組成部分在多層神經網絡上都欠奉,整個領域逐漸形成這樣的認知就理所當然了。

但近幾天的一篇文章揭示了另一個真正有爭議的問題:關于 AI 研究的方法論,是要「設計會學習的、能利用大規模計算能力的方法(元算法),即便我們現在的計算能力還不足以支持這樣的方法,但我們靜等算力發展就好」,還是「想辦法把人類的知識直接做成模型的一部分,這才是原理化、結構化的做法」。這個問題形成了不小的討論,許多知名學者都發表了自己的意見。

強化學習開路人首先發難

Richard Sutton 是強化學習領域的開拓者,有「強化學習之父」之稱。Richard Sutton是如今鼎鼎大名的 DeepMind 研究科學家、AlphaGo 主程序員 David Silver 的老師,他本人如今也在 DeepMind 工作。

3 月 13 日,Richard Sutton 在自己的個人主頁incompleteideas.net 發表了一篇博客,名為「The Bitter Lesson」(苦澀的教訓)。我們把全文編譯如下。

AI 研究這七十年的發展中,我們學到的最有用的一課是,能夠充分利用計算能力的通用方法最終往往是效果最好的,而且要比其他方法的表現高出一大截。這個結論背后最重要的原因是由于摩爾定律,或者說,摩登定律的實際影響是讓每單位計算能力的價格指數級地降低。大多數 AI 研究進行的時候都默認了智能體可以使用的資源是固定的(在這種情況下,能繼續提高智能體表現的方法并不多,借助人類的知識就是其中一種);但是,只需要不長的時間,比如只比一個一般的研究進行的時間再長一點,我們就一定會有更多的計算資源可以拿來用。研究人員們總是想要找到能在短期內帶來提升的方法,所以他們的成果往往是想辦法把他們已經掌握的人類知識利用起來;但是長期來看,真正重要的事情是利用更多的計算能力。這兩種路線其實并不是對立的,但是在實踐中大家往往只做其中一個,就好像在心里做出了承諾必須要一條路走到黑一樣。選擇了利用人類知識這條路的研究人員們就免不了會讓方法變得復雜,更復雜的方法也就更不容易像通用方法那樣使用更多的計算資源。有很多 AI 研究人員都是做了很久研究之后才學到這個教訓。下面我給大家講幾個比較重大的例子,希望大家看過之后都能有些收獲。

在用計算機下國際象棋的嘗試中,1997 年擊敗人類國際象棋冠軍卡斯帕洛夫的方法,就是基于大規模深度搜索的。當時大多數計算機下棋的研究人員選擇的方法都嘗試運用人類對棋盤上特殊結構的理解,所以當他們看到大規模深度搜索的方法首先擊敗了人類的時候,他們都不免有些驚愕和沮喪。不過他們也并沒有立即就認輸,面對著依靠專門的軟硬件+簡單的搜索就能得到高超表現的方法,他們聲稱「暴力搜索」也許這次勝利了,但這并不是一種通用的策略,而且人類也不是這樣下棋的。他們希望某個基于人類知識的系統可以突然出現并勝出,但遺憾的是這樣的事情并沒有發生。

計算機下圍棋的研究里也出現過類似的故事,只不過時間上要遲 20 年左右。研究人員們起初投入了大量的時間精力研究如何利用人類的知識,或者是利用棋局中的特殊特征,以避免使用暴力搜索。顯然最終他們的努力仍然白費了,而且這次還要更糟糕一點,一旦基于搜索的方法開始大規模、高效地使用起來,那些方法就再也沒有追上的機會。同等重要的是一種新方法開始得到使用:通過自我對弈的過程,學習價值函數(很多其它的游戲/比賽中也有這樣的做法,只不過在 1997 年的那個國際象棋程序里沒有很多運用)。「自我對弈學習」,以及「學習」這件事總地來說,其實就像是一種搜索,它能讓大規模計算能力更好地發揮作用。在 AI 研究中,搜索和學習是能夠利用大規模計算能力的最重要的兩類技術。下圍棋的研究就和下象棋的研究一樣,大家一開始都是直接嘗試如何運用人類的理解(這樣就不需要那么多搜索),然后直到后來他們開始擁抱搜索和學習的時候才獲得了巨大的成功。

在語音識別領域,早在 1970 年代就有 DARPA 贊助的語音識別競賽。當時參加比賽的很多都是利用人類知識的方法——單詞知識、音節、人聲的頻率特征,等等;同時也有新一些的方法,它們在本質上更像統計學的方法,而且也需要更多的計算,基于的理論是隱馬爾可夫模型(HMMs)。再一次,基于統計的方法勝過了基于人類知識的方法。在這之后的幾十年中,自然語言處理領域逐漸發生了巨大的變化,基于統計學和計算的方法逐漸占據了主導地位。近幾年出現的用于語音識別的深度學習方法更是這個方向上的堅定一步。深度學習對人類知識的依賴更小、使用的計算能力更多,再加上是在非常大的訓練數據集上學習的,最終得到的語音識別系統的表現也有了大跨度的飛躍。在游戲中也是一樣,研究人員們總是先嘗試理解自己的思考方式,然后據此設計系統。他們很努力地嘗試把自己的知識融入到系統中,但是最終結果表明這樣的做法并沒有什么好處,也浪費了研究者自己的大量時間精力;而同時,通過摩爾定律,大規模計算能力變得觸手可及,我們也有了新的方式讓這些計算能力派上用場。

計算機視覺領域也有類似的模式。早期的方法認為視覺任務是尋找邊緣,或者是泛化的圓柱體,或者是一些 SIFT 特征。如今這些方法都扔進垃圾堆了。現代深度學習神經網絡只需要一個卷積的概念和某幾種變種,然后就可以獲得好得多的表現。

這是一個很大的教訓。但是作為一個領域,我們還沒能完全吸取這個教訓,因為我們還在持續地犯相同的錯誤。為了能看清這點,以及有效地避免這種錯誤,我們要能夠理解這些錯誤的誘人之處。我們必須要學到這個苦澀的教訓,那就是我們對自己的思考方式的了解,長期看來是行不通的。對于過往歷史的觀察已經表明了:

AI 研究人員總是會嘗試把知識構建到他們的智能體中;

短期總是可以看到回報的,這對研究者當事人來說是好的;

長期看來這會延緩甚至阻止更大的進步產生;

真正的突破性進展最終來自完全相反的方向,那就是基于大規模計算能力的搜索和學習。

雖然最終取得了成功,但這條路上布滿了苦澀,而且成功的果實也無法完全消化,因為成功畢竟并不來源于人們更喜歡的、更以人為中心的途徑。

在這個苦澀的教訓中我們應該學到一件事,那就是通用目標方法含有巨大的力量,隨著可用的計算能力變多,這些方法的表現可以變得越來越好。搜索和學習這兩種方法的表現隨著計算能力增加而變好的程度簡直是沒有上限的。

還有一件事需要我們學到,那就是人類思維的真正內容是極其復雜、無法描述的。我們需要停止嘗試尋找更簡單的方法理解我們自己的思維,比如用簡單的方法理解空間、物體、多智能體、對稱性,等等。所有這些都是無窮多樣的、本征復雜的外部環境的一部分。我們沒辦法嘗試把這些元素構建成為系統的一部分,因為它們的復雜性本來就是無窮高的。相反地,我們應該做的是,構建那些可以自己尋找并捕捉這種任意復雜性的元方法。這些方法的關鍵點是它們能夠找到好的近似,但是尋找近似的過程也是這些方法自己執行,而不是我們(通過增加人類知識的方法)替他們完成。我們希望智能體可以像我們一樣探索發現,而不是直接包括我們已經探索發現好的。把我們已知的東西放在里面,只會更難看到真正的探索發現過程是如何發生的。

AI 研究學者們反應不一

Richard Sutton 的文章發表后在 Twitter 上的 AI 學者圈子里引發了熱烈的討論,贊同和反對的聲音都有很多。

贊同的包括:

谷歌大腦研究員 David Ha轉推評論:(Sutton「苦澀的教訓」文章)這就像擴大簡單的隨機搜索的規模就可以避免使用集成了領域知識的難搞的強化學習算法。(雷鋒網 AI 科技評論注:David Ha 近期就在關注一些簡單的隨機搜索獲得比強化學習更好表現的論文)。我得到的收獲是,往往是那些可以拓展規模的方法才能夠經受時間考驗。能夠拓展的系統具有簡單、優雅的設計,也便于理解。設計這樣的系統也需要更高的人類智慧。如果研究 AI 的人有時候可以思考得不那么像科學家或者工程師,而是更像設計師或者藝術家的話,他們可能會有新的收獲。AI 研究有時候更像藝術而不是科學(也有人說像「煉丹」)。

OpenAI CTO Greg Brockman轉發評論:Sutton 的這篇文章觀察了歷史上反復發生的事情,發現 AI 計算規模的增加總是可以擊敗那些自以為精妙的設計(而且他也解釋了為什么這個事實很難讓人接受)

特斯拉 AI 總監Andrej Karpathy:推薦閱讀 Sutton 的這篇關于算法中的領域知識能否持久的文章。實際上如果你翻翻老的 AI 雜志也能很明顯地看到這點。

反對的聲音有:

牛津大學計算機科學學院教授 Shimon Whiteson發表長推特:

Richard Sutton 發表了一篇新博客「苦澀的教訓」,我表示強烈反對。他在文中說道,AI 領域的歷史告訴我們,對計算能力的應用最后總是能夠勝過對人類知識的應用。我覺得這是對歷史的故意曲解。

確實有很多嘗試把人類知識集成到 AI 中的嘗試最終失敗了,但同時隨著計算力(以及錢、存儲空間、能源、數據)變得越來越充裕,很多其它的方法也被拋棄了。然而,如今我們得到的成功的方法僅僅歸功于有充足的資源是不對的,其中還有很多我們保留下來的人類知識。要是沒有卷積、LSTM、ReLU、批歸一化等等人類開發出的技術,我們還怎么做深度學習?即便是圍棋,也需要有“這是一個靜態、零和、完全可觀察博弈”的先驗知識。

所以 AI 的歷史并不是一部集成人類知識的失敗史,恰恰相反,如今 AI 的成功正是因為留下了有用的人類知識,而且這個過程也是完全正常的科研策略體現:我們嘗試了各種各樣的東西,我們丟棄了其中不成功的 99%;但正是最后剩下的那 1% 對現代 AI 來說無比關鍵,我們能充分利用大規模計算能力也正是依靠它們。

Sutton 說,因為世界是本征復雜的,所以我們不應該嘗試在系統里集成先驗知識。但我得出的是相反的結論,對于 Sutton 提出的我們所依賴的搜索和學習方法來說,如此高的復雜性是難以處理的,只有通過適當的先驗知識、正確的歸納偏倚,我們才能更好地對付這樣的復雜性。

他還說「現代深度學習神經網絡只需要一個卷積的概念和某幾種變種,然后就可以獲得好得多的表現」。他句子里的「只需要」就已經表明了他這句話說得有多么不負責任。沒有這些卷積和變體的深度學習確實無法成功,但這些已經是最基礎的東西,也足夠通用了。這樣說起來,他的文章討論的「要不要集成人類知識」(因為顯然大家的答案是要),但其實他避開了那個真正的問題,那就是「什么樣的知識是值得集成的,我們要在何時、如何運用它」。

Sutton 說,「我們希望智能體可以像我們一樣探索發現,而不是直接包括我們已經探索發現好的」。這話沒錯,但我們人類擅長探索發現的原因正是因為我們生來就有適當的歸納偏倚。回看 AI 歷史,我覺得我們獲得的是「甜蜜的教訓」,雖然找到正確的歸納偏倚很難,但是這種做法讓我們有能力處理其他方法束手無策的問題。

也有中立的發聲:

康奈爾大學博士、MIT 博士后、機器學習量化分析師 Seth Stafford轉推評論 Shimon Whiteson 的長推特:Richard Sutton 和 Shimon Whiteson 觀點的區別是,把人類的知識集成到模型里所增加的價值是否符合我們希望的「原則性」的方法。Sutton 的苦澀的教訓是,針對單個任務的技巧是不行的;但 Whiteson 認為更深入的(原則性更強的)方法是可以的。

高通 AI 研究院 深度學習研究員 Taco Cohen轉推評論:大家仔細看看這個。不要再浪費時間考慮那些領域專用的技巧了。好好做一做平滑度、關系模型、成分性、等方差不等方差、局部性、穩定性、層次性、因果性等等抽象和通用的歸納偏倚。仔細考慮考慮如今的 AI 里到底缺的是什么。

-

AI

+關注

關注

87文章

30155瀏覽量

268424

原文標題:AI 發展的理想路線是什么?學者們為了這個爭起來了

文章出處:【微信號:CAAI-1981,微信公眾號:中國人工智能學會】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

RISC-V在AI領域的發展前景怎么樣?

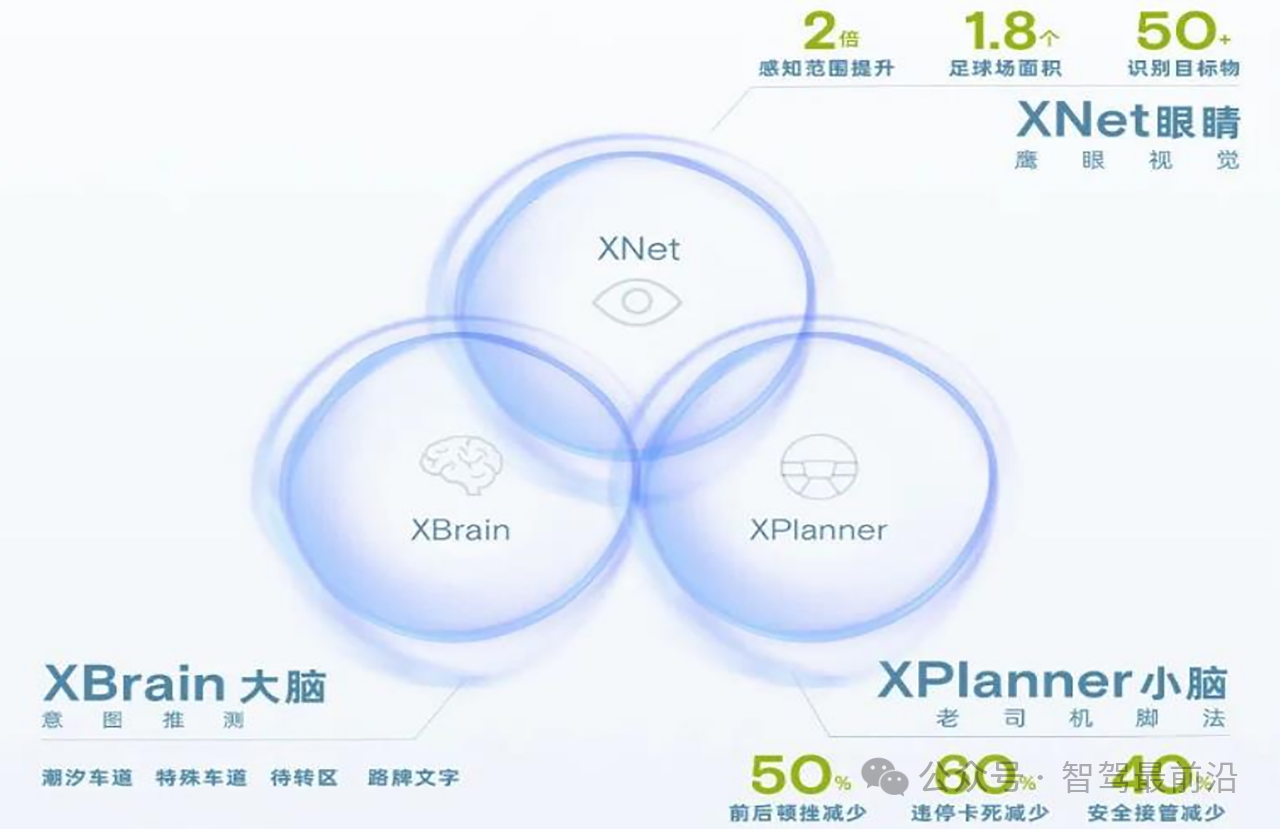

從小鵬、理想、蔚來布局看自動駕駛發展趨勢

【免費領取】AI人工智能學習資料(學習路線圖+100余講課程+虛擬仿真平臺體驗+項目源碼+AI論文)

簡述邊緣計算的持續發展

OpenAI硬件負責人熱議AI基礎設施擴展與節能方案

開啟全新AI時代 智能嵌入式系統快速發展——“第六屆國產嵌入式操作系統技術與產業發展論壇”圓滿結束

NVIDIA AI芯片Blackwell推遲發布引熱議,公司強調Hopper需求強勁

2024學習生成式AI的最佳路線圖

英飛凌為AI數據中心提供先進的高能效電源裝置產品路線圖

AI 發展的理想路線是什么?引學者熱議

AI 發展的理想路線是什么?引學者熱議

評論