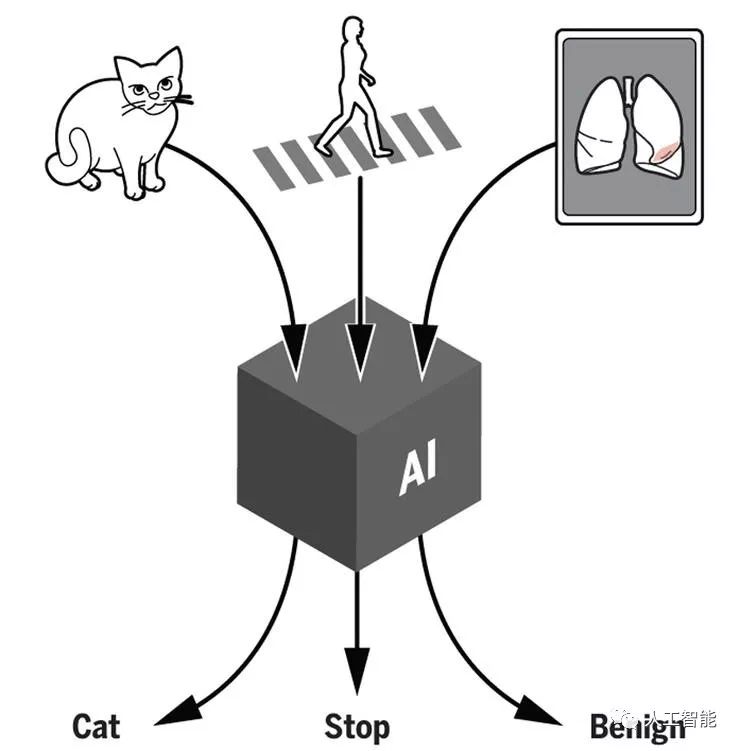

一直以來(lái)大家都對(duì)深度學(xué)習(xí)這樣的黑盒系統(tǒng)多有詬病,即便深度學(xué)習(xí)的可解釋性方面已經(jīng)有所建樹(shù),懷疑和抵制之聲仍然很多。但CMU材料科學(xué)與工程系教授ElizabethA.Holm近期在《科學(xué)》雜志發(fā)表了一篇短評(píng)文章,少見(jiàn)地為黑盒系統(tǒng)給予一些肯定。這篇文章的視角也提醒我們重新考慮一下,一聽(tīng)說(shuō)是黑盒系統(tǒng)就敬而遠(yuǎn)之是否是最好的做法。

曾經(jīng),科幻小說(shuō)作家DouglasAdams假想人類建造出了有史以來(lái)最厲害的計(jì)算機(jī),它的名字叫DeepThought,它上面運(yùn)行的程序可以解答人類能夠提出的最深刻的問(wèn)題「生命的意義是什么」、「宇宙為什么存在」,以及其它所有問(wèn)題。在計(jì)算了750萬(wàn)年以后,DeepThought給出了一個(gè)回答:數(shù)字「42」。隨著人工智能系統(tǒng)已經(jīng)開(kāi)始進(jìn)入所有人類努力探索的領(lǐng)域,包括科學(xué)、工程以及醫(yī)療保健,如今人類也必須面對(duì)DouglasAdams在這個(gè)故事里巧妙地隱含的問(wèn)題:當(dāng)我們不理解為什么會(huì)出現(xiàn)這個(gè)答案的時(shí)候,我們還有沒(méi)有必要知道這個(gè)答案?一個(gè)黑盒系統(tǒng)到底好還是不好?

在我們學(xué)校大多數(shù)的物理科學(xué)和工學(xué)的教授同事們眼中,不使用深度學(xué)習(xí)這樣的AI方法的最大原因就是他們不知道如何解釋AI給出的答案是如何產(chǎn)生的。這個(gè)反對(duì)意見(jiàn)非常有力,其中隱含的顧慮可以包括實(shí)踐、可以包括道德、甚至還可以包括法律。科學(xué)家們的使命、以及工程師們的職責(zé)都要求不僅僅能夠預(yù)測(cè)會(huì)發(fā)生什么,還要理解它為什么會(huì)發(fā)生。一個(gè)工程師能夠?qū)W會(huì)預(yù)測(cè)一座橋是否會(huì)倒塌,AI系統(tǒng)其實(shí)也可以學(xué)會(huì)做同樣的事情,但只有工程師才能通過(guò)物理模型解釋清楚他的決定是如何做出的,然后和別人溝通交流、讓他們?cè)u(píng)價(jià)他的思路。假設(shè)有兩座橋,人類工程師認(rèn)為一座橋不會(huì)塌,AI認(rèn)為另一座橋不會(huì)塌,那你會(huì)對(duì)哪一座橋更放心呢?

黑箱系統(tǒng)給出的答案無(wú)法完全令人信服的事情并不只發(fā)生在科學(xué)家和工程師身上。2018年提出的「歐盟一般數(shù)據(jù)保護(hù)條例」GDPR中就要求基于個(gè)人數(shù)據(jù)的自動(dòng)決策系統(tǒng)能夠?yàn)闆Q策對(duì)象提供「對(duì)于涉及的決策邏輯的有意義的解釋」。目前人們?nèi)匀辉谟懻撨@條要求如何在司法實(shí)踐中落實(shí),但是我們已經(jīng)可以看到司法系統(tǒng)對(duì)于無(wú)法解釋的系統(tǒng)的不信任。

在這種整個(gè)社會(huì)的懷疑氛圍下,AI研究人員們的行動(dòng)很好理解,他們不再公開(kāi)宣揚(yáng)黑盒決策系統(tǒng),但他們展開(kāi)更多研究,嘗試更好地理解黑盒系統(tǒng)是如何做出決策的——這也就是我們常說(shuō)的「可解釋性」問(wèn)題。實(shí)際上,這也是計(jì)算機(jī)科學(xué)領(lǐng)域當(dāng)今最大的挑戰(zhàn)之一。

不過(guò),一刀切地拒絕所有的黑盒系統(tǒng)也許魯莽了一點(diǎn)。在現(xiàn)實(shí)中,科學(xué)家和工程師們,作為人類、也和所有其他人一樣地,根據(jù)自己已有的判斷和經(jīng)驗(yàn)做出決策,就好像是來(lái)自他們自己大腦中的「深度學(xué)習(xí)系統(tǒng)」。所以,腦神經(jīng)科學(xué)也遇到了和計(jì)算機(jī)科學(xué)一樣的可解釋性挑戰(zhàn)。然而,對(duì)于人類做出的決策、給出的結(jié)論,我們常常不加防備地直接接受,也不去試著完全了解它們的來(lái)源過(guò)程。這樣說(shuō)來(lái),AI系統(tǒng)給出的答案也許值得考慮一下,它們也許也能發(fā)揮類似的益處;如果能確認(rèn)的話,那我們還應(yīng)該使用它們。

首當(dāng)其中可以說(shuō)的,也是最明顯的,就是當(dāng)錯(cuò)誤答案帶來(lái)的代價(jià)比正確答案帶來(lái)的價(jià)值低很多的時(shí)候。定向廣告投放就是一個(gè)典型的例子。從廣告商的角度講,投放了廣告但是目標(biāo)群體不想看的成本是很小的,但是成功的廣告卻能帶來(lái)可觀的收益。以我自己的研究領(lǐng)域,材料科學(xué)來(lái)說(shuō),圖像分割任務(wù)通常都需要人類把材料圖像中感興趣的部分的復(fù)雜內(nèi)部結(jié)構(gòu)的邊界手動(dòng)勾畫出來(lái)。這個(gè)過(guò)程成本很高,以至于不論是博士論文還是工業(yè)級(jí)的質(zhì)量控制系統(tǒng)中一旦有需要圖像分割的部分,都要讓這部分所需的圖像盡可能地少。如果換成AI系統(tǒng),它就能很快完成大批量的圖像分割任務(wù),同時(shí)還具有很高的保真度(雖然并不完美)。在這里,完美的圖像分割結(jié)果對(duì)于這些系統(tǒng)并不是必需的,因?yàn)槌霈F(xiàn)那么一些誤分類的像素的代價(jià)要比沒(méi)有AI系統(tǒng)時(shí)研究生們付出的時(shí)間精力低太多了。

第二個(gè)可以使用黑盒系統(tǒng)的例子也很明顯,不過(guò)要更有活力一些。如果一個(gè)黑盒系統(tǒng)能產(chǎn)生最佳的結(jié)果,那我們就應(yīng)當(dāng)使用它。比如,在評(píng)估標(biāo)準(zhǔn)的平面醫(yī)學(xué)影像時(shí),經(jīng)過(guò)訓(xùn)練的AI系統(tǒng)可以幫助人類影像科醫(yī)生得到更準(zhǔn)確的癌癥評(píng)估結(jié)果。雖然這種情況下出現(xiàn)一個(gè)錯(cuò)誤答案(不論是假正例還是假負(fù)例)的代價(jià)并不低,但在黑盒系統(tǒng)的幫助下我們可以達(dá)到其它任何方案都無(wú)法達(dá)到的高準(zhǔn)確率,這就成為了當(dāng)前最佳的解決方案。當(dāng)然了,有人會(huì)說(shuō)讓AI看X光片本來(lái)就可以接受,部分原因是因?yàn)榭倳?huì)有人類醫(yī)生檢查AI給出的結(jié)果;讓AI開(kāi)車就會(huì)讓人有更多顧慮,因?yàn)檫@個(gè)黑盒系統(tǒng)做出的決策能影響人的生死,但同時(shí)它卻沒(méi)有給人類留出干預(yù)的機(jī)會(huì)。即便這樣,自動(dòng)駕駛汽車也總有一天會(huì)比人類駕駛的汽車更安全,它們將會(huì)在事故率和死亡率上都做得比人類司機(jī)更好。如果取一些合理的指標(biāo)來(lái)衡量,那么那一天一旦到來(lái)我們馬上就會(huì)知道,但是是否讓人類司機(jī)讓位給AI司機(jī)會(huì)是整個(gè)社會(huì)的決定,需要考慮到人類道德觀念、公平性、非人類實(shí)體的追責(zé)等許多方面。

但是需要說(shuō)明的是,我們能列出這些情況并不代表黑盒模型在這些場(chǎng)景中就直接得到許可了。在上面兩種情況中我們都假設(shè)了一個(gè)理想的黑盒子,有人對(duì)它的運(yùn)行負(fù)責(zé),而且能夠它的代價(jià),或者能夠明確無(wú)誤地定義什么是最好的結(jié)果。這兩個(gè)假設(shè)都有落入誤區(qū)的可能。AI系統(tǒng)可能會(huì)有一系列的缺點(diǎn),包括偏倚、在訓(xùn)練的領(lǐng)域外不適用、脆弱性(很容易被欺騙)。更重要的是,評(píng)估代價(jià)和最佳結(jié)果是一個(gè)復(fù)雜的決策問(wèn)題,需要在經(jīng)濟(jì)性、個(gè)體需求、社會(huì)文化、道德考量等許多方面之中做出權(quán)衡。更糟糕的是,這些因素可能是一環(huán)套一環(huán)的:一個(gè)有偏倚的模型可能會(huì)隱含著一些代價(jià),可以表現(xiàn)為模型自己做出錯(cuò)的預(yù)測(cè),也可以表現(xiàn)為外人對(duì)模型的公平性的評(píng)估不準(zhǔn)確。一個(gè)脆弱的模型可能會(huì)包含一些盲點(diǎn),在某些時(shí)候會(huì)產(chǎn)生錯(cuò)的離譜的糟糕決定。就像面對(duì)任何決策系統(tǒng)一樣,使用黑盒系統(tǒng)的時(shí)候仍然要配合知識(shí)、判斷力和責(zé)任心。

根據(jù)定義,人類無(wú)法解釋一個(gè)黑盒算法是如何給出某個(gè)具體的答案的。但是,當(dāng)黑盒系統(tǒng)能夠帶來(lái)最佳的產(chǎn)出,或者給出錯(cuò)誤答案的代價(jià)很小,或者能夠啟發(fā)新的思維的時(shí)候,它們?nèi)匀豢梢詾槲覀儙?lái)價(jià)值。

雖然AI的思考過(guò)程是帶有限制的、可能包含偏倚甚至可能直接就是錯(cuò)誤的,但它們畢竟和人類的思考方式有很大的區(qū)別,有可能可以揭示新的聯(lián)系和新的方法。這樣一來(lái),黑盒系統(tǒng)就有了第三種可以使用的場(chǎng)景:作為引導(dǎo)人類思考和質(zhì)疑的工具。比如在某項(xiàng)突破性的醫(yī)學(xué)影像研究中,科學(xué)家們訓(xùn)練了一個(gè)深度學(xué)習(xí)系統(tǒng)來(lái)根據(jù)眼部照片診斷糖尿病性視網(wǎng)膜病變,得到的結(jié)果能夠近似或者超過(guò)一組眼科專家的表現(xiàn)。更令人驚奇的是,這個(gè)系統(tǒng)還可以一并分析得出眼科診斷中不會(huì)涉及的別的信息,包括心臟病風(fēng)險(xiǎn)高低、年齡、性別等等。在此之前從來(lái)沒(méi)有人注意過(guò)不同性別的視網(wǎng)膜之間會(huì)有什么區(qū)別,所以這個(gè)黑盒子系統(tǒng)的發(fā)現(xiàn)就給科研人員們提供了新的線索,可以進(jìn)一步探究不同性別的視網(wǎng)膜之間到底有何區(qū)別。對(duì)于這些引發(fā)的問(wèn)題的研究也就不再繼續(xù)屬于可解釋的AI系統(tǒng)以及人類智慧的黑盒系統(tǒng)領(lǐng)域。

說(shuō)了一圈,我們可以再來(lái)看看一開(kāi)始提到的DeepThought給出的答案「42」。我們沒(méi)法用黑盒AI系統(tǒng)尋找因果關(guān)系、構(gòu)建知識(shí)和邏輯系統(tǒng)以及達(dá)成理解,一個(gè)黑盒系統(tǒng)也沒(méi)辦法告訴我們橋?yàn)槭裁磿?huì)塌、生命和宇宙的種種問(wèn)題的答案是什么、以及解釋世間的一切。至少目前,這些問(wèn)題都屬于人類智慧和逐漸發(fā)展的可解釋AI的領(lǐng)域。但同時(shí),我們也仍然可以用適當(dāng)?shù)姆绞浇邮芎诤邢到y(tǒng)。黑盒系統(tǒng)可以對(duì)科學(xué)、技術(shù)、工程、數(shù)學(xué)等等領(lǐng)域產(chǎn)生潛在且正面的影響,可以產(chǎn)生價(jià)值、優(yōu)化結(jié)果以及啟發(fā)創(chuàng)新。

-

黑盒

+關(guān)注

關(guān)注

0文章

5瀏覽量

8107 -

人工智能系統(tǒng)

+關(guān)注

關(guān)注

0文章

38瀏覽量

10574 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5493瀏覽量

120985

原文標(biāo)題:不要一棍子打翻所有黑盒模型,其實(shí)可以讓它們發(fā)揮作用

文章出處:【微信號(hào):worldofai,微信公眾號(hào):worldofai】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

LMK04832配置時(shí)鐘輸出時(shí),IDL和ODL怎么配置?有沒(méi)有統(tǒng)一的做法?

基于簡(jiǎn)儀科技產(chǎn)品的水聽(tīng)器陣列測(cè)試系統(tǒng)解決方案

ATG-2042功率信號(hào)源在多頻共振水聽(tīng)器研制中的應(yīng)用

TAS2505的MCLK是否可以使用一顆cmos晶振提供?頻率是多少最好?

聚徽-工控一體機(jī)是否需要重裝系統(tǒng)怎么判斷

OPA660可以用什么芯片替代?

無(wú)功補(bǔ)償器一直手動(dòng)運(yùn)行是否可行

功能測(cè)試是白盒還是黑盒測(cè)試

國(guó)產(chǎn)DSP有哪些型號(hào)

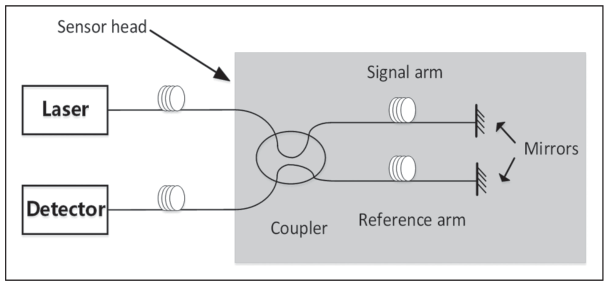

什么是光纖水聽(tīng)器系統(tǒng)?光纖水聽(tīng)器的主要元器件

光纖矢量水聽(tīng)器工作原理淺析

AD7194的模擬地和數(shù)字地最好應(yīng)在什么位置接入系統(tǒng)地?

什么是ABS view?講一下ABS view的作用

一文詳解前端常用設(shè)計(jì)模式

一聽(tīng)說(shuō)是黑盒系統(tǒng)就敬而遠(yuǎn)之是否是最好的做法?

一聽(tīng)說(shuō)是黑盒系統(tǒng)就敬而遠(yuǎn)之是否是最好的做法?

評(píng)論