Facebook AI、新加坡國立大學、360 人工智能研究院的研究人員提出一種新的卷積操作OctConv,可以直接替代傳統卷積,持續提高圖像和視頻識別任務的精度,同時降低內存和計算成本。

傳統卷積運算,有了一種全新的替代方法。

近日,Facebook AI、新加坡國立大學、360人工智能研究院的研究人員提出一種新的卷積操作——Octave Convolution (OctConv)。

論文地址:

https://export.arxiv.org/pdf/1904.05049

其中,論文一作陳云鵬現于新加坡國立大學讀博士,師從顏水成和馮佳時,兩人也是這篇論文的作者。其他作者來自Facebook AI。

作者表示,OctConv 是一種即插即用的卷積單元,可以直接替代傳統的卷積,而無需對網絡架構進行任何調整。

在自然的圖像中,信息以不同的頻率傳遞,其中較高的頻率通常以精細的細節編碼,較低的頻率通常以全局結構編碼。

類似地,卷積層的輸出特征圖也可以看做是不同頻率的信息的混合。

在這項工作中,作者提出將混合特征映射根據其頻率進行分解,并設計了一種全新的卷積運算:Octave Convolution (OctConv),用以存儲和處理在較低空間分辨率下空間變化 “較慢” 的特征圖,從而降低了內存和計算成本。

Octave 一詞表示 “八音階” 或 “八度”,音樂里降 8 個音階表示頻率減半。通過降低低頻特征的分辨率,從而節省內存和計算。

實驗表明,通過簡單地用OctConv 替代卷積,我們可以持續提高圖像和視頻識別任務的精度,同時降低內存和計算成本。

采用 OctConv 的 ResNet-152 僅用 22.2 GFLOPs 就能在 ImageNet 上實現 82.9% 的top-1 分類精度。

完美替代傳統卷積,即插即用無需調參

卷積神經網絡 (CNNs) 在許多計算機視覺任務中都取得了顯著的成功,并且隨著最近的研究在降低密集模型參數和特征圖通道維數的固有冗余,它們的效率不斷提高。然而,CNN 生成的特征圖在空間維度上也存在大量冗余,其中每個位置獨立存儲自己的特征描述符,忽略了可以一起存儲和處理的相鄰位置之間的公共信息。

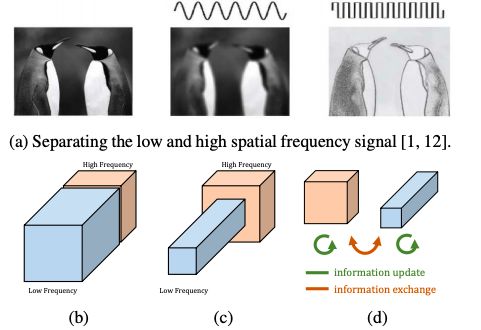

圖 1:(a) 動機。視覺的空間頻率模型的相關研究表明,自然圖像可以分解為低空間頻率和高空間頻率兩個部分。(b) 卷積層的輸出圖也可以根據其空間頻率進行分解和分組。(c) 所提出的多頻特征表示將平滑變化的低頻映射存儲在低分辨率張量中,以減少空間冗余。(d) 所提出的 Octave Convolution 直接作用于這個表示。它會更新每個組的信息,并進一步支持組之間的信息交換。

如圖 1(a) 所示,自然圖像可以分解為描述平穩變化結構的低空間頻率分量和描述快速變化的精細細節的高空間頻率分量。

類似地,我們認為卷積層的輸出特征映射也可以分解為不同空間頻率的特征,并提出了一種新的多頻特征表示方法,將高頻和低頻特征映射存儲到不同的組中,如圖 1(b) 所示。因此,通過相鄰位置間的信息共享,可以安全地降低低頻組的空間分辨率,減少空間冗余,如圖 1(c) 所示。

為了適應新的特征表示,我們提出 Octave Convolution (OctConv),它接收包含兩個頻率的特征映射,并直接從低頻映射中提取信息,而無需解碼回到高頻,如圖 1(d) 所示。

作為傳統卷積的替代,OctConv 消耗的內存和計算資源都大大減少。此外,OctConv利用相應的 (低頻) 卷積處理低頻信息,有效地擴大了原始像素空間的感受野,從而提高識別性能。

我們以一種通用的方式設計 OctConv,使它成為卷積的替代,而且即插即用。由于OctConv 主要側重于處理多空間頻率的特征映射并減少其空間冗余,它與現有的方法是相交且互補的,現有的方法側重于構建更好的 CNN 拓撲結構,減少卷積特征映射中的信道冗余和密集模型參數中的冗余。

此外,與利用多尺度信息的方法不同,OctConv 可以很容易地部署為即插即用單元,以替代卷積,而不需要改變網絡結構或需要超參數調優。

我們的實驗證明,通過簡單地用 OctConv 代替傳統卷積,可以持續提高流行的 2D CNN 模型的 ImageNet 圖像識別性能,包括 ResNet ResNeXt, DenseNet, MobileNet,以及 SE-Net。

采用 OctConv 的 Oct-ResNet-152 超過了手工設計的 state-of-the-art 網絡,并且所需的內存和計算成本更低。

我們的貢獻可以總結如下:

我們提出將卷積特征映射分解成不同空間頻率的兩個組,并分別以相應的頻率處理不同的卷積,相隔一個八度 (octave)。由于可以降低低頻圖的分辨率,因此能夠節省存儲和計算。這也有助于每一層獲得更大的感受野,以捕獲更多的上下文信息。

我們設計了一種即插即用的運算,名為 OctConv,用來代替傳統的卷積運算。OctConv直接對新的特征表示進行運算,減少了空間冗余。更重要的是,OctConv 在實踐中速度很快,達到了接近理論極限的加速。

我們廣泛研究了所提出的 OctConv 在用于圖像和視頻任務的各種骨干 CNN 上的特性,并獲得了顯著的性能提高,甚至可以與最好的 AutoML 網絡相媲美。

Octave Convolution:方法詳解

octave feature representation 減少了空間冗余,比原始表示更加緊湊。然而,由于輸入特征的空間分辨率不同,傳統卷積不能直接對這種表示進行操作。

避免這個問題的一種簡單方法是將低頻部分 上采樣到原始的空間分辨率,將它與

上采樣到原始的空間分辨率,將它與 連接起來,然后進行卷積,這將導致額外的計算和內存開銷。

連接起來,然后進行卷積,這將導致額外的計算和內存開銷。

為了充分利用緊湊的多頻特征表示,我們提出 Octave Convolution,它可以直接在分解張量 上運行,而不需要任何額外的計算或內存開銷。

上運行,而不需要任何額外的計算或內存開銷。

傳統卷積(Vanilla Convolution)

令 表示一個 k×k 卷積核,

表示一個 k×k 卷積核, 表示輸入張量和輸出張量。

表示輸入張量和輸出張量。

中的每個 feature map 可以下面的公式計算:

中的每個 feature map 可以下面的公式計算:

式中 (p, q) 為位置坐標,

定義了一個局部鄰域。

Octave Convolution.

我們的設計目標是有效地處理相應頻率張量中的低頻和高頻分量,同時使我們的 Octave特征表示的高頻分量和低頻分量之間能夠有效地通信。

設 X, Y 為分解輸入和輸出張量。那么輸出 的高頻和低頻特征映射將由

的高頻和低頻特征映射將由 和

和

給出。

給出。

Octave Convolution 的設計細節。綠色箭頭表示信息更新,紅色箭頭表示兩個頻率之間的信息交換。

Octave Convolution kernel。k×k Octave 卷積核與普通卷積核等價,即二者具有完全相同的參數量。

實驗和評估

在實驗和評估部分,我們驗證了 Octave Convolution 在 2D 和 3D 網絡中的有效性和效率。

我們分別進行了 ImageNet 上圖像分類的研究,然后將其與目前最先進的方法進行了比較。

然后,我們用 Kinetics-400 和 dynamics 600 數據集,證明所提出的 OctConv 也適用于 3D CNN。

圖 4:ImageNet 上的結果

如圖 4 所示,采用 OctConv 的模型比基線模型更有效、更準確。圖中每條線的黑色標記表示不采用 OctConv 的相應基線模型的精度。

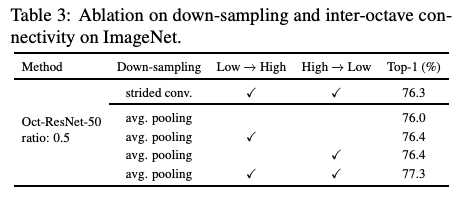

表 2:ResNet-50 的結果

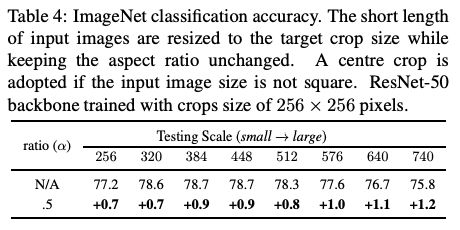

表 4:ImageNet 分類精度

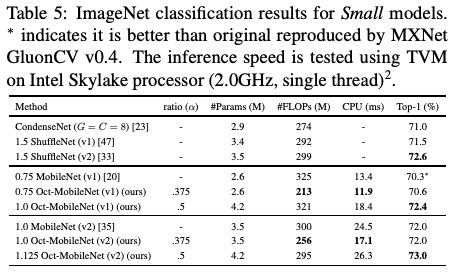

表 5:小型模型的 ImageNet 分類精度

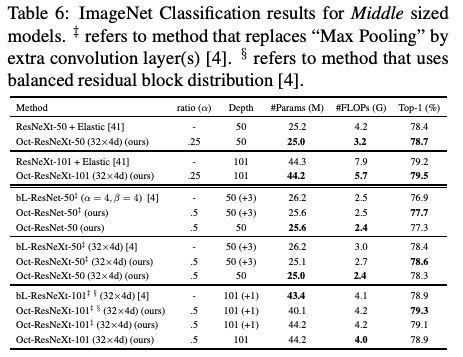

表 6:中型模型的 ImageNet 分類精度

表 7:大型模型的 ImageNet 分類精度

表 8:視頻動作識別的結果

-

神經網絡

+關注

關注

42文章

4717瀏覽量

99977 -

圖像識別

+關注

關注

9文章

514瀏覽量

38147 -

Facebook

+關注

關注

3文章

1428瀏覽量

54472

原文標題:完美代替傳統卷積!Facebook等提出全新卷積操作OctConv,速度接近理論極限

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

verilog實現卷積運算

Nexar如何為FPGA設計提供一種全新的方法?

一種伺服電機的控制方法

利用卷積調制構建一種新的ConvNet架構Conv2Former

一種改進的基于卷積神經網絡的行人檢測方法

一種基于深度學習的焊點位置檢測方法

一種輕量級時間卷積網絡設計方案

一種基于DSCNN-BILSTM的入侵檢測方法

傳統卷積運算,有了一種全新的替代方法

傳統卷積運算,有了一種全新的替代方法

評論