在應用機器學習算法時,我們通常采用梯度下降法來對采用的算法進行訓練。其實,常用的梯度下降法還具體包含有三種不同的形式,它們也各自有著不同的優缺點。

下面我們以線性回歸算法來對三種梯度下降法進行比較。

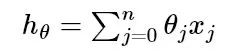

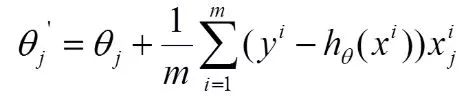

一般線性回歸函數的假設函數為:

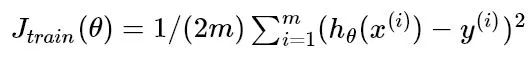

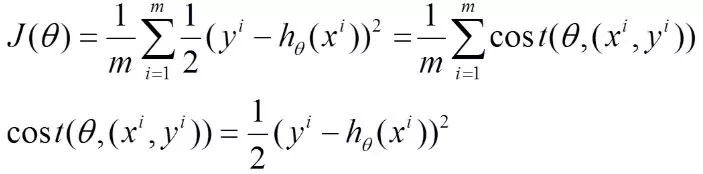

對應的能量函數(損失函數)形式為:

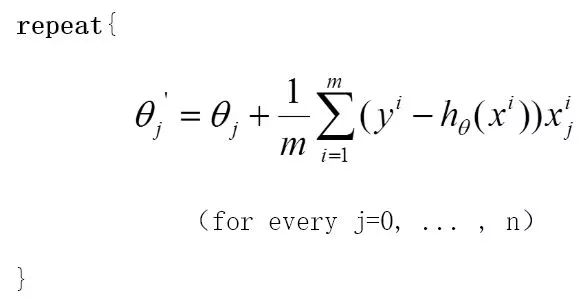

下圖為一個二維參數(θ0和 θ1)組對應能量函數的可視化圖:

01

批量梯度下降法BGD

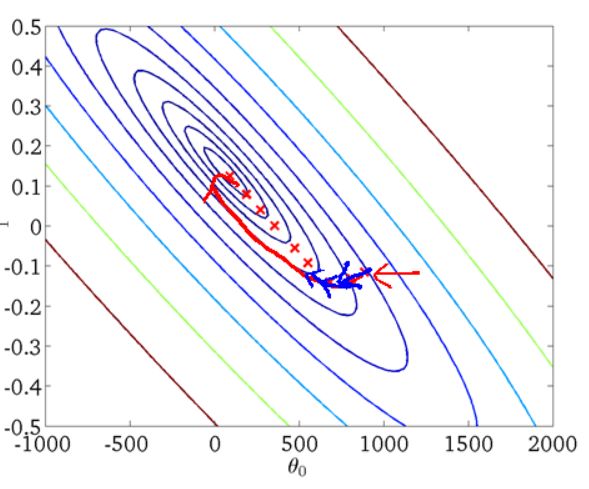

批量梯度下降法(Batch Gradient Descent,簡稱BGD)是梯度下降法最原始的形式,它的具體思路是在更新每一參數時都使用所有的樣本來進行更新,其數學形式如下:

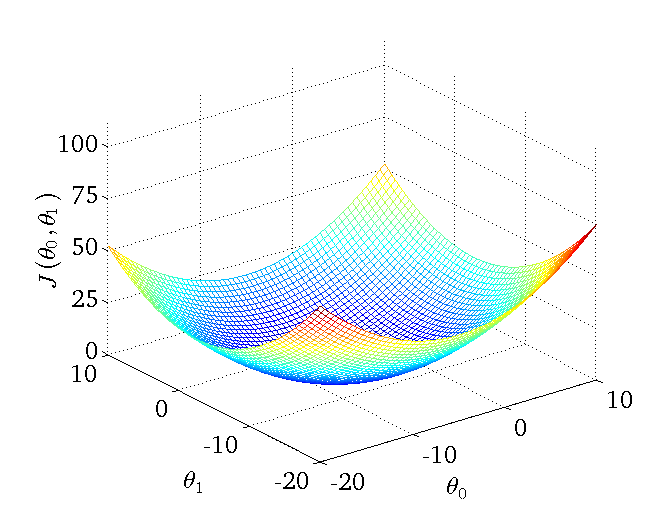

(1) 對上述的能量函數求偏導:

(2) 由于是最小化風險函數,所以按照每個參數θ的梯度負方向來更新每個 θ :

具體的偽代碼形式為:

從上面公式可以注意到,它得到的是一個全局最優解,但是每迭代一步,都要用到訓練集所有的數據,如果樣本數目 m 很大,那么可想而知這種方法的迭代速度!所以,這就引入了另外一種方法,隨機梯度下降。

優點:

全局最優解;易于并行實現;

缺點:

當樣本數目很多時,訓練過程會很慢。

從迭代的次數上來看,BGD迭代的次數相對較少。其迭代的收斂曲線示意圖可以表示如下:

02

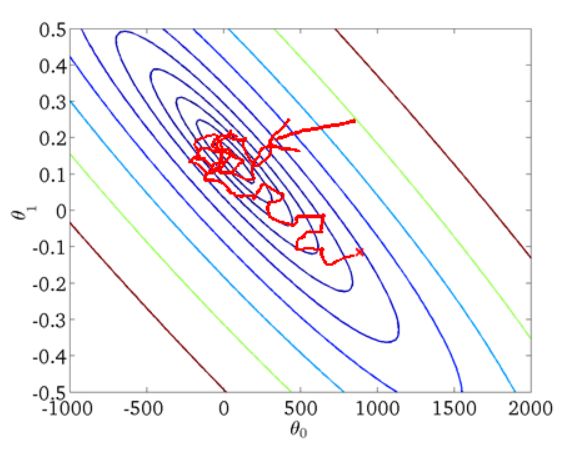

隨機梯度下降法SGD

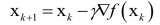

由于批量梯度下降法在更新每一個參數時,都需要所有的訓練樣本,所以訓練過程會隨著樣本數量的加大而變得異常的緩慢。隨機梯度下降法(Stochastic Gradient Descent,簡稱SGD)正是為了解決批量梯度下降法這一弊端而提出的。

將上面的能量函數寫為如下形式:

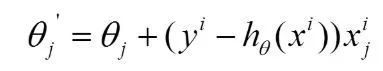

利用每個樣本的損失函數對θ求偏導得到對應的梯度,來更新 θ :

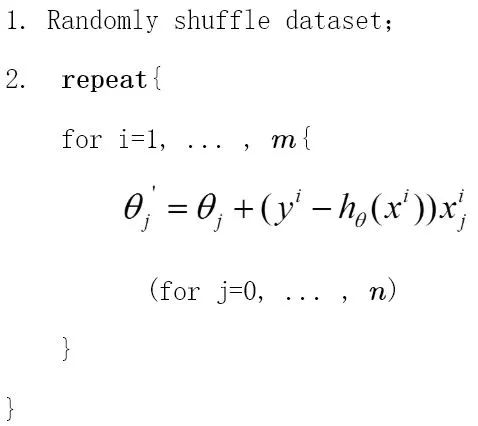

具體的偽代碼形式為:

隨機梯度下降是通過每個樣本來迭代更新一次,如果樣本量很大的情況(例如幾十萬),那么可能只用其中幾萬條或者幾千條的樣本,就已經將theta迭代到最優解了,對比上面的批量梯度下降,迭代一次需要用到十幾萬訓練樣本,一次迭代不可能最優,如果迭代10次的話就需要遍歷訓練樣本10次。但是,SGD伴隨的一個問題是噪音較BGD要多,使得SGD并不是每次迭代都向著整體最優化方向。

優點:

訓練速度快;

缺點:

準確度下降,并不是全局最優;不易于并行實現。

從迭代的次數上來看,SGD迭代的次數較多,在解空間的搜索過程看起來很盲目。其迭代的收斂曲線示意圖可以表示如下:

03

小批量梯度下降法MBGD

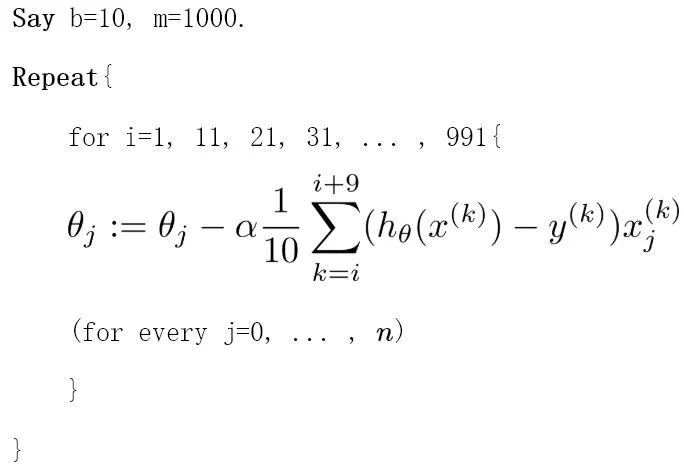

有上述的兩種梯度下降法可以看出,其各自均有優缺點,那么能不能在兩種方法的性能之間取得一個折衷呢?即,算法的訓練過程比較快,而且也要保證最終參數訓練的準確率,而這正是小批量梯度下降法(Mini-batch Gradient Descent,簡稱MBGD)的初衷。

MBGD在每次更新參數時使用b個樣本(b一般為10),其具體的偽代碼形式為:

4. 總結

Batch gradient descent:Use all examples in each iteration;

Stochastic gradient descent:Use 1 example in each iteration;

Mini-batch gradient descent:Use b examples in each iteration.

-

函數

+關注

關注

3文章

4306瀏覽量

62431 -

梯度

+關注

關注

0文章

30瀏覽量

10309 -

機器學習

+關注

關注

66文章

8377瀏覽量

132410

原文標題:梯度下降法的三種形式BGD、SGD以及MBGD

文章出處:【微信號:Imgtec,微信公眾號:Imagination Tech】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

回歸預測之入門

回歸算法有哪些,常用回歸算法(3種)詳解

TensorFlow實現簡單線性回歸

基于梯度下降法和互補濾波的航向姿態參考系統

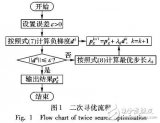

一種結合梯度下降法的二層搜索粒子群算法

以線性回歸算法來對三種梯度下降法進行比較

以線性回歸算法來對三種梯度下降法進行比較

評論