2007年9月,PCI-SIG官方發布了《Single Root I/O Virtualization and Sharing Specification Revision 1.0》規范,定義了多個System Images如何共享PCI接口的I/O硬件設備,這里的設備可以是PCIe 網卡,一塊PCIe SSD等等。

這就是今天要討論的話題——SR-IOV,一種硬件角度出發的虛擬化解決方案,本文不僅會對這項技術的概念和原理進行介紹,還會結合AWS以及Memblaze的研究來探討SR-IOV在云計算數據中心的應用方法、價值和前景。

SR-IOV及虛擬化系統中相關概念

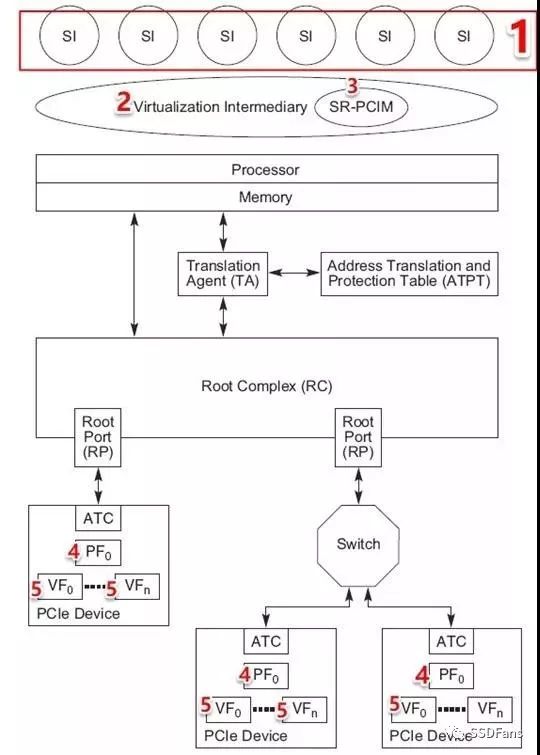

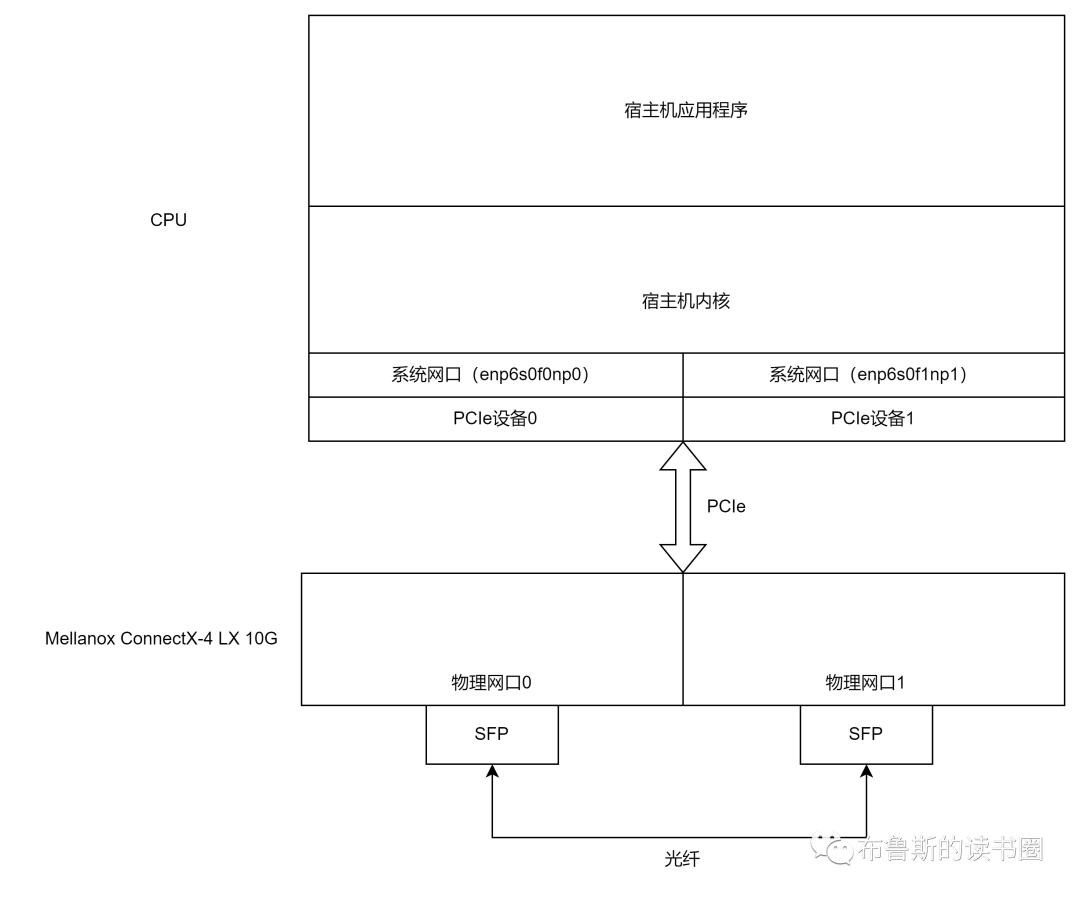

在介紹之前,需要先明確一些SR-IOV相關的概念,一個典型的SR-IOV方案架構如下。

SR-IOV的實現模型

(來源:http://www.pcisig.com/)

System Image(SI),客戶機,或者稱虛擬機OS。

Virtual Intermediary(VI),虛擬機管理層,是物理機和虛擬機的中介,可以是hypervisor或者VMM。(SR-IOV的主要作用就是消除VI對I/O操作的干預,進而提升數據傳輸性能)。

SR-PCIM,配置和管理SR-IOV功能以及PF/VF的軟件,SR-PCIM可以處理相關的錯誤和實現設備的整體控制(比如實現電源管理和熱插拔,一個PCIe設備支持SR-IOV時,SR-PCIM就可以通過熱插入的方式為物理主機添加VF設備,然后就可以配置VF給虛擬機使用。)

PF(Physical Function),SR-IOV中的關鍵概念, PF 是 PCIe一種物理功能,每個PF都可以被物理主機發現和管理。進一步講,借助物理主機上的PF驅動可以直接訪問PF所有資源,并對所有VF并進行配置,比如:設置VF數量,并對其進行全局啟動或停止。

VF(Virtual Function),PF虛擬出來的功能。一個或者多個VF共享一個PF,其驅動裝在虛擬機上,當VF分配給虛擬機以后,虛擬機就能像使用普通PCIe設備一樣初始化和配置VF。如果PF代表的是一張物理網卡,那么VF則是一個虛擬機可以看見和使用的虛擬網卡。

一句話解釋SR-IOV

SR-IOV通過將PF分為多個VF為上層虛擬機使用,相當于虛擬機繞過VI直接使用PCIe 設備處理I/O和傳輸數據。

值得一提的是,物理主機啟動時不能簡單的掃描SR-IOV設備并列舉出所有VF,因為VF沒有完整的PCIe配置空間。可以用Linux PCI熱插拔API動態為物理主機增加VF,然后分配給虛擬機使用。

SR-IOV實現的價值

傳統虛擬化系統中大量的資源和時間損耗在Hypervisor(或者VMM)軟件層面,PCIe設備的性能優勢因此無法徹底發揮。而SR-IOV的價值在于消除這一軟件瓶頸,助力多個虛擬機實現物理資源共享,同時使得虛擬機可以使用到NVMe SSD的高性能。

在此我們可以總結得出SR-IOV優勢:

實現SR-IOV之后,VMM把中斷交給虛擬機處理,而不是VMM處理I/O,提高了性能;

虛擬機直接和PCIe設備交互減輕物理主機CPU負擔,使之有能力承載更多虛擬機;

SR-IOV虛擬化技術可以減少客戶所需PCIe設備數量,進而節省PCIe插槽;

SR-IOV可以與其他的I/O虛擬化技術進行結合提供一個更加完整的兼具高性能和安全性的解決方案。

以NVMe SSD為例,今天的一塊NVMe SSD容量可以達到十幾TB,而IOPS沖到了100萬,同時有著微秒級的延遲。SR-IOV可以使NVMe SSD直接被上層多個VM所用,SSD的性能優勢也可以直接被上層應用感知到。

可以看到虛擬化和云計算都是SR-IOV大顯身手的領域。事實上,我們看到當前走在SR-IOV實踐最前面的,就是云計算巨頭AWS。接下來我們也將通過AWS公布的一些資料解讀SR-IOV的實現和瓶頸。

從AWS實踐看SR-IOV

AWS從全局的角度考慮,構建了一套基于Nitro System的方案,實現存儲、網絡等多種VF功能,為此,AWS在2015年收購了以3.5億美元收購以色列芯片商Annapurna Labs。

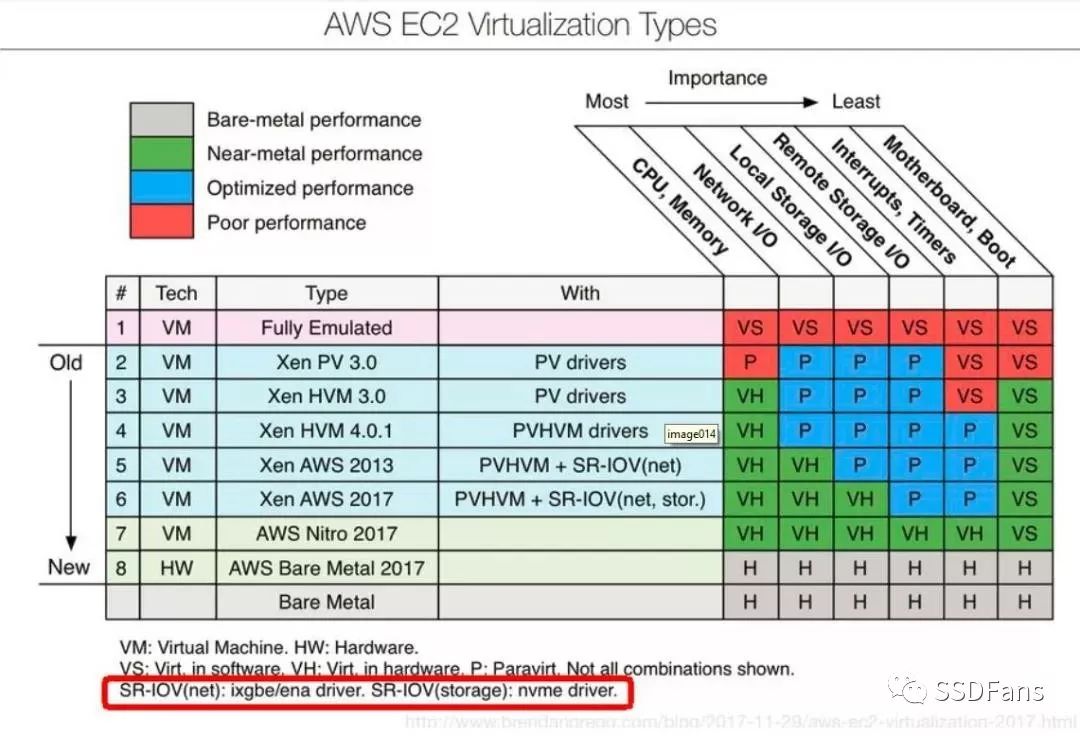

下圖展示了AWS在SR-IOV上的進展,可以看到AWS經歷了從全虛擬化到半虛擬化,而后的2013年到2017年,通過使用SR-IOV技術使得虛擬機的網絡和存儲性能,逐步達到近似Bare-metal performance的水平。

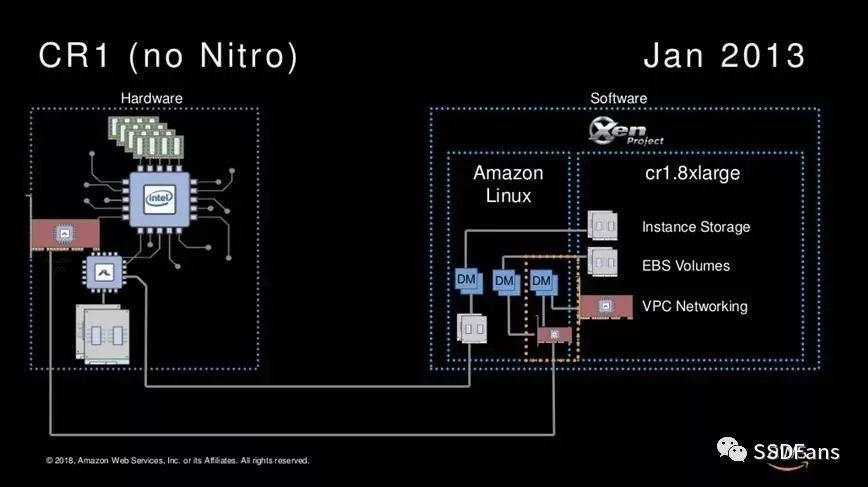

從AWS產品服務來看,2013年的CR1的實現,不論存儲和網絡訪問都是要過Amazon的hypervisor layer(Xen)的。

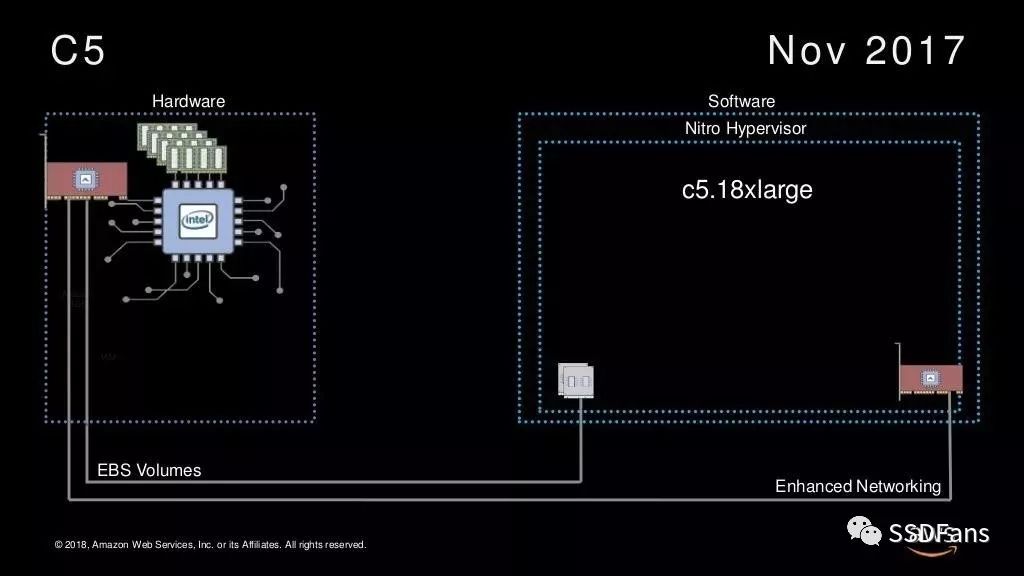

而到了2017年的C5,VM的EBS Storage和Network全部不通過Amazon Linux hypervisor layer,而通過Lightweight Nitro hypervisor。

對于這個Nitro Hypervisior,AWS給出的解釋是這是一個new hypervisor,但是不僅僅是個hypervisor。基于Annapurna Labs這顆芯片,AWS實現了PCIe設備PV到VF的SR-IOV虛擬化功能,利用Nitro Hypervisior實現了QoS管理功能。看AWS的C5和C5D機型的配置,VF可以是50、100、200、400、900GB的大小。

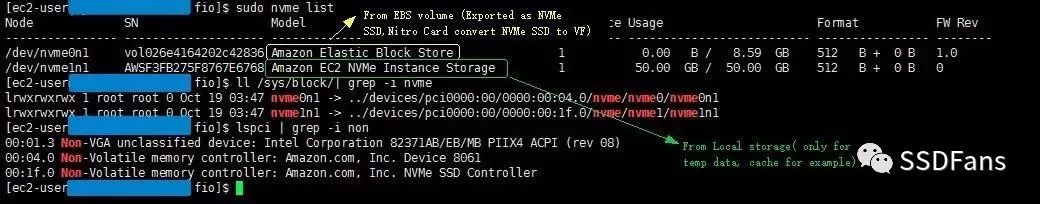

Memblaze測試工程師申請了一個亞馬遜AWS服務器以及一個c5d.large的NVMe SSD,從AWS官方看到實例配置可知c5d.large的IOPS讀被限制在2萬IOPS、寫被限制在9000IOPS。

Memblaze申請的AWS服務器

Amazon EBS 和 NVMe

在基于 Nitro system的虛擬機上,EBS 卷顯示為 NVMe 塊儲存設備,這些設備依賴于操作系統上的標準 NVMe 驅動程序。這些驅動程序通常在虛擬機啟動期間,通過掃描 PCI 總線來發現連接的設備,然后根據設備響應的順序創建設備節點。設備名稱為 /dev/nvme0n1、/dev/nvme1n1,以此類推。

實測,可以看到AWS可同時給云主機提供EBS(上圖Amazon Elastic Block Store)遠程存儲和本地NVMe SSD(上圖Amazon EC2 NVMe Instance Storage),兩者均被識別為一個PCIe設備。

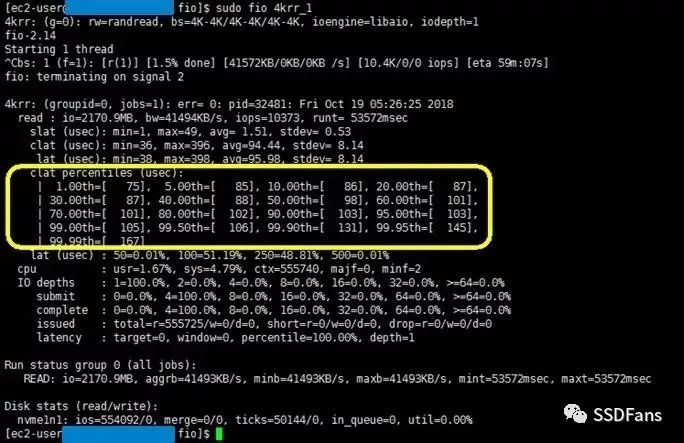

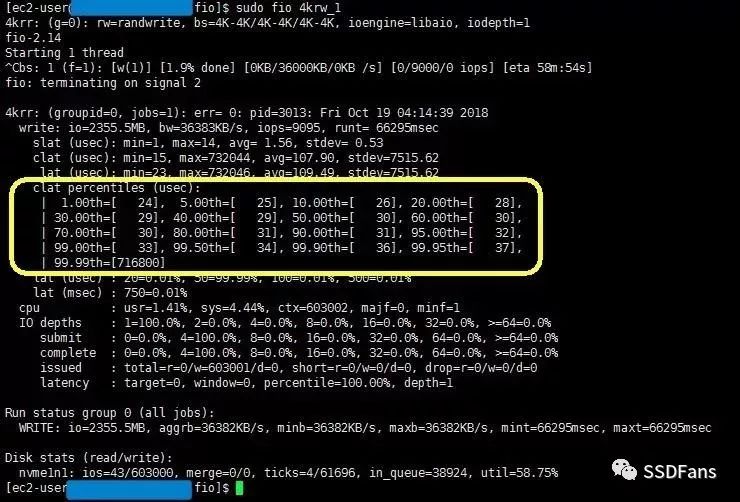

分別測試兩者的讀和寫延遲。測試結果如下:

AWS VM的Instance store(nvme1n1)讀latency在96μs

AWS VM的Instance store(nvme1n1)寫latency 99.95%都在24-37μs

通過Nitro 虛擬化后虛擬機僅增加了10μs延遲。AWS全局的SR-IOV設計理念在于,存儲和網絡都可以通過Nitro系統實現SR-IOV,分布式的EBS卷經Nitro Card到虛擬機就成為了一個NVMe塊存儲設備,而不需要底層的SSD支持SR-IOV。

但是全球只有AWS做到了這點,他的SR-IOV實踐證明這項技術價值的同時也展示了其技術實力。

Memblaze在SR-IOV領域的研究現狀

另一方面,SSD實現SR-IOV的同時,需要系統做相應的修改和調優處理,這里總結了企業客戶實現SR-IOV的幾點需求。

從安全性考慮,NVMe SSD需要實現多命名空間管理,并且滿足使用命名空間的租戶之間不能互相訪問到數據,尤其是命名空間重新分配給云主機用戶的時候。

從云主機業務性能QoS保障的角度,需要NVMe SSD實現不同VF之間的I/O隔離。而這里的I/O隔離同樣需要基于多命名空間實現。

(關于多命名空間可以參看文末相關閱讀中的《實錘,PBlaze5實力演繹multiple namespaces 功能》)

PCIe驅動以及NVMe驅動的修改。驅動是連接系統和SSD的關鍵,這里需要修改PCIe Driver對 VF BAR空間地址的分配機制以及修改NVMe Driver對VF I/O超時處理的機制

最后也是最重要的是合作,SR-IOV實現需要Memblaze與客戶進行環境聯調,以及大規模測試驗證,以此保障SR-IOV功能的可靠性、性能表現等。

-

云計算

+關注

關注

39文章

7744瀏覽量

137212 -

虛擬化

+關注

關注

1文章

368瀏覽量

29775 -

AWS

+關注

關注

0文章

427瀏覽量

24316

原文標題:超低延遲SR-IOV!全球只有他做到了

文章出處:【微信號:SSDFans,微信公眾號:SSDFans】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

正在使用SR-IOV功能,請問能不能再VF端口中啟動MAC學習?

云數據中心市場的十大趨勢

基于PCI Express SR-IOV的大量虛擬化功能

Intel圖形SR-IOV增強工具箱使用指南

華為與福建漳州簽訂戰略合作 云計算數據中心落地

用SR-IOV創建虛擬函數

全球海拔最高的云計算數據中心建在西藏 遠在北京也可控制

探討“新基建”時代云計算數據中心面臨的各種挑戰

杭鋼云計算數據中心推出的Liebert?EXL系列大功率UPS有哪些核心優勢?

什么是SR-IOV呢?SR-IOV技術的優缺點及應用場景

SR-IOV研究:一個簡單的測試環境

SR-IOV在云計算數據中心的應用方法、價值和前景

SR-IOV在云計算數據中心的應用方法、價值和前景

評論