要說目前最火的用到手機攝像頭的應用是什么,毫無疑問非二維碼識別莫屬了。微信帶起來的二維碼熱,幾乎已經改變了整個世界的支付方式、社交方式。

但二維碼的設計畢竟是為了對算法友好,人眼看起來就丑了些。

一種天然的想法是,能否把信息嵌入到照片里去?想象一下如果給一張個人大頭照,就可以自動提取里面的名片信息,或者掃個風景照就支付,那看起來就自然多了。

實際上用圖像檢索的方式可以在一定程度上實現上述功能,提取特征然后到服務器上匹配圖像,把對應信息下載下來。

傳統的AR(增強現實)就是這么做的。但這需要聯網,而且對于紋理不豐富的圖片,檢索效果很差,也沒有很好的信息校正機制。以前有一家國內電商用類似圖像檢索的方式做過拍書籍封面搜商品的應用,但用的人并不是很多。

深度學習時代,能否實現照片“隱寫術“?

幾天前看到一篇論文,感覺距離實現這個目標不遠了。

論文題目“StegaStamp: Invisible Hyperlinks in Physical Photographs”,翻譯一下就是《隱寫郵票:自然照片中嵌入不可見超鏈接》,Stega有隱寫術的意思。

這篇論文作者來自美國加州大學伯克利分校。

作者的想法就是把信息寫入圖像中,使打印出來的圖片感知度不被破壞,同時拍攝打印的圖片還能把信息解碼出來!

下圖把這個一目了然表達了出來。需要說明的是,作者論文中說不只是打印照片支持拍照再解碼,顯示在屏幕上也能拍照后解碼。

細節的流程是這樣的,如下圖:

圖像與要嵌入的信息經過神經網絡編碼成新的照片,經過打印或者屏幕顯示后再拍攝,把得到的圖像經過檢測算法得到校正后的圖像區域,該圖像經過解碼算法得到嵌入圖像里的信息。

這個過程中,我們不免有疑問,信息嵌入會不會影響照片的視覺感知?另外,信息嵌入是可以,但經過打印或者再次成像后拍照,外界的環境變化可能很大,如何保證提取信息的魯棒性?

在目前該文的算法中,嵌入信息過多的確會影響視覺感知,但作者實驗嵌入100bits信息還是OK的。

下圖展示了,嵌入信息后(第二列)與原始圖像(第一列)的差異(第三列)。視覺上幾乎難以分辨不同。

至于解決魯棒性的問題,做法是在訓練解碼器的時候,模擬真實的圖像質量退化模型對嵌入信息的圖像做變換。如下圖:

包括圖像透視變換、模糊化、顏色操作、加噪聲、JPEG壓縮。

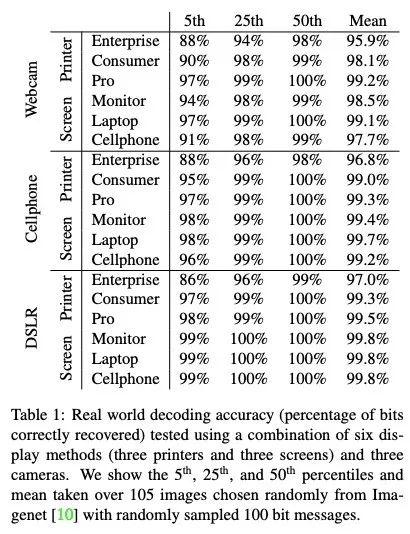

最終該文得到的效果還是很不錯的!

在大多數情況下都能100%正確解碼!

下圖為更多圖像的識別結果:

同時該算法對各種真實世界的環境影響均有魯棒性。

這是對抗光照變化:

這是對抗視角變化:

這是對抗局部遮擋:

這是對抗光線反射:

是不是很神奇?!

這個算法感覺很有用,不知道作者申請了專利沒有。

作者已經開源了代碼:

https://github.com/tancik/StegaStamp

該項目主頁:

http://www.matthewtancik.com/stegastamp

論文地址:

https://arxiv.org/abs/1904.05343

有了這個技術,很多有趣的東西可以做出來,它不僅可以作為超鏈接,還可以在用戶不知情的情況下對照片和屏幕嵌入信息。。。

-

服務器

+關注

關注

12文章

9021瀏覽量

85183 -

圖像檢索

+關注

關注

0文章

28瀏覽量

8030 -

深度學習

+關注

關注

73文章

5492瀏覽量

120975

原文標題:UC伯克利開源照片“隱寫術”StegaStamp,打印照片能當二維碼用!| 技術頭條

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

基于NTFS的最小侵入式隱寫系統

序貫LSB隱寫術的提取攻擊

針對F5隱寫分析算法的FPGA實現

如何實現照片分享

針對JPEG格式的數字隱寫與隱寫分析

針對特定測試樣本的隱寫分析方法

面向AAV壓縮域的通用隱寫分析方法

基于空域圖像變換參數擾動的隱寫術

深度學習時代,能否實現照片“隱寫術”?

深度學習時代,能否實現照片“隱寫術”?

評論