近日,Reddit一位網(wǎng)友根據(jù)近期OpenAI Five、AlphaStar的表現(xiàn),提出“深度強(qiáng)化學(xué)習(xí)是否已經(jīng)到達(dá)盡頭”的問(wèn)題。此問(wèn)題一出便引起了眾網(wǎng)友的熱烈討論,觀(guān)點(diǎn)向一邊倒:根本沒(méi)到盡頭!

深度強(qiáng)化學(xué)習(xí)已經(jīng)達(dá)到了盡頭?

前幾日,OpenAI Five擺擂三天,以99%的勝率秒殺人類(lèi)玩家。但值得注意的是,OpenAI Five是接受了45000年的訓(xùn)練,而人類(lèi)只通過(guò)一天的時(shí)間便找到了戰(zhàn)勝它的策略。

OpenAI Five和AlphaStar都是深度強(qiáng)化學(xué)(DRL)最大規(guī)模、最精細(xì)的實(shí)現(xiàn)方式。但即便是AlphaStar上場(chǎng),估計(jì)結(jié)果都是一樣的。

Reddit網(wǎng)友便針對(duì)此現(xiàn)象,拋出了這樣一個(gè)問(wèn)題:

有很多研究正在進(jìn)行,以使DRL更具數(shù)據(jù)效率,并使深度學(xué)習(xí)對(duì)于分布不均和對(duì)抗性的例子更加強(qiáng)大,但與人類(lèi)的差距是如此極端以至于我懷疑是不是快要達(dá)到深度學(xué)習(xí)的極限了?亦或還是有希望能夠推動(dòng)范式的發(fā)展?

許多網(wǎng)友比較傾向的觀(guān)點(diǎn)是:根本沒(méi)有達(dá)到所謂的極限,而只是可能到了人們不再用“智能”這樣的詞來(lái)談?wù)揇RL的地步。

網(wǎng)友hobbesfanclub認(rèn)為:

我覺(jué)得我們才剛剛開(kāi)始。每天都有很多東西被釋放出來(lái),我甚至都跟不上。幾天前我認(rèn)為是最先進(jìn)的技術(shù)突然間就不存在了,因?yàn)樵谶@個(gè)領(lǐng)域里有大量的工作要做。對(duì)于我們這些在這一領(lǐng)域工作的人來(lái)說(shuō),這些進(jìn)步仍然是令人難以置信的,在我看來(lái),真正令人印象深刻的是,這些技術(shù)在整體上仍然非常年輕……

網(wǎng)友adventuringraw認(rèn)為:

這是一個(gè)很有趣的問(wèn)題,關(guān)于深度學(xué)習(xí)本身也有類(lèi)似的討論——我們已經(jīng)達(dá)到神經(jīng)網(wǎng)絡(luò)的極限了嗎?如果沒(méi)有根本性的范式轉(zhuǎn)變,是否更不可能?

但是你看,在神經(jīng)網(wǎng)絡(luò)上有各種各樣的方法,這些方法在2012年可能會(huì)讓一些人大吃一驚。很明顯,GAN、VAE、神經(jīng)風(fēng)格遷移、深度強(qiáng)化學(xué)習(xí)本身就屬于神經(jīng)網(wǎng)絡(luò)范疇內(nèi),與其說(shuō)深學(xué)習(xí)被取代了,不如說(shuō)它被置于“堆棧”之下了。它是一個(gè)組成部分,一個(gè)解決問(wèn)題的策略,一種思考方式。即使是深度網(wǎng)絡(luò)自己,也是建立在過(guò)去各種進(jìn)步和見(jiàn)解的基礎(chǔ)上的。

我個(gè)人的想法是:這似乎是無(wú)模型方法的一個(gè)基本問(wèn)題。你需要在特征空間中進(jìn)行密集的覆蓋,或者換句話(huà)說(shuō),你知道在一個(gè)已經(jīng)完全探索過(guò)的領(lǐng)域里該做什么,但你不一定能夠推斷和推理出新的環(huán)境,你需要一個(gè)全局模型來(lái)進(jìn)行推理。

我之前看過(guò)基于Google Brain的'SimPLe'模型的RL論文,開(kāi)始向基于模型的RL過(guò)渡并不是一個(gè)全新的概念。但是在我們得到一個(gè)能夠在空間中進(jìn)行抽象推理的智能體之前,還有一些嚴(yán)重的問(wèn)題有待解決:

它如何學(xué)習(xí)空間中相關(guān)的獨(dú)立實(shí)體、動(dòng)作、等等?

它能在無(wú)人監(jiān)督的情況下完成嗎?

它如何將當(dāng)前的世界理解壓縮為一個(gè)更低的維度表示,從而完美地捕捉到解決當(dāng)前問(wèn)題最需要的維度?

它能學(xué)會(huì)周?chē)h(huán)境的地圖嗎?

創(chuàng)建分層長(zhǎng)期計(jì)劃的最佳方法是什么?

......

即使只使用圖像分類(lèi),我們?nèi)匀缓茈y提取基于形狀的特征而不是基于紋理的特征。一般來(lái)說(shuō),局部模式似乎比全局模式更容易獲取,所以我想OpenAI Five更容易利用局部模式所采用的策略,這使得它很容易受到具有正確洞察力的玩家的攻擊。

我一直在讀Judea Pearl的《因果關(guān)系》(Causality),有一些有趣的東西是值得思考的。我不認(rèn)為他的因果關(guān)系模型是我們需要讓智能體明確地向世界學(xué)習(xí)什么東西,但是若是讓一個(gè)智能體能夠完全適應(yīng)新環(huán)境并在宏觀(guān)規(guī)模上進(jìn)行規(guī)劃的整體似乎是需要它能夠反事實(shí)地推理,并對(duì)它自己的世界有一個(gè)強(qiáng)有力的理解。

考慮到我們才剛剛開(kāi)始了解創(chuàng)建一個(gè)魯棒的圖像分類(lèi)器需要什么(即使是在有監(jiān)督的環(huán)境中,更不用說(shuō)無(wú)監(jiān)督的環(huán)境了),我認(rèn)為在深度強(qiáng)化學(xué)習(xí)完全成長(zhǎng)之前,我們已經(jīng)有了一些基礎(chǔ)理論。

但非常瘋狂的事情是,我們似乎正在逐步消除了這些障礙。而另一方面,卻出現(xiàn) 了一個(gè)可以玩Dota2、學(xué)會(huì)合作、學(xué)會(huì)對(duì)世界進(jìn)行推理的無(wú)監(jiān)督系統(tǒng),這似乎讓人覺(jué)得我們快要到達(dá)技術(shù)的頂尖了,但實(shí)際上并沒(méi)有。所以我對(duì)于OpenAI沒(méi)有到達(dá)那個(gè)點(diǎn)并不感到驚訝。但對(duì)于接下來(lái)即將發(fā)生的事情還是抱有很大的期待的。

該問(wèn)題似乎在reddit的討論熱度很高,但是縱觀(guān)網(wǎng)友們的評(píng)論,可以很容易看出對(duì)這個(gè)問(wèn)題的看法是向一邊傾倒的:

深度強(qiáng)化學(xué)習(xí)遠(yuǎn)未及極限,還有很長(zhǎng)的一段路要走。

“寒冬論”四起,榮耀屬于熬過(guò)寒冬的人

但其實(shí),人們不僅會(huì)對(duì)深度強(qiáng)化學(xué)習(xí)提出“寒冬論”的言論,深度學(xué)習(xí)亦是如此。

多年來(lái),深度學(xué)習(xí)一直處于所謂的人工智能革命的最前沿,許多人相信深度學(xué)習(xí)將帶領(lǐng)我們進(jìn)入通用AI時(shí)代。在2014,2015,2016年,很多事件每每推動(dòng)人們對(duì) Ai的理解邊界。例如Alpha Go等。特斯拉等公司甚至宣稱(chēng):全自動(dòng)駕駛汽車(chē)正在路上。

但是現(xiàn)在,2018年中期,事情開(kāi)始發(fā)生變化。從表面上看,NIPS會(huì)議仍然很火,關(guān)于AI的新聞也很多,Elon Mask仍然看好自動(dòng)駕駛汽車(chē),而Google CEO不斷重申Andrew Ng的口號(hào),即AI比電力作出了更大的貢獻(xiàn)。但是這些言論已經(jīng)開(kāi)始出現(xiàn)裂紋。裂紋最明顯的地方是自動(dòng)駕駛- 這種現(xiàn)實(shí)世界中的實(shí)際應(yīng)用。

當(dāng)ImageNet有了很好的解決方案(注意這并不意味著視覺(jué)問(wèn)題得到已經(jīng)解決),該領(lǐng)域的許多杰出研究人員(甚至包括一直保持低調(diào)的Geoff Hinton)都在積極地接受采訪(fǎng),在社交媒體上發(fā)布內(nèi)容(例如Yann Lecun,吳恩達(dá),李飛飛等)。他們的話(huà),可以總結(jié)為:世界正處在一場(chǎng)巨大的AI革命中。然而,好幾年已經(jīng)過(guò)去了,這些人的Twitter信息變得不那么活躍了,比如 Andrew Ng:

2013年 - 每天0.413推文

2014 年- 每天0.605條推文

2015 -每天0.320條推文

2016 -每天0.802推文

2017 -每天0.668推文

2018 -每天0.263推文(至5月24日)

也許這是因?yàn)锳ndrew 的某些夸張言論,在當(dāng)下會(huì)被進(jìn)行更詳細(xì)的審查,如下面的推文所示:

不可否認(rèn),深度學(xué)習(xí)的熱度已經(jīng)大大下降,贊美深度學(xué)習(xí)作為AI終極算法的推文少得多了,而且論文正在變得不那么“革命”,現(xiàn)在大家換了個(gè)詞,叫:進(jìn)化。

自從Alpha Zero以來(lái),DeepMind已經(jīng)許久沒(méi)有產(chǎn)出令人驚嘆的東西了。OpenAI更是相當(dāng)?shù)牡驼{(diào),他們最近一次出現(xiàn)在媒體的報(bào)道上,是他們做了一個(gè)自動(dòng)打Dota 2的機(jī)器人 [我一開(kāi)始以為,這是跟 Alpha Go 一樣的偉大,然后后來(lái)證明,并不是]。

從某些文章來(lái)看,貌似Google實(shí)際上并不知道如何處理Deepmind,因?yàn)樗麄兊慕Y(jié)果顯然不如原先預(yù)期的那么實(shí)際......至于杰出的研究人員,他們一般都為了funding 在各種政府機(jī)構(gòu)間游走,Yann Lecun甚至從 Facebook的AI首席科學(xué)家的位置上下臺(tái)了。

像這種從富有的大公司向政府資助的研究機(jī)構(gòu)的逐漸轉(zhuǎn)變表明,這些公司對(duì)這類(lèi)研究的興趣(我認(rèn)為是谷歌和Facebook)實(shí)際上正在慢慢消失。這些都是早期跡象,沒(méi)有人大聲的宣揚(yáng),但這些行動(dòng)就像肢體語(yǔ)言,也能傳達(dá)某種意思。

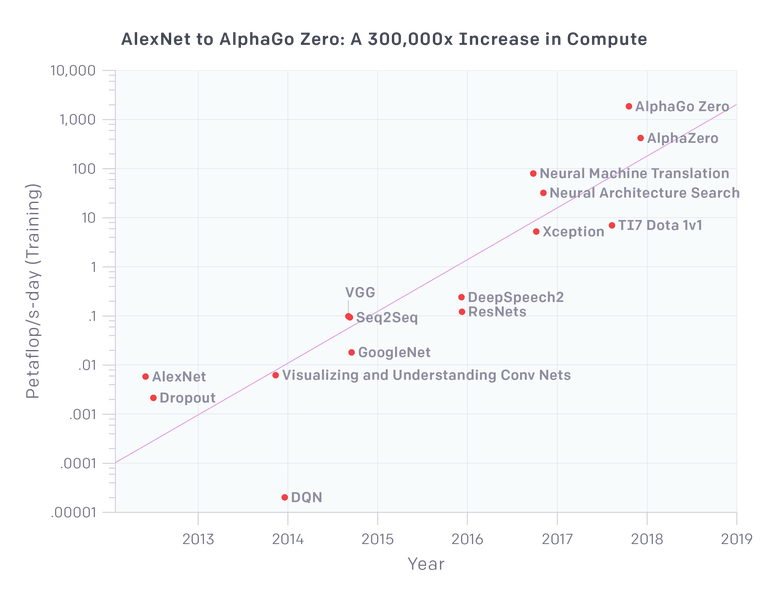

深度學(xué)習(xí)的一個(gè)重要口號(hào)是它可以輕松的擴(kuò)展。我們?cè)?012年擁有60M參數(shù)的AlexNet,現(xiàn)在我們已經(jīng)有至少1000倍的數(shù)量的模型了嗎?好吧,我們可能會(huì)這樣做,但問(wèn)題是 - 這些東西有1000x的能力提升嗎?100倍的能力?openAI的研究派上用場(chǎng):

因此,就視覺(jué)應(yīng)用而言,我們看到VGG和Resnets在計(jì)算資源應(yīng)用的一個(gè)數(shù)量級(jí)上飽和(就參數(shù)數(shù)量而言實(shí)際上較少)。Xception是谷歌Inception架構(gòu)的一種變體,實(shí)際上它在ImageNet上的表現(xiàn)只是略微優(yōu)于其他模型,因?yàn)锳lexNet基本上解決了ImageNet。

因此,在比AlexNet計(jì)算量提高100倍的情況下,我們?cè)谝曈X(jué)方面已經(jīng)有了近乎飽和的體系結(jié)構(gòu),換句話(huà)說(shuō),圖像分類(lèi)的精確已經(jīng)提不動(dòng)了。

神經(jīng)機(jī)器翻譯是所有大型網(wǎng)絡(luò)搜索玩家(google, baidu, yahoo 等)的一大努力,難怪它有多少機(jī)器就用多少機(jī)器(盡管谷歌翻譯仍然很糟糕,雖然已經(jīng)在變得更好了)。

該圖上的最新三點(diǎn)有趣地顯示了Deep Mind和OpenAI應(yīng)用于游戲的強(qiáng)化學(xué)習(xí)相關(guān)項(xiàng)目。特別是AlphaGo Zero和稍微更通用的Alpha Zero需要大量計(jì)算,但不適用于真實(shí)世界的應(yīng)用程序,因?yàn)樾枰罅坑?jì)算來(lái)模擬和生成這些數(shù)據(jù)來(lái)供這些模型使用。

好的,現(xiàn)在我們可以在幾分鐘內(nèi)完成AlexNet的訓(xùn)練,但是我們可以在幾天內(nèi)訓(xùn)練一個(gè)比AlexNet大1000倍,質(zhì)量更好的模型嗎?顯然不是。

迄今為止,對(duì)深度學(xué)習(xí)的聲譽(yù)打擊最大的事件來(lái)自自動(dòng)駕駛領(lǐng)域。一開(kāi)始人們認(rèn)為End-to-End的深度學(xué)習(xí)可以以某種方式解決自動(dòng)駕駛問(wèn)題 (Nvidia特別推崇這一理念)。現(xiàn)在我覺(jué)得地球上應(yīng)該沒(méi)有人還相信這一點(diǎn)(盡管我可能是錯(cuò)的)。

看看前年加州車(chē)輛管理局DMV給各個(gè)廠(chǎng)商的自動(dòng)駕駛車(chē)輛人為干預(yù)報(bào)告,Nvidia的自動(dòng)駕駛汽車(chē)在缺少人為干預(yù)的情況下,連開(kāi)10英里都做不到。

自2016年以來(lái),特斯拉自動(dòng)駕駛系統(tǒng)發(fā)生了幾起事故,其中一些事件是致命的。可以說(shuō),特斯拉的自動(dòng)駕駛輔助技術(shù)不應(yīng)該與自動(dòng)駕駛混淆起來(lái)雖然在核心上它依賴(lài)于同一種技術(shù)。

都到今天了,它仍然不能自動(dòng)停在路口,不能識(shí)別交通信號(hào)燈,甚至不能通過(guò)環(huán)形交叉路口。那是在2018年5月,在承諾特斯拉將自動(dòng)駕駛從西海岸開(kāi)到東海岸的幾個(gè)月后(盡管傳言是他們已經(jīng)嘗試過(guò)但是在小于30次人工干預(yù)的情況下無(wú)法實(shí)現(xiàn))。幾個(gè)月前(2018年2月),伊隆馬斯克(Elon Musk)在一次電話(huà)會(huì)議上被問(wèn)及海岸到海岸的行駛問(wèn)題時(shí)重復(fù)說(shuō)到:

“我們本可以實(shí)現(xiàn)海岸到海岸的駕駛,但它需要太多的專(zhuān)門(mén)代碼來(lái)有效地進(jìn)行游戲;或者使代碼變得脆弱一些,這樣它只適用于一個(gè)特定的路線(xiàn),這不是通用的解決方案。

我對(duì)神經(jīng)網(wǎng)絡(luò)方面取得的進(jìn)展感到非常興奮。但是看起來(lái)并沒(méi)有太多的進(jìn)展。它會(huì)覺(jué)得這是一個(gè)蹩腳的司機(jī)。就像…好吧,這是一個(gè)非常好的司機(jī)。像“Holy Cow!”

因此,有許多人開(kāi)始對(duì)深度學(xué)習(xí)提出“寒冬論”:

預(yù)測(cè)人工智能的冬天就像是猜測(cè)股市崩盤(pán)一樣——不可能精確地知道發(fā)生的時(shí)間,但幾乎可以肯定會(huì)在某個(gè)時(shí)刻發(fā)生,就像股市崩盤(pán)之前,有跡象表明會(huì)發(fā)生危機(jī),但在當(dāng)時(shí)的環(huán)境中,卻很容易被大家忽視。

在我看來(lái),深度學(xué)習(xí)已經(jīng)出現(xiàn)了明顯的下降跡象。我并不知道這個(gè)冬天會(huì)有多“深度”,我也不知道接下來(lái)會(huì)發(fā)生什么,但我可以肯定,這個(gè)冬天一定會(huì)來(lái)臨,并且只會(huì)來(lái)的比想象的要早。

然而,上個(gè)月2018年圖靈獎(jiǎng)公布,深度學(xué)習(xí)三巨頭:Yoshua Bengio、Geoffrey Hinton、Yann LeCun獲獎(jiǎng),三人瓜分100萬(wàn)美元獎(jiǎng)金。

Yann LeCun、Geoffrey Hinton、Yoshua Bengio

去年,”深度學(xué)習(xí)寒冬論“頻起,三位大神也在多個(gè)場(chǎng)合對(duì)”寒冬“做出了回應(yīng)。實(shí)際上,三人對(duì)“寒冬”早有抗體,在上世紀(jì)八十年代,Geoffrey Hinton等人坐了數(shù)年的冷板凳,直到本世紀(jì)AI的再度爆發(fā)。

不僅如此,Geoffrey Hinton還提出新的神經(jīng)網(wǎng)絡(luò)模型Capsule Network(膠囊網(wǎng)絡(luò)),試圖找到解決深度學(xué)習(xí)缺陷的新方法,這位71歲的老人熬過(guò)最冷的AI冬天,并且認(rèn)定下一個(gè)“冬天”不會(huì)到來(lái)。

事實(shí)證明,榮耀是屬于熬過(guò)寒冬的人。

-

人工智能

+關(guān)注

關(guān)注

1791文章

46859瀏覽量

237557 -

自動(dòng)駕駛

+關(guān)注

關(guān)注

783文章

13684瀏覽量

166147 -

強(qiáng)化學(xué)習(xí)

+關(guān)注

關(guān)注

4文章

266瀏覽量

11213

原文標(biāo)題:靈魂一問(wèn):深度強(qiáng)化學(xué)習(xí)終到盡頭?

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

螞蟻集團(tuán)收購(gòu)邊塞科技,吳翼出任強(qiáng)化學(xué)習(xí)實(shí)驗(yàn)室首席科學(xué)家

NPU在深度學(xué)習(xí)中的應(yīng)用

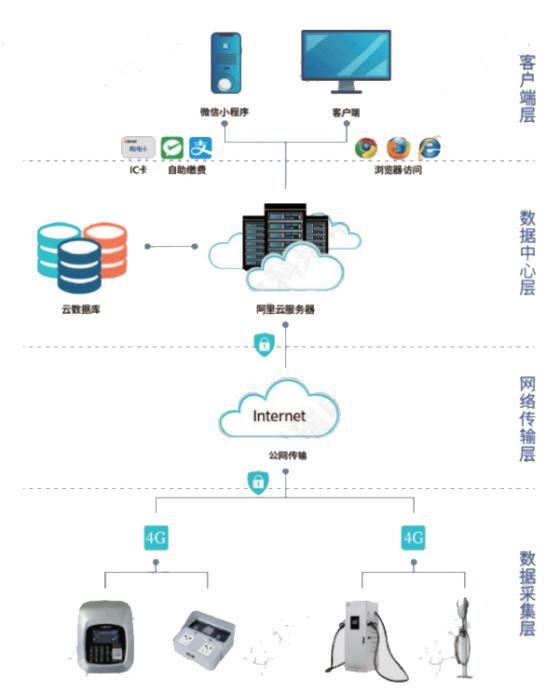

淺談適用于大規(guī)模充電場(chǎng)站的深度強(qiáng)化學(xué)習(xí)有序充電策略

如何使用 PyTorch 進(jìn)行強(qiáng)化學(xué)習(xí)

GPU深度學(xué)習(xí)應(yīng)用案例

AI大模型與深度學(xué)習(xí)的關(guān)系

谷歌AlphaChip強(qiáng)化學(xué)習(xí)工具發(fā)布,聯(lián)發(fā)科天璣芯片率先采用

深度學(xué)習(xí)中的時(shí)間序列分類(lèi)方法

深度學(xué)習(xí)與nlp的區(qū)別在哪

基于深度學(xué)習(xí)的小目標(biāo)檢測(cè)

深度學(xué)習(xí)與卷積神經(jīng)網(wǎng)絡(luò)的應(yīng)用

通過(guò)強(qiáng)化學(xué)習(xí)策略進(jìn)行特征選擇

深度解析深度學(xué)習(xí)下的語(yǔ)義SLAM

為什么深度學(xué)習(xí)的效果更好?

深度學(xué)習(xí)如何訓(xùn)練出好的模型

深度強(qiáng)化學(xué)習(xí)已經(jīng)達(dá)到了盡頭?

深度強(qiáng)化學(xué)習(xí)已經(jīng)達(dá)到了盡頭?

評(píng)論