DeepFakes技術(shù)的安全性已然成為輿論的焦點(diǎn)。而近日,來自加州大學(xué)伯克利分校和南加州大學(xué)的研究人員打造了一款AI識(shí)別系統(tǒng),能從Deepfake制假者未注意到的面部細(xì)節(jié)入手,準(zhǔn)確"揪出"假視頻。

DeepFake假視頻的泛濫早已經(jīng)不只是惡搞和娛樂的問題了!這些假視頻衍生出的假新聞可能會(huì)成為2020美國(guó)大選的一場(chǎng)噩夢(mèng)。

目前,越來越多的研究人員在努力尋找準(zhǔn)確識(shí)別Deepfake的假視頻的方法。這場(chǎng)斗法已經(jīng)成為一場(chǎng)維護(hù)新聞?wù)鎸?shí)性、甚至是關(guān)乎國(guó)家安全的一場(chǎng)軍備競(jìng)賽。

近日,來自加州大學(xué)伯克利分校和南加州大學(xué)的研究人員在這場(chǎng)競(jìng)賽中暫時(shí)走在了前面。他們打造的AI識(shí)別系統(tǒng),能從Deepfake制假者未注意到的面部細(xì)節(jié)入手,準(zhǔn)確"揪出"假視頻。

現(xiàn)在使用神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)偽造的視頻,其質(zhì)量和生產(chǎn)速度可能讓即將到來的總統(tǒng)大選成為一場(chǎng)噩夢(mèng)。但是,利用當(dāng)前深度技術(shù)中被忽視的一些東西,研究人員發(fā)現(xiàn)了一種自動(dòng)識(shí)別這些虛假視頻的新方法。

DeepFake不再可怕,精準(zhǔn)判斷真?zhèn)?/p>

利用Deepfake生成視頻現(xiàn)在還遠(yuǎn)遠(yuǎn)算不上完美。這些視頻是利用互聯(lián)網(wǎng)上抓取的海量圖像庫(kù)創(chuàng)建的,早期生成的視頻分辨率一般很低(因?yàn)楦菀纂[藏缺陷),而且是過度壓縮的。但Deepfake技術(shù)的發(fā)展速度非常驚人,而且這個(gè)過程中,不斷改進(jìn)生成視頻中的缺陷,比如假視頻中人物從不眨眼的缺陷,很快得到了改善,使這些生成的假視頻變得越來越逼真可信。

早期的Deepfake生成的假視頻缺陷明顯,比如人物說話時(shí)從不眨眼,現(xiàn)在這個(gè)缺陷已被修復(fù)

假視頻的生成與識(shí)別已經(jīng)成為一場(chǎng)軍備競(jìng)賽,任何一方都不會(huì)很快徹底打垮對(duì)手。不過最近,來自加州大學(xué)伯克利分校和南加州大學(xué)的研究人員在這場(chǎng)戰(zhàn)斗中開發(fā)了出了新的武器,可以更加準(zhǔn)確地識(shí)別偽造的視頻。研究人員利用前總統(tǒng)奧巴馬的現(xiàn)有視頻,使用類似的過程來創(chuàng)建假視頻,訓(xùn)練AI來尋找每個(gè)人的“軟性生物識(shí)別”標(biāo)簽。

這聽起來很復(fù)雜,其實(shí)這東西我們并不陌生。每當(dāng)我們開口說話時(shí),都會(huì)以微妙但獨(dú)特的方式來移動(dòng)身體,我們的頭、手、眼睛甚至嘴唇都會(huì)產(chǎn)生這樣的運(yùn)動(dòng)。這一切都是在潛意識(shí)里完成的,你沒有意識(shí)到你的身體正在做這件事,大腦也沒有立刻意識(shí)到身體其他部位的運(yùn)動(dòng)發(fā)生在何時(shí),但從結(jié)果上看,這是一個(gè)目前Deepfake在創(chuàng)造假視頻時(shí)的時(shí)候沒有考慮到的因素。

在實(shí)驗(yàn)中,這款新的AI準(zhǔn)確發(fā)現(xiàn)偽造視頻的幾率達(dá)到了92%,實(shí)驗(yàn)對(duì)象包括使用多種技術(shù)創(chuàng)建的假視頻,以及由于視頻文件被過度壓縮導(dǎo)致圖像質(zhì)量下降的視頻。

下一步,研究人員還打算通過識(shí)別人聲的獨(dú)特節(jié)奏和特征,來進(jìn)一步提高AI識(shí)別假視頻的成功率。但目前的實(shí)際情況是,Deepfake的發(fā)展和改進(jìn)速度非常快,可能會(huì)在2020年之前迎頭趕上,成功欺騙目前的AI識(shí)別工具。這可能是一場(chǎng)曠日持久的戰(zhàn)斗,最終誰會(huì)獲勝現(xiàn)在還很難講。

深度學(xué)習(xí)的最新進(jìn)展使得創(chuàng)建復(fù)雜且引人注目的假視頻變得更加容易。現(xiàn)在,普通人就可以利用相對(duì)適度的數(shù)據(jù)和計(jì)算力,炮制出一段名人的演講視頻,這些所謂的“Deepfake”視頻可能會(huì)對(duì)國(guó)家安全和社會(huì)構(gòu)成重大威脅。為了應(yīng)對(duì)這種日益嚴(yán)重的威脅,本文提出了一種技術(shù),可以模擬人物說話時(shí)潛在的面部表情和動(dòng)作。雖然這些動(dòng)作看上去不顯眼,但制造假視頻的方法沒有注意這一點(diǎn),因此可用于驗(yàn)證視頻的真假。

我們假設(shè),當(dāng)一個(gè)人說話時(shí),會(huì)做出不同的(但可能不是唯一的)面部表情和動(dòng)作。給定單個(gè)視頻作為輸入,首先跟蹤面部和頭部運(yùn)動(dòng),然后檢測(cè)并提取特定動(dòng)作單元的存在性和強(qiáng)度。由此可以構(gòu)建一個(gè)能夠區(qū)分真假視頻的新的檢測(cè)模型。

圖1 上面所示是來自250幀剪輯片段中的五個(gè)等距幀,顯示了對(duì)OpenFace的跟蹤結(jié)果。下半部分為此視頻剪輯上測(cè)量的一個(gè)動(dòng)作單元AU01(眉毛抬起)的程度。

我們使用開源面部行為分析工具包OpenFace2 來提取視頻中的面部和頭部運(yùn)動(dòng)。該數(shù)據(jù)庫(kù)為給定視頻中的每幀提供2-D和3-D面部地標(biāo)位置、頭部姿勢(shì)、眼睛注視和面部動(dòng)作單元。提取量度標(biāo)準(zhǔn)如圖1所示。

具體來說,首先要明確的是,不同的人在說話時(shí)會(huì)表現(xiàn)出相對(duì)不同的面部和頭部運(yùn)動(dòng)模式。而Deepfake假視頻往往會(huì)破壞這些模式,因?yàn)榧僖曨l中的這些模式的表達(dá)由模仿算法控制,可能導(dǎo)致嘴巴與臉部的其他部分不自然的分離。

本文構(gòu)建了高度個(gè)人化的“軟生物識(shí)別指標(biāo)”,并利用這些指標(biāo)來區(qū)分真實(shí)和虛假視頻。與以前的方法不同,這種方法能夠有效應(yīng)對(duì)laundering,因?yàn)樵摲椒ㄒ蕾囉诓灰灼茐牡南鄬?duì)粗略的量度。

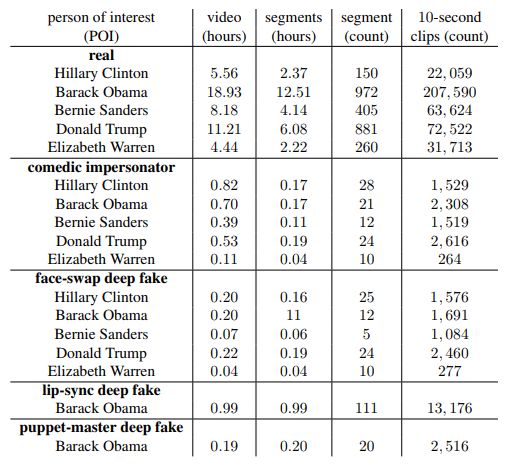

表1. POI正在講話的下載視頻和段的總持續(xù)時(shí)間,以及從段中提取的段和10秒剪輯的總數(shù)。

圖2.從上到下依次是原始視頻,嘴唇同步Deepfake假視頻、喜劇模仿視頻、換臉Deepfake和木偶大師deepfake的10秒視頻剪輯的五個(gè)示例幀。

圖3. 希拉里·克林頓(棕色),巴拉克·奧巴馬(淺灰色帶框),伯尼·桑德斯(綠色),唐納德·特朗普(橙色),伊麗莎白·沃倫(藍(lán)色)的190-D特征的二維可視化),隨機(jī)任務(wù)(粉色),以及奧巴馬的Deepfake假視頻(深灰色帶框)

實(shí)驗(yàn)結(jié)果:總體識(shí)別準(zhǔn)確率超過95%

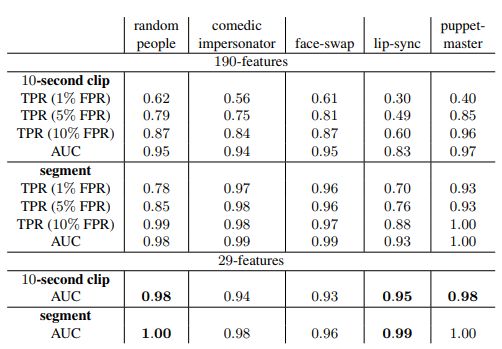

表2:奧巴馬視頻的三種不同假陽性率(FPR)曲線下面積(AUC)和真陽性率(TPR)的總體準(zhǔn)確度。上半部分對(duì)應(yīng)于使用完整190個(gè)特征的10秒視頻片段和完整視頻片段的識(shí)別準(zhǔn)確度。下半部分為于僅使用29個(gè)特征的識(shí)別準(zhǔn)確度。

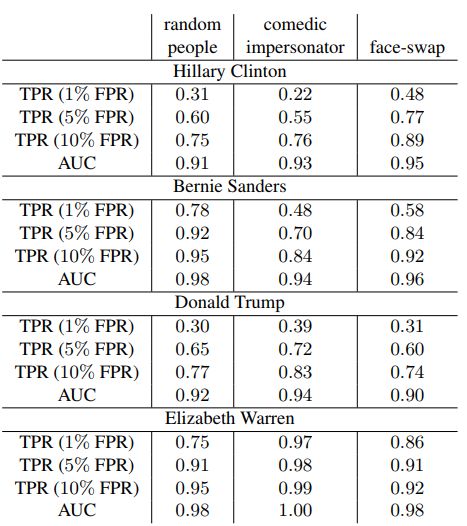

表3:希拉里·克林頓,伯尼·桑德斯,唐納德·特朗普和伊麗莎白沃倫的10秒視頻剪輯的總體識(shí)別準(zhǔn)確度

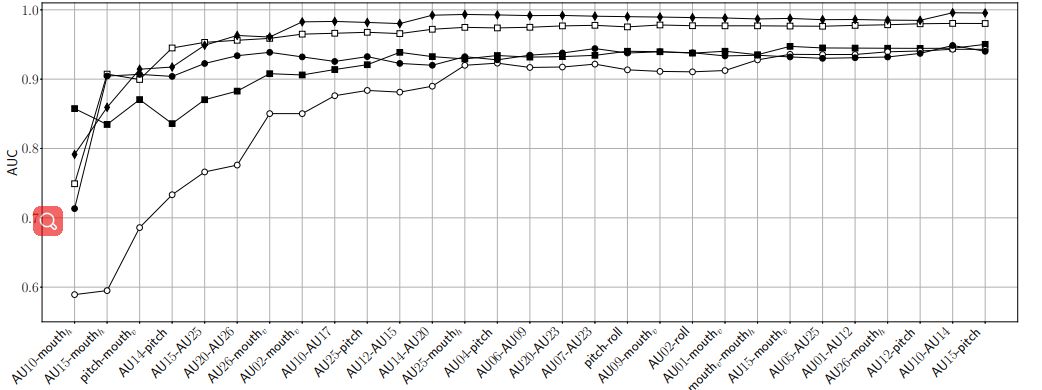

表4:對(duì)喜劇模仿假視頻(黑色方塊),隨機(jī)人物假視頻(白色方塊),嘴唇同步Deepfake假視頻(黑色圓圈),換臉Deepfake假視頻(白色圓圈)和木偶大師Deepfake假視頻(黑色菱形)的識(shí)別準(zhǔn)確度

圖5:(a)真實(shí)的樣本框架; (b)喜劇模仿假視頻樣本框架; (c)四個(gè)名人的換臉Deepfake假視頻的樣本框架

研究局限與未來方向

本文提出的方法與現(xiàn)有的基于像素的檢測(cè)方法相比,可以更好地抵御圖像壓縮的影響。不過我們也發(fā)現(xiàn),本方法的適用性容易受到人們說話的不同背景的影響(直面鏡頭正式講話,與不看鏡頭的現(xiàn)場(chǎng)采訪)。我們建議通過以下兩種方式來應(yīng)對(duì)。

在各種多樣化環(huán)境中收集更大、更多樣化的視頻集,或者構(gòu)建幾位名人基于特定環(huán)境下的講話模型。除了這種背景環(huán)境效應(yīng)之外,我們發(fā)現(xiàn)當(dāng)演講人始終遠(yuǎn)離鏡頭時(shí),動(dòng)作單元的可靠性可能會(huì)受到嚴(yán)重影響。為了解決這些局限性,建議通過語言分析來增強(qiáng)模型性能,更好地捕獲所說內(nèi)容與說法方式之間的相關(guān)性。

-

AI

+關(guān)注

關(guān)注

87文章

30239瀏覽量

268481 -

DeepFake

+關(guān)注

關(guān)注

0文章

15瀏覽量

6663

原文標(biāo)題:DeepFakes天敵來了!伯克利緊急研發(fā)“火眼金睛”防偽克星

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

RISC-V,即將進(jìn)入應(yīng)用的爆發(fā)期

4K高清高速攝像頭在車牌識(shí)別技術(shù)中的革新應(yīng)用與優(yōu)勢(shì)解析

人員超員識(shí)別系統(tǒng) 作業(yè)區(qū)域超員預(yù)警系統(tǒng)

如何判斷進(jìn)口示波器探頭的真?zhèn)?/b>

基于FPGA的指紋識(shí)別系統(tǒng)設(shè)計(jì)

多目標(biāo)智能識(shí)別系統(tǒng)

基于OpenCV的人臉識(shí)別系統(tǒng)設(shè)計(jì)

基于GIS的SAR多目標(biāo)智能識(shí)別系統(tǒng)

車載語音識(shí)別系統(tǒng)語音數(shù)據(jù)采集標(biāo)注案例

車載語音識(shí)別系統(tǒng)語音數(shù)據(jù)采集標(biāo)注案例

斯坦福、伯克利大神教授創(chuàng)業(yè)給機(jī)器人造大腦,OpenAI紅杉搶著投5億

開發(fā)者手機(jī) AI - 目標(biāo)識(shí)別 demo

科學(xué)家如何加速下一代微電子技術(shù)的發(fā)展

基于Qorvo超寬帶雷達(dá)芯片組打造的車內(nèi)傳感應(yīng)用解決方案

伯克利打造AI識(shí)別系統(tǒng),DeepFake不再可怕!精準(zhǔn)判斷真?zhèn)?/h1>

伯克利打造AI識(shí)別系統(tǒng),DeepFake不再可怕!精準(zhǔn)判斷真?zhèn)?/h1>

評(píng)論