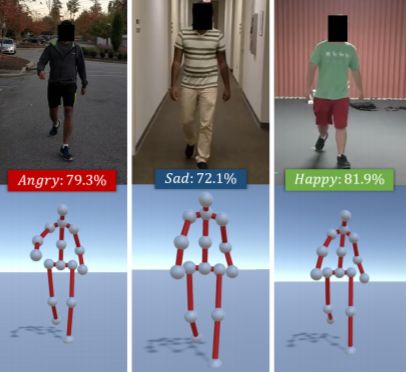

研究人員最近開發(fā)了一種機(jī)器學(xué)習(xí)方法,可以從一個(gè)人的步態(tài)識(shí)別人的情緒(例如,積極或消極,平靜或精力充沛)。這是第一種此類方法,并在初步實(shí)驗(yàn)中取得了80.07%的準(zhǔn)確率。

一個(gè)人走路的樣子很能說明人在特定時(shí)刻的感受。例如,當(dāng)你感到壓抑或沮喪時(shí),相比感到心滿意足時(shí),走路的時(shí)候更可能耷拉著肩膀。

利用這種身體語言,教堂山大學(xué)和馬里蘭大學(xué)的研究人員最近開發(fā)了一種機(jī)器學(xué)習(xí)方法,可以從一個(gè)人的步態(tài)中識(shí)別人的感知情緒(例如,積極或消極,平靜或精力充沛)。研究人員稱這是第一種此類方法,并且在初步實(shí)驗(yàn)中取得了80.07%的準(zhǔn)確率。

論文地址:

https://arxiv.org/pdf/1906.11884.pdf

“情感在我們的生活中扮演著重要的角色,定義著我們的經(jīng)歷,塑造著我們看待世界和與他人互動(dòng)的方式,”作者在論文中寫道。“由于感知情感在日常生活中的重要性,自動(dòng)情感識(shí)別在許多領(lǐng)域都是一個(gè)關(guān)鍵問題,比如游戲和娛樂、安全和執(zhí)法、購物、人機(jī)交互等。”

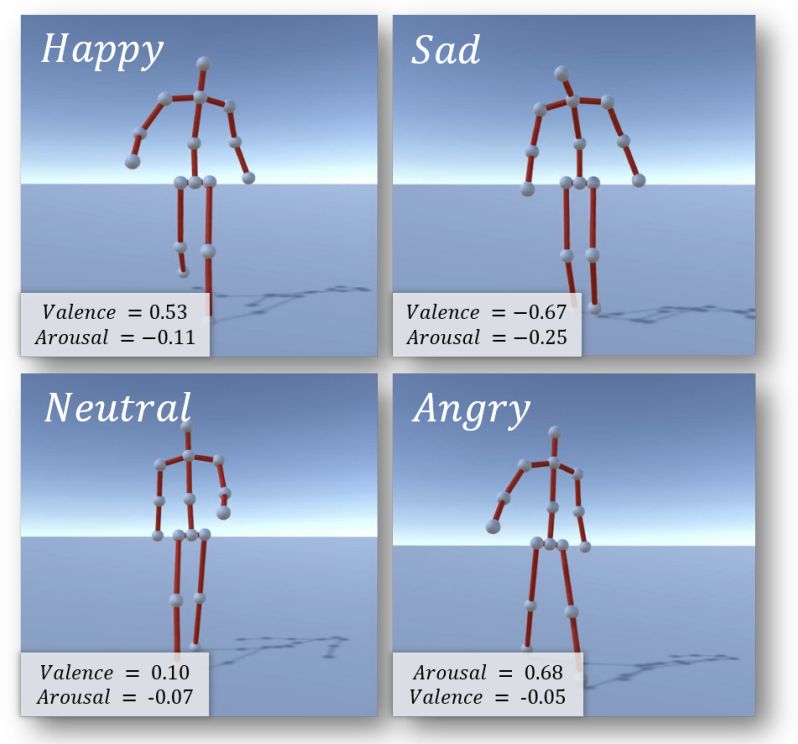

研究人員選擇了四種情緒:快樂、悲傷、憤怒和中性,因?yàn)檫@些情緒傾向于“持續(xù)較長一段時(shí)間”,以及這些情緒對步態(tài)活動(dòng)的影響較大。

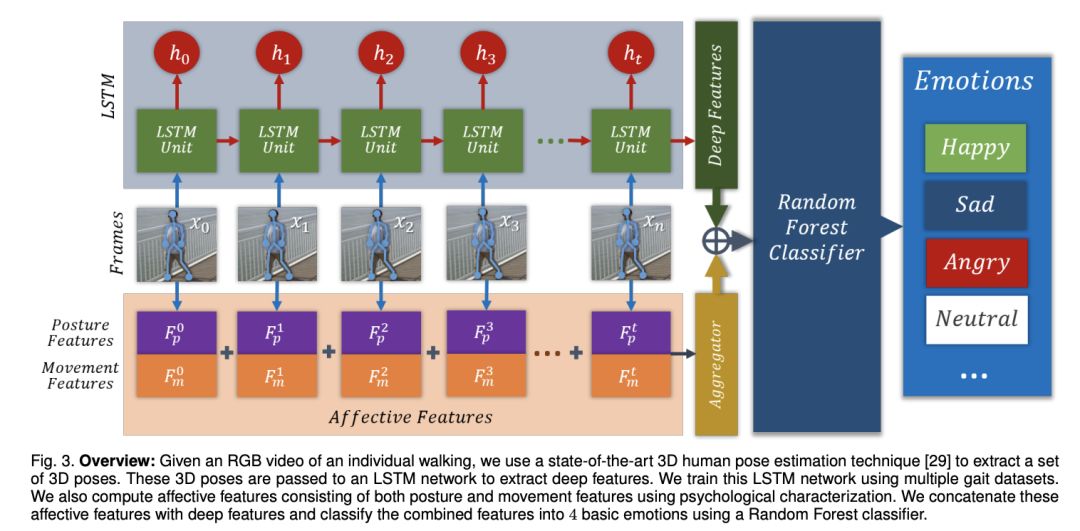

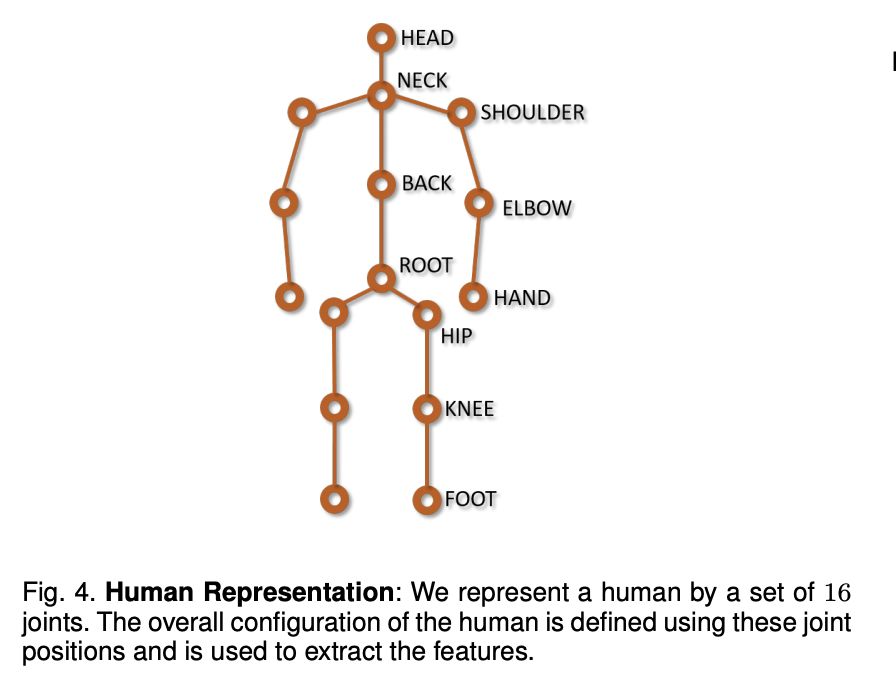

然后,他們從多個(gè)步行視頻語料庫中提取步態(tài)來識(shí)別情感特征,并使用三維姿態(tài)估計(jì)技術(shù)提取姿態(tài)。

最后,他們利用長短時(shí)記憶(LSTM)模型——能夠?qū)W習(xí)長期依賴關(guān)系——從姿態(tài)序列中獲得特征,并將其與隨機(jī)森林分類器(該分類器輸出多個(gè)獨(dú)立決策樹的平均預(yù)測)相結(jié)合,將樣本分類為上述四種情緒類別。

這些特征包括肩膀姿勢、連續(xù)步數(shù)之間的距離以及手和脖子之間的區(qū)域。

頭部傾斜角度被用來區(qū)分快樂和悲傷的情緒,而“身體緊張”和“身體舒張”分別識(shí)別積極和消極的情緒。至于情緒平靜還是精神充沛,研究人員注意到它往往與運(yùn)動(dòng)量是否增加相對應(yīng),該模型考慮了速度、加速度的大小,以及手、腳和頭部關(guān)節(jié)的“運(yùn)動(dòng)抖動(dòng)”。

AI系統(tǒng)處理的樣本來自“Emotion Walk”數(shù)據(jù)集,簡稱EWalk。EWalk是一組包含1384個(gè)步態(tài)的新數(shù)據(jù)集,這些步態(tài)是從24名受試者在大學(xué)校園(包括室內(nèi)和室外)散步的視頻中提取的。大約有700名來自 Amazon Mechanical Turk 的參與者給情緒貼上標(biāo)簽,研究人員用這些標(biāo)簽來確定情緒的類別和興奮程度。

在測試中,研究人員報(bào)告說,他們的情感檢測方法比最先進(jìn)的算法提高了13.85%,比不考慮情感特征的“普通”LSTM提高了24.60%。

但這并不是說它是萬無一失的——它的精度在很大程度上取決于3D人體姿態(tài)估計(jì)和步態(tài)提取的精度。但盡管有這些限制,研究人員相信他們的方法將為涉及額外活動(dòng)和其他情感識(shí)別算法的研究提供堅(jiān)實(shí)的基礎(chǔ)。

“我們的方法也是第一個(gè)利用最先進(jìn)的3D人體姿態(tài)估計(jì)技術(shù),為步行視頻中的情緒識(shí)別提供實(shí)時(shí)通道的方法,”研究者寫道。“作為未來工作的一部分,我們希望收集更多的數(shù)據(jù)集,并解決目前的限制。”

-

分類器

+關(guān)注

關(guān)注

0文章

152瀏覽量

13175 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8378瀏覽量

132425

原文標(biāo)題:今天你快樂嗎?AI 從走路姿態(tài)就能識(shí)別你的情緒

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

【卡酷機(jī)器人】——基礎(chǔ)學(xué)習(xí)方法

【技術(shù)雜談】用AI讀懂人心?情感科學(xué)專家:靠表情識(shí)別情緒不靠譜

自動(dòng)步態(tài)識(shí)別系統(tǒng)如何實(shí)現(xiàn)?

是否可以使用LSM6DSOTR生成的數(shù)據(jù)來唯一識(shí)別一個(gè)人?

一種改進(jìn)的步態(tài)識(shí)別方法

日本研究團(tuán)隊(duì)創(chuàng)建了一種算法 可以解讀并再現(xiàn)一個(gè)人看到的圖像或想象的圖像

讓機(jī)器人通過一段只有一個(gè)人的視頻來模仿學(xué)習(xí)

動(dòng)態(tài)部位特征的步態(tài)識(shí)別方法

一種模糊森林學(xué)習(xí)方法

一種可以超越傳統(tǒng)方法捕捉微小的面部表情,并更好的測量人類情緒的機(jī)器學(xué)習(xí)模型

一種新的基于機(jī)器學(xué)習(xí)的系統(tǒng)

面部識(shí)別算法可以輕松地從一個(gè)瞬間識(shí)別出個(gè)人

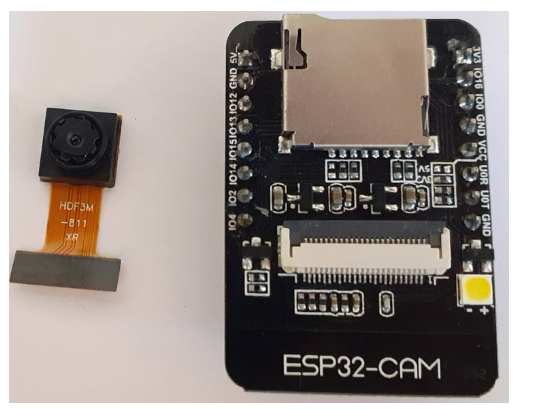

如何使用ESP32-CAM構(gòu)建一個(gè)人臉識(shí)別系統(tǒng)

聯(lián)合學(xué)習(xí)在傳統(tǒng)機(jī)器學(xué)習(xí)方法中的應(yīng)用

一種機(jī)器學(xué)習(xí)方法可以從一個(gè)人的步態(tài)中識(shí)別人的感知情緒

一種機(jī)器學(xué)習(xí)方法可以從一個(gè)人的步態(tài)中識(shí)別人的感知情緒

評論