iPhone 8/8p和iPhone X都搭載了蘋果自研的A11 Bionic(仿生)芯片。雖然蘋果全程并沒有在這款芯片上花太多功夫介紹,但我們仍舊知道它集成了一個專用于機器學習的硬件——“神經網絡引擎(Neural Engine)”

可別小看了這塊A11,通過智東西仔細研究發現,它不僅是iPhone X中一眾“黑科技”的來源,而且蘋果為了打造這塊芯片早在9年前就開始了技術布局。

一、參數亮相,跑分爆表了

在介紹A11里專門用于機器學習的“神經網絡引擎”之前,我們先來看看A11的基本參數。

工藝方面,A11采用了臺積電10nm FinFET工藝,集成了43億個晶體管(上一代采用16nm工藝的A10 Fusion集成了33億個晶體管,華為麒麟970則用10nm工藝集成了55億個)。

A11搭載了64位ARMv8-A架構的6核CPU,其中包括2個名為“Monsoon”的性能核(performance core)和4個名為“Mistral”的能效核(high-eggiciency core),性能核比上一代A10里的快了25%,能效核則快了70%。

而且,與A10不同,A11中使用了蘋果自研的第二代新型性能控制器,允許6個CPU內核同時使用,整體性能比上一代快了70%。

至于為什么分為性能核和能效核呢?當手機進行發短信、瀏覽網頁等輕量任務時,系統會選擇調用能耗更低的能效核(high-eggiciency core),而當手機需要運行對計算能力要求更高的軟件時,則需要動用性能核(performance core)進行處理,借此可以有效延長平均電池壽命。搭載了A11的iPhone X在充滿電后,將會比iPhone 7延長2個小時的待機時間。

A11的另外一大亮點就是首次搭載了蘋果自研的GPU,這是一款3核GPU,性能相比A10 Fusion提升30%,只需要一半的功耗就能達到A10的表現。這是今年4月蘋果宣布和英國GPU設計公司Imagination Technologies“分手”后推出的首款自研GPU,針對AR、沉浸式3D游戲等方面都進行了優化,比A10快了30%。

A11里還集成了蘋果自研的ISP、自研的視頻編解碼器等等。從種種強調的“自研”我們不難發現,蘋果已經越來越強調架構的自主化。在徹底跟老朋友Imagination Technologies分手后(并且導致人家股價斷崖式下跌70%后),蘋果的下一個自研目標也許會移到基帶技術上,與高通曠日持久的專利訴訟案件算得上是前兆了。

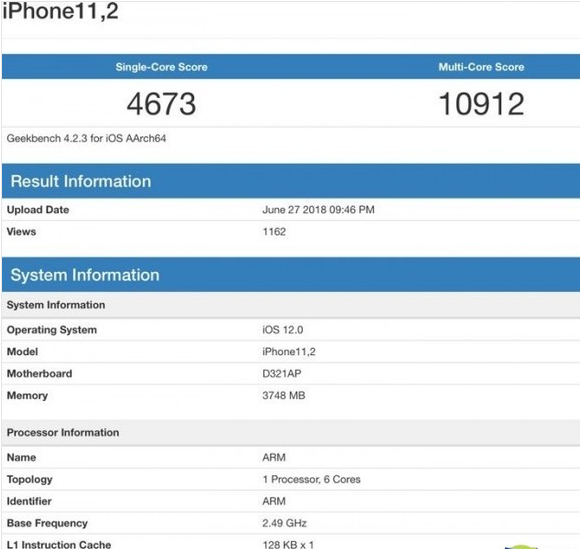

此外,我們也可以從A11在Geekbench的跑分上一窺究竟:在Geekbench中有A11的幾個跑分,其中單核性能最高的是4274,多核性能最高的是10438,而取這些跑分平均值后,單核性能是4169,多核性能是9836。

這是什么概念呢?跟上一代A10的“單核成績3332,多核成績5558”比起來,A11在兩方面的性能有接近30%和50%的飆升。而iPad Pro中的A10X單核性能平均在3900左右,而多核性能是9200左右,依然弱于A11。

而Android陣營的種子選手——高通驍龍835的GeekBench成績為單核2000左右,多核6500左右。

二、A11就是“人工智能芯片”

這次,蘋果在自家的A11 Bionic芯片上搭載了一個專用于機器學習的硬件——“神經網絡引擎(neural engine)”。

現在所謂的手機處理器,比如高通的835、蘋果的A11、麒麟970等,實際上所指的是一個“處理器包”封裝在一起,這個計算包專業一點說叫Soc(System-on-a-Chip),高大上的說法是“計算平臺”;根據分工不同,很多專用功能的處理單元加進來,比如我們最熟悉的是GPU,現在這個包里的獨立單元數量已經越來越大,比如ISP(圖像處理)、Modem(通信模塊)、DSP(數字信號處理)等。

不同的數據進來,交給不同特長的計算模塊來處理將會得到更好的效果、更高的能效比,A11的神經網絡引擎(neural engine)跟麒麟970的NPU一樣,是在手機處理器平臺新加入的一個擅長神經網絡計算的硬件模塊。

而這也是為什么從20nm、16nm、到現在的10nm、以及研發中的7nm,各大芯片設計商、代工商都在拼命把芯片技術往小了做,為的就是在不影響芯片大小的前提下擠進更多的獨立處理單元。

A11的神經網絡引擎采用雙核設計,每秒運算次數最高可達6000億次,相當于0.6TFlops(寒武紀NPU則是1.92TFlops,每秒可以進行19200次浮點運算),以幫助加速人工智能任務,即專門針對Face ID,Animoji和AR應用程序的ASIC(專用集成電路/全定制AI芯片)。

有了神經網絡引擎,蘋果高級副總裁Phil Schiller很有底氣的表示:

“A11 Bionic是一款智能手機到目前為止所能擁有的最強勁、最智能的芯片。而基于ASIC的深度學習,實現了高準確率之外,還能比基于通用芯片(GPU、FPGA)的方案減少功耗。”

不過,蘋果對這款神經網絡引擎的功耗、實測性能等方面都沒有進一步披露。

A11同時也支持Core ML,這是蘋果在今年WWDC開發者大會上推出的一款新型機器學習框架,能讓開發者更方便地將機器學習技術整合到自己的App中。Core ML支持所有主要的神經網絡,如DNN、RNN、CNN等,開發者可以把訓練完成的機器學習模型封裝進App之中。

三、買買買,買出來的AI帝國

從去2010年開始,蘋果就沒有停止過收購人工智能創企的步伐,并且每次給出的都是慣常聲明:“蘋果會不時收購規模較小的科技公司。我們通常不討論目的或計劃。”非常有“事了拂衣去,深藏功與名”的意思。

而且,每個被蘋果收購的公司都會立即關閉對外的產品和服務,像是忽然從世界消失一般。

收購芯片廠商

以芯片為例,早在2008年,蘋果就以2.78億美元收購了2003年成立加州的高性能低功耗處理器制造商PA Semi。

隨后在2010年,蘋果以1.21億美元收購了1997年成立的美國德州半導體邏輯設計公司Intrinsity,專注于設計較少晶體管、低能耗同時具備高性能的處理器。

2011年年底,蘋果又以3900萬美元的價格收購了以色列閃存控制器設計公司Anobit。

2013年8月1日,蘋果收購了成立于2007年的加州半導體公司Passif Semiconductor,其專長于低功耗無線通訊芯片(大膽地猜測一下Apple Watch的芯片技術是不是來自這里)。

其后的2015年底,蘋果再次斥資1820萬美元,收購了一間位于加州圣何塞北部的面積7萬平方英尺(6500平方米)的芯片制造工廠。這座工廠原屬于芯片制造商Maxim Integrated Products,其設施包括了芯片制造工具,而且工廠地址靠近三星半導體公司。

從以上一連串的買買買我們可以看到,蘋果的芯片布局早在近十年前就開始了。

除了芯片之外,從2010年至今,蘋果已經陸續收購了四五十家創企,包括語音識別、圖像/面部識別、計算機視覺、AR、數據挖掘、機器學習、地圖、定位等等,而這其中幾個比較具備代表性的有:

收購面部識別/表情追蹤廠商——Animoji和Face ID的技術來源

2010年,蘋果以2900萬美元收購瑞典面部識別創企Polar Rose,他們開發的面部識別程序可以可以為用戶自動圈出照片中的人臉。

2015年11月,蘋果收購《星球大戰》背后的動作捕捉技術公司Faceshift,這家蘇黎世的創業公司開發了實時追蹤人臉表情,然后再用動畫表現出來的技術。該技術還可以實現面部識別。

2016年1月,蘋果收購了加州AI初創Emollient,該公司使用人工智能技術讀取圖片中的面部表情。

2017年2月,蘋果以200萬美元收購了面部識別以色列創企RealFace,該公司開發了一種獨特的面部識別技術,其中整合人工智能并將人類的感知帶回數字過程。

收購AR引擎巨頭

2015年5月,蘋果收購AR引擎巨頭德國Metaio公司。彼時Metaio與Vuforia并肩稱霸AR引擎行業,Metaio擁有約15萬名開發者,Vuforia則擁有大約18萬,兩家的SDK開發者占到了當時整個市場的95%以上,在AR的行業地位有如Windows和Mac OS之于PC。這個收購舉措,可以看作是ARkit的技術來源。

收購25年德國老牌眼球追蹤企業

而離現在最近的一次收購,就是蘋果今年6月時宣布收購德國老牌眼動追蹤企業SMI(SensoMotoric Instruments)。其歷史要追溯到1991年,SMI從柏林自由大學學術醫療研究院剝離出來,獨自成立眼球追蹤技術公司,迄今已經有超過25年的發展歷史了。產品包括面向企業與研發機構的眼球追蹤設備/應用、醫療醫療眼控輔助設備、手機、電腦、VR設備等的眼控技術支持等。

目前,眼球追蹤技術已經被集成在了iPhone X里。在用Face ID解鎖時,只要你眼睛沒有看著屏幕,屏幕也是不會解鎖的。

四、用來干啥:Face ID背后的結構光學技術

既然是“人工智能芯片”,當然是用來做人工智能——人臉識別、圖像識別、面部表情追蹤、語音識別、NLP、SLAM等等。

而A11的神經網絡引擎第一個重要的應用就是iPhone X的刷臉解鎖——Face ID。

雖然刷臉解鎖并不是什么石破天驚的新技術,但是蘋果的Face ID解鎖跟普通的基于RGB圖像的人臉識別解鎖不同。寒武紀架構研發總監劉少禮博士說:

“我們這次對蘋果A11的AI引擎了解不多,特別是功耗、實測性能等方面蘋果發布會基本沒有提。個人覺得iPhone X這次最大的亮點是距離傳感器,用來支持3D的Face ID,這個功能在業內還是引起了不小震動,后續會給予這功能開發出不少有趣的應用。通過結構光發射器和紅外攝像頭配合,可以捕捉人臉的深度信息,比之前用2D圖像作人臉識別進步了很多。”

根據原理和硬件實現方式的不同,行業內所采用的3D機器視覺主要有三種:結構光、TOF 時間光、雙目立體成像。

三種主流的 3D 視覺方案代表性產品

雙目立體成像方案軟件算法復雜,技術還不成熟;結構光方案技術成熟,功耗低,平面信息分辨率高,但是容易受光照影響,識別距離近;TOF 方案抗干擾性好,識別距離遠,但是平面分辨率低,功耗較大。

綜合來看,結構光方案更加適合消費電子產品前置近距離攝像,可應用于人臉識別 、手勢識別等方面,TOF方案更加適合消費電子產品后置遠距離攝像,可應用于 AR、體感交互等方面。

iPhone X的Face ID采用了人工智能加持的結構光方案:數據采集由該機正面上方的景深感知攝像機(即“劉海兒”,TrueDepth Camera System)完成,其紅外線發射器可以發射3萬個偵測點,利用神經引擎(Neural Engine)將反射回來的數據與儲存在A11芯片隔區內的數據進行對比,實現用戶面部的3D讀取與處理。通過神經網絡訓練的加持,Face ID失誤率僅為百萬分之一,遠小于Touch ID的五萬分之一。

與此同時,iPhone X還具備眼球追蹤功能,在你面對屏幕,但是眼睛沒有看著它的時候,也是不會解鎖的。所以,這樣的人臉解鎖是照片騙不了的。

而且,蘋果的軟件工程高級副總裁Craig Federighi曾表示,“我們不會在用戶注冊Face ID時收集數據,它會保留在你的設備上,不會被發送到云端進行訓練。” 符合蘋果一貫的“用戶隱私為上”理念。

最為神奇的是,用戶面容適應(化妝、佩戴眼鏡、長胡子、隨著年齡增長而變容改變等)過程需要用到的深度學習訓練也是在本地完成的。深度學習分為訓練(Training)和推理/應用(Inference)兩部分,訓練階段所需的計算量比應用階段的要大上許多。

另一方面,計算與訓練的本地化也有助于讓Siri變得更加智能。畢竟有不少人認為由于蘋果對用戶的隱私過于重視,導致Siri發展較慢,競爭對手們后來居上。

此外,在A11的加成下,iPhone X前頭“劉海兒”實現的臉部追蹤技術還可以用于個人定制化表情Animoji(能捕捉并分析 50 多種不同的肌肉運動)、AR濾鏡等,新的互動的方式有望提高用戶的參與度和粘性,提高AR社交平臺的經濟價值。而3D視覺所提供的景深信息和建模能力是現有普通攝像頭無法比擬的。

而iPhone X還搭載了全新陀螺儀和加速計,刷新率達到60 fps,可以實現準確的動作追蹤以及很好的渲染效果。在發布會上,蘋果全球市場營銷高級副總裁Phil Schiller是這么說的:“這是第一款真正為AR打造的智能手機。”

五、火熱的AI芯片產業

當前人工智能芯片主要分為GPU、ASIC、FPGA。代表分別為NVIDIA Tesla系列GPU、Google的TPU、Xilinx的FPGA。此外,Intel還推出了融核芯片Xeon Phi,適用于包括深度學習在內的高性能計算,但目前根據公開消息來看在深度學習方面業內較少使用。

其中,蘋果的A11、寒武紀的A1、谷歌的TPU等都屬于ASIC,也就是專用集成電路。

ASIC(Application Specific Integrated Circuit)。顧名思義,ASIC就是根據特定的需求而專門設計并制造出的芯片,能夠優化芯片架構,針對性的提出神經網絡計算處理的指令集,因而在處理特定任務時,其性能、功耗等方面的表現優于 CPU、GPU 和 FPGA;但ASIC算法框架尚未統一,因此并未成為目前主流的解決方案。

如何評價蘋果A11處理器?

CPU:

發布會前,當4000/10000左右的GB4跑分泄露的時候,我既覺情理之中,又覺出乎意料。情理之中的是在移動SoC的晶體管開銷的限制下,Apple也已經摸到了單核性能的天花板,算一下會發現,A11和A10X單核的同頻性能是幾乎一樣的,已經沒多少手腳可以動了。意料之外的是,2big+4LITTLE的配比,居然能跑到上萬分。當時抱著手上的A10X酸酸地發了一下呆,之后我汗毛突然豎了起來。為什么?因為這意味著Apple很有可能在A11上使用了全新設計的Cache Coherent總線,使得大小核可以同時工作,并且衰減很低。之前一直覺得要是Ax開始堆核了,友商的ARM們怕是會很難受。3個月前在A10X上出現的時候,還覺得果然很遙遠,現在突然啪的一下產品就放在眼前了,速度之快令人咋舌。

從X光掃描圖可以看到,在臺積電10nm FFT的制程下,A11整體面積相對A10減小了30%,CPU部分也減小了30%,內存控制器減小了40%。但占用整個芯片的面積比例幾乎沒有發生變化,CPU只占了大約15%的面積,內存控制器占用了8%的面積。也就是說,光在CPU核心上,A11就比A10多了將近30%的晶體管(這遠不是多出來的2個小核可以達到的)。而在CPU性能上,A11與A10X對比是更加科學的,因為二者有著更加接近的頻率以及同樣的緩存結構。稍微算一下,我們能發現A11比A10X同頻單核心能提升了大約6%,可能是架構微調帶來的性能提升。在如此大的多核調度改進的同時,能穩步優化微架構,Apple也算是(比Intel)良心了。

GPU:

想起4月份Apple在挖空了PowerVR的人后宣布以后將不依賴PowerVR使用自主設計的GPU時,PVR股價大跌的慘狀。這到底是Apple挖墻腳搞技術壟斷,還是持著8%的股份不甘寂寞自導自演準備收購PVR,我們時至今日仍然不清楚Apple酒里賣的什么葫蘆。我們只知道,當時說好的“Within the next two years”怎么過了半年就出來了?這個研發效率和實力,我只能說,還有這種騷操作?不過從硬件本身的性能上來說,在Mali,Adreno的ALU,API都動不了都沒法繼續往上堆的時候,Apple的GPU也顯得保守,30%的提升似乎可以全部歸功于10nm制程。從掃描圖中可以看出來,A11的GPU面積相對于A10減少了40% (比Adreno540大了將近80%),也就是說從晶體管數量上看,二者區別不大。而再仔細瞧一眼,這個聲稱三核的自主核心,其實還是一個6核心的架構,Chipworks也認為跟A10的整體結構區別不大。那么我們能不能推測,Apple提到的30%的性能提升,只來自于10nm制程帶來的頻率提升(可能要達到1100MHz以上)和Metal2帶來的進一步針對性優化呢?還需要時間來驗證。

Connection:

A11的配套基有兩個型號,第一是在非CDMA地區使用的英特爾XMM7480(PMB9948)配合英特爾雙PMB5757射頻IC,最高Cat.15 4CA 800Mbps,官方的Product Brief如下:https://www.intel.com/content/dam/www/public/us/en/documents/platform-briefs/xmm-7480-brief.pdf

第二個是我們喜聞樂見的支持全網通的高通基帶X16 (MDM9655)配合高通單WTR5975射頻IC,最高支持Cat.16 4CA 1Gbps。

明明有14nm的Gigabite Modern XMM7560卻趕不上,只能說相當遺憾。也許這是iPhone團隊內夠用黨的又一次勝利,也許這是亦敵亦友的Intel拖后腿的無奈之舉,畢竟連XMM7480都幾乎不能如期交貨。

此外,A11還配套博通的BCM4361——首款支持BT5.0的通訊SoC,與三星S8屬于同款。因此A11搭載的機型支持BT5.0與2×2 MIMO WiFi,使得在無線連接性上能與驍龍835和獵戶座8895看齊。這點上,華為可能要閉嘴不敢吭聲了。

AI Relative:

對于新興的AI模塊/神經處理單元,我也屬于小白。現在僅有的兩個廠商的硬軟件實現思路可能會有比較大的差別,所以目前還沒有公認的評估體系去評價一個神經引擎的好與壞,我只能從最基礎的晶體管開銷,指令效率去大致推測其性能。A11比A10多了10億晶體管,Kirin970比Kirin960多了15億晶體管,考慮到4組G7x,我們可以大致說,A11的NE和Kirin970的寒武紀NPU使用了相近數量的晶體管。A11官網給出的是0.6T OPS(估計是FP32),而Kirin970官方給出的是1.92T OPS(未知是否包含了GPU的能力)。A11給出了與970 NPU類似的Neural Engine,搭配了與Zeroth類似的開發平臺Core ML用于機器學習,并且在發布會的時候,顯擺了一下他們已經做到的程度,如Stage light等特殊濾鏡,以及本由大型計算機完成的人臉識別與建模。雖然比起快了25X的寒武紀NPU是遜色了,但是這兩家的眼光和實力都是值得肯定的。

ISP/DSP:

4K@60Hz HDR HEVC編碼這個是首屈一指的,與8895規格相同,并且還支持240fps@1080P,是現今SoC中FHD慢速攝錄的最高規格。而在音頻方面,Apple至今還掐著Hi-res不肯支持也是首屈一指的。A11硬件本身配套的Codec對音頻的支持到了什么程度呢?我們看到iFixit的iPhone X拆解圖中,赫然出現了雙晶振,并且上面就是老牌音頻廠家Wolfson (已經被Cirrus收購)的IC,實在是讓人浮想聯翩,加上iPhone8/X新增了對FLAC的支持,是不是代表著Hi-Res的開放呢?

這兩塊iPhoneX獨占的多出來的小板讓X比8Plus多了35%的電路板面積

總結:

A11很強,相當強。待到845,9810等等規格都出來之后,再對比一下這些SoC,將會是一件非常有趣的事。

電子發燒友App

電子發燒友App

評論