摘要:

摘要: 標(biāo)簽比例學(xué)習(xí)問(wèn)題是一項(xiàng)僅使用樣本標(biāo)簽比例信息去構(gòu)建分類模型的挖掘任務(wù),由于訓(xùn)練樣本不充分,現(xiàn)有方法將該問(wèn)題視為單一任務(wù),在文本分類中的表現(xiàn)并不理想。考慮到遷移學(xué)習(xí)在一定程度上能解決訓(xùn)練數(shù)據(jù)不充分的問(wèn)題,于是如何利用歷史數(shù)據(jù)(原任務(wù)數(shù)據(jù))幫助新產(chǎn)生的數(shù)據(jù)(目標(biāo)任務(wù)數(shù)據(jù))進(jìn)行分類顯得異常重要。本文提出了一種基于標(biāo)簽比例信息的遷移學(xué)習(xí)算法,將知識(shí)從原任務(wù)遷移到目標(biāo)任務(wù),幫助目標(biāo)任務(wù)更好構(gòu)建分類器。為了獲得遷移學(xué)習(xí)模型,該方法將原始優(yōu)化問(wèn)題轉(zhuǎn)換為凸優(yōu)化問(wèn)題,然后解決對(duì)偶優(yōu)化問(wèn)題為目標(biāo)任務(wù)建立準(zhǔn)確的分類器。實(shí)驗(yàn)結(jié)果表明,大部分條件下所提算法性能優(yōu)于傳統(tǒng)方法。

1. 引言

在傳統(tǒng)監(jiān)督學(xué)習(xí)的分類問(wèn)題中,已知所有樣本的標(biāo)簽,分類器可以通過(guò)大量樣本屬性及其標(biāo)簽學(xué)習(xí)得到,進(jìn)而利用學(xué)習(xí)得到的分類器對(duì)未知標(biāo)簽的樣本進(jìn)行預(yù)測(cè)。但在實(shí)際應(yīng)用中,通過(guò)人工標(biāo)注獲取樣本標(biāo)簽需要較高成本,或者受限于隱私等客觀條件,有時(shí)無(wú)法獲取所有樣本的標(biāo)簽,而僅僅已知各類樣本的標(biāo)簽比例信息,比如在匿名投票中,只能知道反對(duì)票和贊成票的比例。因此,在已知樣本標(biāo)簽比例信息的前提下,以多個(gè)樣本組成的包為單位,基于包內(nèi)樣本和包的標(biāo)簽比例信息來(lái)訓(xùn)練從而獲取樣本層面的分類器,更加具有實(shí)用價(jià)值。

近年來(lái),標(biāo)簽比例學(xué)習(xí) [1] [2] (Learning with Label Proportions, LLP)在數(shù)據(jù)挖掘引起了廣泛的關(guān)注,并成功應(yīng)用于現(xiàn)實(shí)生活中的許多領(lǐng)域,如欺詐識(shí)別、銀行重要客戶識(shí)別、垃圾郵件過(guò)濾、視頻事件檢測(cè)、收入預(yù)測(cè)、視覺(jué)特征建模等。在標(biāo)簽比例學(xué)習(xí)問(wèn)題中,只知道每個(gè)包中屬于不同類別的樣本的比例,但是樣本的標(biāo)簽是未知的,它基于包層面的標(biāo)簽比例信息解決了樣本層面的分類問(wèn)題。

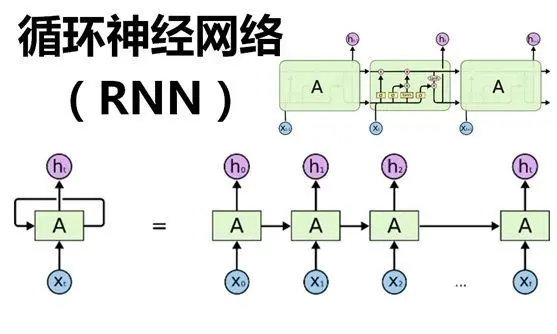

遷移學(xué)習(xí)(Transfer Learning) [3] [4] 是可以將知識(shí)從原任務(wù)(Source task)遷移到目標(biāo)任務(wù)(Target task)的一種新的機(jī)器學(xué)習(xí)方法,其運(yùn)用已存有的知識(shí)對(duì)不同但相關(guān)領(lǐng)域問(wèn)題進(jìn)行求解,遷移的知識(shí)可以幫助目標(biāo)任務(wù)建立遷移學(xué)習(xí)分類器以進(jìn)行預(yù)測(cè)。然而,大多數(shù)現(xiàn)有的方法都沒(méi)有考慮實(shí)踐中從原任務(wù)到目標(biāo)任務(wù)的知識(shí)遷移,將標(biāo)簽比例學(xué)習(xí)視為單一任務(wù),無(wú)法解決遷移學(xué)習(xí)問(wèn)題。

綜上所述,本文針對(duì)標(biāo)簽比例學(xué)習(xí)問(wèn)題,為了訓(xùn)練得到更準(zhǔn)確的分類器,提出了一種基于標(biāo)簽比例信息的遷移學(xué)習(xí)算法(label proportion information-based transfer learning method, LPI-TL),該方法可以利用遷移學(xué)習(xí)將知識(shí)從原任務(wù)遷移到目標(biāo)任務(wù),幫助目標(biāo)任務(wù)構(gòu)建分類器。首先為了幫助目標(biāo)任務(wù)學(xué)習(xí)預(yù)測(cè)模型,本文提出了一種遷移學(xué)習(xí)模型,然后使用拉格朗日方法將方法的原始問(wèn)題轉(zhuǎn)換為凸優(yōu)化問(wèn)題并求解,最后獲得目標(biāo)任務(wù)的預(yù)測(cè)分類器。實(shí)驗(yàn)結(jié)果表明,本文方法在標(biāo)簽比例問(wèn)題上能取得更好的性能。

本文主要貢獻(xiàn)如下:

1) 結(jié)合支持向量回歸算法提出了基于標(biāo)簽比例信息的遷移學(xué)習(xí)模型,該模型可以利用遷移學(xué)習(xí)將知識(shí)從原任務(wù)遷移到目標(biāo)任務(wù)。

2) 利用拉格朗日方法將原始目標(biāo)模型轉(zhuǎn)換為凸優(yōu)化問(wèn)題,并獲得原任務(wù)和目標(biāo)任務(wù)的預(yù)測(cè)模型。

3) 在多個(gè)數(shù)據(jù)集上進(jìn)行廣泛實(shí)驗(yàn),并與現(xiàn)有算法進(jìn)行對(duì)比,驗(yàn)證了提出算法的有效性。

2. 問(wèn)題描述與相關(guān)工作

2.1. 問(wèn)題描述

在標(biāo)簽比例學(xué)習(xí)問(wèn)題中,一個(gè)包內(nèi)含有多個(gè)樣本,僅知道包中不同類別樣本的標(biāo)簽比例信息。本文定義包的標(biāo)簽比例為包中正樣本的比例。假設(shè)給定的原任務(wù)數(shù)據(jù)集為 D={x1,x2,?,xn}D={x1,x2,?,xn},則每個(gè)樣本xi所對(duì)應(yīng)的標(biāo)簽yi未知,數(shù)據(jù)會(huì)被分為t1個(gè)互相獨(dú)立的包 (BsI,PsI),I=1,2,?,ti(BIs,PIs),I=1,2,?,ti,其中 BsIBIs 和 PsIPIs 分別表示原任務(wù)數(shù)據(jù)集的第I個(gè)包和包中正樣本的比例 PsI=∣∣{xi∈BsI:yi=1}∣∣/∣∣BsI∣∣PIs=|{xi∈BIs:yi=1}|/|BIs|,同理,目標(biāo)任務(wù)數(shù)據(jù)集用 (BtJ,PtJ),J=1,2,?,t2(BJt,PJt),J=1,2,?,t2 表示。

對(duì)于二元分類問(wèn)題,標(biāo)簽比例學(xué)習(xí)任務(wù)是學(xué)習(xí)一個(gè)分類器將未知標(biāo)簽樣本分為正類或負(fù)類。如圖1所示:圖左邊的黑色橢圓表示包,黑色圓圈表示未標(biāo)記的樣本。在圖的右邊,加號(hào)“+”和減號(hào)“?”分別表示分類后的正樣本和負(fù)樣本,實(shí)線表示由標(biāo)簽比例和未標(biāo)記的樣本訓(xùn)練得到的分類器。

Figure 1. Two-class label proportions learning problem

圖1. 二分類標(biāo)簽比例學(xué)習(xí)問(wèn)題

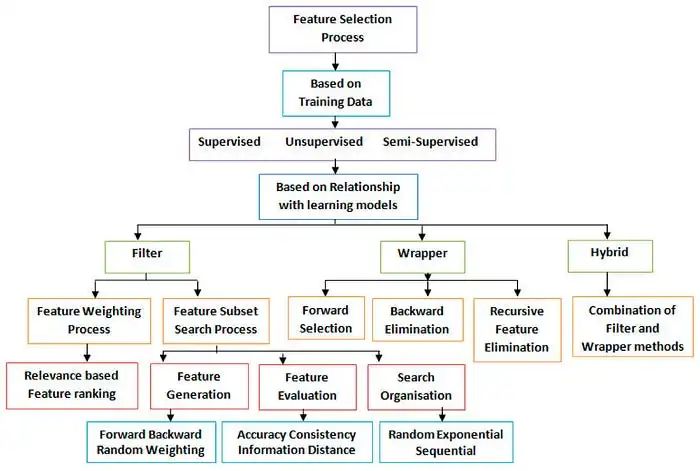

2.2. 相關(guān)工作

本目前,國(guó)內(nèi)外有多種標(biāo)簽比例學(xué)習(xí)分類方法的研究,主要分為概率模型和支持向量機(jī)模型兩類。

基于概率模型的分類方法。文獻(xiàn) [5] 假設(shè)給定類變量的預(yù)測(cè)變量之間具有條件獨(dú)立性,并采用了三種期望最大化算法來(lái)學(xué)習(xí)樸素貝葉斯模型。文獻(xiàn) [6] 通過(guò)估計(jì)條件類密度來(lái)估計(jì)后驗(yàn)概率,從貝葉斯角度提出一種新的學(xué)習(xí)框架,并且利用估計(jì)對(duì)數(shù)概率的網(wǎng)絡(luò)模型來(lái)求解分類問(wèn)題的后驗(yàn)概率。文獻(xiàn) [7] 構(gòu)建了一個(gè)應(yīng)用于美國(guó)總統(tǒng)大選的概率方法,該方法使用基數(shù)勢(shì)在學(xué)習(xí)過(guò)程中對(duì)潛在變量進(jìn)行推理,并引入了一種新的消息傳遞算法,將基數(shù)勢(shì)擴(kuò)展到多變量概率模型。文獻(xiàn) [8] 開(kāi)發(fā)模型并使用Twitter數(shù)據(jù)來(lái)估算美國(guó)總統(tǒng)大選期間政治情緒與人口統(tǒng)計(jì)之間的關(guān)系。

基于支持向量機(jī)(Support Vector Machine, SVM)的分類方法。文獻(xiàn) [9] 提出InvCal算法,該方法可以利用樣本的比例信息,反推出分類器,使得分類器預(yù)測(cè)出的樣本比例與實(shí)際比例相近。文獻(xiàn) [10] 提出了Alter-SVM算法并通過(guò)交替優(yōu)化的方法最小化損失函數(shù)。該方法在標(biāo)準(zhǔn)SVM模型的基礎(chǔ)上加入了比例損失的約束項(xiàng),使得模型得到每個(gè)包的比例與實(shí)際比例盡可能接近。在文獻(xiàn) [10] 的基礎(chǔ)上,文獻(xiàn) [11] 提出了一種基于二支持向量機(jī)的分類模型,模型被轉(zhuǎn)換為兩個(gè)更小的二分類問(wèn)題求解。文獻(xiàn) [12] 首先分析了比例學(xué)習(xí)問(wèn)題中的結(jié)構(gòu)化信息,并利用數(shù)據(jù)點(diǎn)的幾何信息引入拉普拉斯項(xiàng)并且討論了如何將比例學(xué)習(xí)框架與拉普拉斯項(xiàng)結(jié)合。文獻(xiàn) [13] 提出了一種基于非平行支持向量機(jī)的解決方案并將分類器改進(jìn)為一對(duì)非平行分類超平面。

盡管對(duì)標(biāo)簽比例學(xué)習(xí)的研究已經(jīng)比較深入,然而大部分研究?jī)H將該問(wèn)題視為單一任務(wù),沒(méi)有利用歷史數(shù)據(jù)彌補(bǔ)訓(xùn)練樣本不充分的不足,不能很好地體現(xiàn)出分類器的效果。不同于大部分已有的工作,本文從遷移學(xué)習(xí)角度出發(fā),利用遷移學(xué)習(xí)可以在相似領(lǐng)域中幫助新領(lǐng)域目標(biāo)任務(wù)學(xué)習(xí)的特性,提出了一種基于標(biāo)簽比例信息的遷移學(xué)習(xí)方法,該方法基于支持向量回歸方法并結(jié)合樣本組成的包構(gòu)建模型,并給出了目標(biāo)方程從而解決了遷移學(xué)習(xí)方法運(yùn)用于標(biāo)簽比例學(xué)習(xí)分類的問(wèn)題。

3. 標(biāo)簽比例學(xué)習(xí)算法

由于只通過(guò)標(biāo)簽比例信息無(wú)法直接訓(xùn)練分類函數(shù),參考InvCal [9] 中利用標(biāo)簽比例信息反推出分類器的操作,提出的方法使用Platt尺度函數(shù) [14] 并反解求出y:

3.1. 目標(biāo)函數(shù)

除對(duì)于具有相關(guān)性的原任務(wù)數(shù)據(jù)集和目標(biāo)任務(wù)數(shù)據(jù)集,該算法使用f1和f2分別表示原任務(wù)和目標(biāo)任務(wù)分類器:

其中 w1=w0+v1w1=w0+v1, w2=w0+v2w2=w0+v2,w0表示分離超平面的權(quán)向量公共參數(shù),v1和v2為增量參數(shù),原任務(wù)和目標(biāo)任務(wù)越相似,則v1和v2越“小”,b1和b2是偏差。

本文對(duì)每個(gè)包中所有樣本求平均值得到一個(gè)平均數(shù)樣本來(lái)代表包,并利用支持向量回歸算法對(duì)所得到的平均數(shù)樣本求回歸方程,于是LLP問(wèn)題轉(zhuǎn)換為求解如下目標(biāo)函數(shù):

其中: ξtiξti 和 ξ?ti(t=1,2)ξti?(t=1,2) 為訓(xùn)練誤差, ε1iε1i 和 ε2mε2m 為可容忍損失,控制 εε 損失帶的大小;參數(shù) λ1λ1 和 λ2λ2 用來(lái)控制原任務(wù)和目標(biāo)任務(wù)權(quán)重,C1和C2是邊緣與經(jīng)驗(yàn)損失的權(quán)衡參數(shù)。

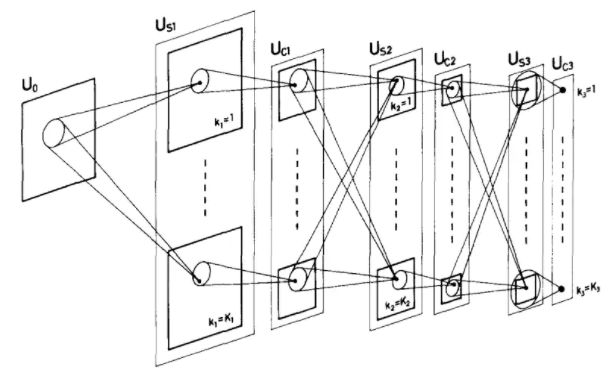

為了更好地理解遷移學(xué)習(xí),圖2示意了知識(shí)遷移的基本思想。圖2中圓圈表示樣本,圓圈內(nèi)數(shù)字表示樣本所屬包的編號(hào),每個(gè)包都有兩個(gè)未知標(biāo)簽的樣本,只知道包中正樣本的比例為50%;實(shí)線和虛線則分別表示分類器和間隔邊界。在圖的右邊,紅色圓圈表示目標(biāo)任務(wù)樣本,當(dāng)僅利用目標(biāo)任務(wù)樣本構(gòu)建分類。

Figure 2. Transfer knowledge from the source task to the target task

圖2. 原任務(wù)遷移知識(shí)到目標(biāo)任務(wù)

3.2. 對(duì)偶問(wèn)題

由于目標(biāo)函數(shù)公式5為凸函數(shù),引入拉格朗日乘子,公式5轉(zhuǎn)換為其對(duì)偶問(wèn)題,等同為最小化下式:

具體算法求解過(guò)程如表1所示。

| 算法:LPI-TL |

|

輸入:?(?B?I?s?,?P?I?s?)?,?I?=?1?,?2?,???,?t?1?,?(?B?J?t?,?P?J?t?)?,?J?=?1?,?2?,???,?t?2?, λ?1?,?λ?2?,?C?1?,?C?2?,?ε 輸出:?w?1?,?w?2?,?b?1?,?b?2 方法: a):For i=1:(t1+t2) b):?y?i?=???log?(?1?p?i???1?) c): End d): 調(diào)用Matlab的CVX包求解公式6,解得拉格朗日乘子a e): 將a代入公式(7)-(9)求得w1,w2 f): 將w1,w2,yi代入公式3和公式4可解得b1,b2 |

Table 1. LPI-TL Algorithm

表1. LPI-TL算法流程

3.3. 時(shí)間復(fù)雜度分析

對(duì)于提出的LPI-TL算法,假設(shè)求解標(biāo)準(zhǔn)SVM的時(shí)間復(fù)雜度為 O([數(shù)據(jù)量]2)Ο([數(shù)據(jù)量]2),則在本文中解決公式6等同于求解一個(gè)數(shù)據(jù)量為M個(gè)原任務(wù)樣本和N個(gè)目標(biāo)任務(wù)樣本的標(biāo)準(zhǔn)SVM問(wèn)題,則最終的時(shí)間復(fù)雜度為 O((M+N)2)Ο((M+N)2)。

4. 實(shí)驗(yàn)與分析

為驗(yàn)證所提出算法的有效性,本文設(shè)計(jì)了數(shù)據(jù)實(shí)驗(yàn)來(lái)驗(yàn)證所述方法,并采用Inv-Cal [8],Alter-SVM [9] 和p-NPSVM [12] 作為對(duì)比方法。

4.1. 實(shí)驗(yàn)數(shù)據(jù)

論本文采用SRAA1和20 Newsgroups2數(shù)據(jù)集,這兩個(gè)數(shù)據(jù)集是用于文本分類、文本挖掘和信息檢索研究的國(guó)際標(biāo)準(zhǔn)數(shù)據(jù)集之一,并被廣泛用于遷移學(xué)習(xí)實(shí)驗(yàn)。SRAA數(shù)據(jù)集包含來(lái)自四個(gè)討論組的7327個(gè)UseNet文章,里面包含著模擬賽車,模擬航空,真實(shí)汽車,真實(shí)航空四個(gè)主題的數(shù)據(jù)。20 Newsgroups數(shù)據(jù)集收集了大約20,000左右的新聞組文檔,每個(gè)頂級(jí)類別下都有20個(gè)子類別,每個(gè)子類別都有1000個(gè)樣本。有一些新聞之間是相關(guān)的,比如Sci.elec vs. Sci.med;有一些新聞是不相關(guān)的,比如Sci.cryptvs.Alt.atheism。

由于上述兩個(gè)數(shù)據(jù)集不是專門(mén)為L(zhǎng)LP問(wèn)題設(shè)置,需要將文本數(shù)據(jù)集重新組織為適用于標(biāo)簽比例學(xué)習(xí)問(wèn)題的數(shù)據(jù)集。采用文獻(xiàn) [15] [16] 處理上述數(shù)據(jù)集的方法,我們根據(jù)數(shù)據(jù)集的頂級(jí)類別重新組織LLP數(shù)據(jù)集。首先,我們從頂級(jí)類別(A)中選擇一個(gè)子類別a(1)作為正類別,因此將該子類別a(1)中的每個(gè)樣本視為正類樣本,其他頂級(jí)類別作為負(fù)類別。其次,對(duì)于原任務(wù),我們從正子類別a(1)中隨機(jī)選擇多個(gè)樣本作為正樣本,并從其他類別中隨機(jī)選取相同數(shù)目的樣本作為負(fù)樣本,并將它們組成為原任務(wù)數(shù)據(jù)集。對(duì)目標(biāo)任務(wù)執(zhí)行相同的操作以形成正類樣本和負(fù)類樣本。為了使兩個(gè)任務(wù)相關(guān),我們讓原任務(wù)和目標(biāo)任務(wù)的正類具有相同的頂級(jí)類別,例如原任務(wù)為a(1),則目標(biāo)任務(wù)為a(2)。在不損失有效性的情況下,我們僅保留具有較高文檔頻率的單詞以減少維數(shù),并且每個(gè)樣本均由特征表示。最后隨機(jī)選取同等比例的正樣本和負(fù)樣本生成5個(gè)數(shù)據(jù)集,如表2所示。

| 編號(hào) | 原任務(wù) | 樣本個(gè)數(shù) | 目標(biāo)任務(wù) | 樣本個(gè)數(shù) |

| 1 | Simauto | 3000 | Realauto | 800 |

| 2 | Auto | 3000 | Aviation | 800 |

| 3 | Sci-elec | 5000 | Sci-med | 1500 |

| 4 | Rec.autos | 5000 | Rec.motor | 1500 |

| 5 | Spo.baseball | 5000 | Spo.hockey | 1500 |

Table 2. The list of data sets

表2. 數(shù)據(jù)集列表

4.2. 實(shí)驗(yàn)設(shè)置

為減少包中樣本數(shù)量對(duì)實(shí)驗(yàn)結(jié)果的影響,本實(shí)驗(yàn)從每個(gè)數(shù)據(jù)集中分別隨機(jī)選擇20,40和60個(gè)樣本組成包,并分別對(duì)大小不同的包依次進(jìn)行實(shí)驗(yàn),其中對(duì)四個(gè)算法的參數(shù)設(shè)置如下:

其中本文方法使用線性核函數(shù) K(x1,x2)=x1?x2K(x1,x2)=x1?x2,采用五折交叉驗(yàn)證法進(jìn)行實(shí)驗(yàn)。由于Inv-Cal,Alter-SVM和p-NPSVM為單一任務(wù)算法,對(duì)其只在目標(biāo)數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),對(duì)提出的算法則使用原任務(wù)數(shù)據(jù)集和目標(biāo)任務(wù)數(shù)據(jù)集進(jìn)行實(shí)驗(yàn)。

4.3. 實(shí)驗(yàn)結(jié)果分析

首先,利用本文提出的基于標(biāo)簽比例信息的遷移學(xué)習(xí)算法遷移原任務(wù)數(shù)據(jù)知識(shí)來(lái)對(duì)目標(biāo)任務(wù)數(shù)據(jù)集進(jìn)行實(shí)驗(yàn),并采用準(zhǔn)確率、精度、召回率和F1值等評(píng)價(jià)指標(biāo)與Inv-Cal,Alter-SVM和p-NPSVM對(duì)比。

五個(gè)數(shù)據(jù)集具體的平均測(cè)試準(zhǔn)確率和標(biāo)準(zhǔn)差實(shí)驗(yàn)結(jié)果如表3所示。表3表明,在數(shù)據(jù)集3包的大小為20以及數(shù)據(jù)集4包的大小為40和60中,本文提出算法比其他方法略低外,在其他實(shí)驗(yàn)結(jié)果中均能取得最高準(zhǔn)確率和較低的標(biāo)準(zhǔn)差。圖3展示了這四個(gè)算法的平均準(zhǔn)確率的柱狀圖,其中四個(gè)算法的平均準(zhǔn)確率分別為:62.44%、63.09%、63.38%和67.77%,可見(jiàn)提出的算法LPI-TL的平均準(zhǔn)確率高于Inv-Cal,Alter-SVM和p-NPSVM三個(gè)算法。這表明提出的方法在通過(guò)遷移原任務(wù)數(shù)據(jù)知識(shí)在分類準(zhǔn)確率上能取得較高且穩(wěn)定的性能。

另外,為了將其他算法與提出的LPI-TL方法進(jìn)一步比較,將對(duì)上面實(shí)驗(yàn)得到的準(zhǔn)確率做Wilcoxon符號(hào)秩和檢驗(yàn) [17] [18]。通常,如果測(cè)試值p值低于置信度0.05,則LPI-TL與所比較的方法之間存在顯著差異。對(duì)于每種方法,其與LPI-TL之間的測(cè)試結(jié)果列在表4中。從表中可以看出,每種方法對(duì)LPI-TL的p值均小于置信度0.05,這意味著在統(tǒng)計(jì)視角中,本文提出的算法LPI-TL比其他三個(gè)方法在準(zhǔn)確率上取得顯著性提高。

為了進(jìn)一步驗(yàn)證本文提出算法的性能,對(duì)5個(gè)數(shù)據(jù)集在包為20的情況下分別計(jì)算準(zhǔn)確率、召回率和F1值等指標(biāo)的平均值。實(shí)驗(yàn)結(jié)果如表5所示。從表中可以看出,LPI-TL算法平均召回率比Alter-SVM算

| 數(shù)據(jù)集 | 算法 | 20 | 40 | 60 |

| 1 | Inv-Cal | 64.87 ± 1.60 | 60.42 ± 1.04 | 56.31 ± 2.00 |

| Alter-SVM | 62.53 ± 1.31 | 60.13 ± 1.20 | 60.72 ± 1.45 | |

| p-NPSVM | 66.72 ± 0.47 | 63.23 ± 0.96 | 60.02 ± 1.52 | |

| LPI-TL | 70.97 ± 0.37 | 68.60 ± 0.75 | 65.87 ± 1.22 | |

| 2 | Inv-Cal | 71.47 ± 0.70 | 68.37 ± 1.26 | 63.62 ± 1.06 |

| Alter-SVM | 70.03 ± 0.95 | 66.47 ± 0.97 | 63.03 ± 0.98 | |

| p-NPSVM | 71.30 ± 1.02 | 65.50 ± 1.11 | 65.31 ± 1.00 | |

| LPI-TL | 72.65 ± 0.41 | 72.57 ± 0.95 | 69.79 ± 0.82 | |

| 3 | Inv-Cal | 62.23 ± 0.73 | 59.52 ± 2.31 | 55.91 ± 1.79 |

| Alter-SVM | 60.52 ± 1.28 | 58.68 ± 1.45 | 56.76 ± 1.21 | |

| p-NPSVM | 63.22 ± 1.52 | 62.07 ± 1.35 | 57.82 ± 0.48 | |

| LPI-TL | 63.00 ± 0.73 | 64.32 ± 1.02 | 63.02 ± 0.75 | |

| 4 | Inv-Cal | 60.81 ± 1.47 | 62.02 ± 1.72 | 59.91 ± 1.79 |

| Alter-SVM | 64.07 ± 1.08 | 62.59 ± 0.93 | 60.06 ± 1.41 | |

| p-NPSVM | 61.19 ± 1.11 | 58.65 ± 1.03 | 56.02 ± 0.88 | |

| LPI-TL | 64.25 ± 0.92 | 62.03 ± 0.87 | 59.82 ± 0.75 | |

| 5 | Inv-Cal | 65.28 ± 1.32 | 63.56 ± 0.52 | 62.24 ± 1.24 |

| Alter-SVM | 70.32 ± 0.96 | 65.27 ± 0.76 | 65.21 ± 0.91 | |

| p-NPSVM | 68.02 ± 1.23 | 65.42 ± 1.04 | 66.13 ± 1.08 | |

| LPI-TL | 75.33 ± 0.62 | 73.56 ± 0.52 | 70.82 ± 0.53 |

Table 3. Experimental accuracy and standard deviation Statistics

表3. 實(shí)驗(yàn)準(zhǔn)確率和標(biāo)準(zhǔn)差結(jié)果統(tǒng)計(jì)

Figure 3. The mean accuracy

圖3. 平均準(zhǔn)確率

| LPI-TL | R+ | R- | p-value |

| vs. Inv-Cal | 118 | 2 | 0.0062 |

| vs. Alter-SVM | 115 | 5 | 0.0144 |

| vs. p-NPSVM | 119 | 1 | 0.0380 |

Table 4. Wilcoxon signed ranks test.

表4. Wilcoxon符號(hào)秩和檢驗(yàn)

| 算法 | 平均精度 | 平均召回率 | 平均F1值 |

| InvCal | 0.501 | 0.648 | 0.565 |

| Alter-SVM | 0.462 | 0.672 | 0.548 |

| p-NPSVM | 0.499 | 0.662 | 0.569 |

| LPI-TL | 0.554 | 0.667 | 0.606 |

Table 5. Performance comparison of each algorithm

表5. 各個(gè)算法性能對(duì)比

法低,這是由于Alter-SVM算法找出更多的負(fù)樣本,所以召回率更高;相比之下,LPI-TL算法取得更大的精度和F1值。總體來(lái)看,本文提出的LPI-TL算法的結(jié)果比對(duì)比方法更佳。

5. 結(jié)束語(yǔ)

本文對(duì)基于標(biāo)簽比例信息的遷移學(xué)習(xí)進(jìn)行了研究,為了目標(biāo)任務(wù)能更有效的學(xué)習(xí)預(yù)測(cè)模型,本文提出了一種遷移學(xué)習(xí)的模型用于從標(biāo)簽比例信息中學(xué)習(xí)分類器,該方法能將知識(shí)從原任務(wù)遷移到目標(biāo)任務(wù),并可以幫助目標(biāo)任務(wù)構(gòu)建分類器。本文實(shí)施了大量的實(shí)驗(yàn)去研究該方法的性能,實(shí)驗(yàn)表明該方法優(yōu)于現(xiàn)有的LLP方法。該方法的不足之處在于僅能處理二分類問(wèn)題還無(wú)法處理多分類數(shù)據(jù),將來(lái)希望將該方法應(yīng)用于多分類問(wèn)題,這個(gè)問(wèn)題值得后續(xù)進(jìn)一步研究。

審核編輯:湯梓紅

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論