自動(dòng)駕駛的軌跡預(yù)測必須不斷推理路上智能體的隨機(jī)運(yùn)動(dòng)并遵守場景約束。現(xiàn)有方法通常依賴于一階段軌跡預(yù)測模型,該模型根據(jù)觀察到的軌跡結(jié)合融合的場景信息來確定未來軌跡。然而,他們經(jīng)常與復(fù)雜的場景約束作斗爭,例如在十字路口遇到的約束。為此,論文提出了一種稱為LAformer的新方法。它使用時(shí)間上稠密的車道感知估計(jì)模塊僅選擇HD地圖中最有潛力的車道段,從而有效且連續(xù)地將運(yùn)動(dòng)動(dòng)態(tài)與場景信息對(duì)齊,通過過濾掉不相關(guān)的車道段減少后續(xù)基于注意力的解碼器的表示要求。此外,與一階段預(yù)測模型不同,LAformer 利用第一階段的預(yù)測作為錨點(diǎn)軌跡,并添加第二階段運(yùn)動(dòng)細(xì)化模塊,以進(jìn)一步探索整個(gè)時(shí)間范圍內(nèi)的時(shí)間一致性。在Argoverse1和nuScenes上進(jìn)行的大量實(shí)驗(yàn)表明,LAformer在多模態(tài)軌跡預(yù)測方面取得了出色的性能。

介紹

準(zhǔn)確的軌跡預(yù)測對(duì)于在涉及與各種道路智能體交互的各種交通場景中實(shí)現(xiàn)自動(dòng)駕駛至關(guān)重要。由于智能體的隨機(jī)行為及其相互影響,加上環(huán)境場景上下文的變化,軌跡預(yù)測仍然是一項(xiàng)極具挑戰(zhàn)性的任務(wù)。因此,這項(xiàng)任務(wù)需要有效地學(xué)習(xí)智能體的運(yùn)動(dòng)動(dòng)力和與其他智能體的交互,以及仔細(xì)考慮場景約束。

已經(jīng)開發(fā)了許多數(shù)據(jù)驅(qū)動(dòng)的方法來解決軌跡預(yù)測問題,從順序軌跡中提取運(yùn)動(dòng)信息和光柵化地圖數(shù)據(jù)中提取場景上下文信息,然后將它們?cè)跐撛诳臻g中進(jìn)行融合作為多模態(tài)解碼器的輸入,如Trajectron++ [39]、CoverNet [34] 和AgentFormer [47]等工作所述。然而,這些方法未能在后續(xù)解碼模塊的早期階段利用空間和時(shí)間信息。此外,柵格化地圖需要大量的感受野過濾器和計(jì)算成本來感知場景上下文,在復(fù)雜的交叉路口,這可能無法提供準(zhǔn)確的道路結(jié)構(gòu)特征,特別是對(duì)于車輛軌跡預(yù)測。因此,解碼器可能會(huì)生成不符合場景的軌跡預(yù)測。為了緩解這個(gè)問題,VectorNet [10] 建議將軌跡和高清 (HD) 地圖數(shù)據(jù)統(tǒng)一為一致的矢量化形式。這種矢量化使基于高清地圖的軌跡和車道段能夠用相同的編碼器輕松處理和融合。

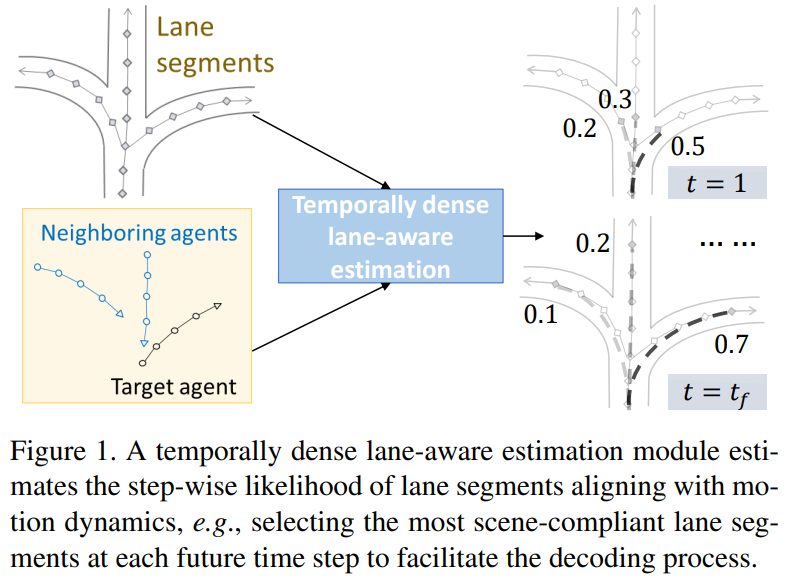

已經(jīng)有很多探索車道段的嘗試,包括深度特征融合,例如 [20, 48] 和啟發(fā)式搜索,例如 [9]. 論文進(jìn)一步將主流方法分類為空間和時(shí)間密集的方法。當(dāng)前的大多數(shù)方法都屬于前一種方法,它估計(jì)稠密概率目標(biāo)候選 [50、15]、端點(diǎn) [43、11、12] 的分段建議點(diǎn)或投影到給定場景的整個(gè)序列編碼 [9]。論文認(rèn)為這些方法不是最優(yōu)的,因?yàn)槿绻诔跏疾襟E中預(yù)測準(zhǔn)確,則可能會(huì)出現(xiàn)復(fù)合預(yù)測錯(cuò)誤。相比之下,時(shí)間稠密的方法試圖估計(jì)運(yùn)動(dòng)狀態(tài)在每個(gè)時(shí)間步與車道位置對(duì)齊的可能性。因此,如果運(yùn)動(dòng)狀態(tài)和車道段隨著時(shí)間的推移而偏離,解碼器就有更好的機(jī)會(huì)調(diào)整其預(yù)測。然而,這并非微不足道,因?yàn)楣烙?jì)模塊需要考慮車道段的可變性和運(yùn)動(dòng)狀態(tài)的不確定性。此外,當(dāng)自車輛處于具有多個(gè)平行車道的交叉路口時(shí),或者當(dāng)自車輛進(jìn)行車道變換或轉(zhuǎn)彎時(shí),僅基于距離度量 [12] 的對(duì)齊是不夠的。然而,在探索時(shí)間稠密方法上并沒有太多研究,也沒有太多關(guān)注有選擇地將地圖信息提供給解碼器以促進(jìn)解碼過程。

為此,論文提出了一種時(shí)間密集的方法,稱為LAformer。LAformer的本質(zhì)如圖1所示。它利用車道感知估計(jì)模塊在每個(gè)時(shí)間步僅選擇前k個(gè)高潛力車道段,從而有效且連續(xù)地將運(yùn)動(dòng)動(dòng)態(tài)與場景信息對(duì)齊。具體來說,論文采用基于注意力的編碼器,稱為全局交互圖 (GIG),從統(tǒng)一的矢量化軌跡和高清地圖中提取時(shí)空特征。不同于 [43、11、12、9] 等空間稠密方法,論文使用從 GIG 模塊提取的車道信息和目標(biāo)智能體的運(yùn)動(dòng)(包括速度和方向信息)訓(xùn)練二元分類器,以在整個(gè)預(yù)測時(shí)間范圍內(nèi)進(jìn)行逐步車道選擇。然后,論文引入拉普拉斯混合密度網(wǎng)絡(luò) (MDN) 來生成僅與選定的車道段對(duì)齊的符合場景的多模態(tài)軌跡預(yù)測。通過這種方式,過濾掉不相關(guān)的車道段以減少解碼過程的表示要求。

此外,為了進(jìn)一步利用整個(gè)時(shí)間范圍內(nèi)的時(shí)間一致性,論文引入了一個(gè)運(yùn)動(dòng)細(xì)化模塊。LAformer 利用第一階段的預(yù)測作為錨點(diǎn)軌跡,這與使用預(yù)定義錨點(diǎn)的基于錨點(diǎn)的軌跡預(yù)測方法不同 [3, 41]。然后第二階段運(yùn)動(dòng)細(xì)化模塊將觀察到的和預(yù)測的軌跡作為輸入以進(jìn)一步減少預(yù)測偏移,這與第一階段不同。盡管這種改進(jìn)模塊的策略在計(jì)算機(jī)視覺任務(wù)中并不是特別新鮮,但據(jù)論文所知,本文是第一個(gè)有效地將其應(yīng)用于改進(jìn)軌跡預(yù)測的。

本文的主要貢獻(xiàn)總結(jié)如下:

本文提出了一種新的時(shí)間密集車道感知選擇方法,以在每個(gè)預(yù)測時(shí)間步識(shí)別前k個(gè)高可能性車道段,這與以前的空間稠密方法不同。這種選擇方法有助于車道條件下解碼器進(jìn)行軌跡預(yù)測。

論文利用第一階段的預(yù)測軌跡作為錨點(diǎn)軌跡,并引入第二階段的運(yùn)動(dòng)細(xì)化模塊,該模塊同時(shí)考慮觀察到的和預(yù)測的軌跡。細(xì)化模塊進(jìn)一步探索過去和未來時(shí)間范圍內(nèi)的時(shí)間一致性。

論文證明了LAformer 在兩個(gè)基準(zhǔn)數(shù)據(jù)集上的有效性,即Argoverse1 [4]和nuScenes [2] 它在兩個(gè)基準(zhǔn)測試中都取得了出色的性能,并在多模態(tài)運(yùn)動(dòng)預(yù)測任務(wù)中表現(xiàn)出卓越的泛化性能。

相關(guān)工作

智能體之間交互建模

智能體相互連接以實(shí)現(xiàn)社交聯(lián)系和避免碰撞 [33, 17]。大多數(shù)深度學(xué)習(xí)模型,例如 [1, 24, 16, 38, 39, 47],使用智能體的隱藏狀態(tài)來聚合交互操作信息。最流行的聚合策略包括池化 [1、7、10]、使用圖卷積網(wǎng)絡(luò) (GCN) [44] 的消息傳遞 [49、46、48],以及注意力機(jī)制 [47、26、5]。為了根據(jù)周圍智能體的相對(duì)位置和屬性區(qū)分周圍智能體的影響,論文建議在這項(xiàng)工作中使用注意機(jī)制進(jìn)行交互建模。

預(yù)測多模態(tài)軌跡

在自動(dòng)駕駛軌跡預(yù)測的背景下,預(yù)測不同的多模態(tài)軌跡比單一模態(tài)軌跡更有利于應(yīng)對(duì)智能體的不確定行為和場景約束。生成模型,例如生成對(duì)抗網(wǎng)絡(luò) (GAN) [14]、變分自動(dòng)編碼器 (VAE) [23] 和條件 VAE [22] 以及流 [35],使用基于采樣的方法生成多個(gè)預(yù)測 [16, 24, 36, 6]。然而,它們并沒有提供對(duì)每種模態(tài)可能性的直接估計(jì)。雖然高斯混合密度網(wǎng)絡(luò) (MDN) 可以提供概率密度函數(shù)來學(xué)習(xí)模態(tài)分布,但與生成模型類似,當(dāng)只有一個(gè)真值軌跡用于監(jiān)督學(xué)習(xí)時(shí),它們經(jīng)常遇到所謂的模態(tài)崩潰問題 [37]。為了緩解模態(tài)崩潰問題,本文探索了拉普拉斯 MDN 與贏者通吃策略的使用 [28、52、9]。此外,為了增加模態(tài)多樣性,一些方法會(huì)生成過多的預(yù)測并采用集成技術(shù)(例如聚類或非最大抑制)將預(yù)測減少為有限數(shù)量的模態(tài) [41、43]。然而,這種集成過程對(duì)于實(shí)時(shí)自動(dòng)駕駛汽車來說是耗時(shí)且不切實(shí)際的 [52]。因此,本文不采用這種技術(shù)。

提取場景上下文信息

為了預(yù)測符合場景的軌跡,必須考慮場景上下文。卷積神經(jīng)網(wǎng)絡(luò) (CNN) 通常用于從鳥瞰圖像中提取場景上下文,例如具有一般上下文的RGB圖像 [24、38] 和具有不同場景類別的語義圖 [34、39、47]。然而,CNN 難以捕獲細(xì)粒度的場景信息,例如車道幾何形狀和交通規(guī)則。此外,柵格化數(shù)據(jù)的稀疏信息導(dǎo)致計(jì)算效率較低,需要強(qiáng)大的融合模塊來為預(yù)測模塊對(duì)齊異構(gòu)運(yùn)動(dòng)和場景信息。為了應(yīng)對(duì)這些挑戰(zhàn),可以使用統(tǒng)一的矢量化方案 [10] 來對(duì)齊高清地圖中的軌跡和車道。由點(diǎn)、折線和多邊形表示的軌跡和場景上下文都被編碼在一個(gè)具有坐標(biāo)信息和各種智能體或車道屬性的統(tǒng)一向量中 [25、15、52、5、31、9、43]。論文的場景感知軌跡預(yù)測方法采用了這種數(shù)據(jù)表示。

已經(jīng)提出了幾種方法利用基于車道的場景信息來指導(dǎo)預(yù)測過程。基于建議的模型[7, 40]對(duì)智能體的操作進(jìn)行分類,然后相應(yīng)地預(yù)測后續(xù)軌跡。基于目標(biāo)的模型預(yù)測位于合理車道中的可行目標(biāo)[36、50、15、11、12],然后生成完整的軌跡。其他方法使用一組對(duì)應(yīng)于軌跡分布模態(tài)的固定的錨來回歸預(yù)測的多模態(tài)軌跡 [3, 41]。或者,[51] 提出了一種方法,將智能體當(dāng)前位置的歷史軌跡集合視為先驗(yàn)信息,以縮小潛在未來軌跡的搜索空間。論文將這些方法歸類為基于空間稠密車道的方法,因?yàn)樗鼈儗W⒂谏珊蜻x目標(biāo)或空間上完整軌跡的概率分布。然而,這些方法沒有充分探索時(shí)間信息來解釋運(yùn)動(dòng)的不確定性和場景隨時(shí)間的變化。此外,預(yù)測模塊必須隱式地過濾掉不相關(guān)的場景信息,這在復(fù)雜的場景約束(例如十字路口處的場景)中可能具有挑戰(zhàn)性。

與這些方法相比,論文提出了一個(gè)時(shí)間稠密的車道感知模塊來學(xué)習(xí)智能體的運(yùn)動(dòng)模型和潛在車道段之間的對(duì)齊。論文不是簡單地結(jié)合運(yùn)動(dòng)編碼和車道編碼并允許解碼器隱式學(xué)習(xí)它們的關(guān)系[32],而是顯式估計(jì)智能體在每個(gè)時(shí)間步將采用的車道的可能性。然后,論文只選擇最有可能的車道信息來平衡車道段的可變性和運(yùn)動(dòng)模型的不確定性。

3 方法

3.1 問題描述

遵循主流工作,例如 [10, 15, 43, 52, 9],論文假設(shè)路上智能體檢測和跟蹤,以及感知環(huán)境,在 2D 坐標(biāo)系中提供高質(zhì)量的軌跡和高清地圖數(shù)據(jù)。即對(duì)于智能體,獲得給定時(shí)間范圍內(nèi)的 x 和 y 位置,以及環(huán)境高精地圖 C。下游任務(wù)是通過使用 HD 地圖和給定場景中所有智能體的觀測軌跡(包括目標(biāo)智能體的軌跡)預(yù)測后續(xù)軌跡。

兩個(gè)智能體的過去軌跡和車道中心線都表示為向量。更具體地說,對(duì)于智能體i,它的歷史軌跡表示為過去時(shí)間步長的稀疏軌跡向量的有序序列。每個(gè)軌跡向量定義為,其中分別表示起點(diǎn)和終點(diǎn),對(duì)應(yīng)智能體i的屬性特征,例如時(shí)間戳和對(duì)象類型(即自動(dòng)駕駛車輛、目標(biāo)智能體等)。此外,車道中心線被進(jìn)一步分割成預(yù)定義的段以捕獲細(xì)粒度的車道信息,以便精確地建模智能體的意圖。與軌跡向量類似,一條車道中心線段表示為,其中 N 表示總向量長度。每個(gè)車道向量添加以表示起點(diǎn)的前置。車道矢量端到端連接以獲得高清地圖的結(jié)構(gòu)特征。

此外,為了確保輸入特征相對(duì)于智能體位置的不變性,所有向量的坐標(biāo)都被歸一化為以目標(biāo)智能體最后觀察到的位置為中心。

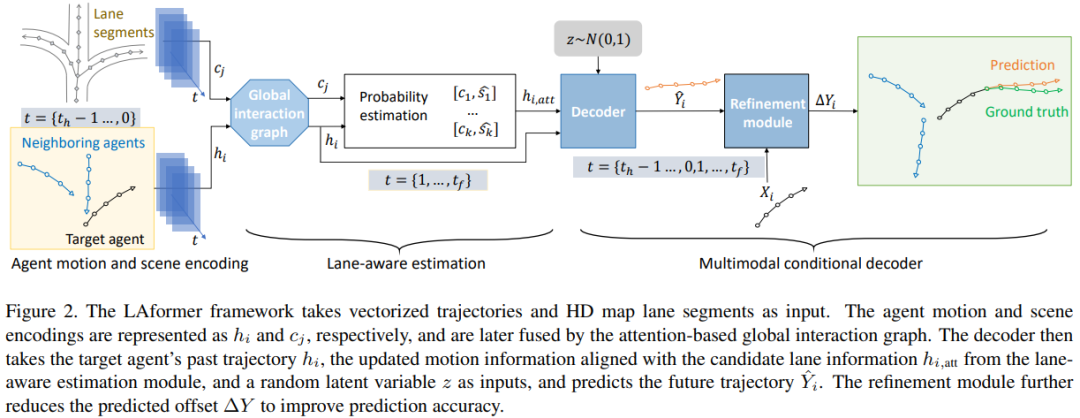

圖 2 展示了LAformer的總體框架,它將矢量化軌跡和高精地圖車道段作為目標(biāo)智能體的輸入以輸出多模態(tài)軌跡。下面詳細(xì)解釋LAformer的每個(gè)模塊。

3.2 智能體運(yùn)動(dòng)和場景編碼

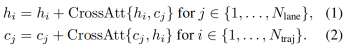

論文設(shè)計(jì)了一個(gè)基于注意力的全局交互圖 (GIG) 來編碼智能體運(yùn)動(dòng)和場景信息。具體而言,論文使用多層感知器 (MLP) 和門控循環(huán)單元 (GRU) 層以順序方式處理軌跡向量和車道向量。在給定的場景中,這些層的輸出編碼表示為和。為了融合這些編碼,論文設(shè)計(jì)了一個(gè)對(duì)進(jìn)行操作的對(duì)稱交叉力注意機(jī)制,如下所示:

之后,GIG 進(jìn)一步進(jìn)行自注意力和跳過連接來學(xué)習(xí)智能體之間的交互。

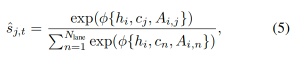

3.3 時(shí)間稠密的車道感知估計(jì)

論文提出了一個(gè)時(shí)間上稠密的車道感知概率估計(jì)模塊,該模塊使用注意力將目標(biāo)智能體引導(dǎo)到對(duì)其未來軌跡最有影響力的車道段。具體來說,論文在每個(gè)未來時(shí)間步t對(duì)齊目標(biāo)智能體的運(yùn)動(dòng)和車道信息。為了實(shí)現(xiàn)這一點(diǎn),論文使用車道評(píng)分頭和注意力機(jī)制來預(yù)測車道概率。K,V向量是智能體運(yùn)動(dòng)編碼的線性變換,Q向量是車道編碼的線性變換。然后將這些向量輸入到縮放的點(diǎn)積注意力塊,輸出第j個(gè)車道在t的預(yù)測得分如下:

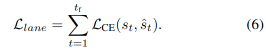

為了平衡車道段的可變性和運(yùn)動(dòng)的不確定性,論文選擇前k個(gè)最高得分的車道段作為候選車道段。然后論文在未來的時(shí)間步長上連接候選車道段和相關(guān)分?jǐn)?shù)以獲得C。接下來,使用交叉注意力以將目標(biāo)智能體的過去軌跡編碼投影為查詢向量,將候選車道編碼 C 投影為鍵和值向量。輸出是與車道信息對(duì)齊的更新運(yùn)動(dòng)信息,表示為。這種交叉注意力進(jìn)一步探索了空間和時(shí)間維度上的場景信息。車道評(píng)分模型使用二值交叉熵?fù)p失來優(yōu)化概率估計(jì)。對(duì)于最接近軌跡真實(shí)位置的車道段,真值設(shè)置為1,對(duì)于所有其他車道,設(shè)置為 0。值得一提的是,真值車道段不需要額外標(biāo)記,可以使用距離度量(例如歐氏距離)輕松識(shí)別。

3.4 多模態(tài)條件解碼器

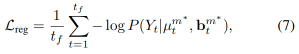

本節(jié)介紹一種拉普拉斯混合密度網(wǎng)絡(luò) (MDN) 解碼器,該解碼器以目標(biāo)智能體的過去軌跡和與候選車道信息 對(duì)齊的更新運(yùn)動(dòng)信息的編碼為條件。為了進(jìn)一步保持多模態(tài)的多樣性,論文從多元正態(tài)分布中采樣一個(gè)潛在向量z,它作為添加到預(yù)測編碼中的附加條件。解碼器預(yù)測一組軌跡。論文使用一個(gè)MLP來預(yù)測 ,一個(gè) GRU 來恢復(fù)預(yù)測的時(shí)間維度,以及兩個(gè)并排的MLP來預(yù)測μ和b。

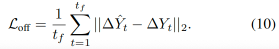

論文通過最小化回歸損失和分類損失來訓(xùn)練拉普拉斯 MDN 解碼器。回歸損失是使用 Winner-Takes-All 策略 [28, 52, 9] 計(jì)算的,定義為:

交叉熵?fù)p失用于優(yōu)化模態(tài)分類,定義為:

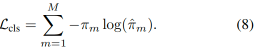

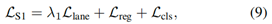

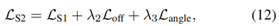

論文采用軟位移誤差[52],作為論文的目標(biāo)概率。第一階段運(yùn)動(dòng)預(yù)測的總損失由下式給出:

3.5 運(yùn)動(dòng)優(yōu)化

引入第二階段運(yùn)動(dòng)細(xì)化以進(jìn)一步探索預(yù)測更準(zhǔn)確的未來軌跡的時(shí)間一致性。目標(biāo)是減少真值軌跡和預(yù)測軌跡之間的偏移。在這個(gè)階段,論文使用完整的軌跡 為輸入,使用與第一階段類似的時(shí)間編碼器來提取運(yùn)動(dòng)編碼 。然后由雙層MLP構(gòu)建的回歸頭將兩個(gè)階段的所有運(yùn)動(dòng)編碼作為輸入,并預(yù)測真值和預(yù)測軌跡之間的偏移量。論文使用損失優(yōu)化偏移量。

在這里,論文采用贏者通吃的策略來優(yōu)化偏移和角度損失,類似于第一階段。第二階段的總損失可以表示為:

4 實(shí)驗(yàn)

4.1 實(shí)驗(yàn)設(shè)置

數(shù)據(jù)集:所提出的方法是在兩個(gè)具有挑戰(zhàn)性且廣泛使用的自動(dòng)駕駛基準(zhǔn)上開發(fā)和評(píng)估的:nuScenes [2] 和 Argoverse1[4]。這些基準(zhǔn)提供了各種類型道路智能體的軌跡以及給定場景的高清地圖。在nuScenes中,目標(biāo)智能體隨后的六秒軌跡是根據(jù)其和相鄰智能體最多兩秒的軌跡預(yù)測的,軌跡采樣率為 2Hz。在Argoverse1中,目標(biāo)智能體的后續(xù)三秒軌跡是根據(jù)其和鄰近智能體在最初兩秒內(nèi)的軌跡預(yù)測的,軌跡采樣率為10 Hz。為確保公平比較,兩個(gè)基準(zhǔn)測試的官方數(shù)據(jù)分區(qū)和在線測試服務(wù)器分別用于訓(xùn)練和測試設(shè)置。

評(píng)估準(zhǔn)則:論文采用標(biāo)準(zhǔn)評(píng)估指標(biāo)來衡量預(yù)測性能,包括和,分別表示預(yù)測K模態(tài)最后一步的誤差和每一步的平均值。此處報(bào)告了K模態(tài)的最小誤差。ADE和FDE均以米為單位。此外,未命中率衡量最后一步誤差大于2.0 m的場景的百分比。對(duì)于多模態(tài)軌跡預(yù)測,K在nuScenes中設(shè)置為5和10,在Argoverse1中設(shè)置為6。對(duì)于所有評(píng)估指標(biāo),越低越好。

實(shí)現(xiàn)細(xì)節(jié):LAformer中所有特征向量的隱藏維度設(shè)置為128。只有目標(biāo)智能體50 m(曼哈頓距離)內(nèi)的車道段被采樣為場景上下文。公式中的 λ1 (9)設(shè)置為10。等式中的λ2、λ3(12)分別設(shè)置為5和 2。論文使用兩階段訓(xùn)練方案。在第一階段,除了運(yùn)動(dòng)細(xì)化模塊之外的所有模塊都使用Adam優(yōu)化器 [21] 進(jìn)行訓(xùn)練。在第二階段,所有模塊一起訓(xùn)練。LAFormer 在 8xRTX3090 卡上接受了每個(gè)階段約8小時(shí)的訓(xùn)練。

4.2 定量結(jié)果與比較

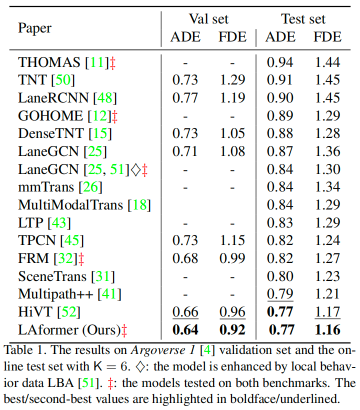

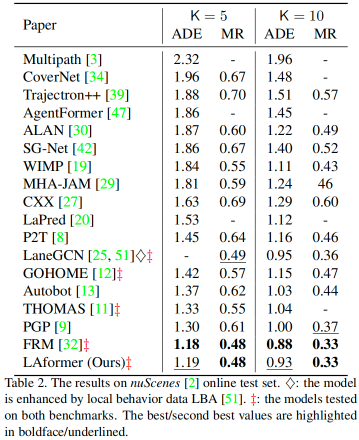

表1和表2分別顯示了在Argoverse 1驗(yàn)證和在線測試集以及nuScenes在線測試集上獲得的結(jié)果。根據(jù)官方發(fā)布的論文,排行榜結(jié)果(在線測試)更新至2023-02-20。

在Argoverse 1基準(zhǔn)測試中,LAformer在ADE和FDE上以明顯優(yōu)勢在驗(yàn)證集上實(shí)現(xiàn)了最先進(jìn)的性能。它還在測試集上取得了優(yōu)異的成績,與亞軍方法 HiVT 不相上下。

在nuScenes基準(zhǔn)測試中,LAformer取得了具有競爭力的性能,在ADE方面僅略遜于新發(fā)布的 FRM [32]。FRM 引入關(guān)系推理來幫助理解未來自我與其他智能體之間的交互,而LAformer則依賴注意力機(jī)制來學(xué)習(xí)智能體之間的交互,并更側(cè)重于場景約束。這種方法上的差異可能會(huì)導(dǎo)致性能差異。然而,LAformer 以明顯的優(yōu)勢優(yōu)于其他基于車道的模型,例如 LaneGCN [25、51] 和 PGP [9],表明論文的車道感知估計(jì)比其他基于距離或啟發(fā)式車道搜索更有效。

此外,與在兩個(gè)基準(zhǔn)測試中測試的模型(用?標(biāo)記)相比,即THOMAS [11]、GO HOME [12]、LaneGCN [25]由本地行為數(shù)據(jù) LBA[51]增強(qiáng),以及FRM, LAformer 在基準(zhǔn)測試中明顯表現(xiàn)出更普遍的表現(xiàn)。這表明,即使Argoverse 1和nuScenes中提供的軌跡包括不同城市的位置和駕駛方向,所提出的時(shí)間稠密車道感知估計(jì)模塊有效地將場景約束與運(yùn)動(dòng)模型對(duì)齊。支持該模塊功能的進(jìn)一步證據(jù)可以在表中列出的以下消融研究中找到。

?

4.3 消融實(shí)驗(yàn)

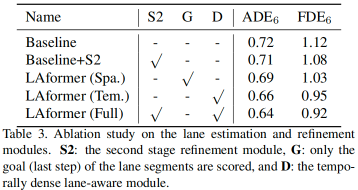

考慮到數(shù)據(jù)規(guī)模和真值的可用性,論文對(duì)具有39,472個(gè)序列的Argoverse 1驗(yàn)證集進(jìn)行了消融研究。基線模型預(yù)測未來軌跡僅以目標(biāo)及其鄰近智能體的觀測軌跡為條件,第二個(gè)細(xì)化模塊(S2)和車道感知估計(jì)模塊被移除。LAformer (Spa.)僅估計(jì)目標(biāo)位置與車道信息對(duì)齊的可能性,類似于空間密集模型。相比之下,LAformer (Tem.)估計(jì)每個(gè)時(shí)間步的位置與時(shí)間稠密車道信息對(duì)齊的可能性。LAformer(完整)是完整的建議模型。

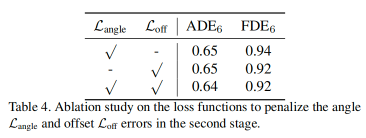

從表3可以看出,Baseline的性能遠(yuǎn)不如其他模型。Baseline對(duì)比 Baseline+S2和LAformer (Tem.) 對(duì)比LAformer (Full)證明了S2的性能增益,例如,3%的FDE。LAformer (Spa.)與 LAformer (Tem.)的比較表明,論文的時(shí)間稠密方法比空間稠密方法更有效,將ADE降低約 4%,將FDE降低約 8%。此外,論文進(jìn)行了一項(xiàng)消融研究,以分析第二階段中角度和偏移損失的有效性。如表4所示,通過使用兩種損失有助于將預(yù)測精度(使用ADE和FDE度量)提高約2%。

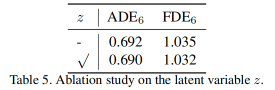

論文還消融了添加到多模態(tài)條件解碼器輸入的潛在變量z。它是從維度設(shè)置為2的多元正態(tài)分布中采樣的。但是,如表5所示,論文發(fā)現(xiàn)插入z只會(huì)帶來細(xì)微性能提升(小于0.5厘米)。

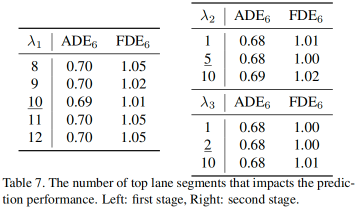

4.4 超參數(shù)的敏感性分析

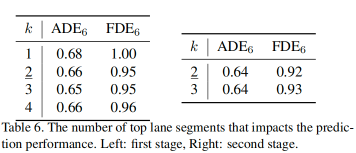

top-k 車道段的數(shù)量和損失的權(quán)重是 LAformer 的關(guān)鍵超參數(shù)。為了驗(yàn)證它們的影響,論文通過在表6和表7中下劃線指示的實(shí)驗(yàn)設(shè)置范圍內(nèi)改變它們的值來進(jìn)行實(shí)驗(yàn)。

如表6左側(cè)所示,車道段的數(shù)量從1增加到4,性能開始隨著k的增加有所提升,直到k=3,但在那之后,它開始下降。在第二階段,k=2提供了比3更好的結(jié)果。使用較大的k增加了包含不相關(guān)的車道段的概率,而相對(duì)較小的k使解碼器能夠?qū)W⒂谧钕嚓P(guān)的車道段。

論文還改變了等式(9)中的損失權(quán)重 λ1和等式(12)中的λ2,λ3,如表7所示,論文僅觀察到細(xì)微性能差異,例如在1厘米內(nèi)波動(dòng)。

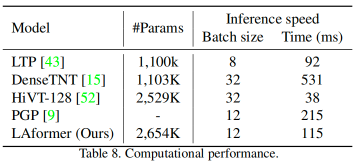

4.5 計(jì)算性能

如表 8 所示,LAformer 具有2,645K參數(shù),類似于HiVT-128,但大于LTP和DenseTNT。對(duì)于平均有 12個(gè)智能體的場景,它的推理時(shí)間約為115 ms,與HiVT相比,這不是主要優(yōu)勢。但這種推理速度與 LTP 相當(dāng),比DenseTNT和 GP更快,使LAformer在10 Hz時(shí)接近實(shí)時(shí)。

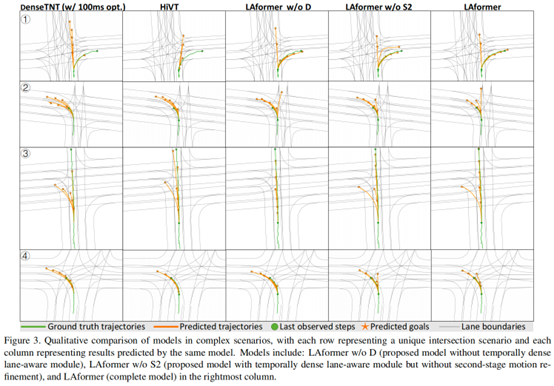

4.6 定性結(jié)果

圖3顯示了LAFormer與Argoverse 1驗(yàn)證集上的亞軍模型相比的定性結(jié)果。為了確保公平比較,論文使用公開訓(xùn)練的 HiVT [52] 模型來復(fù)制他們論文中報(bào)告的結(jié)果。由于 DenseTNT [15] 不提供經(jīng)過訓(xùn)練的模型,論文從頭開始通過優(yōu)化(DenseTNT w/100ms opt.)重新訓(xùn)練離線模型,以實(shí)現(xiàn)與他們論文中報(bào)告的性能相似的性能。所有模型在十字路口的各種交通場景中為目標(biāo)主體生成合理的多模態(tài)預(yù)測,例如右轉(zhuǎn) 1 和左轉(zhuǎn)2、4,或加速直行3。但是,LAformer 在右轉(zhuǎn)場景1和加速場景 中生成更準(zhǔn)確的預(yù)測,而其他模型傾向于預(yù)測減速或轉(zhuǎn)彎模式。此外,當(dāng)時(shí)間稠密的車道感知模塊被停用時(shí)(w/o D vs. w/o S2),LAformer 在橫向方向上生成的預(yù)測較少。然而,最右列顯示的具有第二階段細(xì)化模塊的完整模型保持了良好的預(yù)測多樣性和準(zhǔn)確性。

?

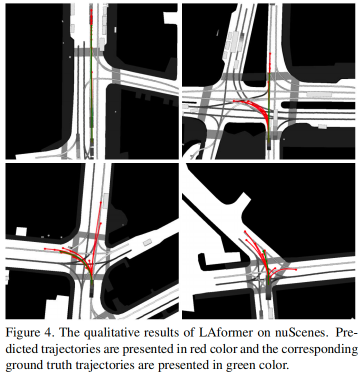

圖4顯示了LAformer在nuScenes上的更多定性結(jié)果 它不僅可以在直行行駛中生成準(zhǔn)確的預(yù)測,而且可以在復(fù)雜的交叉路口生成準(zhǔn)確的預(yù)測,例如繼續(xù)向前行駛、左轉(zhuǎn)或右轉(zhuǎn)。與車道段對(duì)齊的多模態(tài)預(yù)測意味著智能體在交叉路口的運(yùn)動(dòng)不確定。

5 結(jié)論

該論文介紹了LAformer,這是一種基于端到端注意力的軌跡預(yù)測模型,它將觀察到的軌跡和高清地圖作為輸入并輸出一組多模態(tài)預(yù)測軌跡。基于Transformer 的時(shí)間稠密車道感知模塊和第二階段運(yùn)動(dòng)細(xì)化模塊用于提高預(yù)測準(zhǔn)確性。LAformer在Argoverse 1和nuScenes運(yùn)動(dòng)預(yù)測基準(zhǔn)測試中都優(yōu)于其他模型,展示了卓越的泛化性能。此外,廣泛的消融和敏感性研究驗(yàn)證了車道感知和運(yùn)動(dòng)優(yōu)化模塊的性能。

編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論