自DARPA舉辦2004/2005年鄉(xiāng)村無(wú)人車(chē)大賽和2007年城市自動(dòng)駕駛挑戰(zhàn)賽以來(lái),自動(dòng)駕駛一直是人工智能應(yīng)用最活躍的領(lǐng)域之一。本文概述了自動(dòng)駕駛領(lǐng)域相關(guān)技術(shù)和未解決難題。我們參與調(diào)研的自動(dòng)駕駛領(lǐng)域主要包括:感知、建圖和定位、預(yù)測(cè)、規(guī)劃和控制、仿真、V2X、安全等。與眾不同的是,我們闡述了如何在數(shù)據(jù)閉環(huán)框架下解決上述問(wèn)題,其中,"數(shù)據(jù)閉環(huán)"是解決自動(dòng)駕駛"長(zhǎng)尾問(wèn)題"的有效框架。

1 簡(jiǎn)介

10多年來(lái),自動(dòng)駕駛一直是一個(gè)熱門(mén)話題。2004年和2005年,DARPA舉辦了鄉(xiāng)村無(wú)人車(chē)大賽。2007年,DARPA還舉辦了城市環(huán)境中的自動(dòng)駕駛大賽。之后,斯坦福大學(xué)的S.Thrun教授(2005年冠軍和2007年亞軍)加入谷歌,建立了Google X和自動(dòng)駕駛團(tuán)隊(duì)。

最近有三篇關(guān)于自動(dòng)駕駛的調(diào)查報(bào)告[3,9,14]。自動(dòng)駕駛作為機(jī)器學(xué)習(xí)和計(jì)算機(jī)視覺(jué)等人工智能領(lǐng)域最具挑戰(zhàn)性的應(yīng)用之一,已經(jīng)被證明是一個(gè)"長(zhǎng)尾"問(wèn)題,即少量類(lèi)別占據(jù)了絕大多少樣本,而大量的類(lèi)別僅有少量的樣本。在本文中,我們研究了如何在數(shù)據(jù)閉環(huán)中研發(fā)自動(dòng)駕駛技術(shù)。我們的綜述工作涵蓋了自動(dòng)駕駛技術(shù)主要領(lǐng)域,包括:感知、建圖和定位、預(yù)測(cè)、規(guī)劃和控制、仿真、V2X和安全等。

最后,我們將討論新興大模型對(duì)自動(dòng)駕駛行業(yè)的影響。

2 簡(jiǎn)要介紹

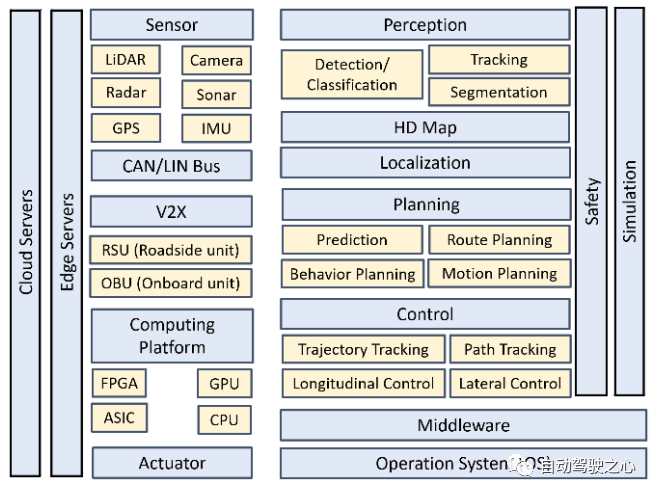

目前存在的一些關(guān)于自動(dòng)駕駛技術(shù)的綜述文章,包含整個(gè)系統(tǒng)/平臺(tái)到單個(gè)模塊/功能[1-2,4-8,10-13,15-33]。在本節(jié)中,我們簡(jiǎn)要介紹圖1所示的基本自動(dòng)駕駛功能和模塊,硬件和軟件體系結(jié)構(gòu),包括:感知、預(yù)測(cè)、定位和建圖、規(guī)劃、控制、安全、仿真以及V2X等。

圖 1 自動(dòng)駕駛平臺(tái)的硬件和軟件

2.1 自動(dòng)化水平

美國(guó)運(yùn)輸部和國(guó)家公路交通安全管理局(NHTSA)采用了國(guó)際標(biāo)準(zhǔn)化組織汽車(chē)工程師學(xué)會(huì)(SAE)制定的自動(dòng)化水平標(biāo)準(zhǔn),該標(biāo)準(zhǔn)將自動(dòng)駕駛車(chē)輛自動(dòng)化分為6個(gè)等級(jí),即從0級(jí)(人工駕駛員完全控制)到5級(jí)(車(chē)輛完全自主駕駛)。

在1級(jí)中,駕駛員和自動(dòng)化系統(tǒng)共同控制車(chē)輛。在2級(jí)中,自動(dòng)化系統(tǒng)完全控制車(chē)輛,但駕駛員必須時(shí)刻準(zhǔn)備好立即干預(yù)。在3級(jí)中,駕駛員可以免于駕駛?cè)蝿?wù),車(chē)輛將要求立即響應(yīng),因此駕駛員仍須隨時(shí)準(zhǔn)備干預(yù)。在4級(jí)中,與3級(jí)相同,但不需要駕駛員保持注意力來(lái)確保安全,駕駛員可以安全地睡覺(jué)或離開(kāi)駕駛員座位。

2.2 硬件

自動(dòng)駕駛車(chē)輛測(cè)試平臺(tái)應(yīng)該能夠?qū)崿F(xiàn)實(shí)時(shí)通信,例如使用控制器區(qū)域網(wǎng)絡(luò)(CAN)總線和以太網(wǎng),可以準(zhǔn)確地實(shí)現(xiàn)車(chē)輛的方向、油門(mén)和制動(dòng)器的實(shí)時(shí)控制。進(jìn)行車(chē)輛傳感器合理配置,以滿足環(huán)境感知的可靠性要求,并最大限度降低生產(chǎn)成本。

自動(dòng)駕駛車(chē)輛的感知可以分為三大類(lèi):本體感知、定位和環(huán)境感知。本體感知:通過(guò)車(chē)輛的傳感器測(cè)量當(dāng)前車(chē)輛狀態(tài),即橫擺速率、速度、偏航角等。本體感知的傳感器包括行程計(jì)、慣性測(cè)量單元(IMU)、陀螺儀和CAN總線。定位:使用外部傳感器(如全球定位系統(tǒng)(GPS))或IMU讀數(shù)的里程計(jì)來(lái)確定車(chē)輛的全局和局部位置。環(huán)境感知:使用外部感測(cè)器來(lái)感知車(chē)道標(biāo)線、道路坡度、交通信號(hào)牌、天氣條件和障礙物等。

本體感知傳感器和環(huán)境感知傳感器分為主動(dòng)傳感器和被動(dòng)傳感器。主動(dòng)傳感器以電磁波的形式發(fā)出能量,并測(cè)量返回時(shí)間以確定距離等參數(shù),例如聲納、雷達(dá)和光探測(cè)與測(cè)距(LiDAR)傳感器。被動(dòng)傳感器不發(fā)出信號(hào),而是感知環(huán)境中已經(jīng)存在的電磁波(例如基于光的和紅外相機(jī))。

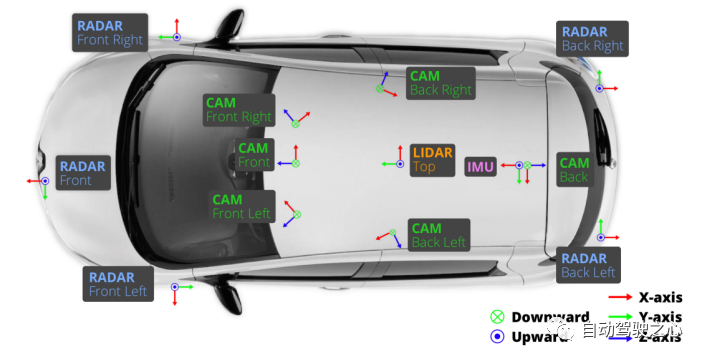

另一個(gè)重要方面是計(jì)算平臺(tái),它支持傳感器數(shù)據(jù)處理以識(shí)別周?chē)h(huán)境,并通過(guò)密集優(yōu)化算法、計(jì)算機(jī)視覺(jué)算法和機(jī)器學(xué)習(xí)算法來(lái)實(shí)時(shí)控制車(chē)輛。目前存在不同的計(jì)算平臺(tái),如CPU、GPU、ASIC和FPGA等。為了支持基于AI的自動(dòng)駕駛,也需要云服務(wù)器來(lái)提供大數(shù)據(jù)服務(wù),例如進(jìn)行大規(guī)模機(jī)器學(xué)習(xí)和大容量數(shù)據(jù)存儲(chǔ)(例如高清地圖)。為了實(shí)現(xiàn)車(chē)路協(xié)同,還需要處理車(chē)端信息的路側(cè)通信設(shè)備和計(jì)算設(shè)備。圖2顯示了一輛自動(dòng)駕駛汽車(chē)中的傳感器配置示例(來(lái)自公開(kāi)數(shù)據(jù)集NuScene)。它安裝了LiDAR、相機(jī)、雷達(dá)、GPS和IMU等。

圖 2 自動(dòng)駕駛傳感器硬件示例

如果需要收集多模態(tài)傳感器數(shù)據(jù),還需要進(jìn)行傳感器校準(zhǔn),其中涉及確定每個(gè)傳感器數(shù)據(jù)之間的坐標(biāo)系統(tǒng)關(guān)系,例如相機(jī)校準(zhǔn)、相機(jī)-LiDAR校準(zhǔn)、LiDAR-IMU校準(zhǔn)以及相機(jī)-雷達(dá)校準(zhǔn)。此外,傳感器之間需要使用統(tǒng)一的時(shí)鐘(例如GNSS),然后使用某個(gè)信號(hào)觸發(fā)傳感器的操作。例如,LiDAR的傳輸信號(hào)可以觸發(fā)相機(jī)的曝光時(shí)間,實(shí)現(xiàn)時(shí)間同步。

2.3 軟件

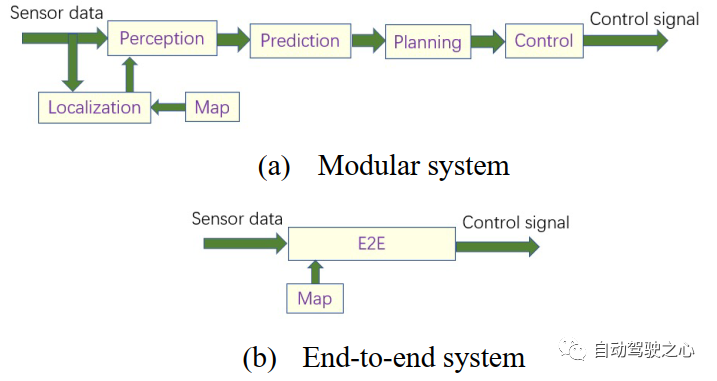

自動(dòng)駕駛系統(tǒng)的軟件平臺(tái)分為4個(gè)層次,從底層到頂層分別為:實(shí)時(shí)操作系統(tǒng)(RTOS)、中間件、功能軟件和應(yīng)用軟件。軟件體系結(jié)構(gòu)分為:模塊化結(jié)構(gòu)和端到端結(jié)構(gòu)。

模塊化系統(tǒng)由多個(gè)構(gòu)件組成,連接感知輸入到執(zhí)行器輸出。模塊化自動(dòng)駕駛系統(tǒng)(ADS)的關(guān)鍵功能通常分為:感知、定位和繪圖、預(yù)測(cè)、規(guī)劃和決策以及車(chē)輛控制等。

端到端系統(tǒng)直接從傳感器輸入生成控制信號(hào)。控制信號(hào)主要來(lái)自轉(zhuǎn)向輪和油門(mén)(加速器),用于加速/減速(甚至停止)和左/右轉(zhuǎn)彎。端到端駕駛主要包括三種方式:直接監(jiān)督深度學(xué)習(xí)、神經(jīng)進(jìn)化和深度強(qiáng)化學(xué)習(xí)。

圖 3 顯示了端到端和模塊化系統(tǒng)的體系結(jié)構(gòu)

"感知"系統(tǒng)通過(guò)傳感器收集信息并從環(huán)境中提取有效信息。它能對(duì)駕駛環(huán)境進(jìn)行上下文理解,如檢測(cè)、跟蹤和分割障礙物、道路標(biāo)志/標(biāo)線和空曠的可駕駛區(qū)域。根據(jù)所采用的傳感器,環(huán)境感知任務(wù)主要通過(guò)使用LiDAR、相機(jī)、雷達(dá)或多傳感器融合來(lái)完成。在最高層次上,感知方法可以分為三類(lèi):中介感知、行為反射感知和直接感知。中介感知需要繪制車(chē)輛、行人、樹(shù)木、車(chē)道標(biāo)記等周?chē)h(huán)境的詳細(xì)地圖。行為反射感知將傳感器數(shù)據(jù)(圖像、點(diǎn)云、GPS位置)直接映射到駕駛機(jī)動(dòng)操作。直接感知將行為反射感知與中介感知方法的度量獲取相結(jié)合。

"建圖"是指建立包含道路、車(chē)道、標(biāo)志/標(biāo)線和交通規(guī)則等信息的地圖。一般來(lái)說(shuō),有兩種主要類(lèi)型的地圖:平面地圖,指依賴(lài)地理信息系統(tǒng)(GIS)上的圖層或平面繪制的地圖;點(diǎn)云地圖,指基于GIS中的數(shù)據(jù)點(diǎn)集的地圖。高清(HD)地圖包含自動(dòng)駕駛所需的有用的靜態(tài)元素,如車(chē)道、建筑、交通燈和車(chē)道標(biāo)記等。HD地圖與車(chē)輛定位功能緊密相連,并與車(chē)輛傳感器(如LiDAR、雷達(dá)和相機(jī))保持交互,從而構(gòu)建自動(dòng)駕駛系統(tǒng)的感知模塊。

"定位"確定車(chē)輛相對(duì)于駕駛環(huán)境的位置。全球?qū)Ш叫l(wèi)星系統(tǒng)(GNSS)如GPS、GLONASS、北斗和伽利略等,他們使用不少于四顆衛(wèi)星并以相對(duì)較低的成本估計(jì)車(chē)輛的全球位置。全球?qū)Ш叫l(wèi)星系統(tǒng)可以使用差分模式來(lái)提高GNSS的精度。GNSS通常與IMU集成來(lái)設(shè)計(jì)性?xún)r(jià)比高的車(chē)輛定位系統(tǒng)。IMU用于估計(jì)車(chē)輛相與其初始位置的相對(duì)位置,這種方法稱(chēng)為里程計(jì)。由于HD地圖已經(jīng)用于自動(dòng)駕駛,基于HD地圖的定位也被考慮在內(nèi)。最近,出現(xiàn)了許多自主的里程計(jì)方法和同時(shí)定位與建圖方法(SLAM)。SLAM技術(shù)通常應(yīng)用一個(gè)里程計(jì)算法來(lái)獲得當(dāng)前姿態(tài)信息,然后將其送到一個(gè)全局地圖優(yōu)化算法中。基于圖像的計(jì)算機(jī)視覺(jué)算法包括:特征提取和匹配、相機(jī)運(yùn)動(dòng)估計(jì)、三維重建(三角測(cè)量)和優(yōu)化(約束調(diào)整)等,由于這些算法的缺點(diǎn),目前視覺(jué)SLAM仍然是一個(gè)具有挑戰(zhàn)性的方向。

"預(yù)測(cè)"是指根據(jù)障礙物的運(yùn)動(dòng)學(xué)、行為和長(zhǎng)短期歷史估計(jì)其軌跡。要完全解決軌跡預(yù)測(cè)問(wèn)題,社會(huì)智能化非常重要。因?yàn)橹悄芑纳鐣?huì)環(huán)境中,各種可能性被約束,無(wú)限的搜索空間也被約束。為了建立社會(huì)互動(dòng)模型,我們需要了解智能體及其周?chē)h(huán)境的動(dòng)態(tài),以預(yù)測(cè)其未來(lái)的行為,防止發(fā)生任何碰撞。

"規(guī)劃"是生成一條避障的參考路徑或軌跡,使車(chē)輛在避開(kāi)障礙物的同時(shí)到達(dá)目的地。規(guī)劃可以分為不同的等級(jí):路線(任務(wù))規(guī)劃、行為規(guī)劃和運(yùn)動(dòng)規(guī)劃。路徑規(guī)劃是指在有向圖中尋找點(diǎn)到點(diǎn)的最短路徑,傳統(tǒng)方法分為目標(biāo)導(dǎo)向技術(shù)、基于分離器的技術(shù)、分層技術(shù)和有界跳技術(shù)四類(lèi)。行為規(guī)劃決定了局部駕駛?cè)蝿?wù),該任務(wù)使車(chē)輛向目的地前進(jìn)并遵守交通規(guī)則,傳統(tǒng)上由有限狀態(tài)機(jī)(FSM)定義。最近正在研究模仿學(xué)習(xí)和強(qiáng)化學(xué)習(xí),以生成車(chē)輛所需的行為。運(yùn)動(dòng)規(guī)劃在環(huán)境中選擇一條連續(xù)路徑,以完成局部驅(qū)動(dòng)任務(wù),例如RRT(快速探索隨機(jī)樹(shù))和Lattice規(guī)劃。

"控制"是通過(guò)選擇適當(dāng)?shù)膱?zhí)行器輸入來(lái)執(zhí)行規(guī)劃的動(dòng)作。通常控制可分為橫向控制和縱向控制。大部分情況下,可以將控制解耦為兩階段,即軌跡/路徑生成階段和跟蹤階段,例如純跟蹤法。然而,它也可以同時(shí)生成軌跡/路徑并進(jìn)行跟蹤。

"V2X(車(chē)聯(lián)網(wǎng))"是一種能夠使車(chē)輛能夠與周?chē)能?chē)流和環(huán)境進(jìn)行通信的車(chē)輛技術(shù)系統(tǒng),包括:車(chē)輛間通信(V2V)和車(chē)輛基礎(chǔ)設(shè)施通信(V2I)。從行人的移動(dòng)設(shè)備到交通燈上的固定傳感器,車(chē)輛可以通過(guò)V2X訪問(wèn)大量數(shù)據(jù)。通過(guò)積累來(lái)自其他車(chē)輛的詳細(xì)信息,將克服單車(chē)智能的感知范圍、盲區(qū)和規(guī)劃不足等缺點(diǎn)。V2X有助于提高安全性和交通效率,但車(chē)輛之間和車(chē)路之間的協(xié)同仍然具有挑戰(zhàn)性。

值得一提的是,ISO(國(guó)際標(biāo)準(zhǔn)化組織)26262標(biāo)準(zhǔn)適用于自動(dòng)駕駛車(chē)輛,它定義了一套全面的要求,以確保車(chē)輛軟件開(kāi)發(fā)的"安全"。該標(biāo)準(zhǔn)建議使用危險(xiǎn)分析和風(fēng)險(xiǎn)評(píng)估(HARA)方法來(lái)識(shí)別危險(xiǎn)事件,并確定了減輕危險(xiǎn)的安全目標(biāo)。車(chē)輛安全完整性級(jí)別(ASIL)是ISO 26262中定義的車(chē)輛系統(tǒng)風(fēng)險(xiǎn)分類(lèi)方案。AI系統(tǒng)帶來(lái)了更多安全問(wèn)題,這些問(wèn)題由一個(gè)新建立的標(biāo)準(zhǔn)ISO/PAS 21448 SOTIF(預(yù)期功能的安全性)來(lái)解決。

除了模塊化或端到端系統(tǒng),ADS開(kāi)發(fā)中還有一個(gè)重要的"仿真"平臺(tái)。由于在道路上駕駛實(shí)驗(yàn)車(chē)輛的成本很高,而且在現(xiàn)有的人類(lèi)駕駛的道路網(wǎng)絡(luò)上進(jìn)行實(shí)驗(yàn),會(huì)受到限制,因此仿真環(huán)境可以實(shí)現(xiàn)在實(shí)際道路測(cè)試之前開(kāi)發(fā)某些算法/模塊。仿真系統(tǒng)由以下核心部分組成:傳感器模型(相機(jī)、雷達(dá)、LiDAR和聲納)、車(chē)輛動(dòng)力學(xué)和運(yùn)動(dòng)學(xué)、行人、駕車(chē)者和騎車(chē)者的形狀和運(yùn)動(dòng)學(xué)模型、路網(wǎng)和交通網(wǎng)絡(luò)、三維虛擬環(huán)境(城市和鄉(xiāng)村場(chǎng)景)以及駕駛行為模型(年齡、文化、種族等)。仿真平臺(tái)存在的關(guān)鍵問(wèn)題是"sim2real"和"real2sim",前者是指如何模擬真實(shí)場(chǎng)景,后者是指如何以數(shù)字孿生的方式進(jìn)行情景再現(xiàn)。

3 感知

感知周?chē)h(huán)境并提取信息是自動(dòng)駕駛的關(guān)鍵任務(wù)。使用不同傳感模式的各種任務(wù)都屬于感知范疇[5-6,25,29,32,36]。基于計(jì)算機(jī)視覺(jué)技術(shù),相機(jī)成為使用最廣泛的傳感器,3D視覺(jué)則成為一個(gè)強(qiáng)大的替代方案/補(bǔ)充。

最近,BEV(鳥(niǎo)瞰視角)感知[25,29]成為自動(dòng)駕駛中最活躍的感知方向之一,特別是在基于視覺(jué)的系統(tǒng)中。主要原因有以下兩點(diǎn):首先,BEV對(duì)駕駛場(chǎng)景的表示可以直接由下游模塊應(yīng)用,如軌跡預(yù)測(cè)和運(yùn)動(dòng)規(guī)劃等。其次,BEV提供了一種可解釋的方式來(lái)融合來(lái)自不同視角、模式、時(shí)間序列和智能體的信息。例如,其他常用傳感器,如LiDAR和Radar在3D空間中獲取的數(shù)據(jù),可以輕松轉(zhuǎn)換到BEV,并直接與相機(jī)直接進(jìn)行傳感器融合。

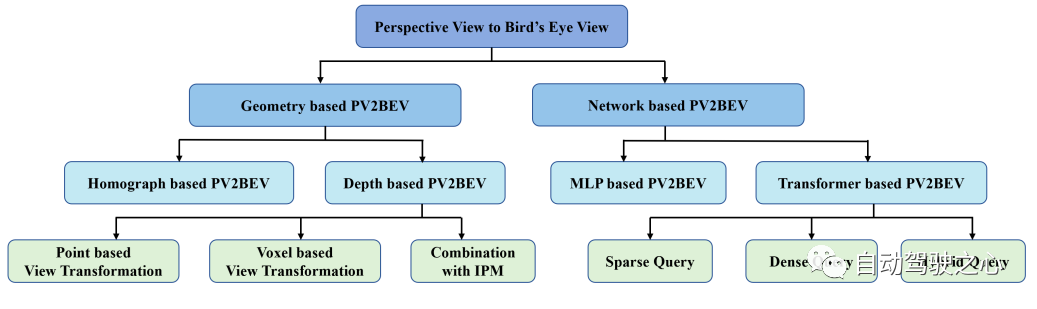

在調(diào)研報(bào)告[25]中,BEV工作可以分為以下幾個(gè)類(lèi)別,如圖4所示。

圖 4 BEV工作的類(lèi)別

首先,根據(jù)視圖變換方式可以分為基于幾何的變換和基于網(wǎng)絡(luò)的變換。基于幾何的變換充分利用相機(jī)的物理原理進(jìn)行視圖轉(zhuǎn)換,該方法可進(jìn)一步分為經(jīng)典的基于同圖的方法(即逆投影映射)和基于深度的方法,通過(guò)顯式或隱式深度估計(jì)可以將二維特征提升至三維特征。

根據(jù)深度信息的利用方式,我們可以將基于深度的方法分為兩類(lèi):基于點(diǎn)的方法和基于體素的方法;基于點(diǎn)的方法直接利用深度估計(jì)將像素轉(zhuǎn)換為點(diǎn)云,散布在連續(xù)的三維空間中;而基于體素的方法通常直接利用深度引導(dǎo)將二維特征(而不是點(diǎn))散布在相應(yīng)的三維位置上。

基于網(wǎng)絡(luò)的方法可以采用自下而上的策略,即神經(jīng)網(wǎng)絡(luò)像視圖投影儀一樣發(fā)揮作用;另一種方法可以采用自上而下的策略,即直接構(gòu)建BEV查詢(xún),并通過(guò)交叉注意力機(jī)制(基于Transformer)在前視圖像上搜索相應(yīng)的特征,提出稀疏、密集或混合查詢(xún)以匹配不同的下游任務(wù)。

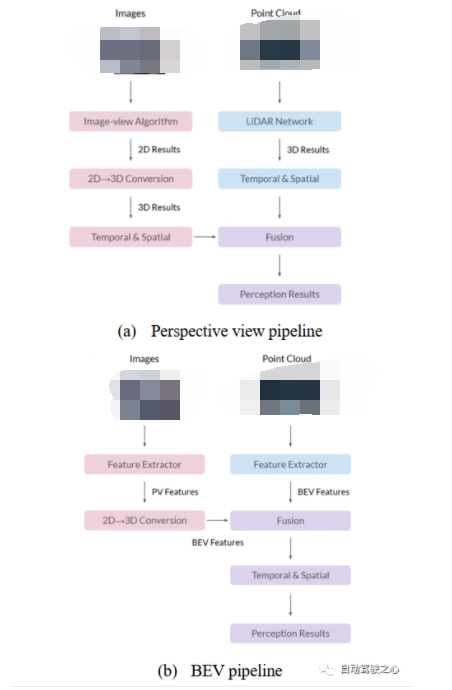

圖 5 BEV方案

迄今為止,BEV網(wǎng)絡(luò)已被用于物體檢測(cè)、語(yǔ)義分割、在線映射、傳感器融合和軌跡預(yù)測(cè)等。如研究論文[29]圖5所示,BEV融合算法有兩種典型的過(guò)程設(shè)計(jì)。兩者主要區(qū)別在于2D到3D的轉(zhuǎn)換和融合模塊。在透視圖方案(a)中,首先將不同算法的結(jié)果轉(zhuǎn)換到三維空間,然后使用先驗(yàn)規(guī)則或人工方法進(jìn)行融合。BEV方案(b)首先將透視圖特征轉(zhuǎn)換為BEV,然后融合特征以獲得最終預(yù)測(cè)結(jié)果,從而保留大部分原始信息并避免人工設(shè)計(jì)。

繼BEV之后,三維占位網(wǎng)絡(luò)逐漸成為自動(dòng)駕駛感知領(lǐng)域的前沿技術(shù)[32]。BEV可以簡(jiǎn)化駕駛場(chǎng)景的縱向幾何,而三維體素能夠以較低的分辨率表示完整的幾何,包括道路地面和障礙物體積,這需要較高的計(jì)算成本。基于相機(jī)的方法正在三維占位網(wǎng)絡(luò)中興起。圖像具有天然的像素密度,但是需要深度信息才能反向投射到三維占位中。注:對(duì)于LiDAR數(shù)據(jù),占位網(wǎng)絡(luò)實(shí)際上實(shí)現(xiàn)了語(yǔ)義場(chǎng)景補(bǔ)全(SSC)任務(wù)。

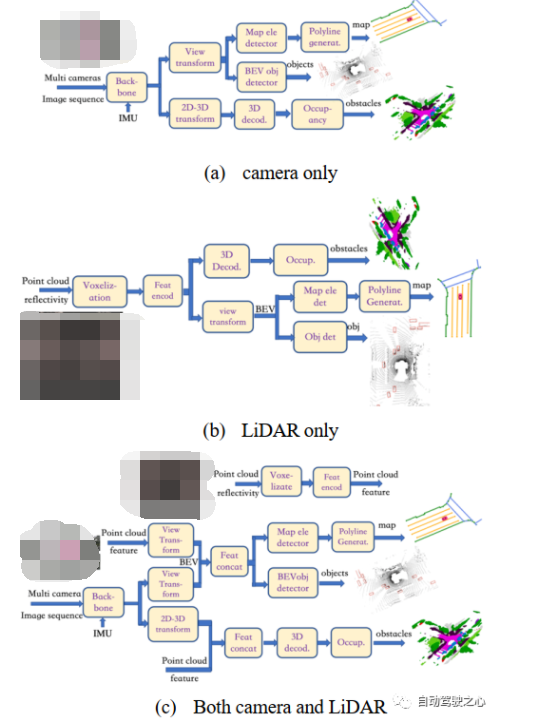

在圖6中,我們解釋了BEV和占用網(wǎng)絡(luò)的三種模型體系結(jié)構(gòu),僅針對(duì)相機(jī)輸入,僅針對(duì)LiDAR輸入以及兩者結(jié)合輸入。

圖 6 BEV和占位網(wǎng)絡(luò)實(shí)例

僅多相機(jī)輸入如圖6(a)所示,多相機(jī)圖像首先通過(guò)"Backbone"模塊編碼,如EfficientNetor/RegNet加上FPN/Bi-FPN,然后分為兩路;一方面,圖像特征進(jìn)入"view transform"模塊,通過(guò)深度分布或Transformer架構(gòu)構(gòu)建BEV特征,然后分別進(jìn)入兩個(gè)不同的頭部:一個(gè)頭通過(guò)"map ele detector"模塊輸出地圖元素的矢量化表示(其結(jié)構(gòu)類(lèi)似于基于Transformer的DETR模型,也有一個(gè)可變形的關(guān)注模塊,并輸出關(guān)鍵點(diǎn)的位置和它們所屬元素的ID)和"polyline generat"模塊(它也是一個(gè)基于Transformer結(jié)構(gòu)的模型,輸入這些嵌入的關(guān)鍵點(diǎn)、多段線分布模型可以生成多段線的頂點(diǎn)并獲得地圖元素的幾何表示),另一個(gè)頭通過(guò)"BEV obj Detector"模塊獲得obj BEV邊界框,它可以使用Transformer架構(gòu)或類(lèi)似的PointPillar架構(gòu)來(lái)實(shí)現(xiàn);另一方面,在"2D-3D transform"模塊中,基于深度分布將二維特征編碼投影到三維坐標(biāo),其中保留高度信息,得到的相機(jī)體素特征進(jìn)入"3D decod."模塊得到多尺度體素特征,然后進(jìn)入"occupancy"模塊進(jìn)行類(lèi)預(yù)測(cè),生成體素語(yǔ)義分割。

僅LiDAR輸入如圖6(b)所示,部分模塊與圖6(a)相同。首先,在"Voxelization"模塊中,將點(diǎn)云劃分為間距均勻的體素網(wǎng)格,生成三維點(diǎn)與體素的多對(duì)一映射;然后進(jìn)入"FeatEncod"模塊,將體素網(wǎng)格轉(zhuǎn)換為點(diǎn)云特征圖(使用PointNet或PointPillar);一方面,在"view transform"模塊中,將特征圖投影到BEV上,在BEV空間中結(jié)合特征聚合器和特征編碼器,然后進(jìn)行BEV解碼,分為兩個(gè)頭:一個(gè)頭部的工作原理如圖6(a)所示。另一方面,三維點(diǎn)云特征圖可以直接進(jìn)入"3D Decod"模塊,通過(guò)三維解卷積獲得多尺度體素特征,然后在"Occup"模塊中進(jìn)行上采樣和類(lèi)預(yù)測(cè),生成體素語(yǔ)義分割。

相機(jī)和LiDAR同時(shí)輸入如圖6(c)所示,大多數(shù)模塊與圖6(a)和6(b)相同,除了"Feat concat"模塊將連接來(lái)自LiDAR路徑和相機(jī)路徑的特征。

注:對(duì)于基于相機(jī)的占位網(wǎng)絡(luò),值得一提的是計(jì)算機(jī)圖形學(xué)和計(jì)算機(jī)視覺(jué)領(lǐng)域的一種新范例--神經(jīng)輻射場(chǎng)(NeRF)[47]。NeRF不是直接還原整個(gè)三維場(chǎng)景的幾何圖形,而是生成一種被稱(chēng)為"輻射場(chǎng)"的體積表示,它能夠?yàn)橄嚓P(guān)三維空間中的每一點(diǎn)創(chuàng)建顏色和密度。

4 軌跡預(yù)測(cè)

為實(shí)現(xiàn)安全高效的導(dǎo)航,自動(dòng)駕駛汽車(chē)應(yīng)考慮周?chē)渌悄荏w的未來(lái)軌跡。軌跡預(yù)測(cè)最近受到了廣泛關(guān)注,這是一項(xiàng)極具挑戰(zhàn)性的任務(wù),它根據(jù)場(chǎng)景中所有運(yùn)動(dòng)的智能體的當(dāng)前和過(guò)去狀態(tài)預(yù)測(cè)其未來(lái)狀態(tài)。

預(yù)測(cè)任務(wù)可分為兩部分。第一部分是作為分類(lèi)任務(wù)的"意圖",它通常可被視為一個(gè)監(jiān)督學(xué)習(xí)問(wèn)題,我們需要標(biāo)注智能體可能的意圖。第二部分是需要預(yù)測(cè)智能體在未來(lái)N個(gè)幀中的一組可能位置的"軌跡",這個(gè)"軌跡"被稱(chēng)為"路徑點(diǎn)"(way-points)。這建立了它們與其他智能體以及道路的交互。

文獻(xiàn)[10,12,34]進(jìn)行了一些預(yù)測(cè)相關(guān)的研究。傳統(tǒng)上,我們將行為預(yù)測(cè)模型分為基于物理的模型、基于機(jī)動(dòng)的模型和基于交互意識(shí)的模型。基于物理的模型由動(dòng)態(tài)方程構(gòu)成,為不同類(lèi)別的智能體建立人工設(shè)計(jì)運(yùn)動(dòng)模型。基于機(jī)動(dòng)的模型是基于智能體的預(yù)期運(yùn)動(dòng)類(lèi)型的實(shí)際模型。交互感知模型通常是基于ML的系統(tǒng),能夠?qū)?chǎng)景中的每一個(gè)智能體進(jìn)行配對(duì)推理,并為所有動(dòng)態(tài)智能體生成交互感知預(yù)測(cè)。

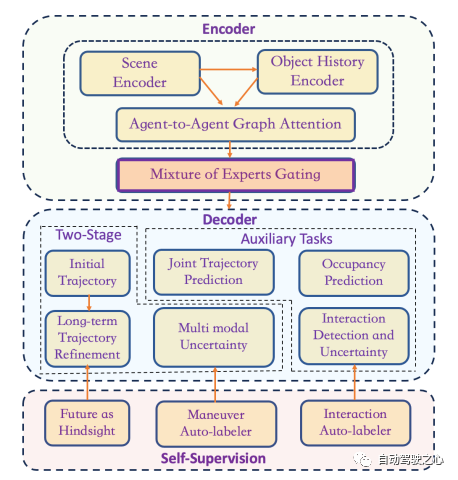

圖 7 L4創(chuàng)業(yè)公司Cruise.AI的預(yù)測(cè)模型

圖7給出了L4自動(dòng)駕駛創(chuàng)業(yè)公司Cruise.AI[36]設(shè)計(jì)的預(yù)測(cè)模型圖。顯然,它展示了一個(gè)編碼器-解碼器結(jié)構(gòu)。在編碼器中,有一個(gè)"場(chǎng)景編碼器"來(lái)處理環(huán)境上下文(地圖),類(lèi)似于谷歌Waymo的ChauffeurNet(光柵化圖像作為輸入)或VectorNet(矢量化輸入)架構(gòu)一樣;有一個(gè)"對(duì)象歷史編碼器"來(lái)處理智能體歷史數(shù)據(jù)(位置);還有一個(gè)基于注意力圖網(wǎng)絡(luò)來(lái)捕捉智能體之間的聯(lián)合交互。為了處理動(dòng)態(tài)場(chǎng)景的變化,他們將專(zhuān)家混合(MoE)編碼到門(mén)控網(wǎng)絡(luò)中。例如,在停車(chē)場(chǎng)有不同的行為,如倒車(chē)駛出、駛出和K形轉(zhuǎn)彎、平行停車(chē)第二次嘗試、倒車(chē)和駛出、倒車(chē)平行停車(chē)和垂直駛出等。

在圖7所示的解碼器中,有一個(gè)兩階段的結(jié)構(gòu),即由一個(gè)簡(jiǎn)單的回歸器生成初始軌跡,然后由具有"多模態(tài)不確定性"估計(jì)的長(zhǎng)期預(yù)測(cè)器進(jìn)行完善。為了增強(qiáng)軌跡預(yù)測(cè)器,還有一些輔助任務(wù)需要訓(xùn)練,如"聯(lián)合軌跡不確定性"估計(jì)和"交互檢測(cè)和不確定性"估計(jì),以及"占位預(yù)測(cè)"。

該軌跡預(yù)測(cè)器的一個(gè)大創(chuàng)新是它的"自監(jiān)督"機(jī)制。基于"后見(jiàn)之明"的觀察,他們提供"機(jī)動(dòng)自動(dòng)標(biāo)注器"和"交互自動(dòng)標(biāo)注器"為預(yù)測(cè)器模型生成大量訓(xùn)練數(shù)據(jù)。

5 建圖

地圖,特別是HD地圖,是自動(dòng)駕駛的先驗(yàn)知識(shí)。建圖技術(shù)可以分類(lèi)為在線建圖和離線建圖[24]。在離線建圖中,我們?cè)?a target="_blank">中心位置收集所有數(shù)據(jù),這些數(shù)據(jù)采集來(lái)自安裝有GNSS、IMU、LiDAR和相機(jī)的車(chē)輛。另一方面,在線建圖使用輕量級(jí)模塊在自動(dòng)駕駛車(chē)輛上進(jìn)行。

所有有前途的建圖技術(shù)目前都使用LiDAR作為主要傳感器,特別是用于HD地圖。另一方面,也有一些方法只使用視覺(jué)傳感器構(gòu)建地圖,如Mobileye的REM,或稱(chēng)為roadbook,它基于視覺(jué)SLAM和深度學(xué)習(xí)[35]。

創(chuàng)建HD地圖通常涉及采集高質(zhì)量的點(diǎn)云、對(duì)準(zhǔn)同一場(chǎng)景的多個(gè)點(diǎn)云、標(biāo)記地圖元素以及頻繁更新地圖。這個(gè)過(guò)程需要大量人力和時(shí)間,限制了其可擴(kuò)展性。BEV感知[25,29]具有在線學(xué)習(xí)地圖的潛力,它根據(jù)局部傳感器觀察動(dòng)態(tài)地構(gòu)建高清地圖,這可能是一種可以為自動(dòng)駕駛汽車(chē)提供語(yǔ)義和先驗(yàn)幾何信息的更具可擴(kuò)展性的方式,。

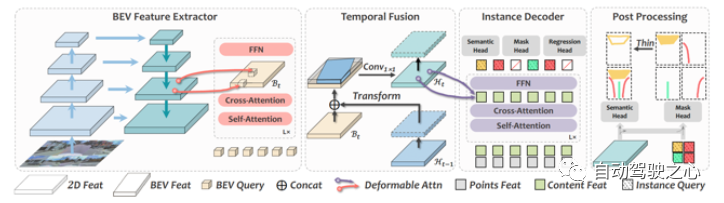

在這里,我們介紹在線建圖的最新工作,稱(chēng)為MachMap[45],它將高清地圖構(gòu)建公式化為BEV空間中的點(diǎn)檢測(cè)范式,以端到端的方式。基于地圖緊湊方案,它遵循基于查詢(xún)的范式,集成了CNN基礎(chǔ)架構(gòu)(如InternImage),基于時(shí)間的實(shí)例解碼器和點(diǎn)掩膜耦合頭。

圖 8 MachMap框架

MachMap的框架如圖8所示。它通過(guò)圖像骨干和周?chē)鷪D像的頸部從每個(gè)視圖生成2D特征。然后,可變形注意力用于聚合不同視圖之間的3D特征,并沿z軸對(duì)其進(jìn)行平均。在時(shí)間融合模塊中,新的BEV特征與BEV特征的隱藏狀態(tài)進(jìn)行融合。

利用實(shí)例級(jí)可變形注意力機(jī)制執(zhí)行實(shí)例解碼器可以完善內(nèi)容和點(diǎn)特征并獲得最終結(jié)果。

6 定位

自動(dòng)駕駛車(chē)輛的精準(zhǔn)定位可對(duì)下游任務(wù)(如行為規(guī)劃)產(chǎn)生巨大的影響。雖然使用傳統(tǒng)的動(dòng)態(tài)傳感器(如IMU和GPS)可以獲得可接受的結(jié)果,但基于視覺(jué)的傳感器(LiDAR或相機(jī))顯然更適合這項(xiàng)任務(wù),因?yàn)槭褂眠@類(lèi)傳感器獲得的定位結(jié)果同時(shí)依賴(lài)于車(chē)輛本身及其周?chē)沫h(huán)境。雖然這兩種傳感器都具有良好的定位性能,但它們也存在一些局限性[27]。

多年來(lái),研究者一直在研究自動(dòng)駕駛汽車(chē)定位,這大多數(shù)情況下是與建圖一起進(jìn)行的,這帶來(lái)了兩種不同的路線:第一種是SLAM,即定位和建圖同時(shí)循環(huán)運(yùn)行;第二種是將定位和建圖分開(kāi),直接離線構(gòu)建地圖。

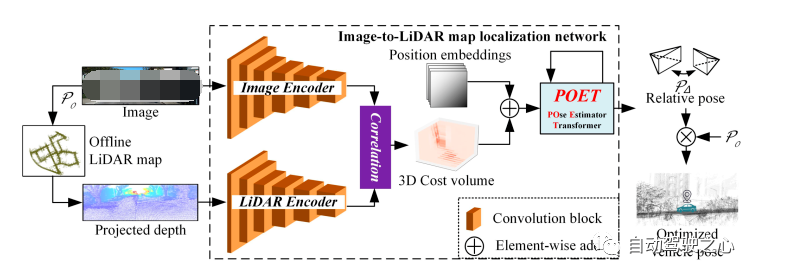

最近,深度學(xué)習(xí)為SLAM帶來(lái)了新的數(shù)據(jù)驅(qū)動(dòng)的方法,尤其是更具挑戰(zhàn)性的視覺(jué)SLAM,這在論文[28]中有所提及。這里我們討論一個(gè)基于Transformer定位方法的例子[48],其中獲取姿勢(shì)是通過(guò)所提出的POse Estimator Transformer(POET)模塊使用注意機(jī)制與從跨模型特征中檢索到的相關(guān)信息交互來(lái)更新的。定位架構(gòu)如圖9所示。

圖 9 使用Transformers進(jìn)行地圖定位

如圖9所示,該網(wǎng)絡(luò)以RGB圖像和LiDAR地圖上給定初始姿態(tài)的相鄰點(diǎn)云的重投影深度圖像作為輸入。然后,它們分別通過(guò)對(duì)應(yīng)的編碼器進(jìn)行處理以獲得高維特征。之后,進(jìn)行圖像特征和LiDAR特征融合,獲得融合特征。之后,把位置信息添加到融合特征后,將融合特征輸入到所提出的POET模塊中。

POET將融合特征作為輸入并初始化姿勢(shì)信息。經(jīng)過(guò)與融合特征相關(guān)信息的迭代更新,姿勢(shì)信息可以被優(yōu)化為圖像與初始姿態(tài)之間高精度的相對(duì)姿態(tài)。

這里應(yīng)用了DETR解碼器來(lái)更新姿勢(shì)信息。解碼器由交替堆疊的自注意層和交叉注意層組成。自注意力在姿勢(shì)信息內(nèi)計(jì)算,而交叉注意力在姿勢(shì)信息和處理過(guò)的代價(jià)量之間計(jì)算。

7 規(guī)劃

大多數(shù)規(guī)劃方法,尤其是行為規(guī)劃,是基于規(guī)則的[1,2,7-8],這為數(shù)據(jù)驅(qū)動(dòng)系統(tǒng)的探索和升級(jí)帶來(lái)了巨大的負(fù)擔(dān)。基于規(guī)則的規(guī)劃框架負(fù)責(zé)為車(chē)輛的低級(jí)控制器要跟蹤的軌跡點(diǎn)序列。基于規(guī)則的規(guī)劃框架的優(yōu)點(diǎn)是具有可解釋性,當(dāng)出現(xiàn)故障或意外的系統(tǒng)行為時(shí),可以識(shí)別有缺陷的模塊。其局限性在于需要許多手動(dòng)啟發(fā)式功能。

基于學(xué)習(xí)的規(guī)劃方法已成為自動(dòng)駕駛研究中的一種趨勢(shì)[15,18,33]。駕駛模型可以通過(guò)仿真學(xué)習(xí)獲取知識(shí),并通過(guò)強(qiáng)化學(xué)習(xí)探索駕駛策略。與基于規(guī)則的方法相比,基于學(xué)習(xí)的方法可以更有效地處理車(chē)輛與環(huán)境的交互。盡管其概念吸引人,但當(dāng)模型行為不當(dāng)時(shí),很難甚至不可能找出原因。

仿真學(xué)習(xí)(IL)是指基于專(zhuān)家軌跡的智能體學(xué)習(xí)策略。每個(gè)專(zhuān)家軌跡都包含一系列狀態(tài)和動(dòng)作,并且所有"狀態(tài)-動(dòng)作"對(duì)都被提取來(lái)構(gòu)建數(shù)據(jù)集。IL的具體目標(biāo)是評(píng)估狀態(tài)與動(dòng)作之間最適合的映射,以便智能體盡可能接近專(zhuān)家軌跡。

為了緩解標(biāo)注數(shù)據(jù)的負(fù)擔(dān),一些科學(xué)家已經(jīng)將強(qiáng)化學(xué)習(xí)(RL)算法應(yīng)用于行為規(guī)劃或決策制定。智能體可以通過(guò)與環(huán)境交互獲得一些獎(jiǎng)勵(lì)。RL的目標(biāo)是通過(guò)試誤來(lái)優(yōu)化累積數(shù)值獎(jiǎng)勵(lì)。通過(guò)與環(huán)境持續(xù)交互,智能體逐步獲得關(guān)于達(dá)到目標(biāo)端點(diǎn)的最佳策略的知識(shí)。在RL中從零開(kāi)始訓(xùn)練策略通常很耗時(shí)且具有挑戰(zhàn)性。將RL與其他方法(如IL和課程學(xué)習(xí))相結(jié)合可能是一個(gè)可行的解決方案。

近年來(lái),深度學(xué)習(xí)(DL)技術(shù)通過(guò)深度神經(jīng)網(wǎng)絡(luò)(DNN)的奇妙特性:函數(shù)逼近和表征學(xué)習(xí),為行為規(guī)劃問(wèn)題提供了強(qiáng)大的解決方案。DL技術(shù)使RL/IL能夠擴(kuò)展到以前難以解決的問(wèn)題(如高維狀態(tài)空間)。

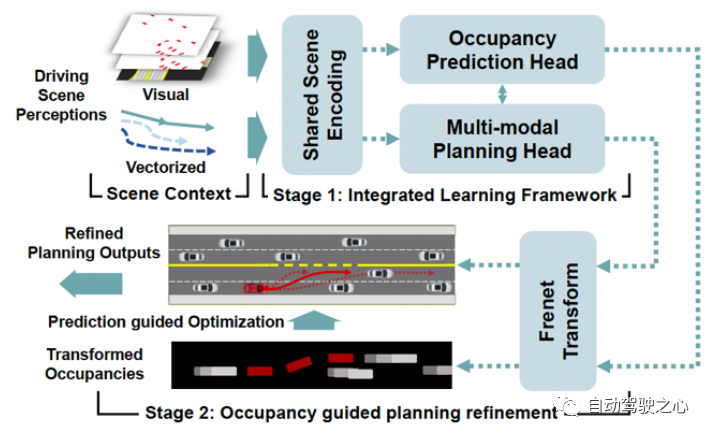

這里介紹一個(gè)兩階段占位預(yù)測(cè)引導(dǎo)的神經(jīng)規(guī)劃器(OPGP)[46],它將未來(lái)占位和運(yùn)動(dòng)規(guī)劃的聯(lián)合預(yù)測(cè)與預(yù)測(cè)引導(dǎo)相結(jié)合,如圖10所示。

圖 10 兩階段式OPGP

在OPGP的第一階段,在基于Transformer骨干上建立了一個(gè)集成網(wǎng)絡(luò)。視覺(jué)特征是歷史占用柵格和柵格化BEV路線圖的組合,代表特定場(chǎng)景下交通參與者的空間-時(shí)間狀態(tài)。矢量化上下文最初關(guān)注以自動(dòng)駕駛車(chē)輛為中心的參與者的動(dòng)態(tài)上下文。考慮到視覺(jué)特征和矢量化上下文的交互,同時(shí)輸出所有類(lèi)型交通參與者的占位預(yù)測(cè)。同時(shí),編碼后的場(chǎng)景特征和占位情況在規(guī)劃頭中共享并實(shí)現(xiàn)有條件地查詢(xún),規(guī)劃頭進(jìn)行多模態(tài)運(yùn)動(dòng)規(guī)劃。

OPGP第二階段的重點(diǎn)是以一種優(yōu)化可行的方式為細(xì)化建模來(lái)自占用率預(yù)測(cè)的明確指導(dǎo)。更具體地說(shuō),他們?cè)贔renet空間(這是一個(gè)由切線和曲率決定的移動(dòng)右旋坐標(biāo)系)中構(gòu)建了一個(gè)優(yōu)化過(guò)程,用于使用變換后的占用率預(yù)測(cè)進(jìn)行規(guī)劃細(xì)化。

8 控制

與自動(dòng)駕駛中的其他模塊(如感知和規(guī)劃)相比,車(chē)輛控制相對(duì)成熟,經(jīng)典控制理論發(fā)揮著主要作用[20,21]。然而,深度學(xué)習(xí)方法不僅能在各種非線性控制問(wèn)題上獲得優(yōu)異的性能,還能將先前學(xué)習(xí)到的規(guī)則外推到新的場(chǎng)景中,因此在自動(dòng)駕駛控制領(lǐng)域的應(yīng)用前景十分廣闊。因此,深度學(xué)習(xí)在自動(dòng)駕駛控制中的應(yīng)用正變得越來(lái)越流行[13]。

傳感器的配置多種多樣;有些人僅通過(guò)視覺(jué)來(lái)控制車(chē)輛,有些人則利用測(cè)距傳感器(LiDAR或雷達(dá)),還有些人利用多傳感器。在控制目標(biāo)方面也存在差異,有些人將系統(tǒng)設(shè)計(jì)為一個(gè)高級(jí)控制器提供目標(biāo),然后通過(guò)低級(jí)控制器實(shí)現(xiàn)目標(biāo),這種方式通常使用經(jīng)典控制技術(shù)。另一些則旨在端到端學(xué)習(xí)的自動(dòng)駕駛,將觀測(cè)結(jié)果直接映射到低級(jí)車(chē)輛控制界面命令。

車(chē)輛控制可以分為橫向控制和縱向控制。橫向控制系統(tǒng)旨在控制車(chē)輛在車(chē)道上的位置,并實(shí)現(xiàn)其他橫向動(dòng)作,如變道和回避碰撞動(dòng)作。在深度學(xué)習(xí)領(lǐng)域,這通常是通過(guò)使用車(chē)載相機(jī)的圖像/LiDAR的點(diǎn)云捕捉環(huán)境信息作為神經(jīng)網(wǎng)絡(luò)的輸入來(lái)實(shí)現(xiàn)的。

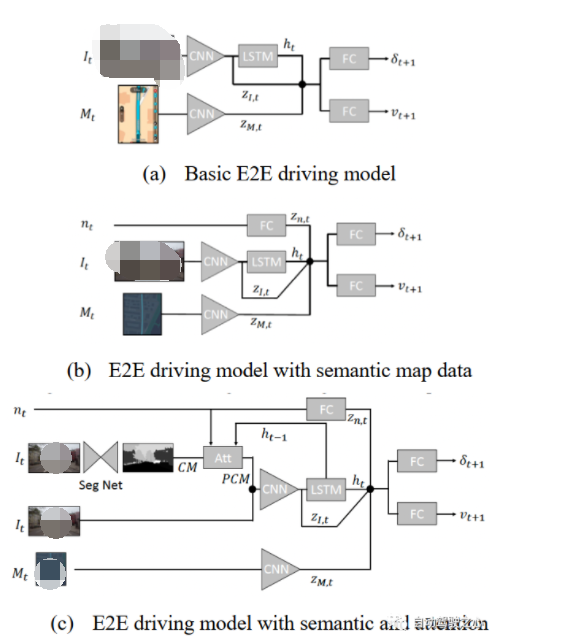

在本節(jié)中,我們將介紹一種帶有語(yǔ)義視覺(jué)地圖和相機(jī)的端到端(E2E)駕駛模型[16]。仿真人類(lèi)駕駛是通過(guò)對(duì)抗學(xué)習(xí)來(lái)實(shí)現(xiàn)的,其中一個(gè)生成器模仿人類(lèi)駕駛員,一個(gè)識(shí)別器使其像人類(lèi)駕駛員。

訓(xùn)練數(shù)據(jù)(名稱(chēng)為"Drive360數(shù)據(jù)集")由前置相機(jī)和渲染的TomTom路線規(guī)劃模塊采集。然后采用HERE地圖數(shù)據(jù)對(duì)數(shù)據(jù)集進(jìn)行離線增強(qiáng),以提供同步的語(yǔ)義地圖信息。

圖 11 E2E駕駛模式框架

對(duì)于基本的E2E駕駛模型,記錄歷史圖像和地圖渲染序列,并預(yù)測(cè)動(dòng)作。網(wǎng)絡(luò)結(jié)構(gòu)如圖11(a)所示:圖像通過(guò)視覺(jué)編碼器輸入,輸出的潛變量進(jìn)一步輸入LSTM,從而產(chǎn)生隱藏狀態(tài)h;地圖渲染也在視覺(jué)編碼器中處理,產(chǎn)生另一個(gè)潛變量量;然后將這三個(gè)變量連接起來(lái)預(yù)測(cè)動(dòng)作。 ? 帶有額外語(yǔ)義地圖信息的簡(jiǎn)單方法稱(chēng)為后融合方法,其示意圖如圖11(b)所示:一個(gè)向量嵌入所有語(yǔ)義地圖信息,經(jīng)過(guò)全連接網(wǎng)絡(luò)處理,輸出潛在變量量與、和h連接。 ? 最近,一種新方法被提出:根據(jù)語(yǔ)義圖信息提高分割網(wǎng)絡(luò)的輸出類(lèi)別概率,其完整架構(gòu)如圖11(c)所示。該方法使用語(yǔ)義分割網(wǎng)絡(luò)獲得所有19個(gè)類(lèi)別的置信度掩碼,然后使用軟注意力網(wǎng)絡(luò)使該掩碼生成19個(gè)類(lèi)別的注意力向量。 ? 在訓(xùn)練駕駛模型時(shí),決策問(wèn)題可以被視為匹配動(dòng)作序列(稱(chēng)為drivelets)的監(jiān)督回歸問(wèn)題。因此可以使用生成對(duì)抗網(wǎng)絡(luò)(GAN)來(lái)制定模仿學(xué)習(xí)問(wèn)題,其中生成器是駕駛模型,判別器識(shí)別drivelet是否類(lèi)似于人類(lèi)規(guī)劃的路徑。 ?

9 V2X

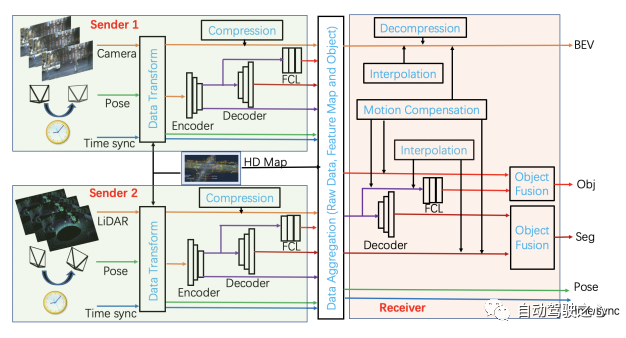

得益于通信基礎(chǔ)設(shè)施的完善和通信技術(shù)的發(fā)展(如車(chē)聯(lián)網(wǎng)(V2X)通信等),車(chē)輛可以通過(guò)可靠的方式傳遞信息,從而實(shí)現(xiàn)車(chē)輛之間的協(xié)作[4,11]。協(xié)同駕駛利用車(chē)對(duì)車(chē)(V2V)和車(chē)對(duì)基礎(chǔ)設(shè)施(V2I)通信技術(shù),旨在實(shí)現(xiàn)協(xié)同功能:(i)協(xié)同感知和(ii)協(xié)同操縱。 ? 有一些通用的協(xié)同駕駛場(chǎng)景:智能停車(chē)、變道和并線以及交叉路口協(xié)同管理。車(chē)輛隊(duì)列(Vehicle Platooning),也稱(chēng)為車(chē)隊(duì)駕駛,是指兩輛或兩輛以上的車(chē)輛連續(xù)在同一車(chē)道上以較小的的車(chē)間距(通常小于1秒)同速并排行駛,這是實(shí)現(xiàn)合作自動(dòng)駕駛的一個(gè)主要用例[26]。 ? 采用集中式或分散式的策略進(jìn)行有價(jià)值的研究工作主要集中在協(xié)調(diào)交叉路口的CAV和高速公路入口匝道上的并線上。在集中式的策略中,系統(tǒng)中至少有一項(xiàng)任務(wù)是由單個(gè)中央控制器控制所有車(chē)輛的。在分散控制中,每輛車(chē)根據(jù)從道路上其他車(chē)輛或協(xié)調(diào)器接收到的信息選擇自己的控制策略。 ? 分散式的策略可分為三種類(lèi)型:協(xié)商、協(xié)議和緊急。最有代表性的協(xié)商類(lèi)型是:協(xié)同合作問(wèn)題和博弈競(jìng)爭(zhēng)問(wèn)題。協(xié)調(diào)過(guò)程的協(xié)議將產(chǎn)生一系列可接受的措施,甚至動(dòng)態(tài)地重新確定目標(biāo)。緊急問(wèn)題使得每輛車(chē)根據(jù)自己的目標(biāo)和感知,以一種有利于自己的方式規(guī)劃,例如博弈論或自組織。 ? 與單車(chē)感知不同,協(xié)同感知可以利用多個(gè)智能體之間的交互來(lái)豐富自動(dòng)駕駛系統(tǒng)的感知,因此受到了廣泛關(guān)注[31]。隨著深度學(xué)習(xí)方法被廣泛應(yīng)用于自動(dòng)駕駛感知系統(tǒng),協(xié)同感知系統(tǒng)的能力和可靠性也在穩(wěn)步增加。 ? 根據(jù)信息傳遞和協(xié)同階段,協(xié)同感知方案可大致分為早期協(xié)同、中期協(xié)同和后期協(xié)同。早期協(xié)同采用網(wǎng)絡(luò)輸入端的原始數(shù)據(jù)融合,也稱(chēng)為數(shù)據(jù)級(jí)融合或低級(jí)融合。考慮到早期協(xié)同的高帶寬,一些工作提出了中間協(xié)同方法,以平衡性能和帶寬之間的權(quán)衡。后期協(xié)同或?qū)ο蠹?jí)協(xié)同采用網(wǎng)絡(luò)預(yù)測(cè)融合。協(xié)同感知的挑戰(zhàn)性問(wèn)題包括:標(biāo)定、車(chē)輛定位、時(shí)空同步等。 ?

圖 12 V2X協(xié)同感知示意圖 ? 這里我們提出了一個(gè)多層的V2X感知平臺(tái),如圖12所示。時(shí)間同步信息處理不同智能體的數(shù)據(jù)之間的時(shí)間差異。為了靈活性,數(shù)據(jù)容器優(yōu)先保留一個(gè)時(shí)間窗口,例如1秒(LiDAR/雷達(dá)為10幀,相機(jī)為30幀)。空間構(gòu)建需要姿態(tài)信息,姿態(tài)信息從車(chē)輛定位和標(biāo)定中獲取,大多基于在線地圖或與離線建立的HD地圖信息進(jìn)行匹配。 ? 我們假設(shè)傳感器是相機(jī)和LiDAR。神經(jīng)網(wǎng)絡(luò)模型可以處理原始數(shù)據(jù),包括:輸出中間表征(IR)、場(chǎng)景分割和目標(biāo)檢測(cè)。為統(tǒng)一協(xié)同空間,原始數(shù)據(jù)映射到BEV(鳥(niǎo)瞰視圖),處理結(jié)果也位于相同的空間中。 ? 為了保持有限的尺度空間,保留多個(gè)IR層,如3層,這允許不同數(shù)據(jù)分辨率的靈活融合。V2X協(xié)同感知需要接收端做更多工作,整合來(lái)自其他車(chē)輛和路側(cè)的信息,分別融合IR、分割和檢測(cè)。融合模塊可以使用CNN、Transformer或圖神經(jīng)網(wǎng)絡(luò)(GNN)。 注意:FCL代表全連接層原始數(shù)據(jù)需要"壓縮"模塊和"解壓縮"模塊;"插值"模塊和"運(yùn)動(dòng)補(bǔ)償"模塊對(duì)基于時(shí)間同步的信號(hào)和基于在線建圖/定位/HD地圖(離線構(gòu)建)的相對(duì)姿態(tài)的接收器都是有用的。 ?

10 仿真

在封閉道路或公共道路上進(jìn)行實(shí)車(chē)測(cè)試既不安全,成本又高,而且并不總是可重復(fù)的。模擬測(cè)試有助于填補(bǔ)這項(xiàng)空白,然而,模擬測(cè)試的問(wèn)題在于:它的好壞取決于用來(lái)測(cè)試的模擬器和模擬場(chǎng)景對(duì)于真實(shí)環(huán)境的代表性程度[17]。 ? 理想的仿真效果應(yīng)該盡可能接近現(xiàn)實(shí)。然而,這意味著模擬器必須模擬三維場(chǎng)景環(huán)境方面高度精細(xì),并在汽車(chē)物理等底層車(chē)輛計(jì)算方面非常精確。因此,需要在三維場(chǎng)景的精細(xì)度度和車(chē)輛動(dòng)力學(xué)的簡(jiǎn)化之間進(jìn)行權(quán)衡。 ? 一般來(lái)說(shuō),從虛擬場(chǎng)景中學(xué)到的駕駛知識(shí)需要遷移到現(xiàn)實(shí)世界中,因此如何將在模擬場(chǎng)景中學(xué)到的駕駛知識(shí)適應(yīng)到現(xiàn)實(shí)中成為一個(gè)關(guān)鍵問(wèn)題。虛擬世界和現(xiàn)實(shí)世界之間的差距通常被稱(chēng)為"現(xiàn)實(shí)差距"。為了處理這種差距,人們提出了各種方法,分為兩類(lèi):從仿真到現(xiàn)實(shí)的知識(shí)轉(zhuǎn)移(sim2real)和在數(shù)字孿生中學(xué)習(xí)(real2sim)[44]。 ? 在sim2real中逐漸發(fā)展出6種方法,包括課程學(xué)習(xí)、材料學(xué)習(xí)、知識(shí)提煉、魯棒性強(qiáng)化學(xué)習(xí)、領(lǐng)域隨機(jī)化和遷移學(xué)習(xí)。基于數(shù)字孿生的方法旨在利用傳感器和物理模型的數(shù)據(jù),在仿真環(huán)境中構(gòu)建真實(shí)世界物理實(shí)體的映射,達(dá)到反映相應(yīng)物理實(shí)體全生命周期過(guò)程的作用,如AR(增強(qiáng)現(xiàn)實(shí))和MR(混合現(xiàn)實(shí))。 ? 盡管仿真的自動(dòng)駕駛測(cè)試系統(tǒng)相對(duì)便宜而且安全,但為了評(píng)估而制作的安全關(guān)鍵場(chǎng)景對(duì)于管理風(fēng)險(xiǎn)和降低成本更為重要[22]。實(shí)際上,安全關(guān)鍵場(chǎng)景在現(xiàn)實(shí)世界中并不多見(jiàn),因此在仿真中生成這些場(chǎng)景數(shù)據(jù)的各種方法被投入研究,生成方式分為三種類(lèi)型:數(shù)據(jù)驅(qū)動(dòng)生成,即僅利用收集到的數(shù)據(jù)集信息生成場(chǎng)景;對(duì)抗生成,即利用部署在仿真中的自動(dòng)駕駛車(chē)輛的反饋信息生成場(chǎng)景;基于知識(shí)的生成,即主要利用外部知識(shí)信息作為生成場(chǎng)景的約束或指導(dǎo)。 ?

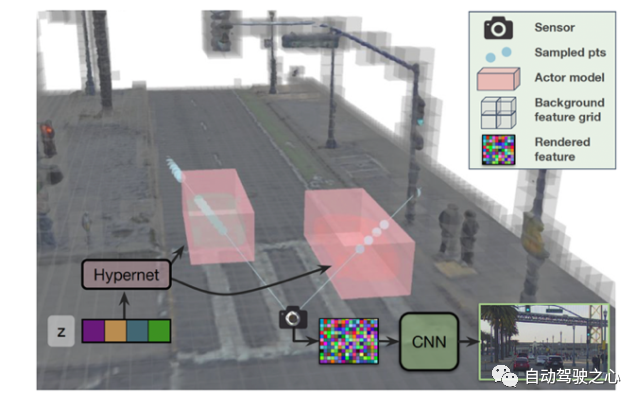

圖 13 UniSim傳感器模擬器概述 ? 這里我們報(bào)告一個(gè)最新的神經(jīng)傳感器仿真平臺(tái)[49]-UniSim,由Waabi、Toronto 和MIT構(gòu)建。UniSim將車(chē)輛傳感器捕獲的單個(gè)記錄日志轉(zhuǎn)換為逼真的閉環(huán)多傳感器仿真作為可編輯和可控制的數(shù)字孿生。圖13展示了UniSim的概況。 ? 如圖13所示,UniSim是一個(gè)神經(jīng)閉環(huán)仿真器,它聯(lián)合學(xué)習(xí)靜態(tài)場(chǎng)景和動(dòng)態(tài)行為者的形狀和外觀表示,從對(duì)環(huán)境的單次通過(guò)中捕獲的傳感器數(shù)據(jù)。為了更好地處理外推視角,為動(dòng)態(tài)對(duì)象引入了可學(xué)習(xí)的先驗(yàn)知識(shí),并利用卷積網(wǎng)絡(luò)完成未見(jiàn)區(qū)域。 ? 此外,UniSim中的3D場(chǎng)景被分為靜態(tài)背景(灰色)和一組動(dòng)態(tài)行為者(紅色)。神經(jīng)特征場(chǎng)對(duì)靜態(tài)背景和動(dòng)態(tài)行為者模型進(jìn)行單獨(dú)訪問(wèn),并執(zhí)行體繪制以生成神經(jīng)特征描述符。靜態(tài)場(chǎng)景由稀疏特征網(wǎng)格建模,并使用Hypernet從可學(xué)習(xí)潛在空間生成每個(gè)參與者的表示。最后,使用CNN將特征解碼為圖像。 ? 注意:一類(lèi)稱(chēng)為擴(kuò)散模型[50]的新興生成模型,具有正向過(guò)程和反向過(guò)程的通用過(guò)程,以學(xué)習(xí)數(shù)據(jù)分布以及采樣過(guò)程以生成新數(shù)據(jù),在計(jì)算機(jī)視覺(jué)中獲得了重大關(guān)注。最近,它在圖像到圖像、文本到圖像、3D形狀生成、人體運(yùn)動(dòng)合成、視頻合成等方面變得越來(lái)越受歡迎。期待擴(kuò)散模型為自動(dòng)駕駛中的仿真器合成可想象的駕駛場(chǎng)景內(nèi)容。 ?

11 安全性

安全性是實(shí)際部署自動(dòng)駕駛系統(tǒng)(ADS)的主要挑戰(zhàn)[19,23]。除了傳感器和網(wǎng)絡(luò)系統(tǒng)的可能受到傳統(tǒng)攻擊之外,基于人工智能或機(jī)器學(xué)習(xí)(包括深度學(xué)習(xí))的系統(tǒng),尤其需要考慮神經(jīng)網(wǎng)絡(luò)天生易受來(lái)自對(duì)抗性示例的對(duì)抗性攻擊所帶來(lái)的新的安全問(wèn)題。 ? ISO 26262道路車(chē)輛——功能安全是廣泛使用的安全指導(dǎo)標(biāo)準(zhǔn),僅適用于緩解與已知部件故障相關(guān)的已知不合理風(fēng)險(xiǎn)(即已知不安全情景)。但不適用于因復(fù)雜的環(huán)境變化以及ADS如何應(yīng)對(duì)它們而產(chǎn)生的AV駕駛風(fēng)險(xiǎn),而車(chē)輛不存在技術(shù)故障 ? 目前,對(duì)抗防御可以分為主動(dòng)防御和被動(dòng)防御。主動(dòng)防御集中于改善目標(biāo)AI模型的魯棒性,而被動(dòng)防御則針對(duì)檢測(cè)反向示例,然后再將它們反饋到模型中。主動(dòng)防御方法主要有五種類(lèi)型:對(duì)抗訓(xùn)練、網(wǎng)絡(luò)蒸餾、網(wǎng)絡(luò)正則化、模型集成和認(rèn)證防御。被動(dòng)防御主要包括以下兩類(lèi):對(duì)抗檢測(cè)和對(duì)抗轉(zhuǎn)換。 ? 可解釋性是由深度神經(jīng)網(wǎng)絡(luò)的黑盒特性引起的一個(gè)問(wèn)題。簡(jiǎn)單地說(shuō),它應(yīng)該為深度學(xué)習(xí)模型的行為提供人類(lèi)可以理解的解釋。解釋過(guò)程可以分為兩個(gè)步驟:提取步驟和展示步驟。提取步驟獲得中間表征,展示步驟以簡(jiǎn)單的方式將其呈現(xiàn)給人類(lèi)。在自動(dòng)駕駛中,可視化模型主干中的特征圖或管理解碼器輸出的損失,是增強(qiáng)可解釋性的有效方式。 ? 為了提供安全保證,需要針對(duì)ADS將面臨的現(xiàn)實(shí)世界中的各種場(chǎng)景進(jìn)行大量的驗(yàn)證和確認(rèn)(V&V)。V&V最大化場(chǎng)景覆蓋率的一個(gè)常規(guī)策略是在模擬生成的大量包含ADS的場(chǎng)景樣本。確保合理覆蓋率的方法分為兩類(lèi):基于場(chǎng)景抽樣的方法和形式化方法。 ? 場(chǎng)景抽樣方法是人工智能安全控制的主要方法,包括基于測(cè)試的抽樣和基于偽造的抽樣,基于測(cè)試的抽樣是為了以最小的代價(jià)獲得最大的場(chǎng)景覆蓋率,基于偽造的抽樣是為了發(fā)現(xiàn)開(kāi)發(fā)人員更關(guān)注的不常見(jiàn)案例,如安全關(guān)鍵場(chǎng)景。 ?

圖 14 SOTIF的目標(biāo)[23] ? ISO 21448《預(yù)定功能安全》(SOTIF)提出了一個(gè)定性目標(biāo),從高層次描述了如何最小化ADS功能設(shè)計(jì)中已知和未知的不安全場(chǎng)景后果[23],如圖14所示。基于采樣的方法在發(fā)現(xiàn)未知的不安全場(chǎng)景時(shí)偏差較小,更具探索性,并且從未知到已知的過(guò)程中,所有采樣場(chǎng)景都在一致的仿真環(huán)境和相同的保真度水平下進(jìn)行。 ? 在AV安全性中廣泛使用的常規(guī)方法包括模型檢查、可達(dá)性分析和定理證明。模型檢查來(lái)自軟件開(kāi)發(fā),以確保軟件行為遵循設(shè)計(jì)規(guī)范。當(dāng)安全規(guī)范以公理和引理描述時(shí),然后進(jìn)行定理證明以使用最壞情況假設(shè)來(lái)證明安全性。由于可達(dá)性分析可以對(duì)動(dòng)態(tài)駕駛?cè)蝿?wù)(DDT)的特征給出安全聲明,它估計(jì)DDT的特征,例如Mobileye的安全模型RSS(責(zé)任敏感安全)和Nvidia的安全模型SFF(安全力場(chǎng))。 ?

12 數(shù)據(jù)閉環(huán)

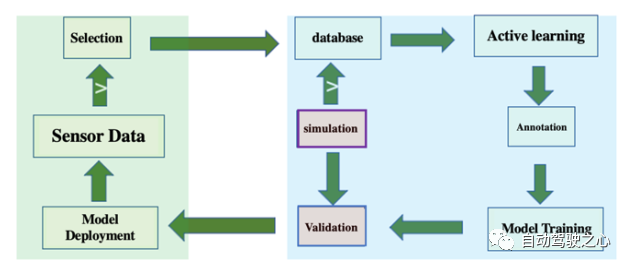

從車(chē)輛采集數(shù)據(jù)、篩選有價(jià)值的數(shù)據(jù)、標(biāo)注數(shù)據(jù)、訓(xùn)練/優(yōu)化預(yù)期模型、驗(yàn)證目標(biāo)模型并部署到車(chē)輛上等過(guò)程,構(gòu)成了自動(dòng)駕駛研發(fā)的數(shù)據(jù)閉環(huán)[37-41],如圖15所示。 ?

圖 15 自動(dòng)駕駛研發(fā)的數(shù)據(jù)閉環(huán) ? 作為自動(dòng)駕駛研發(fā)平臺(tái),數(shù)據(jù)閉環(huán)應(yīng)包括客戶(hù)端車(chē)端和服務(wù)器云端,實(shí)現(xiàn)車(chē)端數(shù)據(jù)采集和初步篩選、云端數(shù)據(jù)庫(kù)基于主動(dòng)學(xué)習(xí)的挖掘、自動(dòng)標(biāo)注、模型訓(xùn)練和仿真測(cè)試(仿真數(shù)據(jù)也可加入模型訓(xùn)練)、模型部署回車(chē)端。數(shù)據(jù)選擇/篩選和數(shù)據(jù)標(biāo)注/標(biāo)注是決定數(shù)據(jù)閉環(huán)效率的關(guān)鍵模塊。 ?

12.1 數(shù)據(jù)選擇

特斯拉是第一家在量產(chǎn)車(chē)上明確提出數(shù)據(jù)選擇策略的公司,被稱(chēng)為在線"影子模式"。可以看出,數(shù)據(jù)選擇分為兩種方式:一種是在線方式,將數(shù)據(jù)采集的觸發(fā)模式設(shè)置在人類(lèi)駕駛的車(chē)輛上,這樣可以最經(jīng)濟(jì)地采集到所需的數(shù)據(jù);這種方式大多用于量產(chǎn)和商務(wù)階段(注:商務(wù)車(chē)配備安全操作員通常直接手動(dòng)觸發(fā)采集)。另一種是離線數(shù)據(jù)庫(kù)模式,一般采用數(shù)據(jù)挖掘模式,在云服務(wù)器中對(duì)增量數(shù)據(jù)進(jìn)行篩選,這種模式常用于研發(fā)階段,即使是量產(chǎn)階段采集的數(shù)據(jù)也會(huì)在服務(wù)器端數(shù)據(jù)中心進(jìn)行二次篩選;此外,在已知場(chǎng)景或目標(biāo)數(shù)據(jù)嚴(yán)重缺乏的情況下,也可以在車(chē)輛或服務(wù)器端設(shè)置"內(nèi)容搜索"模式,搜索類(lèi)似的物體、場(chǎng)景或場(chǎng)景數(shù)據(jù),以提高訓(xùn)練數(shù)據(jù)的多樣性和模型的泛化能力。 ? 在自動(dòng)駕駛領(lǐng)域,邊緣情況也有等同或類(lèi)似的概念,如異常數(shù)據(jù)、新奇數(shù)據(jù)、異常值數(shù)據(jù)、分布外數(shù)據(jù)(OOD)等。邊緣情況檢測(cè)可分為在線和離線兩種模式。在線模式通常用作安全監(jiān)測(cè)和預(yù)警系統(tǒng),而離線模式通常用于在實(shí)驗(yàn)室中開(kāi)發(fā)新算法,選擇合適的訓(xùn)練和測(cè)試數(shù)據(jù)。邊緣情況可以定義在幾個(gè)不同的層次:1)像素/體素;2)域;3)對(duì)象;4)場(chǎng)景;5)情景。最后一個(gè)情景級(jí)別的極端情況通常不僅與感知相關(guān),還涉及預(yù)測(cè)和決策規(guī)劃。 ?

圖 16 在線和離線數(shù)據(jù)選擇 ? 在此,我們提出一個(gè)在線和離線數(shù)據(jù)選擇框架,如圖16所示。在圖16(a)所示的在線模式下,我們采用多種篩選路徑,如場(chǎng)景搜索、陰影模式、駕駛操作和單類(lèi)分類(lèi)。在內(nèi)容搜索模式下,基于給定的查詢(xún),"場(chǎng)景/情景搜索"模塊從圖像或連續(xù)幀中提取特征(空間或時(shí)間信息)進(jìn)行模式匹配,以發(fā)現(xiàn)特定的對(duì)象、情境或交通行為,例如夜間街道上出現(xiàn)的摩托車(chē)、惡劣天氣下高速公路上的大貨車(chē)、環(huán)島中的車(chē)輛和行人、高速路上的變道、街道交叉口的掉頭行為等。 ? “陰影模式"模塊根據(jù)車(chē)載自動(dòng)駕駛系統(tǒng)(ADS)的結(jié)果進(jìn)行判斷,如感知模塊中不同攝像頭檢測(cè)到的物體匹配錯(cuò)誤、連續(xù)幀檢測(cè)到的抖動(dòng)或突然消失、隧道出入口強(qiáng)烈的光照變化,以及決策規(guī)劃中要求車(chē)輛減速但車(chē)輛實(shí)際加速或要求車(chē)輛加速但車(chē)輛實(shí)際減速的行為,檢測(cè)到前方障礙物但未試圖避讓、變道時(shí)接近并幾乎與后側(cè)攝像頭檢測(cè)到的車(chē)輛相撞等異常情況。 ? ”駕駛操作"模塊將從車(chē)輛CAN總線獲得的偏航率、速度等數(shù)據(jù)中檢測(cè)異常情況,如奇怪的之字形現(xiàn)象、過(guò)度加速或制動(dòng)、大角度轉(zhuǎn)向或轉(zhuǎn)彎角度,甚至觸發(fā)突然緊急制動(dòng)(AEB)。 ? "單類(lèi)分類(lèi)"模塊一般為感知、預(yù)測(cè)和規(guī)劃中的數(shù)據(jù)進(jìn)行訓(xùn)練異常檢測(cè)器,這是一種廣義的數(shù)據(jù)驅(qū)動(dòng)的"影子模式";它依據(jù)感知特征、預(yù)測(cè)軌跡和規(guī)劃路徑的正常駕駛數(shù)據(jù);對(duì)于車(chē)端的輕量化任務(wù),則采用單類(lèi)SVM模型。 ? 最后,根據(jù)采集路徑對(duì)"數(shù)據(jù)采集"模塊中對(duì)采集到的數(shù)據(jù)進(jìn)行標(biāo)注。 ? 對(duì)于圖16(b)所示的離線模式,我們同樣選擇多條路徑進(jìn)行數(shù)據(jù)篩選。無(wú)論是從研發(fā)數(shù)據(jù)采集車(chē)還是量產(chǎn)商業(yè)車(chē)上采集的新數(shù)據(jù),都將存儲(chǔ)在"臨時(shí)存儲(chǔ)"硬盤(pán)中,以備二次選擇。同樣,另一個(gè)"場(chǎng)景/情景搜索"模塊根據(jù)定義的某種情景的直接檢索數(shù)據(jù)。應(yīng)用的算法/模型規(guī)模更大,計(jì)算耗時(shí)更長(zhǎng),但不受實(shí)時(shí)性的限制。此外,還可以使用數(shù)據(jù)挖掘技術(shù)。聚類(lèi)"模塊將執(zhí)行一些無(wú)監(jiān)督的分組方法或密度估計(jì)方法來(lái)生成場(chǎng)景聚類(lèi)。因此,某些遠(yuǎn)離聚類(lèi)中心點(diǎn)的數(shù)據(jù)會(huì)產(chǎn)生異常。 ? 為了進(jìn)一步篩選數(shù)據(jù),可以分步驟在數(shù)據(jù)上運(yùn)行自動(dòng)駕駛軟件(如LogSim風(fēng)格),并可以在一系列設(shè)計(jì)的檢查點(diǎn)上檢測(cè)到異常。這里,自動(dòng)駕駛采用模塊化過(guò)程,包括"感知/定位/融合"模塊、"預(yù)測(cè)/時(shí)間域融合"模塊和"規(guī)劃和決策"模塊。每個(gè)模塊的輸出是一個(gè)檢查點(diǎn),通過(guò)"單類(lèi)分類(lèi)"模塊檢測(cè)異常。因?yàn)闆](méi)有實(shí)時(shí)限制,所采用這種異常檢測(cè)器更復(fù)雜。在服務(wù)器端,可以使用深度神經(jīng)網(wǎng)絡(luò)進(jìn)行單類(lèi)分類(lèi)。這是一種離線的“影子模式”。 ?

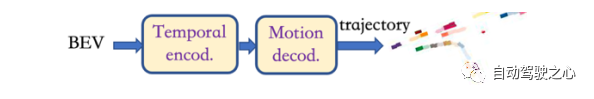

圖 17 預(yù)測(cè)模塊 ? "感知/定位/融合"模塊的架構(gòu)與圖6相似。"預(yù)測(cè)/時(shí)空融合"模塊作為額外的輸出頭,其結(jié)構(gòu)圖如圖17所示。特征進(jìn)入"時(shí)序編碼"模塊,該模塊的結(jié)構(gòu)可以設(shè)計(jì)為類(lèi)似于RNN(GRU或LSTM)模型或基于圖神經(jīng)網(wǎng)絡(luò)(GNN)的交互建模器,融合多幀特征。運(yùn)動(dòng)解碼"模塊理解類(lèi)似于BEVerse模型的時(shí)空特征,并輸出預(yù)測(cè)軌跡。 ?

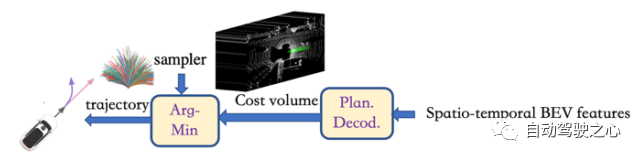

圖 18 規(guī)劃和決策模塊 ? 在感知和預(yù)測(cè)的基礎(chǔ)上,我們?cè)O(shè)計(jì)了與ST-P3類(lèi)似的規(guī)劃決策算法框圖,如圖18所示。基于預(yù)測(cè)輸出的BEV時(shí)空特征,我們選擇了基于采樣的規(guī)劃方法,在 "Plan Decod"模塊中訓(xùn)練代價(jià)函數(shù)來(lái)計(jì)算采樣器生成的各種軌跡,并在"ArgMin"模塊中找到代價(jià)最小的軌跡。代價(jià)函數(shù)包括安全性(避開(kāi)障礙物)、交通規(guī)則和軌跡平滑性(加速度和曲率)等方面。最后,對(duì)整個(gè)感知-預(yù)測(cè)-規(guī)劃過(guò)程的全局損失函數(shù)進(jìn)行優(yōu)化。 ? 綜上所述,BEV/Occupancy網(wǎng)絡(luò)為基礎(chǔ)的感知、預(yù)測(cè)和規(guī)劃構(gòu)成了一個(gè)端到端的自動(dòng)駕駛解決方案,稱(chēng)為BP3。 ?

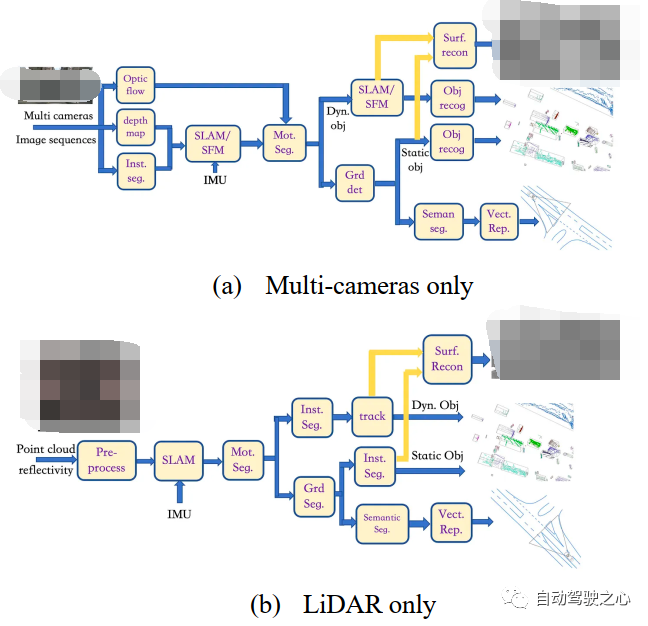

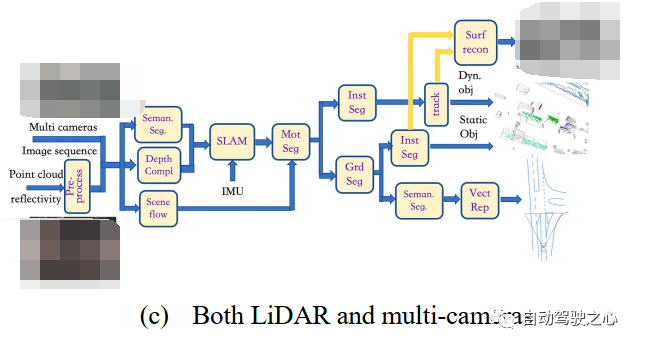

12.2 數(shù)據(jù)標(biāo)注

數(shù)據(jù)標(biāo)注的任務(wù)分為研發(fā)階段和量產(chǎn)階段:1)研發(fā)階段主要涉及研發(fā)團(tuán)隊(duì)的數(shù)據(jù)采集車(chē),包括LiDAR,使LiDAR能夠?yàn)橄鄼C(jī)的圖像數(shù)據(jù)提供三維點(diǎn)云數(shù)據(jù),從而提供三維地面真實(shí)值。例如,BEV(鳥(niǎo)瞰)視覺(jué)感知需要從二維圖像中獲取BEV輸出,這涉及到透視投影和三維信息推測(cè);2)在量產(chǎn)階段,數(shù)據(jù)主要由乘用車(chē)客戶(hù)或商用車(chē)運(yùn)營(yíng)客戶(hù)提供。其中大部分沒(méi)有LiDAR數(shù)據(jù),或者只有有限FOV(如前向)的三維點(diǎn)云。因此,對(duì)于相機(jī)圖像輸入,需要估計(jì)或重建三維數(shù)據(jù)以進(jìn)行標(biāo)注。 ? 在圖6中,我們展示了基于深度學(xué)習(xí)的端到端(E2E)數(shù)據(jù)標(biāo)注模型。然而,為了訓(xùn)練這樣一個(gè)E2E模型,我們需要大量的標(biāo)注數(shù)據(jù)。為了緩解數(shù)據(jù)需求,我們提出了一個(gè)半傳統(tǒng)的標(biāo)注框架,它是經(jīng)典計(jì)算機(jī)視覺(jué)和深度學(xué)習(xí)的混合體,如圖19所示。

?

圖 19 半傳統(tǒng)的數(shù)據(jù)標(biāo)注框架 ? 對(duì)于僅相機(jī)多輸入,如圖19(a)所示,我們首先在多個(gè)相機(jī)的圖像序列中使用三個(gè)模塊,即"inst seg"、"depth map"和"optical flow",以計(jì)算實(shí)例分割圖、深度圖和光流圖;"inst seg"模塊使用深度學(xué)習(xí)模型定位和分類(lèi)一些對(duì)象像素,如車(chē)輛和行人;"depth map"模塊使用深度學(xué)習(xí)模型根據(jù)單目視頻估計(jì)兩個(gè)連續(xù)幀之間的像素運(yùn)動(dòng),形成虛擬立體視覺(jué)來(lái)推斷深度圖;"optical flow"模塊使用深度學(xué)習(xí)模型直接推斷兩個(gè)連續(xù)幀之間的像素運(yùn)動(dòng);基于深度圖估計(jì),"SLAM/SFM"模塊可以獲得類(lèi)似RGB-D+IMU傳感器的稠密3D重構(gòu)點(diǎn)云;與此同時(shí),實(shí)例分割結(jié)果實(shí)際上可以剔除障礙物,如車(chē)輛和行人;通過(guò)"motseg"模塊,獲得的各種運(yùn)動(dòng)障礙物將在下一個(gè)"SLAM/SFM"模塊(不輸入IMU)中重建,這類(lèi)似于RGB-D傳感器的SLAM架構(gòu),可以看作單目SLAM的擴(kuò)展;然后,它將"instseg"的結(jié)果轉(zhuǎn)移到"obj recog"模塊,并標(biāo)注點(diǎn)云的3D包圍框;對(duì)于靜態(tài)背景,"grd det"模塊將區(qū)分靜態(tài)障礙物和道路點(diǎn)云,以便靜止障礙物(如停車(chē)車(chē)輛和交通錐)將"inst seg"模塊的結(jié)果轉(zhuǎn)移到"obj recog"模塊,對(duì)點(diǎn)云的3D邊界框進(jìn)行標(biāo)注;從"SLAM/SFM"模塊獲得的動(dòng)態(tài)對(duì)象點(diǎn)云和從"grd det"模塊獲得的靜態(tài)對(duì)象點(diǎn)云進(jìn)入"Surf Recon"模塊進(jìn)行泊松重建;道路表面點(diǎn)云僅提供擬合的3D道路表面;從圖像域"inst seg"模塊可以獲得道路表面區(qū)域;基于自身運(yùn)動(dòng)學(xué),可以進(jìn)行圖像拼接;在"seman seg"模塊在拼接的道路表面圖像之后,可以獲得車(chē)道標(biāo)線、斑馬線和道路邊界;然后,在"vectrep"模塊中使用多線標(biāo)注;最后,所有標(biāo)注都投影到車(chē)輛坐標(biāo)系上,得到一幀的最終標(biāo)注。 ? 圖19(b)所示,對(duì)于僅LiDAR輸入,我們經(jīng)過(guò)"預(yù)處理"模塊、"SLAM"模塊和"mot seg "模塊。在"inst seg"模塊中,直接對(duì)不同于背景的運(yùn)動(dòng)物體進(jìn)行基于點(diǎn)云的檢測(cè);使用神經(jīng)網(wǎng)絡(luò)模型(如PointNet和PointPillar)從點(diǎn)云中提取特征圖;對(duì)于靜態(tài)背景,經(jīng)過(guò)"Grd Seg"模塊后,判斷為非路面的點(diǎn)云進(jìn)入另一個(gè)"Inst Seg"模塊進(jìn)行物體檢測(cè),得到靜態(tài)物體的三維邊界框標(biāo)注;對(duì)于路面點(diǎn)云,應(yīng)用"Semantic Seg"模塊,基于深度學(xué)習(xí)模型,利用反射強(qiáng)度對(duì)與圖像數(shù)據(jù)相似的語(yǔ)義對(duì)象進(jìn)行像素級(jí)分類(lèi),即車(chē)道標(biāo)線、斑馬線、道路區(qū)域等;通過(guò)檢測(cè)道路邊界得到路緣石位置,最后在"Vect Rep"模塊中進(jìn)行多邊形的標(biāo)注;跟蹤到的動(dòng)態(tài)物體點(diǎn)云和實(shí)例分割得到的靜態(tài)物體點(diǎn)云進(jìn)入"surf recon"模塊,進(jìn)行泊松重建;最后,將所有標(biāo)注投影到車(chē)輛坐標(biāo)系上得到一幀的最終標(biāo)注。 ? 對(duì)于圖19(c)所示具有LiDAR和多相機(jī)的輸入,我們將圖19(a)中的"光流"模塊替換為"場(chǎng)景流"模塊,"場(chǎng)景流"模塊使用深度學(xué)習(xí)模型估計(jì)三維點(diǎn)云的運(yùn)動(dòng);"深度圖"模塊替換為"深度填充"模塊,"深度填充"模塊使用神經(jīng)網(wǎng)絡(luò)模型完成深度填充,深度填充由點(diǎn)云投影(插值和"填補(bǔ)空洞")到圖像平面得到,然后反向投影回三維空間生成點(diǎn)云;同時(shí),"seg inst"模塊替換為"seman seg"模塊,該模塊使用深度學(xué)習(xí)模型標(biāo)注點(diǎn)云;隨后,稠密的點(diǎn)云和IMU數(shù)據(jù)將進(jìn)入"SLAM"模塊進(jìn)行運(yùn)動(dòng)軌跡估計(jì),并選擇標(biāo)記為障礙物(車(chē)輛和行人)的點(diǎn)云;同時(shí),估計(jì)的場(chǎng)景流也將進(jìn)入"mot seg"模塊,進(jìn)一步區(qū)分運(yùn)動(dòng)障礙物和靜態(tài)障礙物;運(yùn)動(dòng)物體通過(guò)"inst seg"模塊和"track"模塊后,得到運(yùn)動(dòng)物體的標(biāo)注;同樣,靜態(tài)障礙物通過(guò)"grd seg"模塊后,由"inst seg"模塊標(biāo)注;車(chē)道標(biāo)線、斑馬線、道路邊緣等地圖元素通過(guò)"seman seg"模塊得到;拼接后的路面圖像和對(duì)齊后的點(diǎn)云進(jìn)入"vect rep"模塊進(jìn)行多邊形標(biāo)注;通過(guò)跟蹤得到的動(dòng)態(tài)物體點(diǎn)云和實(shí)例分割得到的靜態(tài)物體點(diǎn)云進(jìn)入"surf recon"模塊進(jìn)行泊松重建;最后將所有標(biāo)注投影到車(chē)輛坐標(biāo)系上得到一幀的最終標(biāo)注。 ? 注意:這種半傳統(tǒng)標(biāo)注方法也被稱(chēng)為4D標(biāo)注,是由特斯拉的自動(dòng)駕駛團(tuán)隊(duì)首先探索。因此,所提出的數(shù)據(jù)標(biāo)注框架分兩階段運(yùn)行:首先是半傳統(tǒng)4D標(biāo)注,然后是基于深度學(xué)習(xí)的端到端標(biāo)注。 ?

12.3 主動(dòng)學(xué)習(xí)

自動(dòng)駕駛機(jī)器學(xué)習(xí)模型的訓(xùn)練平臺(tái)可以根據(jù)邊緣情況、OOD或異常數(shù)據(jù)的檢測(cè)方法,采用合理的方法利用這些增量數(shù)據(jù)。其中,主動(dòng)學(xué)習(xí)是最常用的方法,可以有效利用這些有價(jià)值的數(shù)據(jù)。主動(dòng)學(xué)習(xí)是一個(gè)迭代過(guò)程,在這個(gè)過(guò)程中,每次迭代都會(huì)學(xué)習(xí)一個(gè)模型,并使用一些啟發(fā)式方法從未標(biāo)明點(diǎn)池中選擇一組點(diǎn)進(jìn)行標(biāo)注。不確定性估計(jì)是啟發(fā)式方法之一,在自動(dòng)駕駛領(lǐng)域得到了廣泛應(yīng)用。不確定性有兩種主要類(lèi)型:感知不確定性和偶然不確定性。感知不確定性通常被稱(chēng)為模型不確定性,其估計(jì)方法主要包括集合法(Ensemble method)和蒙特卡羅剔除法(Monte Carlo dropout method);偶然不確定性被稱(chēng)為數(shù)據(jù)不確定性,常用的估計(jì)方法是基于貝葉斯理論的概率機(jī)器學(xué)習(xí)。 ? 注:盡管人們大多采用監(jiān)督學(xué)習(xí)來(lái)訓(xùn)練數(shù)據(jù)閉環(huán)中的模型,但為了提高泛化、可擴(kuò)展性和效率,引入了一些新的機(jī)器學(xué)習(xí)技術(shù),如半監(jiān)督學(xué)習(xí)(同時(shí)使用有標(biāo)簽和無(wú)標(biāo)簽數(shù)據(jù)),甚至自監(jiān)督學(xué)習(xí)(如流行的無(wú)標(biāo)簽數(shù)據(jù)對(duì)比學(xué)習(xí))。 ?

13 結(jié)論

在這篇關(guān)于自動(dòng)駕駛的綜述中,我們概述了一些關(guān)鍵的創(chuàng)新和未解決的問(wèn)題。我們提出了幾種基于深度學(xué)習(xí)的架構(gòu)模型,即BEV/占位感知、V2X中的協(xié)同感知、基于BEV/占用網(wǎng)絡(luò)的感知與預(yù)測(cè)和規(guī)劃(BP3)的端到端自動(dòng)駕駛。本文的一個(gè)新觀點(diǎn)是,我們更關(guān)注自動(dòng)駕駛研發(fā)中的數(shù)據(jù)閉環(huán)。特別是,我們提出了對(duì)應(yīng)的數(shù)據(jù)選擇/篩選和數(shù)據(jù)標(biāo)注/標(biāo)記機(jī)制來(lái)驅(qū)動(dòng)數(shù)據(jù)閉環(huán)。 ?

13.1 ChatGPT 和 SOTA 大模型

最后,我們簡(jiǎn)要討論大模型對(duì)自動(dòng)駕駛領(lǐng)域及其數(shù)據(jù)閉環(huán)范式的影響。 ? 最近,由大型語(yǔ)言模型(LLMs)驅(qū)動(dòng)的聊天系統(tǒng)(如chatGPT和PaLM)出現(xiàn)并迅速成為自然語(yǔ)言處理(NLP)中實(shí)現(xiàn)人工通用智能(AGI)的一個(gè)前景廣闊的方向[42]。實(shí)際上,諸如大規(guī)模預(yù)訓(xùn)練(學(xué)習(xí)整個(gè)世界網(wǎng)絡(luò)上的知識(shí))、指令微調(diào)、提示學(xué)習(xí)、上下文學(xué)習(xí)、思維鏈(COT)和來(lái)自人類(lèi)反饋的強(qiáng)化學(xué)習(xí)(RLHF)等關(guān)鍵創(chuàng)新在提高LLM的適應(yīng)性和性能方面發(fā)揮了重要作用。與此同時(shí),強(qiáng)化偏差、隱私侵犯、有害錯(cuò)覺(jué)(不真實(shí)的胡言亂語(yǔ))和巨大的計(jì)算機(jī)功耗等問(wèn)題也引起了人們的關(guān)注。 ? 大模型的概念已經(jīng)從NLP擴(kuò)展到其他領(lǐng)域,如計(jì)算機(jī)視覺(jué)和機(jī)器人學(xué)。同時(shí),多模態(tài)輸入或輸出的實(shí)現(xiàn)使應(yīng)用領(lǐng)域更加廣泛。視覺(jué)語(yǔ)言模型(VLMs)從網(wǎng)絡(luò)規(guī)模的圖像-文本對(duì)中學(xué)習(xí)豐富的視覺(jué)語(yǔ)言相關(guān)性,并通過(guò)單個(gè)VLM(如CLIP和PaLM-E)實(shí)現(xiàn)對(duì)各種計(jì)算機(jī)視覺(jué)任務(wù)的零樣本預(yù)測(cè)。Meta[43]提出的ImageBind是一種學(xué)習(xí)跨六種不同模態(tài)(圖像、文本、音頻、深度、熱和IMU數(shù)據(jù))聯(lián)合嵌入的方法。它實(shí)際上利用了大規(guī)模視覺(jué)語(yǔ)言模型,并通過(guò)與圖像配對(duì)將零樣本功能擴(kuò)展到一種新的模態(tài)。 ? 擴(kuò)散模型在圖像合成領(lǐng)域取得了巨大成功,并擴(kuò)展到其他模態(tài),如視頻、音頻、文本、圖形和三維模型等。作為多視圖重建的一個(gè)新分支,NeRF提供了3D信息的隱式表示。擴(kuò)散模型和NeRF的結(jié)合在文本到3D合成方面取得了顯著成效。 ? NavGPT是一個(gè)純粹基于LLM的指令遵循導(dǎo)航代理器,它通過(guò)在視覺(jué)語(yǔ)言導(dǎo)航任務(wù)中進(jìn)行零樣本預(yù)測(cè),揭示了GPT模型在具體場(chǎng)景中的推理能力。NavGPT可以明確對(duì)導(dǎo)航進(jìn)行高級(jí)規(guī)劃,包括將指令分解為子目標(biāo)、整合與導(dǎo)航任務(wù)相關(guān)的常識(shí)知識(shí)、從觀察到的場(chǎng)景中識(shí)別地標(biāo)、跟蹤導(dǎo)航進(jìn)度以及通過(guò)計(jì)劃調(diào)整適應(yīng)異常情況。 ?

13.2 大模型在自動(dòng)駕駛系統(tǒng)中的應(yīng)用

總之,LLM的出現(xiàn)使得AGI從NLP到各個(gè)領(lǐng)域,尤其是計(jì)算機(jī)視覺(jué)領(lǐng)域產(chǎn)生了連鎖反應(yīng)。自動(dòng)駕駛系統(tǒng)(ADS)必將受到這一趨勢(shì)的影響。有了足夠多的海量數(shù)據(jù)和視覺(jué)語(yǔ)言模型,再加上NeRF和擴(kuò)散模型,大模型的理念和操作將為自動(dòng)駕駛帶來(lái)革命性的變化。"長(zhǎng)尾"問(wèn)題將在很大程度上得到緩解,數(shù)據(jù)閉環(huán)可能會(huì)轉(zhuǎn)變?yōu)榱硪环N閉環(huán)模式,即預(yù)訓(xùn)練+微調(diào)+強(qiáng)化學(xué)習(xí),更不用說(shuō)輕量級(jí)車(chē)載模型的仿真平臺(tái)搭建和訓(xùn)練數(shù)據(jù)的自動(dòng)標(biāo)注了。 ? 然而,我們?nèi)匀粚?duì)其魯棒性、可解釋性和實(shí)時(shí)延遲表示擔(dān)憂。安全是ADS中最重要的問(wèn)題,大模型中的有害信息將導(dǎo)致駕駛危險(xiǎn)。基于規(guī)則的系統(tǒng)可以很容易地理解一些故障導(dǎo)致的結(jié)果,但深度學(xué)習(xí)模型仍然缺少性能和架構(gòu)之間的聯(lián)系。使用ADS最關(guān)鍵的是實(shí)時(shí)響應(yīng)。到目前為止,我們還沒(méi)有看到任何一個(gè)大模型的應(yīng)用可以在100毫秒內(nèi)生成結(jié)果,更不用說(shuō)車(chē)載工作的內(nèi)存要求了。

編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論