由于本文以大語言模型 RLHF 的 PPO 算法為主,所以希望你在閱讀前先弄明白大語言模型 RLHF 的前兩步,即 SFT Model 和 Reward Model 的訓練過程。另外因為本文不是純講強化學習的文章,所以我在敘述的時候不會假設你已經非常了解強化學習了。

2023-12-11 18:30:49 1151

1151

本文來自愛奇藝資深工程師王亞楠在LiveVideoStackCon2018熱身分享,由LiveVideoStack整理而成。在分享中,王亞楠介紹了自動碼率調節算法的實現過程與評價標準,以及基于強化學習的自動碼率調節算法的技術架構與實現要點。

2018-08-02 17:51:41 6146

6146

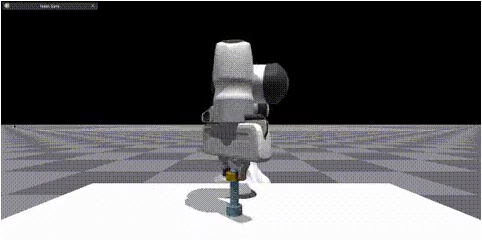

使用Isaac Gym來強化學習mycobot抓取任務

2023-04-11 14:57:12 5344

5344

什么是深度強化學習? 眾所周知,人類擅長解決各種挑戰性的問題,從低級的運動控制(如:步行、跑步、打網球)到高級的認知任務。

2023-07-01 10:29:50 1002

1002

Facebook近日推出ReAgent強化學習(reinforcement learning)工具包,首次通過收集離線反饋(offline feedback)來實現策略評估(policy evaluation)。

2019-10-19 09:38:41 1347

1347 不斷變化的,因此深度學習是人工智能AI的重要組成部分。可以說人腦視覺系統和神經網絡。2、目標檢測、目標跟蹤、圖像增強、強化學習、模型壓縮、視頻理解、人臉技術、三維視覺、SLAM、GAN、GNN等。

2020-11-27 11:54:42

強化學習的另一種策略(二)

2019-04-03 12:10:44

如何訓練AI玩飛機大戰游戲(創號版)

2019-07-01 12:27:34

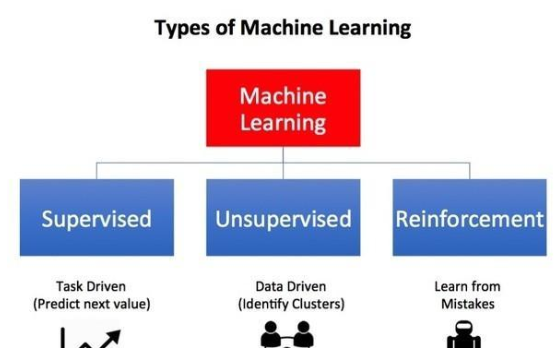

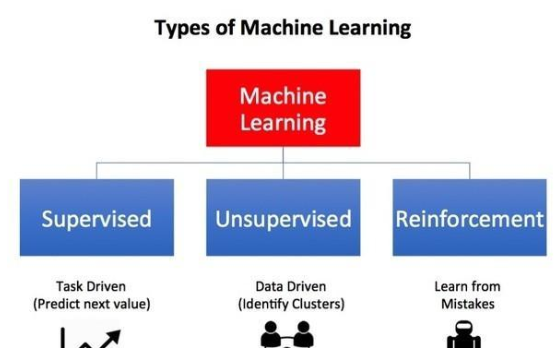

`轉一篇好資料機器學習算法可以分為三大類:監督學習、無監督學習和強化學習。監督學習可用于一個特定的數據集(訓練集)具有某一屬性(標簽),但是其他數據沒有標簽或者需要預測標簽的情況。無監督學習可用

2017-04-18 18:28:36

內容2:課程一: Tensorflow入門到熟練:課程二:圖像分類:課程三:物體檢測:課程四:人臉識別:課程五:算法實現:1、卷積神經網絡CNN2、循環神經網絡RNN3、強化學習DRL4、對抗性生成

2021-01-09 17:01:54

時間安排大綱具體內容實操案例三天關鍵點1.強化學習的發展歷程2.馬爾可夫決策過程3.動態規劃4.無模型預測學習5.無模型控制學習6.價值函數逼近7.策略梯度方法8.深度強化學習-DQN算法系列9.

2022-04-21 14:57:39

內容2:課程一: TensoRFlow入門到熟練:課程二:圖像分類:課程三:物體檢測:課程四:人臉識別:課程五:算法實現:1、卷積神經網絡CNN2、循環神經網絡RNN3、強化學習DRL4、對抗性生成

2021-01-10 13:42:26

無監督學習算法中,我們沒有目標或結果變量來預測。 通常用于不同群體的群體聚類。無監督學習的例子:Apriori 算法,K-means。0.3 強化學習 工作原理: 強化學習(reinforcement

2018-10-23 14:31:12

AI是如何設計微波集成電路的AI能學會設計集成電路,靠的是一個“基于聚類和異步的優勢行動者評論家算法模型”。文章介紹道,該模型包含兩部分——聚類算法和強化學習神經網絡模型。其中,聚類算法用來對網格化

2019-08-16 07:00:00

針對強化學習在連續狀態連續動作空間中的維度災難問題,利用BP神經網絡算法作為值函數逼近策略,設計了自動駕駛儀。并引入動作池機制,有效避免飛行仿真中危險動作的發生。首先

2013-06-25 16:27:22 27

27 強化學習在RoboCup帶球任務中的應用_劉飛

2017-03-14 08:00:00 0

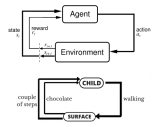

0 與監督機器學習不同,在強化學習中,研究人員通過讓一個代理與環境交互來訓練模型。當代理的行為產生期望的結果時,它得到正反饋。例如,代理人獲得一個點數或贏得一場比賽的獎勵。簡單地說,研究人員加強了代理人的良好行為。

2018-07-13 09:33:00 24321

24321

深度強化學習DRL自提出以來, 已在理論和應用方面均取得了顯著的成果。尤其是谷歌DeepMind團隊基于深度強化學習DRL研發的AlphaGo,將深度強化學習DRL成推上新的熱點和高度,成為人工智能歷史上一個新的里程碑。因此,深度強化學習DRL非常值得研究。

2018-06-29 18:36:00 27596

27596 薩頓在專訪中(再次)科普了強化學習、深度強化學習,并談到了這項技術的潛力,以及接下來的發展方向:預測學習

2017-12-27 09:07:15 10857

10857 針對路徑規劃算法收斂速度慢及效率低的問題,提出了一種基于分層強化學習及人工勢場的多Agent路徑規劃算法。首先,將多Agent的運行環境虛擬為一個人工勢能場,根據先驗知識確定每點的勢能值,它代表最優

2017-12-27 14:32:02 0

0 本文提出了一種LCS和LS-SVM相結合的多機器人強化學習方法,LS-SVM獲得的最優學習策略作為LCS的初始規則集。LCS通過與環境的交互,能更快發現指導多機器人強化學習的規則,為強化學習系統

2018-01-09 14:43:49 0

0 在風儲配置給定前提下,研究風電與儲能系統如何有機合作的問題。核心在于風電與儲能組成混合系統參與電力交易,通過合作提升其市場競爭的能力。針對現有研究的不足,在具有過程化樣本的前提下,引入強化學習算法

2018-01-27 10:20:50 2

2 在本篇論文中,研究人員使用流行的異步進化算法(asynchronous evolutionary algorithm)的正則化版本,并將其與非正則化的形式以及強化學習方法進行比較。

2018-02-09 14:47:41 3454

3454

傳統上,強化學習在人工智能領域占據著一個合適的地位。但強化學習在過去幾年已開始在很多人工智能計劃中發揮更大的作用。

2018-03-03 14:16:56 3924

3924 的基礎上增加BCS退避策略以解決流量較大場合業務區分問題;針對協調器節點,提出了基于強化學習的占空比調整策略,該策略能根據不同應用需求和環境變化自適應調整占空比。仿真結果表明,提出算法能針對不同環境滿足高優先級業務性能需求,并能根據流量變化進行占空比調整,具有極

2018-03-09 16:02:07 0

0 Q-learning和SARSA是兩種最常見的不理解環境強化學習算法,這兩者的探索原理不同,但是開發原理是相似的。Q-learning是一種離線學習算法,智能體需要從另一項方案中學習到行為a*的價值

2018-04-15 10:32:22 12973

12973 強化學習是智能系統從環境到行為映射的學習,以使獎勵信號(強化信號)函數值最大,強化學習不同于連接主義學習中的監督學習,主要表現在教師信號上,強化學習中由環境提供的強化信號是對產生動作的好壞作一種評價

2018-05-30 06:53:00 1234

1234 當我們使用虛擬的計算機屏幕和隨機選擇的圖像來模擬一個非常相似的測試時,我們發現,我們的“元強化學習智能體”(meta-RL agent)似乎是以類似于Harlow實驗中的動物的方式在學習,甚至在被顯示以前從未見過的全新圖像時也是如此。

2018-05-16 09:03:39 4475

4475

McAleer和他的團隊稱這個過程為“一種新型的強化學習算法,能夠教導算法如何在沒有人類協助的情況下解開魔方。” 他們聲稱,這種學習算法可以在30步內解開100%的隨機打亂魔方 - 這和人類的表現不相上下或優于人類的表現。

2018-06-22 16:49:39 3600

3600

Q Learning算法是由Watkins于1989年在其博士論文中提出,是強化學習發展的里程碑,也是目前應用最為廣泛的強化學習算法。

2018-07-05 14:10:00 3368

3368 自動駕駛汽車首先是人工智能問題,而強化學習是機器學習的一個重要分支,是多學科多領域交叉的一個產物。今天人工智能頭條給大家介紹強化學習在自動駕駛的一個應用案例,無需3D地圖也無需規則,讓汽車從零開始在二十分鐘內學會自動駕駛。

2018-07-10 09:00:29 4676

4676

前段時間,OpenAI的游戲機器人在Dota2的比賽中贏了人類的5人小組,取得了團隊勝利,是強化學習攻克的又一游戲里程碑。

2018-07-13 08:56:01 4439

4439

強化學習是人工智能基本的子領域之一,在強化學習的框架中,智能體通過與環境互動,來學習采取何種動作能使其在給定環境中的長期獎勵最大化,就像在上述的棋盤游戲寓言中,你通過與棋盤的互動來學習。

2018-07-15 10:56:37 17106

17106

這些具有一定難度的任務 OpenAI 自己也在研究,他們認為這是深度強化學習發展到新時代之后可以作為新標桿的算法測試任務,而且也歡迎其它機構與學校的研究人員一同研究這些任務,把深度強化學習的表現推上新的臺階。

2018-08-03 14:27:26 4305

4305 結合 DL 與 RL 的深度強化學習(Deep Reinforcement Learning, DRL)迅速成為人工智能界的焦點。

2018-08-09 10:12:43 5789

5789 強化學習作為一種常用的訓練智能體的方法,能夠完成很多復雜的任務。在強化學習中,智能體的策略是通過將獎勵函數最大化訓練的。獎勵在智能體之外,各個環境中的獎勵各不相同。深度學習的成功大多是有密集并且有效的獎勵函數,例如電子游戲中不斷增加的“分數”。

2018-08-18 11:38:57 3363

3363 而這時,強化學習會在沒有任何標簽的情況下,通過先嘗試做出一些行為得到一個結果,通過這個結果是對還是錯的反饋,調整之前的行為,就這樣不斷的調整,算法能夠學習到在什么樣的情況下選擇什么樣的行為可以得到最好的結果。

2018-08-21 09:18:25 19123

19123

強化學習(RL)研究在過去幾年取得了許多重大進展。強化學習的進步使得 AI 智能體能夠在一些游戲上超過人類,值得關注的例子包括 DeepMind 攻破 Atari 游戲的 DQN,在圍棋中獲得矚目的 AlphaGo 和 AlphaGo Zero,以及在 Dota2 對戰人類職業玩家的Open AI Five。

2018-08-31 09:20:49 3498

3498 強化學習是一種非常重要 AI 技術,它能使用獎勵(或懲罰)來驅動智能體(agents)朝著特定目標前進,比如它訓練的 AI 系統 AlphaGo 擊敗了頂尖圍棋選手,它也是 DeepMind 的深度

2018-09-03 14:06:30 2653

2653 強化學習是一種訓練主體最大化獎勵的學習機制,對于目標條件下的強化學習來說可以將獎勵函數設為當前狀態與目標狀態之間距離的反比函數,那么最大化獎勵就對應著最小化與目標函數的距離。

2018-09-24 10:11:00 6779

6779 按照以往的做法,如果研究人員要用強化學習算法對獎勵進行剪枝,以此克服獎勵范圍各不相同的問題,他們首先會把大的獎勵設為+1,小的獎勵為-1,然后對預期獎勵做歸一化處理。雖然這種做法易于學習,但它也改變了智能體的目標。

2018-09-16 09:32:03 5336

5336 Silver的演講中提出的強化學習10大要點涵蓋涉及算法評估、狀態控制、建模函數等方面的心得和建議,非常值得開發者和機器學習愛好者參考學習。一起看看他是怎么說的吧!

2018-09-17 08:41:19 3067

3067 之前接觸的強化學習算法都是單個智能體的強化學習算法,但是也有很多重要的應用場景牽涉到多個智能體之間的交互。

2018-11-02 16:18:15 21017

21017 11月1日,Facebook開源了Horizon,一個由Facebook的AI研究人員、推薦系統專家和工程師共同搭建的強化學習平臺,其框架的構建工作開始于兩年半前,在過去一年中一直被Facebook內部使用。

2018-11-05 09:34:17 722

722 本文作者通過簡單的方式構建了強化學習模型來訓練無人車算法,可以為初學者提供快速入門的經驗。

2018-11-12 14:47:39 4570

4570 OpenAI 近期發布了一個新的訓練環境 CoinRun,它提供了一個度量智能體將其學習經驗活學活用到新情況的能力指標,而且還可以解決一項長期存在于強化學習中的疑難問題——即使是廣受贊譽的強化算法在訓練過程中也總是沒有運用監督學習的技術。

2019-01-01 09:22:00 2122

2122

強化學習(RL)能通過獎勵或懲罰使智能體實現目標,并將它們學習到的經驗轉移到新環境中。

2018-12-24 09:29:56 2949

2949 在一些情況下,我們會用策略函數(policy, 總得分,也就是搭建的網絡在測試集上的精度(accuracy),通過強化學習(Reinforcement Learning)這種通用黑盒算法來優化。然而,因為強化學習本身具有數據利用率低的特點,這個優化的過程往往需要大量的計算資源。

2019-01-28 09:54:22 4705

4705 Google AI 與 DeepMind 合作推出深度規劃網絡 (PlaNet),這是一個純粹基于模型的智能體,能從圖像輸入中學習世界模型,完成多項規劃任務,數據效率平均提升50倍,強化學習又一突破。

2019-02-17 09:30:28 3036

3036

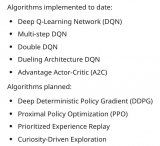

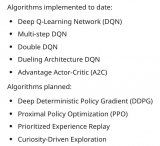

)等算法,還有 DDPG(Deep Deterministic Policy Gradient)、PPO(Proximal Policy Optimization)、Curiosity-Driven Exploration 等算法在計劃中。

2019-02-25 09:28:11 3209

3209

在傳統的多智體學習過程當中,有研究者在對其他智能體建模 (也即“對手建模”, opponent modeling) 時使用了遞歸推理,但由于算法復雜和計算力所限,目前還尚未有人在多智體深度強化學習 (Multi-Agent Deep Reinforcement Learning) 的對手建模中使用遞歸推理。

2019-03-05 08:52:43 4556

4556 近日,Reddit一位網友根據近期OpenAI Five、AlphaStar的表現,提出“深度強化學習是否已經到達盡頭”的問題。

2019-05-10 16:34:59 2313

2313 在谷歌最新的論文中,研究人員提出了“非政策強化學習”算法OPC,它是強化學習的一種變體,它能夠評估哪種機器學習模型將產生最好的結果。數據顯示,OPC比基線機器學習算法有著顯著的提高,更加穩健可靠。

2019-06-22 11:17:08 3374

3374 近幾年來,強化學習在任務導向型對話系統中得到了廣泛的應用,對話系統通常被統計建模成為一個 馬爾科夫決策過程(Markov Decision Process)模型,通過隨機優化的方法來學習對話策略。

2019-08-06 14:16:29 1836

1836 強化學習非常適合實現自主決策,相比之下監督學習與無監督學習技術則無法獨立完成此項工作。

2019-12-10 14:34:57 1092

1092 惰性是人類的天性,然而惰性能讓人類無需過于復雜的練習就能學習某項技能,對于人工智能而言,是否可有基于惰性的快速學習的方法?本文提出一種懶惰強化學習(Lazy reinforcement learning, LRL) 算法。

2020-01-16 17:40:00 745

745 本文檔的主要內容詳細介紹的是深度強化學習的筆記資料免費下載。

2020-03-10 08:00:00 0

0 Goldie和Mirhoseini將芯片placement建模為強化學習問題。與典型的深度學習不同,強化學習系統不會訓練大量的標簽數據。相反,他們會邊做邊學,并在成功時根據獎勵信號調整網絡中的參數。

2020-03-25 15:23:27 1756

1756 強化學習(RL)是現代人工智能領域中最熱門的研究主題之一,其普及度還在不斷增長。 讓我們看一下開始學習RL需要了解的5件事。

2020-05-04 18:14:00 3117

3117

加州大學伯克利分校的一組研究人員本周開放了使用增強數據進行強化學習(RAD)的資源。

2020-05-11 23:09:04 1179

1179 深度學習DL是機器學習中一種基于對數據進行表征學習的方法。深度學習DL有監督和非監督之分,都已經得到廣泛的研究和應用。強化學習RL是通過對未知環境一邊探索一邊建立環境模型以及學習得到一個最優策略。強化學習是機器學習中一種快速、高效且不可替代的學習算法。

2020-05-16 09:20:40 3150

3150 深度學習DL是機器學習中一種基于對數據進行表征學習的方法。深度學習DL有監督和非監督之分,都已經得到廣泛的研究和應用。強化學習RL是通過對未知環境一邊探索一邊建立環境模型以及學習得到一個最優策略。強化學習是機器學習中一種快速、高效且不可替代的學習算法。

2020-06-13 11:39:40 5529

5529 近期,有不少報道強化學習算法在 GO、Dota 2 和 Starcraft 2 等一系列游戲中打敗了專業玩家的新聞。強化學習是一種機器學習類型,能夠在電子游戲、機器人、自動駕駛等復雜應用中運用人工智能。

2020-07-27 08:50:15 715

715 訓練最新 AI 系統需要驚人的計算資源,這意味著囊中羞澀的學術界實驗室很難趕上富有的科技公司。但一種新的方法可以讓科學家在單臺計算機上訓練先機的 AI。2018 年 OpenAI 報告每 3.4 個月訓練最強大 AI 所需的處理能力會翻一番,其中深度強化學習對處理尤為苛刻。

2020-07-29 09:45:38 581

581 強化學習屬于機器學習中的一個子集,它使代理能夠理解在特定環境中執行特定操作的相應結果。目前,相當一部分機器人就在使用強化學習掌握種種新能力。

2020-11-06 15:33:49 1552

1552 深度強化學習是深度學習與強化學習相結合的產物,它集成了深度學習在視覺等感知問題上強大的理解能力,以及強化學習的決策能力,實現了...

2020-12-10 18:32:50 374

374 RLax(發音為“ relax”)是建立在JAX之上的庫,它公開了用于實施強化學習智能體的有用構建塊。。報道:深度強化學習實驗室作者:DeepRL ...

2020-12-10 18:43:23 499

499 本文主要介紹深度強化學習在任務型對話上的應用,兩者的結合點主要是將深度強化學習應用于任務型對話的策略學習上來源:騰訊技術工程微信號

2020-12-10 19:02:45 781

781 進入到2021年,AI領域的你最應該學的是什么?我覺得是強化學習。 為什么這么說?首先要知道什么是強化學習。 ? 強化學習是機器學習的一種,是一種行為學習模型。由算法提供數據分析反饋,引導用戶逐步

2021-01-18 16:16:42 1504

1504 Ⅰ為基準算法,其僅利用城市間的距離等靜態結構信息來構造初始解,解構造方法2~解構造方法4則嘗試利用搜索過程中積累的歷史數據,通過強化學習挖掘有用信息,用于引導解的構造過程。在25個國際公開算例上的測試結果表明,基于歷史信息的

2021-03-17 11:42:37 16

16 強化學習( Reinforcement learning,RL)作為機器學習領域中與監督學習、無監督學習并列的第三種學習范式,通過與環境進行交互來學習,最終將累積收益最大化。常用的強化學習算法分為

2021-04-08 11:41:58 11

11 深度強化學習(DRL)作為機器學習的重要分攴,在 Alphago擊敗人類后受到了廣泛關注。DRL以種試錯機制與環境進行交互,并通過最大化累積獎賞最終得到最優策略。強化學習可分為無模型強化學習和模型

2021-04-12 11:01:52 9

9 當機器人遇見強化學習,會碰出怎樣的火花? 一名叫 Cassie 的機器人,給出了生動演繹。 最近,24 歲的中國南昌小伙李鐘毓和其所在團隊,用強化學習教 Cassie 走路 ,目前它已學會蹲伏走路

2021-04-13 09:35:09 2164

2164

強化學習是人工智能領域中的一個研究熱點。在求解強化學習問題時,傳統的最小二乘法作為一類特殊的函數逼近學習方法,具有收斂速度快、充分利用樣本數據的優勢。通過對最小二乘時序差分算法

2021-04-23 15:03:03 5

5 利用深度強化學習技術實現路口信號控制是智能交通領域的硏究熱點。現有硏究大多利用強化學習來全面刻畫交通狀態以及設計有效強化學習算法以解決信號配時問題,但這些研究往往忽略了信號燈狀態對動作選擇的影響以及

2021-04-23 15:30:53 21

21 在移動霧計算中,霧節點與移動終端用戶之間的通信容易受到偽裝攻擊,從而帶來通信和數據傳輸的安全問題。基于移動霧環境下的物理層密鑰生成策略,提出一種基于強化學習的偽裝攻擊檢測算法。構建移動霧計算中的偽裝

2021-05-11 11:48:39 5

5 目前壯語智能信息處理研究處于起步階段,缺乏自動詞性標注方法。針對壯語標注語料匱乏、人工標注費時費力而機器標注性能較差的現狀,提出一種基于強化學習的壯語詞性標注方法。依據壯語的文法特點和中文賓州

2021-05-14 11:29:35 14

14 壓邊力控制策略的學習優化。基于深度強化學習的壓邊力優化算法,利用深度神經網絡處理巨大的狀態空間,避免了系統動力學的擬合,并且使用一種新的網絡結構來構建策略網絡,將壓邊力策略劃分為全局與局部兩部分,提高了壓邊

2021-05-27 10:32:39 0

0 一種新型的多智能體深度強化學習算法

2021-06-23 10:42:47 36

36 基于深度強化學習的無人機控制律設計方法

2021-06-23 14:59:10 46

46 基于強化學習的虛擬場景角色乒乓球訓練

2021-06-27 11:34:33 62

62 使用Matlab進行強化學習電子版資源下載

2021-07-16 11:17:09 0

0 多Agent 深度強化學習綜述 來源:《自動化學報》,作者梁星星等 摘 要?近年來,深度強化學習(Deep reinforcement learning,DRL) 在諸多復雜序貫決策問題中取得巨大

2022-01-18 10:08:01 1226

1226

本文主要內容是如何用Oenflow去復現強化學習玩 Flappy Bird 小游戲這篇論文的算法關鍵部分,還有記錄復現過程中一些踩過的坑。

2022-01-26 18:19:34 2

2 PPO改性方法分為物理改性(共混、填充等)和化學改性(主鏈、端基改性等),物理改性主要是與其他高性能樹脂共混形成塑料合金,化學改性是在PPO分子鏈上引入活性基團改善相容性或與其他分子進行嵌段、接枝以克服自身缺陷。

2022-09-06 15:12:27 2989

2989 來源:DeepHub IMBA 強化學習的基礎知識和概念簡介(無模型、在線學習、離線強化學習等) 機器學習(ML)分為三個分支:監督學習、無監督學習和強化學習。 監督學習(SL) : 關注在給

2022-12-20 14:00:02 828

828 電子發燒友網站提供《ESP32上的深度強化學習.zip》資料免費下載

2022-12-27 10:31:45 0

0 作者:Siddhartha Pramanik 來源:DeepHub IMBA 目前流行的強化學習算法包括 Q-learning、SARSA、DDPG、A2C、PPO、DQN 和 TRPO。這些算法

2023-02-03 20:15:06 747

747 本文介紹了強化學習與智能駕駛決策規劃。智能駕駛中的決策規劃模塊負責將感知模塊所得到的環境信息轉化成具體的駕駛策略,從而指引車輛安全、穩定的行駛。真實的駕駛場景往往具有高度的復雜性及不確定性。如何制定

2023-02-08 14:05:16 1441

1441 強化學習(RL)是人工智能的一個子領域,專注于決策過程。與其他形式的機器學習相比,強化學習模型通過與環境交互并以獎勵或懲罰的形式接收反饋來學習。

2023-06-09 09:23:23 355

355 前言 DeepMind 最近在 Nature 發表了一篇論文 AlphaDev[2, 3],一個利用強化學習來探索更優排序算法的AI系統。 AlphaDev 系統直接從 CPU 匯編指令的層面入手

2023-06-19 10:49:27 357

357

來源:DeepHubIMBA強化學習的基礎知識和概念簡介(無模型、在線學習、離線強化學習等)機器學習(ML)分為三個分支:監督學習、無監督學習和強化學習。監督學習(SL):關注在給定標記訓練數據

2023-01-05 14:54:05 419

419

作者:SiddharthaPramanik來源:DeepHubIMBA目前流行的強化學習算法包括Q-learning、SARSA、DDPG、A2C、PPO、DQN和TRPO。這些算法已被用于在游戲

2023-02-06 15:06:38 665

665

電子發燒友網站提供《人工智能強化學習開源分享.zip》資料免費下載

2023-06-20 09:27:28 1

1 摘要:基于強化學習的目標檢測算法在檢測過程中通常采用預定義搜索行為,其產生的候選區域形狀和尺寸變化單一,導致目標檢測精確度較低。為此,在基于深度強化學習的視覺目標檢測算法基礎上,提出聯合回歸與深度

2023-07-19 14:35:02 0

0 體的發展,從最早的 AlphaGo、AlphaZero 到后來的多模態、多任務、多具身 AI 智能體 Gato,智能體的訓練方法和能力都在不斷演進。 從中不難發現,隨著大模型越來越成為人工智能發展的主流趨勢,DeepMind 在智能體的開發中不斷嘗試將強化學習與自然語言處理、計算機視覺

2023-07-24 16:55:02 296

296

訊維模擬矩陣在深度強化學習智能控制系統中的應用主要是通過構建一個包含多種環境信息和動作空間的模擬矩陣,來模擬和預測深度強化學習智能控制系統在不同環境下的表現和效果,從而優化控制策略和提高系統的性能

2023-09-04 14:26:36 296

296

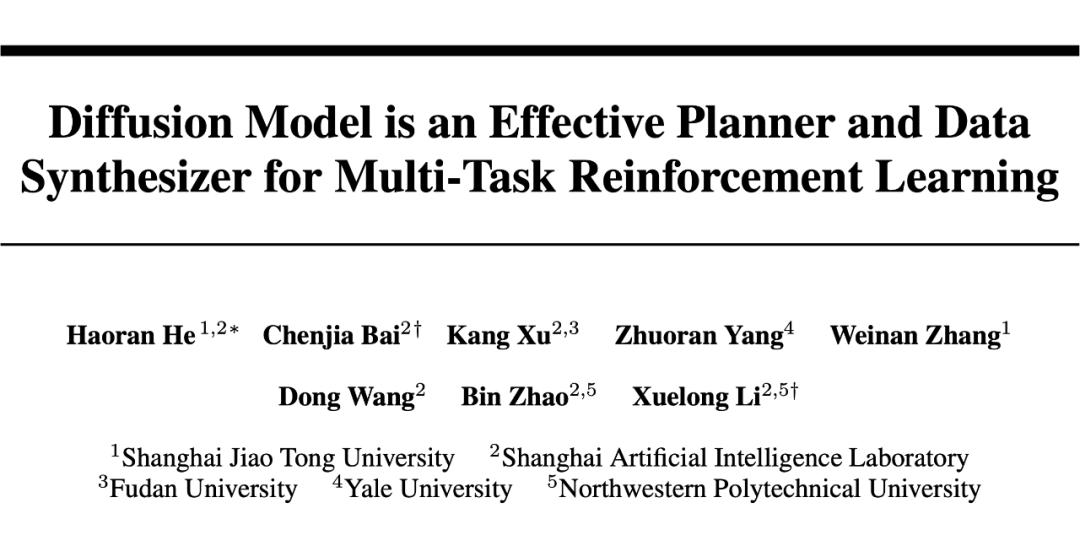

擴散模型(diffusion model)在 CV 領域甚至 NLP 領域都已經有了令人印象深刻的表現。最近的一些工作開始將 diffusion model 用于強化學習(RL)中來解決序列決策問題

2023-10-02 10:45:02 403

403

強化學習是機器學習的方式之一,它與監督學習、無監督學習并列,是三種機器學習訓練方法之一。 在圍棋上擊敗世界第一李世石的 AlphaGo、在《星際爭霸2》中以 10:1 擊敗了人類頂級職業玩家

2023-10-30 11:36:40 1051

1051

電子發燒友App

電子發燒友App

評論