ChatGPT是OpenAI開發的一個基于文本生成技術的對話機器人,以其驚艷的效果迅速出圈,在這個低迷的2023年初,憑著一己之力重新掀起了AI領域的熱潮。

早在上個世紀五十年代,就有學者提出了人工智能(Artificial Intelligence)的概念,其目的是希望讓計算機擁有人類智能(或部分人類智能)。這個領域經過很多年的發展,依然沒有突破,直到2012年出現了深度學習技術。深度學習主要解決了模型表示能力的瓶頸。我們面對的建模問題,比如圖像理解、語言翻譯、語音識別、分子-蛋白結合構象預測等技術,都是非常復雜的非線性問題,在深度學習出現之前,模型表示能力很弱,無法對這些復雜問題進行精確表示。而深度學習技術,可以通過模型的層次堆疊,理論上可以構建任意深度的模型,突破了模型表示能力的瓶頸,從而在語音識別、計算機視覺、自然語言理解等領域取得了突破性進展。

深度學習技術的出現標志著人工智能進入到一個新的階段,我們姑且把2012年左右開始的通過深度學習驅動的人工智能浪潮叫作新一代人工智能時代(實際上在語音識別領域深度學習應用可以追溯到最早,但是鑒于后續很多深度學習的進步都來自于計算機視覺領域,所以,我們以2012年AlexNet出現作為起點)。這個時期,可以認為是深度學習驅動的新一代人工智能的第一個階段,即標注數據驅動的深度學習模型,大幅提高了模型表示能力,從而推動人工智能技術顯著提升,并且在計算機視覺和語音識別領域獲得了產品和商業上的成功。這個階段的主要局限,是非常依賴于標注數據的數量。由于模型參數變多,想要求解這么多的模型參數,需要大量的訓練數據作為約束。而想獲得大量的標注數據非常貴,到億級別之后就很難再有提升,數據支撐的有效模型大小也受到限制。2012-2015年這段時間,計算機視覺是最活躍的領域,出現了包括ResNet在內的各種深度網絡模型。

2017年,一個重要的基礎工作Transformer出現了。2019年,在一直未能有重大突破的自然語言處理(NLP)領域,一個叫作BERT的工作脫穎而出,在十幾個不同的自然語言處理領域(NLP)任務中都取得了最好的結果,這些任務之間的差別很大,所以BERT工作發表后,馬上引起了整個領域的關注。BERT采用了一個叫作自監督預訓練的思路,無需標注數據僅利用文本語料本身存在的約束就可以訓練模型(比如某句話的某個位置只能用某些限定的詞),這樣互聯網上存在的優質語料不需要進行人工標定就可以用來做訓練,從而一下子使得可用訓練數據的數量有了巨大的提高,再配合上大模型,使得BERT模型的效果遠遠超過過去的模型,并且在不同任務間具有很好的通用性,成為NLP領域里程碑工作之一。

其實在BERT出現之前的2018年,還有個工作叫作GPT(即GPT1.0),更早利用了自監督預訓練的思路來做文本生成,即輸入前面的文本,模型預測輸出后面的文本,領域里面的優質語料無需標注就可以做訓練。BERT和GPT都是在Transformer基礎上發展而來的,而Transformer也逐漸發展成為AI領域的通用模型。GPT1.0的效果并不驚艷。在BERT出現后不久,GPT很快發布了GPT2.0,模型大小和訓練數據量都有大幅提升,作為通用模型(即不用下游任務做訓練,直接測試結果)在大多數任務上結果好于現有模型。但由于BERT模型在特征表示上比GPT2.0模型更有優勢,也更容易訓練,所以這個階段領域里最受關注的工作還是BERT。但2020年7月,GPT3.0橫空出世,以1700億參數驚艷四座,更重要的是,在效果上,GPT3.0作為一個通用語言模型,只需向它提供一段簡單描述,說明想生成的內容,就可以在無需重新訓練的情況下,根據提示,生成可執行代碼,生成網頁或圖標,完成一篇文章或新聞,還可以編寫詩歌和音樂。GPT3.0出現后,受到了行業的廣泛關注,很多開發者基于GPT3.0做了很多好玩的應用。GPT3.0成為最好也最受關注的文本生成模型。

在自監督預訓練技術出現之后,我們可以認為新一代人工智能發展到了第二個階段,即自監督預訓練技術使得可用訓練數據有了幾個數量級的提升,在訓練數據大幅提升的支撐下,模型大小也有了數個數量級的提升(有效模型達到了千億規模),而在模型效果上,這些模型變得不再依賴于下游任務領域數據的再訓練,所以,領域進入到基于自監督預訓練的通用大模型時代。

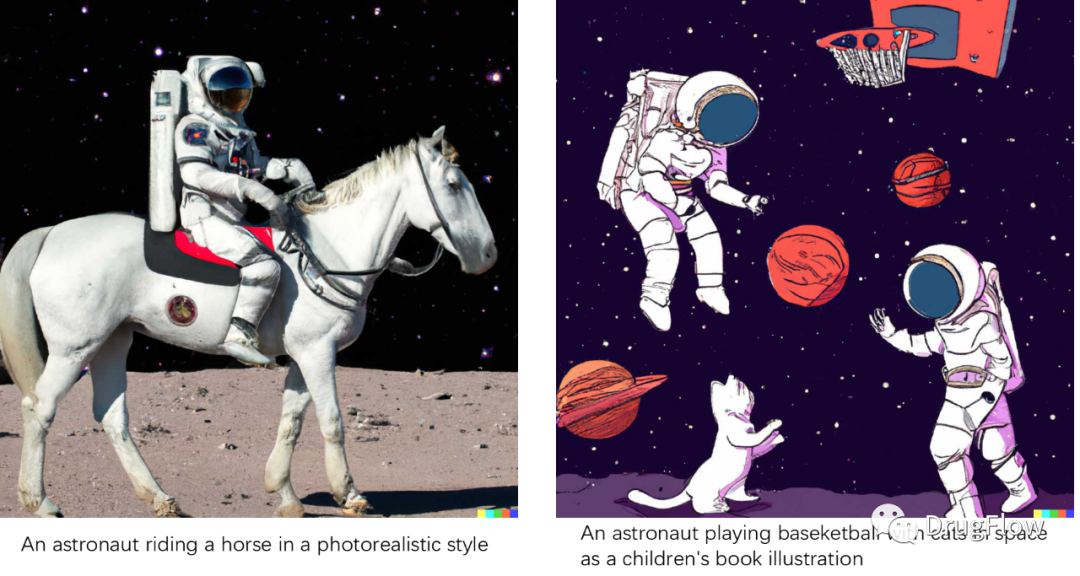

之后,GPT3.0與領域其他工作一起引發了一波模型大小的軍備競賽,但鮮有真正有突破的技術出現。大家意識到僅僅增加模型大小,并不能根本上解決問題。就在大家期待GPT4.0等后續工作出現的時候,整整兩年過去,GPT一直沒有更新。這段時間內,人工智能領域最活躍的工作主要集中在兩個方面,多模態統一模型和內容生成。多模態統一模型,希望構建多模態或跨模態統一模型,嘗試將文本、圖像、語音等不同模態數據統一表示在一個模型中,其中包括最早的跨模態表示模型CLIP,和后續的一系列多模態統一表示模型。而內容生成領域,一方面在技術層面,出現了擴散模型(Diffusion Model)這樣的基礎模型,Diffusion Model及一系列變種模型的發展,使得人工智能內容生成(AI Generated Content,即AIGC)領域變得非常熱,從圖像生成領域擴展到自然語言處理和生命科學領域;另一方面在應用層面,基于文本生成圖像領域取得了很多實質進展,其中最有代表性的工作DALLE2,模型能夠按照輸入的文本描述輸出看起來很真實的圖像,即使在文本描述超越了現實的情況下,依然可以生成看似合理符合文本描述的圖像,如下圖所示。DALLE2等一系列工作的成功,一方面歸功于大量的文本-圖像對應關系數據(大約有數億對),建模了文本和圖像語義之間的對應關系,另外一方面歸功于擴散模型克服了GAN、VAE等模型難訓練、生成效果細節保留不夠等缺陷。圖像生成效果的驚艷,甚至讓很多人相信AI已經可以創造內容了。

圖。 DALLE2生成效果

時間來到了2022年11月底,OpenAI發布了ChatGPT。ChatGPT發布后,大家發現這個聊天機器人很不一般,經常給出令人驚艷的回答。對話機器人領域曾出現過很多個對話機器人,比如蘋果的Siri,微軟的小冰小娜等,這些通用對話系統的體驗都不是非常理想,大家拿來調戲一下就扔到了一邊。而智能音箱等產品中使用的指令執行式問答機器人,系統框架是基于規則驅動的對話管理系統,存在大量的手工規則,使得這些系統一方面無法擴展到通用領域,只能進行簡單程式化的回答,另一方面,無法處理多輪對話的環境語義信息(Context)。從技術層面看,ChatGPT和原來主流的對話系統完全不同,整個系統基于一個深度生成大模型,對于給定的輸入,經過深度模型的處理,直接輸出抽象總結性的回答。而在產品體驗上,ChatGPT也遠遠超越了過去的聊天系統。作為一個通用聊天機器人,它幾乎可以回答任何領域的問題,而且準確率已經達到人類愿意持續使用的要求,在多輪對話的場景下依然保持非常好的體驗。

當然,ChatGPT并不完美,作為一個深度學習模型,ChatGPT存在無法百分之百精準的缺陷,對于一些需要精確回答的問題(比如數學計算、邏輯推理或人名等),會出現一些可感知的明顯錯誤。后面又出現了一些改進工作,比如有些工作會提供信息的參考網頁鏈接,而在Facebook最新的工作ToolFormer中,則嘗試在生成模型中,將特定任務交給特定API去計算,不走通用模型,這有望克服模型無法百分之百精準的問題。如果這條路走通,深度生成模型有望成為AGI的核心框架,用插件方式集成其他技能API,想想就很激動人心。

商業上,ChatGPT一方面引發了對于Google等搜索引擎挑戰的暢想,另一方面,大家看到了各種自然語言理解有關的垂直產品應用機會。無疑,ChatGPT在自然語言理解領域正掀起一次可能媲美搜索推薦的新商業機會。

ChatGPT為什么能有這樣驚艷的效果?其中一個核心原因是ChatGPT基于生成大模型GPT3.5構建,這應該是當前自然語言理解領域文本生成最好的模型(GPT3.5比GPT3.0使用了更多的數據和更大的模型,具有更好的效果)。

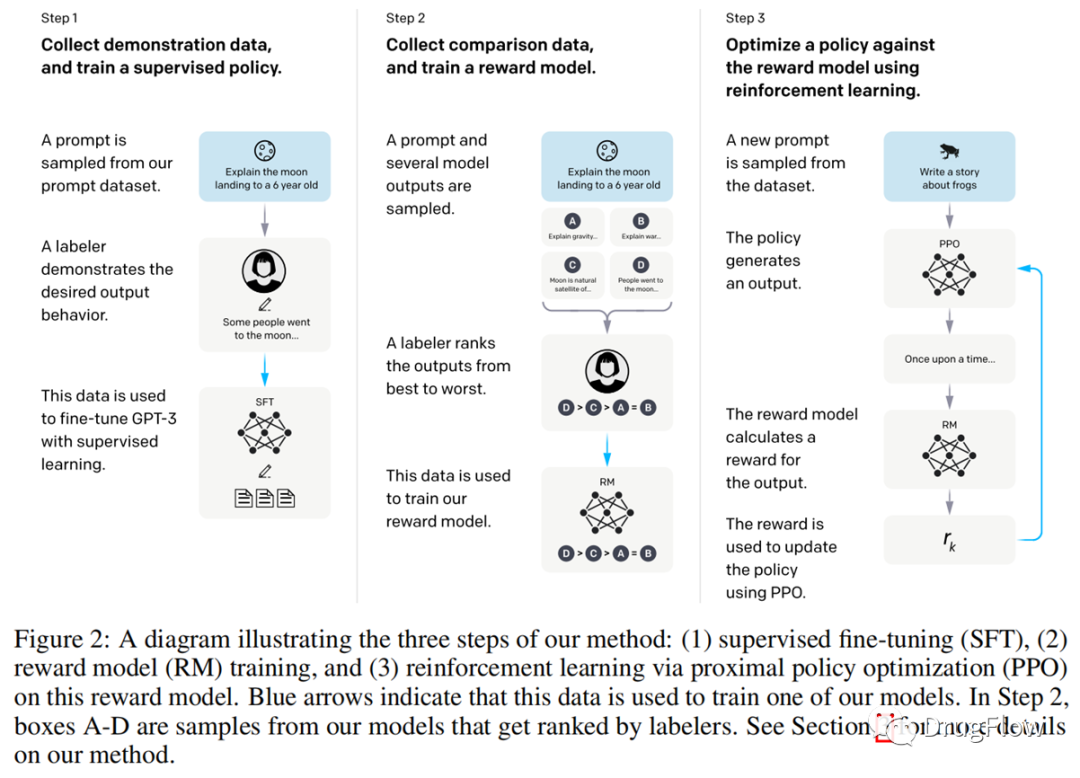

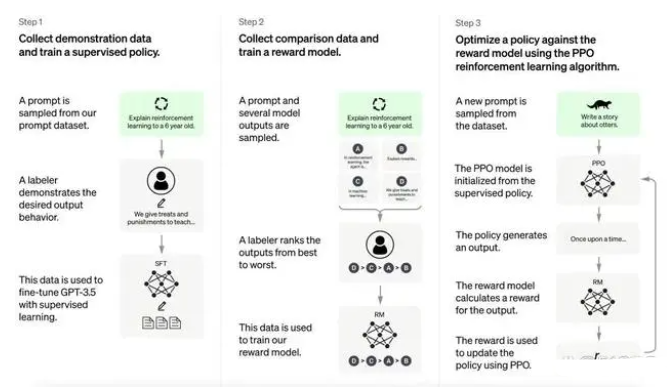

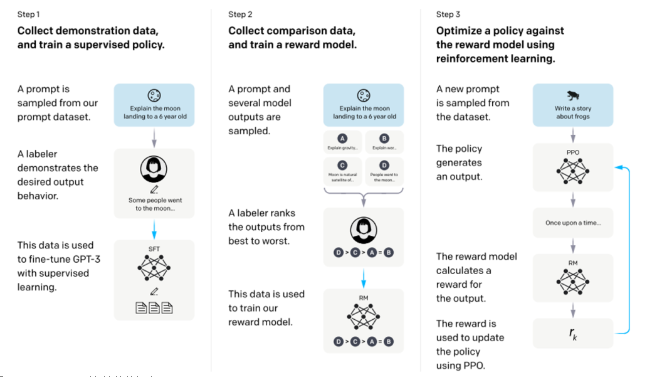

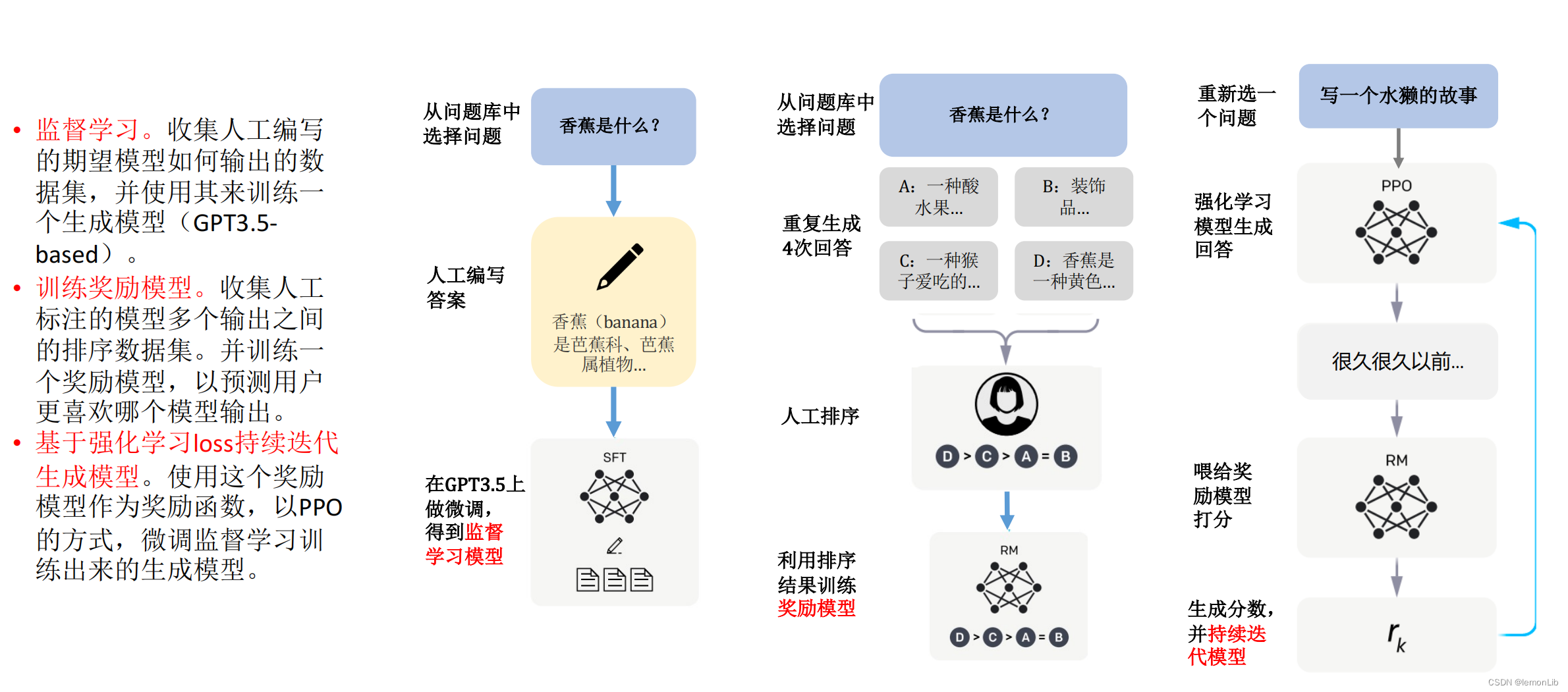

第二個核心原因則是基于人類反饋的強化學習技術,即Reinforcement Learning from Human Feedback(簡寫作RLHF)。由于OpenAI并沒有發表ChatGPT的論文,也沒有代碼公開,大家一般認為其與之前的一篇文章InstructGPT(https://arxiv.org/pdf/2203.02155.pdf)中批露的技術最為相近。如下圖所示,按照InstructGPT中的描述,第一步,先收集用戶對于同一問題不同答案的偏好數據;第二步,利用這個偏好數據重新訓練GPT模型,這一步是基于監督信息的精調;第三步,根據用戶對于不同答案的偏好,訓練一個打分函數,對于ChatGPT的答案會給出分數,這個分數會體現出用戶對于不同答案的偏好;第四步,用這個打分函數作為強化學習的反饋(Reward)訓練強化學習模型,使得

ChatGPT最終輸出的答案更偏向于用戶喜歡的答案。通過上述過程,ChatGPT在GPT3.5的基礎上,針對用戶輸入,輸出對用戶更友好的回答。

ChatGPT第一階段訓練GPT生成模型使用的訓練數據非常多,大約在幾十TB,訓練一次模型需要花費千萬美元,而第二個階段,基于強化學習的少量優質數據反饋則只需要數萬條優質數據。我們可以看到,ChatGPT技術,是在自監督預訓練大模型基礎上結合基于人類反饋的強化學習技術,取得了非常顯著的進展。這種新的范式,有可能成為第三階段人工智能的核心驅動技術,即首先基于自監督預訓練的大模型,再結合基于少量優質數據反饋的強化學習技術,形成模型和數據的閉環反饋,獲得進一步的技術突破。

ChatGPT第一階段訓練GPT生成模型使用的訓練數據非常多,大約在幾十TB,訓練一次模型需要花費千萬美元,而第二個階段,基于強化學習的少量優質數據反饋則只需要數萬條優質數據。我們可以看到,ChatGPT技術,是在自監督預訓練大模型基礎上結合基于人類反饋的強化學習技術,取得了非常顯著的進展。這種新的范式,有可能成為第三階段人工智能的核心驅動技術,即首先基于自監督預訓練的大模型,再結合基于少量優質數據反饋的強化學習技術,形成模型和數據的閉環反饋,獲得進一步的技術突破。

關于ChatGPT,我們的觀點如下:

(1)ChatGPT確實是這個時代最偉大的工作之一,讓我們看到了基于自監督預訓練的生成大模型與基于少量優質數據強化學習反饋策略結果后AI的驚艷效果,某種意義上改變了我們的認知。

(2)ChatGPT相關技術具有非常大的商業價值,使得搜索引擎在內的很多產品都面臨被重構或者顛覆的機會,無疑會帶來很多新的商業機會,整個NLP領域都會受益。

(3)基于自監督預訓練的生成大模型與基于少量優質數據強化學習反饋策略的學習范式,有望成為未來推動各個領域前進的動力,除NLP領域外,有望在生命科學、機器人、自動駕駛等各個領域引發新一輪人工智能熱潮。

(4)ChatGPT并不能證明人工智能已經有了人類心智,ChatGPT表現出來的一些創造性和心智,是因為自然語言理解語料中包含了語義、邏輯,基于自然語言語料訓練出來的生成模型,統計意義上學習到了這些對應關系,看起來似乎有了智能,但并不是真的有人類心智。ChatGPT很棒,但說他智力等于幾歲小朋友的說法,都不夠嚴謹。因為從根本上講,人學習新知識、進行邏輯推理、想象、運動反饋這些能力,目前AI還沒有具備。過度炒作ChatGPT的智能和能力,會劣幣驅逐良幣,損害整個行業。

(5)在這個領域,中國的技術還有差距,過去兩年,我們還沒有看到真正復制出GPT3.0效果的文本生成模型,而沒有GPT3.0和3.5,就不會有ChatGPT。GPT3、GPT3.5和ChatGPT等工作都沒有開源,甚至API都對中國做了封鎖,這都是復制工作實際面臨的困難。說得悲觀一點,大部分想復制ChatGPT效果的團隊,都不會成功。

(6)ChatGPT并不是一兩個研究人員做出的算法突破,而是在先進理念指導下,非常復雜的算法工程體系創造出來的成果,需要在團隊和組織上匹配(類比OpenAI和DeepMind)。純研究型的團隊恐怕不能成功,對深度學習理解不夠、太工程化的團隊也不會成功。這只團隊需要:第一要有足夠資源支持,可以支撐昂貴的深度學習訓練和人才招聘;第二要有真正在工業界領導過工程化大模型團隊的專家領導,ChatGPT不僅有算法創新,更是工程體系創新;第三,也可能是最重要的,需要一個團結協作有統一領導且不追求論文發表的組織(松散型的組織利于算法創新,但不利于工程化算法攻堅),且配備足夠多優秀的工程和算法人才。

(7)我們不僅追求做一個ChatGPT,更要持續追求其背后的技術創新,即大力發展自監督預訓練生成大模型和基于少量優質數據的強化學習反饋策略技術,這既是下一代ChatGPT的核心技術,也是推動人工智能領域整體進步的技術。最擔心的是,由于投機追風,造成力量分散而使大量資源被浪費,或者過度宣傳ChatGPT損害了行業。

(8) ChatGPT還存在改進空間,也不是唯一值得關注和期待的技術。對于AI,最常見的誤區是,高估其短期表現,而低估其長期表現。這是一個AI成為核心推動力的偉大時代,但AI并不會那么快無所不能,需要我們長期努力。 這里,我們簡單總結一下2012年以來深度學習引起的新一代人工智能浪潮里面的關鍵技術演進:

(1)第一個階段,關鍵進展是標記數據驅動的有監督深度學習模型,大幅提高了模型表示能力,從而推動人工智能技術顯著進步,這個階段最活躍的是計算機視覺和語音識別領域,主要的局限是有標記數據比較貴,限制了可以獲得的數據量,進而限制了數據能支撐的有效模型大小。

(2)第二個階段,關鍵進展是自監督預訓練大數據驅動的通用大模型,自監督預訓練技術使得可用訓練數據有了幾個數量級的提升,從而支撐著模型大小也有了數個數量級的提高,成為無需依賴下游任務領域數據再訓練的通用模型,這個階段進步最大、最活躍的是自然語言理解領域;主要的局限在于需要海量數據訓練,且模型非常大,訓練和使用都非常昂貴,重新訓練垂直場景模型也非常不方便。

(3)第三個階段,目前雖然還不能蓋棺論定,但呈現出一定趨勢。未來非常重要的技術關鍵在于,能否在大模型的基礎上,用強化學習、Prompting等方式,僅通過少量優質數據就能顯著影響大模型的輸出結果。如果這個技術走通,那么無人駕駛、機器人以及生命科學等數據獲取昂貴的領域將顯著受益。過去,如果想改善AI模型存在的問題,必須采集大量的數據重新訓練模型。假如,在需要線下交互的機器人領域,在預訓練大模型的基礎上,僅通過告知機器人真實場景中一些正確和錯誤的動作選擇就能影響機器人的決策,那么無人駕駛和機器人領域在技術迭代上會更加高效。生命科學領域,如果僅通過少量的試驗數據反饋,就能顯著影響模型預測結果的話,整個生命科學領域與計算融合的革命將會來得更快一些。在這一點上,ChatGPT是非常重要的里程碑,相信后面還會有非常多的工作出現。

讓我們把目光回到我們更關注的生命科學領域。

由于ChatGPT帶來的技術進步改善了大多數NLP相關領域,所以,生命科學領域內和信息查詢檢索抽取有關的技術和產品,會優先受益。例如,在未來有沒有可能出現一個生命科學領域對話方式的垂直搜索引擎,專家可以向它詢問任何問題(比如關于疾病、靶點、蛋白等有關的問題),它一方面可以給出綜合趨勢的判定(也許沒有那么精確,但大概正確,有助于我們快速了解一個領域),另一方面可以給出關于某個話題的相關有價值資料,這無疑會顯著改善專家的信息處理效率。還例如,能否構建一個AI醫生,病人可以咨詢有關疾病的知識和處理辦法(限于技術的局限,AI無法給出精確的答案,更無法代替醫生),但可以給出很多信息參考和后續該做什么的建議,其體驗一定會顯著優于現在的搜索引擎。

生命科學領域本身還存在很多沒有被解決的重要任務,比如小分子-蛋白結合構象和親和力預測、蛋白-蛋白相互作用預測、小分子表示和性質預測、蛋白質性質預測、小分子生成、蛋白質設計、逆合成路線設計等任務。目前看這些問題還沒有被完美解決,如果在這些任務上取得突破,那么藥物發現甚至整個生命科學領域,都會迎來巨大變化。

基于大模型的AIGC領域,以及基于專家或試驗反饋的RLHF領域,受益于ChatGPT的推動,一定會引來一輪新的技術進步。其中AIGC(人工智能內容生成)技術,在過去一年中,已經在小分子生成、蛋白質設計等領域取得了不錯的進展。我們預測,在不遠的未來,下列任務將顯著受益于AIGC生成技術的發展,產生技術階躍:

(1)小分子生成和優化技術,即如何不依賴活性配體信息,而是基于蛋白口袋結構信息生成綜合考慮活性、成藥性、可合成性等多種條件約束的配體小分子,這部分技術將顯著受益于AIGC領域的發展;

(2)構象預測某種意義上可以看作是生成問題,小分子和蛋白結合構象預測任務也會受益于AIGC相關技術的發展;

(3)蛋白質、多肽、AAV等序列設計領域,也一定會受益于AIGC技術的發展。

上述AIGC相關任務,以及幾乎所有需要試驗驗證反饋的任務,包括但不限于活性預測、性質預測、合成路線設計等,都將有機會受益于RLHF技術帶來的紅利。

當然也存在很多挑戰。受限于可用數據數量,當前生命科學領域使用的生成模型還比較淺,主要使用的是GNN等淺層深度學習模型(GNN受限于消息傳遞的平滑性,層數只能使用到3層左右),生成效果上雖然體現了很好的潛力,但依然沒有ChatGPT那樣驚艷。而基于專家或試驗反饋的強化學習技術,受限于試驗數據產生速度以及生成模型表示能力不夠的影響,驚艷效果呈現也會需要一定的時間。但從ChatGPT技術演進趨勢推演,如果能訓練足夠深、表示能力足夠強的生成大模型,并且利用強化學習,基于少量優質試驗數據或者專家反饋來進一步提升生成大模型的效果,我們可以預期AIDD領域一定會迎來一次革命。

簡而言之,ChatGPT不僅是自然語言理解領域的一項技術進步,會引發新一輪信息服務和內容生成領域的商業潮流,同時,其背后基于海量數據的深度生成技術,以及基于人類反饋的強化學習技術,是更長遠的進步動力,會引起生命科學等領域的長足發展。我們會再迎來一次AI技術進步和產業落地的浪潮。

編輯:黃飛

電子發燒友App

電子發燒友App

評論