一、GPT-4正式發布,多模態能力帶來更多應用想象

1.1、OpenAI發布GPT-4,能力全面升級

GPT-4 正式發布,性能全面升級。2023 年 3 月 15 日凌晨,OpenAI 正式發布了 GPT-4 預訓練大 模型,相比于 GPT-3.5 模型進行了全方位的升級。實際上在半年前 OpenAI 就已經完成了 GPT-4 的模型,隨后又采用對抗性測試對 GPT-4 進行了 6 個月的迭代調整,保證其在真實性、可操作性 和安全方面達到最好。GPT-4 仍為 Transformer 架構的預訓練模型,與 ChatGPT 類似,同樣采用 了基于人類反饋的強化學習(RLHF)方法,在一些專業和學術領域上已經達到了人類水平,是 OpenAI 在人工智能領域的又一里程碑。

GPT-4 相比 GPT-3.5 具有四方面的能力提升:1) GPT-4 具有一定的多模態能力,能夠進行圖文結合輸入的分析。GPT-4 是一個多模態模型, 它能夠接受圖片和文本輸入,并輸出文本回復,相比 GPT-3.5 增加了對圖像模態的分析推理 能力。與業界之前的預測不同,GPT-4 并不具備多模態的生成能力,即無法從文本輸入中得 到圖片(類似于 DALL-E),只能對圖片的輸入進行分析,并且圖片輸入目前仍處于研究預 覽階段,還未對公眾開放。根據 OpenAI 顯示,GPT-4 對圖片的處理分析能力達到了很高的 水準,這相當于機器擁有了視覺并且能夠進行思考,在應用層面有非常廣的空間。比如,完 全可以成為視力障礙人群的眼睛,給出題目的圖片能夠直接進行解題步驟的輸出等,在教育 領域有廣泛的落地場景。

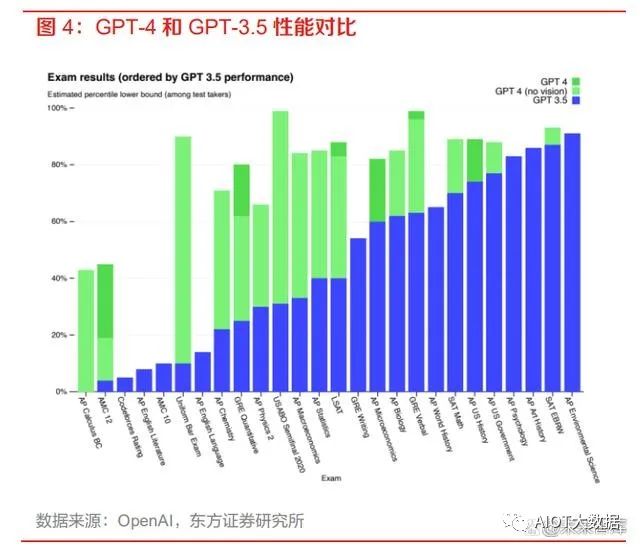

2) GPT-4 在復雜專業領域的性能表現大幅超過 GPT-3.5 和當下的 SOTA 大模型。據 OpenAI 顯示,GPT-4 和 GPT-3.5 在一些普通的談話測試中的性能區別不大,但是在處理較為復雜 和專業的任務上,GPT-4 相比 GPT-3.5 則表現更優。在美國律師資格考試測試中,GPT-4 的成績可以達到前 10%,而 GPT-3.5 只能達到后 10%的水平。與 SOTA 模型(state-of-theart model,目前最好的模型)相比,GPT-4 也展現出了更好的性能。

3) GPT-4 能夠處理更長的文本,具有更好的創作能力和邏輯推理能力。ChatGPT 處理的文本 字數上限為 3000 字,而 GPT-4 可以處理超過 25000 字的長文本,支持內容創作、對話拓展 和文檔分析等功能。在創造性方面,GPT-4 可以輔助用戶進行生成、處理和迭代創意工作, 例如創作歌曲、編寫劇本或學習用戶的寫作風格。與 ChatGPT 相比,GPT-4 的邏輯推理能 力更進一步,在復雜的推理問題中表現更佳。4) GPT-4 支持用戶自定義 AI 的對話風格。在 OpenAI 的開發者直播中可以初步窺視 GPT-4 的 頁面布局,用戶可以左側的 System 欄中輸入命令來定義 GPT-4 的交互對話風格,而不是像 ChatGPT 一樣只有一種風格。我們認為,自定義 AI 對話風格對于基于 GPT-4 的二次開發應 用來說是非常方便的,開發者可以輕松地創造出具有個人獨特風格的 AI 應用。

GPT-4 已開放給 ChatGPT Plus 用戶使用,并且開放了 GPT-4 API 使用申請,使用成本大幅提 升。據 OpenAI 顯示,目前僅有 ChatGPT Plus 的訂閱會員用戶能夠訪問 GPT-4,但存在容量上 限,OpenAI 會對此進行持續擴展和優化,未來可能會推出免費的 GPT-4 試用版和更高級的訂閱 版本以供用戶獲得更多的使用容量。OpenAI 同時開放了 GPT-4 API 的使用申請,開發者可以申 請進入 GPT-4 API 的等待列表,OpenAI 會逐步邀請開發人員開始試用 API。目前提供給開發者 的 API 只能進行文本的輸入,分為 8k 和 32k token 兩個版本,最便宜的 8k-prompt 版本的定價為 0.03 美元/1k tokens,相比于之前發布的 GPT-3.5-turbo 的 0.002 美元/1k tokens 要貴十倍以上。

1.2、GPT-4有望帶來多場景智能化升級

GPT-4 已在多領域落地,微軟官宣證實 New Bing 背后的大模型就是 GPT-4。伴隨著 GPT-4 的 發布,OpenAI 也給出了 GPT-4 的 6 個應用實例,涵蓋了教育、金融和政府領域。例如在 Duolingo 里加入 AI 與用戶進行日常聊天,加速用戶對語言的學習;摩根士丹利采用 GPT-4 來對 其知識庫進行管理,幫助員工快速訪問想要的內容。微軟也在 GPT-4 發布后官宣,New Bing 背 后的模型就是 GPT-4,并且將隨著 GPT-4 的更新持續迭代。我們在之前的報告中已多次提到,大 模型的能力將對產業智能化帶來重大影響。隨著 GPT-4 的發布以及性能飛躍,大模型在各領域有 望迎來進一步的落地應用。考慮到其對話交互的特性,我們看好 GPT-4 在如下幾個領域的應用。

1) 教育場景:GPT-4的自定義AI風格能力與其連續對話交互能力與教育場景十分契合,對不 同性格的學生采用不同風格的AI作為虛擬導師,回答學生的問題、提供個性化的學習建議 和教育資源、分析學生的學習進展等,達成對學生進行個性化教育的目標,使得每個學生都 能以最大化的效率進行學習。此外GPT-4還能作為教師的輔助教學工具,幫助教師更好地 管理教學過程和學生。例如,教師可以使用 AI 來分析學生的學習數據,針對不同的學生制 定更加個性化的教學計劃和評估學生的學習成果。GPT-4的圖片分析能力還能夠輔助教學過 程中的閱卷工作,實現對主觀題的評分,減輕教師工作負擔,提高閱卷的公正性與準確性。

2) 醫療場景:GPT-4 豐富的專業知識使其能夠做好輔助診斷的工作,通過分析醫療記錄、病歷 資料、診斷報告等數據,提供有關疾病診斷、治療方案和藥物處方等方面的建議和指導,幫 助醫生更加準確地診斷和治療疾病,提高醫療質量和治療效果。在醫學影像領域,GPT-4 新 增的圖片分析能力也可以用于CT等圖像的診斷,智能標記出存在癥狀的圖像區域。將GPT4 與可穿戴設備結合,可實現對重癥患者的全天候健康監測,進行實時健康風險評估,幫助 患者做好健康管理等。

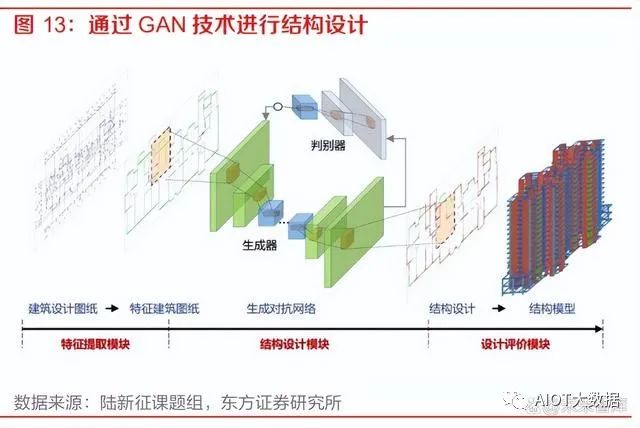

3) 企業經營管理辦公場景:GPT-4 的對話交互特性與邏輯分析能力可以助力企業經營管理辦公 全流程的效率提升。在企業的 OA 系統中,GPT-4 可以輔助員工快速智能地進行流程辦理;在企業 ERP 系統中,GPT-4 可以通過數據分析來輔助企業進行經營決策;在辦公環節, GPT-4 的長文本理解能力有望對會議、文檔和郵箱場景帶來效率提升。4) 工業設計場景:GPT-4 在復雜專業領域的性能以及其多模態分析能力可以成為良好的工業設 計輔助工具。例如在 CAD、CAE、EDA 等工業設計軟件領域,GPT-4 可以作為其中的插件 來進行模型的輔助設計、圖紙生成等。清華大學土木工程系的陸新征課題組已經將生成對抗 網絡技術應用到了結構設計中,能夠自動為剪力墻進行配筋,結果基本和普通的結構設計軟 件給出的配筋結果一致。能力更強的大模型在這方面的應用更加值得期待。

二、百度發布會召開,文心生態圈持續擴大

2.1、“文心一言”正式發布,具備多模態能力

百度的對話式大模型“文心一言”正式發布。3 月 16 日下午,百度 CEO 李彥宏在發布會上正式 揭開了“文心一言”的面紗。“文心一言”是百度新一代知識增強大語言模型,它基于百度 ERNIE 及 PLATO 系列模型的基礎進行研發,其大模型的訓練數據包括萬億級網頁數據、數十億的搜索數據和圖片數據、百億級的語音日均調用數據,以及5500億事實的知識圖譜等。李彥宏表 示,雖然“文心一言”的實際能力還并不完美,但希望通過發布后的真實用戶反饋來幫助大模型 快速迭代,加速模型能力的提升。

“文心一言”具備五大能力:1) 文學創作:發布會現場以《三體》為例,“文心一言”能夠對《三體》進行續寫,并能回答 事實相關問題,體現出了強大的總結分析與推理能力。2) 商業文案創作:“文心一言”能夠為公司起名提供創意,并能直接進行商業新聞稿的創作, 展現了模型的理解表達與創作能力。3) 數理邏輯推算:“文心一言”能夠看出題目本身存在的錯誤,并能給出正確題目的解題步驟, 具備較強的數理邏輯能力。4) 中文理解:“文心一言”基于大量中文語料進行訓練,能夠解釋“洛陽紙貴”背后的經濟學 原理,并能寫出藏頭詩,展現了對中文的強大理解能力。5) 多模態生成能力:“文心一言”可以輸入文字生成圖像、音頻和視頻,并支持多種方言生成。文字生成視頻的能力現階段還未對外開放,但百度旗下的百家號已經在使用這項技術。

“文心一言”的多模態生成能力亮眼,多模態是未來大模型的發展趨勢。從“文心一言”現場演 示的幾大功能來看,最為亮眼的當屬其多模態的生成能力,能夠支持圖像、音頻和視頻多種模態 內容的生成,而 OpenAI 的 GPT-4 目前還沒有多模態的生成能力,在應用領域將會有更廣闊的的 空間。我們認為,多模態是未來 AI 大模型的發展趨勢,隨著百度多模態統一大模型的能力增強, “文心一言”的多模態生成能力也會不斷提升。

“文心一言”是新一代知識增強大語言模型,具有六大核心基礎模塊。百度 CTO 王海峰提到, “文心一言”與別的大語言模型相比,除了有監督精調(Supervised Fine-Tune)、人類反饋的 強化學習(RLHF)、提示(Prompt)這三項大模型均會采用的基礎訓練模塊外,增加了三項具 有百度特色的核心基礎模塊:知識增強、檢索增強、對話增強,充分利用了百度旗下的百度知識 圖譜和百度搜索引擎等產品的能力。

1) 知識增強:“文心一言”的知識增強主要是通過知識內化和知識外用兩種方式。知識內化是 從大規模知識和無標注數據中,基于語義單元學習,利用知識構造訓練數據,將知識學習到 模型參數中;知識外用,是引入外部多源異構知識,做知識推理、提示構建等等。2) 檢索增強:“文心一言”的檢索增強,來自以語義理解與語義匹配為核心技術的新一代搜索 架構。通過引入搜索結果,可以為大模型提供時效性強、準確率高的參考信息,更好地滿足 用戶需求。3) 對話增強:基于對話技術和應用積累,“文心一言”具備記憶機制、上下文理解和對話規劃 能力,實現更好的對話連貫性、合理性和邏輯性。

2.2、文心生態圈持續擴大,大模型帶來新的產業機會

“文心一言”生態圈已加入650家企業,落地場景涵蓋各行各業。李彥宏在發布會上宣布,已有 650 家企業首批接入了“文心一言”,涵蓋了互聯網、媒體、金融、保險、汽車、企業軟件等行 業,百度大模型在 B端的生態圈迅速擴大。我們認為,隨著“文心一言”的首批生態企業應用逐 步落地,百度將建立起開發者及用戶調用和模型迭代之間的飛輪,加速構建開放繁榮的技術生態, 在推動公司增長的同時,也對中國生成式 AI 的發展帶來了巨大的促進作用。

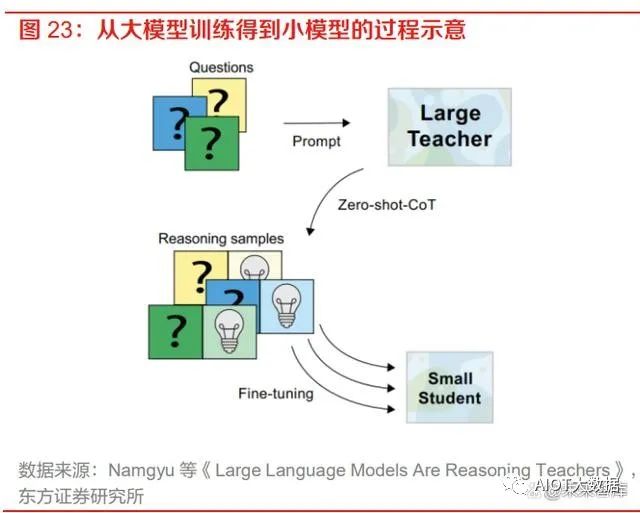

“文心一言”將在 3 月 27 日正式開放,大模型的發展將帶來三大產業機會。“文心一言”目前 仍處于邀請制內測階段,百度智能云官方宣布將于 3 月 27 日召開發布會,屆時“文心一言”將正 式向大眾開放。李彥宏在“文心一言”發布會上預測,大模型的發展有望帶來三大產業機會:新型云計算、行業模型精調和應用開發。我們在之前的報告《文心一言發布在即,大模型有望引領 產業智能化變革》也有展望過,MaaS 未來將有望成為大模型落地的新形態,通過模型蒸餾技術 將大模型“瘦身”成為垂直行業模型,能夠大大降低模型搭建的成本。我們認為,隨著“文心一 言”的發布,基于大模型的垂直場景化模型以及基于垂直模型的應用開發將會快速增加,AI 市場 有望迎來需求的大幅增長。

百度具有人工智能全棧布局,長期的技術積累和生態優勢助力百度成為國內對話式大模型先行者。基于搜索引擎這一天然的自然語言理解與處理的入口,百度從誕生開始就逐漸在NLP、語義理解方面進行持續的技術積累。過去數十年,百度深耕人工智能領域,目前已經擁有芯片、框架、模型和應用四層技術棧,文心大模型自2019年推出以來也歷經了多次迭代,目前已經具備較強的泛化能力與性能。良好的技術儲備與自身的生態優勢使得百度成為了國內對話式大模型的先行者,我們也十分看好“文心一言”發布后在各個產業中的落地應用。

三、微軟和英偉達相繼召開發布會,AI應用廣泛落地

3.1、微軟推出Microsoft 365 Copilot,辦公場景根本性變革

微軟宣布 Microsoft 365 服務全面接入 AI 驅動工具 Copilot。3 月 16 日晚,微軟在“The Future Work with AI”發布會上宣布將人工智能大語言模型技術(LLM)引入 Office 應用程序,推出了 AI 助手——Microsoft 365 Copilot,幫助用戶提高辦公生產力。該 AI 助手由 OpenAI 的 GPT-4 技術 驅動,出現在 Microsoft 365 應用的側邊欄,可以作為一個聊天機器人隨時召喚,帶來更智能、更 高效的辦公體驗。微軟 CEO 表示,Copilot 的核心特點是通過自然語言理解用戶的需求提供更加 個性化的服務,基于自然語言技術將大模型、用戶數據和應用結合起來。

Copilot 打通微軟辦公產品線,數據在各個產品中自由流通。Microsoft 365 Copilot 將大語言模型 的能力與儲存在 Microsoft Graph 中的數據如郵件、文檔、會議、日程、聊天等以及 Word、Excel、 PowerPoint、Teams、Outlook 等辦公產品全部聯系到一起,通過四個步驟將用戶的文本命令輸 入轉化為應用層的執行。Copilot 以迭代的方式來處理和編排這一系列流程服務,形成了集合大模 型、用戶數據和應用的 Copilot System,實現了多種令人驚嘆的功能。

1) 第一步:用戶在辦公產品端通過文本輸入 prompt,Copilot 接收用戶的 prompt,并通過 Grounding 技術對 prompt 進行預處理,其核心是調用 Microsoft Graph 來檢索與此 prompt 相關的業務內容背景信息,并基于這些信息對 Prompt 進行修改;2) 第二步:Copilot 將修改后的 prompt 發送給大語言模型 LLM;3) 第三步:Copilot 獲取到 LLM 對 prompt 產生的回應,并再次通過 Grounding 技術對回應進行 后處理,包括額外的圖形調用、對 AI 生成結果的安全性、合規性檢查等,并生成對應用的 調用命令;4) 第四步:Copilot 向用戶發送最終回復和對應用程序的調用命令。

Copilot 與 Microsoft 365 應用緊密集成。微軟將 AI 助手 Copilot 與 Word、Excel、PowerPoint、 Outlook、Teams 等產品緊密結合,成為高效的生產力工具。用戶可以用 Copilot 實現在 Word 中 生成文稿,為 PPT 增加圖片和動畫效果,在 Excel 里分析用戶輸入的數據并將結果生成可視化圖 表,幫助 Outlook 進行郵件管理和智能生成回復,在 Teams 里進行會議實時總結和會議紀要生成 等功能,甚至可以在不同的產品應用間進行格式轉換,例如要求其根據給定的 Word 文檔創建 PPT,極大地提高了用戶在辦公場景的效率。

Business Chat 功能將數據轉化為知識,大幅提升辦公效率。Copilot 提供了 Business Chat 功能, 橫跨了所有的數據和應用,用 Microsoft Graph 將來自文檔、PPT、電子郵件、日歷、便箋和聯系 人等的數據匯集在一起。比如可以直接通過與客戶的聊天、郵件、日歷等信息進行總結,按照 A 文件的格式編寫包含 B 計劃的時間表并給相關聯系人發送郵件等。同時,團隊中的每個人都可以 在同一個Chat頁面上共同進行業務的推進,比如在員工 A 創建了文檔后,員工B可以直接命令Copilot對文檔進行修改,實現了協同辦公效率的大幅提升。

Copilot 作為流程編排引擎驅動流程自動化與業務應用開發的 AI 變革。微軟將 Copilot 也接入到 了旗下的低代碼開發平臺 Power Platform 中,用戶可以在 Power Apps、Power Virtual Agents 和 Power Automate 中用自然語言描述他們想要的應用、功能和流程,Copilot 可以在幾秒鐘內完成 應用和流程的創建,并提供改進的建議。在 2022 年 10 月上線的預覽版 Power Automate 中,采 用了 AI 驅動的流程自動化創建能夠節省約 50%的時間,大幅提高了業務工作效率。

3.2、英偉達GTC 2023召開,展現AI多領域應用

英偉達 GTC 2023 正式召開,展現 AI、加速計算及其他領域的突破性進展。北京時間 3 月 21 日 晚,英偉達 CEO 黃仁勛為 GTC 2023 進行了主題演講,對英偉達在 AI 應用、加速計算等軟硬件 領域取得的新進展進行了介紹。經過幾十年的經營,英偉達不僅成為了全球領先的 AI 算力提供商, 也構建了一套圍繞著實際產業運轉的 AI 應用生態,在自然科學、化學制藥、視覺解析、數據處理、 機器學習和大模型領域成為不可或缺的一環。

AI 產業迎來“iPhone”時刻,英偉達聯手云廠商推出 DGX 云服務。黃仁勛在演講中多次表示, AI 產業正處于“iPhone”時刻,生成式 AI 技術的快速進步引發了全球企業對 AI 戰略制定的緊迫 感。為了方便企業客戶更快地訪問英偉達 AI 算力與應用庫,黃仁勛在演講中宣布英偉達將與微軟 Azure、谷歌云、Oracle OCI 合作,推出英偉達 DGX 云服務。這一合作將英偉達的生態系統引入 了云服務廠商,極大地擴展了英偉達的觸及范圍。這意味著當下性能最佳的 DGX AI 超級計算機 將成為能夠提供多租戶的云服務設施,一眾試圖訓練自營大語言模型、圖片模型的企業,將能直 接通過云服務快速實現自己的愿景。目前已有 50 余家企業客戶已經開始使用 DGX 云服務,涵蓋 了醫療、媒體、金融等多個行業領域。

生成式 AI 將重塑幾乎所有行業,行業模型有望成為未來大趨勢。生成式 AI 是一種新型的計算平 臺,與 PC、互聯網、移動設備和云誕生的時代類似,先行者們已經在利用生成式 AI 打造新的應 用,利用其智能自動化和協同創作能力來改變傳統的行業運行模式。對于某些具有較高專業性的 領域比如醫療、藥物等行業,可能需要用專屬的行業數據來構建定制化的行業模型,以滿足該行 業的特定要求。我們在之前的報告《文心一言發布在即,大模型有望引領產業智能化變革》也有 展望過,通過模型蒸餾技術將大模型“瘦身”成為垂直行業模型,能夠大大降低模型搭建的成本, MaaS 在未來將有望成為大模型落地的新形態。

英偉達推出 AI Foundations 云服務,提供從建立模型到上線運營的全套服務。對想要建立獨有 的垂直領域行業模型的客戶,英偉達推出了 AI Foundations 一站式云服務,從模型的構建到生成 應用上線,英偉達就類似于芯片行業的臺積電,成為了生成式 AI 領域的代工廠,協助客戶快速構 建、優化和運營大模型,把制造大模型的能力傳遞到每一個用戶。英偉達 AI Foundations 由三個 部分組成:

1) NEMO:NEMO 是用于自然語言文本的生成式模型,提供 80 億、430 億、5300 億參數的 GPT 模型,客戶也可以引入自己想要的模型。Nemo 會定期更新額外的訓練數據,可以幫助 企業為客服、企業搜索、文檔處理、市場分析等場景定制生產生成式 AI 模型。2) PICASSO:PICASSO 是一項視覺語言模型的制作服務,可以用于訓練能夠生成圖像、視頻 和 3D 素材的模型。客戶可以基于英偉達提供的 Edify 大模型或是自建定制模型來進行訓練 和優化,得到自己想要的生成式 AI 模型。Shtterstock 目前正在與英偉達合作開發一款以其 專業的圖像、3D 和視頻素材庫進行訓練的 Edify-3D 生成式模型,用于簡化創意制作、數字 孿生和虛擬協作中 3D 素材的創建過程。Adobe 也與英偉達合作,發布了 Adobe Firefly 這一 生成式 AI 工具,將生成式 AI 融入了營銷人員和創意工作者的日常工作流中。

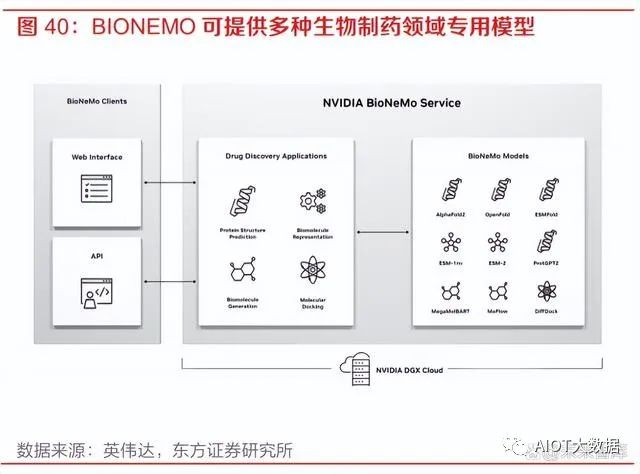

3) BIONEMO:BIONEMO 是針對于生物制藥領域的 AI 模型服務。生物制藥行業目前正在轉向 利用生成式 AI 來發現疾病靶因、設計新型分子或蛋白質類藥物、以及預測藥物對機體的作 用等。BIONEMO 可以為用戶提供創建、微調、提供自定義模型的平臺,包括 AlphaFold、 ESMFold、OpenFold 等蛋白質預測模型。生成式 AI 模型可以在給出氨基酸序列的條件下快 速準確地預測目標蛋白質結構,預測蛋白質和分子的相互作用等,極大地提升了最佳候選藥 物研發的效率。

工業軟件領域與 AI 大模型能力的結合值得期待。本次英偉達 CEO 的主題演講中,AI 與專業的創 意設計、工業設計、模擬仿真類軟件結合方式為 AI 大模型的落地帶來了新的場景,在駕駛仿真、 粒子特效運算、動畫制作、材質表面生成、物理效果等領域都有良好的應用。我們認為,隨著 AI 能力的持續進步和業界對 AI 應用方式的不斷探索,像 CAD、EDA、BIM 等工業軟件也有較大成 長的機會,其模型設計、圖紙生成等功能都與大模型能力十分契合。未來隨著國外頭部廠商進行 大模型方向的創新應用,國內的相關工業軟件企業也會有較大發展空間。

四、生成與通用領域雙線發展,人工智能邁入“雙G時代”

大語言模型的誕生帶來了新的知識表示和調用方式的變遷。自計算機誕生以來,知識表示和調用 方式歷經了兩次大的變遷。在互聯網誕生之前,最為常見的知識表示方式是關系型數據庫,通過 SQL 語句進行調用,精確度高但調用的方式較為復雜,代表的公司比如 Oracle 等數據庫的巨頭公 司。隨著互聯網的誕生與搜索引擎的誕生,知識的調用方式變化為了關鍵詞搜索,方便程度提高了,但是對于知識調用的精確度卻有所降低。而大模型的誕生進一步提高了知識調用方式的自然 度,僅需通過自然語言交互即可訪問想要的知識。

當下人工智能在生成和通用兩條主線上不斷發展,邁入“雙 G 時代”。目前人工智能最火熱的兩 個賽道分別是生成(Generation)和通用(General),這兩條賽道相互交織并行,AI 領域也進 入了“雙 G 時代”。在生成領域,以 DALLE-2、Stable Diffusion 等引領的生成式 AI 技術與 AIGC 概念如火如荼;在通用領域,AI 研究者們現在都在朝著通用人工智能(Artificial General Intelligence, AGI)的方向不斷努力,大模型不斷增強的多模態感知能力就是邁向 AGI 的重要途徑。這兩條賽道是密不可分的,像百度的“文心一言”大模型就既具有多模態的生成能力,又能夠回 答大部分的通用問題,具有一定的通用人工智能能力。

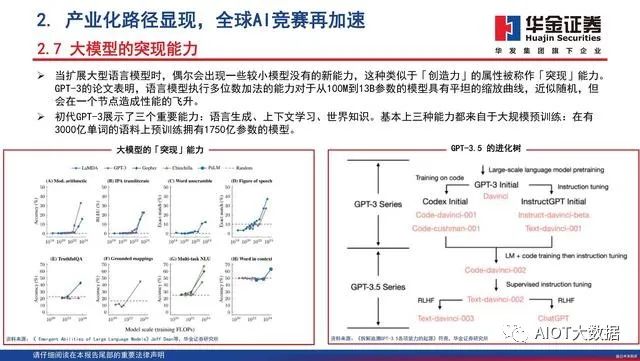

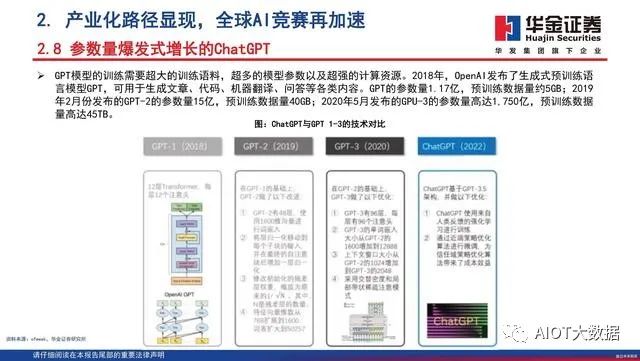

OpenAI 及其 GPT 系列模型是當前人工智能賽道上的領跑者,超大規模模型帶來的知識涌現能力 是 ChatGPT 出圈的關鍵。OpenAI 和 GPT-4 毫無疑問是當下人工智能領域最為耀眼的明珠,回 顧 GPT 系列模型的發展歷程,2018 年 OpenAI 發布 GPT-1 模型,僅有 1.17 億參數,性能也落后 于谷歌隨后發布的 BERT 模型,BERT 也成為當時 NLP 領域最常用的模型。OpenAI 持續在 GPT 模型上發力,陸續推出規模更大的迭代版本 GPT-2 和 GPT-3,在 OpenAI 的研究中,發現了當模 型參數到達一定規模時,模型會開始涌現出 In-context learning(上下文學習)、Chain ofThoughts(思維鏈)、Zero-shot(能夠處理未見任務)等能力,而這樣的能力成為了 ChatGPT 能夠“更像人”的關鍵。

“文心一言”已達“能用”標準,我國在人工智能賽道上將持續追趕。從近期的“文心一言”相 關測試來看,距離 GPT-4 還有很大差距,但是其能力展現已有 GPT-3 的水平,達到了“能用” 標準,在 B 端、垂直行業端等都有應用的空間。我們認為,我國的人工智能技術起步晚,經驗積累不足,但是發展速度較快。隨著我國相關科技公司大力投入生成式 AI、大語言模型的研究,我 國在 AI 的“雙 G 時代”中將持續扮演追趕者的角色,爭取和國際領先水平縮小差距。

服務器產業鏈如何受益于AI大模型

(報告出品方:華泰證券)

產業鏈公司梳理

以 ChatGPT 為代表的 AI 應用掀起 AI 落地千行百業的浪潮,驅動算力需求增長。我們認為 服務器產業鏈將深度受益于 AI 算力需求,產業鏈公司包括:1)服務器品牌及整機:聯想、 浪潮、工業富聯、中興通訊、紫光股份;2)PCB&CCL&ABF 載板:滬電股份、深南電路、 生益電子、興森科技、勝宏科技、生益科技、華正新材等;3)主機板:環旭電子;4)半 導體:寒武紀、海光信息、龍芯中科、瀾起科技、杰華特、東微半導、華潤微、聞泰科技 等;5)光模塊及光芯片:中際旭創、新易盛、天孚通信、華工科技、源杰科技等;5)光 纖光纜:長飛光纖光纜、亨通光電、中天科技等;6)熱管理:英維克、申菱環境。

AI 大模型如何推動服務器產業鏈需求

為了滿足 AI 市場的需求,英偉達今年 GTC2023 上不僅發布了 L4 Tensor Core GPU、L40 GPU、H100 NVL GPU 和 Grace Hopper 等芯片,還進一步推出 NVIDIA DGX 超級計算機, 成為大語言模型實現突破背后的引擎。英偉達在 GTC2023 中表示,《財富》100 強企業中 有一半安裝了 DGX AI 超級計算機,DGX 已成為 AI 領域的必備工具。DGX 配有 8 個 H100 GPU 模組,H100 配有 Transformer 引擎,旨在支持類似 ChatGPT 的大模型。這 8 個 H100 模組通過 NVLINK Switch 彼此相連,以實現全面無阻塞通信。8 個 H100 協同工作,形成一個巨型 GPU。通過 400 Gbps 超低延遲的 NVIDIA Quantum InfiniBand 進行網絡內計算,將成千上萬個 DGX 節點連接成一臺 AI 超級計算機,并不斷擴 展應用范圍,成為全球客戶構建 AI 基礎設施的藍圖。

服務器廠商如何把握 AI 大模型機會

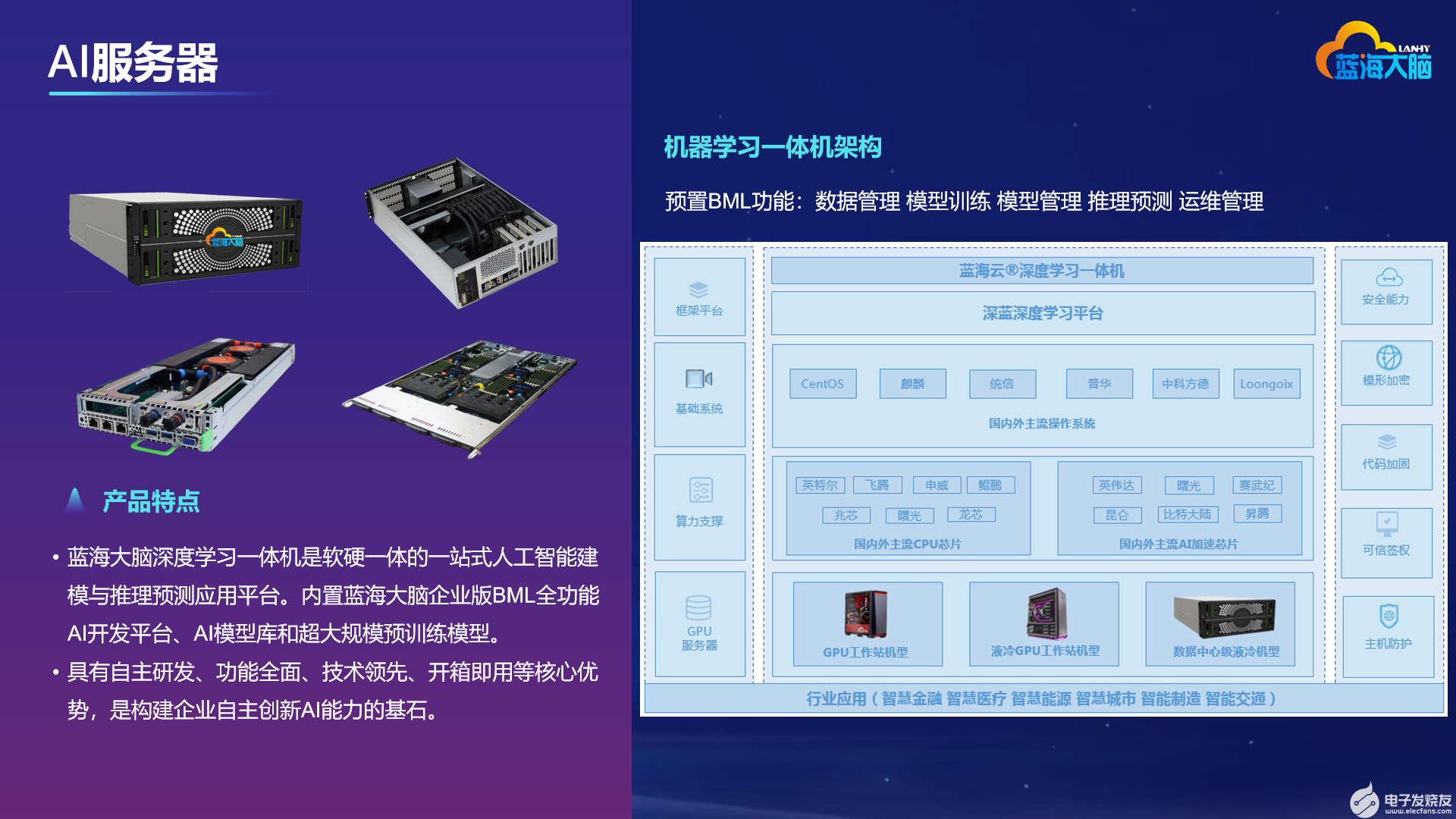

AI 大模型訓練和推理催生 GPU 需求上漲,AI 服務器采用異構式架構,NVIDIA DGX A100 服務器 8 個 GPU+2 個 CPU 的配置遠高于普通服務器 1~2 個 CPU 的配置,能夠滿足 AI 大模型需求。在單芯片計算訓練性能不斷提升的基礎上,服務器整體能效的提升同樣受到 關注。IDC 預計,全球 AI 服務器市場規模穩健增長,2021-2026E CAGR 預計達 17%。我 們認為,AI 大模型將帶動算力需求增長,催生對 AI 服務器的需求。工業富聯、聯想、中興 通訊、紫光股份等公司有望把握住AI大模型帶來的機會,受益于AI服務器需求的持續提升。

全球 AI 服務器市場規模穩健增長,2021-2026E CAGR 預計達 17%

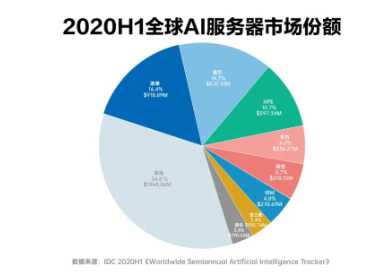

根據 IDC 數據,2014-2021 年,全球服務器廠商銷售總額總體呈上升趨勢,2021 年全球服 務器市場規模達到 USD99bn。其中,戴爾、HPE、聯想、浪潮市場份額排名前列,合計占 比超過 40%。IDC 認為 2021-2026E 全球 AI 服務器廠商市場規模將穩健增長,2026 年市 場規模有望達 USD35mn,預計 2021-2026E CAGR 達到 17%。1H21 全球 AI 服務器廠商 競爭格局相對集中,其中浪潮信息占比最高(20.2%),其次是戴爾、HPE、聯想。

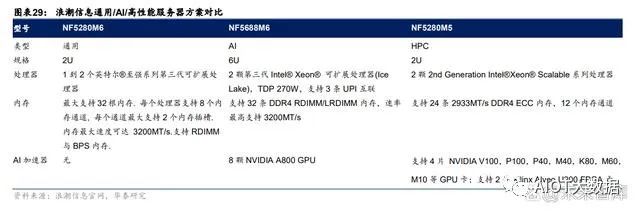

AI 服務器采用異構式架構,GPU 數量遠高于普通服務器

AI 大模型訓練和推理催生 GPU 需求上漲。目前 AI 訓練主要采用:1)英偉達在 AI 訓練 GPGPU:包括 V100/A100/H100(22 年下半年開始量產出貨)以及美國限制出口后英偉達 推出的裁剪版 A800。2)AMD 推出的 AI 訓練芯片包括 MI 250/250X/300。在推理芯片的選用方面,相較于訓練更多關注模型大小而言,推理更依賴于任務本質,以 此決定所需芯片種類。當需要大量內容/圖像 AI 生成式時,需要 GPU 進行推理計算(如英 偉達主流的 T4 芯片);而對于較簡單的推理過程(語音識別等),CPU 有時也會成為較好 的推理引擎。AI 服務器采用異構式架構,GPU 數量遠高于普通服務器。隨著多模態大模型 AI 服務器和 普通服務器的主要區別在于:1)架構不同。AI 服務器采用 CPU+GPU/FPGA/ASIC 等異構 式架構,而普通服務器一般是 CPU 架構;2)GPU 數量差異顯著。比較 NVIDIA DGX A100 和浪潮英信服務器 NF5280M6 構造,NVIDIA DGX A100 包括 8 個 A100 GPU 和 2 個 AMD Rome CPU,而浪潮英信服務器 NF5280M6 僅配置 1-2 個英特爾第三代 Xeon 處理器。僅 在 GPU 方面,一臺 AI 服務器就能夠帶來約 10 萬美元的價值量提升。

在單芯片計算訓練性能提升的基礎上,服務器整體能效的提升同樣受到關注

英偉達在此次 GTC 大會上推出 DGX H100 服務器,配有 8 個 H100 GPU 模組,配有 Transformer 引擎以支持處理類似 ChatGPT 的生成式訓練模型,FP8 精度在大型語言模型 相較上一代 A00 的訓練和推理能力分別提升 9/30 倍。8 個 H100 模組通過 NVLINK Switch 相連,確保 GPU 之間的合作和通信。我們認為,AI 服務器整體能效的提升驅動服務器各零部件升級需求,包括且不限于:1)AI 訓練和推理對網絡帶寬提出更高要求,有望催生光模塊速率進一步升級需求,其中 800G 光模塊有望加速放量;2)PCB:AI 服務器用 PCB 一般是 20-28 層,傳統服務器最多 16 層,每提升一層,PCB 價值量提升 1000 元左右,因此單臺 AI 服務器的 PCB 價值量約為 單臺傳統服務器的 3-4 倍;3)服務器半導體:GPU 方面,一臺 AI 服務器就能夠帶來約 10 萬美元的價值量提升,而大功率供電需求也驅動多相電源用量增長,進一步提升價值量。

服務器廠商有望借助“AI 算力革命”機遇再創高峰

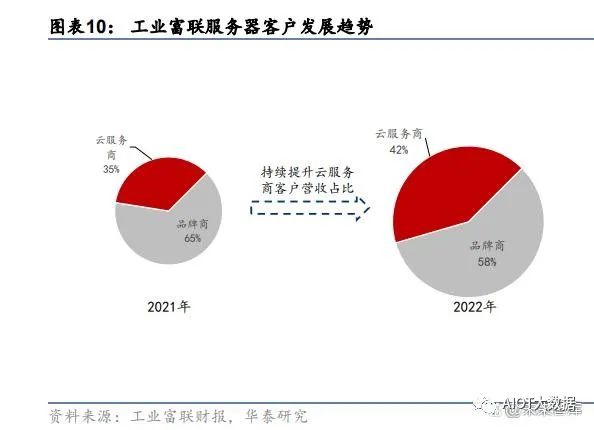

工業富聯作為提供服務器代工服務的龍頭廠商,將深度受益于 AI 服務器市場擴容帶來的機 會,有望憑借高性能的 AI 服務器迎來營收增長。客戶方面,相較于 2021 年,2022 年工業 富聯服務器營收中云服務商比重由 35%上升至 42%,來自云服務商客戶的營收占比持續提 升;產品方面,伴隨著 AI 硬件市場迅速成長,公司相關產品 2022 年出貨加倍,AI 服務器 及 HPC 出貨增長迅速,在 2022 年云服務商產品中占比增至約 20%。算力時代的開啟為高 效 AI 服務器提供了更廣闊的發展空間,據公司 2022 年報,相關新產品將在 2023 年陸續研 發推出。2022 年,工業富聯云服務設備占總營收比例超過 40%,考慮到收入增速超平均 的 CSP 業務占公司云設備業務比重上升,我們預測工業富聯服務器 23/24/25 年的收入增 幅為 8.6%/8.2%/8.2%,高于行業平均。

環旭電子:服務器和高速交換機主機板供應商,協助客戶推出邊緣 AI 計算服務器

環旭為客戶提供 ODM/JDM/EMS 伺服器、存儲、NAS 和 SSD 產品以及制造服務,并提供 L10 系統設計服務,包括主機板、固件 BIOS 和 BMC、子卡(背板、附加卡等)、外殼和散 熱設計以及系統集成。Al 服務器方面,環旭提供設計制造(JDM)服務,協助品牌客戶推出 邊緣 Al 計算服務器。根據環旭電子 2022 年業績快報,云端及存儲類業務營收達 69.89 億 元,同比增長 41.1%,占公司營收比例由 2021 年的 8.7%增長至 2022 年的 10.2%。我們 認為,受益于 AI 帶來的云端及邊緣計算新需求,公司云端及存儲類產品營收有望實現長期 穩健增長。

PCB 廠商如何把握 AI 大模型機會

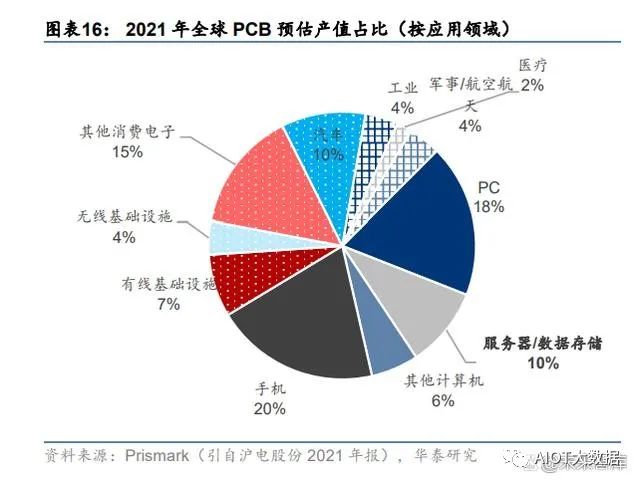

從下游應用來看,服務器/數據存儲是 PCB 重要的下游應用領域之一。根據 Prismark 數據, 預估 2021 年服務器/數據存儲占全球 PCB 產值的 10%,并預測其 2021-2026 年產值復合 增速在 PCB 下游細分領域中排名第一。

PCB 在服務器中主要用于:1)主板:服務器標配,且使用的 PCB 價值量最高;2)電源 背板:單獨設置或與主板集成;3)功能性配板:網卡、硬盤、內存、CPU 等。服務器用 PCB 的特點主要體現在高層數、高縱橫比、高密度及高傳輸速率,以高多層板、封裝基板 為主。

AIGC 大模型的訓練和推理需要大量的高性能計算算力支持,對 AI 服務器需求提升,同時 將進一步加速服務器平臺升級。整體來看,AI 大模型的發展對 PCB 的核心影響在于價值量 提升,包括:1)服務器平臺升級;2)AI 服務器對 PCB 的高要求。

服務器平臺升級對 PCB 的影響關鍵在于總線標準升級

價#1:服務器平臺升級對 PCB 的影響關鍵在于總線標準升級。其價增邏輯在于,服務器平 臺升級→PCIe 總線標準升級→傳輸速率提升→走線密度增加→PCB 層數、材料等級、工藝 (如背鉆)要求更高、更嚴格→PCB 價值量提升。以 Intel 服務器平臺為例,從 Purley 到 Whitley 再到即將量產的 Eagle Stream,對應的 PCIe 接口級別依次提升,分別為 PCIe 3.0、 4.0 和 5.0,PCB 層數從 12 層以下增加至 16 層以上,CCL 材料等級從 Mid Loss 升級至 Ultra Low Loss,對背鉆等技術的管控更嚴格。根據產業調研,從 Whitley 到 Engle Stream, PCB 層數雖僅增加 2-4 層,但價格差不多翻倍。以 ChatGPT 大模型引領的新一輪 AI 技術革命,將加速新一代服務器平臺滲透率提升及下 一代服務器平臺研發。從主流廠商規劃來看,AMD 的 Zen4 平臺和 Intel 的 Engle Stream 預計將在今年 Q3-Q4 開始上量,有望開啟新一輪服務器 PCB 上行周期。

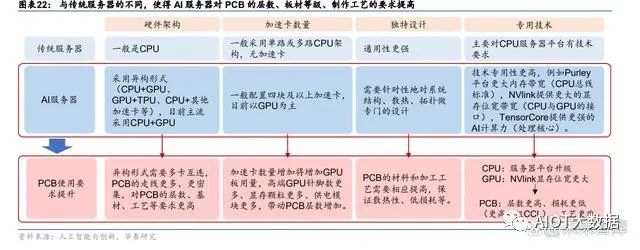

相比傳統服務器,AI 服務器的 PCB 層數更高,單臺 PCB 價值量大幅提升

價#2:相比傳統服務器,AI 服務器的 PCB 層數更高,單臺 PCB 價值量大幅提升。AI 服務 器與傳統服務器的區別主要在于:1)硬件架構更復雜:多采用“CPU+其他加速卡”的異 構形式,且目前 CPU+GPU 為主流;2)加速卡數量更多:一般配置四塊及以上加速卡;3) 設計更獨特:針對系統結構、散熱、拓撲等專門設計;4)技術更專用:如服務器平臺需要 更大內存帶寬,NVlink 提供更大的顯存位寬帶寬,TensorCore 提供更強的 AI計算力等。這些區別,尤其是 NVlink 這些特殊接口都使得 AI 服務器對 PCB 層數,通信速度都提出了 更高要求,從而帶動 AI 服務器的 PCB 價值量大幅提升。根據產業調研, AI 服務器用 PCB 一般是 20-28 層,傳統服務器最多 16 層,每提升一層, PCB 價值量提升 1000 元左右,因此單臺 AI 服務器的 PCB 價值量相較傳統服務器的 PCB 價值量將有明顯提升。

AI 服務器占全球服務器出貨量比例將逐年提升,長期仍有量增空間

量:AI 服務器占全球服務器出貨量比例將逐年提升,長期仍有量增空間。目前 AI 服務器占 整體服務器出貨量的比例并不高,但在智算算力需求的潛在預期下占比有望逐年提升,長 期看對 PCB/CCL 有增量空間。據 TrendForce 數據,截至 2022 年為止,預估搭載 GPGPU 的 AI 服務器年出貨量占整體服務器比重近 1%,預計在 ChatBot 相關應用加持下,2023 年 出貨量年增長可達 8%,另外預測其 2022-2026 年 CAGR 將達 10.8%,是全球整體服務器 的復合增速的 2 倍多。因此,AI 服務器對 PCB 的影響,短期以價值量提升為主,長期仍有 增量空間。

從競爭格局上看,大陸 PCB 廠商在全球服務器的競爭中已占據一席之地,但在 AI 服務器 領域參與度不高。AI 大模型要求多張 GPU 通過 NVLINK 等特殊接口緊密鏈接形成一張超 級 GPU,對高密度 PCB 板的層數、通信速度等提出更高要求。產業鏈公司包括生產通信 用高密度 PCB 的深南電路、滬電,興森科技等,以及生產高速 PCB 板用材料(M6)的生 益科技。

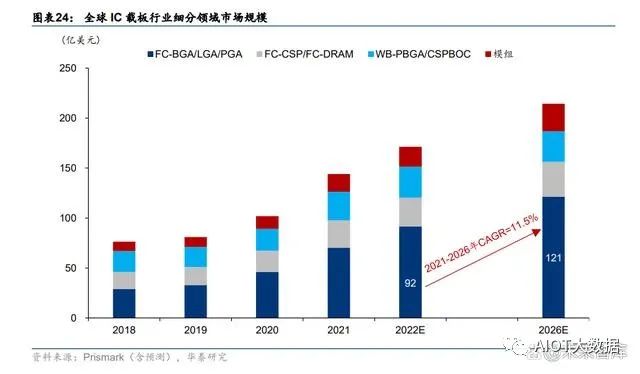

高算力需求帶動先進封裝需求,ABF 載板有望充分受益

高算力需求帶動先進封裝需求,ABF 載板有望充分受益。以 AI 大模型為基礎的 AIGC 新應 用快速興起,對算力的要求提高,服務器單機將搭載更多的 CPU/GPU 等芯片,解決多芯 片間高速互連的先進封裝成為關鍵。而 IC 載板作為先進封裝的關鍵材料,有望進一步打開 價值空間。尤其 ABF 載板,相較于 BT 載板具備層數多、面積大、線路密度高、線寬線距 小等特點,更能承載 AI 高性能運算,在 CPU、GPU、FPGA、ASIC 等高運算性能 IC 放量 預期下將更充分受益。據 Prismark 預測,ABF 載板為 IC 載板行業規模最大、增速最快的 細分領域,預計全球 ABF 載板市場規模 2026 年將達到 121 億美元,2021-2026 年 CAGR 為 11.5%。

從競爭格局看,載板技術壁壘較高,長期以日韓臺廠商為主,國內起步較晚。我們認為, 隨著半導體產業鏈的國產化替代加速,國內廠商仍有較大上升空間。

半導體廠商如何把握 AI 大模型機會

電源芯片:AI 服務器多相電源用量提升,國產替代空間廣闊

隨著大數據、云計算、人工智能概念的興起, CPU、GPU 對供電電壓調節器(VRM/Vcore) 和負載點電源 (PoL)的效率和功率提出了嚴峻挑戰。多相Buck電源包含控制器及DrMOS, 是一種多路交錯并聯的同步 Buck 拓撲,被公認為是此類應用場景的最佳解決方案。通過多 相控制器和 DrMOS 的組合使用,將多個降壓電路的輸出并聯使用,從而輸出數百安培到數 千安培的電流,適用于超大功率供電的需求。DrMOS 能給 CPU /GPU 電源設計帶來三點 優勢:1)更穩定的電源;2)power 零部件減少;3)power 零件小型化與線路簡潔化,滿 足下游產品輕薄短小但高效的需求。

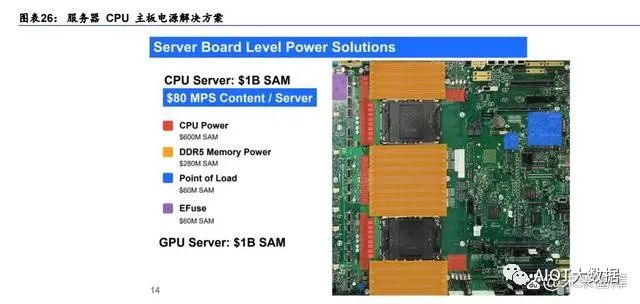

根據 MPS 數據,服務器主板電源解決方案涉及 CPU/GPU 供電、存儲 DDR 供電、POL 以及 EFuse 等產品,CPU 服務器及 GPU 服務器電源合計市場規模約 20 億美金。具體來 看 CPU、GPU 供電主要采用多相控制器+ DrMOS 模式。根據 MPS 官網,最初 CPU 采用 4 相,6 相,GPU 已經演進至采用 16 相供電,總市場規模約 6 億美金。POL(負載點電源) 則是分布與各個功能單元電路前端的 DC/DC 穩壓器,一臺服務器上有十多顆 POL,對應市 場規模約 6000 萬美金。由于 DDR5 標準將直流供電功能從主板轉移至內存條,因此每一 個內存條將額外包含一組 DC-DC 直流變壓電路。這種方式無疑會增加成本,總市場規模 約 2.8 億美金。電子保險絲 EFuse 用于為子電路或 PC 板提供局部快速響應保護, 對應全 球市場規模約 6000 萬美金。

AI 服務器采用異構式架構,NVIDIA DGX A100 服務器 8 個 GPU+2 個 CPU 的配置遠高于 普通服務器 1~2 個 CPU 的配置。單顆 NVIDIA A100 至少需要 16 相電源解決方案,單臺 AI 服務器所需多相電源數量呈幾何式增長。IDC 預計,全球 AI 服務器市場規模穩健增長, 2021-2026E CAGR 預計達 21%。我們認為,AI 大模型將帶動算力需求增長,催生對 AI 服務器的需求,帶動多相電源市場需求增加。

國外廠商主導 DrMOS及多相控制器市場,國內空白亟待彌補。由于DrMOS技術難點較多:1)大功率大電流的工藝——BCD 工藝;2)設計;3)封裝,DrMOS 在國內尚屬空白,國 產替代亟待推進。DrMOS 主要廠商為 MPS、ADI、TI 和安森美等,目前下游廠商幾乎只采 用海外 DrMOS 產品,如微星 B650 迫擊炮采用 MPS 產品, 2206/MP87670 單相提供額定 80A 電流。大陸廠商僅杰華特具有 DrMOS 量產能力,單芯片已經做到 70 安培,性能可與 國際一流廠商相比,有望彌補國內空白,目前公司 DrMOS 產品在服務器、筆電領域均實 現批量出貨。公司多相控制器產品目前處于送樣階段,未來會與 DrMOS 配套出貨。

計算芯片/存儲控制芯片:增加 AI 加速器芯片,提升計算效率

芯片端:增加 GPU 等 AI 加速芯片提升計算效率

AI 服務器與普通服務器相比,AI 服務器的芯片通常被優化和設計用于執行機器學習和深度 學習算法,常采用異構計算的方式。具體來看 1)CPU:AI 服務器和普通服務器都使用 CPU。但 AI 服務器通常會使用性能更高的 CPU, 以便更快地處理復雜的計算任務。2)GPU:GPU 是 AI 服務器的核心組成部分,在矩陣運算和深度學習模型訓練方面具有更 高的效率。相比之下,普通服務器通常只使用 CPU 而不使用 GPU。以浪潮信息為例,我 們看到 AI/HPC 服務器分別配備 8 顆 A800 GPU 以及 4 顆 V100/ P100 等英偉達 GPU。3)FPGA/ASIC:是專門為特定任務設計的芯片,與通用 CPU 或 GPU 相比,這兩類芯片 可以更快地執行特定的計算任務。我們看到 HPC 服務器相比通用/AI 服務器多配備 2 顆賽 靈思 FPGA,整體服務器的單機臺芯片用量預計隨著 AI 服務器的用量而顯著提升。

寒武紀訓練卡:思元 370 推訓一體實現硬件升級,同英偉達數據中心產品 T4/A10 直面競 爭,思元 590 加入浮點計算實測性能優異。目前寒武紀核心發力云端,其核心產品包括:1) 思元 370 于 2021 年推出,是寒武紀第三代云端產品采用 7nm 制程工藝,是寒武紀首款采 用 Chiplet(芯粒)技術的人工智能芯片。思元 370 智能芯片最大算力高達 256TOPS(INT8), 是寒武紀第二代云端推理產品思元270算力的2倍,產品形態包括3款加速卡:MLU370-S4、 MLU370-X4、MLU370-X8,已與國內主流互聯網廠商開展深入的應用適配。2)思元 590 在上一代思元 290 的基礎上增加浮點計算能力,采用 MLUarch05 全新架構,實測訓練性能 較在售旗艦產品有了大幅提升,它提供了更大的內存容量和更高的內存帶寬,其 IO 和片間 互聯接口也較上代實現大幅升級。

海光 DCU:公司 DCU 產品主要面向智能計算以及人工智能市場,采用高性能計算市場目 前主流的 GPGPU 架構。當前 DCU 產品綜合性能約為英偉達 A100 產品的 70%-80%,與 國內同行相比,公司的優勢在于:①全精度計算:公司產品覆蓋 64 位、32 位、16 位以 及整型 8 位訓練/推理;②兼容主流生態:兼容“類 CUDA”環境,能夠較好地適配、適應 國際主流商業計算軟件和人工智能軟件,并通過更好的性價比實現國產替代。海光 DCU 集 成片上高帶寬內存芯片,可以在大規模數據計算過程中提供優異的數據處理能力,使海光 DCU 可以廣泛應用于不同的場景。目前該產品可廣泛應用于大數據處理、人工智能、商業 計算等計算密集類應用領域,我們預計將在超算中心首先得到應用,長期來看將憑借當前 與互聯網公司、AI 廠商、先進計算中心以及智算中心的深度合作關系,實現從政府項目到 行業的破圈。

通信設備廠商如何把握 AI 大模型機會

光模塊:數據中心市場空間廣闊,2023 年有望迎 800G 放量元年

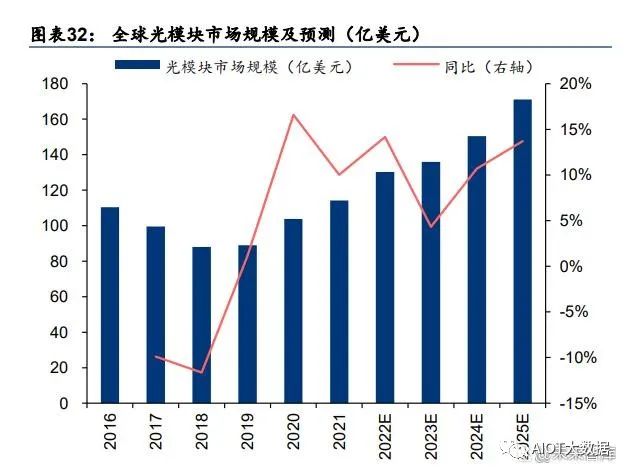

全球光模塊市場穩健增長,數據中心光模塊市場空間廣闊。根據 LightCounting 的統計及 預測,2019~2021 年,全球光模塊市場規模從 89 億美元增長到 114 億美元,預測 2025 年 全球光模塊市場將達到 171 億美元,對應 2022~2025 年 CAGR 為 10.65%。全球光模塊市 場結構方面,CWDM/DWDM 光模塊和用于數據中心的以太網光模塊占比較高,二者出貨 金額合計占比從 2019 年的 74%提升至 2021 年的 79%,其中光模塊市場規模為 47億美元, 占比為 41%,為光模塊中最大細分品類市場。

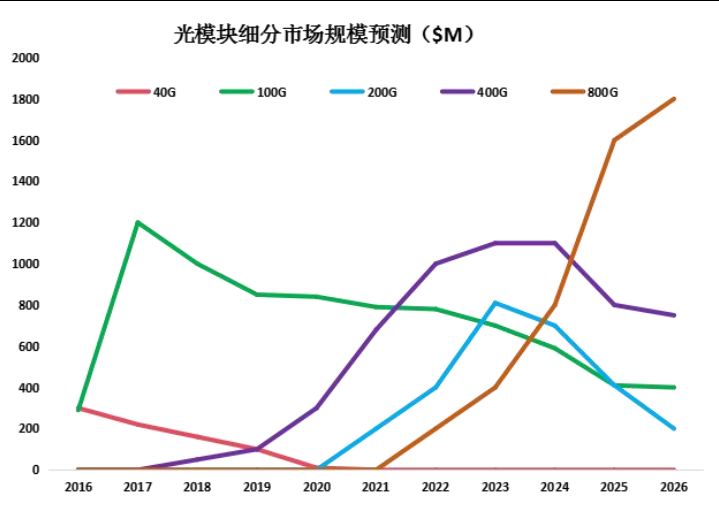

800G 有望迎接放量元年。隨著云計算、AI、元宇宙等技術產業的快速發展和傳統產業數字 化的轉型,全球范圍內數據快速的增長對網絡帶寬提出新的要求,有望催生光模塊速率升 級需求。LightCounting 指出,AI 應用等帶來的數據流量的增長,超預期的數據中心帶寬需 求以及光模塊廠商技術的迭代都是推動 800G 應用的動力。根據 LightCounting 于 2022 年 4 月發布的預測,2022~2024 年全球 800G 以太網光模塊出貨量有望達 11、39、119 萬只。我們認為隨著 800G 光模塊有望迎來放量元年,國內頭部光模塊以及上游光器件、光芯片 廠商有望迎發展機遇。

國內光模塊廠商彰顯全球競爭力。根據 Lightcounting 于 2022 年 5 月發布的統計數據,2021 年全球前十大光模塊廠商,中國廠商占據六席,分別為旭創(與 II-VI 并列第一)、華為海思 (第三)、海信寬帶(第五)、光迅科技(第六)、華工正源(第八)及新易盛(第九);相 比于 2010 年全球前十大廠商主要為海外廠商,國內僅 WTD(武漢電信器件有限公司,2012 年與光迅科技合并)一家公司入圍,體現出十年以來國產光模塊廠商競爭實力及市場地位 的快速提升。

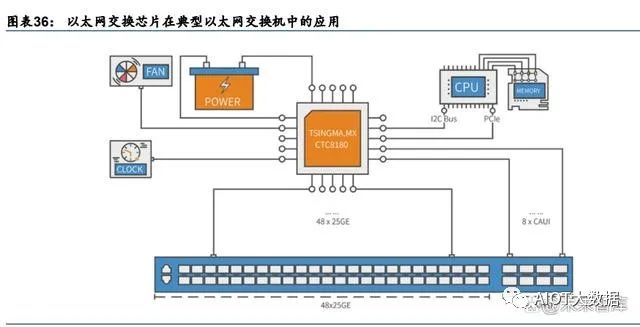

以太網交換機芯片:交換機核心部件,國產替代空間廣闊

以太網交換芯片是交換機核心部件。以太網交換機為用于網絡信息交換的網絡設備,是實 現各種類型網絡終端互聯互通的關鍵設備。交換設備由以太網交換芯片、CPU、PHY、PCB、 接口/端口子系統等組成,其中以太網交換芯片為最核心部件。交換芯片是用于交換處理大量數據及報文轉發的專用芯片,是針對網絡應用優化的專用集成電路(ASIC)。

全球以太網交換芯片市場增長穩健,國內增速領先。根據盛科通信招股書和灼識咨詢預測, 2020 年全球以太網交換芯片市場規模為 368 億元,同比下降 4.3%,預計 2020-2025E 年 均復合增速為 3.4%,2025 年全球市場規模為 434 億元。2020 年我國交換芯片市場規模為 90 億元,同比增長 25.2%,灼識咨詢預測 2025 年我國市場規模可達 171.4 億元,對應 2021E-2025E 復合增速為 13.8%,顯著領先全球增速。根據信通院,國內市場由于數據中 心等新基建領域政策環境向好(如東數西算、算力網絡建設等政策),而交換機作為搭建數 據中心架構的骨骼,用以保證數據傳輸穩定可靠,將隨之大量提振需求。

“高速化”:100G 及以上端口速率將成主流,應對下一代數據中心帶寬需求。端口速率是 以太網芯片的每個端口每秒鐘傳輸的最大 bit 數量,是衡量芯片性能的重要指標。近年數字 經濟的快速發展,推動了云計算、人工智能、大數據等技術產業的快速發展和傳統產業數 字化的轉型,全球范圍內數據快速的增長對網絡帶寬提出新的要求。根據信通院《數據中 心產業圖譜研究報告》預測,100G、400G 及以上的市場需求將逐漸增多,預計 400G 產 品最終會占據優勢地位,中長期來看,預計 400G 數據中心交換機 2022 年末有望成為營收 主力,2023 年開始 800G 交換機有望得到快速發展。根據灼識咨詢預測,100G 以上占比 將從 2020 年的 24.1%提升至 2025 年的 44.2%。

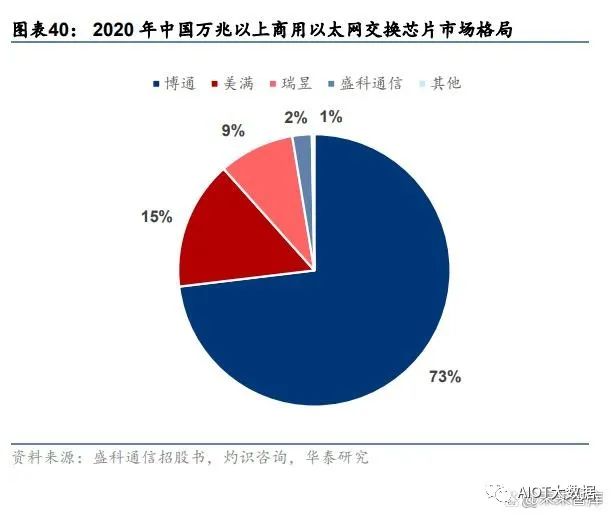

國內商用交換芯片行業集中度高,海外巨頭壟斷,盛科通信為頭部國產商。以太網交換芯 片領域由少數參與者掌握大部分份額,2020 年中國商用以太網交換芯片市場中,博通、美 滿和瑞昱分別以 61.7%、20.0%和 16.1%分列前三,CR3 達到 97.8%,博通的產品在超大 規模的云數據中心、HPC 集群與企業網絡市場上占據較高份額,為以太網交換芯片的全球 龍頭,是盛科發展方向借鑒的對象。由于交換芯片具備較高技術、客戶、應用和資金壁壘, 行業整體國產化程度較低,國內參與廠商較少。盛科通信在中國商用以太網交換芯片市場 中,以銷售額計占據 1.6%的份額,排名第四,在國產廠商中排名第一。此外,2020 年中 國萬兆以上商用以太網交換芯片市場中,盛科通信市占率達 2.3%。

AI產業化再加速,GPU智能大時代已開啟

(報告出品方/作者:華金證券,孫遠峰、王臣復、王海維)

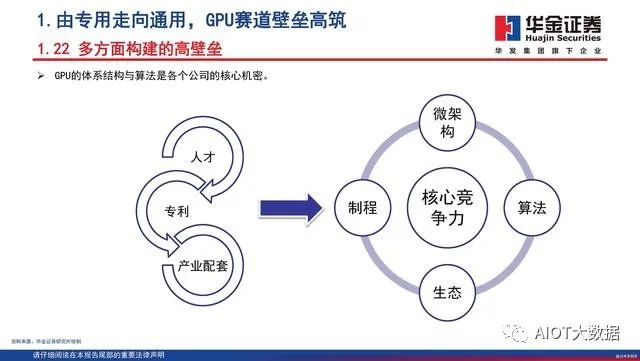

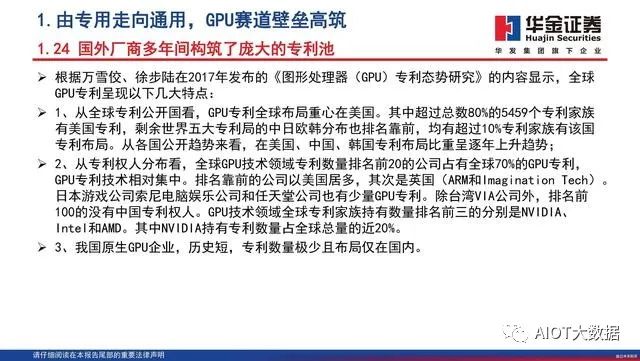

1.由專用走向通用,GPU賽道壁壘高筑

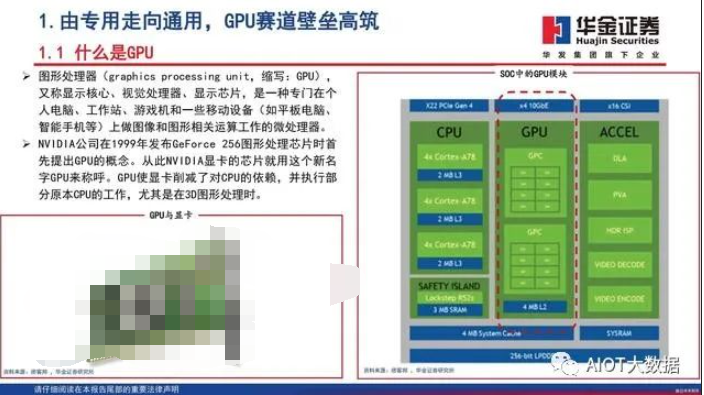

什么是GPU

圖形處理器(graphics processing unit,縮寫:GPU), 又稱顯示核心、視覺處理器、顯示芯片,是一種專門在個 人電腦、工作站、游戲機和一些移動設備(如平板電腦、 智能手機等)上做圖像和圖形相關運算工作的微處理器。NVIDIA公司在1999年發布GeForce 256圖形處理芯片時首 先提出GPU的概念。從此NVIDIA顯卡的芯片就用這個新名 字GPU來稱呼。GPU使顯卡削減了對CPU的依賴,并執行部 分原本CPU的工作,尤其是在3D圖形處理時。

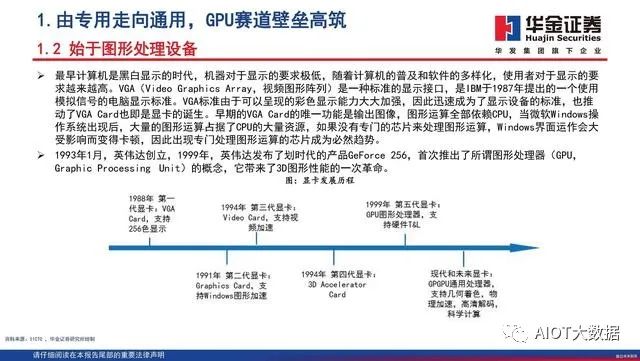

始于圖形處理設備

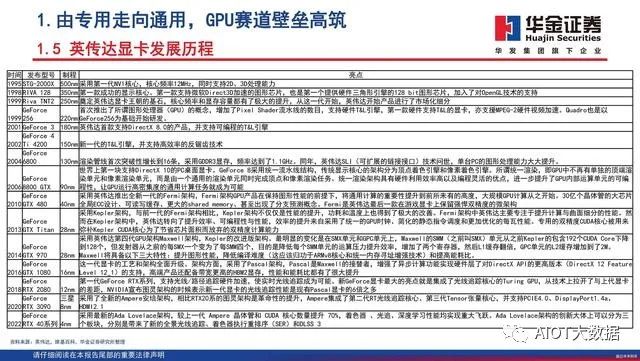

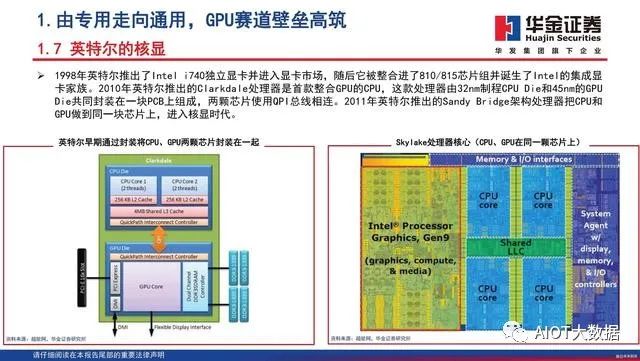

最早計算機是黑白顯示的時代,機器對于顯示的要求極低,隨著計算機的普及和軟件的多樣化,使用者對于顯示的要求越來越高。VGA(Video Graphics Array,視頻圖形陣列)是一種標準的顯示接口,是IBM于1987年提出的一個使用模擬信號的電腦顯示標準。VGA標準由于可以呈現的彩色顯示能力大大加強,因此迅速成為了顯示設備的標準,也推動了VGA Card也即是顯卡的誕生。早期的VGA Card的唯一功能是輸出圖像,圖形運算全部依賴CPU,當微軟Windows操作系統出現后,大量的圖形運算占據了CPU的大量資源,如果沒有專門的芯片來處理圖形運算,Windows界面運作會大受影響而變得卡頓,因此出現專門處理圖形運算的芯片成為必然趨勢。1993年1月,英偉達創立,1999年,英偉達發布了劃時代的產品GeForce 256,首次推出了所謂圖形處理器(GPU,Graphic Processing Unit)的概念,它帶來了3D圖形性能的一次革命。

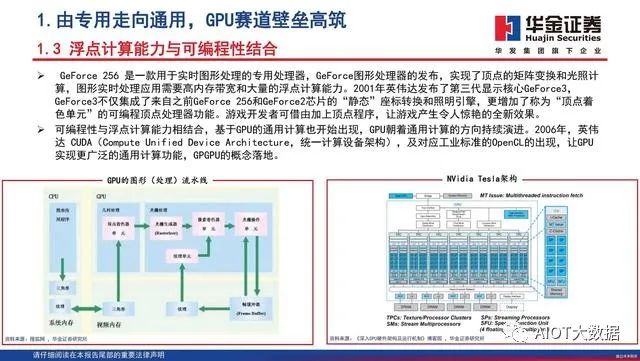

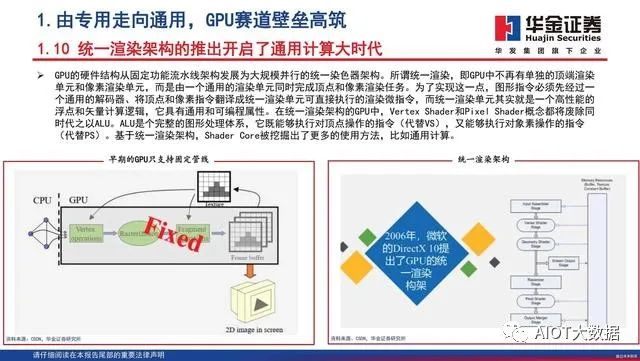

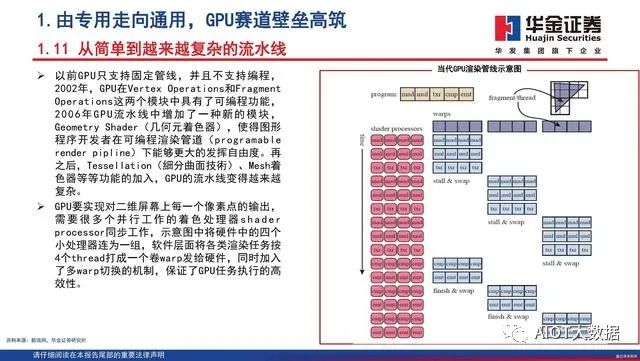

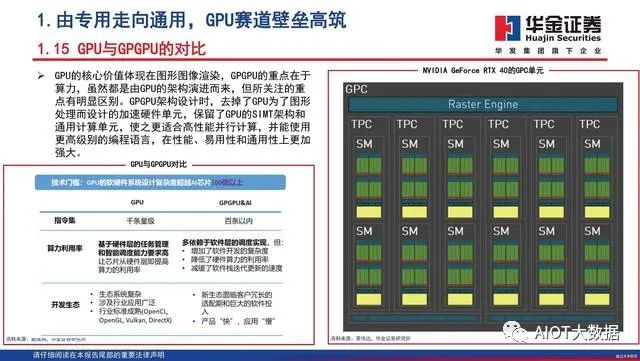

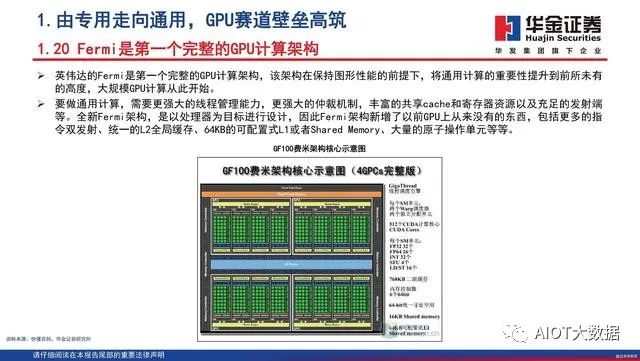

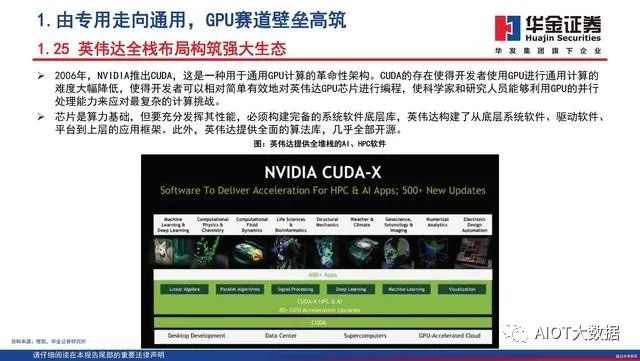

浮點計算能力與可編程性結合

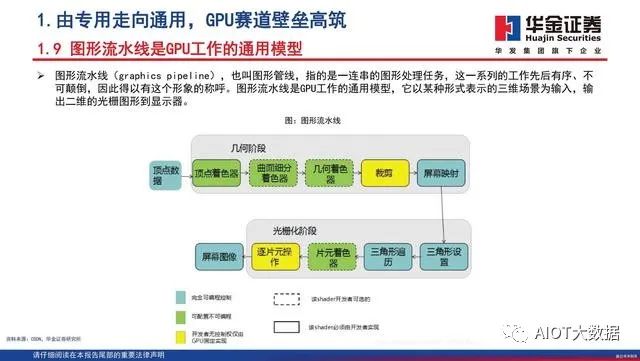

GeForce 256 是一款用于實時圖形處理的專用處理器,GeForce圖形處理器的發布,實現了頂點的矩陣變換和光照計算,圖形實時處理應用需要高內存帶寬和大量的浮點計算能力。2001年英偉達發布了第三代顯示核心GeForce3,GeForce3不僅集成了來自之前GeForce 256和GeForce2芯片的“靜態”座標轉換和照明引擎,更增加了稱為“頂點著色單元”的可編程頂點處理器功能。游戲開發者可借由加上頂點程序,讓游戲產生令人驚艷的全新效果。可編程性與浮點計算能力相結合,基于GPU的通用計算也開始出現,GPU朝著通用計算的方向持續演進。2006年,英偉達 CUDA(Compute Unified Device Architecture,統一計算設備架構),及對應工業標準的OpenCL的出現,讓GPU實現更廣泛的通用計算功能,GPGPU的概念落地。

GPU發展三大方向

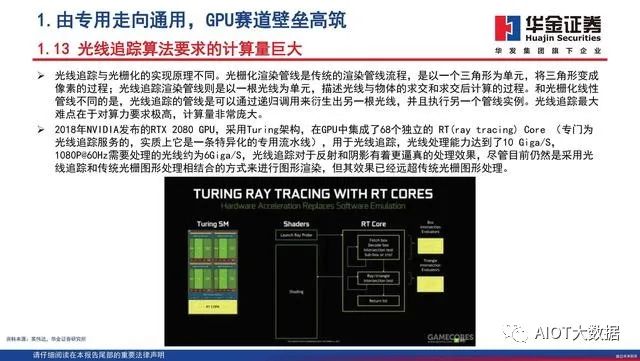

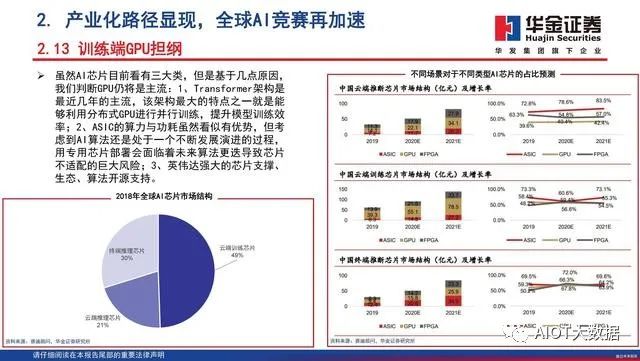

GPU最初用在PC和移動端上運行繪圖運算工作的微處理器,與CPU集成以集成顯卡(核顯)的形態發揮功能。NVIDIA于2007年率先推出獨立GPU(獨顯),使其作為“協處理器”在PC和服務器端負責加速計算,承接CPU計算密集部分的工作負載,同時由CPU繼續運行其余程序代碼。2019年NVIDIA的中國GTC大會設置了兩大主題:AI和圖形。從大會的關注重點可以看出,GPU未來趨勢主要是3個:大規模擴展計算能力的高性能計算(GPGPU)、人工智能計算(AIGPU)、更加逼真的圖形展現(光線追蹤RayTracingGPU)。

GeForce RTX 40系列,時代最強

2022秋季GTC大會上,英偉達發布GeForce RTX 40系列GPU,旨在為游戲玩家和創作者提供革命 性性能,其中新旗艦產品RTX 4090 GPU的性能相 較上一代提升最高可達4倍。作為全球首款基于 全新NVIDIA Ada Lovelace架構的GPU,RTX 40 系列在性能和效率上都實現了巨大的代際飛躍, 根據NVIDIA創始人兼首席執行官黃仁勛的介紹, RTX光線追蹤和神經網絡渲染的時代正在全面展 開。RTX 40系列GPU具有一系列新的技術創新:包括 流式多處理器具有高達83 TFLOPS的著色器能力、 第三代RT Cores的有效光線追蹤計算能力達到 191 TFLOPS、第四代Tensor Cores具有高達1.32 Petaflops的FP8張量處理性能、著色器執行重排 序(SER)通過即時重新安排著色器負載來提高 執行效率、Ada光流加速器帶來2倍的性能提升、 架構上改進來實現與TSMC 4N定制工藝技術緊密 結合等。

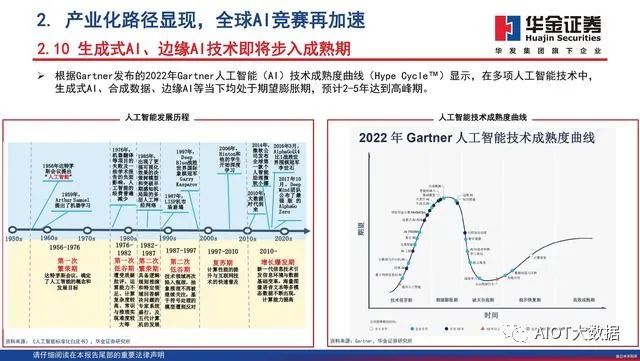

2. 產業化路徑顯現,全球AI競賽再加速

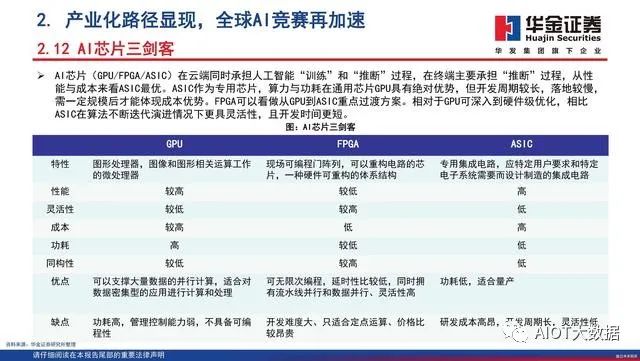

AI技術賦能實體經濟面臨的瓶頸

過去,絕大部分人工智能企業和研究機構遵循算法、算力和數據三位一體的研究范式,即以一定的算力和數據為基礎,使用開源算法框架訓練智能模型。而這也導致了當前大部分人工智能處于“手工作坊式”階段,面對各類行業的下游應用,AI逐漸展現出碎片化、多樣化的特點,也出現了模型通用性不高的缺陷。這不僅是AI技術面臨的挑戰,也限制了AI的產業化進程。隨著人工智能賦能實體經濟進入深水區,企業通常面臨數據資源有限、算力投資難度大、模型泛化能力差、高水平人才稀缺的發展瓶頸。

ChatGPT的破圈

聊天生成型預訓練變換模型(Chat Generative Pre-trained Transformer)簡稱ChatGPT,是OpenAI開發的人工智慧聊天機器人程序,于2022年11月推出,上線兩個月后已有上億用戶。ChatGPT目前仍以文字方式互動,而除了可以用人類自然對話方式來互動,還可以用于甚為復雜的語言工作,包括自動生成文本、自動問答、自動摘要等多種任務。

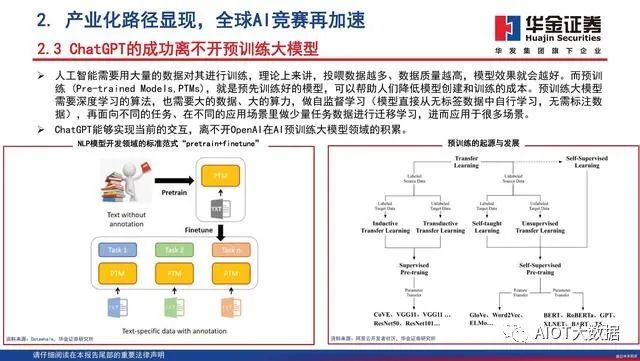

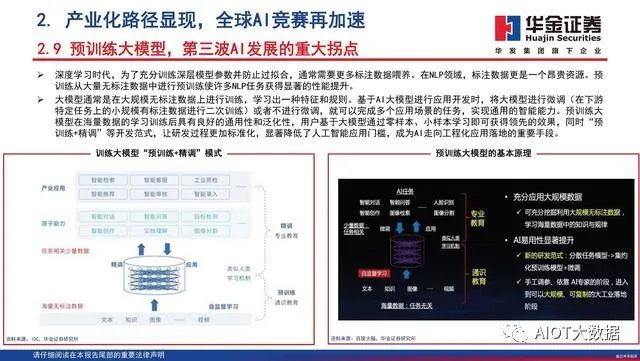

ChatGPT的成功離不開預訓練大模型

人工智能需要用大量的數據對其進行訓練,理論上來講,投喂數據越多、數據質量越高,模型效果就會越好。而預訓練 (Pre-trained Models,PTMs),就是預先訓練好的模型,可以幫助人們降低模型創建和訓練的成本。預訓練大模型需要深度學習的算法,也需要大的數據、大的算力,做自監督學習(模型直接從無標簽數據中自行學習,無需標注數據),再面向不同的任務、在不同的應用場景里做少量任務數據進行遷移學習,進而應用于很多場景。ChatGPT能夠實現當前的交互,離不開OpenAI在AI預訓練大模型領域的積累。

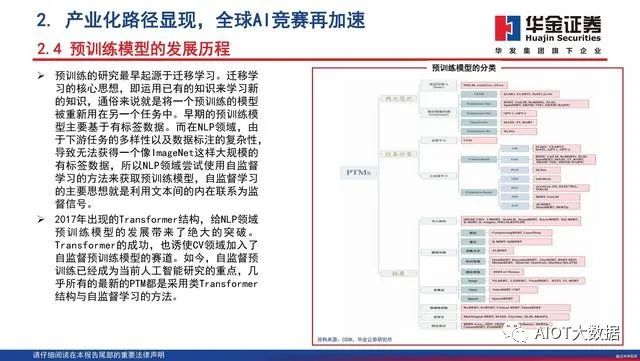

預訓練模型的發展歷程

預訓練的研究最早起源于遷移學習。遷移學 習的核心思想,即運用已有的知識來學習新 的知識,通俗來說就是將一個預訓練的模型 被重新用在另一個任務中。早期的預訓練模 型主要基于有標簽數據。而在NLP領域,由 于下游任務的多樣性以及數據標注的復雜性, 導致無法獲得一個像ImageNet這樣大規模的 有標簽數據,所以NLP領域嘗試使用自監督 學習的方法來獲取預訓練模型,自監督學習 的主要思想就是利用文本間的內在聯系為監 督信號。2017年出現的Transformer結構,給NLP領域 預訓練模型的發展帶來了絕大的突破。Transformer的成功,也誘使CV領域加入了 自監督預訓練模型的賽道。如今,自監督預 訓練已經成為當前人工智能研究的重點,幾 乎所有的最新的PTM都是采用類Transformer 結構與自監督學習的方法。

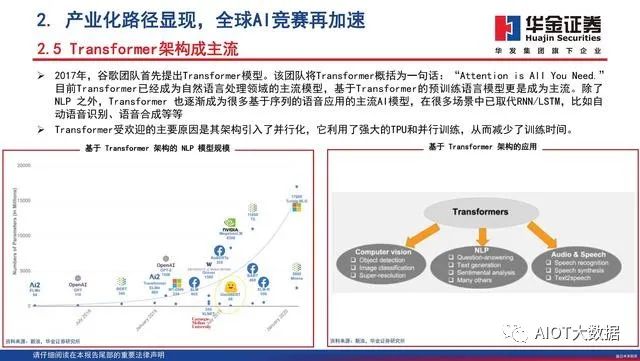

Transformer架構成主流

2017年,谷歌團隊首先提出Transformer模型。該團隊將Transformer概括為一句話:“Attention is AllYouNeed.”目前Transformer已經成為自然語言處理領域的主流模型,基于Transformer的預訓練語言模型更是成為主流。除了NLP 之外,Transformer 也逐漸成為很多基于序列的語音應用的主流AI模型,在很多場景中已取代RNN/LSTM,比如自動語音識別、語音合成等等 。Transformer受歡迎的主要原因是其架構引入了并行化,它利用了強大的TPU和并行訓練,從而減少了訓練時間。

3. 全維智能化大時代,國產算力行則必至

全球數據中心負載任務量快速增長

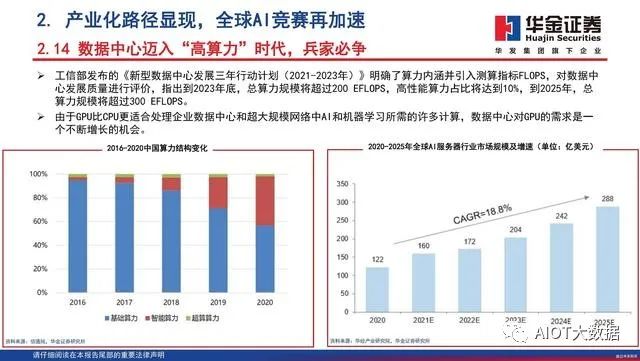

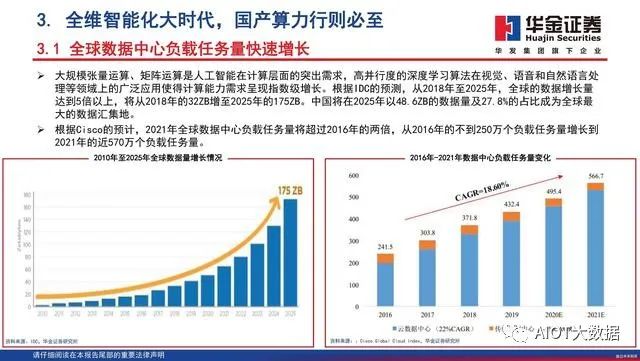

大規模張量運算、矩陣運算是人工智能在計算層面的突出需求,高并行度的深度學習算法在視覺、語音和自然語言處理等領域上的廣泛應用使得計算能力需求呈現指數級增長。根據IDC的預測,從2018年至2025年,全球的數據增長量達到5倍以上,將從2018年的32ZB增至2025年的175ZB。中國將在2025年以48.6ZB的數據量及27.8%的占比成為全球最大的數據匯集地。根據Cisco的預計,2021年全球數據中心負載任務量將超過2016年的兩倍,從2016年的不到250萬個負載任務量增長到2021年的近570萬個負載任務量。

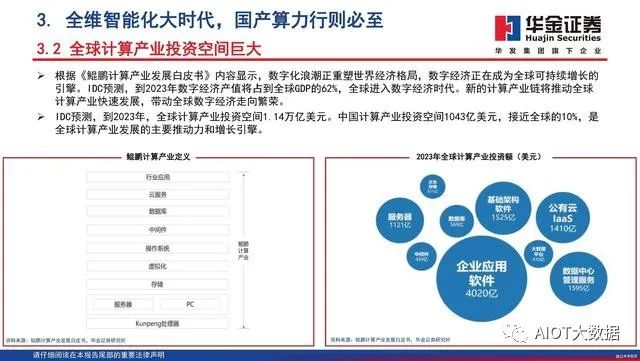

全球計算產業投資空間巨大

根據《鯤鵬計算產業發展白皮書》內容顯示,數字化浪潮正重塑世界經濟格局,數字經濟正在成為全球可持續增長的引擎。IDC預測,到2023年數字經濟產值將占到全球GDP的62%,全球進入數字經濟時代。新的計算產業鏈將推動全球計算產業快速發展,帶動全球數字經濟走向繁榮。IDC預測,到2023年,全球計算產業投資空間1.14萬億美元。中國計算產業投資空間1043億美元,接近全球的10%,是全球計算產業發展的主要推動力和增長引擎。

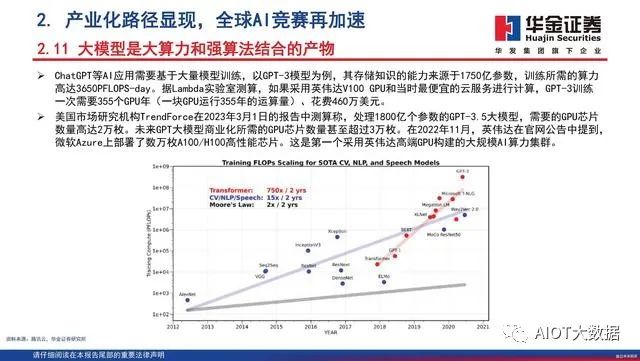

預訓練大模型對于GPU的需求

根據TrendForce的估計,2020年,GPT模型處理訓練數據所需的GPU數量達到了20000左右。展望未來,GPT模型(或ChatGPT)商業化所需的GPU數量預計將達到30000個以上。這些均使用英偉達的A100 GPU作為計算基礎。根據中關村在線的新聞顯示,目前英偉達A100顯卡的售價在1.00~1.50萬美元之間。英偉達還將A100作為DGXA100系統的一部分進行銷售,該系統具有八塊A100,兩塊AMD Rome 7742 CPU,售價高達199,000美元。

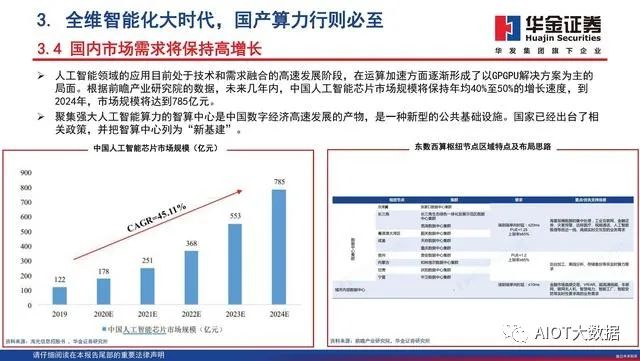

國內市場需求將保持高增長

人工智能領域的應用目前處于技術和需求融合的高速發展階段,在運算加速方面逐漸形成了以GPGPU解決方案為主的局面。根據前瞻產業研究院的數據,未來幾年內,中國人工智能芯片市場規模將保持年均40%至50%的增長速度,到2024年,市場規模將達到785億元。聚集強大人工智能算力的智算中心是中國數字經濟高速發展的產物,是一種新型的公共基礎設施。國家已經出臺了相關政策,并把智算中心列為“新基建”。

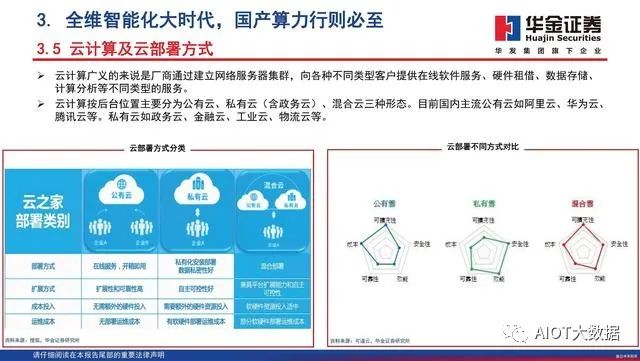

云計算及云部署方式

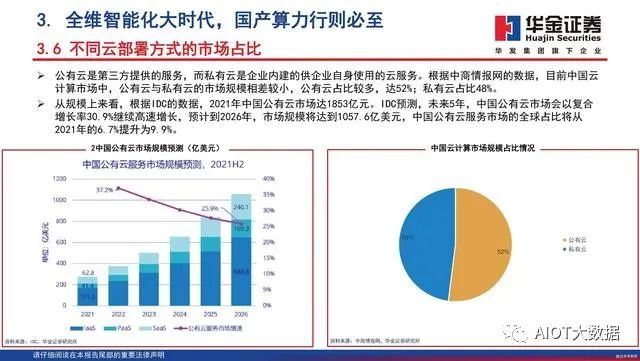

云計算廣義的來說是廠商通過建立網絡服務器集群,向各種不同類型客戶提供在線軟件服務、硬件租借、數據存儲、計算分析等不同類型的服務。云計算按后臺位置主要分為公有云、私有云(含政務云)、混合云三種形態。目前國內主流公有云如阿里云、華為云、騰訊云等。私有云如政務云、金融云、工業云、物流云等。

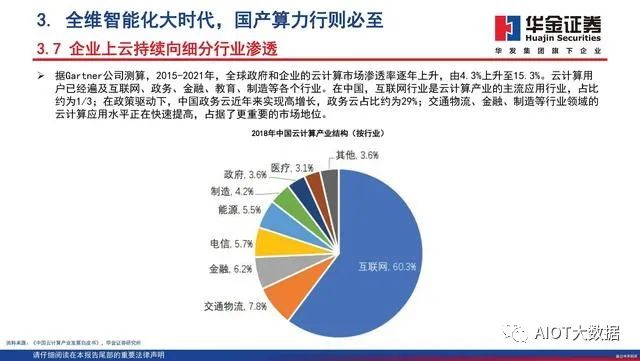

企業上云持續向細分行業滲透

據Gartner公司測算,2015-2021年,全球政府和企業的云計算市場滲透率逐年上升,由4.3%上升至15.3%。云計算用戶已經遍及互聯網、政務、金融、教育、制造等各個行業。在中國,互聯網行業是云計算產業的主流應用行業,占比約為1/3;在政策驅動下,中國政務云近年來實現高增長,政務云占比約為29%;交通物流、金融、制造等行業領域的云計算應用水平正在快速提高,占據了更重要的市場地位。

4.重點公司分析

瑞芯微主要致力于大規模集成電路及應用方案的設計、開發和銷售,在大規模SoC芯片設計、數模混合芯片設計、影像處理、高清視頻編解碼、人工智能及系統軟件開發上具有豐富的經驗和技術儲備,形成了多層次、多平臺、多場景的專業解決方案,賦能智能硬件、機器視覺、行業應用、消費電子、汽車電子等多元領域。公司產品涵蓋智能應用處理器芯片、數模混合芯片、接口轉換芯片、無線連接芯片及與自研芯片相關的模組產品等,并為客戶提供技術服務。

晶晨股份

晶晨半導體是全球布局、國內領先的無晶圓半導體系統設計廠商,為智能機頂盒、智能電視、音視頻系統終端、無線連接及車載信息娛樂系統等多個產品領域提供多媒體SoC芯片和系統級解決方案,業務覆蓋全球主要經濟區域,積累了全球知名的客戶群。產品技術先進性和市場覆蓋率位居行業前列,為智能機頂盒芯片的領導者、智能電視芯片的引領者和音視頻系統終端芯片的開拓者。晶晨半導體擁有豐富的SoC全流程設計經驗,堅持超高清多媒體編解碼和顯示處理、內容安全保護、系統IP等核心軟硬件技術開發,整合業界領先的CPU/GPU技術和先進制程工藝,實現前所未有的成本、性能和功耗優化,提供基于多種開放平臺的完整系統解決方案,幫助全球頂級運營商、OEM、ODM等客戶快速部署市場。

星宸科技

公司為全球領先的視頻監控芯片企業,主營業務為視頻監控芯片的研發及銷售,產品主要應用于智能安防、視頻對講、智能車載等領域。公司在芯片設計全流程具有豐富經驗,可支撐大型先進工藝下的SoC設計。公司自研全套AI技術,包含AI處理器指令集、AI處理器IP及其編譯器、仿真器等全套AI處理器工具鏈。公司擁有大量核心IP資源,包含圖像IP、視頻IP、高速模擬IP和音頻IP等。公司在視頻監控領域持續研發創新,在圖像信號處理、音視頻編解碼、顯示處理等領域具有領先優勢,并積極投入AI等新領域的芯片研發。公司擁有ISP技術、AI處理器技術、多模視頻編碼技術、高速高精度模擬電路技術、先進制程SoC芯片設計技術等多項核心技術,公司擁有已授權專利92項,其中境內發明專利11項,境外專利81項;在申請中專利154項,其中境內發明專利63項,境外專利91項。

公司是領先的智能應用處理器SoC、高性能模擬器件和無線互聯芯片設計廠商。公司目前的主營業務為系智能應用處理器SoC、高性能模擬器件和無線互聯芯片的研發與設計。主要產品為智能應用處理器SoC、高性能模擬器件和無線互聯芯片,產品廣泛適用于智能硬件、平板電腦、智能家電、車聯網、機器人、虛擬現實、網絡機頂盒以及電源模擬器件、無線通信模組、智能物聯網等多個產品領域。公司以客戶為中心,凝聚卓越團隊和堅持核心技術長期投入,在超高清視頻編解碼、高性能CPU/GPU/AI多核整合、先進工藝的高集成度、超低功耗、全棧集成平臺等方面提供具有市場突出競爭力的系統解決方案和貼心服務。

報告節選:

編輯:黃飛

?

電子發燒友App

電子發燒友App

評論