當(dāng)您深入了解生成式 AI 處理時(shí),系統(tǒng)設(shè)計(jì)會帶來了很多挑戰(zhàn)。接下來讓我們了解效率、功耗和內(nèi)存問題是如何發(fā)揮作用的。

在不到一年的時(shí)間里,生成式人工智能通過OpenAI的ChatGPT(一種基于transformers的流行算法)獲得了全球聲譽(yù)和使用。基于transformers的算法可以學(xué)習(xí)對象不同元素(如句子或問題)之間的復(fù)雜交互,并將其轉(zhuǎn)換為類似人類的對話。

在transformers和其他大型語言模型(LLM)的推動下,軟件算法取得了飛速發(fā)展,但執(zhí)行這些算法的處理硬件卻落后了。即使是最先進(jìn)的算法處理器也不具備必要的性能,無法在一兩秒的時(shí)間內(nèi)完成最新的 ChatGPT 查詢。

為了彌補(bǔ)性能上的不足,領(lǐng)先的半導(dǎo)體公司使用大量最好的硬件處理器構(gòu)建系統(tǒng)。為此,他們在功耗、帶寬/延遲和成本之間進(jìn)行了權(quán)衡。這種方法適用于算法訓(xùn)練,但不適用于部署在邊緣設(shè)備上的推理。?

功耗挑戰(zhàn)

雖然訓(xùn)練通常基于 fp32 或 fp64 浮點(diǎn)運(yùn)算來生成大量數(shù)據(jù),但對延遲要求并不嚴(yán)格。它的功耗高,成本也高。

推理過程則截然不同。推理通常是在 fp8 算法上進(jìn)行的,它仍然會產(chǎn)生大量數(shù)據(jù),但要求嚴(yán)格的延遲、低能耗和低成本。

模型訓(xùn)練的解決方案來自計(jì)算農(nóng)場。計(jì)算農(nóng)場需要運(yùn)行數(shù)天,使用大量電力,產(chǎn)生大量熱量,購置、安裝、運(yùn)行和維護(hù)費(fèi)用高昂。更糟糕的是,推理過程會碰壁,阻礙 GenAI 在邊緣設(shè)備上的普及。

推理過程則大不相同。推理通常在 fp8 算法上執(zhí)行,該算法仍會產(chǎn)生大量數(shù)據(jù),但需要關(guān)鍵延遲、低能耗和低成本。

模型訓(xùn)練的解決方案來自計(jì)算場(computing farm)。需要運(yùn)行數(shù)天,使用大量電力,產(chǎn)生大量熱量,購置、安裝、運(yùn)行和維護(hù)費(fèi)用高昂。更糟糕的是,推理過程會碰壁,阻礙 GenAI 在邊緣設(shè)備上的普及。

邊緣生成式人工智能推理技術(shù)現(xiàn)狀

用于 GenAI 推斷的成功硬件加速器必須滿足五個(gè)屬性:

處理能力達(dá)到 petaflops 級,效率高(超過 50%)

低延遲,在幾秒內(nèi)提供查詢響應(yīng)

能耗控制在 50W/Petaflops 或以下

與邊緣應(yīng)用兼容的經(jīng)濟(jì)實(shí)惠的成本

現(xiàn)場可編程,可進(jìn)行軟件更新或升級,避免在工廠進(jìn)行硬件改造

現(xiàn)有的大多數(shù)硬件加速器都能滿足部分要求,但不能滿足所有要求。古老的 CPU 是最差的選擇,因?yàn)樗膱?zhí)行速度無法令人接受;GPU 的速度相當(dāng)快,但功耗高,延遲不足(因此成為訓(xùn)練的選擇);FPGA 在性能和延遲方面都有妥協(xié)。

完美的設(shè)備應(yīng)該是定制/可編程的片上系統(tǒng)(SoC),設(shè)計(jì)用于執(zhí)行基于transformers的算法以及其他類型的算法。它應(yīng)支持適當(dāng)?shù)膬?nèi)存容量,以存儲嵌入 LLM 的海量數(shù)據(jù),并可編程,以適應(yīng)現(xiàn)場升級。

實(shí)現(xiàn)這一目標(biāo)有兩個(gè)障礙:內(nèi)存墻和 CMOS 設(shè)備的高能耗。

內(nèi)存墻

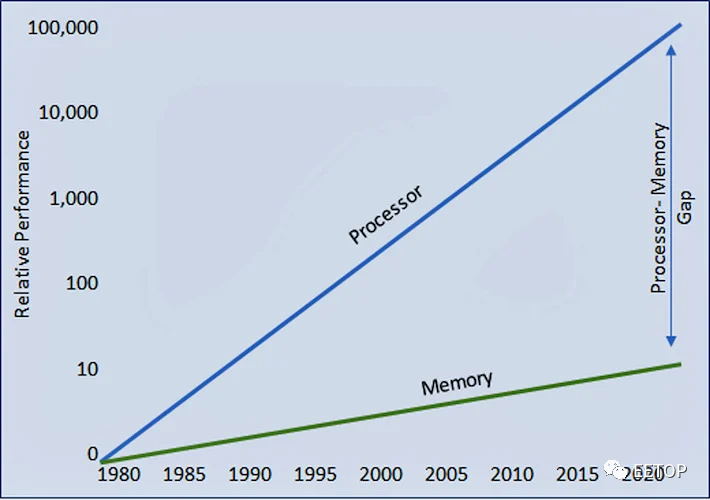

在半導(dǎo)體發(fā)展歷史的早期,人們觀察到處理器性能的進(jìn)步被內(nèi)存訪問速度進(jìn)展緩慢所抵消。

隨著時(shí)間的推移,兩者之間的差距繼續(xù)分化,迫使處理器等待越來越長的時(shí)間讓內(nèi)存提供數(shù)據(jù)。結(jié)果是處理器效率從完全 100% 利用率下降(圖 1)。

圖1.處理器性能的進(jìn)步繼續(xù)受到內(nèi)存高效傳輸數(shù)據(jù)能力的阻礙。圖片由VSORA提供

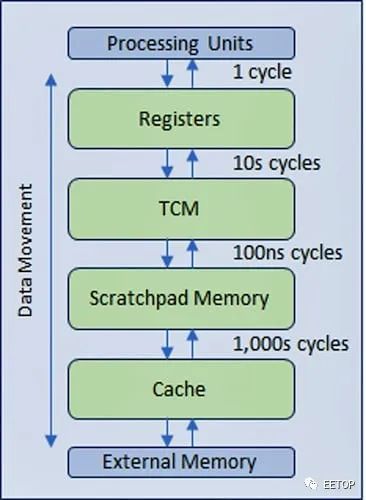

為了緩解效率的下降,業(yè)界設(shè)計(jì)了一種多級分層內(nèi)存結(jié)構(gòu),在處理器附近采用更快、更昂貴的內(nèi)存技術(shù),用于多級緩存,從而最大限度地減少主內(nèi)存較慢甚至較慢的外部內(nèi)存的流量(圖 2)。

圖2.靠近處理器的多級分層內(nèi)存結(jié)構(gòu)包括多級緩存,可最大限度地減少主內(nèi)存和外部內(nèi)存較慢的流量。圖片由VSORA提供

CMOS IC的能耗

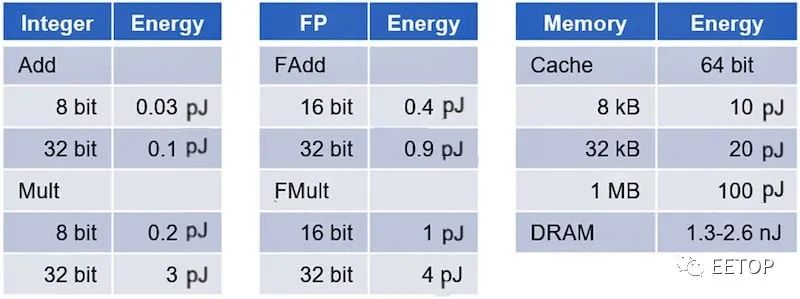

與直覺相反,CMOS IC的功耗主要是數(shù)據(jù)移動而不是數(shù)據(jù)處理。內(nèi)存訪問的功耗比基于斯坦福大學(xué)Mark Horowitz教授領(lǐng)導(dǎo)的一項(xiàng)研究的基本數(shù)字邏輯計(jì)算消耗的能量高出幾個(gè)數(shù)量級(表1)。

表 1.這些表比較了簡單算術(shù)運(yùn)算符與內(nèi)存訪問的能耗。圖片由斯坦福大學(xué)提供

在使用整數(shù)運(yùn)算時(shí),加法器和乘法器的能耗不到 1 皮焦,而在處理浮點(diǎn)運(yùn)算時(shí),加法器和乘法器的能耗只有幾皮焦。相比之下,在高速緩存中訪問數(shù)據(jù)所耗費(fèi)的能量則會躍升一個(gè)數(shù)量級,達(dá)到 20-100 皮焦,而在 DRAM 中訪問數(shù)據(jù)所耗費(fèi)的能量則會躍升三個(gè)數(shù)量級,超過 1000 皮焦。

GenAI加速器是以數(shù)據(jù)移動為主導(dǎo)的設(shè)計(jì)的典型例子。

內(nèi)存墻和能耗對延遲和效率的影響

生成式AI處理中內(nèi)存墻和能耗的影響正變得難以控制。

在短短幾年內(nèi),ChatGPT 的基礎(chǔ)模型 GPT 就從 2019 年的 GPT-2 演進(jìn)到 2020 年的 GPT-3,再到 2022 年的 GPT-3.5,直至目前的 GPT-4。每一代模型的規(guī)模和參數(shù)(權(quán)重、令牌和狀態(tài))數(shù)量都有數(shù)量級的增長。

GPT-2 模型包含 15 億個(gè)參數(shù),GPT-3 模型包含 1 750 億個(gè)參數(shù),而最新的 GPT-4 模型則將參數(shù)數(shù)量增加到約 1.7 萬億個(gè)(官方數(shù)字尚未公布)。

這些參數(shù)的龐大數(shù)量不僅迫使內(nèi)存容量達(dá)到 TB 級,而且在訓(xùn)練/推理過程中同時(shí)高速訪問這些參數(shù)也將內(nèi)存帶寬推高到數(shù)百 GB/秒,甚至 TB/秒。更糟糕的是,移動這些參數(shù)會消耗大量能源。

昂貴的硬件閑置

內(nèi)存和處理器之間令人生畏的數(shù)據(jù)傳輸帶寬和明顯的功耗使處理器效率不堪重負(fù)。最近的分析表明,在尖端硬件上運(yùn)行 GPT-4 的效率下降到 3% 左右。為運(yùn)行這些算法而設(shè)計(jì)的昂貴硬件 97% 的時(shí)間都處于閑置狀態(tài)。

執(zhí)行效率越低,執(zhí)行相同任務(wù)所需的硬件就越多。例如,假設(shè)有兩個(gè)供應(yīng)商可以滿足 1 Petaflops(1000 Teraflops)的需求。供應(yīng)商(A 和 B)的處理效率不同,分別為 5%和 50%(表 2)。

那么供應(yīng)商 A 只能提供 50 Teraflops 的有效處理能力,而非理論處理能力。供應(yīng)商 B 將提供 500 Teraflops 的處理能力。要提供 1 petaflop 的有效計(jì)算能力,供應(yīng)商 A 需要 20 個(gè)處理器,而供應(yīng)商 B 只需要 2 個(gè)。

表 2.具有不同處理效率的兩個(gè)處理器供應(yīng)商需要不同數(shù)量的處理器才能滿足1 Petaflops 的可用性能。圖片由VSORA提供

例如,硅谷一家初創(chuàng)公司計(jì)劃在其超級計(jì)算機(jī)數(shù)據(jù)中心使用 22,000 個(gè) Nvidia H100 GPU。粗略計(jì)算,22000 個(gè) H100 GPU 的價(jià)格為 8 億美元,這是其最新融資的大部分。這個(gè)數(shù)字還不包括基礎(chǔ)設(shè)施的其他成本、房地產(chǎn)、能源成本以及企業(yè)內(nèi)部硬件總擁有成本(TCO)中的所有其他因素。

系統(tǒng)復(fù)雜性對延遲和效率的影響

另一個(gè)基于目前最先進(jìn)的基因人工智能培訓(xùn)加速器的例子將有助于說明這一關(guān)切。這家硅谷初創(chuàng)公司對GPT-4的配置將需要在HGX H100或DGX H100系統(tǒng)上以8組部署22,000個(gè)Nvidia H100 GPU,總共需要2,750個(gè)系統(tǒng)。

考慮到 GPT-4 包括 96 個(gè)解碼器,將它們映射到多個(gè)芯片上可能會減輕對延遲的影響。由于 GPT 結(jié)構(gòu)允許順序處理,因此每個(gè)芯片分配一個(gè)解碼器,總共 96 個(gè)芯片,可能是一個(gè)合理的設(shè)置。

這種配置相當(dāng)于 12x 個(gè) HGX/DGX H100 系統(tǒng),不僅會影響單個(gè)芯片之間的數(shù)據(jù)傳輸延遲,還會影響板卡之間和系統(tǒng)之間的數(shù)據(jù)傳輸延遲。使用增量transformers可以顯著降低處理復(fù)雜性,但需要處理和存儲狀態(tài),這反過來又增加了需要處理的數(shù)據(jù)量。

最重要的是,前面提到的3%的實(shí)施效率是不現(xiàn)實(shí)的。當(dāng)加上系統(tǒng)實(shí)現(xiàn)的影響以及相關(guān)的更長延遲時(shí),實(shí)際應(yīng)用中的實(shí)際效率將顯著下降。

從長遠(yuǎn)來看,GPT-3.5 所需的數(shù)據(jù)量遠(yuǎn)不及 GPT-4。從商業(yè)角度來看,使用類似 GPT-3 的復(fù)雜性比 GPT-4 更具吸引力。另一方面,GPT-4 更準(zhǔn)確,如果可以解決硬件挑戰(zhàn),它將成為首選。

最佳成本分析

讓我們把重點(diǎn)放在能夠處理大量查詢的系統(tǒng)的實(shí)施成本上,例如類似谷歌的每秒 10 萬次查詢量。

使用當(dāng)前最先進(jìn)的硬件,我們可以合理地假設(shè),包括購置成本、系統(tǒng)運(yùn)營和維護(hù)在內(nèi)的總擁有成本約為 1 萬億美元。據(jù)統(tǒng)計(jì),這大約相當(dāng)于世界第八大經(jīng)濟(jì)體意大利 2021 年國內(nèi)生產(chǎn)總值(GDP)的一半。

ChatGPT 對每次查詢成本的影響使其具有商業(yè)挑戰(zhàn)性。摩根士丹利估計(jì),2022 年谷歌搜索查詢(3.3 萬億次查詢)的每次查詢成本為 0.2 美分,被視為基準(zhǔn)。同一分析指出,ChatGPT-3 的每次查詢成本在 3 美分到 14 美分之間,是基準(zhǔn)成本的 15-70 倍。

尋找芯片架構(gòu)解決方案

半導(dǎo)體行業(yè)正在狂熱地尋找解決成本/查詢挑戰(zhàn)的方法。雖然所有的嘗試都是受歡迎的,但解決方案必須來自一種新穎的芯片架構(gòu),這種架構(gòu)將打破內(nèi)存墻并大幅降低功耗。

編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評論