的支持。蓬勃發(fā)展的大模型應(yīng)用所帶來的特殊性需求,正推動(dòng)芯片設(shè)計(jì)行業(yè)邁向新紀(jì)元。眾多頂級(jí)的半導(dǎo)體廠商紛紛為大模型應(yīng)用而專門構(gòu)建 AI 芯片,其高算力、高帶寬、動(dòng)輒千億的晶體管數(shù)量成為大芯片的標(biāo)配。 芯片設(shè)計(jì)復(fù)雜度,邁向新高峰 在人工

2023-08-15 11:02:11 836

836

? 流行的GPU/TPU集群網(wǎng)絡(luò)組網(wǎng),包括:NVLink、InfiniBand、ROCE以太網(wǎng)Fabric、DDC網(wǎng)絡(luò)方案等,深入了解它們之間的連接方式以及如何在LLM訓(xùn)練中發(fā)揮作用。為了獲得良好的訓(xùn)練性能,GPU網(wǎng)絡(luò)需要滿足以下條件。

2023-12-25 10:11:43 1377

1377

NVIDIA與Arm、Ampere、Cray、富士通、HPE、Marvell攜手構(gòu)建GPU加速服務(wù)器,以滿足從超大規(guī)模云到邊緣、從模擬到AI、從高性能存儲(chǔ)到百萬兆級(jí)超級(jí)計(jì)算等多樣化需求。

2019-11-20 09:38:42 1384

1384 NVIDIA NeMo Megatron 框架; 可定制的大規(guī)模語言模型 Megatron 530B;多GPU、多節(jié)點(diǎn) Triton推理服務(wù)器助力基于語言的AI開發(fā)和部署,推動(dòng)行業(yè)和科學(xué)發(fā)展。

2021-11-10 14:22:52 752

752 而言,核心三要素是算法、數(shù)據(jù)和算力,其中算力是底座。 ?對(duì)于算力而言,目前行業(yè)基本的共識(shí)是基于通用GPU來構(gòu)建AI大模型的算力集群,上海天數(shù)智芯半導(dǎo)體有限公司(以下簡稱:天數(shù)智芯)是目前國內(nèi)第一家實(shí)現(xiàn)通用GPU量產(chǎn)并落地的公司。在WAIC上,天數(shù)

2023-07-11 01:07:00 2462

2462

1 個(gè) AI 模型 = 5 輛汽車終身碳排量,AI 為何如此耗能?

2021-01-22 06:35:03

摘要: 3月28日,在2018云棲大會(huì)·深圳峰會(huì)上,阿里云宣布與英偉達(dá)GPU 云 合作 (NGC),開發(fā)者可以在云市場下載NVIDIA GPU 云鏡像和運(yùn)行NGC 容器,來使用阿里云上的NVIDIA

2018-04-04 14:39:24

AI算法中比較常用的模型都有什么

2022-08-27 09:19:06

雖然GPU解決方案對(duì)訓(xùn)練,AI部署需要更多。

預(yù)計(jì)到2020年代中期,人工智能行業(yè)將增長到200億美元,其中大部分增長是人工智能推理。英特爾Xeon可擴(kuò)展處理器約占運(yùn)行AI推理的處理器單元的70

2023-08-04 07:25:00

在 CPU 和 GPU 上推斷出具有 OpenVINO? 基準(zhǔn)的相同模型:

benchmark_app.exe -m model.xml -d CPU

benchmark_app.exe -m

2023-08-15 06:43:46

GPU來完成。但GPU于手機(jī)及PC端滲透率基本見頂,根據(jù)中國社科院數(shù)據(jù),2011-2018年全球主要國家PC每百人滲透率呈下降趨勢,智能手機(jī)對(duì)PC具有一定替代性。而云計(jì)算與智能駕駛及AI的興起對(duì)高算力

2021-12-07 10:04:11

GPU編程--OpenCL四大模型

2019-04-29 07:40:44

ai芯片和gpu的區(qū)別▌車載芯片的發(fā)展趨勢(CPU-GPU-FPGA-ASIC)過去汽車電子芯片以與傳感器一一對(duì)應(yīng)的電子控制單元(ECU)為主,主要分布與發(fā)動(dòng)機(jī)等核心部件上。...

2021-07-27 07:29:46

集群通信網(wǎng)絡(luò)是什么?數(shù)字集群移動(dòng)通信網(wǎng)絡(luò)是如何運(yùn)行的?

2021-05-26 06:27:08

上漲,因?yàn)槭聦?shí)表明,它們的 GPU 在訓(xùn)練和運(yùn)行 深度學(xué)習(xí)模型 方面效果明顯。實(shí)際上,英偉達(dá)也已經(jīng)對(duì)自己的業(yè)務(wù)進(jìn)行了轉(zhuǎn)型,之前它是一家純粹做 GPU 和游戲的公司,現(xiàn)在除了作為一家云 GPU 服務(wù)

2024-03-21 15:19:45

服務(wù)器,而隨著人們對(duì)服務(wù)器工作負(fù)載模式的新需求,越來越多的智能場景需要小型服務(wù)器來部署。方案簡介集群服務(wù)器解決方案,以多塊核心板的組合方式,提供標(biāo)準(zhǔn)的軟硬件接口,支持分布式AI運(yùn)算,可用于機(jī)器學(xué)習(xí)

2019-08-16 15:09:56

Imagination全新BXS GPU助力德州儀器汽車處理器系列產(chǎn)品實(shí)現(xiàn)先進(jìn)圖形處理功能

2020-12-16 07:04:43

Mali GPU 支持tensorflow或者caffe等深度學(xué)習(xí)模型嗎? 好像caffe2go和tensorflow lit可以部署到ARM,但不知道是否支持在GPU運(yùn)行?我希望把訓(xùn)練

2022-09-16 14:13:01

的任務(wù)中,比如運(yùn)行用于語言翻譯的GNMT模型等。功能豐富、應(yīng)用廣泛的NVIDIA T4Tensor Core GPU 在多個(gè)場景取得了優(yōu)秀的成績。這個(gè)功耗僅為70瓦的GPU能夠輕松安裝到任何帶有PCIe槽

2019-11-08 19:44:51

的模型在微控制器上平穩(wěn)運(yùn)行。這使我們能夠保持競爭力,并為客戶提供最佳解決方案。“多虧了 STM32Cube.AI 開發(fā)人員云,我們可以在很短的時(shí)間內(nèi)確認(rèn)我們創(chuàng)建具有嵌入式AI的產(chǎn)品的方法的有效性。通過

2023-02-02 09:52:43

層多活解決方案。DRDS按照之前說的業(yè)務(wù)數(shù)據(jù)拆分的維度,阿里云DRDS有兩種集群分別支持買家維度與賣家維度:unit 模式的DRDS集群:多地用戶分別在本地域讀寫本地域的數(shù)據(jù),且本地域的數(shù)據(jù)會(huì)和中心數(shù)據(jù)做雙向同步。copy 模式的DRDS集群:此集群數(shù)據(jù)在中心數(shù)據(jù)庫寫,完成后全.

2021-11-16 09:23:44

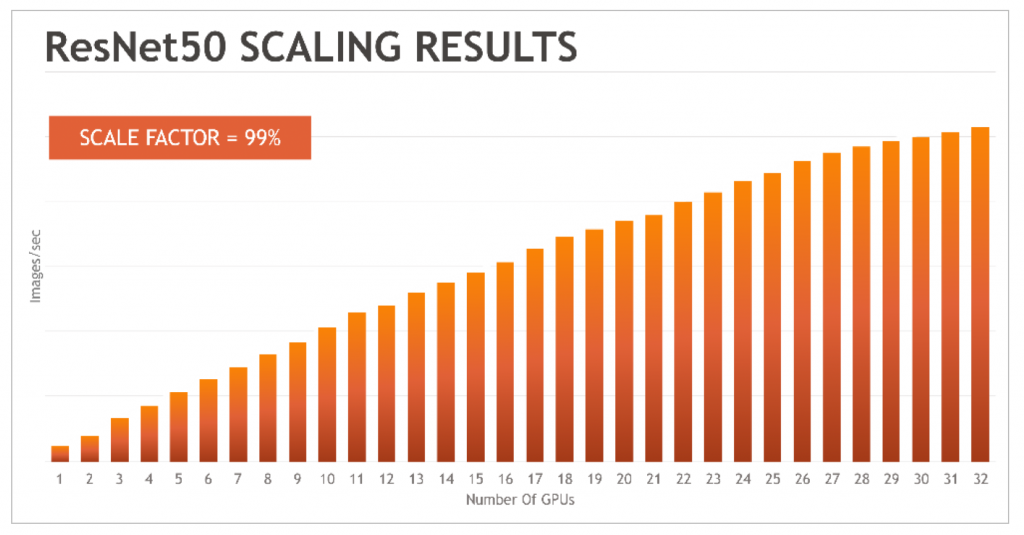

模型收斂的情況下,最大集群規(guī)模只支持10塊GPU。這意味著在進(jìn)行數(shù)據(jù)運(yùn)算時(shí),即時(shí)使用更多的GPU,計(jì)算效果也只相當(dāng)于10塊GPU的能力,這樣訓(xùn)練的時(shí)間將更加的漫長。 而華為云的深度學(xué)習(xí)

2018-08-02 20:44:09

Vitis AI 的所有工具和庫,而不需要在本地安裝任何依賴。CPU版本的Vitis AI docker 可以在沒有 GPU 的機(jī)器上運(yùn)行,但是模型優(yōu)化的速度會(huì)比 GPU 版本慢一些。

實(shí)際上,我會(huì)選擇通過

2023-10-14 15:34:26

,本周將會(huì)推出針對(duì)異構(gòu)計(jì)算GPU實(shí)例GN5年付5折的優(yōu)惠活動(dòng),希望能夠打造良好的AI生態(tài)環(huán)境,幫助更多的人工智能企業(yè)以及項(xiàng)目順利上云。隨著深度學(xué)習(xí)對(duì)人工智能的巨大推動(dòng),深度學(xué)習(xí)所構(gòu)建的多層神經(jīng)網(wǎng)絡(luò)模型

2017-12-26 11:22:09

華為云華為云IoT,致力于提供極簡接入、智能化、安全可信等全棧全場景服務(wù)和開發(fā)、集成、托管、運(yùn)營等一站式工具服務(wù),助力合作伙伴/客戶輕松、快速地構(gòu)建5G、AI萬物互聯(lián)的場景化物聯(lián)網(wǎng)解決方案,包括實(shí)現(xiàn)設(shè)備的統(tǒng)一接入和管理;處理和分析物聯(lián)網(wǎng)數(shù)據(jù),實(shí)現(xiàn)數(shù)據(jù)快速變現(xiàn)等

2022-12-12 10:35:23

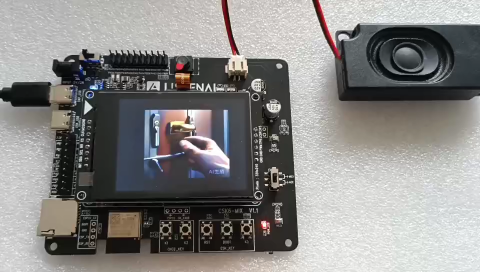

介紹在STM32cubeIDE上部署AI模型的系列教程,開發(fā)板型號(hào)STM32H747I-disco,值得一看。MCUAI原文鏈接:【嵌入式AI開發(fā)】篇四|部署篇:STM32cubeIDE上部署神經(jīng)網(wǎng)絡(luò)之模型部署

2021-12-14 09:05:03

使用cube-AI分析模型時(shí)報(bào)錯(cuò),該模型是pytorch的cnn轉(zhuǎn)化成onnx

```

Neural Network Tools for STM32AI v1.7.0 (STM.ai v8.0.0-19389)

INTERNAL ERROR: list index out of range

```

2024-03-14 07:09:26

是否可以使用NVidia虛擬化在云計(jì)算中使用GPU虛擬化創(chuàng)建VM群集?怎么能實(shí)現(xiàn)呢?以上來自于谷歌翻譯以下為原文Is it possible to use NVidia virtualization

2018-09-30 10:47:56

問題最近在Ubuntu上使用Nvidia GPU訓(xùn)練模型的時(shí)候,沒有問題,過一會(huì)再訓(xùn)練出現(xiàn)非常卡頓,使用nvidia-smi查看發(fā)現(xiàn),顯示GPU的風(fēng)扇和電源報(bào)錯(cuò):解決方案自動(dòng)風(fēng)扇控制在nvidia

2022-01-03 08:24:09

你好, 我試圖在 X-CUBE-AI.7.1.0 中導(dǎo)入由在線 AI 平臺(tái)生成的 .h5 模型,收到錯(cuò)誤:E010(InvalidModelError): Model saved with Keras 2.7.0 but

2022-12-27 06:10:35

的定義和訓(xùn)練的收斂趨勢。總結(jié)我們可以利用阿里云Kubernetes容器服務(wù),輕松的搭建在云端搭建TensorFlow的環(huán)境,運(yùn)行深度學(xué)習(xí)的實(shí)驗(yàn)室,并且利用TensorBoard追蹤訓(xùn)練效果。歡迎大家使用阿里云上的GPU容器服務(wù),在使用GPU高效計(jì)算的能力同時(shí),比較簡單和快速的開始模型開發(fā)工作。原文鏈接

2018-05-10 10:24:11

當(dāng)我為 TFLite 模型運(yùn)行基準(zhǔn)測試時(shí),有一個(gè)選項(xiàng) --nnapi=true我如何知道 GPU 和 NPU 何時(shí)進(jìn)行推理?謝謝

2023-03-20 06:10:30

在即將開展的“中國移動(dòng)全球合作伙伴大會(huì)”上,華為將發(fā)布一款面向運(yùn)營商電信領(lǐng)域的一站式AI開發(fā)平臺(tái)——SoftCOM AI平臺(tái),幫助電信領(lǐng)域開發(fā)者解決AI開發(fā)在數(shù)據(jù)準(zhǔn)備、模型訓(xùn)練、模型發(fā)布以及部署驗(yàn)證

2021-02-25 06:53:41

的時(shí)間線(右)默認(rèn)情況下,所有 ML-Agents 模型都使用 Barracuda 執(zhí)行。Barracuda包是 Unity的跨平臺(tái) NN 推理庫。它可以在 GPU 和 CPU 上運(yùn)行 NN 模型。但

2022-08-15 15:43:38

+ OSS on ACK,允許Spark分布式計(jì)算節(jié)點(diǎn)對(duì)阿里云OSS對(duì)象存儲(chǔ)的直接訪問。容器開啟數(shù)據(jù)服務(wù)之旅系列(二):Kubernetes如何助力Spark大數(shù)據(jù)分析(二):Kubernetes

2018-04-17 15:10:33

和模型編譯成與浪潮深度學(xué)習(xí)加速解決方案的配置腳本,即可進(jìn)行線上應(yīng)用,省去至少3個(gè)月到半年的開發(fā)周期和相關(guān)成本。并且在算法運(yùn)行效率上,浪潮FPGA加速方案相比CPU、GPU都有著很大優(yōu)勢。 目前,浪潮

2021-09-17 17:08:32

AI設(shè)計(jì)主要參與方都是功能強(qiáng)大的CPU,GPU和FPGA等。微型微控制器與強(qiáng)大的人工智能(AI)世界有什么關(guān)系?但隨著AI從云到邊緣的發(fā)展,使得這一觀點(diǎn)正在迅速改變,AI計(jì)算引擎使MCU能夠突破

2021-11-01 08:55:02

躺在實(shí)驗(yàn)機(jī)器上在現(xiàn)有條件下,一般涉及到模型的部署就要涉及到模型的轉(zhuǎn)換,而轉(zhuǎn)換的過程也是隨著對(duì)應(yīng)平臺(tái)的不同而不同,一般工程師接觸到的平臺(tái)分為GPU云平臺(tái)、手機(jī)和其

2021-07-16 06:08:20

在計(jì)算棒上,計(jì)算棒是一個(gè)專用AI應(yīng)用模塊;Toybrick 1808計(jì)算棒提供全套模型保護(hù)方案加解密過程均運(yùn)行中TrustZone安全環(huán)境中,無法跟蹤讓您的模型在計(jì)算棒上不用擔(dān)心被盜走,每顆計(jì)算棒上

2020-07-24 10:58:40

用于快速模型的模型調(diào)試器是用于可擴(kuò)展集群軟件開發(fā)的完全可重定目標(biāo)的調(diào)試器。它旨在滿足SoC軟件開發(fā)人員的需求。

Model Debugger具有易于使用的GUI前端,并支持:

?源代碼級(jí)調(diào)試

2023-08-10 06:33:37

用于快速模型的模型調(diào)試器是用于可擴(kuò)展集群軟件開發(fā)的完全可重定目標(biāo)的調(diào)試器。它旨在滿足SoC軟件開發(fā)人員的需求。

Model Debugger具有易于使用的GUI前端,并支持:

?源代碼級(jí)調(diào)試

2023-08-09 07:57:45

雖然人工智能和機(jī)器學(xué)習(xí)計(jì)算通常在數(shù)據(jù)中心中大規(guī)模地執(zhí)行,但是最新的處理設(shè)備使得能夠?qū)?b class="flag-6" style="color: red">AI / ML能力嵌入到網(wǎng)絡(luò)邊緣的IoT設(shè)備中。邊緣的AI可以快速響應(yīng),無需等待云的響應(yīng)。如果可以在本地完成推理

2019-05-29 10:38:09

將AI推向邊緣的影響通過在邊緣運(yùn)行ML模型可以使哪些具體的AI項(xiàng)目更容易運(yùn)行?

2021-02-23 06:21:10

萌新求助,求云模型及發(fā)生器matlab代碼

2021-11-19 07:11:38

摘要: 阿里云ECS彈性裸金屬服務(wù)器(神龍)已經(jīng)與其容器服務(wù)全面兼容,用戶可以選擇在彈性裸金屬服務(wù)器上直接運(yùn)行容器、管控Kubernetes/Docker容器集群,如此將會(huì)獲得非常出色的性能、數(shù)倍

2018-06-13 15:52:15

訓(xùn)練好的ai模型導(dǎo)入cubemx不成功咋辦,試了好幾個(gè)模型壓縮了也不行,ram占用過大,有無解決方案?

2023-08-04 09:16:28

Mali T604 GPU的結(jié)構(gòu)是由哪些部分組成的?Mali T604 GPU的編程特性有哪些?Mali GPU的并行化計(jì)算模型是怎樣構(gòu)建的?基于Mali-T604 GPU的快速浮點(diǎn)矩陣乘法并行化該如何去實(shí)現(xiàn)?

2021-04-19 08:06:26

使用 STM32Cube.AI 的模型轉(zhuǎn)換工具,獲得一個(gè)集成了 AI 的 BSP對(duì),就是這么硬核,一步肝到位!內(nèi)部的流程請(qǐng)看源碼或者 plugin_stm32 倉庫下的 readme 文檔運(yùn)行命令進(jìn)入

2022-09-02 15:06:14

用于快速模型的模型調(diào)試器是用于可擴(kuò)展集群軟件開發(fā)的完全可重定目標(biāo)的調(diào)試器。它旨在滿足SoC軟件開發(fā)人員的需求。

Model Debugger具有易于使用的GUI前端,并支持:

?源代碼級(jí)調(diào)試

2023-08-08 06:28:56

模型并為其提供了輸入數(shù)據(jù)。最后,我運(yùn)行了模型的推理,并輸出了預(yù)測結(jié)果。此外,還需要考慮其他因素,如模型的優(yōu)化器、損失函數(shù)和評(píng)估指標(biāo)等。

為了防止AI大模型被黑客病毒入侵控制,通常可以采取以下措施

2024-03-19 11:18:16

。 對(duì)于世界杯這種超大觀看量級(jí)、超強(qiáng)影響力的重要體育賽事,阿里云一直致力研究的AI技術(shù)一定不會(huì)缺席。本屆世界杯互聯(lián)網(wǎng)直播的順利進(jìn)行,離不開各大云計(jì)算廠商的支持。在這其中,阿里云是當(dāng)之無愧的“C位“,除了

2018-07-12 15:12:13

拷貝多份占用存儲(chǔ)空間,也給網(wǎng)絡(luò)管理和數(shù)據(jù)管理帶來了復(fù)雜性;并且由于數(shù)據(jù)無法共享,無法支持整個(gè)GPU集群同時(shí)運(yùn)行任務(wù),降低了整個(gè)IT系統(tǒng)的使用效率。為了便于數(shù)據(jù)管理和共享,傳統(tǒng)文件存儲(chǔ)在AI系統(tǒng)中得到一定

2018-08-23 17:39:35

群擴(kuò)容和縮容。同云桌面/GPU服務(wù)器的結(jié)合 一般在仿真工作流里面,完成大量的仿真計(jì)算后會(huì)進(jìn)入到渲染階段,所以一般會(huì)經(jīng)過GPU服務(wù)器集群的Pipeline,最后通過云桌面展示給客戶的客戶。于是E-HPC

2018-05-18 22:19:53

作業(yè)在上汽仿真計(jì)算云平臺(tái)上完成,模擬了整車、發(fā)動(dòng)機(jī)數(shù)百種工況。由于阿里云超級(jí)計(jì)算集群帶來的性能提升,相對(duì)本地集群節(jié)約了計(jì)算求解時(shí)間,用戶作業(yè)排隊(duì)時(shí)間也明顯縮短,工程師可以在工作時(shí)間段做更多的模型調(diào)整

2018-05-31 15:30:30

摘要: kubernetes集群讓您能夠方便的部署管理運(yùn)維容器化的應(yīng)用。但是實(shí)際情況中經(jīng)常遇到的一些問題,就是單個(gè)集群通常無法跨單個(gè)云廠商的多個(gè)Region,更不用說支持跨跨域不同的云廠商。這樣會(huì)給

2018-03-12 17:10:52

,Hovorod等多種深度學(xué)習(xí)框架,CPU、GPU、FPGA等異構(gòu)計(jì)算集群可以統(tǒng)一管理調(diào)度和高效運(yùn)行,如此實(shí)現(xiàn)模型持續(xù)訓(xùn)練和迭代上線,從而降低開發(fā)AI應(yīng)用服務(wù)的門檻,大大提升AI落地的效率。未來阿里云將在

2018-07-02 15:27:20

智行,裝車量已突破60萬輛。未來雙方也將繼續(xù)深入合作,從端到云全面拓展合作。上汽仿真計(jì)算云 基于ECS神龍SCC超級(jí)計(jì)算集群+E-HPC彈性高性能計(jì)算產(chǎn)品,讓客戶在阿里云端打造了一個(gè)媲美物理機(jī)集群性能,同時(shí)兼具與HPC業(yè)務(wù)部署靈活性和彈性的高性能云端計(jì)算服務(wù)平臺(tái),助力智能制造行業(yè)客戶上云。原文鏈接

2018-06-19 16:04:24

摘要: 近日,阿里云重磅推出視頻點(diǎn)播新功能——視頻AI ,基于深度學(xué)習(xí)、計(jì)算機(jī)視覺技術(shù)和海量數(shù)據(jù),為廣大用戶提供多場景的視頻AI服務(wù)。近日,阿里云重磅推出視頻點(diǎn)播新功能——視頻AI,基于深度學(xué)習(xí)

2018-01-23 15:19:23

提出一種適用于SMP 集群的混合MPI+OpenMP 并行編程模型。該模型貼近于SMP 集群的體系結(jié)構(gòu)且綜合了消息傳遞和共享內(nèi)存2 種編程模型的優(yōu)勢,能獲得較好的性能。討論該混合模型的實(shí)

2009-03-30 09:28:40 32

32 GPU將開創(chuàng)計(jì)算新紀(jì)元

魏鳴,是NVIDIA公司中國區(qū)市場總監(jiān)。

美國著名計(jì)算機(jī)科學(xué)家、田納西州大學(xué)計(jì)算機(jī)創(chuàng)新實(shí)驗(yàn)室主任Jack Dongarra博士曾經(jīng)說過,將來的計(jì)算

2009-12-30 10:17:39 1221

1221 研究如何使用Jini 來實(shí)現(xiàn)集群網(wǎng)格計(jì)算環(huán)境,給出系統(tǒng)模型JCGE(a Jini-based cluster grid environment),設(shè)計(jì)一個(gè)在此模型上進(jìn)行并行計(jì)算的通用算法,并在集群主機(jī)上對(duì)此模型及算法進(jìn)行測試,

2011-05-14 11:05:45 17

17 作為NVIDIA在中國重要的合作伙伴,阿里巴巴正在將GPU大規(guī)模的應(yīng)用于諸多業(yè)務(wù)的AI推理應(yīng)用中,借助GPU帶來的強(qiáng)大算力為AI應(yīng)用賦能,助力多個(gè)業(yè)務(wù)實(shí)現(xiàn)突破。

2018-10-04 08:41:00 3066

3066 亞馬遜宣布推出Inferentia,這是由AWS設(shè)計(jì)的芯片,專門用于部署帶有GPU的大型AI模型,該芯片將于明年推出。

2018-12-03 09:46:08 1753

1753 然而,如果攻擊者在使用AI模型時(shí)也“以管理員身份運(yùn)行”,給AI模型埋藏一個(gè)“后門”,平時(shí)程序運(yùn)行正常,然而一旦被激活,模型輸出就會(huì)變成攻擊者預(yù)先設(shè)置的目標(biāo)。

2020-08-23 09:47:39 1412

1412 研究的熱點(diǎn)之一。 本篇文章希望能提供一個(gè)對(duì)GPU共享工作的分享,希望能和相關(guān)領(lǐng)域的研究者們共同討論。 GPU共享,是指在同一張GPU卡上同時(shí)運(yùn)行多個(gè)任務(wù)。優(yōu)勢在于: (1)集群中可以運(yùn)行更多任務(wù),減少搶占。 (2)資源利用率(GPU/顯存/e.t.c.)提高;GPU共享后,總利用率接近運(yùn)行任務(wù)利

2020-11-27 10:06:21 3271

3271 NVIDIA Megatron 是一個(gè)基于 PyTorch 的框架,用于訓(xùn)練基于 Transformer 架構(gòu)的巨型語言模型。本系列文章將詳細(xì)介紹Megatron的設(shè)計(jì)和實(shí)踐,探索這一框架如何助力

2021-10-20 09:25:43 2078

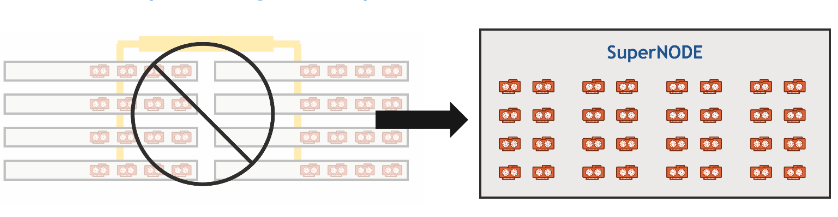

2078 基于京東部署的DGX SuperPOD集群 “天琴α”,京東探索研究院聯(lián)合悉尼大學(xué)共同研發(fā)了織女模型,一并攻克了 GLUE 兩項(xiàng)挑戰(zhàn)性任務(wù)。

2022-01-04 14:22:55 3380

3380 Meta的AI超級(jí)計(jì)算機(jī)是迄今為止最大的NVIDIA DGX A100客戶系統(tǒng)。該系統(tǒng)將為Meta的AI研究人員提供5百億億次級(jí)AI計(jì)算性能,采用了最先進(jìn)的NVIDIA系統(tǒng)、InfiniBand網(wǎng)絡(luò)和軟件,實(shí)現(xiàn)了數(shù)千個(gè)GPU集群的系統(tǒng)優(yōu)化。

2022-02-07 10:40:56 1621

1621 Microsoft 的目標(biāo)是,通過結(jié)合使用 Azure 與 NVIDIA GPU 和 Triton 推理軟件,率先將一系列強(qiáng)大的 AI Transformer 模型投入生產(chǎn)用途。

2022-03-28 09:43:38 1029

1029 近期,該團(tuán)隊(duì)在 GPU 助力的服務(wù)器上測試了適用于 Apache Spark 的 NVIDIA RAPIDS 加速器,該軟件可將工作分配到集群中的各節(jié)點(diǎn)。

2022-04-01 14:15:03 890

890 “強(qiáng)悍的織女模型在京東探索研究院建設(shè)的全國首個(gè)基于 DGX SuperPOD 架構(gòu)的超大規(guī)模計(jì)算集群 “天琴α” 上完成訓(xùn)練,該集群具有全球領(lǐng)先的大規(guī)模分布式并行訓(xùn)練技術(shù),其近似線性加速比的數(shù)據(jù)、模型、流水線并行技術(shù)持續(xù)助力織女模型的高效訓(xùn)練。”

2022-04-13 15:13:11 783

783 經(jīng)過百度內(nèi)部 NLP 研究團(tuán)隊(duì)的驗(yàn)證,在這個(gè)網(wǎng)絡(luò)環(huán)境下的超大規(guī)模集群上提交千億模型訓(xùn)練作業(yè)時(shí),同等機(jī)器規(guī)模下整體訓(xùn)練效率是普通 GPU 集群的 3.87 倍。

2022-05-20 15:00:27 953

953 通過 NVIDIA GPU 加速平臺(tái),Colossal-AI 實(shí)現(xiàn)了通過高效多維并行、異構(gòu)內(nèi)存管理、大規(guī)模優(yōu)化庫、自適應(yīng)任務(wù)調(diào)度等方式,更高效快速部署 AI 大模型訓(xùn)練與推理。

2022-10-19 09:39:39 1149

1149 近日,天數(shù)智芯通用GPU產(chǎn)品“天垓100”與計(jì)圖即時(shí)編譯深度學(xué)習(xí)框架完成兼容性適配認(rèn)證,同時(shí)支持加速深度學(xué)習(xí)模型的訓(xùn)練和推理,支持運(yùn)行多種前沿AI應(yīng)用,進(jìn)一步助力國產(chǎn)AI生態(tài)發(fā)展。

2022-12-23 09:35:33 684

684 第七屆集微半導(dǎo)體峰會(huì)于6月初在廈門成功舉辦,上海天數(shù)智芯半導(dǎo)體有限公司(以下簡稱“天數(shù)智芯”)產(chǎn)品線總裁鄒翾受邀參加“集微通用芯片行業(yè)應(yīng)用峰會(huì)”,發(fā)表了題為“國產(chǎn)GPU助力大模型的實(shí)踐”的主題演講

2023-06-08 22:55:02 952

952

專為生成式AI設(shè)計(jì)的GPU:HBM密度是英偉達(dá)H100的2.4倍,帶寬是英偉達(dá)H100的1.6倍。

2023-06-20 10:47:47 605

605 據(jù)悉,SDXL 0.9是在所有開源圖像模型中參數(shù)數(shù)量位居前茅,并且可以在消費(fèi)級(jí)GPU上運(yùn)行,還具備一個(gè)35億參數(shù)的基礎(chǔ)模型和一個(gè)66億參數(shù)的附加模型。

2023-06-26 09:41:49 720

720 6 月 27 日上午1000,電子工程專輯【EE直播間】最新一期即將開播! 本期直播將圍繞“GPU助力數(shù)據(jù)中心高性能計(jì)算和AI大模型的開發(fā)”為主題,由 AspenCore 產(chǎn)業(yè)分析師為大家介紹

2023-06-26 11:20:02 337

337

據(jù)了解,星脈網(wǎng)絡(luò)具備業(yè)界最高的 3.2T 通信帶寬,可提升 40% 的 GPU 利用率、節(jié)省 30%~60% 的模型訓(xùn)練成本,進(jìn)而能為 AI 大模型帶來 10 倍通信性能提升。基于騰訊云新一代算力集群,可支持 10 萬卡的超大計(jì)算規(guī)模。

2023-07-14 14:46:33 1215

1215

適配。測試結(jié)果顯示,曦云C500在智譜AI的升級(jí)版大模型上充分兼容、高效穩(wěn)定運(yùn)行。 沐曦旗艦產(chǎn)品曦云C500基于自主研發(fā)的高性能GPU IP,特別適合千億參數(shù)AI大模型的訓(xùn)練和推理;基于全自研 GPU 指令集打造的MXMACA軟件棧,全面兼容主流GPU生態(tài),實(shí)現(xiàn)用戶零成本遷移;

2023-08-23 10:38:47 3030

3030 ,具有自學(xué)能力,能夠自動(dòng)從大量數(shù)據(jù)中提取并學(xué)習(xí)規(guī)律,從而實(shí)現(xiàn)人工智能的基礎(chǔ)。 盤古AI大模型采用了GPU(圖形處理器)加速技術(shù),GPU優(yōu)化的算法使其在短時(shí)間內(nèi)能夠完成非常龐大的數(shù)據(jù)集的學(xué)習(xí)和處理。GPU的基本原理是通過并行處理來加

2023-08-31 09:01:40 2008

2008 目前,GPT-4、PaLM-2的算力當(dāng)量,已經(jīng)達(dá)到了GPT-3的數(shù)十倍,相當(dāng)于上萬顆業(yè)界性能領(lǐng)先的NVIDIA Hopper架構(gòu)的GPU芯片組成的AI集群,訓(xùn)練超過1個(gè)月的時(shí)間。

2023-09-01 15:54:24 568

568

盤古ai大模型怎么使用 盤古AI大模型是一個(gè)基于自然語言處理的人工智能模型,是華為公司發(fā)布的 超大規(guī)模預(yù)訓(xùn)練模型, 可以進(jìn)行文本分析、問題回答、智能客服、智能寫作等多種應(yīng)用。盤古ai大模型

2023-09-04 10:42:44 9386

9386 在大模型趨勢下,墨芯通過領(lǐng)先的稀疏計(jì)算優(yōu)勢,助力企業(yè)加速AI應(yīng)用,商業(yè)化進(jìn)程接連取得重要突破。

2023-09-07 11:37:15 620

620

聯(lián)發(fā)科天璣9300最高可運(yùn)行330億參數(shù)AI大模型 聯(lián)發(fā)科這個(gè)是要把AI大模型帶到手機(jī)端的節(jié)奏嗎?聯(lián)發(fā)科正式發(fā)布了天璣9300旗艦5G生成式AI移動(dòng)芯片,天璣9300號(hào)稱最高可運(yùn)行330億參數(shù)AI

2023-11-07 19:00:06 912

912 AI大模型逐步走入冷靜期,思考大模型如何助力解決實(shí)際問題、實(shí)現(xiàn)商業(yè)化落地成為新趨勢。

2024-01-12 09:18:04 207

207

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論