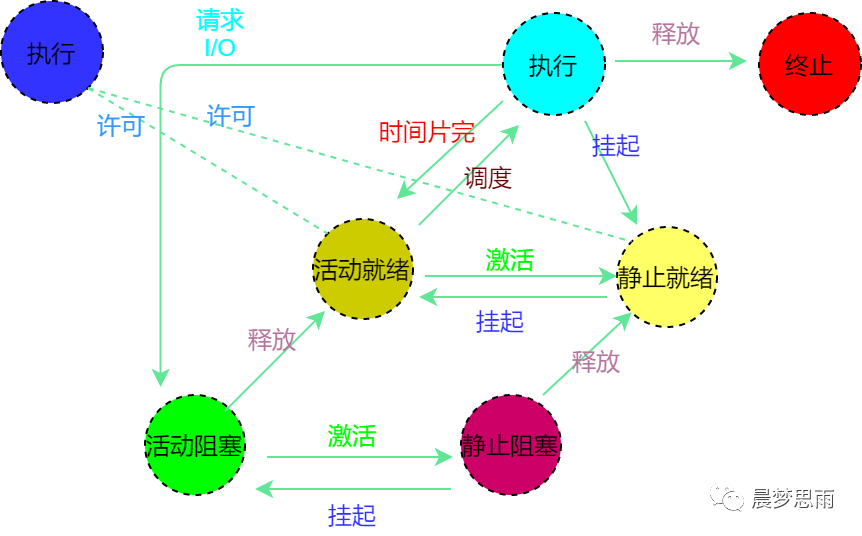

進(jìn)程是什么?進(jìn)程與程序的區(qū)別在哪?進(jìn)程的狀態(tài)有哪幾種?

2021-12-23 06:27:17

進(jìn)程間通信就是在不同進(jìn)程之間傳播或交換信息,進(jìn)程間控制信息的交換稱為低級通信,進(jìn)程間大批量數(shù)據(jù)的交換稱為高級通信。

2019-08-05 08:09:12

GMR7580-15P2CNN - Vertical Mount Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7580-15S2CNN - Vertical Mount Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7580-15S3CNN - Vertical Mount Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7580-21P1CNN - Vertical Mount Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7590-15S1CNN - Right Angle Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7590-9P2CNN - Right Angle Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7590-9P3CNN - Right Angle Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7590-9S1CNN - Right Angle Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

GMR7590-9S2CNN - Right Angle Micro-D Connectors - Glenair, Inc.

2022-11-04 17:22:44

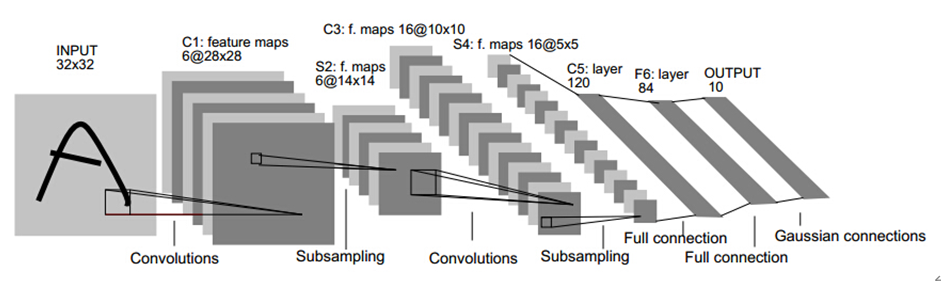

2.概述一個(gè)簡單的AI開發(fā)sampleGithub開源的數(shù)字手勢識別CNN模型,識別數(shù)字0-10十一種手勢類LeNet-5,兩個(gè)卷積層,兩個(gè)池化層,一個(gè)全連接層,一個(gè)Softmax輸出層3.RKNN

2022-04-02 15:22:11

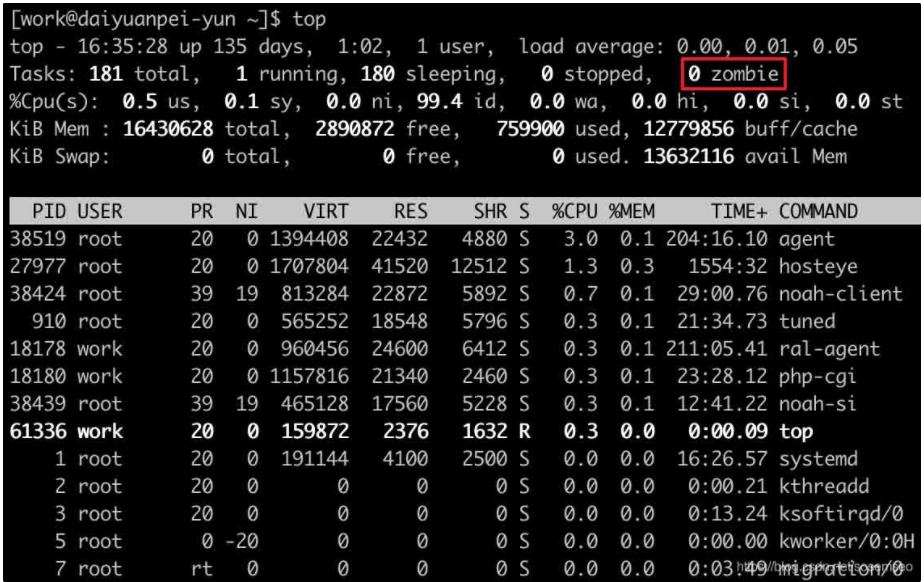

ps 命令用于查看當(dāng)前正在運(yùn)行的進(jìn)程。grep 是搜索例如: ps -ef | grep java表示查看所有進(jìn)程里 CMD 是 java 的進(jìn)程信息ps -aux | grep java-aux 顯示

2016-04-24 00:04:10

進(jìn)程。 內(nèi)核將所有進(jìn)程存放在雙向循環(huán)鏈表(進(jìn)程鏈表)中,其中鏈表的頭是init_task描述符。鏈表的每一項(xiàng)都是類型為task_struct,稱為進(jìn)程描述符的結(jié)構(gòu),該結(jié)構(gòu)包含了與一個(gè)進(jìn)程相關(guān)的所有信息

2017-05-27 09:24:11

`#嵌入式培訓(xùn)#華清遠(yuǎn)見嵌入式linux學(xué)習(xí)資料《Linux下的進(jìn)程結(jié)構(gòu)》,進(jìn)程不但包括程序的指令和數(shù)據(jù),而且包括程序計(jì)數(shù)器和處理器的所有寄存器及存儲臨時(shí)數(shù)據(jù)的進(jìn)程堆棧,因此正在執(zhí)行的進(jìn)程包括處理器當(dāng)前的一切活動(dòng)。詳情:http://t.cn/zQacK50`

2013-08-05 11:05:59

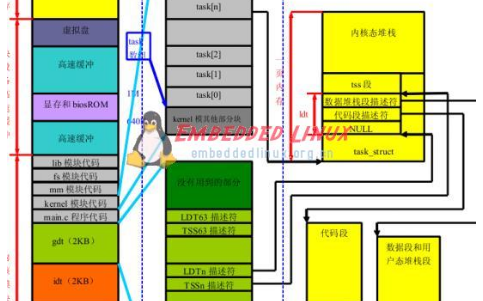

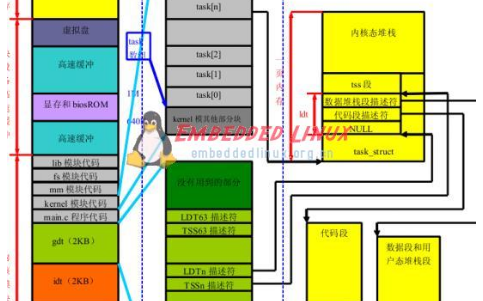

(task_struct)代表一個(gè)進(jìn)程,代表進(jìn)程的數(shù)據(jù)結(jié)構(gòu)指針形成了一個(gè)task數(shù)組(Linux中,任務(wù)和進(jìn)程是相同的術(shù)語),這種指針數(shù)組有時(shí)也稱為指針向量。這個(gè)數(shù)組的大小由NR_TASKS(默認(rèn)為512),表明

2019-07-11 16:59:35

PCB包含了一個(gè)進(jìn)程的重要運(yùn)行信息,所以我們將圍繞在創(chuàng)建一個(gè)新進(jìn)程時(shí),如何來建立一個(gè)新的PCB的這一個(gè)過程來進(jìn)行分析,在Linux系統(tǒng)中,PCB主要是存儲在一個(gè)叫做task_struct這一個(gè)結(jié)構(gòu)體中,創(chuàng)建新進(jìn)程僅能通過

2019-08-08 08:42:58

TF之CNN:CNN實(shí)現(xiàn)mnist數(shù)據(jù)集預(yù)測 96%采用placeholder用法+2層C及其max_pool法+隱藏層dropout法+輸出層softmax法+目標(biāo)函數(shù)cross_entropy法+

2018-12-19 17:02:40

TF之CNN:Tensorflow構(gòu)建卷積神經(jīng)網(wǎng)絡(luò)CNN的嘻嘻哈哈事之詳細(xì)攻略

2018-12-19 17:03:10

在TensorFlow中實(shí)現(xiàn)CNN進(jìn)行文本分類(譯)

2019-10-31 09:27:55

1 CNN簡介

CNN即卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks),是一類包含卷積計(jì)算的神經(jīng)網(wǎng)絡(luò),是深度學(xué)習(xí)(deep learning)的代表算法之一,在圖像識別

2023-08-18 06:56:34

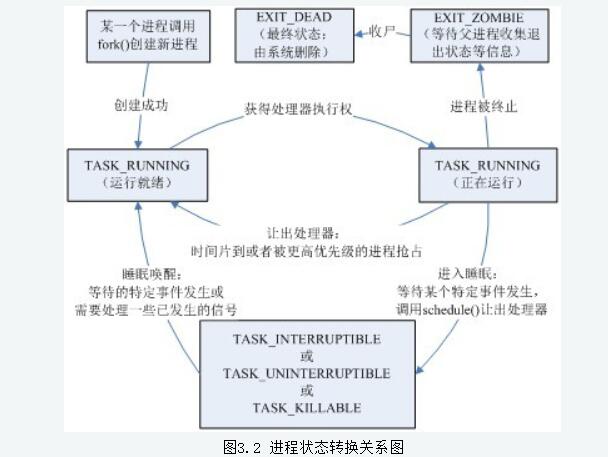

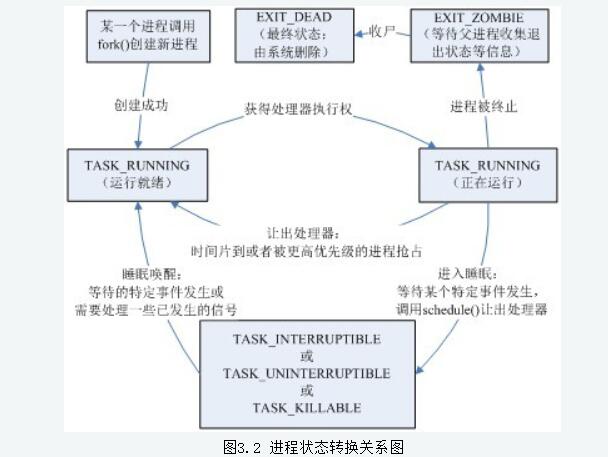

什么是進(jìn)程?進(jìn)程可以理解為正在運(yùn)行的程序。我們編寫好的代碼,經(jīng)過編譯后生成一個(gè)可執(zhí)行的文件,我們稱作一個(gè)程序。當(dāng)運(yùn)行可執(zhí)行文件后,操作系統(tǒng)會執(zhí)行可執(zhí)行文件中的代碼,在CPU上運(yùn)行的這組代碼被稱做進(jìn)程

2021-12-14 08:26:41

在UNIX里,除了進(jìn)程0(即PID=0的交換進(jìn)程,Swapper Process)以外的所有進(jìn)程都是由其他進(jìn)程使用系統(tǒng)調(diào)用fork創(chuàng)建的,這里調(diào)用fork創(chuàng)建新進(jìn)程的進(jìn)程即為父進(jìn)程,而相對應(yīng)的為其創(chuàng)建出的進(jìn)程則為子進(jìn)程,因而除了進(jìn)程0以外的進(jìn)程都只有一個(gè)父進(jìn)程,但一個(gè)進(jìn)程可以有多個(gè)子進(jìn)程。

2019-08-02 08:36:06

硬件加速,最典型的架構(gòu)就是將需要加速的大運(yùn)算量邏輯部署到FPGA上,而將流程控制的邏輯部署到arm上。典型的ZYNQ SoC結(jié)構(gòu)如圖1。 CNN簡介 CNN全稱卷積神經(jīng)網(wǎng)絡(luò),包括卷積層

2021-01-15 17:09:15

【深度學(xué)習(xí)】卷積神經(jīng)網(wǎng)絡(luò)CNN

2020-06-14 18:55:37

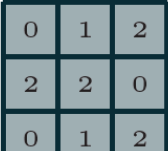

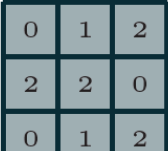

CNN的基本原理。 圖2為一個(gè)簡單的二維m×n的CNN結(jié)構(gòu)圖。C(i,j)表示第i行、第j列的神經(jīng)元,它只同周圍r范圍內(nèi)的神經(jīng)元相連,而同其他的神經(jīng)元不連接。細(xì)胞神經(jīng)網(wǎng)絡(luò)是一個(gè)大的動(dòng)態(tài)系統(tǒng),它的每個(gè)

2009-09-19 09:35:15

【技術(shù)綜述】為了壓榨CNN模型,這幾年大家都干了什么

2019-05-29 14:49:27

很多人對于卷積神經(jīng)網(wǎng)絡(luò)(CNN)并不了解,卷積神經(jīng)網(wǎng)絡(luò)是一種前饋神經(jīng)網(wǎng)絡(luò),它包括卷積計(jì)算并具有很深的結(jié)構(gòu),卷積神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)的代表性算法之一。那么如何利用PyTorch API構(gòu)建CNN

2020-07-16 18:13:11

單片機(jī)(Cortex-M內(nèi)核,無操作系統(tǒng))可以跑深度學(xué)習(xí)嗎? ——Read Air 2019.8.20Xu_CNN框架待處理:1.需要設(shè)計(jì)一個(gè)可讀寫的消息棧 ()2.函數(shù)的類型參數(shù)使用結(jié)構(gòu)體傳入 (已實(shí)現(xiàn))3.動(dòng)態(tài)...

2021-12-09 08:02:27

MIMRTX1064(SDK2.13.0)的KWS demo中放置了ds_cnn_s.tflite文件,提供demo中使用的模型示例。在 read.me 中,聲明我可以找到腳本,但是,該文檔中的腳本

2023-04-19 06:11:51

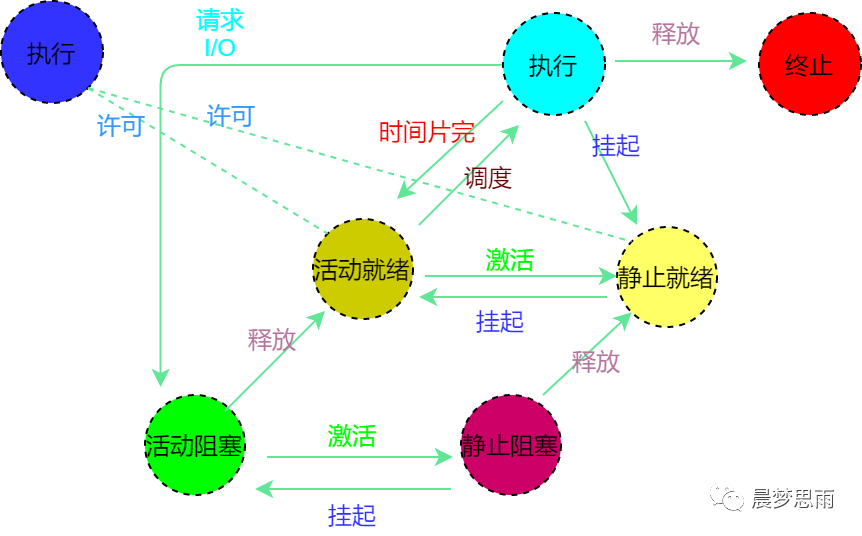

進(jìn)程管理是操作系統(tǒng)重點(diǎn)、難點(diǎn)問題,也是貫穿Linux學(xué)習(xí)的知識點(diǎn)。那么什么是進(jìn)程?為什么引入進(jìn)程的概念??從理論角度看,是對正在運(yùn)行的程序過程的抽象;?從實(shí)現(xiàn)角度看,是一種數(shù)據(jù)結(jié)構(gòu),目的在于清晰

2020-10-23 16:02:40

)第二步:使用Lattice sensAI 軟件編譯已訓(xùn)練好的神經(jīng)網(wǎng)絡(luò),定點(diǎn)化網(wǎng)絡(luò)參數(shù)。該軟件會根據(jù)神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)和預(yù)設(shè)的FPGA資源進(jìn)行分析并給出性能評估報(bào)告,此外用戶還可以在軟件中做

2020-11-26 07:46:03

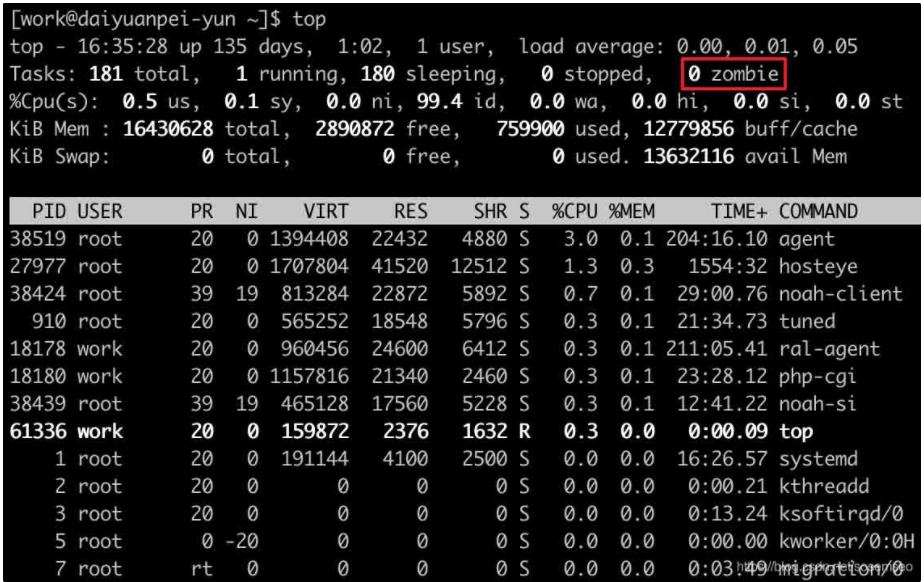

什么危害。補(bǔ)充:任何一個(gè)子進(jìn)程(init除外)在exit()之后,并非馬上就消失掉,而是留下一個(gè)稱為僵尸進(jìn)程的數(shù)據(jù)結(jié)構(gòu),等待父進(jìn)程去處理。如果父進(jìn)程在子進(jìn)程exit()之后,沒有及時(shí)處理,出現(xiàn)僵尸進(jìn)程

2016-11-29 14:08:43

怎么區(qū)別父進(jìn)程和子進(jìn)程? 各位大神

2017-01-11 17:15:43

進(jìn)程的內(nèi)核對象:即我們通常所講的PCB(進(jìn)程控制塊),該結(jié)構(gòu)只能由該內(nèi)核訪問,他是操作系統(tǒng)用來管理進(jìn)程的一個(gè)數(shù)據(jù)結(jié)構(gòu),操作系統(tǒng)通過該數(shù)據(jù)結(jié)構(gòu)來感知和管理進(jìn)程;它的成員負(fù)責(zé)維護(hù)進(jìn)程的各種信息,包括進(jìn)程

2019-08-05 07:17:11

進(jìn)程需要了解 進(jìn)程,父進(jìn)程,進(jìn)程組,會話和控制終端的相關(guān)概念。進(jìn)程和父進(jìn)程:每個(gè)進(jìn)程都有父進(jìn)程,而所有的進(jìn)程以init進(jìn)程為根,形成一個(gè)樹狀結(jié)構(gòu)

2019-08-07 08:28:13

??在linux 中每一個(gè)進(jìn)程都由task_struct 數(shù)據(jù)結(jié)構(gòu)來定義. task_struct就是我們通常所說的PCB.她是對進(jìn)程控制的唯一手段也是最有效的手段. 當(dāng)我們調(diào)用fork

2019-08-08 06:05:22

HK網(wǎng)絡(luò)演化模型的研

2009-03-29 10:50:51 8

8 作為一種新型的理論研究和實(shí)踐技術(shù),演化硬件(EHW)在機(jī)器學(xué)習(xí)、人工神經(jīng)網(wǎng)絡(luò)、自適應(yīng)控制、信號處理與識別、容錯(cuò)系統(tǒng)和機(jī)器人等方面已經(jīng)受到了廣泛的重視。本文針對FPGA

2009-05-26 15:08:04 15

15 分析了與Linux 2.6 進(jìn)程調(diào)度密切相關(guān)的一些重要數(shù)據(jù)結(jié)構(gòu),詳細(xì)描述了進(jìn)程調(diào)度的時(shí)機(jī)、調(diào)度的策略和調(diào)度器的工作流程,并從算法分析和HackBench 測試兩個(gè)方面對Linux 2.4和2.6 進(jìn)程調(diào)

2009-06-13 10:13:09 11

11 PID 參數(shù)優(yōu)化是自動(dòng)控制領(lǐng)域研究的一個(gè)重要問題. 提出了一種差分演化算法的PID參數(shù)優(yōu)化算法, 同時(shí), 為了增強(qiáng)算法的易用性, 對差分演化算法中的縮放因子采用隨機(jī)產(chǎn)生的方法

2009-06-20 10:19:22 25

25 演化計(jì)算是一種通過模擬的自然界的生物演化過程搜索最優(yōu)解的方法,主要包括遺傳算法(CA)、演化策略(ES)、演化規(guī)劃(EP)等。演化計(jì)算具有子組織性、自適應(yīng)性等智能特能

2009-06-26 17:43:42 24

24 本文中提出了一種電子郵件網(wǎng)絡(luò)加權(quán)動(dòng)態(tài)演化模型,它通過生成和刪除兩種機(jī)制來模擬用戶定期整理其地址簿的行為,模擬了真實(shí)電子郵件網(wǎng)絡(luò)拓?fù)?b class="flag-6" style="color: red">結(jié)構(gòu)的動(dòng)態(tài)演化。并通過仿真實(shí)驗(yàn)

2009-07-16 08:49:14 15

15 在線手寫簽名驗(yàn)證是目前生物特征識別領(lǐng)域較為熱門的一個(gè)方向,論文試圖將演化計(jì)算的思想,用于在線簽名驗(yàn)證。在建立數(shù)學(xué)模型的基礎(chǔ)上,提出了簽名驗(yàn)證匹配演化算法,并

2009-08-14 08:57:05 14

14 測試系統(tǒng)體系結(jié)構(gòu)作為測試系統(tǒng)的藍(lán)圖,為人們宏觀把握系統(tǒng)的整體結(jié)構(gòu)提供了一條有效途徑。基于系統(tǒng)進(jìn)一步發(fā)展的技術(shù)需要,研究了軍用測試系統(tǒng)體系結(jié)構(gòu)演化開發(fā)過程,它將

2009-09-23 11:17:32 10

10 LINUX 進(jìn)程源代碼分析

task_struct 數(shù)據(jù)結(jié)構(gòu)表示進(jìn)程的數(shù)據(jù)結(jié)構(gòu)是struct task_struct。task_struct 結(jié)構(gòu)是進(jìn)程實(shí)體的核心,Linux 內(nèi)核通過對該結(jié)構(gòu)的相關(guān)操作來控制

2010-02-09 15:13:41 16

16 在硬件電路設(shè)計(jì)中引入演化計(jì)算,在可編程邏輯器件上通過對基本電路元器件進(jìn)行演化而自動(dòng)生成人工不可能設(shè)計(jì)出的電路結(jié)構(gòu),稱為演化硬件設(shè)計(jì)。本文就演化硬件的原理和其國

2010-08-04 11:23:46 0

0

高壓大功率變換器拓?fù)?b class="flag-6" style="color: red">結(jié)構(gòu)的演化及分析和比較

摘要:闡述了高壓大功率變換器拓?fù)?b class="flag-6" style="color: red">結(jié)構(gòu)的發(fā)展,同時(shí)對它們進(jìn)行了分

2009-07-11 10:54:28 1476

1476 演化硬件實(shí)際上是一種特殊硬件,它可以像生物一樣具有自適應(yīng)、自組織、自修復(fù)特性,從而可以根據(jù)使用環(huán)境的變化而改變自身的結(jié)構(gòu)以適應(yīng)其生存環(huán)境。從狹義上來講,演化硬

2010-08-04 11:24:44 845

845 基于演化硬件的多目標(biāo)進(jìn)化算法的研究

2017-01-08 14:47:53 0

0 基于DC-DC變換器及演化

2017-09-12 10:20:05 11

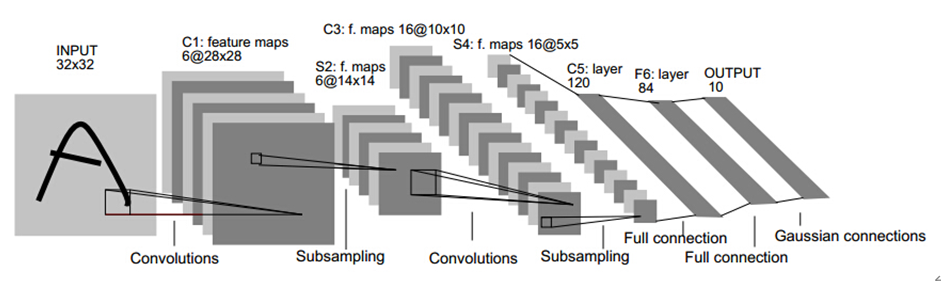

11 和tiny-cnn( ) 設(shè)計(jì)一個(gè)簡單的7層CNN結(jié)構(gòu)如下: 輸入層Input:神經(jīng)元數(shù)量32*32=1024; C1層:卷積窗大小5*5,輸出特征圖數(shù)量6,卷積窗種類6,輸出特征圖大小28*28,可訓(xùn)練參數(shù)(權(quán)值+閾值(偏置))5*5*6+6=150+6,神經(jīng)元數(shù)量28*28*6=4704;

2017-11-15 12:27:39 18949

18949

CNN是目前自然語言處理中和RNN并駕齊驅(qū)的兩種最常見的深度學(xué)習(xí)模型。圖1展示了在NLP任務(wù)中使用CNN模型的典型網(wǎng)絡(luò)結(jié)構(gòu)。一般而言,輸入的字或者詞用Word Embedding的方式表達(dá),這樣

2017-11-15 17:59:19 14700

14700

之前在網(wǎng)上搜索了好多好多關(guān)于CNN的文章,由于網(wǎng)絡(luò)上的文章很多斷章取義或者描述不清晰,看了很多youtobe上面的教學(xué)視頻還是沒有弄懂,最后經(jīng)過痛苦漫長的煎熬之后對于神經(jīng)網(wǎng)絡(luò)和卷積有了粗淺的了解

2017-11-16 13:18:40 56168

56168

對于神經(jīng)網(wǎng)絡(luò)和卷積有了粗淺的了解,關(guān)于CNN 卷積神經(jīng)網(wǎng)絡(luò),需要總結(jié)深入的知識有很多:人工神經(jīng)網(wǎng)絡(luò) ANN卷積神經(jīng)網(wǎng)絡(luò)CNN 卷積神經(jīng)網(wǎng)絡(luò)CNN-BP算法卷積神經(jīng)網(wǎng)絡(luò)CNN-caffe應(yīng)用卷積神經(jīng)網(wǎng)絡(luò)CNN-LetNet分析 LetNet網(wǎng)絡(luò).

2017-11-16 13:28:01 2562

2562

傳統(tǒng)分布仿真系統(tǒng)時(shí)鐘不一致影響因素分析方法,已不能滿足當(dāng)前面向服務(wù)分布仿真的時(shí)鐘狀態(tài)分析需要。從系統(tǒng)全局時(shí)鐘演化出發(fā),闡述了時(shí)鐘狀態(tài)演化內(nèi)涵與過程;在此基礎(chǔ)上,基于有限自動(dòng)機(jī)理論,提出了用于時(shí)鐘

2017-11-22 10:34:14 9

9 核心邊緣結(jié)構(gòu)是復(fù)雜網(wǎng)絡(luò)中一種重要且常見的簇團(tuán)結(jié)構(gòu),相關(guān)研究一直較少。為了研究復(fù)雜網(wǎng)絡(luò)核心邊緣結(jié)構(gòu)的相關(guān)特性,分析了隨機(jī)塊模型的結(jié)構(gòu),并在此基礎(chǔ)上提出了一種具有無標(biāo)度特性的核心邊緣結(jié)構(gòu)網(wǎng)絡(luò)演化模型

2017-11-22 15:05:11 0

0 具體描述時(shí)間維度上的主題動(dòng)態(tài)演化,同時(shí)在文檔中構(gòu)成主題共享的詞對結(jié)構(gòu),擴(kuò)充了短文本特征。采用Gibbs采樣方法對BToT參數(shù)進(jìn)行估計(jì),根據(jù)獲得的主題一時(shí)間分布參數(shù)對主題進(jìn)行演化分析。在真實(shí)微博數(shù)據(jù)集上進(jìn)行驗(yàn)證,結(jié)果表明,BToT模型可以描述

2017-12-03 11:31:15 14

14 方法對卷積神經(jīng)網(wǎng)絡(luò)(CNN)結(jié)構(gòu)進(jìn)行優(yōu)化,提出基于優(yōu)化CNN結(jié)構(gòu)的交通標(biāo)志識別算法。其中:BN方法可以用來改變中間層的數(shù)據(jù)分布情況,把卷積層輸出數(shù)據(jù)歸一化為均值為0、方差為1,從而提高訓(xùn)練收斂速度,減少訓(xùn)練時(shí)間;GLP方法則是先訓(xùn)練第一層

2017-12-06 14:15:04 1

1 為了利用演化算法求解離散域上的組合優(yōu)化問題,借鑒遺傳算法(GA)、二進(jìn)制粒子群優(yōu)化(BPSO)和二進(jìn)制差分演化(HBDE)中的映射方法,提出了一種基于映射變換思想設(shè)計(jì)離散演化算法的實(shí)用方法編碼轉(zhuǎn)換法

2017-12-14 16:12:10 0

0 動(dòng)態(tài)信息網(wǎng)絡(luò)是當(dāng)前復(fù)雜網(wǎng)絡(luò)領(lǐng)域中一個(gè)極具挑戰(zhàn)的問題,其動(dòng)態(tài)的演化過程具有時(shí)序、復(fù)雜、多變的特點(diǎn).結(jié)構(gòu)是網(wǎng)絡(luò)最基本的特征,也是進(jìn)行網(wǎng)絡(luò)建模和分析的基礎(chǔ),研究網(wǎng)絡(luò)結(jié)構(gòu)的演化過程,對全面認(rèn)識復(fù)雜系統(tǒng)的行為

2018-01-02 15:25:13 0

0 軟件持續(xù)演化已經(jīng)是不爭的事實(shí),演化意味著需求的變化,也就必然導(dǎo)致了缺陷的不斷產(chǎn)生.現(xiàn)有的缺陷預(yù)測技術(shù)多偏重于基于軟件工作制品,如文檔、代碼、測試用例等的屬性來預(yù)測缺陷,但如果把軟件看作一種物種,其生

2018-01-05 11:42:42 0

0 不斷動(dòng)態(tài)演化才能增強(qiáng)生命力,才能適者生存.支持動(dòng)態(tài)演化的軟件能在運(yùn)行時(shí)改變系統(tǒng)的實(shí)現(xiàn),包括完善系統(tǒng)功能、改變體系結(jié)構(gòu)等,而無需重啟或重編譯系統(tǒng).軟件演化己成為軟件生命周期中的重要組成部分,而軟件動(dòng)態(tài)演化由于具有持續(xù)可用等優(yōu)點(diǎn),則逐

2018-01-12 10:31:00 0

0 具體來說,我們提出一種用于設(shè)計(jì)移動(dòng)端的CNN模型的自動(dòng)神經(jīng)結(jié)構(gòu)搜索方法,稱之為Platform-Aware神經(jīng)結(jié)構(gòu)搜索。圖1是Platform-Aware神經(jīng)結(jié)構(gòu)搜索方法的總體視圖,它與以前的方法

2018-08-07 14:10:03 3610

3610 由 mengqiqi 于 星期三, 2018-09-05 09:58 發(fā)表 一、前述 CNN和RNN幾乎占據(jù)著深度學(xué)習(xí)的半壁江山,所以本文將著重講解CNN+RNN的各種組合方式,以及CNN和RNN

2018-09-06 22:32:01 539

539 。 于是在這里記錄下所學(xué)到的知識,關(guān)于CNN 卷積神經(jīng)網(wǎng)絡(luò),需要總結(jié)深入的知識有很多: 人工神經(jīng)網(wǎng)絡(luò) ANN 卷積神經(jīng)網(wǎng)絡(luò) CNN 卷積神經(jīng)網(wǎng)絡(luò) CNN - BP算法 卷積神經(jīng)網(wǎng)絡(luò) CNN - caffe應(yīng)用 卷積神經(jīng)網(wǎng)絡(luò) CNN - LetNet分析 LetNet網(wǎng)絡(luò) 下圖是一個(gè)經(jīng)典的CNN結(jié)構(gòu),稱為

2018-10-02 07:41:01 544

544 所有運(yùn)行在Linux操作系統(tǒng)中的進(jìn)程都被task_struct結(jié)構(gòu)管理,該結(jié)構(gòu)同時(shí)被叫作進(jìn)程描述。一個(gè)進(jìn)程描述包含一個(gè)運(yùn)行進(jìn)程所有的必要信息,例如進(jìn)程標(biāo)識、進(jìn)程屬性和構(gòu)建進(jìn)程的資源。如果你了解該進(jìn)程構(gòu)造,你就能理解對于進(jìn)程的運(yùn)行和性能來說,什么是重要的。圖1-2展示了進(jìn)程結(jié)構(gòu)相關(guān)的進(jìn)程信息概述。

2019-02-15 14:29:06 7375

7375

在task數(shù)組中占有一項(xiàng),指向一頁物理內(nèi)存,該物理內(nèi)存低端是進(jìn)程控制塊task_struct(里面包括tss段和ldt段),其余部分是進(jìn)程的內(nèi)核態(tài)堆棧。

2019-05-15 11:16:52 1004

1004

嵌入式Linux中文站收集整理Linux0.11版本內(nèi)核學(xué)習(xí)筆記,本文分析了Linux進(jìn)程控制模塊的數(shù)據(jù)結(jié)構(gòu)。

2019-05-15 15:22:19 833

833 Mask R-CNN是承繼于Faster R-CNN,Mask R-CNN只是在Faster R-CNN上面增加了一個(gè)Mask Prediction Branch(Mask預(yù)測分支),并且在ROI

2019-04-04 16:32:07 12856

12856 激光增材制造過程中微結(jié)構(gòu)及其演化與制造參數(shù)之間關(guān)聯(lián)的計(jì)算預(yù)測,已成為基于增材制造的材料/結(jié)構(gòu)設(shè)計(jì)和開發(fā)過程的重要組成部分。

2019-11-13 17:22:32 4931

4931

盡管許多研究人員已經(jīng)開發(fā)了用于FER的CNN方法,但到目前為止,他們中很少有人試圖確定哪種類型的網(wǎng)絡(luò)最適合這一特定任務(wù)。意識到文獻(xiàn)中的這種差距,永勝和他的同事邵杰為FER開發(fā)了三種不同的CNN,并進(jìn)行了一系列的評估,以確定他們的優(yōu)勢和劣勢。

2020-04-17 10:55:01 14141

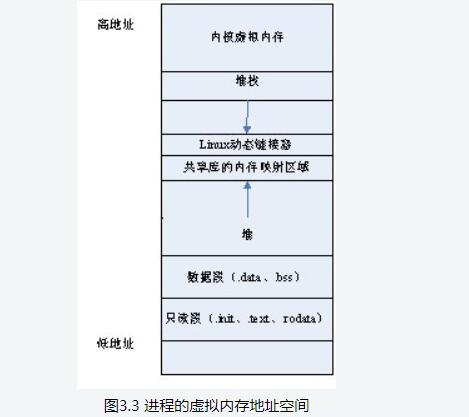

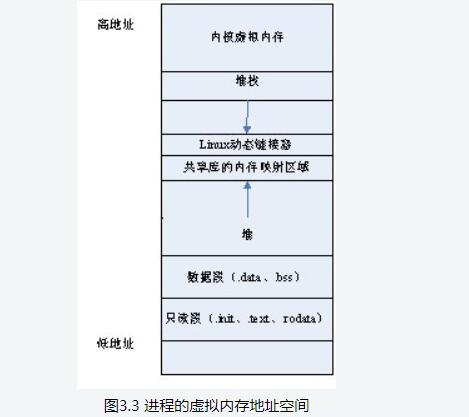

14141 Linux操作系統(tǒng)采用虛擬內(nèi)存管理技術(shù),使得每個(gè)進(jìn)程都有各自互不干涉的進(jìn)程地址空間。該地址空間是大小為4GB的線性虛擬空間,用戶所看到和接觸到的都是該虛擬地址,無法看到實(shí)際的物理內(nèi)存地址。利用這種

2020-06-01 09:17:03 1323

1323

進(jìn)程不但包括程序的指令和數(shù)據(jù),而且包括程序計(jì)數(shù)器和處理器的所有寄存器及存儲臨時(shí)數(shù)據(jù)的進(jìn)程堆棧,因此正在執(zhí)行的進(jìn)程包括處理器當(dāng)前的一切活動(dòng)。

2020-06-11 09:29:06 939

939

卷積神經(jīng)網(wǎng)絡(luò)(CNN)在單幅圖像超分辨率重構(gòu)中存在網(wǎng)絡(luò)結(jié)構(gòu)較淺、可提取特征較少和細(xì)節(jié)重構(gòu)效果不顯著等問題。為此,提出一種基于多通道極深CNN的圖像超分辨率算法,分別對原始低分辨率圖像進(jìn)行

2021-03-23 15:27:05 10

10 內(nèi)部的詞依賴關(guān)系,從而捕獲序列的內(nèi)部結(jié)構(gòu)。重利用淺層特征并與多頭自注意力特征進(jìn)行融合,結(jié)合深度學(xué)習(xí)中的CNN進(jìn)一步優(yōu)化文本情感極性分析效果。在基準(zhǔn)數(shù)據(jù)集 Semeval-2017Task5上進(jìn)行實(shí)驗(yàn),結(jié)果表明,與傳統(tǒng)機(jī)器學(xué)習(xí)算法 CNN ELSTM、 ATT-BLSTM等相比

2021-03-25 15:16:39 6

6 概述 深度學(xué)習(xí)中CNN網(wǎng)絡(luò)是核心,對CNN網(wǎng)絡(luò)來說卷積層與池化層的計(jì)算至關(guān)重要,不同的步長、填充方式、卷積核大小、

2021-04-06 15:13:25 2453

2453

為了更好地管理軟件的演化,越來越多的軟件演仳管理模型被提岀,然而現(xiàn)存的軟件演化管理模型或版本管理系統(tǒng)中存儲的軟件大多是以文件或者項(xiàng)目為單位的,而這些模型中又缺乏軟件體系結(jié)構(gòu)及組成構(gòu)件的演化歷史信息

2021-04-28 15:44:43 2

2 基于單分類的演化算法預(yù)選擇策略O(shè)CPS

2021-06-07 16:07:58 2

2 (powder-bed-fusion, PBF)技術(shù)是最常用的AM技術(shù)之一。理解并預(yù)測PBF過程中晶粒演化對通過調(diào)整工藝以定制樣件的晶粒結(jié)構(gòu)具有重要的指導(dǎo)意義。 目前,通過數(shù)值模擬方法(如元胞自動(dòng)機(jī)法、相場法)可以很好地模擬PBF過程中的部分晶粒演化現(xiàn)象,如晶粒形核和生長、競爭生長、外延生長等。值得注意

2021-06-15 15:06:06 1597

1597 基于CNN與約束概率矩陣分解的推薦算法

2021-06-17 16:36:19 7

7 基于改進(jìn)CNN等的左心室射血分?jǐn)?shù)精準(zhǔn)計(jì)算

2021-06-27 10:44:44 35

35 單片機(jī)(Cortex-M內(nèi)核,無操作系統(tǒng))可以跑深度學(xué)習(xí)嗎? ——Read Air 2019.8.20Xu_CNN框架

2021-11-26 09:51:05 11

11 之前我們介紹過CNN inference框架的基本結(jié)構(gòu),如何從tensorflow的graph中提取conv2d的權(quán)重,隨后利用該權(quán)重進(jìn)行對應(yīng)的卷積操作。本文我...

2022-02-07 11:47:06 0

0 LeNet 卷積神經(jīng)網(wǎng)絡(luò)是由深度學(xué)習(xí)三巨頭之一的 Yan Le Cun于 1994 年提出來的。其對構(gòu)建的 MNIST手寫字符數(shù)據(jù)集進(jìn)行分類。LeNet 的提出確立了 CNN 的基本網(wǎng)絡(luò)架構(gòu)。

2022-07-05 11:50:09 1569

1569 以卷積結(jié)構(gòu)為主,搭建起來的深度網(wǎng)絡(luò)(一般都指深層結(jié)構(gòu)的)

CNN目前在很多很多研究領(lǐng)域取得了巨大的成功,例如: 語音識別,圖像識別,圖像分割,自然語言處理等。對于大型圖像處理有出色表現(xiàn)。

一般將圖片作為網(wǎng)絡(luò)的輸入,自動(dòng)提取特征,并且對圖片的變形(平移,比例縮放)等具有高度不變形

2023-02-09 14:34:38 2049

2049

卷積神經(jīng)網(wǎng)絡(luò)(CNN)是解決圖像分類、分割、目標(biāo)檢測等任務(wù)的流行模型。本文將CNN應(yīng)用于解決簡單的二維路徑規(guī)劃問題。主要使用Python, PyTorch, NumPy和OpenCV。

2023-02-13 14:30:54 406

406 作者:Ahzam Ejaz 來源: DeepHub IMBA 卷積神經(jīng)網(wǎng)絡(luò)(cnn)是一種神經(jīng)網(wǎng)絡(luò),通常用于圖像分類、目標(biāo)檢測和其他計(jì)算機(jī)視覺任務(wù)。CNN的關(guān)鍵組件之一是特征圖,它是通過對圖像

2023-04-12 10:25:05 518

518 電子發(fā)燒友網(wǎng)站提供《PyTorch教程14.8之基于區(qū)域的CNN(R-CNN).pdf》資料免費(fèi)下載

2023-06-05 11:09:06 0

0 14.8。基于區(qū)域的 CNN (R-CNN)? Colab [火炬]在 Colab 中打開筆記本 Colab [mxnet] Open the notebook in Colab

2023-06-05 15:44:37 339

339

作者:AhzamEjaz來源:DeepHubIMBA卷積神經(jīng)網(wǎng)絡(luò)(cnn)是一種神經(jīng)網(wǎng)絡(luò),通常用于圖像分類、目標(biāo)檢測和其他計(jì)算機(jī)視覺任務(wù)。CNN的關(guān)鍵組件之一是特征圖,它是通過對圖像應(yīng)用卷積濾波器

2023-04-19 10:33:09 430

430

它用TensorFlow.js加載了一個(gè)10層的預(yù)訓(xùn)練模型,相當(dāng)于在你的瀏覽器上跑一個(gè)CNN模型,只需要打開電腦,就能了解CNN究竟是怎么回事。

2023-06-28 14:47:09 2622

2622

和高效的處理方式,CNN已經(jīng)成為圖像識別、語音識別和自然語言處理等領(lǐng)域中的優(yōu)選技術(shù)。CNN對于處理基于網(wǎng)格結(jié)構(gòu)的數(shù)據(jù)具有天然的優(yōu)勢,因此在處理圖像和視頻等視覺數(shù)據(jù)時(shí),具有獨(dú)特的優(yōu)越性能。 CNN的特點(diǎn) 1. 卷積操作:CNN最重要的操作是卷積操作,這也是CNN得名的來源。CNN的卷積操

2023-08-21 16:41:48 1662

1662 cnn卷積神經(jīng)網(wǎng)絡(luò)原理 cnn卷積神經(jīng)網(wǎng)絡(luò)的特點(diǎn)是什么? 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network,CNN)是一種特殊的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),主要應(yīng)用于圖像處理和計(jì)算機(jī)視覺領(lǐng)域

2023-08-21 17:15:25 1027

1027 cnn卷積神經(jīng)網(wǎng)絡(luò)算法 cnn卷積神經(jīng)網(wǎng)絡(luò)模型 卷積神經(jīng)網(wǎng)絡(luò)(CNN)是一種特殊的神經(jīng)網(wǎng)絡(luò),具有很強(qiáng)的圖像識別和數(shù)據(jù)分類能力。它通過學(xué)習(xí)權(quán)重和過濾器,自動(dòng)提取圖像和其他類型數(shù)據(jù)的特征。在過去的幾年

2023-08-21 17:15:57 946

946 cnn卷積神經(jīng)網(wǎng)絡(luò)matlab代碼? 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network, CNN)是深度學(xué)習(xí)中一種常用的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),它是通過卷積層、池化層和全連接層等組合而成

2023-08-21 17:15:59 798

798 以解決圖像識別問題為主要目標(biāo),但它的應(yīng)用已經(jīng)滲透到了各種領(lǐng)域,從自然語言處理、語音識別、到物體標(biāo)記以及醫(yī)療影像分析等。在此,本文將對CNN的原理、結(jié)構(gòu)以及基礎(chǔ)代碼進(jìn)行講解。 1. CNN的原理 CNN是一種能夠自動(dòng)提取特征的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),它的每個(gè)層次在進(jìn)行特征提取時(shí)會自動(dòng)適應(yīng)輸入數(shù)據(jù)

2023-08-21 17:16:13 1622

1622 資源分配調(diào)度的獨(dú)立單位。 結(jié)構(gòu)特征:為了使程序能夠獨(dú)立運(yùn)行,應(yīng)配置一個(gè)進(jìn)程控制塊PCB。進(jìn)程是由程序段,相關(guān)的數(shù)據(jù)段和PCB(進(jìn)程控制塊)三部分構(gòu)成的。 動(dòng)態(tài)性:進(jìn)程是程序的一次執(zhí)行,由創(chuàng)建而產(chǎn)生,由調(diào)度而執(zhí)行,由撤銷而

2023-10-08 15:29:53 333

333

進(jìn)程中的指令已經(jīng)執(zhí)行完成,但是進(jìn)程PCB結(jié)構(gòu)還沒有回收。

即子進(jìn)程先于父進(jìn)程退出后,子進(jìn)程的PCB需要其父進(jìn)程釋放,但是父進(jìn)程并沒有釋放子進(jìn)程的PCB,這樣的子進(jìn)程就稱為僵尸進(jìn)程。

2023-11-29 15:52:09 2549

2549

電子發(fā)燒友App

電子發(fā)燒友App

評論