完善資料讓更多小伙伴認識你,還能領取20積分哦,立即完善>

電子發燒友網技術文庫為您提供最新技術文章,最實用的電子技術文章,是您了解電子技術動態的最佳平臺。

GPU和深度學習的結合對于使人工智能更快、更高效地升級也至關重要。GPU可以同時處理大量數據,從而實現更快的訓練和推理。...

OpenRAN技術路線理論上可行,產品能夠正常運行,但實際表現仍然不如華為產品,成本也更高。華為通過有機的系統設計路線,將設備前后級融為一體,實現了效能的最大化,同時降低了成本。...

基于多尺度變換(MST)的偏振圖像融合方法研究開始較早且應用廣泛。2016年,中北大學提出一種紅外偏振與強度圖像融合算法,融合結果能夠保留紅外強度圖像的全部特征和大部分偏振圖像的特征。...

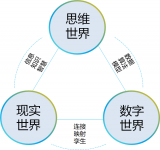

研究者們提出了一個框架來描述LLMs在處理多語言輸入時的內部處理過程,并探討了模型中是否存在特定于語言的神經元。...

Al算力對高效電源提出新需求,背面供電技術蓄勢待發:越來越高度化的集成會造成針對加速芯片的電源解決方案越來越復雜,方案需要不同電壓、不同路的多路輸入,這種情況下電壓軌會越來越多。...

本質是讓設計人員聚焦于修復BUG,而不是花時間發現BUG。將需要大量人力的工作交給AI,極大的推動了覆蓋率收斂的速度。...

傳統的雷達目標檢測方法,主要圍繞雷達回波信號的統計特性進行建模,進而在噪聲和雜波的背景下對目標存在與否進行判決,常用的典型算法如似然比檢測(LRT)、檢測前跟蹤(TBD)以及恒虛警(CFAR)等。...

循環神經網絡 (RNN) 是一種深度學習結構,它使用過去的信息來提高網絡處理當前和將來輸入的性能。RNN 的獨特之處在于該網絡包含隱藏狀態和循環。...

ASR 是自然語言中一項頗具挑戰性的任務,它由語音分割、聲學建模和語言建模等一系列子任務組成,根據噪聲和未分割的輸入數據形成預測(標簽序列)。...

人工智能是由約翰·麥卡錫(John McCarthy)于1956年提出來的,當時的定義是“制造智能機器的科學與工程”。 現在的人工智能是指“研究、開發用于模擬、延伸和擴展人的智能的理論、方法、技術及應用系統的一門新的技術科學”。...

有監督學習通常是利用帶有專家標注的標簽的訓練數據,學習一個從輸入變量X到輸入變量Y的函數映射。Y = f (X),訓練數據通常是(n×x,y)的形式,其中n代表訓練樣本的大小,x和y分別是變量X和Y的樣本值。...

在人工智能領域,谷歌可以算是開源的鼻祖。今天幾乎所有的大語言模型,都基于谷歌在 2017 年發布的 Transformer 論文;谷歌的發布的 BERT、T5,都是最早的一批開源 AI 模型。...

那關于LLM的長文本能力,目前業界通常都是怎么做的?有哪些技術點或者方向?今天我們就來總結一波,供大家快速全面了解。...

門控網絡或路由: 這個部分用于決定哪些令牌 (token) 被發送到哪個專家。例如,在下圖中,“More”這個令牌可能被發送到第二個專家,而“Parameters”這個令牌被發送到第一個專家。...

大模型:即基礎模型,在海量數據和計算資源的基礎上通過預先訓練出來的,具有大參數規模的深度學習模型 >狹義多指大語言模型,廣義還包括CV、多模態等各種模型類型...

大模型的核心技術是自然語言處理(NLP)和深度學習。具體而言,它基于Transformer架構,使用了大規模無監督學習方法,例如自回歸語言建模和掩碼語言建模,來訓練一個龐大的神經網絡模型。...

圖神經網絡直接應用于圖數據集,您可以訓練它們以預測節點、邊緣和與圖相關的任務。它用于圖和節點分類、鏈路預測、圖聚類和生成,以及圖像和文本分類。...

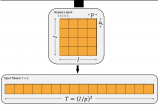

LDM 就是 Stable Diffusion 使用的模型架構。擴散模型的一大問題是計算需求大,難以擬合高分辨率圖像。為了解決這一問題,實現 LDM時,會先訓練一個幾乎能無損壓縮圖像的自編碼器,能把 512x512 的真實圖像壓縮成 64x64 的壓縮圖像并還原。...

自然語言處理領域存在著一個非常有趣的現象:在多語言模型中,不同的語言之間似乎存在著一種隱含的對齊關系。...