InfiniBand(IB)是由InfiniBand貿(mào)易協(xié)會(huì)(IBTA)建立的先進(jìn)計(jì)算機(jī)網(wǎng)絡(luò)通信標(biāo)準(zhǔn)。它在高性能計(jì)算(HPC)中的廣泛采用歸功于它能夠?yàn)?a href="http://www.nxhydt.com/v/tag/1722/" target="_blank">網(wǎng)絡(luò)傳輸提供卓越的吞吐量、帶寬和低延遲。

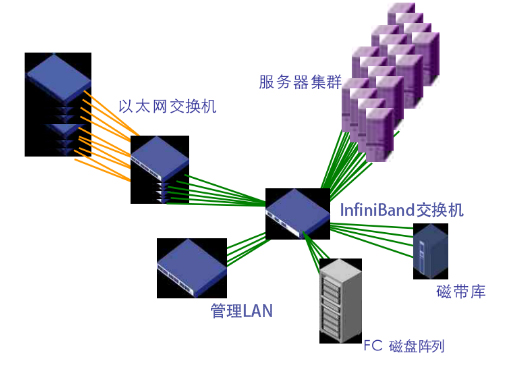

InfiniBand是計(jì)算系統(tǒng)內(nèi)部和外部的關(guān)鍵數(shù)據(jù)連接。無(wú)論是通過(guò)直接鏈路還是通過(guò)網(wǎng)絡(luò)交換機(jī)進(jìn)行互連,InfiniBand都有助于實(shí)現(xiàn)服務(wù)器到存儲(chǔ)和存儲(chǔ)到存儲(chǔ)數(shù)據(jù)傳輸?shù)母咝阅芫W(wǎng)絡(luò)。InfiniBand網(wǎng)絡(luò)可擴(kuò)展性允許通過(guò)交換網(wǎng)絡(luò)進(jìn)行水平擴(kuò)展,以滿(mǎn)足多樣化的網(wǎng)絡(luò)需求。隨著科學(xué)計(jì)算、人工智能(AI)和云數(shù)據(jù)中心的快速發(fā)展,InfiniBand在端到端高性能網(wǎng)絡(luò)的HPC超級(jí)計(jì)算應(yīng)用中越來(lái)越受到青睞。

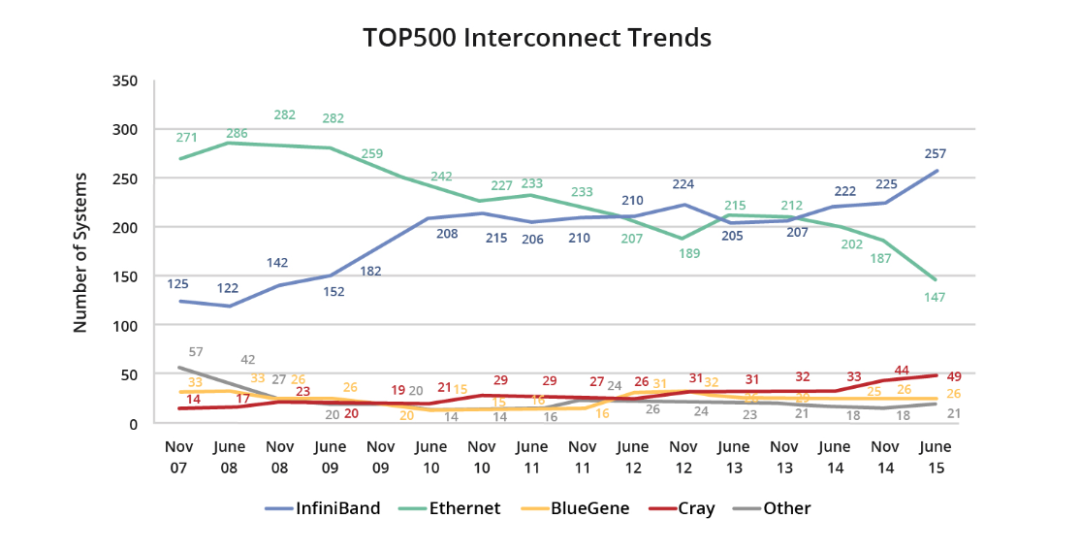

2015年6月,InfiniBand在全球最強(qiáng)大的超級(jí)計(jì)算機(jī)500強(qiáng)名單中占據(jù)了驚人的51.8%,同比增長(zhǎng)了15.8%。

在2022年6月的Top500榜單中,InfiniBand網(wǎng)絡(luò)再次占據(jù)了超級(jí)計(jì)算機(jī)互連設(shè)備的領(lǐng)先地位。與之前的榜單相比,InfiniBand網(wǎng)絡(luò)展現(xiàn)了在數(shù)量和性能方面的優(yōu)勢(shì)。主要趨勢(shì)包括:

基于InfiniBand的超級(jí)計(jì)算機(jī)以189個(gè)系統(tǒng)數(shù)量遙遙領(lǐng)先。

基于InfiniBand的超級(jí)計(jì)算機(jī)以59臺(tái)設(shè)備數(shù)量在前100個(gè)系統(tǒng)中占據(jù)主導(dǎo)地位。

英偉達(dá)(NVIDIA)GPU和網(wǎng)絡(luò)產(chǎn)品,尤其是邁絡(luò)思(Mellanox)HDR Quantum QM87xx交換機(jī)和BlueField DPU,在超過(guò)三分之二的超級(jí)計(jì)算機(jī)中占據(jù)了主導(dǎo)互連的地位。

除了傳統(tǒng)的HPC應(yīng)用之外,InfiniBand網(wǎng)絡(luò)還廣泛用于企業(yè)級(jí)數(shù)據(jù)中心和公有云。例如,領(lǐng)先的企業(yè)超級(jí)計(jì)算機(jī)英偉達(dá)(NVIDIA)Selene和Microsoft的Azure公有云利用InfiniBand網(wǎng)絡(luò)提供卓越的業(yè)務(wù)性能。

在2023年11月的最新Top500榜單中,InfiniBand保持著領(lǐng)先位置,突顯了其持續(xù)增長(zhǎng)的趨勢(shì)。InfiniBand在Top500排行榜中備受關(guān)注,主要是因?yàn)樗哂凶吭降男阅軆?yōu)勢(shì)。

InfiniBand網(wǎng)絡(luò)的優(yōu)勢(shì)

InfiniBand技術(shù)被認(rèn)為是面向未來(lái)的高性能計(jì)算(HPC)標(biāo)準(zhǔn),在超級(jí)計(jì)算機(jī)、存儲(chǔ)甚至LAN網(wǎng)絡(luò)的HPC連接方面享有很高的聲譽(yù)。InfiniBand技術(shù)擁有眾多優(yōu)勢(shì),包括簡(jiǎn)化管理、高帶寬、完全CPU卸載、超低延遲、集群可擴(kuò)展性和靈活性、服務(wù)質(zhì)量(QoS)、SHARP支持等。

輕松的網(wǎng)絡(luò)管理

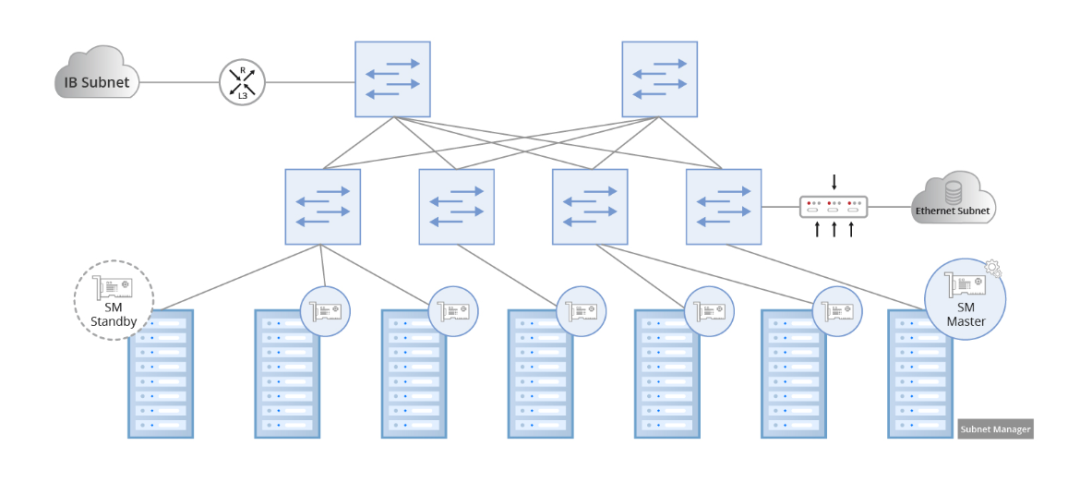

InfiniBand代表了專(zhuān)為軟件定義網(wǎng)絡(luò)(SDN)打造的開(kāi)創(chuàng)性網(wǎng)絡(luò)架構(gòu),并由子網(wǎng)管理器進(jìn)行監(jiān)督。子網(wǎng)管理器負(fù)責(zé)配置本地子網(wǎng),確保網(wǎng)絡(luò)無(wú)縫運(yùn)行。為了管理流量,所有通道適配器和交換機(jī)都必須實(shí)現(xiàn)與子網(wǎng)管理器協(xié)作的子網(wǎng)管理代理(SMA)。在建立或切斷鏈接時(shí),每個(gè)子網(wǎng)至少需要一個(gè)子網(wǎng)管理器進(jìn)行初始設(shè)置和重新配置。仲裁機(jī)制用于指定主子網(wǎng)管理器,其他子網(wǎng)管理器在備用模式下運(yùn)行。在備用模式下,每個(gè)子網(wǎng)管理器都會(huì)保留備份拓?fù)?a target="_blank">信息并驗(yàn)證子網(wǎng)的運(yùn)行狀態(tài)。如果主子網(wǎng)管理器發(fā)生故障,備用子網(wǎng)管理器將接管控制權(quán),從而保證子網(wǎng)管理不間斷。

更高的帶寬

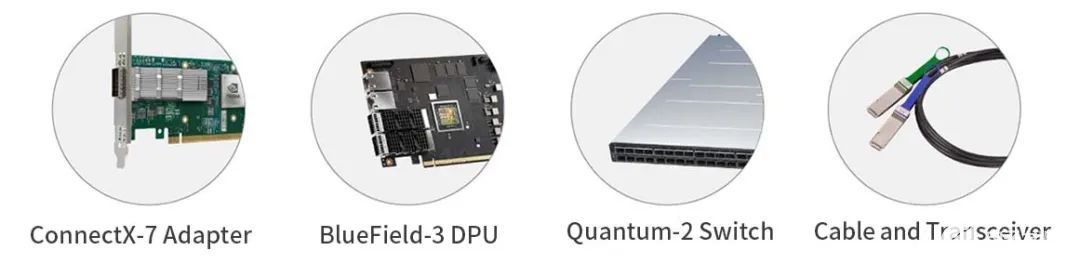

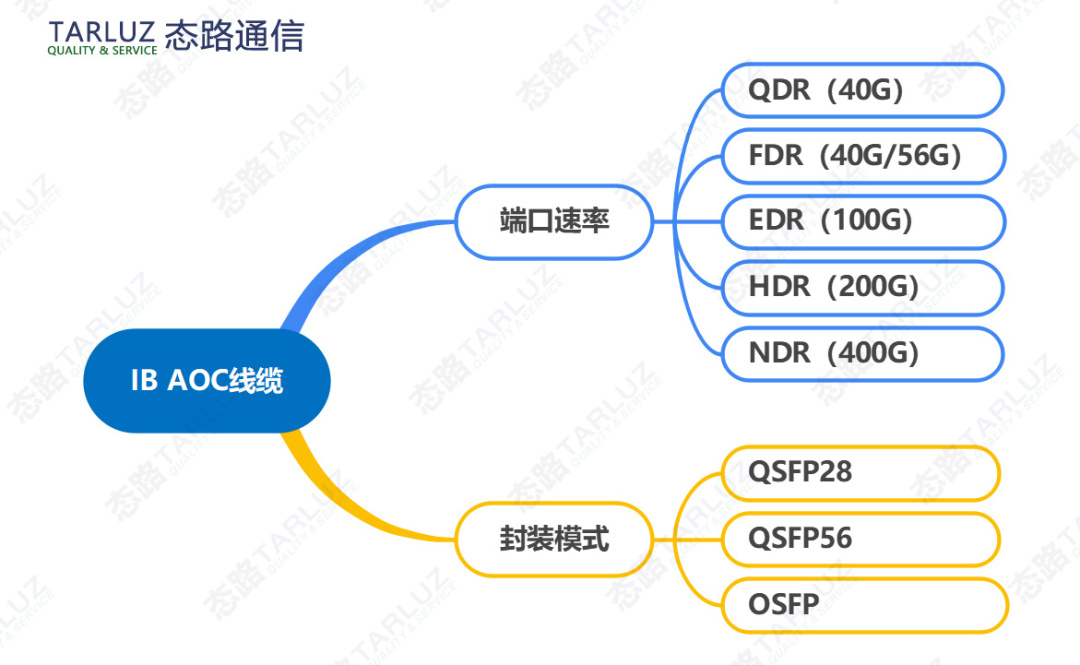

自從InfiniBand問(wèn)世以來(lái),其網(wǎng)絡(luò)數(shù)據(jù)速率一直超過(guò)以太網(wǎng),主要是因?yàn)樗诟咝阅苡?jì)算中的服務(wù)器互連中得到了廣泛應(yīng)用,滿(mǎn)足了對(duì)更高帶寬的需求。在2014年早期,流行的InfiniBand速率是40Gb/s QDR和56Gb/s FDR。目前,更高的InfiniBand速率,例如100Gb/s EDR和200Gb/s HDR,已被全球眾多超級(jí)計(jì)算機(jī)廣泛采用。最新的OpenAI工具ChatGPT的推出促使企業(yè)考慮在其高性能計(jì)算(HPC)系統(tǒng)中部署具有400Gb/s NDR數(shù)據(jù)速率的先進(jìn)InfiniBand網(wǎng)絡(luò)產(chǎn)品,包括InfiniBand NDR交換機(jī)和光纜。

每種InfiniBand速率類(lèi)型的縮寫(xiě)如下:

SDR-單數(shù)據(jù)速率,8Gbps。

DDR-雙倍數(shù)據(jù)速率,10Gbps/16Gbps。

QDR-四倍數(shù)據(jù)速率,40Gbps/32Gbps。

FDR-十四倍數(shù)據(jù)率,56Gbps。

EDR-增強(qiáng)型數(shù)據(jù)速率,100Gbps。

HDR-高動(dòng)態(tài)范圍,200Gbps。

NDR-下一代數(shù)據(jù)速率,400Gbps。

XDR-極致數(shù)據(jù)速率,800Gbps。

高效的CPU卸載

CPU卸載是增強(qiáng)計(jì)算性能的一項(xiàng)關(guān)鍵技術(shù),而InfiniBand網(wǎng)絡(luò)架構(gòu)通過(guò)以下方式以最少的CPU資源促進(jìn)數(shù)據(jù)傳輸:

整個(gè)傳輸層協(xié)議棧的硬件卸載。

內(nèi)核繞行,零拷貝。

RDMA(遠(yuǎn)程直接內(nèi)存訪問(wèn)),一種將數(shù)據(jù)從一臺(tái)服務(wù)器的內(nèi)存直接寫(xiě)入另一臺(tái)服務(wù)器的內(nèi)存的過(guò)程,無(wú)需CPU參與。

利用GPUDirect技術(shù)是另一種選擇,它允許直接訪問(wèn)GPU內(nèi)存中的數(shù)據(jù),并加速數(shù)據(jù)從GPU內(nèi)存?zhèn)鬏數(shù)狡渌?jié)點(diǎn)。此功能可提高人工智能(AI)、深度學(xué)習(xí)訓(xùn)練、機(jī)器學(xué)習(xí)等計(jì)算應(yīng)用程序的性能。

低延遲

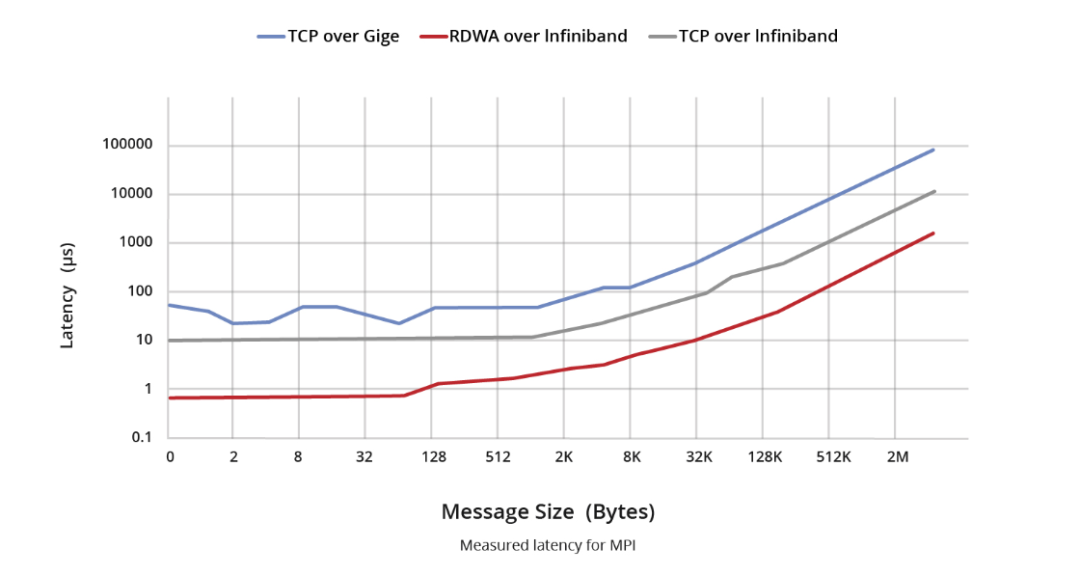

InfiniBand和以太網(wǎng)之間的延遲對(duì)比可以分為兩個(gè)主要組成部分。首先,在交換機(jī)層面上,以太網(wǎng)交換機(jī)在網(wǎng)絡(luò)傳輸模型中作為第2層設(shè)備運(yùn)行,通常采用MAC表查找尋址和存儲(chǔ)轉(zhuǎn)發(fā)機(jī)制(某些產(chǎn)品可能采用InfiniBand的直通技術(shù))。以太網(wǎng)交換機(jī)中,IP、MPLS、QinQ和其他處理等復(fù)雜服務(wù)會(huì)導(dǎo)致處理持續(xù)時(shí)間延長(zhǎng),延遲測(cè)量結(jié)果通常以微秒為單位(直通支持可能超過(guò)200ns)。相比之下,InfiniBand交換機(jī)簡(jiǎn)化了第2層處理,僅依靠16位LID轉(zhuǎn)發(fā)路徑信息。此外,采用直通技術(shù)可將轉(zhuǎn)發(fā)延遲顯著降低到100ns以下,已經(jīng)超過(guò)以太網(wǎng)交換機(jī)的速率。

如前所述,在網(wǎng)卡(NIC)層面,RDMA技術(shù)消除了網(wǎng)卡遍歷CPU進(jìn)行消息轉(zhuǎn)發(fā)的需要。這種加速盡可能地減少了封裝和解封裝期間消息處理的延遲。通常,InfiniBand網(wǎng)卡的發(fā)送和接收延遲(寫(xiě)入、發(fā)送)為600ns,而使用以太網(wǎng)的基于以太網(wǎng)TCP UDP應(yīng)用程序的發(fā)送和接收延遲通常徘徊在10us左右。這導(dǎo)致InfiniBand和以太網(wǎng)之間的延遲差距超過(guò)10倍。

可擴(kuò)展性和靈活性

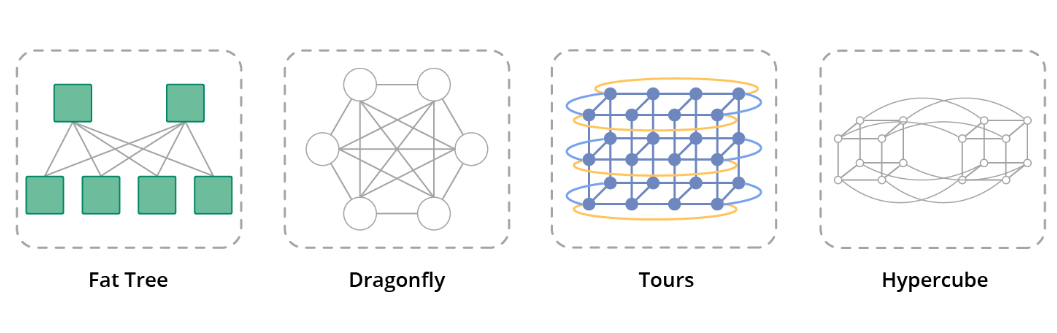

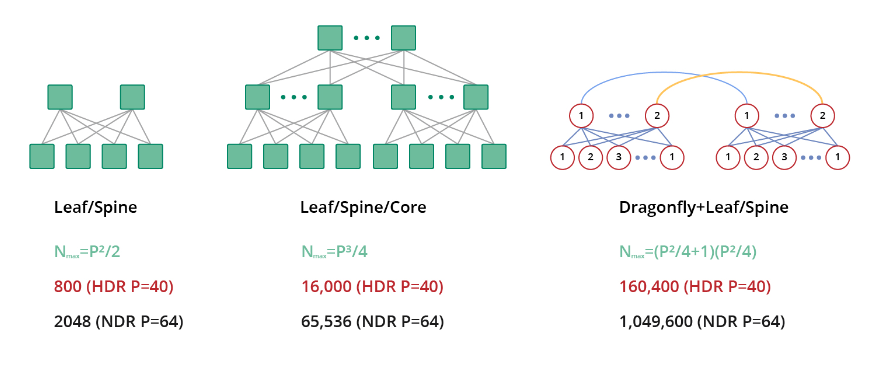

InfiniBand網(wǎng)絡(luò)的一個(gè)重要優(yōu)勢(shì)在于其能夠在單個(gè)子網(wǎng)中部署多達(dá)48,000個(gè)節(jié)點(diǎn),形成一個(gè)龐大的第二層網(wǎng)絡(luò)。此外,InfiniBand網(wǎng)絡(luò)避開(kāi)了ARP等廣播機(jī)制,從而避免了廣播風(fēng)暴和相關(guān)的額外帶寬浪費(fèi)。多個(gè)InfiniBand子網(wǎng)的連接可通過(guò)路由器和交換機(jī)實(shí)現(xiàn),展示了該技術(shù)在支持各種網(wǎng)絡(luò)拓?fù)浞矫娴亩喙δ苄浴?/p>

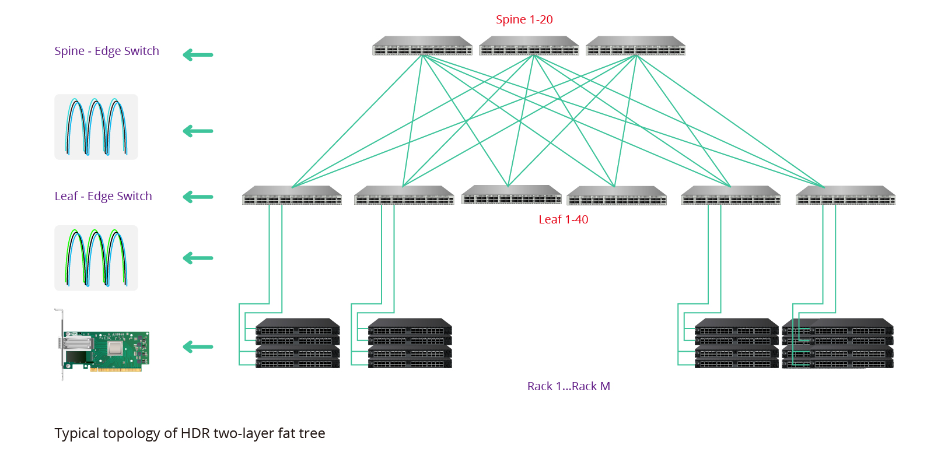

對(duì)于較小規(guī)模的情況,建議使用2層胖樹(shù)拓?fù)浣Y(jié)構(gòu),而對(duì)于較大規(guī)模的情況,可以選擇3層胖樹(shù)網(wǎng)絡(luò)拓?fù)浣Y(jié)構(gòu)。在特定規(guī)模之上,可以采用經(jīng)濟(jì)高效的Dragonfly拓?fù)浣Y(jié)構(gòu)來(lái)進(jìn)一步提升可擴(kuò)展性。

服務(wù)質(zhì)量(QoS)支持

在管理InfiniBand網(wǎng)絡(luò)時(shí),如果各種應(yīng)用程序共存于同一子網(wǎng)上,且具有不同的優(yōu)先級(jí)要求,那么提供服務(wù)質(zhì)量(QoS)就成為一個(gè)關(guān)鍵因素。QoS表示為不同的應(yīng)用程序、用戶(hù)或數(shù)據(jù)流提供不同優(yōu)先級(jí)服務(wù)的能力。在InfiniBand環(huán)境中,可以將高優(yōu)先級(jí)應(yīng)用程序分配給特定的端口隊(duì)列,從而確保這些隊(duì)列中的消息得到優(yōu)先處理。

InfiniBand通過(guò)實(shí)施虛擬通道(VL)實(shí)現(xiàn)QoS。虛擬通道是共享公共物理鏈路的離散邏輯通信鏈路。每個(gè)VL能夠支持多達(dá)15個(gè)標(biāo)準(zhǔn)虛擬通道以及一個(gè)指定為VL15的管理通道。這種方法可以根據(jù)優(yōu)先級(jí)對(duì)流量進(jìn)行有效隔離,從而允許在InfiniBand網(wǎng)絡(luò)內(nèi)優(yōu)先傳輸高優(yōu)先級(jí)應(yīng)用程序。

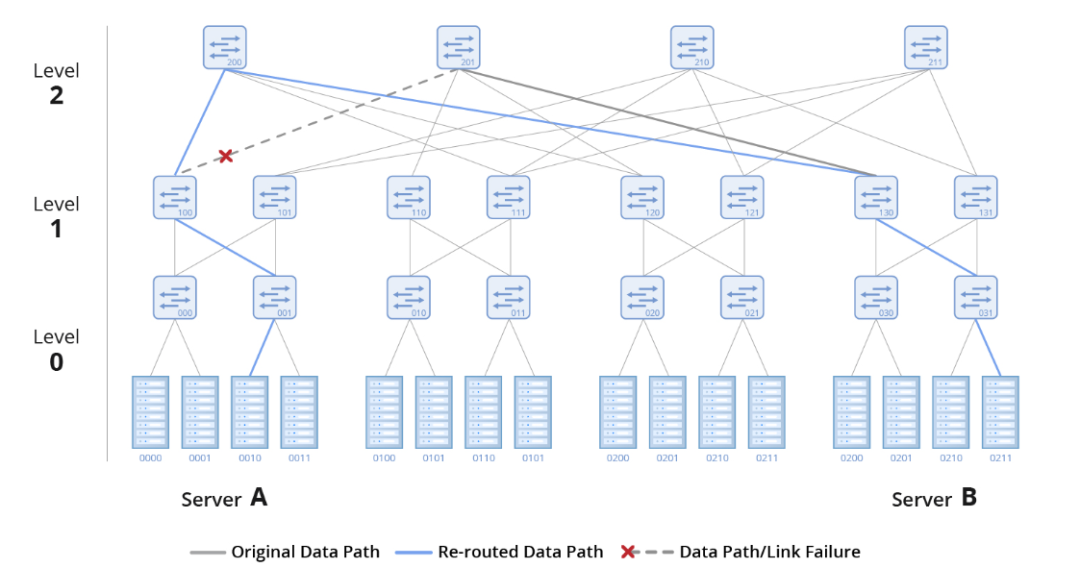

穩(wěn)定性和彈性

在理想情況下,網(wǎng)絡(luò)運(yùn)行穩(wěn)定且沒(méi)有故障。然而,現(xiàn)實(shí)情況中長(zhǎng)期運(yùn)行的網(wǎng)絡(luò)偶爾會(huì)出現(xiàn)故障。為了解決這些挑戰(zhàn)并確保快速恢復(fù),InfiniBand采用了一種稱(chēng)為自我修復(fù)網(wǎng)絡(luò)的機(jī)制,這是一種集成到InfiniBand交換機(jī)中的硬件功能。

NVIDIA Mellanox InfiniBand解決方案包括InfiniBand交換機(jī)、網(wǎng)卡和邁絡(luò)思(Mellanox)線纜等硬件組件,利用自我修復(fù)網(wǎng)絡(luò)實(shí)現(xiàn)從鏈路故障中快速恢復(fù)。這種基于硬件的功能能夠在驚人的1ms內(nèi)恢復(fù)鏈路故障,比正常恢復(fù)時(shí)間快了5000倍。

優(yōu)化的負(fù)載均衡

提高網(wǎng)絡(luò)利用率是高性能數(shù)據(jù)中心的一項(xiàng)關(guān)鍵要求。在InfiniBand網(wǎng)絡(luò)中,一種有效的實(shí)現(xiàn)方法是負(fù)載均衡。

負(fù)載均衡是一種路由策略,可以在多個(gè)可用端口之間分配流量。其中自適應(yīng)路由是一個(gè)關(guān)鍵特性,可以確保流量在交換機(jī)端口之間均勻分布。這個(gè)特性在交換機(jī)上得到硬件支持,并由自適應(yīng)路由管理器進(jìn)行管理。

當(dāng)自適應(yīng)路由處于活動(dòng)狀態(tài)時(shí),交換機(jī)上的隊(duì)列管理器將監(jiān)控所有組出口端口上的流量,均衡每個(gè)隊(duì)列上的負(fù)載,并將流量引導(dǎo)至未充分利用的端口。自適應(yīng)路由可動(dòng)態(tài)平衡負(fù)載,防止網(wǎng)絡(luò)擁塞并優(yōu)化網(wǎng)絡(luò)帶寬利用率。

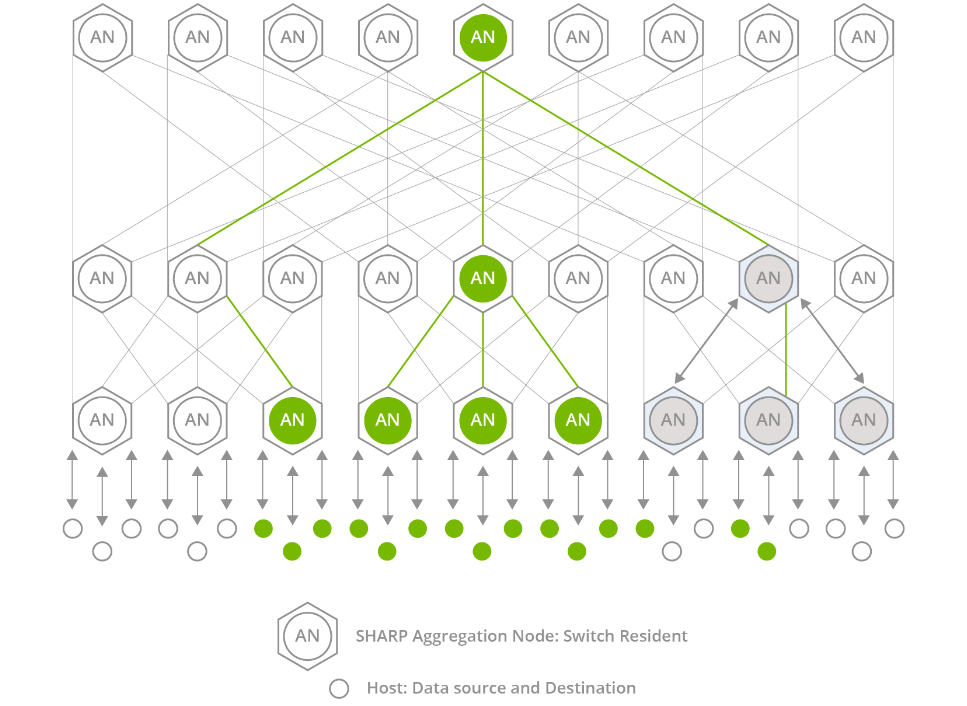

網(wǎng)絡(luò)計(jì)算技術(shù)-SHARP

InfiniBand交換機(jī)還具有SHARP網(wǎng)絡(luò)計(jì)算技術(shù),該技術(shù)代表可擴(kuò)展的分層聚合和縮減協(xié)議。SHARP是集成到交換機(jī)硬件中的軟件,是一個(gè)集中管理的軟件包。

通過(guò)將聚合通信任務(wù)從CPU和GPU卸載到交換機(jī),SHARP可以?xún)?yōu)化這些通信。它可以防止節(jié)點(diǎn)之間的冗余數(shù)據(jù)傳輸,從而減少必須遍歷網(wǎng)絡(luò)的數(shù)據(jù)量。因此,SHARP顯著提高了加速計(jì)算的性能,尤其是在AI和機(jī)器學(xué)習(xí)等MPI應(yīng)用中。

多樣化的網(wǎng)絡(luò)拓?fù)?/p>

InfiniBand支持各種網(wǎng)絡(luò)拓?fù)洌缗謽?shù)、Torus、Dragonfly+、Hypercube和HyperX,滿(mǎn)足網(wǎng)絡(luò)擴(kuò)展、降低總擁有成本(TCO)、最小化延遲和延長(zhǎng)傳輸距離等不同需求。

InfiniBand利用其無(wú)與倫比的技術(shù)優(yōu)勢(shì),顯著簡(jiǎn)化了高性能網(wǎng)絡(luò)架構(gòu),減輕了多級(jí)架構(gòu)層次結(jié)構(gòu)帶來(lái)的延遲。此功能為無(wú)縫升級(jí)關(guān)鍵計(jì)算節(jié)點(diǎn)的訪問(wèn)帶寬提供了強(qiáng)大的支持。InfiniBand網(wǎng)絡(luò)因其高帶寬、低延遲以及與以太網(wǎng)的兼容性,越來(lái)越多地在各種場(chǎng)景中得到應(yīng)用。

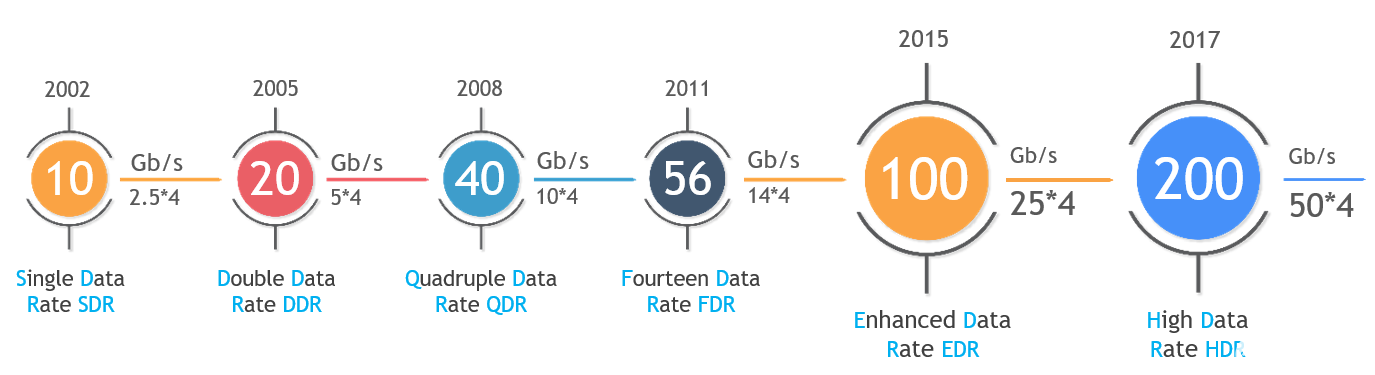

InfiniBand HDR產(chǎn)品解決方案簡(jiǎn)介

隨著客戶(hù)端需求的不斷增長(zhǎng),100Gb/s EDR正逐漸退出市場(chǎng)。目前NDR的數(shù)據(jù)速率被認(rèn)為過(guò)高,而HDR憑借其提供HDR100(100G)和HDR200(200G)的靈活性獲得廣泛采用。

InfiniBand HDR交換機(jī)

英偉達(dá)(NVIDIA)提供兩種類(lèi)型的InfiniBand HDR交換機(jī)。第一種是HDR CS8500模塊化機(jī)箱交換機(jī),這是一款29U交換機(jī),提供多達(dá)800個(gè)HDR 200Gb/s端口。每個(gè)200G端口支持拆分為2X100G,最多支持1600個(gè)HDR100(100Gb/s)端口。第二種是QM87xx系列固定交換機(jī),1U面板集成了40個(gè)200G QSFP56端口。這些端口可以拆分為多達(dá)80個(gè)HDR 100G端口,以連接到100G HDR網(wǎng)卡。同時(shí),每個(gè)端口還向后支持EDR速率以連接100G EDR網(wǎng)卡卡。需要注意的是,單個(gè)200G HDR端口只能降速到100G連接EDR網(wǎng)卡,不能拆分成2X100G連接兩個(gè)EDR網(wǎng)卡。

200G HDR QM87xx交換機(jī)有兩種型號(hào):MQM8700-HS2F和MQM8790-HS2F。這兩種型號(hào)之間的唯一區(qū)別在于管理方法。QM8700交換機(jī)具有支持帶外管理的管理端口,而QM8790交換機(jī)需要英偉達(dá)(NVIDIA)UFMR平臺(tái)進(jìn)行管理。

對(duì)于QM8700和QM8790,每種交換機(jī)都提供兩種氣流選項(xiàng)。其中,MQM8790-HS2F交換機(jī)具有P2C(電源到線纜)氣流,可通過(guò)風(fēng)扇模塊上的藍(lán)色標(biāo)記來(lái)識(shí)別。如果忘記了顏色標(biāo)記,也可以通過(guò)將手放在開(kāi)關(guān)的進(jìn)氣口和出風(fēng)口前面來(lái)確定氣流方向。MQM8790-HS2R交換機(jī)采用C2P(線纜到電源)氣流,風(fēng)扇模塊上有紅色標(biāo)記。QM87xx系列交換機(jī)型號(hào)詳情如下:

CQM8700和QM8790交換機(jī)通常用于兩種連接應(yīng)用。一種與200G HDR網(wǎng)卡連接,從而實(shí)現(xiàn)使用200G到200GAOC/DAC線纜的直接連接。另一種常見(jiàn)的應(yīng)用是連接100G HDR網(wǎng)卡,需要使用200G轉(zhuǎn)2X100G線纜將交換機(jī)的物理200G(4X50G)QSFP56端口拆分為兩個(gè)虛擬100G(2X50G)端口。拆分后,端口符號(hào)從x/y轉(zhuǎn)換為x/Y/z,其中“x/Y”表示拆分前端口的原始符號(hào),“z”表示單通道端口的編號(hào)(1,2),每個(gè)子物理端口被視為一個(gè)單獨(dú)的端口。

InfiniBand HDR網(wǎng)卡(NIC)

與HDR交換機(jī)相比,HDR網(wǎng)卡(NIC)種類(lèi)繁多。關(guān)于速率,有兩種選擇:HDR100和HDR。

HDR100網(wǎng)卡支持100Gb/s的傳輸速率,兩個(gè)HDR100端口可以使用200G HDR轉(zhuǎn)2X100G HDR100線纜連接到HDR交換機(jī)。與100G EDR網(wǎng)卡相比,HDR100網(wǎng)卡的100G端口可以同時(shí)支持4X25G NRZ傳輸和2X50G PAM4傳輸。

200G HDR網(wǎng)卡支持200G的傳輸速率,可以使用200G直連線纜直接連接到交換機(jī)。

除了兩種接口數(shù)據(jù)速率外,每種速率的網(wǎng)卡都可以根據(jù)業(yè)務(wù)需求選擇單端口、雙端口和PCIe類(lèi)型。常用的IB HDR網(wǎng)卡型號(hào)如下:

HDR InfiniBand網(wǎng)絡(luò)架構(gòu)簡(jiǎn)單明了,同時(shí)提供了多種硬件選項(xiàng)。對(duì)于100Gb/s速率,有100G EDR和100G HDR100解決方案。200Gb/s速率包括HDR和200G NDR200選項(xiàng)。各種應(yīng)用中使用的交換機(jī)、網(wǎng)卡和附件存在顯著差異。InfiniBand高性能HDR和EDR交換機(jī)、智能網(wǎng)卡、納多德(NADDOD)/邁絡(luò)思(Mellanox)/思科(Cisco)/惠普(HPE)光纜&高速線纜&光模塊產(chǎn)品組合解決方案,為數(shù)據(jù)中心、高性能計(jì)算、邊緣計(jì)算、人工智能等應(yīng)用場(chǎng)景提供更具優(yōu)勢(shì)和價(jià)值的光網(wǎng)絡(luò)產(chǎn)品和綜合解決方案。這大大增強(qiáng)了客戶(hù)的業(yè)務(wù)加速能力,成本低且性能優(yōu)異。

InfiniBand與以太網(wǎng)、光纖通道和Omni-Path有什么區(qū)別

InfiniBand與以太網(wǎng)

與眾不同的技術(shù):InfiniBand和以太網(wǎng)是數(shù)據(jù)傳輸?shù)年P(guān)鍵通信技術(shù),每種技術(shù)都適用于不同的應(yīng)用。

歷史速率:InfiniBand的歷史數(shù)據(jù)傳輸速率從InfiniBand SDR 10Gb/s開(kāi)始,超過(guò)了千兆以太網(wǎng)的初始速率。

當(dāng)前主導(dǎo)地位:InfiniBand已經(jīng)發(fā)展成為主導(dǎo)地位,網(wǎng)絡(luò)速率達(dá)到了100G EDR或200G HDR,并且正在朝著更快的速率發(fā)展,比如400G NDR和800G XDR。

嚴(yán)格的延遲要求:InfiniBand遵守嚴(yán)格的延遲要求,接近零延遲。

理想應(yīng)用:InfiniBand在需要快速和精確數(shù)據(jù)處理的應(yīng)用中表現(xiàn)出色,在超級(jí)計(jì)算中得到廣泛應(yīng)用,適用于大容量數(shù)據(jù)分析、機(jī)器學(xué)習(xí)、深度學(xué)習(xí)訓(xùn)練、推理、對(duì)話(huà)式AI、預(yù)測(cè)和預(yù)測(cè)等任務(wù)。

以太網(wǎng)的作用:盡管速率相對(duì)較慢,以太網(wǎng)以其高可靠性而聞名,非常適合需要穩(wěn)定可靠數(shù)據(jù)傳輸?shù)木钟蚓W(wǎng)應(yīng)用。

速率和可靠性的差異:這些技術(shù)之間的主要差異在于它們的速率和可靠性。在高性能計(jì)算網(wǎng)絡(luò)中,InfiniBand優(yōu)先用于需要快速數(shù)據(jù)傳輸?shù)膽?yīng)用程序,而以太網(wǎng)的可靠性使其更適合在LAN網(wǎng)絡(luò)中進(jìn)行一致的數(shù)據(jù)傳輸。

InfiniBand與光纖通道

存儲(chǔ)區(qū)域網(wǎng)絡(luò)(SAN)中的光纖通道:光纖通道主要用于存儲(chǔ)區(qū)域網(wǎng)絡(luò)(SAN),專(zhuān)門(mén)用于數(shù)據(jù)中心環(huán)境中的服務(wù)器、存儲(chǔ)設(shè)備或客戶(hù)端節(jié)點(diǎn)之間的高速數(shù)據(jù)傳輸。

安全通道技術(shù):光纖通道采用專(zhuān)用的安全通道技術(shù),確保快速可靠的數(shù)據(jù)傳輸。

存儲(chǔ)解決方案的多功能性:光纖通道是一種可靠且可擴(kuò)展的技術(shù),廣泛用于企業(yè)存儲(chǔ)解決方案。

區(qū)分?jǐn)?shù)據(jù)傳輸類(lèi)型:InfiniBand和光纖通道之間的主要區(qū)別在于它們通常支持的數(shù)據(jù)傳輸類(lèi)型。

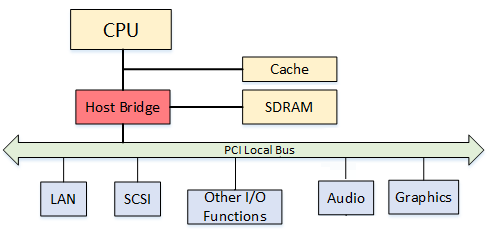

更好選擇:在局域網(wǎng)環(huán)境中,以太網(wǎng)被用于客戶(hù)端和服務(wù)器之間的連接,而光纖通道在存儲(chǔ)區(qū)域網(wǎng)絡(luò)(SAN)中的存儲(chǔ)應(yīng)用方面表現(xiàn)出色。與此同時(shí),InfiniBand作為一種創(chuàng)新技術(shù),用于連接CPU和內(nèi)存組件,支持集群和與I/O控制器的連接。

InfiniBand與Omni-Path

數(shù)據(jù)中心網(wǎng)絡(luò)的演變:盡管英偉達(dá)(NVIDIA)推出了InfiniBand 400G NDR解決方案,但一些用戶(hù)仍在繼續(xù)使用100G EDR解決方案。Omni-Path和InfiniBand都是以100Gb/s速率運(yùn)行的高性能數(shù)據(jù)中心網(wǎng)絡(luò)的常見(jiàn)選擇。

網(wǎng)絡(luò)結(jié)構(gòu)區(qū)別:雖然這兩種技術(shù)提供相似的性能,但Omni-Path和InfiniBand的網(wǎng)絡(luò)結(jié)構(gòu)有很大不同。舉例來(lái)說(shuō),使用InfiniBand的400節(jié)點(diǎn)集群只需要15臺(tái)英偉達(dá)(NVIDIA)Quantum 8000系列交換機(jī)和特定線纜,而Omni-Path需要24臺(tái)交換機(jī)和大量有源光纜。

InfiniBand EDR解決方案的優(yōu)勢(shì):與Omni-Path相比,InfiniBand EDR解決方案在設(shè)備成本、運(yùn)營(yíng)和維護(hù)成本以及總體功耗方面具有顯著優(yōu)勢(shì)。這使得InfiniBand成為更環(huán)保的選擇。

審核編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論